子空间辨识彩色融合图像质量主观评价实验

2018-07-27张晓东高绍姝王宇轩

张晓东, 高绍姝, 王宇轩, 仵 宇

(1. 中国石油大学(华东) 计算机与通信工程学院, 山东 青岛 266580;2. 东北农业大学 电气与信息学院, 哈尔滨 150030)

0 引 言

彩色(夜视)融合技术通过数字图像处理方法,将同一场景的可见光(微光)与红外多波段的灰度源图像合成一幅适于人眼观察的彩色图像,可以帮助观察者更快更准确的探测目标,在军事侦察,安全监控,海上救援等方面展现出广阔的应用前景。研究人员能够通过目标亮度,目标与背景的亮度差,色调差等衡量彩色融合图像中目标的可探测程度[1]。同时也能够根据目标探测率,虚警率以及目标与背景的颜色距离等评价融合图像的目标探测性[2-3]。但目前缺乏公认的彩色(夜视)融合图像质量评价理论和方法,直接影响到彩色夜视成像系统的评价。如何基于目标探测性评价融合图像的综合质量成为亟待解决的问题之一。

彩色(夜视)融合图像质量主观评价实验需要组织学生对图像质量进行主观评价,获取可靠的评价数据,为验证和比较图像质量客观评价模型提供统一的衡量标准。实验内容分为两部分:① 要求学生自行采集图像,安排、设计实验过程,组织志愿者完成图像质量主观评价实验,获取图像多个单一质量评价指标和综合质量的主观评价结果;② 对实验数据进行分析和处理,分析多个单一图像质量评价指标对综合图像质量的影响,建立特定应用环境下的图像质量单一评价指标与综合指标之间的函数表达关系。在实验构思、设计、实现以及完善提高等阶段与学生反复讨论,不仅要求学生掌握扎实的理论功底,同时也要求学生具有较强的动手实践能力。

1 主观评价实验

基于目标探测的彩色融合图像综合质量(Comprehensive Quality Based on target detectability, CQTD)受目标背景对比度(Contrast between the Target and Background, CTB)和目标清晰度(Sharpness of the Target, ST)的影响较大。这两方面单一评价指标易于建模量化,便于客观评价。此外,在实验数据统计与分析的过程中发现当前图像的评价结果与最近一次图像评价结果有着较大的相关性。因此,本实验提出了基于子空间辨识方法建立高阶的单一图像质量评价指标与综合质量评价指标的函数表达关系,提高模型精度,为进一步研究建立CQTD的客观评价模型提供实验和理论依据。

1.1 图像采集

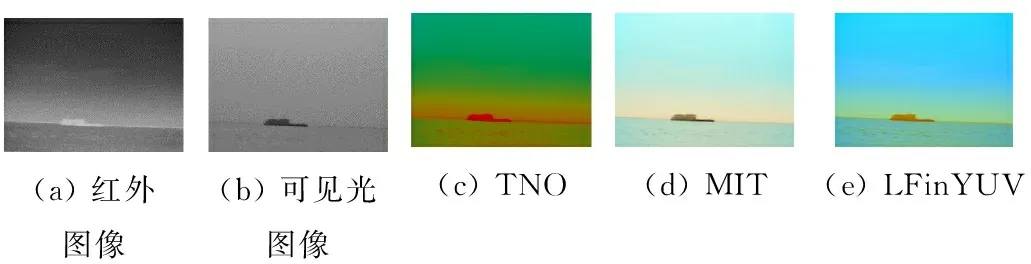

为了测试彩色融合算法针对不同类型源图像产生的融合效果,评价融合算法的适用性,需要采集不同环境光条件下,不同目标和场景的可见光(微光)与红外图像,作为融合的源图像。利用可见光电荷藕合器件图像传感器 (Charge Coupled Device, CCD)和长波红外焦平面热像仪采集并挑选出60对配准的双波段源图像。采用8种不同的可见光与红外彩色融合算法产生实验使用的480幅彩色融合图像进行评价,如图1所示。一组海天背景下的红外图像与可见光图像的8中融合图像。融合算法包括荷兰国家应用科学研究院(Netherlands Organization for Applied Science Research, TNO)彩色融合法[4]、美国麻省理工学院(Massachusetts Institute of Technology, MIT)彩色融合法[5]、YUV颜色空间的线性融合法(Linear Fusion Algorithm in YUV Space, LFinYUV)[6]、基于拮抗视觉特性的YUV空间彩色融合法(Fusion Algorithm Based on Opponent Vision Property in YUV Space, OFinYUV)[7]、基于控向金字塔的彩色融合算法(Steerable Pyramid Color Fusion Algorithm,SP)[8]、基于YUV空间的全局线性色彩传递法(Global Color Transfer Algorithm in YUV Space,GTinYUV)[9]、 基于控向金字塔的RGB空间多分辨率色彩传递算法(Color Transfer Algorithm Based on Multi-resolution in RGB Space,MRTinRGB) 和YUV空间的多分辨率色彩传递算法(Color Transfer Algorithm Based on Multi-resolution in YUV Space,MRTinYUV)[10]。

(a) 红外图像(b) 可见光图像(c) TNO(d) MIT(e) LFinYUV

(f) OFinYUV(g) SP(h) GTinYUV(i) MRTin-RGB(j) MRTin-YUV

图1 可见光与红外源图像以及融合图像

海天、绿色植物和城镇建筑是最常用的3种场景类型。采集在黎明、白天、傍晚及夜晚不同时段的目标和场景的可见光图像,记录采集图像具体时间和情况,如有无星月、月相、天空是否晴朗以及图像采集时的环境照度。实验要求学生能够正确的使用仪器设备采集海天背景、城镇背景以及绿色植物背景3类典型场景图像,组织观察者进行主观评价实验,科学地获取评价分数。针对这3种典型场景建立的模型可以满足一定规模实际场景图像质量的评价要求。彩色融合图像库见表1。

表1 可见光与红外彩色融合图像库

图像中热目标可以是人、车辆或船只等,每幅图像包含唯一的热目标。同一场景的可见光与红外源图像以及使用不同融合算法得到的彩色融合图像为一组,每类典型场景包含20组实验图像,一共60组图像。

1.2 评价指标

基于目标探测的图像综合质量主要受目标清晰度和目标与背景对比度的影响。因此,主观评价实验主要获取如下3方面的主观评价数据。

(1) 目标清晰度。目标边缘以及目标区域内细节纹理的人眼可辨识度。人眼在很大程度上,依赖于目标的边缘和纹理来探测目标。特别是在简单的背景中,目标清晰度对目标探测性存在显著的影响。

(2) 目标背景对比度。反映目标与背景在亮度和颜色方面的差异程度。在一定程度上,人眼依赖于相对亮度和颜色差异来发现目标,更容易探测到与其邻域背景对比度较大的目标。

(3) 基于目标探测的图像综合质量。评价彩色融合图像是否有助于观察者更好地发现目标。帮助观察者准确迅速地探测目标,是彩色融合图像的主要应用目的之一,该指标针对具体的应用需求衡量融合图像的综合质量。

1.3 实验条件及观察者

经过色视觉测试,组织30名具有正常色视觉与正常视力的志愿者参与主观评价实验。为了避免环境光的影响,在暗室中开展评价实验,利用经过标定和特性化的阴极射线管显示器显示实验图像。显示器峰值白点亮度调节到100 cd/m2。使用光谱辐射度计PR-715测量显示器白点色度坐标为(0.314, 0.328) 接近D65(0.313, 0.329)。其分辨率设置为1 024×768。其使用选用增益-偏置-伽马(Gain- Offset-Gamma, GOG)模型进行设备相关颜色空间RGB到设备无关CIEXYZ 3刺激值的变换,使用27个检验样本计算各个样本的3刺激值,与实测值比较,二者的色差在规定范围内,完全满足人眼主观评价实验的要求。

1.4 实验过程

为了使观察者按要求给出合理的评价分数。需要对所有观察者进行培训,从实验目的、实验内容、评价指标和评价要求等方面进行讲解。评价实验前,显示器需要进行至少两小时的预热,使其达到稳定的显示状态。每位观察者用2 min适应观察环境,人眼距离显示器50 cm。实验时,显示器首先显示每组的可见光与红外两幅灰度图像,明确其中需要探测的目标,之后显示不同融合算法产生的8幅彩色融合图像,图像大小均为320×240。观察者对融合图像相互比较并进行优劣排序,针对每一个评价指标从优到差分为7个档次,对应7~1分,给出相应的评价分数。由于评价者对图像进行相互比较后给出评价结果,相邻图像评价结果对当前图像评价结果具有较大的影响,因此,在综合质量预测模型的建模过程中要考虑这方面的影响,从而提高预测模型的准确度。

2 实验数据处理

将所有30名观察者对图像p对应评价指标q给出的评价分数进行平均,得到该图像该指标的平均评分[11]

(1)

式中:p=1,2,…,480;q代表某一评价指标CTB、ST或CQTD。

通过实验获得3种典型场景480幅图像对应CTB,ST和CQTD 3方面指标的评价分数。利用Pearson线性相关系数分析各指标间的相关性(见表2)。

表2 3方面评价指标间的相关系数

表中,CTB与CQTD的相关性达到0.934,与ST的相关性为0.679,ST与CTB的相关性较小为0.411。CQTD与ST和CTB均存在显著的相关性。因此,考虑利用这两方面单一指标建立CQTD的预测模型具有可行性和合理性。

3 基于子空间辨识方法的CQTD预测模型

构建基于CTB和ST的CQTD的预测模型,其实质是双输入、单输出的模型。文献[11]中采用线性回归方法获得了CQTD预测模型。但是,考虑相邻图像的质量评价结果对当前图像评价结果的影响,需要构建高阶系统模型提高模型精度。在实际应用中,由于不同场景类型图像包含细节或纹理的丰富度不同,具有不同的颜色以及纹理的特点,各单一评价指标在预测图像综合质量时占有的权重大小也会不同,为了使建立的预测模型更准确,对各典型场景图像对应的实验数据分别进行统计分析,进一步考虑在主观评价结果不够准确的情况下建立高精度模型。

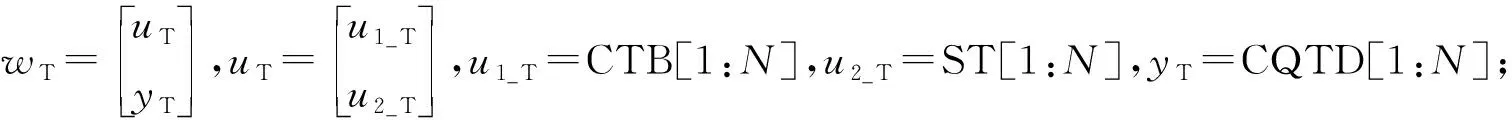

实验提出基于子空间辨识方法建立综合质量高阶预测模型[12-13]。子空间辨识方法具有一定的数值鲁棒性。与传统的预报误差法等方法相比,不需要进行非线性优化问题的迭代求解。与需要确定模型最小参数数目的经典算法不同,子空间辨识方法唯一需要的“参数”是系统的阶次。将CTB和ST作为自变量数据输入,将CQTD作为因变量数据输出,通过构造输入、输出Hankel矩阵投影的行“子空间”和列“子空间”来获取模型参数。

系统预测输出为

(2)

可以通过下述最小二乘问题的求解获得:

(3)

(4)

式中

YV以及YT的定义同上。

基于QR分解子空间矩阵可得:

(5)

选取30组数据训练模型,基于子空间辨识方法建立CQTD二阶预测模型。基于模型式(2),3种不同场景的图像综合质量二阶预测模型参数如下:

海天场景

(6)

植物场景

(7)

城镇建筑物场景

(8)

选取30组图像测试,比较CQTD预测模型预测值与主观评价实验数据,求二者的Pearson相关系数(Pearson Correlation Coefficient,PC),Spearman相关系数(Spearman Correlation Coefficient,SC)以及均方根误差(Root Mean Square Error,RMSE),衡量预测值与实验值的近似程度,即预测模型的预测准确度。表3给出PC、SC和RMSE的计算结果,可以看出,综合质量CQTD可用ST和CTB联合来预测,3种典型场景的

PC均达到0.98以上,SC达到0.97以上,RMES保持在0.05以内,表明基于子空间辨识方法建立的综合质量预测模型可以达到较高的预测精度。

表3 预测值与实验值的PC、SC及RMSE

4 结 语

双波段融合图像质量主观评价实验通过实验数据统计与分析,提出了利用子空间辨识方法,构造融合图像综合质量预测模型,提高了模型精度,获得了较好的实验结果。实验过程中引入CDIO (Conceive、Design、Implement和Operate)工程实践教学模式[14],在图像采集、实验数据预处理、实验数据分析以及建模和评价等方面与学生反复研究和探讨,确保了实验过程的正确性和实验结果的准确性。丰富了融合图像质量评价分数数据库。开发了学生的创新性思维[15]。获得了较好的实验教学效果。部分参与实验的学生对实验兴趣较大,提出了采用机器学习或是深度学习的方法获取图像质量评价模型,但是由于主观评价数据量有限,学生对机器学习以及深度学习的理解有待进一步提高,在后期增大主观评价实验结果的基础上,有望进一步提高模型的准确性。