MOOC中学习者流失问题的预测分析

2018-06-21范逸洲刘敏欧阳嘉煜汪琼

范逸洲 刘敏 欧阳嘉煜 汪琼

【摘 要】 MOOC(Massive Open Online Course)的核心属性之一是“课程”(Course),因此“完成率”或“流失率”始终是其发展中绕不开的话题。借由完成率问题引发的一系列深入讨论和研究,例如流失问题的预测分析,取得了丰富的研究成果,对于增进我们对MOOC研究的认识和相关教学理论的理解都具有积极作用。但由于该领域内还缺乏对预测分析的系统综述,我们对这个问题的研究全貌、研究局限以及未来的研究方向并不明晰。因此,本文通过综述24篇最近五年相关的高质量文献,试图回答三个问题:哪些预测指标是有效的?哪些算法模型是相对较好的?不同模型的节俭性和耐用性如何?通过回答这些问题,本文梳理了有效的预测指标体系,对比了不同算法模型的有效性,并检验了模型的节俭性和耐用性;更进一步,本文通过讨论研究的理性观、实践意义和开展跨领域对话,指出了未来研究可能的研究取径、研究方向和研究重点。

【关键词】 慕课;学习分析;流失率;预测分析;文献综述

【中图分类号】 G420 【文献标识码】 A 【文章编号】 1009-458x(2018)4-0005-10

一、问题引入

MOOC(Massive Open Online Course)作为当今在线教育研究的热点之一,其发展一直伴随着广泛的赞誉和质疑,而其中最受关注的话题之一就是完成率问题。相关研究发现,绝大多数MOOC的完成率低于10%(Liyanagunawardena, et al., 2014; Hone & Said, 2016),而平均情况则在5%左右(Yousef, et al., 2014; Jordan, 2014)。在MOOC发展初期,课程完成率较低一度成为人们不看好MOOC的主要原因。但Ho等人很快指出:MOOC情境下,学习者的动机是多样化的、参与情况是差异化的,课程完成率不应该成为衡量课程或者学习本身是否有意义的指标,其对MOOCs课程评估的重要程度可能不像对传统课程那么关键(Ho, et al., 2014)。

越来越多的课程开发者、高校管理者和教育研究者开始理性而客观地看待MOOC的完成率问题,关注的重点也从“完成率是多少”转向了“完成率受什么影响”。于是,借由完成率问题,一系列相关的研究话题被引申出来,如学习参与和产出、学习动机、学习策略、学习过程中的社会化互动等(Gasevic, Kovanovic, Joksimovic, & Siemens, 2014)。而这其中,许多学者试图通过分析学习者的动机水平、知识水平、参与水平、互动水平等指标,对学习者能否通过课程进行预测,并基于这些预测开展相关干预(Greene, Oswald & Pomerantz, 2015; Wentao Li, etc., 2016; 王雪宇, 等, 2013; 陈云帆, 张铭, 2014; 蒋卓軒, 张岩, 李晓明, 2015)。可以说,这些研究已经取得了较为丰富的研究成果和积极的实践效果。

为了全面了解MOOC中学员流失预测研究方面迄今为止所做的工作,本文对最近几年围绕MOOC完成率或流失率的预测研究进行汇总、整理和综述,试图回答:哪些预测指标是有效的?哪些算法模型是相对较好的?不同模型的节俭性和耐用性如何?

在进行综述分析的过程中,我们发现围绕预测分析的研究大多只关注算法预测的准确性,却忽视了预测指标背后教学原理以及教师在实际教学中的技术局限性。因此,在本文的综述过程中,我们一方面对预测分析的指标和算法进行了探讨,另一方面我们加强了预测指标的理论分析、预测模型节俭性和耐用性的比较,并讨论了实际MOOC环境中可操作的技术干预手段和教学设计方法。这也是本文综述的主要特点与创新之处。

二、综述方法

本研究以 ERIC 电子期刊数据库和中国知网数据库为基础,采纳“慕课”“预测分析”“预测指标”“流失率”“MOOC\MOOCs”“Prediction”“Predictive analytics”“Predictor”“Dropout”等关键词,进行了系统的中英文检索。检索阶段共收集52篇相关文献,这些文献大多发表在经过同行评议的学术期刊和国际学术会议(如Computers in Human Behavior、International Conference on Artificial Intelligence in Education;Learning @ Scale和Learning Analytics & Knowledge Conference),并集中在2013年至2017年这五年间。

为保证文献综述的可靠性,我们对检索到的文献进行了进一步的筛选和梳理。文献筛选的标准主要依据:课程信息是否清晰,研究设计是否严谨,研究方法是否规范,数据阐述是否准确。筛选的步骤:首先,我们剔除了没有介绍研究所分析的课程对象和数据来源的文章,如对数据集包含的内容描述模糊的研究;其次,我们剔除了预测对象并不是课程完成率或流失率的文章,如研究的目标是预测学习者对某知识技能掌握情况的文章;再次,我们重点剔除了未能明确说明预测分析训练集和测试集所使用的数据情况的研究,包括数据分析的时间跨度、采纳的变量、采纳的方法等,如没有介绍使用前几周数据进行预测的文章很难判断其预测能力的实际意义;最后,我们在讨论算法预测能力的部分剔除了在研究发现部分只展示预测准确率的研究,而不讨论F1值和AUC值(评价模型预测能力的主要指标)的研究。剔除这部分研究的原因是由于MOOC本身完成率较低,只报告准确率的研究意义不大,如课程实际流失率为95%,即便盲目预测全体学生流失,该预测的准确率仍高达95%(后文将详细探讨)。

经过上述步骤的文献筛选,我们最终从检索到的52篇文献中选择了24篇符合要求的文献进入文献综述阶段。这些文献对于研究中处理的数据有详细的介绍,对于采纳的预测指标有清晰的阐述,对于使用的不同算法模型有系统的说明,对于预测结果的分析也具备有效的比较标准。这些文献的基本信息经汇总如表1所示。

表1 文献基本信息

[年份 文献来源 数量和

比例 国内期刊和会议 国外期刊和会议 2013年 Balakrishnan, et al., 2013 1篇

(4.17%) 2014年 陈云帆, 张铭, 2014 Halawa, et al., 2014; Kolft, et al., 2014; Amnueypornsakul, et al., 2014; Alariohoyos, et al., 2014; Taylor, et al., 2014 6篇

(25.00%) 2015年 蒋卓轩, 等, 2015 Fei & Yeung, 2015; Brinton & Chiang, 2015; Kennedy, et al., 2015; He, et al., 2015; Boyer & Kalyan, 2015; Greene, et al., 2015; 7篇

(29.17%) 2016年 Xing, et al., 2016; Li, et al., 2016; Ren, et al., 2016; Liang, et al., 2016; 4篇

(16.67%) 2017年 王雪宇, 等, 2017 ; 伍杰华, 付慧平, 2017; 卢晓航, 等, 2017 ; 牟智佳, 武法提, 2017 Whitehill, et al., 2017; Nagrecha, et al., 2017 6篇

(25.00%) 数量和

比例 6篇(25.00%) 18篇(75.00%) 100% ]

我们认为这24篇文献符合本文综述的筛选标准,具有一定的代表性,能够回答本文关注的研究问题,同时契合本综述的重点关切。

三、研究发现

(一)哪些预测指标是有效的

在本文综述的24篇相关文献中,每篇文献都对使用哪些预测指标开展预测有着较为具体的描述。从文献采纳的预测指标的个数来看,50%的文献采纳了6-10个预测指标,22.22%的文献使用了5个及以下指标,另外有27.78%的文献使用了11个及以上预测指标。整体而言,MOOC中预测学习者流失率或完成率的研究,单篇文献平均使用了10个预测指标。其中,使用预测指标最少的文献仅采纳了4个预测指标,而使用预测指标最多的文献则使用了37个预测指标。

我们对于所有文献中采纳的预测指标,按照倾向性指标、人机交互指标和人际交互指标三个维度进行梳理和归纳。这一指标分类延续了适应性学习和以往在线学习变量和指标分类的模型:倾向性指标主要是指学习者进入MOOC时自身具备的一些属性;人机交互指标主要是指学习者在MOOC中与学习平台、课程资料、测验作业等内容发生交互产生的行为;人际交互指标主要是指学习者在MOOC的课程论坛或讨论版中与其他学习者或课程团队之间的交互行为(范逸洲, 汪琼, 2018)。

通过分析这24篇文献采纳指标的类型分布,我们发现绝大多数被采纳的预测指标属于人机交互指标,也就是学习者在MOOC中留下的客观行为数据,这部分预测指标从数量上看占全部指标的66.67%。其中,最普遍被使用的预测指标是学习者“观看视频的次数”,共计11篇文献采纳了这一指标(例如,陈云帆, 张铭, 2014; 伍杰华, 付慧平, 2017),另外还有6篇文献使用了与视频观看相关的指标,如“观看视频的时长”“观看视频的个数”“视频资源的点击频次”“视频观看的比例”“下载视频的数量”等指标(例如,Fei & Yeung, 2015; Brinton & Chiang, 2015)。还有一些文献加入了观看行为方面的指标,如“是否在前一个单元,存在跳过视频的情况”“完整看完视频的比例”“视频观看中快进的次数”“回放视频的个数或比例”等指标(例如,Halawa, Greene, & Mitchell, 2014; Kloft, Stiehler, Zheng, & Pinkwart, 2014; Brinton & Chiang, 2015)。视频资源作为MOOC的核心资源,其学习的频次和时长往往能够很好地表征学习者在课程中的参与程度,而在视频上表现出的行为也往往可以反映出学习者关于课程的动机或态度。如有研究认为在上一个学习单元中大量跳过视频或快进视频,可能意味着学习者对课程内容不感兴趣,或认为视频难度不适合自己等(Halawa, Greene, & Mitchell, 2014)。因此,围绕视频学习行为的相关指标,往往可以有效地预测学习者是否会从课程中流失。

除了视频学习相关的行为表现指标,学习者在课程学习过程中参加的测验次数、提交的作业个数、访问学习资源(如Wiki页面)的次数,以及这些行为频次所覆盖的课程跨度,也是预测学生流失很有用的指标(例如,蒋卓轩, 张岩, 李晓明, 2015; 王雪宇, 邹刚, 李骁, 2017; Amnueypornsakul, Bhat, & Chinprutthiwong, 2014)。同时,有的文献指出,在诸多不同种类的页面浏览行为中,“课程进度页访问次数”表现出了优秀的预测能力(Balakrishnan & Coetzee, 2013)。也就是说,在MOOC这种高度开放的自主学习环境中,学习者是否有意识地对学习进度进行了解和掌控,能够很好地预测其最终的学习结果。

除了人机交互指标,人际交互指标也被多篇文献使用。在MOOC预测流失率和完成率的研究中,近一半的文獻采纳了学习者的人际交互指标,从数量上占全部指标的26.67%。其中,“论坛发帖次数”得到了最为广泛的验证,在全部24篇文献中有6篇文献使用了这一预测指标,并验证了其对预测流失率的显著性影响(例如,Fei & Yeung, 2015; Xing, Stein, & Marcinkowski, 2016; 伍杰华, 付慧平, 2017)。围绕论坛中的交互行为,有学者认为并非所有MOOC学员都有意愿在论坛中表露自己的观点,也有大量的学员属于论坛中的“潜水者”(Alariohoyos, Perezsanagustin, Delgadokloos, Hugo, & Munozorganero, 2014)。因此,有很多学者采用“论坛的浏览或访问次数”这个更宽泛的指标来对学习者的学习结果进行预测,这些预测同样取得了很好的效果(蒋卓轩, 张岩, 李晓明, 2015;Balakrishnan & Coetzee, 2013;Xing, Stein, & Marcinkowski, 2016)。

除了论坛访问次数和发帖次数,论坛中反映学习者社会网络联系的行为指标也表现出良好的预测能力,如在人际交互中的“点赞次数”“回帖评论数量”“多回合交互频次”等(陈云帆, 张铭, 2014; Fei & Yeung, 2015)。同时,有学者将单个课程外的数据信息引入MOOC的流失率预测,如社交媒体的使用情况或者其他MOOC中的交互频次等(王雪宇, 邹刚, 李骁, 2017)。这往往反映了学习者的网络学习习惯和使用习惯,而这些习惯则可能迁移到MOOC的学习中帮助学习者更好地完成课程。

在人机交互和人际交互这两大类指标之外,也有少量的研究(6.67%)检验了学习者倾向性指标对学习结果的预测。得到检验的指标包括学习者的年龄、城市、受教育水平、先验知识和能力基础等(Whitehill, et al., 2017; Kennedy, et al., 2015)。虽然这些指标在单个研究中都表现出显著性,但在MOOC预测分析这一研究领域内还没有得到其他研究的交叉验证。

在此,我们基于本文综述的24篇文献,梳理了MOOC情境下最常被用于预测课程完成率或流失率的10个指标,见表2。

表2 常用预测指标示例

[类型 预测指标 参考文献 倾向性

指标 先验知识 Kennedy, et al., 2015 人机交互指标 视频观看的次数 Brinton & Chiang, 2015

Kloft, et al., 2014

Halawa, Greene, & Mitchell, 2014

Balakrishnan & Coetzee, 2013 视频观看的时长 跳过视频或快进视频次数 测验或作业完成个数 课程进度页访问次数 人际交互指标 论坛发帖次数 蒋卓轩, 张岩, 李晓明, 2015;

陈云帆, 张铭, 2014

王雪宇, 邹刚, 李骁, 2017

Fei & Yeung, 2015 论坛访问次数 回帖评论或点赞次数 社交网络使用情况 ]

(二)哪些算法模型是相对较好的

对于流失率或完成率的预测分析而言,采用哪些预测指标仅仅是研究的第一步,更重要的是如何组织和使用这些预测指标,这就涉及算法模型的问题。通过梳理24篇预测分析的研究文献,我们发现不同学者使用的算法模型是多样化的,包括决策树、逻辑回归、神经网络、支持向量机等方法。

这些算法在预测MOOC学习者的流失率时,表现出的有效性存在一定的共性,也存在一定的差异。在对比这些共性和差异之前,我们首先需要讨论比较不同研究的标准和条件。

首先,预测MOOC学习者的流失与否本质上是一个二分类问题(流失或保留),而比较二分类问题预测模型的有效性,常用的指标包括精确率(Precision)、召回率(Recall)、F1 值(F-measure)、ROC(Receiver Operating Characteristic)、AUC(Area Under Curve)等。其中,F1值(6篇文献)和AUC值(14篇文献)是文献中最常使用的调和参数,一定程度上避免了上文提及的单纯追求精确率而导致的过度拟合问题。在本文的综述分析中,我们采用了AUC值作为衡量不同研究、不同算法预测能力的指标。

其次,在比较不同研究和不同算法时需要明确比较的前提条件,那就是所用数据的时间跨度。一般来说,同一个算法使用时间跨度越长的数据集开展训练其预测的准确性(也就是AUC值)越高,因此我们在比较不同研究和不同算法时需要在同样时间跨度的基础上进行。基于对文献的整理和分析,大多数文献中数据集的时间跨度(以周为单位)集中在3周至6周,而大多数被研究的MOOC的课程持续周期则集中在6周至12周。综合衡量后,本文决定使用“第四周”为时间点比较不同研究和不同算法的预测能力。一方面是因為第四周作为大多数MOOC的期中时间点,具备充分的数据基础开展预测分析,同时也具备基于预测分析开展教学干预的时间条件;另一方面因为是有些文献只汇报了课程前半段的预测结果(如2-3-4周),也有些文献只汇报了课程后半段的预测结果(如4-5-6周),而本文综述的大多数研究都报告了第四周的预测结果。因此,最终在开展比较分析时我们采纳了“第四周”这一时间节点的数据。

基于上面所阐述的筛选指标,我们进一步从24篇文献中选出了“报告第四周AUC值”的文献共计13篇。这些文献累计分析了89门MOOC,样本量超过120万人次的MOOC学习者,使用了四大类算法(包括了决策树算法、逻辑回归算法、神经网络算法和支持向量机算法;对应图中的DT、LR、NN和SVM)。本综述比较了这13篇文献的预测结果,从数据上体现为22个AUC值(有些文献检验了不止一种算法)的对比情况,而图1中的箱图综合呈现了这一比较结果。

图1 四种常见预测算法在第四周的预测能力

通过图1可以看出,大多数算法都表现出了较好的预测能力,这些算法在第四周预测学习者流失的AUC均值都大于0.75。同时,不同算法之间也并不存在巨大的差异,从AUC均值的角度看决策树算法(AUC均值0.865)、回归算法(AUC均值0.84)和神经网络算法(AUC均值0.82)实际的预测能力较为接近。

从相对有效或相对更好的角度而言,决策树算法的平均表现最好,多个研究平均取得的AUC值达到了0.865,同时决策树算法在不同文献中得出的预测效果也具备较高的稳定性(图1箱图中箱体较短,方差较小)。从算法AUC值的平均情况而言,支持向量机算法则表现出相对较差的预测能力,低于决策树算法、回归算法和神经网络的算法。

这样的综述分析结果,同样得到了其他文献的支持。例如,在一项基于39门学堂在线MOOC的预测分析中,梯度提升决策树算法和随机森林算法优于逻辑回归算法和支持向量機算法(Liang & Zheng, 2016);在另外两项基于Edx和Coursera平台上的多门MOOC的预测分析中,长短期记忆神经网络算法(Fei & Yeung, 2015)和逻辑回归算法(蒋卓轩, 张岩, 李晓明, 2015)都表现出了优于支持向量机算法的预测能力。

值得注意的是,虽然采纳不同算法会影响研究的预测能力,但是同样的算法在不同的研究中也表现出了不同的预测能力。例如,在有的研究中逻辑回归的算法可以在第四周就取得了0.928的AUC值(He, Bailey, Rubinstein, et al., 2015),但同样类型的算法却在其他研究中表现较差,仅在第四周取得了低于0.70的AUC值(Liang & Zheng, 2016;Fei & Yeung, 2015)。

基于上面的分析和阐述我们发现:首先,不同算法的预测能力虽然存在一定差异,但整体都可以取得让人满意的预测结果,特别是获得普遍认可的决策树算法、回归算法和神经网络算法并没有十分显著的差异;其次,同样的算法在不同研究之间可能表现出不同的预测能力,这启发研究者更应该从教学研究的角度,而不仅仅是算法层面来思考问题。研究者更应该关注研究情境和具体的预测过程,如课程的性质如何、学员群体的特征、采纳指标的含义等。另外,追求算法最优化的努力往往并不能取得实质性的突破,大量致力于优化算法的研究往往仅能提高0.01至0.05的AUC值。

因此,本文认为以往研究过分关注算法层面的比较是片面的,特别是致力于提高算法预测精确性的努力是比较片面的。我们在关注预测精确性的同时,也需要关注MOOC流失率预测本身的教学原理,以及模型的节俭性和耐用性,而这是本综述的另外一个关注点。

(三)不同模型的节俭性和耐用性如何

一个优秀的预测模型不仅要具备一定的拟合准确性(Fitting),还应该具备足够的节俭性(Frugality)和耐用性(Robust)。准确性决定了模型的有效性,节俭性则决定了模型的效率和速度,耐用性则决定了模型的推广能力和推广成本。

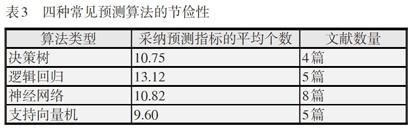

计算模型节俭性的方式有很多,其中最简单也是最广受采纳的方法即“计算模型使用的变量数量”,在有些研究中也被称为“线索数量”。而在MOOC预测分析中,节俭性指的就是模型中采纳的变量个数。通过统计上述13篇使用了四种常见预测算法的文献(某些文献使用了多种算法)中采纳的预测指标个数,得到了表3。

表3 四种常见预测算法的节俭性

[算法类型 采纳预测指标的平均个数 文献数量 决策树 10.75 4篇 逻辑回归 13.12 5篇 神经网络 10.82 8篇 支持向量机 9.60 5篇 ]

结合表3的数据可以看出,不同算法类型采纳的平均指标数量存在一定差异,其中逻辑回归的方法使用指标数量相对较多,而支持向量机的方法使用指标数量则相对较少。但总的来说,四种常用的预测算法都平均需要使用10个左右的预测指标。

计算模型耐用性的方式也有很多,其中最直观的方式即将某个在课程数据集中优化后的模型迁移应用到其他课程的数据集中,并考察模型预测的能力差异。在本文综述和分析的24篇文献中,仅有4篇文献开展了模型的耐用性检验。这些文献并没有得出具有可比性的研究结论,有些文献中预测模型的耐用性较差,也有些文献获得了较好的耐用性检验结果。

例如,Whitehill等人在一项基于哈佛大学40门MOOC的研究中指出:基于某些课程训练出的预测模型,在其他课程中迁移应用时往往难以取得理想的结果,平均来看会出现0.1-0.15(AUC值)的差距。这样的差距在课程早期的预测中表现得更加明显,也就是说模型的耐用性较差(Whitehill, Mohan, Seaton, et al., 2017);在陈云帆和张铭的研究中,基于随机森林的预测模型在被迁移应用到另外一门课程时表现出了同样优秀的预测能力(陈云帆, 张铭, 2015)。因此,依据目前已有的MOOC预测分析文献还很难得出哪些模型或算法具备较好的耐用性,也很难分析哪些因素影响了预测模型的耐用性。围绕预测算法准确性、节俭性和耐用性的讨论,我们将在下文详细论述。

四、讨论与未来研究方向

上面我们综述了MOOC研究领域中预测分析的典型研究,也在梳理预测指标有用性和预测模型准确性、节俭性和耐用性的过程中围绕具体研究进行了讨论。下面将围绕本文的三个核心观点展开讨论。

(一)引入新的研究取径:有限理性的理性观

“MOOC领域的预测分析问题需要最优解吗?”这个问题值得研究者们进行思考。结合本文的分析可以看出,绝大多数文献都致力于发现预测准确性最佳的指标、模型和算法,但实际情况是绝大多数算法都能达到让人基本满意的结果(前提是高质量的研究)。优化算法的努力也并没有取得跨越式的进展,与之相关的是,随着采纳更多的指标、使用更复杂的算法模型的节俭性和耐用性在下降。这就从另一个侧面削弱了预测分析的价值,使其成为极少数数据分析专家才能发言的封闭领域。

针对这个问题,赫伯特·西蒙于 20 世纪50年代提出的“有限理性”观点值得我们深思(Simon, 1956)。他用一把剪刀来比喻有限理性:剪刀的一个刀片是现实中人类的“认知局限性”,而另一个刀片是行为或决策所处的“环境结构”。过去的预测研究强调打破认知局限性,仅仅是从数据中挖掘有价值的信息,而忽视MOOC特定的环境结构。例如,MOOC流失问题的一个特定属性就是——只有极少数的学习者(平均5%左右)能真正通过课程,绝大多数的学习者都难以完成课程。而针对这样特殊的环境属性,有限理性提供了适合解决这种情景的工具包,如采纳最佳(Take the best model)、快估启发式(QuickEst heuristic model)等(吉仁泽, 泽尔腾, 2016),而实证研究也证明简单模型并不比复杂模型差。

Czerlinski等人在20世纪90年代开展了一系列有限理性的相关研究,其研究证明:简单的有限理性模型往往比复杂的概率模型更加有效,这些研究包括預测人口规模、预测高中失学率等(Czerlinski, et al., 1999),模型比较如表4。

表4 跨越20种环境的模型对比

[策略 节俭性 准确性(%正确) 拟合 耐用性 最少化 2.2 69 65 采纳最佳 2.4 75 71 道斯规则 7.7 73 69 多元回归 7.7 77 68 ]

结合表4的对比可以看出,做出好的预测分析或行为决策并不需要仰仗搜集所有可用信息或复杂的算法,恰恰相反的是仅依靠重要的线索或有限的好线索我们就能够在多种多样的研究情境中获得相当不错的预测结果。

至此,MOOC预测分析的研究中还没有学者讨论和使用有限理性的分析模型,或对以往追求最优化的研究取径进行反思。因此,本文认为预测分析的研究领域首先应该抛弃追求最优解的惯性思维,引入有限理性的理性观,并以此指导我们开发“满意即可”的预测模型,而这也应该成为未来的研究方向之一。

(二)转换领域的研究重点:从预测分析到教学干预

既然预测分析“满意即可”,那么今后领域的研究重点应该是什么?本文的观点认为,应该将研究重点由优化预测算法转换到教学干预相关的研究中。

预测分析与教学干预是学习分析中紧密结合的两个步骤,本综述分析的24篇文献中有17篇或多或少谈到了“干预”的问题,这些文献从干预措施、干预时机和干预对象三个角度讨论干预问题。

关于干预措施的问题,本文综述的文献大致可以分成两类:基于教师做干预和基于机器做干预。

在基于教师做干预的讨论中,以往的文献一方面讨论了预测分析的研究发现对教学的启示,另一方面讨论了教师如何使用预测分析的结果做出干预。有些研究指出教师可以利用具体的教学设计技巧开展干预、降低流失率,如发送邮件提醒测验时间、显性化课程结构和教学内容间的依赖关系、设置灵活的作业截止时间、利用不同随机方法合理控制测验难度、设计奖励机制鼓励学习者每周访问论坛并发帖、开展有组织的线上线下互动等方式,引导、支持和鼓励学习者形成自己的学习路径,进而更好地支持MOOC中多样化的自主学习需求、降低流失率(陈云帆, 张铭, 2014; 伍杰华, 付慧平, 2017; 卢晓航, 等, 2017);有学者认为教师可以从系统化教学设计的思路进行课程迭代,他们认为教师应该有意识地持续评估选课学习者的知识储备、学习目标、自主学习能力等关键因素,并提供多样化的学习路径、教学支架和拓展资源(卢晓航, 等, 2017);有学者认为教师在MOOC中开展干预不应该太具体,而更应该从根本上思考如何采取措施激励学习者的动机、增强学习者的目标感、营造积极的归属感等,以开展大规模的整体干预(Kizilcec & Halawa, 2015)。

基于机器做干预的取径则与Kizilcec等人的观点不同,这些文献延续了适应性学习领域的研究传统,强调精确、及时、恰当个性化干预。秉持这种干预取径的学者讨论了多样化的干预方法,例如:可以通过识别学习者的知识基础和需求自动化地从海量信息中确定学习者需要的知识点和其掌握情况,随后由机器判断其是否需要辅导或建议,并个性化地发送邮件或推荐资源(蒋卓轩, 等, 2015);可以通过识别学习者是否处于高流失风险的状态或趋势,在MOOC学习者未流失之前自动化地推送询问邮件(如为什么降低了活跃度等),并通过这些措施激励学习者持续地积极参与课程或鼓励学习者尽快回到课程继续学习(Whitehill, et al., 2015)。

除了如何干预的问题,何时进行干预的问题同样重要。大多数讨论干预时机的文献都认为,尽早地发现或识别存在高流失风险的学习者是重要的(Ren, et al., 2016),特别是当学习者仍然在课程中有学习行为、但已表现出流失倾向时干预是最有效的(Whitehill, et al., 2015)。因此有学者指出,只有在课程早期的预测才是具有实际意义的,以往大量的预测研究都使用了课程半程以上或全程数据,这些研究难以真正指导现实MOOCs中的教学干预,因为课程后半段时学习者已离开课程很久,实施干预也为时已晚(Halawa, Greene, & Mitchell, 2014)。但也有学者认为,过早干预可能也会适得其反,只有在学习者真正表现出流失风险时开始干预才是有效的。因此,有学者认为“实时干预”或“及时干预”对于干预的效果影响巨大,当学习者表现出高流失倾向时立即进行干预会明显提高学习者继续学习的可能性(Ren, et al., 2016; Whitehill, et al., 2015),而这往往需要机器干预或提供给教师及时的流失预测报告。

延续上面的讨论,学者们也讨论了对谁采取干预最恰当的问题。有学者认为,以往预测分析的研究过多地关注如何识别有高流失风险的学习者,但是忽略了一个事实,那就是这些学习者中的大多数都不会因为干预而回到课程,因为他们离开课程的原因是深层次的,如课程难度超出接受范围、找到了更合适的替代性课程、语言障碍的问题等。因此,预测分析不仅要识别哪些是有高流失风险的学习者,还应该识别那些可以被干预措施召回的学习者(Robinson, et al., 2016),或者重点识别那些在干预措施中受益最大的学习者(Whitehill, et al., 2015)。另外,也有学者认为我们不应该过度打扰那些被错误识别为高流失风险而实际可以自主继续学习的学习者,解决这一问题的方法之一就是按照流失风险的高低对学习者进行排序,动态、分批次地实施干预(Xing, Stein, & Marcinkowski, 2016),这就对动态的临时性预测模型提出要求,也就是说我们只干预当下时间点表现出高流失风险的学习者。

围绕教学干预的讨论可以看出,虽然多数文献都提及了教学干预,但是大多停留在观点讨论和设想层面,真正基于预测分析开展教学干预的研究较少。另外,考虑MOOC平台实际添加技术插件的困难性以及大多数教师难以企及的技术壁垒,相对于机器干预的取径,本文认为教师干预的取径具备更大的研究价值,而在讨论教学干预问题时我们应该时刻注意何时干预和干预谁的问题,围绕这些问题的讨论都将成为未来的研究方向。

(三)超越MOOC的领域对话:来自学习分析的启发

MOOC作为学习分析这个大领域中的一个研究情境,不应该只在MOOC相关研究的小圈子里面进行对话,而是应该超越MOOC情境,更多地从其他学习分析的研究情境中获得启发。

在学习分析领域中,预测分析作为基础性的核心问题,在过去十多年的研究中取得了丰富而系统的研究成果。学习分析这个大领域中预测分析问题的发现,已经在以往的一篇文章中进行了详细的综述(范逸洲, 汪琼, 2018)。在这篇综述中,我们通过系统的文献检索和综述,从预测指标适用的学习场所和任务类型出发梳理了倾向性指标、人机交互指标和人际交互指标三种类型的常用预测指标(范逸洲, 汪琼, 2018)。MOOC中的预测分析与整个学习分析领域的预测分析相比,在有些问题上更加聚焦和深入,如具体探讨了视频观看行为、论坛参与行为等对学习结果的影响。但也有些问题探讨得相对较少,如在倾向性指标方面学习分析领域中备受重视的过往学习表现(Bainbridge, et al., 2015)、初始知识(Alexander, et al., 1988)、技能基础(Snow, et al., 2003)和学习驱动力(Shum, et al., 2012)等概念,在MOOC情境中并没有得到广泛的交叉验证,仅有少数文献提及了相关的预测指标。这一方面是由于MOOC学习相对于课堂学习或传统在线学习的延续性,学习者往往是以课程为单位,而不是以跨学期或多学年为线索进行学习。但也有研究开始尝试,将学习者多门课程的学习记录进行关联,对某个特定的课程学习进行预测(王雪宇, 邹刚, 李骁, 2017)。也有研究开始关注课程伊始的入门测验,对于学习者学习体验和最终学习产出的影响(Kennedy, et al., 2015)。但是,如何有效检验学习者知识基礎与课程的匹配程度?如何为学习者提供多样化的学习支架和扩展资源?如何激发或增强学习者的学习驱动力?这些深层次的问题都还有待未来的研究来解决。

在人机交互指标方面,目前MOOC的研究大多聚焦在正面的学习行为,如观看视频、参与论坛、提交作业等,但是Baker 等人认为负面的学习行为对潜在学习风险也具备较强的预测能力 (Baker, et al., 2010)。在MOOC的学习过程中,也存在着多种多样的负面学习行为,如滥用帮助的行为、复制他人发帖或作业的作弊行为、系统性试错的行为或在论坛上寻求答案等行为。这些在Baker等人的研究中称之为“玩弄系统”(gaming the system)的行为(Baker, et al., 2004),也能够对学习者的最终学习结果和产出起到预测作用。另外,在学习分析领域中普遍关注学习行为模型转变(Turning Track)的情况(Brown, 2012),但这并没有在MOOC研究中受到普遍的关注,这就要求我们不仅做时间点的横截面研究,也要开展时间段的时序研究。通过识别学习行为模式对学习者进行预测、聚类,这类分析也应成为未来MOOC研究的发展方向之一。

而在人际交互指标方面,以往的MOOC研究主要关注了交互的频次和时长,但相对较少讨论学习分析领域中普遍关注的网络链接和中心度问题(Dawson, 2010)、社群意识问题(Gasevic, et al., 2012)、对话模式问题(Ferguson, et al., 2011)。这可能与MOOC论坛的交互更加复杂、发帖质量差异较大、交互高频但相对分散等特点有关,但这也同样为人际交互的相关研究提供了新的更有价值的研究情境。本综述认为,MOOC论坛中不同学习者扮演了不同的论坛角色,其共同营造的MOOC学习生态可能是未来MOOC研究的方向之一。特别是教师和课程团队如何在这一生态中合理地发挥作用,如何帮助或促进这一生态的形成,都是非常值得研究的问题。当然,关于这些问题的讨论也必将引导MOOC领域的研究重点从描述完成率、预测流失率,进一步发展和转换到尝试教学干预、探讨教学原理以及完善教学设计上。

五、总结

总的来说,本文认为MOOC的完成率问题始终会是MOOC领域的基础问题和重点问题,而围绕这一问题的预测分析和教学干预也始终是重要的研究方向。因为MOOC的核心属性是课程(Course),而MOOC的课程属性决定了“完成课程”始终是绕不开的话题。

当然,我们认同很多学者的观点:MOOC学习者秉持着多种多样的动机、需求和目标,有些学习者可能并不是为了“学完课程”而来。但正如文章开篇时阐述的那样,借由完成率问题引发的一系列深入讨论将丰富我们对MOOC学习的认识,增进我们对大规模课程教学设计的理解,补足以往研究和学习理论的不足。最终这些研究和讨论,都会帮助我们更好地服务学习者,并促进教学研究领域的长足发展,这也是本综述的意义和价值所在。

[参考文献]

陈云帆,张铭. 2014. MOOC课程学生流失现象分析与预警[J]. 工业和信息化教育(9):30-36.

范逸洲,汪琼. 2018. 学业成就与学业风险的预测——基于学习分析领域中预测指标的文献综述[J]. 中国远程教育(1):5-15.

吉仁泽,泽尔腾. 2016. 有限理性:适应性工具箱[M]. 北京:清华大学出版社.

蒋卓轩,张岩,李晓明. 2015. 基于MOOC数据的学习行为分析与预测[J]. 计算机研究与发展,52(3):614-628.

盧晓航,王胜清,黄俊杰,等. 2017. 一种基于滑动窗口模型的MOOCs辍学率预测方法[J]. 现代图书情报技术,1(4):67-75.

牟智佳,武法提. 2017. MOOC学习结果预测指标探索与学习群体特征分析[J]. 现代远程教育研究(3):58-66.

王雪宇,邹刚,李骁. 2017. 基于MOOC数据的学习者辍课预测研究[J]. 现代教育技术,27(6):94-100.

伍杰华,付慧平. 2017. MOOC学习行为的统计、预测与展望[J]. 工业和信息化教育(2):81-89.

Alexander, Particia A, Judy, et al. (1988). The Interaction of Domain-Specific and Strategic Knowledge in Academic Performance. Review of Educational Research, (58):375-404.

Amnueypornsakul B, Bhat S, Chinprutthiwong P. (2014). Predicting Attrition Along the Way: The UIUC Model. EMNLP 2014 Workshop on Analysis of Large Scale Social Interaction in Moocs: 55-59.

Bainbridge, J., Melitski, J., Zahradnik, A., Eitel J. M. Lauría, Jayaprakash, S., & Baron, J. (2015). Using learning analytics to predict at-risk students in online graduate public affairs and administration education. Journal of Public Affairs Education, 21(2), 247-262.

Baker R S J D, D'Mello S K, Rodrigo M M T, et al. (2010). Better to be frustrated than bored: The incidence, persistence, and impact of learners' cognitive-affective states during interactions with three different computer-based learning environments. International Journal of Human-Computer Studies, 68(4):223-241.

Baker R S, Corbett A T, Koedinger K R. (2004). Detecting Student Misuse of Intelligent Tutoring Systems. International Conference on Intelligent Tutoring Systems: 531-540.

Balakrishnan, G., & Coetzee, D. (2014). Predicting student retention in massive open online courses using hidden markov models. Technical Report Retrieved May 17, 2013, from http://www.eecs.berkeley.edu/Pubs/TechRpts/2013/EECS-2013-109.html

Boyer S, Veeramachaneni K. (2015) Transfer Learning for Predictive Models in Massive Open Online Courses(pp.54-63). Artificial Intelligence in Education. Springer International Publishing.

Brinton C G, Chiang M. (2015). MOOC performance prediction via clickstream data and social learning networks. Computer Communications. IEEE :2299-2307.

Brown M. (2012). Learning Analytics Moving from Concept to Practice. EDUCAUSE Learning Initiative:EDUCAUSE, 1-5.

Corrin L, Corrin L, Corrin L, et al. (2015). Predicting success: how learners' prior knowledge, skills and activities predict MOOC performance. International Conference on Learning Analytics and Knowledge. ACM:136-140.

Czerlinski J, Gigerenzer G, Goldstein D G. (1999). How good are simple heuristics?. Simple Heuristics That Make Us Smart (pp.97-118). Oxford University Press.

Dawson S. (2010). ‘Seeing the learning community: An exploration of the development of a resource for monitoring online student networking. British Journal of Educational Technology, 41(5):736-752.

Fei M, Yeung D Y. (2015). Temporal Models for Predicting Student Dropout in Massive Open Online Courses. IEEE International Conference on Data Mining Workshop. IEEE: 256-263.

Ferguson R, Shum S B. (2011). Learning analytics to identify exploratory dialogue within synchronous text chat. International Conference on Learning Analytics and Knowledge. ACM: 99-103.

Gasevic D, Jovanovic J, Kai P, et al. (2012). Self-regulated Workplace Learning: A Pedagogical Framework and Semantic Web-based Environment. Journal of Educational Technology & Society, 15(4):75-88.

Ga?evic D, Kovanovic V, Joksimovic S, et al. (2014). Where Is Research on Massive Open Online Courses Headed? A Data Analysis of the MOOC Research Initiative. International Review of Research in Open & Distance Learning, 15(5):134-176.

Greene J A, Oswald C A, Pomerantz J. (2015). Predictors of Retention and Achievement in a Massive Open Online Course. American Educational Research Journal, 52(5).

Halawa, S., Greene, D., & Mitchell, J. (2014). Dropout prediction in MOOCs using learner activity features. EMOOCS: 3-12.

He J, Bailey J, Rubinstein B I P, et al. (2015). Identifying At-Risk Students in Massive Open Online Courses. AAAI, 1749-1755.

Ho A D, Reich J, Nesterko S O, et al. (2014) HarvardX and MITx: The First Year of Open Online Courses, Fall 2012-Summer 2013. Retrieved January 21, 2014, from https://papers.ssrn.com/sol3/papers.cfm?abstract_id=2381263

Hone K S, Said G R E. (2016). Exploring the factors affecting MOOC retention: A survey study. Computers & Education, 98:157-168.

Jordan K. (2014). Initial Trends in Enrolment and Completion of Massive Open Online Courses. International Review of Research in Open & Distance Learning, 15(1):133-160.

Kennedy, G., Coffrin, C., et al. (2015). Predicting success: how learners' prior knowledge, skills and activities predict MOOC performance. International Conference on Learning Analytics and Knowledge. ACM: 136-140.

Kizilcec, R. F., & Halawa, S. (2015). Attrition and achievement gaps in online learning. Learning@ Scale. ACM: 57-66.

Kloft M, Stiehler F, Zheng Z, et al. (2014). Predicting MOOC Dropout over Weeks Using Machine Learning Methods. EMNLP 2014 Workshop on Analysis of Large Scale Social Interaction in Moocs: 60-65.

Li W, Gao M, Li H, et al. (2016). Dropout prediction in MOOCs using behavior features and multi-view semi-supervised learning. International Joint Conference on Neural Networks. IEEE: 3130-3137.

Liang J, Li C, Zheng L. (2016). Machine learning application in MOOCs: Dropout prediction. International Conference on Computer Science & Education. IEEE: 52-58.

Liyanagunawardena, Tharindu Rekha Adams, Andrew Alexandar Williams, Shirley Ann. (2014). MOOCs: A Systematic Study of the Published Literature 2008-2012. International Review of Research in Open & Distance Learning, 14(3):202-227.

Nagrecha S, Dillon J Z, Chawla N V. (2017). MOOC Dropout Prediction: Lessons Learned from Making Pipelines Interpretable. International Conference on World Wide Web Companion: 351-359.

Ren Z, Rangwala H, Johri A. (2016). Predicting Performance on MOOC Assessments using Multi-Regression Models. Retrieved May 8, 2016, from https://arxiv.org/abs/1605.02269

Robinson C, Yeomans M, Reich J, et al. (2016). Forecasting student achievement in MOOCs with natural language processing. International Conference on Learning Analytics & Knowledge. ACM: 383-387.

Shum S B, Crick R D. (2012). Learning dispositions and transferable competencies: pedagogy, modelling and learning analytics. International Conference on Learning Analytics & Knowledge: 92-101.

Simon H A. (1956). ‘Rational Choice and the Structure of Environments. Psychological Review, 63(2):129-138.

Snow C E, Biancarosa G. (2003). Adolescent Literacy and the Achievement Gap: What Do We Know and Where Do We Go From Here? New York, NY: Carnegie Corporation.

Taylor C, Veeramachaneni K, O'Reilly U M. (2014). Likely to stop? Predicting Stopout in Massive Open Online Courses. Retrieved August 14, 2014, from https://arxiv.org/abs/1408.3382

Whitehill J, Mohan K, Seaton D, et al. (2017). MOOC Dropout Prediction: How to Measure Accuracy?. Proceedings of the Fourth ACM Conference on Learning @ Scale. ACM: 161-164.

Xing W, Chen X, Stein J, et al. (2016). Temporal predication of dropouts in MOOCs: Reaching the low hanging fruit through stacking generalization. Computers in Human Behavior, (58) 119-129.

Yang D, Sinha T, Adamson D, et al. (2013). "Turn on, Tune in, Drop out": Anticipating student dropouts in Massive Open Online Courses. NIPS Workshop on Data Driven Education.

Yousef A M F, Chatti M A, Schroeder U, et al. (2014). What Drives a Successful MOOC? An Empirical Examination of Criteria to Assure Design Quality of MOOCs. International Conference on Advanced Learning Technologies. IEEE: 44-48.

收稿日期:2017-10-24

定稿日期:2017-12-29

作者簡介:范逸洲,博士研究生;刘敏,硕士研究生;欧阳嘉煜,硕士研究生;汪琼,博士,教授,博士生导师。北京大学教育学院(100871)。

责任编辑 郝 丹