基于卷积神经网络的多波段融合图像彩色化方法

2018-06-21蔺素珍黄福升赵竞超

韩 泽, 蔺素珍, 黄福升, 赵竞超, 刘 震

(中北大学 大数据学院, 山西 太原 030051)

0 引 言

多波段图像融合是当前高精度智能探测系统的关键技术之一. 现有的图像融合技术基于空域、 频域[1]、 混合域[2]或深度学习[3], 可以将不同谱段, 不同模态的信息较好地综合到一幅灰度图像中用于后续的目标自动识别. 不过在重大探测中, 为更精准地识别目标和正确决策, 往往需要人在回路, 由于灰度图像用于人眼观察在信息分辨敏感程度、 真实感和舒适感方面存在不足, 所以, 目前在多波段图像自适应融合的同时对其彩色化具有广泛的需求.

现阶段将图像融合结果彩色化主要有3种方法:① 颜色迁移[4-5]: 该类方法通过匹配灰度图像与参考图像的颜色分布、 纹理等信息, 将参考图像的颜色迁移到融合结果中, 但需要依赖先验知识选择参考图像, 结果的好坏依赖于参考图像选择, 不利于工程化. ② 伪彩色融合[6-7]: 该类方法将输入图像组合转换到颜色空间内, 利用红外与可见光图像的差异信息构成各色度分量, 但图像的颜色往往不符合人眼的认知习惯, 会影响人观察时的舒适感. ③ 自动彩色化[8-10]: 新近有学者将深度学习应用于灰度图像的自动彩色化, 该类方法通过一种端到端的网络去学习彩色化模型, 使得网络输入灰度图像输出彩色化的结果, 相比于前两种方法, 该类方法颜色恢复更接近自然, 并且使用方便, 但该类方法当前多用于可见光图像处理, 并且需要大量的数据进行训练, 而多波段融合图像缺乏训练数据, 无法得到有效的模型. 综上所述, 单一的方法难以对多波段融合图像有效处理, 因此多波段融合图像的彩色化还需进一步探索.

本文以多波段融合图像为对像, 基于深度卷积神经网络(Deep Convolution Neural Network, DCNN)对其进行彩色化, 为解决训练数据缺乏的问题, 在可见光模型的训练库中用加入颜色迁移和伪彩色等方法得到效果较好的图像, 并且构建网络时在网络的输入层以及中间特征处理层添加额外的卷积操作, 输入层的卷积能使网络在输入前对图像预处理, 并且所用的滤波器是通过学习得到的, 特征提取层之后的卷积能使网络具有对噪声特征处理以及在红外特征与可见光特征之间建立关联的能力, 从而提高网络对融合结果彩色化的稳定性.

1 图像彩色化方法

1.1 YUV颜色空间

在RGB颜色空间内, 任意色彩都可用R,G,B3个不同颜色分量相加得到, 而YUV空间用图像的灰度值(Y)和色差(UV)共同控制图像的色彩, 其中Y通道是图像的灰度信息与UV通道共同控制颜色信息.YUV彩色空间的优势是它的灰度和颜色是分离的, 即使UV信号丢失, 也能有灰度图像利用. 根据这一特性, 可将灰度融合结果看作仅有Y通道而UV通道信息丢失的残缺图像, 彩色化过程就是根据Y通道的信息去生成UV通道, 因此本文将灰度融合结果当作Y通道图像, 利用DCNN来生成UV通道图像从而得到彩色融合结果.

1.2 总体思路

本文的整体思路如图 1 所示.

图 1 总体思路图Fig.1 The basic ideas image

1) 将彩色训练图像从RGB颜色空间转换到YUV颜色空间.

2) 在网络输入端输入训练图像的Y通道图像, 以UV通道图像为目标图像训练网络, 使其能根据输入的Y通道信息自动生成UV通道图像.

3) 待网络误差稳定后, 将灰度融合结果当作Y通道信息输入网络中, 网络的输出为预测的UV通道图像.

4) 将灰度融合图像当作Y通道图像, 将其与网络输出的UV通道图像组合然后转换到RGB空间即可得到彩色化的融合结果.

1.3 网络的结构和训练

网络的结构如图 2 所示, 为了降低网络训练的难度, 选择在图像分类里应用较多的VGG网络作为底层特征提取网络, 考虑到网络的深度和内存大小, VGG仅用了前4层; 由于VGG网络中存在下采样操作, 要想输出和原图像大小相同的图像, 要再进行逆变换, 直接用卷积网络去实现逆变换, 一方面逆变换部分需要学到图像的超分辨率, 这就需要很深的网络结构; 另一方面网络层数过深又难以训练. 利用残差编码器[11]跳跃连接, 解决了深度神经网络训练困难的问题, 并且跨接的方式还使后面的网络能得到输入原始信息, 很适合重构任务. 本文选择残差编码器作为网络的重构部分, 让C1,C2,C3和C4的输出直接跨接输送给C10,C9,C8和C7, 使得C7~C10层能通过利用C1~C4层提取到的特征进行逐层重构.

VGG网络的激活函数不变, 其余层的激活函数选择ELUs(Exponential Linear Units, ELUs)[13]来提高网络的稳定性. 图 2 中C1层对图像进行预处理并且将单通道灰度图像转换为3通道图像使其能输入到VGG网络中,C2~C5为VGG16网络的前4层,C6~C10为残差编码器的结构,C11层为网络的输出层, 考虑到图像的颜色由UV通道共同控制,UV通道之间存在相关性, 因此网络的输出为预测得到的UV通道. CON表示卷积操作, DOW为下采样操作, BN为Batch Normalization[12]操作, UP为上采样操作.

图 2 网络结构图Fig.2 The network structure

网络采用反向传播算法进行训练, 在训练时VGG部分参数保持不变, 误差函数为

式中:w,b为网络待训练的参数;zu和zv分别为网络的UV通道输出;yu和yv分别为标签UV通道的标签图像;n为训练样本的个数. 为了加快网络的训练, 采用Adam[14]优化算法, 该方法能对网络的每个参数自适应确定学习率, 使得训练速度更快; mini-batch大小取8, 共迭代42 000个mini-batch, 网络使用Tensorflow进行构建, 显卡为GTX1060.

DCNN学习到的是输入图像像素与颜色的映射关系, 这种映射建立的桥梁是图像的特征, 训练集直接影响彩色结果的准确性和自然感, 当训练集中缺少某类物体特征时, 网络无法建立该特征与颜色的映射, 就会导致颜色错误和不连续的问题. 本文主要面向安防监控、 汽车夜视辅助驾驶等应用, 这些场景多包含道路、 建筑、 植被、 人和天空等户外目标, 因此训练集主要由户外场景图像构成. 为了保证网络能对融合图像彩色化并且自然, 训练集包括可见光图像和挑选后的彩色融合结果. 训练集共1 000张图像, 其中有100幅是从互联网收集到的人工上色的红外图像, 还有100幅是颜色迁移和伪彩色结果[15-16], 这些图像都通过人工挑选, 仅选择其中的户外场景和彩色自然感较好的图像, 可见光图像来自ImageNet数据集, 多波段图像来自TNO数据集.

2 实验结果与分析

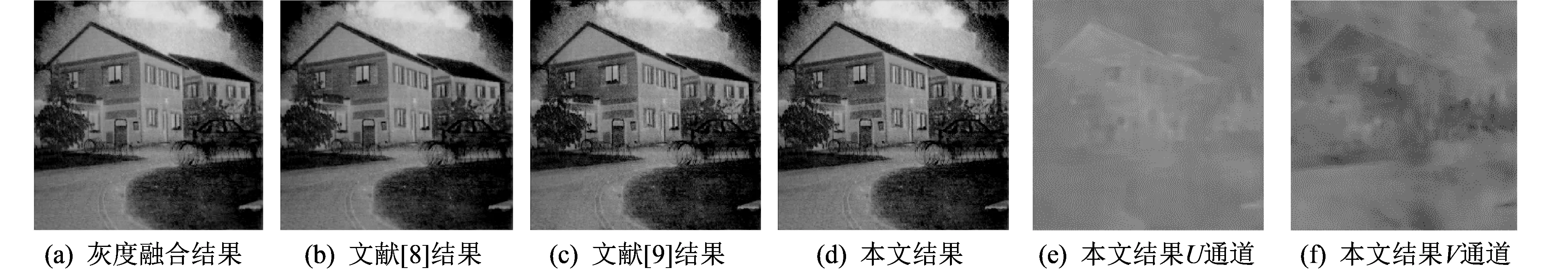

图 3~图 5 为3组测试图像, 均为3波段融合结果(红外长波图像、 近红外图像和可见光图像), 图像来自TNO图像融合数据集, 测试图像不包含在网络的训练集中. 为了验证本文方法的有效性, 选择文献[8]的方法和文献[9]的方法进行对比, 其中文献[8]和文献[9]方法的训练库中仅有可见光图像. 从结果可以看出, 文献[9]的结果色彩分布不均匀, 不连续, 颜色分布没有规律, 不但不利于观察, 反而会干扰人的判断. 文献[8]方法色彩分布虽然均匀, 但其颜色较淡, 所有目标的色彩都基本相同, 效果提升不明显. 本文方法的彩色化结果相对较好, 颜色分布均匀, 能将植物涂成绿色, 墙壁为橙色, 道路为青色, 更接近自然状态.

图 3 第1组测结果Fig.3 Group 1 test image

图 4 第2组测结果Fig.4 Group 2 test image

图 5 第3组测结果Fig.5 Group 3 test image

为了对各方法结果进行比较, 本文从中北大学大数据学院图像处理专业的研究生中抽取20名视力正常的学生(男女各半)对结果进行评价, 这些受试者在实验开始前先进行相关知识培训, 再轮流在同一台电脑上对3组测试图像依次评价, 每幅图像观察2 min, 然后对各方法的彩色结果从整体舒适感, 真实感和色彩丰富程度3方面进行主观评价, 评价等级采用克特5级量表法[1]划分, 5个等级分别为很好、 好、 一般、 不好、 很不好, 对应分值分别为5分、 4分、 3分、 2分和1分.

由于主观观察受观察环境、 受试者专业情况等因素影响, 本文对实验结果进行了客观评价. 所用的评价指标有: ① 颜色数, 颜色数通过统计图像中颜色的数量, 间接反映图像颜色的丰富程度, 值越大越好. ② 标准差, 首先将彩色图像转换到YUV颜色空间, 分别计算UV通道的标准差, 再将结果相加, 标准差可反映数据的离散程度, 由于UV通道代表颜色信息, 标准差越小, 图像颜色整体分布越集中, 间接说明图像颜色更连续, 更均匀, 主观感觉就更好.

图 6 为主客观评价指标结果, 其中整体舒适感、 自然感和颜色丰富程度为20名受试者各项指标的平均结果, 颜色数和标准差结果缩放到0~5. 从图 6 中可看出: 本文方法的整体舒适感和自然感最好, 色彩丰富程度相比虽不如文献[9], 但颜色更均匀, 无论主观评价和客观评价各项指标均最为理想.

图 6 3组测试图像主观评价平均结果Fig.6 The results of subjective eraluation of group 3 test image

3 结 论

本文针对传统多波段融合图像为灰色不利于人眼观察的问题, 提出了多波段融合图像彩色化方法, 主要有以下工作: ① 从理论上分析了可见光图像的自动彩色化方法无法适应于融合结果的原因. ② 在可见光自动彩色化模型的训练库中添加颜色迁移、 伪彩色融合等方法的彩色结果, 使网络能学习到融合图像的特征. ③ 在传统模型的输入层和特征提取层增加更多的操作来减轻环境干扰对结果的影响, 并且使网络能在红外特征与可见光特征之间建立联系. 实验结果表明: 本文方法能对融合结果进行自动彩色化, 不需要额外的参考图像, 颜色自然, 方便易用.

本文提出的多波段融合图像彩色化方法可应用于安防监控、 汽车夜视辅助驾驶等需要人在回路的系统, 对于其他应用, 在构建训练集时应包含应用场景所有的类型的物体, 并且图像数量要多, 颜色要自然. 由于多波段彩色融合图像相比于可见光获取更加困难, 且本文训练集相对较小, 使得结果中部分位置存在颜色不均匀, 因此下一步的工作是: 扩大训练集规模并且提高模型对不同类型融合结果的鲁棒性以及提高彩色结果的连续性.

参考文献:

[1] 蔺素珍, 朱小红, 王栋娟, 等. 基于嵌入式多尺度变换的多波段图像融合[J]. 计算机研究与发展, 2015, 52(4): 952-959.

Lin Suzhen, Zhu Xiaohong, Wang Dongjuan, et al. Multi-band image fusion based on embedded multi-scale transform[J]. Journal of Computer Research and Development, 2015, 52(4): 952-959. (in Chinese)

[2] Lin S Z, Wang D J, Wang X X, et al. Multi-band texture image fusion based on the embedded multi-scale decomposition and possibility theory[J]. Spectroscopy & Spectral Analysis, 2016(7): 2337-2343.

[3] 蔺素珍, 韩泽. 基于深度堆叠卷积神经网络的图像融合[J]. 计算机学报, 2017, 40 (11): 1-13.

Lin Suzhen, Han Ze. Images fusion based on deep stack convolutional neural network[J]. Chinese Journal of Computers, 2017, 40 (11): 1-13. (in Chinese)

[4] 王世亮, 徐岗, 储清林, 等. 基于放缩系数和均值的多参数颜色迁移[J]. 中国图象图形学报, 2013, 18(11): 1536-1541.

Wang Shiliang, Xu Gang, Chu Qinglin, et al. Color transfer with multiple parameters by combining the scaling and mean values[J]. Journal of Image and Graphics, 2013, 18(11): 1536-1541. (in Chinese)

[5] Arbelot B, Vergne R, Hurtut T, et al. Local texture-based color transfer and colorization[J]. Computers & Graphics, 2016, 62: 15-27.

[6] 李惠. 基于生物视觉融合机制的图像增强算法研究[D]. 西安: 电子科技大学, 2016.

[7] 孙凤梅. 多传感器图像彩色融合方法研究[D]. 长沙: 湖南大学, 2009.

[8] Efros A A, Efros A A, Efros A A, et al. Real-time user-guided image colorization with learned deep priors[J]. Acm Transactions on Graphics, 2017, 36(4): 119-125.

[9] Tinyclouds. Automatic colorization[EB/OL]. http:∥tinyclouds.org/colorize/, 2017.

[10] Suárez P L, Sappa A D, Vintimilla B X. Infrared Image Colorization Based on a Triplet DCGAN Architecture[C]. Computer Vision and Pattern Recognition Workshops. IEEE, 2017: 212-217

[11] He K, Zhang X, Ren S, et al. Deep Residual Learning for Image Recognition[C]. Computer Vision and Pattern Recognition (CVPR), 2016: 1-9.

[12] Loffe S, Szegedy C. Batch Normalization: Accelerating Deep Network Training by Reducing Internal Covariate Shift[C]. International Conference on Machine Learning. JMLR.org, 2015: 448-456.

[13] Djork-Arné Clevert, Sepp Hochreiter T U. Fast and accurate deep network learning by exponential linear units (ELUs)[C]. ICLR, 2016: 1-14.

[14] Kingma D, Ba J. Adam: a method for stochastic optimization[C]. The 3rd International Conference for Learning Representations, 2015: 1-15.

[15] Toet A. Natural colour mapping for multiband nightvision imagery[J]. Information Fusion, 2003, 4(3): 155-166.

[16] Toet A, Franken E M. Perceptual evaluation of different image fusion schemes.[J]. Displays, 2003, 24(1): 25-37.