可穿戴设备在交互音乐中的应用

2018-05-30亓梦婕

亓梦婕

(中央音乐学院,北京 100031)

可穿戴设备(wearable device)指的是能够穿戴在人体作为一种辅助工具或植入在人体内的智能电子设备①。随着科学技术的飞速发展,可穿戴设备已经被广泛应用于VR和AR等科技领域,在日常生活、教学、健康医疗、交通通信和社交娱乐领域发挥了重要作用,为人们的生活提供了更多的便利和智能化的服务。

可穿戴设备在数字媒体领域的应用涉及多媒体播放控制、健康参数监控、多媒体设备数据控制、新媒体艺术设计、VR游戏设计和娱乐以及智能纤维等,常见的Myo臂环,各式手套,VR、AR眼镜和头戴式设备等都是最典型的可穿戴设备。脑电波(Electroencephalography,EEG)传感器、各类在不同功能的交互系统中特别设计的DIY传感器和交互系统等技术的发展,为可穿戴设备提供了更丰富的功能。

在艺术创作领域中,可穿戴设备的应用非常活跃。艺术家们试图从创新科技中寻找全新的方式演绎其艺术理念和追求,体现艺术和技术的融合。笔者仅就交互音乐领域可穿戴设备的应用,特别是近年来发展起来的利用脑电波传感器进行艺术创作的应用进行阐述。

1 交互音乐领域的可穿戴设备

可穿戴设备对交互音乐的艺术呈现能够起到极大的辅助和推动作用,并受到越来越多的作曲家、音乐家、舞蹈家和视觉艺术家的关注。它能够实时拾取数据信息,与表演者融为一体,提供沉浸式的表演体验,不仅为表演者和观众搭建主观感受与精神感知的桥梁,也使得观众能够更好地对艺术信息进行直接观察[1]。不论是由厂家设计生产的传感设备,或是艺术家根据作品和表演的需求进行特殊设计的DIY传感器设备,它们都拾取表演者动作过程中产生的数据,并传输到计算机程序。

可穿戴设备中“可穿戴”的特点,能够为用户提供沉浸式的体验。对于交互音乐表演来说,人体的运动(movement)和姿态(gesture)信息的输入数据非常重要。可穿戴设备在交互音乐中的数据应用原理包括动作捕捉(motion capture)、动作追踪(motion tracking)和数据映射(data mapping)等环节。一方面,传感器被广泛运用于交互音乐创作和表演,通过实时追踪人体的动作和加速度等信息,把这些数据传输到Max、Pd或Processing等能够进行实时数据处理的编程环境,将这些数据以声音或图像的形式输出。表演者在舞台上的一系列动作为观众提供了更好的交互感体验,使观众能更好地理解表演者的动作及其艺术效果之间的对应关系。有一些艺术家甚至欢迎观众使用作曲家提供的可穿戴设备,参与到作品的创作和呈现环节,这也是交互表演的另一种体现形式。由于用户与传感器融为一体,几乎感觉不到它的存在,从而能把注意力集中在表演本身。另一方面,使用WiFi或蓝牙连接的方式,不仅实现了数据的无线传输,还保证了表演者在舞台上的自由度,增加了动作的灵活性,能够将表演者身体的动作和音乐、视觉影像效果以及其他媒体融为更好的整体。

目前,基于手套设计的可穿戴设备和Myo臂环被广泛应用在交互音乐的创作和表演中,尤其是脑电波(EEG)传感器能够更好地传达和表现表演者的内心世界。

2 基于手套设计的可穿戴设备的应用

手是人们日常生活中最容易接触和感知到自然世界的器官,基于手套设计的可穿戴设备自诞生至今已有四十多年的时间。这种设备通过检测手指弯曲度、手指间的压力、手指间的相对距离、手掌的运动方向和加速度等数据作为交互系统的数据输入,并且在佩戴它的同时,仍有可能演奏其他乐器。

1976年,伊利诺伊大学芝加哥分院的里奇·赛尔(Rich Sayre)、托马斯·迪凡蒂(Thomas Defanti)和丹尼尔·桑丁(Daniel Sandin)设计了一款造价低而且重量轻的手套,被称为Sayre Glove。光源放置在一种可以弯曲的电子管的一侧,另一侧连接了光电管。每一条电子管都延伸到手指的长度,电子管中会有光通过,当它弯曲时,光的亮度会发生变化,每个光电管的电压变化与手指的弯曲程度相关联。他们使用这个手套进行多通道的声音控制,模拟控制器推子的使用效果[2]。

20世纪80年代早期,麻省理工学院建筑机械组(Architecture Machine Group)和媒体实验室(Media Lab)的研究人员利用带有基于照相机的LED系统进行动作捕捉和追踪,在他们设计的手套上镶嵌了LED灯,通过把最终的信号集中在手部,得到手指的动作信息。这个LED手套在当时只用来进行动作追踪,并没有作为控制设备使用。另外还有其他几种不同的设计,例如由托马斯·齐默尔曼(Thomas Zimmerman)和其他研究人员共同研发的DataGlove,可以检测每一只手上的十个关节和手的位置及方向,它的重量更轻、穿戴更舒适,而且兼容性更强,之后由VPL 研究中心进行商业推广,被广泛应用。

麦特尔·托伊思(Mattel Toys)受到DataGlove的启发,在20世纪80年代中期发明了Power Glove作为游戏控制器。保罗·迪·马林斯(Paul De Marinis)受此启发,他将手套上的弯曲传感器( fi nger fl ex sensors)部分保留下来,使其在音乐表演中用手指控制音高、触发开始和结束的时间点以及保存某一个音乐段落的数据等。1991年,蕾蒂西亚·索娜米(Laetitia Sonami)与迪·马林斯在奥地利的林茨举行的电子音乐节Ars Electronica Festiva演出作品《Mechanization Takes Command》时用到了索娜米设计的手套设备,在橡胶手套上放置磁性传感器来触发信号。一年后,索娜米又在此基础上设计了带有五个微动开关和磁传感器的手套,这样她的左手可以实施完全的控制,并空出右手来控制旋钮。在荷兰电子乐器音乐实验室(Studio for Electro Instrumental Music,简称STEIM)驻地创作期间,索娜米设计了著名的“女士手套”(Lady’s Glove),指尖部分嵌入了微动开关,弯曲传感器用来感应手腕和中指的弯曲度,每个手指的感应器都能接收两组数值,用以辨别手指上两个关节的弯曲程度。指尖部分装有磁性感应器,拇指部分装有磁铁,可以侦测到每个指尖与拇指的距离。这个设备在食指和拇指上装有一个压力垫,在手掌上还有一个超声波发射器,与腰带和鞋子里的接收器一起使用。这个设计使表演者能够通过手腕和手指的弯曲、每个手指之间相对位置的移动、手指之间的按压、开启或关闭指尖的微动开关以及手指和身体的相对位置来控制音乐的参数。这个手套的设计使单一手指的运动改变了多种参数的变化,因此能够对声音进行多次和多种参数的控制,进而能够自如地对音乐表情进行控制[3]。

在托德·麦克弗(Tod Machover)的作品《bug-mudra》(1990)中,他使用Exos DHM②设备来控制交互音乐表演中的音乐参数,计算机系统拾取两位吉他演奏家和一位打击乐演奏家的声音,并在表演中对这些声音进行实时合成。指挥的左手佩戴了DHM,通过它在指挥时进行音色的混合、声相变化以及多声道声音的比例调节。木村麻里(Mari Kimura)也是一位使用手套设备进行交互音乐表演和创作的音乐家。她利用“µgic”传感器提取小提琴演奏中弓法和力度的变化,使用WiFi与计算机进行信号传输,并与实时的计算机音乐相结合,获得了非常有效的演奏效果,这成为她在交互音乐表演中的标志性创意设计。

3 基于肌电传感器的Myo臂环

许多已经在市面上可购买的可穿戴设备在设计之初并没有以艺术设计和创作为目的,而是服务于医学、科技和通信等专业领域,但它们获取到的人体运动、动作、手势,甚至一系列生物信息,如心跳、脑电波和肌肉紧张度的信号,都可以通过计算机将这些信息进行读取、保存、处理,成为艺术创作的重要数据和素材,并实现交互表演。

Myo臂环是由Thalmic Labs设计的可穿戴的动作捕捉和数据控制设备,通过蓝牙进行无线控制,与计算机、智能手机或其他电子设备进行数据传输[4]。Myo臂环由8个包含肌电图(EMG)传感器、加速度传感器、陀螺仪和磁力计的九轴惯性测量单元(IMU)组成,通过识别手臂的运动方向、肌肉紧张度、手掌和手指的动作、加速度以及方向等得到大量的数据。它能够通过OSC协议将获取的数据传输至多种应用程序中,同时为艺术家提供了在众多编程环境下工作的可能。

由于佩戴方便而且不影响表演者的动作幅度,Myo臂环极大地优化了表演者的沉浸式体验效果,不仅对乐器演奏家来说非常便捷,对于舞蹈和戏剧演员等需要在舞台上进行大幅度动作表演的艺术家来说,也非常方便。它的优势还体现在利用它进行人体运动追踪的信号不受维度的限制,只要在蓝牙信号覆盖范围内,就可以稳定地拾取并传输数据。

SALTO(全称为Sensory Aerialist eLecTrOacoustic system)是为高空表演而设计的包括Myo臂环、数字声音合成和电子音乐等模块的交互式表演系统。克里斯蒂安娜·罗斯(Christiana Rose)及其创作团队在2016年创作的《Splinter》是为高空舞蹈表演和SALTO系统创作的交互式电子音乐作品(图1),通过Myo臂环采集数据将高空舞蹈表演者的身体语言转译成声音素材。在这个作品中,尽管由于演员的动作变化和移动而产生动作信息确认的不准确和不稳定的问题,但这种形式为作曲家提供了更多捕捉全方位动作信息的可能性,在技术领域仍然是一种突破。

图1 《Splinter》高空表演

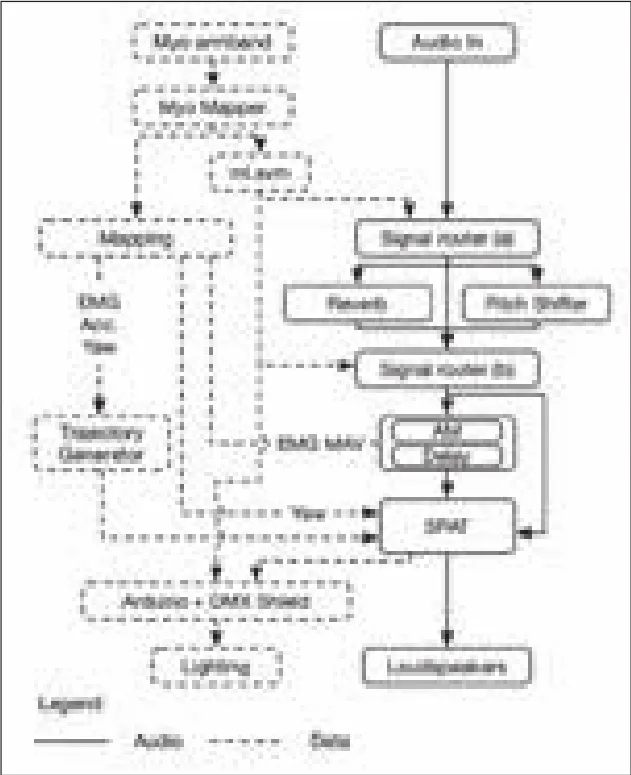

图2 MyoSpat 系统工作原理[6]

就读于伯明翰音乐学院的巴拉迪诺·迪·多纳托(Balandino Di Donato)也是热衷于探索动作追踪与交互音乐的艺术家,尤其善于使用带有Myo臂环的交互系统的应用和研究。他与詹姆斯·杜利(James Dooley)共同设计的MyoSpat是一个交互声音—视觉影像系统(图2),旨在通过表演者用手势和动作信息直接控制声音和灯光效果,增强作品的艺术表现力[5]。MyoSpat 2是根据Myo动作控制作为数据输入,在Pure Data编程环境进行动作数据识别和声音—影像处理的更新版本系统。

在这个系统中,Myo Mapper③从Myo臂环提取并转换数据,传输到OSC;使用ml-lib(机器学习库)外部插件④在PD(Parallels Desktop)环境中进行动作识别和声音—影像信号的处理和空间化呈现;用Arduino将序列数据传输至DMX来控制灯光的效果。在MyoSpat的资料库中有六种动作识别设置,手臂的每一个动作都对应一种声音数据的处理方式,例如音高变化、振幅调制参数和3D空间变化等。埃莉诺·特纳(Eleanor Turner)是竖琴演奏家和作曲家。特纳在她的作品《The Wood and the Water》中也使用了MyoSpat交互音乐系统进行创作和即兴表演,产生了丰富的艺术效果。MyoSpat在其他领域也得到了广泛应用,例如舞蹈表演和虚拟现实等。

4 脑电波传感器的应用

在过去的几十年中,医学、神经学和心理学等领域的研究人员一直致力于脑电波的研究,并取得了显著的成果。在此基础上探索使用脑电波信号,成为艺术家进行创作的新技术手段。

截至目前,已有许多公司研发了基于脑电图描记法(EMG)的生物传感设备,用来获取人体的生物信息数据,例如Emotiv、NeuroSky、iWinks、MUSE。通过获取大脑活动中的脑电波,得到表演者在放松、冥想或思考等不同情绪状态下的脑电波数据。

艾尔文·卢西埃(Alvin Lucier)被公认是较早使用脑电波进行创作的作曲家[7],他在1965年创作的作品《为一位表演者而作的音乐》(Music for Solo Performer)使用了EEG电极检测表演者在冥想时的alpha脑波,这个脑波信号产生的声音与舞台上的打击乐器产生共振,在舞台空间中构成极具戏剧性的效果。表演者的脑电波首先输出到差分前置放大器,然后进入八组立体声放大器。舞台上共有16件乐器,包括钢琴、鼓、吊镲、金属垃圾桶和硬纸板等。这些乐器上都安装了小型的扬声器,能够使alpha脑波传输到扬声器时与声学乐器产生共振,这在当时的实验音乐领域引起了轰动。图3所示为2009年9月26日,艾尔文·卢西埃在伦斯勒表演艺术中心演出的海报。

图3 卢西埃演出海报⑤

图4 丽莎·朴在表演中⑥(图片来源:Olivia Chow)

图5 脑电波信号在编程软件中的图示(图片来源: Olivia Chow)

丽莎·朴(Lisa Park)是一位交互装置艺术家,她的作品多采用人体的生物信息作为交互系统的输入数据,例如人的心跳和脑电波等。她的交互电子音乐作品《Eunoia》创作于2013年。这个标题在希腊语中被译为“美妙的思考”,表达对人类五种情感(喜、怒、哀、恶和欲)的思考,这五种情感构成了一个无限的人类情感统一体,也从另一个侧面体现了作者对采用脑电波进行艺术创作的追求,力图使用最直接而美妙的方式体现大脑思考的美感。她使用NeuroSky公司设计的EEG头戴式设备,获取大脑的活动数据,包括delta、theta、alpha和beta脑波,同时监测眼睛的活动。这些数据实时进入编程软件,并以图示的形式体现出来(图4~图5)。在这部作品中,丽莎·朴使用了一种更加清晰可见的方式为观众呈现这些脑电波信号所产生的效果。她在5个24英寸的金属盘里覆盖了一层水,并在金属盘下方分别安装了15英寸的扬声器,通过扬声器与金属盘的共振,水面呈现出不同的波纹。丽莎·朴将脑电波信号传输至实时编程环境Max和Reaktor,生成带有回声效果的声音。水在金属盘里的波动取决于声音的音量、声相和频率,这些参数随着大脑活动和情绪的变化而产生变化。此外,她还创作了许多使用脑电波的交互式音乐和装置作品,例如《Eunoia II》、《Eudaimonia》以及大型声音装置《NUE》等。

2013年,斯坦福大学教授克里斯·舍费(Chris Chafe)与致力于研究痉挛症状的约瑟夫·帕维兹(Josef Parvizi)教授合作,将病人的脑电波信号转译为音乐。舍费使用了一个接近于女声的声音素材,目的是为听者提供一种更容易接受和理解神经活动的听觉体验。他们后来设计了一种可以进行实时监测病人脑电波的设备,能够在任意时间获取脑电波信号,他们把这个设备称为“大脑听诊器”。帕维兹选择了大脑中一百多个神经元作为信号源,舍费从这些神经元中选择一部分信息来调制女声的音高频率,随着脑波活动的逐渐频繁使音高产生相应的变化。与此同时,女声的音调、音色也在发生改变,每个神经元信号都成为一个演唱声部,整个音乐呈现出高低起伏和律动的变化。

将脑电波用于音乐创作的这些艺术实践活动,并不仅仅存在于严肃音乐或实验音乐领域。爵士鼓手威廉·胡克尔(William Hooker)和歌手罗拉·法耶(Lora Faye)把脑电波信号与爵士乐表演相结合,脑电波信号生成的声音担任音乐中的一个重要声部,这成为独具特色的爵士乐表演方式。

5 结语

托德·温克勒(Todd Winkler)曾提到:“交互音乐系统使用软件来控制音乐的各项参数,体现音乐的艺术表现力……人的动作作为输入信号和数据,也已经被频繁地应用在交互音乐系统中……将动作数据转换为音乐信息的方法,为表演者提供了参与感和创造性……这种交互感取决于表演者的自由度和对产生的效果的感知,以及计算机程序对于表演者动作信息的反应和转译能力。”[8]使用可穿戴设备进行交互音乐表演,更突出地体现了温克勒所说的交互音乐灵活性和创造性的特点。

近年来,交互音乐在科技不断进步的大背景下得到持续的发展,可穿戴设备也在不同领域得到广泛的应用。可穿戴设备的灵活性和隐蔽性为表演者提供了更大的自由空间,在这种极具沉浸感的表演中,表演者能够在表演空间内对自身有更明确的感知,将交互音乐表演中的动作姿态与最终呈现的音乐表情融为一体。可穿戴设备在交互音乐中的应用,缩小了表演者与观众以及表演者与自身的距离,增强了他们的参与感和沉浸感,极大地拓宽了艺术家的创作手段和工具的可选择性。当前,这种跨学科的新媒体艺术创作与多媒体形式的合作形式也在快速发展。以上提到的这些可穿戴设备为艺术家提供了探索声音、画面、文字和结构等元素的多样融合方式,并被广泛应用在交互电子音乐、装置艺术、舞蹈和戏剧等领域,通过实时地将表演者或观众的身体动作信号和生物信息转换为相对应的输出信息,极大地增强他们的参与感,并拓展了艺术的表现力。

注释:

① 来源于https://en.wikipedia.org/wiki/Wearable_technology

② Exos DHM,全称为Dexterous HandMaster,最早是由亚瑟·利特尔(Arthur Little)设计的,它应用霍尔效应传感器作为电位器,准确地测出每个手指的三个关节的弯曲程度、手指外展的位置和拇指复杂的动作。

③ Myo Mapper是由多纳托研发的开源应用程序,能够将Myo臂环的数据映射到OSC信息,该项设计曾在2017年获JUCE Award奖项。

④ ml-lib是在为Max和PureData编程环境设计的机器学习资料库。

⑤ 来源于http://empac.rpi.edu/events/2009/fall/slowwave/music-solo-performer

⑥ 来源于https://creators.vice.com/en_us/article/vvygzm/eunoia-seeking-enlightenment-by-trackingbrainwaves

[1]Federico Visi et. al., Musical Instruments, Body Movement, Space, and Motion Data: Music as an Emergent Multimodal Choreography, human technology, Vol. 13(1), pp. 58-81, May 2017.

[2]David Sturman, David Zeltzer, A Survay of Glove-based Input, IEEE Computer Graphics & Applications,pp. 30-39, January, 1994.

[3]Joel Chadabe, Electronic Sound - the past and promise of electronic music, Prentice Hall, pp.229-230.

[4]Christiana Rose, SALTO: A System for Musical Expression in the Aerial Arts, NIME 17, Aalborg University Copenhagen, Denmark, May 15-19, 2017.

[5]Balandino Di Donato, James Dooley, Myospat: A System for Manipulating Sound and Light Through Hand Gestures, Proceedings of the 3rd Workshop on Intelligent Music Production, Salford, UK, 15 September, 2017.

[6]Balandino Di Donato, James Dooley, Myospat: A System for Manipulating Sound and Light Through Hand Gestures, Proceedings of the 3rd Workshop on Intelligent Music Production, Salford, UK, 15 September, 2017.

[7]Volker Straebel, Wilm Thoben, Alvin Lucier’s Music for Solo Performer: Experimental music beyond soni fi cation, Organised Sound, 2014, Vol. 19(1), pp. 17-29,Cambridge University Press.

[8]Todd Winkler, Making Motion Musical: Gesture Mapping Strategies for Interactive Computer Music,Proceedings of the 1995 ICMC.

[9]Federico Visi et. al, Musical Instruments, Body Movement, Space, and Motion Data: Music as an Emergent Multimodal Choreography, Human Technology, Vol. 13(1), pp. 58-81, May 2017.

[10]David Sturman, David Zeltzer, A Survay of Glovebased Input, IEEE Computer Graphics & Applications,pp. 30-39, January, 1994.

[11]Joel Chadabe, Electronic Sound - the past and promise of electronic music, Prentice Hall, pp.229-230.

[12]Todd Winkler, Making Motion Musical: Gesture Mapping Strategies for Interactive Computer Music,Proceedings of the ICMC, 1995.

[13]Christiana Rose, SALTO: A System for Musical Expression in the Aerial Arts, NIME 17, May 15-19,Aalborg University Copenhagen, Denmark, 2017.

[14]Balandino Di Donato, James Dooley, Myospat: A System for Manipulating Sound and Light Through Hand Gestures, Proceedings of the 3rd Workshop on Intelligent Music Production, Salford, UK, 15 September, 2017.

[15]Volker Straebel, Wilm Thoben, Alvin Lucier’s Music for Solo Performer: Experimental music beyond sonification, Organised Sound, Vol. 19(1), pp. 17-29,Cambridge University Press, 2014.

[16]https://www.datagarden.org/blog/richardlowenberg-interview

[17]https://www.musicmotionalliance.com/projects/2016/10/23/koto-japanese-and-electronicmusic-created-with-brainwaves

[18]https://creators.vice.com/en_us/article/nz4eez/thiseeg-helmet-makes-music-from-brainwaves

[19]http://www.balandinodidonato.com/myomapper/

[20]https://news.stanford.edu/news/2013/september/seizure-music-research-092413.html