一种基于多目视觉的无人机实时定位方法

2018-05-04郑顺义朱锋博

王 辰,郑顺义,朱锋博,桂 力

(武汉大学遥感信息工程学院,湖北 武汉 430079)

随着无人机技术和产业的发展,无人机在生活中变得越来越常见,无人机飞行安全成为一个备受关注的话题,飞行精度是无人机质量检测的重要指标。为配合第三方质检机构对无人机进行质量检测,本文提出了一种基于多目视觉的无人机实时定位方法。

基于视觉的目标检测定位方法可以分为3类:基于单目视觉的目标定位、基于双目视觉的目标定位和基于多目视觉的目标定位。基于单目视觉的目标定位是一个二维恢复三维的问题,需要一些辅助设备或信息来获取深度信息,如刚体表面的多个相对位置已知的附加或自身标识[1-2]、目标在某已知面内运动[3-4]、参考数据[5-7]等。基于附加或自身标识的方法在距离较远时存在标识识别困难的问题,限制目标运动轨迹在某一面内不适用于无人机定位情形,参考数据不能适应不同型号的无人机,且在无人机距离较远时存在特征丢失、匹配困难的问题。双目视觉通过模拟人眼立体观测原理来实现目标定位,在智能交通[8]、机器人抓取引导[9-10]等领域有着广泛应用,其主要缺点在于观测视角有限。多目立体视觉原理和双目立体视觉相同,但相比双目立体观测,多相机的使用一方面可以扩大观测范围[11-12],另一方面也可以提供更多的多余观测,提高定位结果的可靠性。

相比一般的运动目标定位,无人机定位具有范围大、型号多样、逆光成像等特点,导致无人机成像暗,纹理、轮廓等信息丢失,人工发光或反光标识难以识别。针对以上问题,本文提出了一种基于多目视觉的无人机定位方法。该方法使用多个标定后的相机对飞行中的无人机进行软触发同步图像采集,使用背景差分、连通域分析、前方交会、重投影等技术实现无人机的自动检测和定位。最终统计实际定位结果与预先设计的无人机飞行航线间水平和竖直方向偏差、偏差最大值及偏差标准差,以作为无人机飞行质量评价的参考指标。

1 多目视觉无人机自动定位系统设计与实现

1.1 系统设计

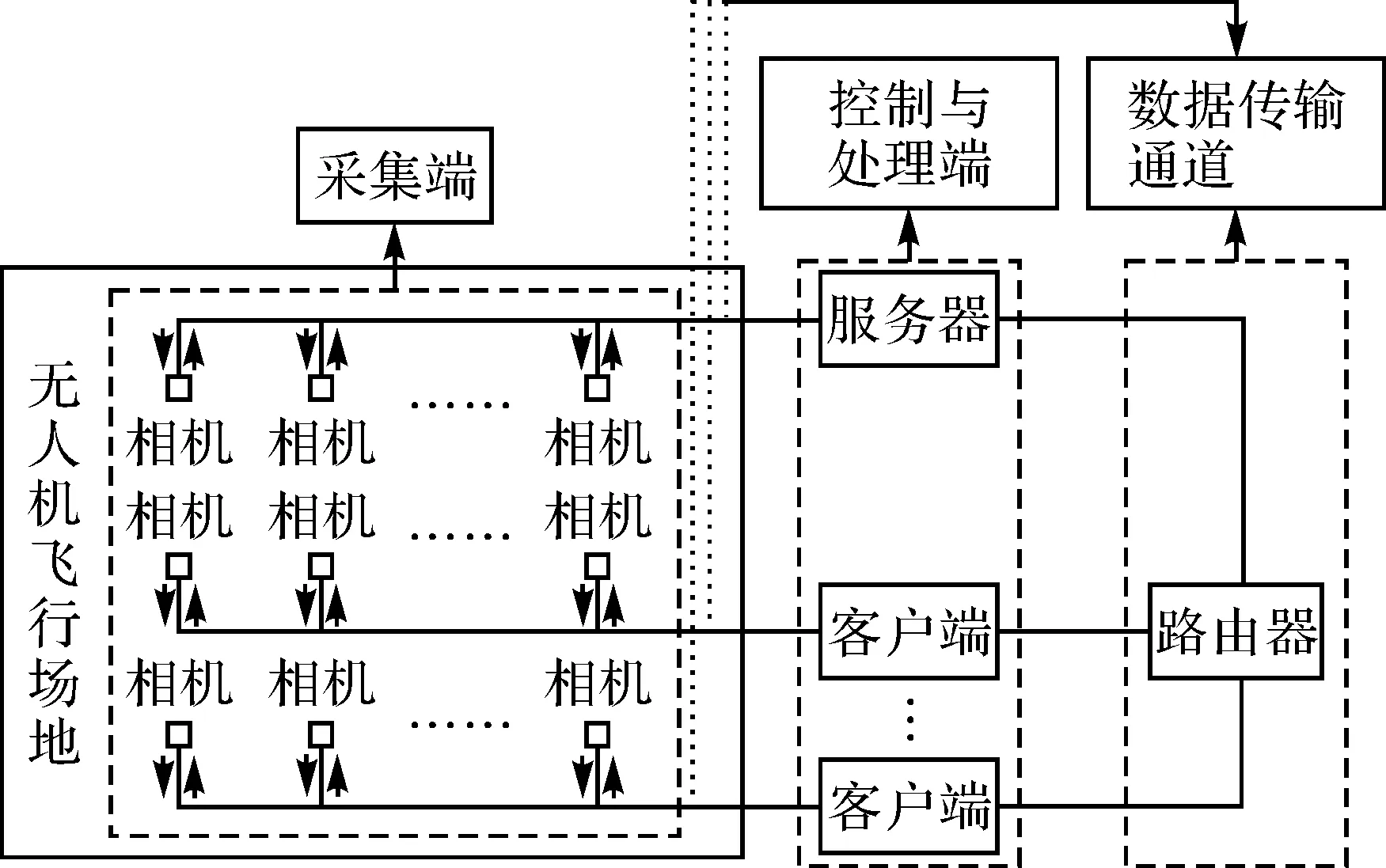

为实现较大范围的区域覆盖,本文采用了多台相机和多台计算机组建局域网的方式。如图1所示,无人机定位系统由数据采集端(相机)、控制与处理端(计算机)和数据传输通道(光纤、网线、路由器等)3部分构成。单台计算机和若干相机连接构成一个分组,负责目标范围内一块区域无人机的定位,包括图像同步采集、无人机自动检测与定位等。其中图像同步采集是指对运动目标进行定位时,为保证定位精度,需要控制多台相机同时曝光,以保证定位结果精度[13]。这里采用的是计算机向与其相连的多台相机同时发出触发指令的方式来实现多相机同步采集图像。多台计算机间通过网线和路由器连接,构建一个局域网。

图1 无人机自动定位系统设计示意图

构建局域网的目的为完成多计算机间的时间校准和无人机定位结果的汇总。其中多计算机间的时间校准采用如下方式实现:选择一台计算机充当服务器端,提供时间基准。其他计算机充当客户端,向服务器端发出时间查询请求,并记录当前客户端时间t1。服务器端收到时间查询请求时,将其当前时间t2发送给相应客户端,客户端收到t2时,记录下客户端当前时间t3,则客户端和服务器端时间差Δt=t2-(t1+t3)/2。此过程通过局域网TCP通信实现,在采集图像前进行,为多计算机的定位结果合并提供参考。无人机定位结果的汇总是指客户端把其无人机定位结果发送到服务器端进行汇总,得到无人机整体的飞行航迹。

1.2 相机标定

相机标定包括内方位元素、畸变参数标定和外方位元素标定。内方位元素和畸变参数通过控制场检校获取。外方位元素使用辅助标志点过渡的方法获取。

图2 相机外壳辅助测量标识示意图(2个标志点被遮挡)

(1)

(2)

Rout=RinRt

(3)

(4)

1.3 背景差分检测无人机

背景差分法是采用图像序列中的当前帧和背景参考模型作差来检测运动物体的一种方法,具有检测运动目标速度快、检测准确、易于实现的特点,其关键是背景图像的获取[14]。因采集图像在无人机起飞前开始,本文采用各相机采集序列影像的第一张影像作为初始背景图。基于背景像素灰度值时间分布符合高斯函数模型的假设,使用一个全局的高斯函数模型

(5)

来表示某像素由环境变化引起的当前影像与背景之间灰度值差值Idif(t)的概率分布P(Idif(t)),根据差值绝对值大小,使用阈值T1把当前帧分为背景和前景,T2确定背景更新的范围,即当Idif(t)绝对值小于等于T2时才对背景图相应的区域进行更新。背景图使用如下更新函数进行更新

B(t)=B(t-1)+ROUND(Idif(t)w(Idif(t)))

(6)

式中

(7)

式(7)是高斯函数的一个变体,表示权值。使用该函数计算权值的依据是一定时间内,灰度值变化满足高斯分布,以当前背景灰度值作为高斯分布的均值,当前帧与背景灰度差值越大,其发生的概率越小;α是一个正常数,α和T2的值越大,背景更新越快;ROUND()表示四舍五入取整;B(t)表示t时刻背景灰度取值;Idif(t)表示t时刻对应帧I(t)与背景B(t-1)的灰度差值。

图3为α=8、T1=10、T2=14时进行运动目标检测的测试结果。从图中可以看出,本文使用的背景更新和差分方法可以有效地检测到无人机。需要注意的是,在使用Idif(t)判断前背景时,并不对其取绝对值,因为背景是天空,无人机所在的区域会变暗,而非变亮。这样,即便初始背景(第一帧)有无人机,只要无人机运动后的位置不与初始位置重合就不影响后续的检测。

图3 背景差分结果示意图

1.4 无人机定位与筛选

因无人机在图像上所成像为面状,在使用背景差分获得运动目标二值图后得到的仅仅是像素级的变化显著区域,并不具备物理含义。为了找到无人机对应的区域,这里首先使用行扫描的方法[15]对二值图进行连通域标记,并对邻近连通域进行合并,然后使用连通域的大小、包围盒宽高比、包围盒填充度(连通域大小和其包围盒面积之比)等参数对连通域进行分析筛选,找到无人机对应的连通域。

由于噪声、鸟等的干扰,实际在单张影像上得到的无人机候选连通域可能不止一个,在使用不同影像上连通域的中心点进行前方交会获得无人机三维空间坐标时需要进一步进行筛选。事实上,无人机的自主飞行是按照预先设计好的航线来进行的,此航线信息可以预先获取,假设无人机在飞行过程中不会偏离航线很远,那么可以使用定位点坐标距离预设航线的距离作为一个约束条件对交会结果进行筛选。另外,本文还使用了无人机飞行速度(大小和方向夹角)作为一个约束条件。如果使用上述约束仍然得到多个交会结果,则将重投影像点误差最小的交会点作为无人机三维空间坐标最优结果。

2 试验验证与分析

为了测试系统的图像采集帧率、处理实时性和无人机定位精度,进行了两个试验测试。测试1主要验证图像采集帧率和处理实时性,使用Basler相机,分辨率为2592×1944像素,镜头水平视场角约为60°;测试2用于测试系统的定位精度。

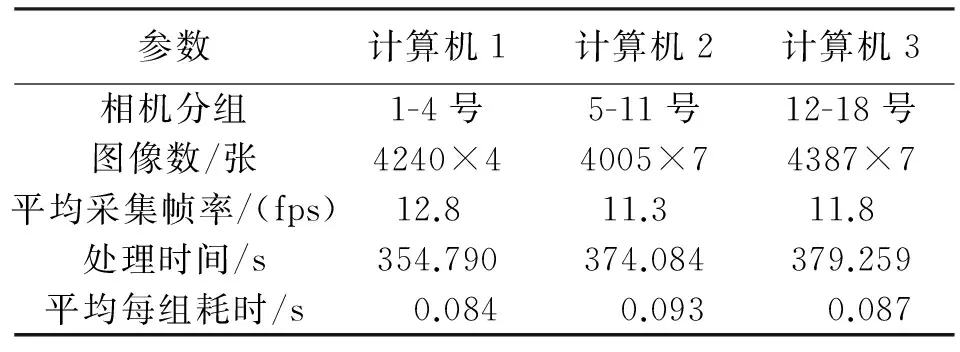

测试1使用3组相机同时进行图像采集和处理测试,统计结果见表1,所得航迹如图4所示。

表1 图像采集与处理效率试验结果

从表1可以看出,3组相机图像同步采集帧率在10 fps以上;单组数据处理时间小于0.1 s,达到了实时处理的水平。图4为3台计算机处理得到的无人机飞行轨迹,灰色为预设航线,(a)中不同颜色的线表示不同计算机的处理结果,(b)中浅灰色线为合并后的结果,S为无人机起降位置。本次飞行仅沿内侧环形预设航线飞行,部分轨迹缺失由线塔遮挡引起。

测试2通过在一组相机公共视野内寻找两个检查点,分别使用全站仪和本系统量测检查点坐标,比较两种方法量测结果偏差来进行,结果见表2。

表2 系统测量精度验证结果 m

从表2可以看出,两个检查点的全站仪测量结果与本系统测量结果各坐标分量偏差均小于0.5 m,点位距离偏差分别为0.48和0.28 m。用于测试的两个相机的坐标分别为(191.57,-24.21,-0.01)和(232.09,-24.49,-0.08),与检查点的距离约为80 m,由此可以看出,该系统百米定位精度达到了0.5 m。

3 结 语

本文提出了一种基于多目视觉的无人机定位方法,并设计、实现了一套系统以验证方案的可行性、效率与精度。该系统通过多计算机和多相机联合组网的分布式设计与并行处理,一方面扩大了无人机观测范围,提高了定位结果的可靠性;另一方面也提高了数据的处理效率,达到了实时处理的水平。此外,该系统在图像采集时的曝光时间确定,以及处理过程中图像上无人机的检测和无人机三维空间坐标的解算均自动完成,极大地降低了工作量和对操作人员的要求。

参考文献:

[1] 解邦福.基于单目视觉的刚体位姿测量系统研究[D].哈尔滨:哈尔滨工业大学,2009.

[2] BENALLAL M,MEUNIER J.Pose Estimation of Polygonal Object in Monocular Vision Using Parametric Equations of Vertices[C]∥IAPR Conference on Machine Vision Applications.[S.l.]:DBLP,2002:342-345.

[3] LIU C,ZHANG Y.3D Trajectory Reconstruction from Monocular Vision Based on Prior Spatial Knowledge[J].IEEE Sensors Journal,2016,16(3):817-822.

[4] JUNG S,JANG D,KIM M.An Approach to 3D Object Localization Based on Monocular Vision[J].Journal of Korea Multimedia Society,2008,11:1658-1667.

[5] XU S,LIU M.Feature Selection and Pose Estimation from Known Planar Objects Using Monocular Vision[C]∥IEEE International Conference on Robotics and Biomimetics.Shenzhen: IEEE,2014:922-927.

[6] DOIGNON C,ABBA G,OSTERTAG E.Recognition and Localization of Solid Objects by a Monocular Vision System for Robotic Tasks[J].Intelligent Robots & Systems Advanced Robotic Systems & the Real World Ir,1994(3):2007-2014.

[7] HOERMANN S,BORGES P V K.Robot Localization Using 3D-models and an Off-board Monocular Camera[C]∥IEEE International Conference on Computer Vision Workshops.Barcelona:IEEE,2011:1006-1013.

[8] LIU W,WANG Z,NING X,et al.An Object Recognition and Location Based on Binocular Stereo Vision[C]∥International Forum on Computer Science-Technology and Applications.Chongqing:IEEE Computer Society,2009:97-99.

[9] HUANG G,CHENG C.3D Coordinate Identification of Object Using Binocular Vision System for Mobile Robot[C]∥Automatic Control Conference.Nantou:IEEE,2014:91-96.

[10] 罗陆锋,邹湘军,叶敏,等.基于双目立体视觉的葡萄采摘防碰空间包围体求解与定位[J].农业工程学报,2016,32(8):41-47.

[11] 王磊,胡超,吴捷,等.基于多相机的人脸姿态识别[J].计算机应用,2010,30(12):3307-3310.

[12] 陈磊,高升,袁宝峰,等.基于多相机的空间机械臂视觉系统[J].航天返回与遥感,2014,35(3):35-42.

[13] 冯文灏.近景摄影测量[M].武汉:武汉大学出版社,2002.

[14] 万缨,韩毅,卢汉清.运动目标检测算法的探讨[J].计算机仿真,2006,23(10):221-226.

[15] 马吉甫,高雪峰.基于扫描线的连通域搜索算法[J].福建电脑,2006(12):121.