基于分布场的特征融合重检测鲁棒性跟踪算法研究∗

2018-04-26张百戬王嘉丰

张百戬 王嘉丰

(西安电子科技大学计算机学院 西安 710071)

1 引言

视觉跟踪技术,是对视频序列中的运动目标逐帧进行描述、检测、特征提取、识别,跟踪,以此获得感兴趣的运动目标(例如车辆、行人等)的运动状态(位置、速度、加速度等),以及运动轨迹参数,经过分析和处理,实现对运动目标的行为理解。

基于区域检测的跟踪算法成为目前视觉跟踪领域的一个热点方向。核心是用学习所得到的外观模型对图像中每一帧的位置和区域进行判别,找出目标的可能位置。目标模板的选择对算法性能有着重要的影响。例如,颜色直方图是目前应用广泛的目标模型,这种方法虽然简单,但丢失了像素的位置信息,使其易受遮挡、光照变化的影响。

Sevilla-lara等首次提出了分布场的概念,引起广泛关注。分布场是一类特征描述符的一般化,并不能对目标的特征做出完整描述,因此所能达到的性能有限。

本文中,以分布场目标跟踪算法为研究对象,克服了原始分布场的局部搜索和实时性差的局限,将单一特征与SURF特征相融合来提高分布场跟踪算法的鲁棒性,并加入TLD算法的失败检测机制以提高跟踪效率,最后通过实验对融合方法的有效性进行验证。

2 分布场简介

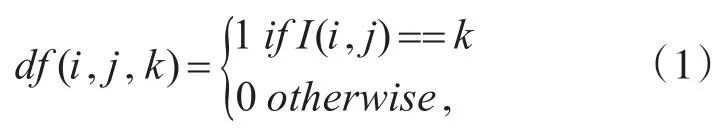

分布场是一个概率分布数组。如果特征空间表示图像的灰度值,那么每个位置字段(像素位置)会有一个概率分布在0~255的值。DF是表示为一个矩阵d(2+N)维度,分别表示图像的宽度和高度。在分布场内DF分解图像I可以定义为

当i和j是索引图像的行和列的值时,k是像素的可能索引值。因此每一个k值对应一个层。在这一点上,分布场表示包含相同的信息作为原始表示。

为了更好地使用分布场进行目标跟踪,对分布场进行一定的平滑处理可引入一定的不确定性从而减少噪声的干扰。平滑分布场dfs可以定义为

h(x ,y)表示二维高斯核函数,*为卷积运算。

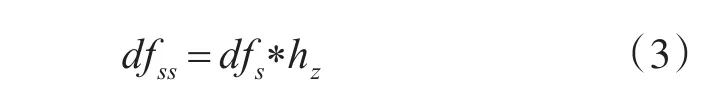

可以进一步把平滑dfss与空间平滑分布场的关系表达为

hz表示一维高斯核函数的特征维度。

比较不同图像的分布场可以使用任意距离函数来完成。为了度量两个分布场的相似性,我们用L1范数表示两个数组d1和d2之间的距离:

两个分布场的距离越小,相似性越高。

3 基于分布场的特征融合重检测鲁棒性算法

作为一种特征描述符,分布场仅能刻画目标像素值在灰度空间上的分布特性,分布场与SURF特征融合的方法,其中面临的问题有:分布场的相似性通过L1范数表达,而其数值并不具有概率意义,不能作为当前结果的置信值。与其他特征进行融合时,不能使用传统的置信度判决或加权平均方法。

3.1 SURF特征与分布场的融合

3.1.1 SURF特征

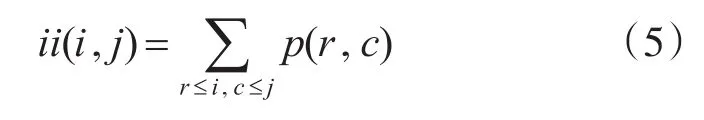

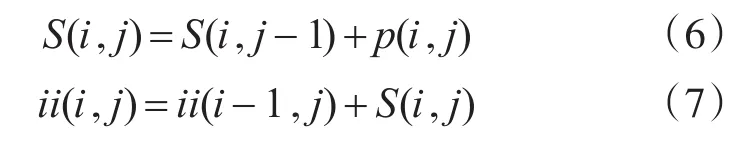

积分图像是图像与高斯二阶微分模板的滤波,可以转化为对积分图像的加减运算。在图像中任意一点(i,j),从原图像左上角到点(i,j)相应的对角线区域灰度值的总和,表示这一点(i,j)的积分图像值ii(i , j) ,即

式中,p(r,c)表示图像中点 (r,c)的灰度值,ii(i,j)可以用下面两式迭代计算得到。

因其在精度和计算时间上的良好性能,我们使用基于Hessian的矩阵。在图像中给定一个点x=(x,y),在点 x的 σ 规模的Hessian矩阵 H(x,σ)可以定义为

高斯尺度空间分析是最佳的。使用近似二阶高斯导数,可以使用积分图像的快速评价。其性能相当于一个使用离散化和剪裁的高斯。

图1 高斯二阶微分简化表示

首先选用模板的大小为9×9,并把这一模板作为选定的最小值来对σ=1.2的高斯二阶微分滤波器进行滤波和斑点检测。我们使用Dxx、Dxy和Dyy表示模板与图像之间进行卷积的结果。可以简化得到行列式。

可以使用以上公式近似得到某一点的响应值。在图像中遍历所有的像素点,可得到在这一尺度下的响应图像。尺度空间通常被实现为图像金字塔。将尺度空间进行分组划分。一个组代表逐渐增大的滤波模板,并对图像进行滤波的响应计算。在这一过程中,每一组由固定的层组成。层与层之间的变化由响应长度k决定相应的规模。在这基础上将尺寸增量翻倍就可以得到下一组滤波器的尺寸。

图2 尺度空间

为了保持不变的旋转,确定一个可重复的方向感兴趣点。特征矢量生成的第一步是构造一个正方形兴趣点,并沿着上节产生的特征点方向。

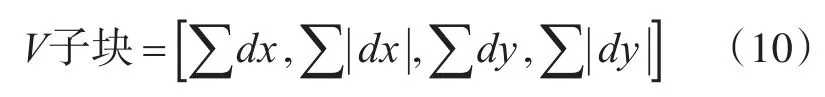

dx和dy总结各个区域,形成整点的第一个的特征向量。为了带来的强度变化极性信息,可以提取响应的绝对值之和。因此,对基本强度V的思维描述表示为

图3 构造surf特征特征点描述算子

3.1.2 系统实现

D=∑(ln-ln')设i为目标中的一个点,它的原始分布场可表示为 Di=(l1,l2,l3,…,ln),与此同时,提取该点的SURF特征,表示为 Si=(k1,k2,k3,…,kn),设点i包含分布场信息与SURF特征的表示为Hi,那么 f(h)=f(d)+f(s)。设ln′为待选区域点i的分布场,则对于点i分布场相似性D=∑(ln-ln'),设kn′为待选区域点i的SURF特征向量,那么对于点i的相似度可表示为S=kn-kn′。为了提高匹配的精度,在分布场表示的基础上,对于目标点增加了SURF特征的表示,那么对于点i的相似度我们可以表示为ΔH=ΔD+ΔS,ΔD表示点的灰度引起的差异,ΔS表示点的结构引起的差异,当Hi为最小时,认为目标点与待选区域重合。

这种将SURF特征融合与分布场的跟踪算法的实现过程如下:

1)选择目标点并构造包含点的信息的函数Hi=Di+Si,那么基于分布场初始模板可以定义为,含有SURF的初始模板定义为sm1;

2)提取待检测点的SURF特征 sm′,用E=edge(I)表示目标中包含结构信息的点的集合,初始化两级平滑尺度下的目标模型=(df(E)+df(I))*hδs(i)*hδf,i=1,2 ;

3)从第二帧开始对视频的每一帧,以上一帧目标位置为中心,以30像素为搜索半径确定待选区域If;

3.2 基于分布场的重检测跟踪算法

在分布场跟踪算法中,没有相应的跟踪失败检测机制,致使跟踪的效率不是很高,引入TLD算法的失败检测机制,以改进分布场跟踪算法。对于整个视频序列,可以把它当做是一个动态的随机系统,而目标的位置信息和大小就是系统的状态,算法过程如下:

第一步初始化边界框。把目标的状态用边界框FB来表示,当确定跟踪目标的边界框后,我们以FBi表示跟踪目标的边界框,在TBi内用网格取样,均匀的选取N个像素点 x1,x2,x3,…,xn,N的值根据实际情况进行选取,如果初始目标框太小,最终计算的置信度会不准确。

第二步跟踪失败检测。对于已选择的像素点,利用金字塔LK光流法跟踪,得到像素点y1,y2,y3,…,yn,再用金字塔LK光流法跟踪上一帧中的像素点 f1,f2,f3,…,fn,计算像素点的跟踪前向和后向的误差FB_error[i]。在模板匹配中,用归一化相关系数匹配法(NNC),计算xi和 yi中像素点的相关系数simi。取相关系数的中值S1,找出 yi中相关系数大于中值系数的点 y1,y2,y3,…,ym,取向后跟踪的误差中值 S2,找FB_error[i]≤ M2的点p1,p2,p3,…,pm,1<m<n 。

第三步预测跟踪目标位置。当跟踪到的像素点个数大于1时,说明跟踪成功。接下来用跟踪到的像素点 p1,p2,p3,…,pm与上一帧中对应的像素点 x1,x2,x3,…,xm,求它们之间像素点的位移,并求出位移中各像素点位移的中值,根据中值预测跟踪目标框的位置和大小,得到FBi+1。如果得到的像素点的个数小于1,那么说明跟踪不成功,或者预测到的目标框位置超出了图像范围,这种情况下,重复进行第一步。

第四步计算当前跟踪目标框的置信度。把跟踪目标框FBi+1缩放成15×15像素的图像块,计算图像块的均值和方差,将其转化为均值0的图像块。根据转变后的图像块,计算出跟踪目标框和在线模型的置信度,如果大于某一值,则说明跟踪有效。

4 实验与分析

计 算 机 硬 件 配 置 为 Intel(R)Core(TM)i7-4770 CPU,主频3.40GHz,内存容量为8.00G,操作系统为Windows 8.164位操作系统,编程环境为Matlab2014a。笔者提出基于分布场特征融合重检测跟踪算法(Robust Feature Confusion Distribution Field Tracking,REFIT)。

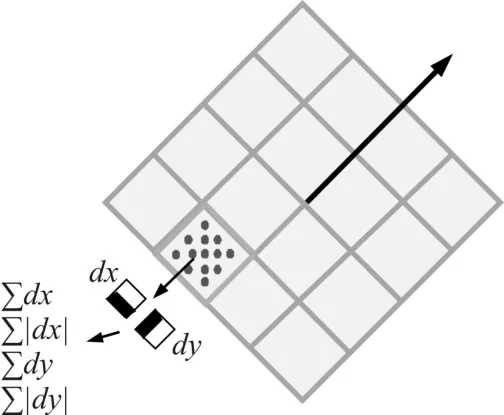

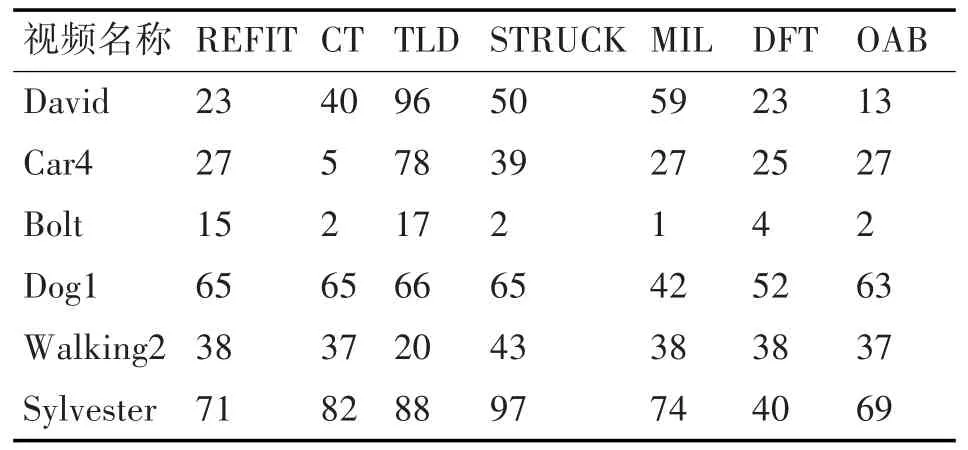

在本文的测试中,使用吴毅等提供的跟踪评测数据集。6个视频序列分别为David,Car4,Bolt,Dog1,Walking2,Sylvester。测试的算法有CT、TLD、STRUCK、MIL、DFT、OAB(如表1)。用于测试的算法参数设置与提供代码中保持一致。

对于本文中REFIT算法,在试验中对参数进行如下设置:分布场的层数b=16,混合参数λ=0.95,一维平滑高斯核函数的宽度分别为[8,16],方差为[4,9],二维平滑的高斯核函数的宽度为6,方差为0.625。

本文提出算法通过给出的视频序列进行了测试,并与其他比较成熟的跟踪算法进行了性能比较。测试的算法有CT、TLD、STRUCK、MIL、DFT、OAB。这几种跟踪算法的简要介绍如表1所示。

4.1 评价方法

在这项工作中,本文使用中心差和成功率进行定量分析。此外,同时也评估了跟踪算法的鲁棒性。

4.1.1 中心差

一种广泛使用的评价指标对跟踪精度的中心位置误差,可以表示为跟踪目标的中心位置和手动标记的矩形框之间的平均欧氏距离。

上式中x表示跟踪算法初始人工标定的目标矩形框的中心点的坐标,^x表示跟踪算法得到的目标矩形框的中心点坐标。中心差从直观的角度反映了跟踪算法对目标跟踪的结果偏移正确结果的误差。

4.1.2 成功率

另一个衡量标准是成功率。它是跟踪结果中的目标矩形框与开始时人工标定矩形框的交集的面积与并集面积的比值,可以表示为

公式中r是初始人工标定矩形框,^r是算法得到的矩形框。公式中交集与并集的面积可以如图4所示。图中使用相同的面积表示了跟踪前后的矩形框,在跟踪算法中,可以通过上面的覆盖率公式计算得出目标位置和大小与初始人工标定的矩形框的覆盖率的值,将这一数值与0.5作比较,判断是否跟踪成功,而后计算成功的跟踪的帧数占视频总帧数的百分比。

4.2 定量分析

跟踪算法在每一视频序列中测试的中心误差如图4和5所示。7个跟踪算法在10个视频测试序列中的平均中心误差如表2所示,各算法的跟踪成功率如表3所示。

图4 不同跟踪算法的跟踪结果

表2 不同跟踪算法的中心差(单位:像素)

表3 不同跟踪算法的成功率(单位:百分比)

可以看出,本文提出的基于分布场的特征融合重检测算法在中心差上,在大部分测试视频上明显低于基于分布场的跟踪算法。在成功率上,也在大部分测试视频上高于基于分布场的跟踪算法。总体来说,从定量分析上来看,本文提出的算法优于基于分布场的跟踪算法。

4.3 定性分析

4.3.1 姿势和光照变化

对于David室内的序列如图5所示,当人走出黑暗的会议室时,由于光照和姿态的变化而逐渐改变。TLD,CT,DFT和REFIT算法在这个序列上表现良好。TLD方法效果很好,因为它使用了一个探测器,用Haar特征进行跟踪。在Sylvester序列中,对象进行大的姿态和光照变化。TLD,STRUCK,CT,MIL,REFIT和DFT算法对该序列进行较低的跟踪误差,比其他方法执行好。

图5 不同跟踪算法的跟踪结果中心差

在Car4测试序列中,也包含了光照和尺度的变化。REFIT算法在这一序列上表现良好。OAB和MIL算法在跟踪执行到汽车进入到桥的阴影后,因为受到光照变化的影响,跟踪目标丢失。Struck算法虽然可以完成整个跟踪过程,但仅仅提供了位置信息,无法自适应完成目标跟踪。TLD算法可以自适应的跟踪目标的大小,但在跟踪过程中,它的跟踪尺度不能随目标变化而发生变化。

4.3.2 遮挡和姿态变化

在Walking视频序列中,包含了遮挡、尺度变化和目标像素低的特点。MIL和CT算法在跟踪过程中由于目标遮挡而发生失败,转而跟踪另外的目标,原始跟踪目标丢失。在目标遮挡后,TLD算法也停止了对目标的继续跟踪。OAB和Struck算法基本不受遮挡的影响。DFT和REFIT算法在目标被遮挡的情况下,效果也不是很好。

4.3.3 旋转和快速运动

在Dog1视频序列中,目标发生了剧烈运动和比较大的尺度变化。用于测试的算法都能完成对目标的跟踪,但是这些算法都不能给出目标的大小信息。从中心差的角度来看,这几种跟踪算法表现差距不大。但在成功率上,本文提出的算法有很大的优势。在Bolt视频序列中,同样包含高速运动的目标,但是尺度和光照始终变化不大。各种算法的跟踪效果明显有着很大的差异。大部分跟踪算法跟踪丢失,跟踪成功率很低。由于目标的快速运动,视频开始时,跟踪算法就已丢失目标,可见大部分跟踪算法在处理快速运动的目标时还有局限。

4.4 定性分析

用论文提出的基于分布场特征融合重检测算法(REFIT)与CT、TLD、STRUCK、MIL、DFT、OAB算法在10个视频序列上进行测试,这10个视频序列包括:David,Car4,Bolt,Dog1,Walking2,Sylvester。这7种跟踪算法利用这些视频序列测试的跟踪结果如图4和5所示。

跟踪算法在每一视频序列中测试的中心误差如图4和图5所示。7个跟踪算法在10个视频测试序列中的平均中心误差如表2所示,各算法的跟踪成功率如表3所示。

5 结语

本文从两个方面提出了对于基于分布场目标跟踪算法的改进,分别是特征融合和重检测,从实验的结果来看,这些改进对于跟踪效果在某些方面有了明显的提高,本文引入了TLD算法的失败检测机制。在这一这过程中使用了LK光流法来实现。但是光流法必须满足三个约束条件,相对来说,这些条件对于某些视频序列要求比较严格,因此容易发生跟踪失误。例如对于目标过大的运动目标和运动速度过快的目标都不适用此算法。为了更好解决这一不足,在今后的研究中,可以考虑引入金字塔光流法。

[1]Cannons K.A Review of Visual Tracking[J].Dept.comput.sci.eng,2008.

[2]Kalal Z,Matas J,Mikolajczyk K.P-N learning:Bootstrap⁃ping binary classifiers by structural constraints[J].2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition,2010,238(6):49-56.

[3]Lin R S,Yang M H,Levinson S E.Object tracking using

[4]Ji H.Real time robust L1 tracker using accelerated proxi⁃mal gradient approach[C]//IEEE Conference on Comput⁃er Vision and Pattern Recognition.IEEE Computer Soci⁃ety,2012:1830-1837.

[5]C.Bao,Y.Wu,H.Ling,and H.Ji,“Real time robust l1 tracker using accelerated proximal gr-adient approach,”in Proceedings of IEEE Conference on Computer Vision and Pattern Recognition,pp.1830-1837,2012.

[6]Viola P,Jones M.Rapid Object Detection using a Boosted Cascade of Simple Features[J].Proc Cvpr,2001,1:511.

[7]Wu Y,Lim J,Yang M H.Online Object Tracking:A Benchmark[J].2013,9(4):2411-2418.

[8]Hare S,Saffari A,Torr P H S.Struck:Structured output tracking with kernels[C]//International Conference on Computer Vision.IEEE Trans Pattern Anal Mach Intell,2011:263-270.

[9]Paragios N,Deriche R.Geodesic active contours and level sets for the detection and tracking of moving objects[J].IEEE Transactions on Pattern Analysis&Machine Intelli⁃gence,2000,22(3):266-280.

[10]Comaniciu D,Ramesh V,Meer P.Real-time tracking of non-rigid objects using mean shift[C]//Computer Vi⁃sion and Pattern Recognition,2000.Proceedings.IEEE Conference on.IEEE,2000:2142.

[11]Nguyen H T,Worring M,Rein V D B.Occlusion robust adaptive template tracking[J].Proc.of International Conf.on Computer Vision,2003,1:678-683.

[12]Matthews L,Ishikawa T,Baker S.The template update problem[J].IEEE Transactions on Pattern Analysis&Machine Intelligence,2004,26(6):810-815.

[13]Jepson A D,Fleet D J,Elmaraghi T F.Robust Online Appearance Models for Visual Tracking[C]//Computer Vision and Pattern Recognition,2001.CVPR 2001.Pro⁃ceedings of the 2001 IEEE Computer Society Conference on.IEEE,2001:1296-1311.