基于变换函数与填充函数的模糊粒子群优化算法

2018-03-10吕柏权张静静李占培刘廷章

吕柏权 张静静 李占培 刘廷章

粒子群优化算法 (Partical swarm optimization,PSO)是由Kennedy等[1]提出的一种基于群体智能的随机优化方法,为改善标准PSO算法在处理复杂多峰搜索问题时的全局寻优能力,学者们对此进行深入地研究和分析,吕强等设计粒子行为相应地改善了算法的寻优能力[2];Wang等提出了用拉丁矩阵设计粒子初始分布[3];Lu等提出了使用控制理论设计粒子群结构的新方法[4].从PSO算法[2−5]不难看出:PSO的目标函数作为评价函数参与调节目标函数变量的过程.从控制理论角度看, PSO算法相当于控制器,而目标函数相当于控制对象,PSO算法解优化问题可以看成控制系统解优化问题.这为PSO算法开辟新的发展空间.一些学者已开始控制系统用于优化问题的研究,Ustundag用简单的模糊逻辑控制器解决单反馈控制系统的一维优化问题[6],Jaewook等用两个阶段方法解决有少数局部极小值的全局优化问题[7],Nader等提出了一类空间分布系统用于解决带线性不等式约束的大型多参数二次规划问题[8].Angelia和Ion用下降方法构造不同的神经网络解决简单的约束优化问题[9−10].但这些方法仍无法应用于复杂的全局最优化问题[11−13].我们知道:对用于优化的控制系统,影响其输出的最重要的因素是控制器和控制对象(目标函数).本文结合PSO算法设计了新模糊控制器,它可以使每个粒子具有不同的规则分布,其模糊规则提高算法的全局搜索能力与局部搜索能力,改善PSO的早熟收敛缺陷;在不影响控制对象全局最优解的条件下,提出了一种变换函数对其进行简化,减少寻优过程陷入局部极小值的可能;构造的新填充函数能使寻优过程很好地跳出局部极小点至比它更小的点处[14−15].本文提出的基于变换函数与填充函数的模糊粒子群优化算法在保持粒子群算法简单,收敛速度快等特点的同时,有效地解决了陷入局部t最优的缺点,测试函数验证了该算法的有效性.

1 多回路模糊控制系统

本文考虑的优化问题为

这里f(x)为可导连续函数.

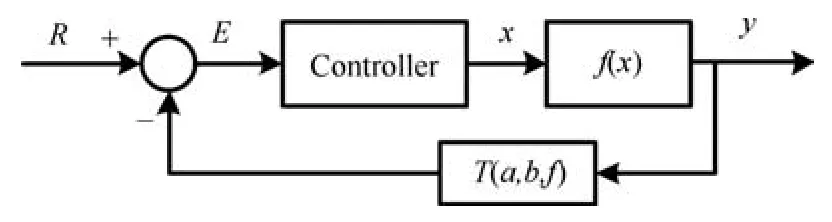

1.1 单回路控制系统

问题(1)的单回路控制系统如图1所示,其中f(x)为被控对象,R为常数输入.这里采用T(a,b,x)改变目标函数的表现形式而不改变目标函数的极值点位置,使目标函数的最优值与局部极小值拉开差距,减少计算过程陷入局部最优的可能,使寻优问题变得快速简单.变换函数的引入必须保证目标函数变换前后的极值点位置不变.

图1 单回路控制系统Fig.1 The single loop control system

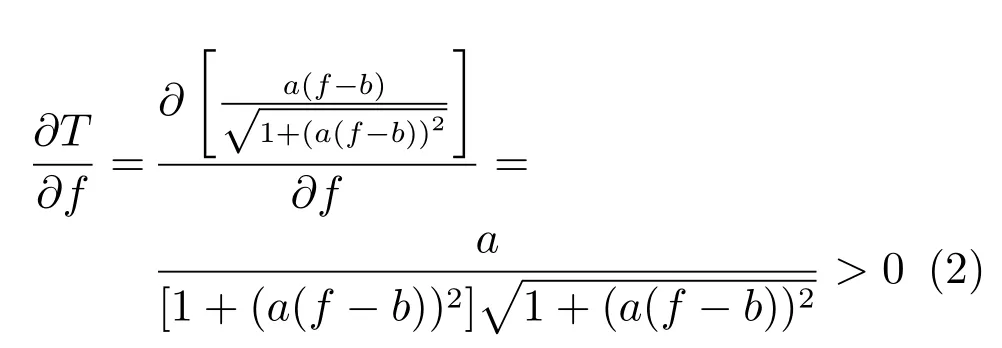

本文中反馈变换为T(a,b,x) =a(x−其为可导连续函数. 目标函数的极值点为0的解,而变换后的函数为T[f(x)] =它的极值点是的解.

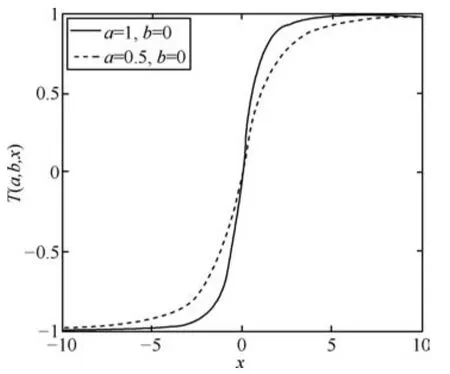

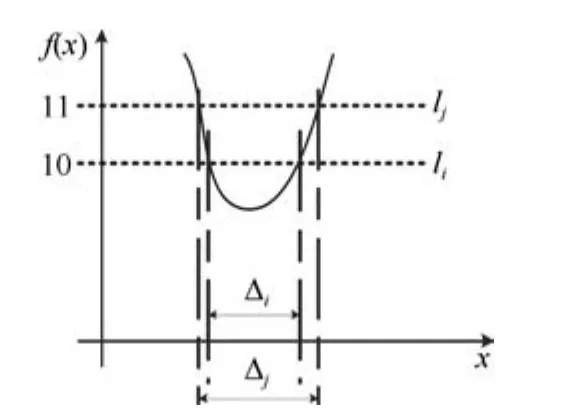

从图2可以看出,b=0时,变换函数T(a,b,x)在零点附近基本成正比,而远离零点的区域变换函数的值趋于1.当变换函数作用于目标函数时,其作用前和作用后的目标函数曲线在零附近形状变化不大,而目标函数值远离零的目标函数曲线趋于1,其形状变化大,呈水平状.这样只要关注由变换得到的新目标函数在零附近的全局最小点即可,从而减少计算过程陷入局部极小点的可能;且a越大,有效搜索范围越小;反之,a越小,有效搜索范围越大.以一维目标函数为例讲述变换函数参数b的作用:由图2可知,当a=1时,如果变换函数的自变量大于10,则变换函数值趋于1,因此其自变量有效变化区间为[—10,10].如图3所示,当b=0时,的直线li与f(x)有两个交点,此时的有效搜索范围应为Δi,而当b=1时,T[f(x)]=(f(x)−即f(x)=11的直线lj与f(x)有两个交点,此时的有效搜索范围应为Δj,由图3可知:Δi<Δj,即对于变换函数当a固定时,b越大,有效搜索范围Δj越大;反之,b越小,有效搜索范围Δi越小.

图2 变换函数图Fig.2 Transformation function curve

图3 目标函数平面示意图Fig.3 Objective function diagram

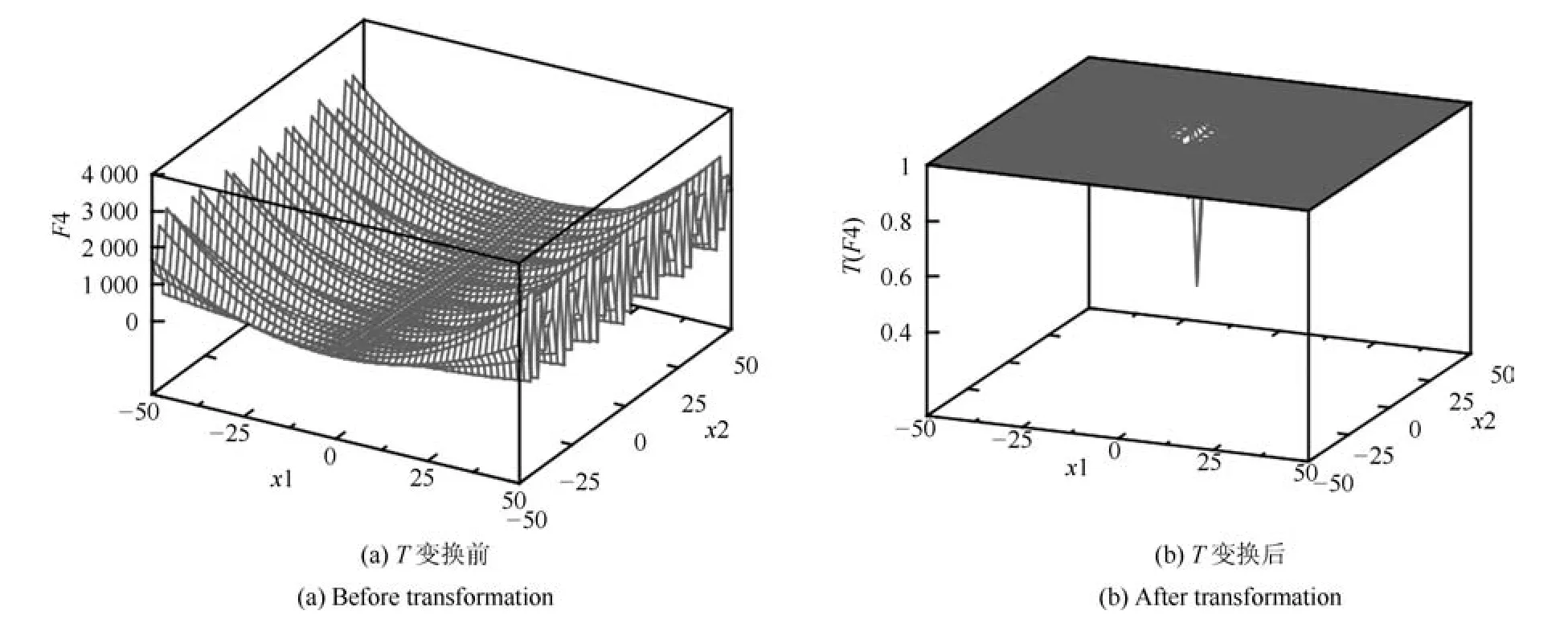

当取a=1,b=0,则T(a,b,x)=T(1,0,x)=变换前后的对比如图4和5所示,其中图4(a)和5(a)为表1中的F4函数和F11函数,可以看出它们有很多局部极值点,计算过程很容易陷入局部极值点;而图4(b)和5(b)为对应T变换后T[f(x)]图,可以看出原函数中很多局部极值被削减,而变换后最优值更好地突显出来,使计算过程更快速高效的找到最优值.所以变换函数用于反馈环节,减少算法陷入局部极值点的可能性.

图4 F4变换前后的曲线图即F4和T(1,0,F4)Fig.4 The curves of F4 before and after transformation:F4 and T(1,0,F4)

图5 F11变换前后的曲线图即F11和T(1,0,F11)Fig.5 The stereogram of F11 before and after transformation:F11 and T(1,0,F11)

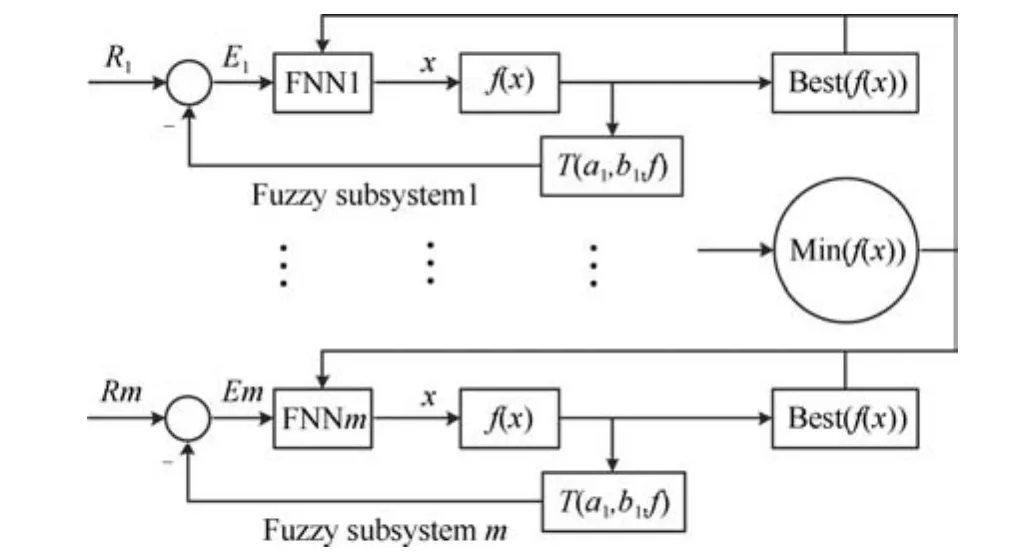

图6 多回路模糊控制系统框图Fig.6 A multi-loop distributed fuzzy control system

1.2 多回路模糊控制系统

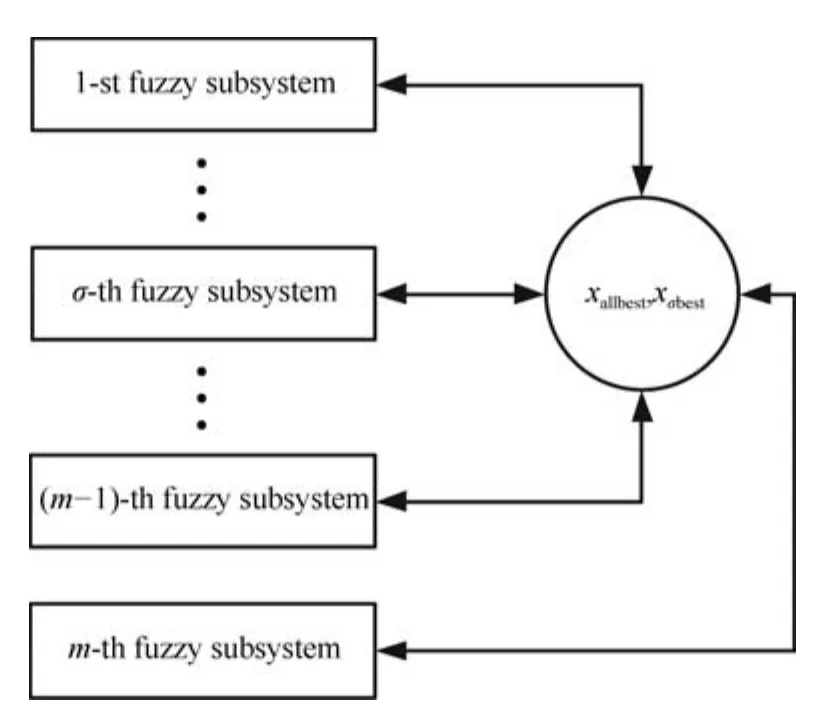

基于上述单回路控制系统,我们可得多回路模糊控制系统如图6所示,一个子系统相当于一个粒子,FNN1,···,FNNm为模糊控制器区别于m个不同的隶属度函数,同时体现系统的全局搜索能力与局部搜索能力,f(x)为目标函数,Best(f(x))为子系统的最优值(局部最优值),各个子系统共享所有子系统的最优值,根据共享信息迅速调整该子系统的寻优方向,min(f(x))为整个系统的最优值(全局最优值).以T变换后的函数值作为反馈.

2 模糊粒子群算法

2.1 粒子群算法

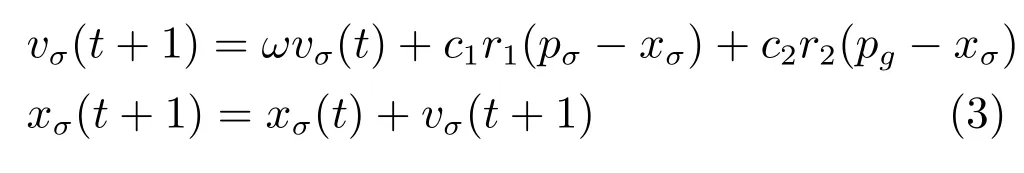

在标准 PSO 算法中,假设在一个n维的问题空间中,包含m个粒子,每个粒子作为搜索空间中待优化问题的一个可行解,通过粒子之间的协作与竞争来寻找问题的最优解. 在第t次迭代中,第σ个粒子的当前位置表示为xσ(t)=(xσ1(t),xσ2(t),···,xσn(t)),当前速度表示为vσ(t)=(vσ1(t),vσ2(t),···,vσn(t)),σ= 1,2,···,m.在每次迭代中,粒子个体搜索到的最好位置为pσ(t)=(pσ1(t),pσ2(t),···,pσn(t)),称为个体最优;群体中所有粒子搜索到的最好位置为pg(t)=(pg1(t),pg2(t),···,pgn(t)),称为全局最优.优化问题的过程可看作粒子不断更新的过程,每个粒子根据式(3)以当前速度、个体最优和全局最优来调整自己的飞行速度和方向,进化方程如下:

其中,r1、r2为[0,1]上的随机数;c1、c2为学习因子是一常数,表示粒子受自身及全局的影响程度,调节向个体最优和全局最优方向飞行的最大移动步长.式(3)中的第一部分称为动量部分,表示粒子对当前自身运动状态的信任程度,ω称为惯性权重,一般取[0.4,0.9]之间的数[1−5],使其依据自身速度进行惯性运动;第二部分称为个体认知部分,引导粒子飞向自身的最好位置;第三部分称为社会认知部分,表示粒子间的信息共享与相互协作,它引导粒子飞向群体中的最好位置.这三个部分之间的相互平衡和制约决定了算法的主要搜索性能.

2.2 模糊粒子群算法

因为传统PSO在全局极值pg或个体极值pσ得到局部最优解时,粒子群不会在解空间中再次进行搜索,而且其他粒子将迅速向局部最优解靠拢,所以使算法容易出现过早收敛导致不能得到最优解.又因为传统PSO的全局搜索模式相对单一,仅仅使用全局极值点的信息,而没有加入其他的参考信息,这样不利于种群多样性且阻碍算法扩大搜索的范围.

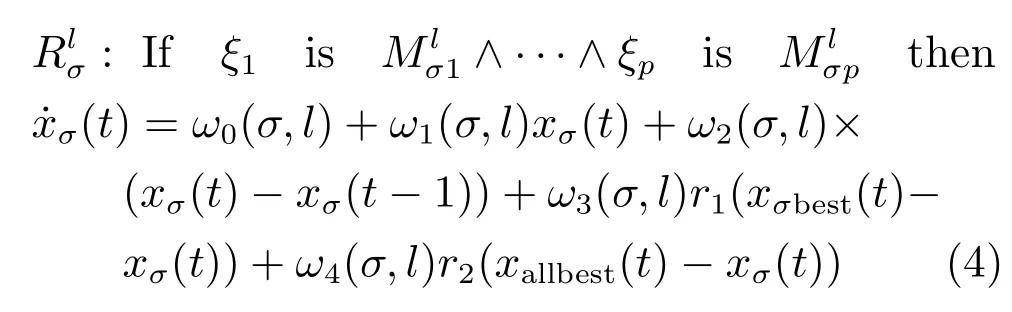

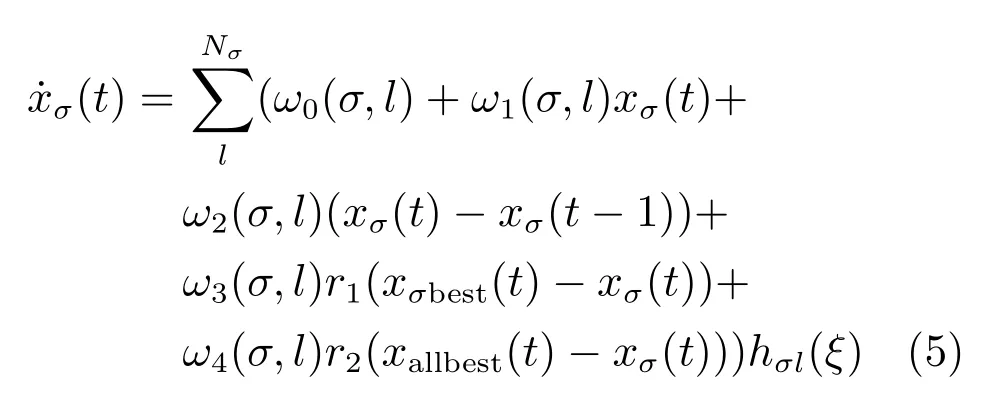

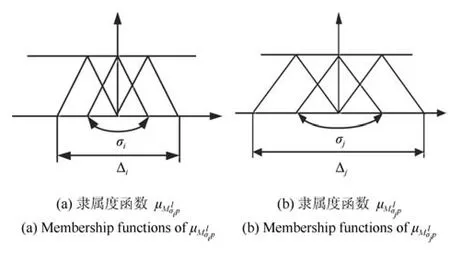

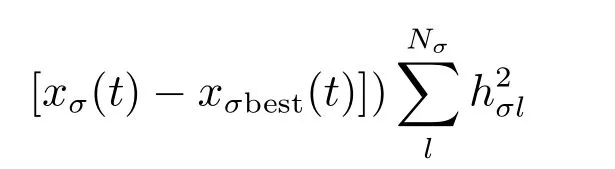

我们知道如果粒子数足够多,并且每个粒子的初始位置分布完全分散,则可以通过式(3)获得目标函数的全局最优解,但它需要大量的CPU时间.为了克服这个问题,我们必须减少粒子的个数,使有限粒子的初始位置尽可能分离.因为模糊决策通常具有分布特征,所以它可以使每个粒子具有规则的分布.基于此本文利用模糊控制器中所使用的模糊规则改进粒子群算法,提高算法的全局搜索能力与局部搜索能力,改善早熟收敛缺陷.根据Takagi−−Sugeno模糊模型,本文模糊控制系统的模糊规则采用如下:表示第σ个模糊子系统的第l个模糊规则,Nσ表示第σ个模糊子系统的模糊规则数,p表示第σ个模糊子系统的模糊变量数,xσbest是第σ个模糊子系统的最好位置向量f(xσbest)=mint≥t1f(xσ(t)),即是PSO中的pσ,xallbest是所有模糊子系统的最好位置向量即是PSO中的pg,根据PSO算法[3−4],xσ(t)是第σ个模糊子系统粒子的当前位置,ω0,ω1,ω2,ω3与ω4是第σ个模糊子系统的调整参数,其中ω0,ω1,ω2分别代表第σ个模糊子系统的变量xσ的零阶项系数,一阶项系数,变化差的系数,这相当于PI控制器系数;而ω3与ω4是相当于PSO系数.r1和r2是[0,1]范围内的随机数,也就是说,第σ个模糊子系统相当于PI控制和PSO的结合.采用加权平均法去模糊化,第σ个模糊子系统的全局模型可描述为

图7 不同宽度的隶属度函数Fig.7 The membership functions with diあerent width

图8 多回路控制系统关系图Fig.8 The relationship with all subsystems

由此可知对于m个模糊控制子系统,只需要设置变换函数的参数a的值就可以改变隶属度函数的宽度区间,即aσil>aσjl,则σi<σj.此时设置m个模糊控制子系统就是设置a为m行矩阵,ai的值越大,第i个子系统隶属度函数的宽度区间越窄,该模糊控制子系统的局部搜索能力越强,精度越高;相反,aj的值越小,第j个子系统隶属度函数的宽度区间越宽,该模糊子系统的全局搜索能力越强,搜索范围越大.当离散步长取一个非常小的正数时,式(5)离散化描述如下:

这里η4是离散步长,一个非常小的正数.式(6)的参数ω0,ω1,ω2,ω3和ω4修正如下:

其中,σ=1,2,···,m;l=1,2,···,Nσ;η1,η2,是很小的正数;m是子系统个数.

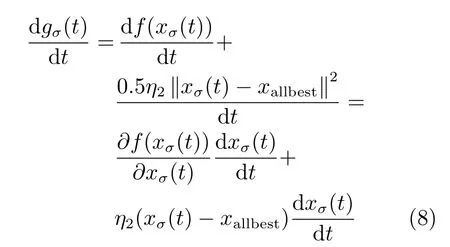

收敛性分析:构造一个 Lyapunov 函数gσ(t)=L+f(xσ(t))+0.5η2‖xσ(t)−xallbest‖2≥0,f(xσ(t))+L≥0,L=0.

把式(5)和式(7)代入上式得:

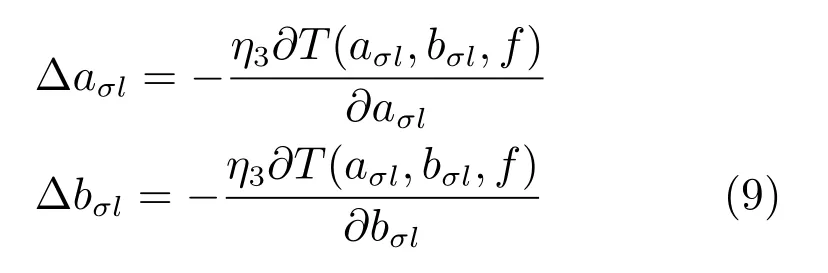

当然变换函数的参数a和b在迭代中,可由下式修正.

其中,η3是很小的正数.

3 填充函数法

上述算法改善了粒子群的全局搜索能力,但也有陷入局部极值点的可能性.为此,构造一个填充函数使其跳出局部极值点至更小的点,从而继续迭代搜索直到全局最优值.

填充函数法的主要思想是:如果已经找到了一个局部极小点x1,但它不是全局最小点,我们可以在x1处构造一个填充函数使迭代点列离开x1所在的谷域,找到更好的点x2(即x2处的目标函数值比x1处的目标函数值更小),然后以x2为初始点极小化原问题找到更优的极小点.

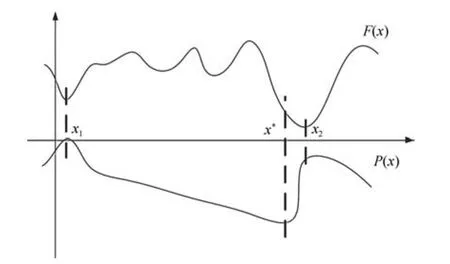

如图9所示,根据目标函数F(x)的一个已知极小点x1构造一个函数P(x),称为填充函数,它在x1处取得极大值,而在任何比x1的盆域B1高的盆域中没有极小点或鞍点,但在某个比x1的盆域低的盆域中有一个极小点或鞍点x∗,然后以x∗作为初始点去极小化F(x),并找到F(x)的一个新的极小点x2,使得F(x2)≤F(x1),用x2代替x1,重复上述过程,直到找到F(x)的全局极小点[14−15].

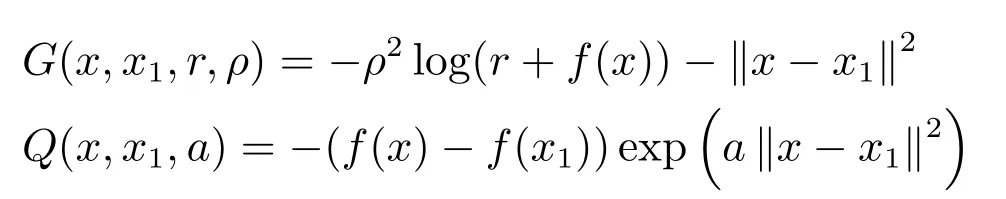

常用的填充函数有以下几种:

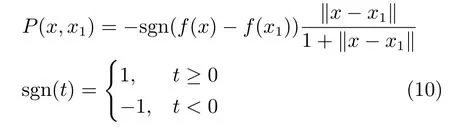

这里r,ρ以及a是计算过程中需要调整的参数,第一个填充函数为双参数,调节起来比较麻烦、费时,最后一个为单参数,可是只有当a很大时,才能成为x1处的填充函数,由于参数a在指数上,当a很大时,计算性能不理想.作者构造了一种新的填充函数:

该填充函数是无参的,节约冗长的计算步骤及调整参数的时间,提高算法的效率.

图9 填充函数示意图Fig.9 Graph of the fi lled function

以下说明P(x,x1)满足填充函数的条件:

1)如果x1是f(x)的一个已知的局部最小点,则x1是P(x,x1)的一个严格的局部最大点.

证明.设B1是f(x)在局部最小点x1的一个S型盆域,即对任意x∈B1有f(x)≥f(x1),则这表明x1是P(x,x1)的一个严格的局部最大点.

2)如果x1是f(x)的一个已知的局部最小点,且x∈S1={x|f(x)≥f(x1),x/=x1},则P(x,x1)在S1域内无固定点或者最小点.

证明. 因为则当f(x)>f(x1)和x/=x1,有∇p(x,x1)=如果d(x)=x−x1和x/=x1,则因此d(x)是对于任意x∈S1,P(x,x1)的一个速降方向.当f(y)=f(x1),有则对于满足‖x−x1‖>‖y−x1‖和‖x2−x1‖<‖y−x1‖的任意x,x2∈S1,有因此,p(x,x1)在S1域内无稳定点或者最小点.

3)如果x1是f(x)的一个已知的局部最小点,对于任意x2∈Ω,x2/=x1,如果f(x2)≥f(x1),则x2是P(x,x1)的一个连续点,或者x2是P(x,x1)的一个下半连续点.

证明.因为x1是f(x)的B1盆域内的一个局部最小点,所以对于任意x∈B1,有f(x2)≥0=P(x1,x1). 因此,P(x,x1)在x1点是连续的. 如果f(x2)/=f(x1)且x2/=x1,即f(x2)<f(x1)或f(x2)>f(x1),则p(x2,x1)=这样存在一个邻域N(x2,δ),δ>0使对于任意x∈N(x2,δ), limx→x1P(x,x1)=P(x2,x1),即P(x,x1)在点x2是连续的.如果f(x2)=f(x1)且x2/=x1,则因此x2是P(x,x1)的一个下半连续点.

4)如果x1是f(x)的一个已知的局部最小点,x2是满足f(x2)<f(x1)的另一个与x1邻近的局部最小点,则存在一点x′∈S2={x,f(x)<f(x1),x∈Ω}使得P(x,x1)最小,且它在x1和x′′的连接线上(x′′属于x2某一个邻域).

证明.已知局部最小点x2满足f(x2)<f(x1),则对于局部极小点x1,存在S型盆域B1,存在x3∈B1满足x3<x1,f(x3)>f(x1),则有由式(3)证明知,则存在一点x′∈S2={x,f(x)<f(x1),x∈Ω}使得P(x,x1)最小,且它在x1和x′的连接线上(x′′属于x2某一个邻域).

5)如果x1是f(x)的一个已知的局部最小点,d是满足dT(x−x1)>0的一个方向,如果f(x)>f(x1),则d是P(x,x1)在点x1的一个速降方向.

证明.因为f(x)>f(x1),dT(x−x1)>0,则因此d是P(x,x1)在点x1的一个速降方向.

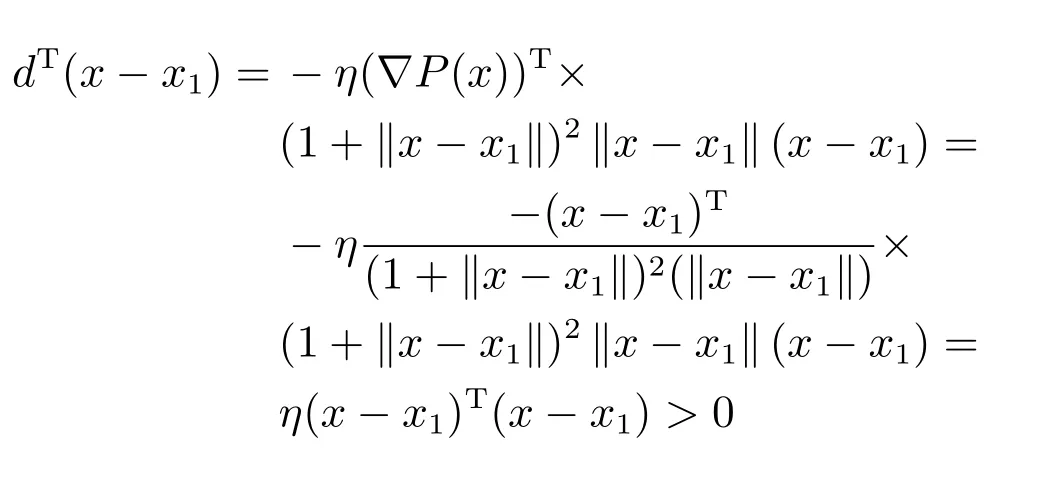

由上述式(1)∼式(5)的论述证明函数P(x,x1)满足构造函数的条件,可以作为构造函数使用.令d=−η∇P(x)(1+‖x−x1‖)2‖x−x1‖,其中η>0,x1是f(x)的一个已知的局部极小值点,x/=x1.

因此d=−η∇P(x)(1+‖x−x1‖)2‖x−x1‖是P(x,x1)在x1点的一个速降方向,在d方向上具有扩散性,能够扩散到搜索范围内的所有点,所以填充函数的迭代公式为

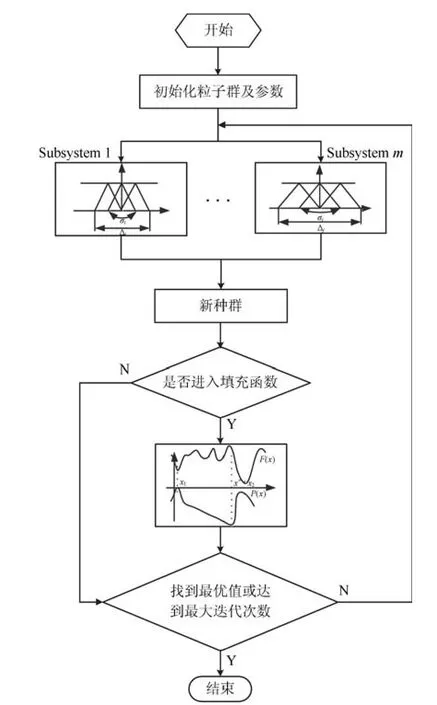

4FPSO-TF算法流程

FPSO-TF(Fuzzy partical swarm optimization based on fi lled function and transformation function)算法流程如图10所示,具体步骤如下:

图10 FPSO-TF算法流程图Fig.10 Flowchart of FPSO-TF algorithm

步骤1.给出变量Xn×m,系统输入R,模糊规则数Nσ,变换函数的参数a,学习系数η1,η2,η3,η4的初值,算法最大迭代次数MN,进入填充函数的最大次数TT,在填充函数中变量迭代的最大次FMN,以及填充函数迭代参数d1(0<d1<1E−5),d2(0<d2<1),d3(1<d3),d4(0<d4<1),d5(1<d5);令L=0,j=0,k=1;

步骤 2.令h(x)=f(x),由模糊粒子群迭代式 (6)更新Xn×m,使j=j+1,并计算f(x)=[f1,f2,···,fm](fσ(x)=Tσ(f(x)),σ= 1,2,···,m);如果fσ<fσbest(σ=1,2,···,m),则xσbest=xσ,fσbest=fσ;如果fσbest<fallbest(σ= 1,2,···,m),则xallbest=xσbest,fallbest=fσbest;

步骤3.如果|hσ(x)−fσ(x)|<d1,k≤FMN且fσ(x)≥fallbest,则进入填充函数循环迭代:k=k+1,xσ(i,k)=xσ(i,k)+d2(rand(1)−0.5)exp(d3(k−1)/FMN),σ=1,2,···m;i= 1,2,···,n,xσ(i,k)=xσ(i,k)+d4(rand(1)+ 1)exp(d5(k−1)/FMN)(xσ(i,k)−xallbest),并计算f(x)=[f1,f2,···,fm](fσ(x)=Tσ(f(x)),σ= 1,2,···,m);如果fσ<fσbest(σ=1,2,···,m),则xσbest=xσ,fσbest=fσ;如果fσbest<fallbest(σ= 1,2,···,m),则xallbest=xσbest,fallbest=fσbest;转至步骤3;否则,若k>FMN,则L=L+1,转至步骤4;若|hσ(x)−fσ(x)|>d1或fσ<fallbest,转至步骤4;

步骤4.根据式(7)更新参数ω0,ω1,ω2,ω3,ω4;如果j>MN或L>TT,则输出fallbest(xallbest),算法结束;否则,转至步骤2.

5 仿真

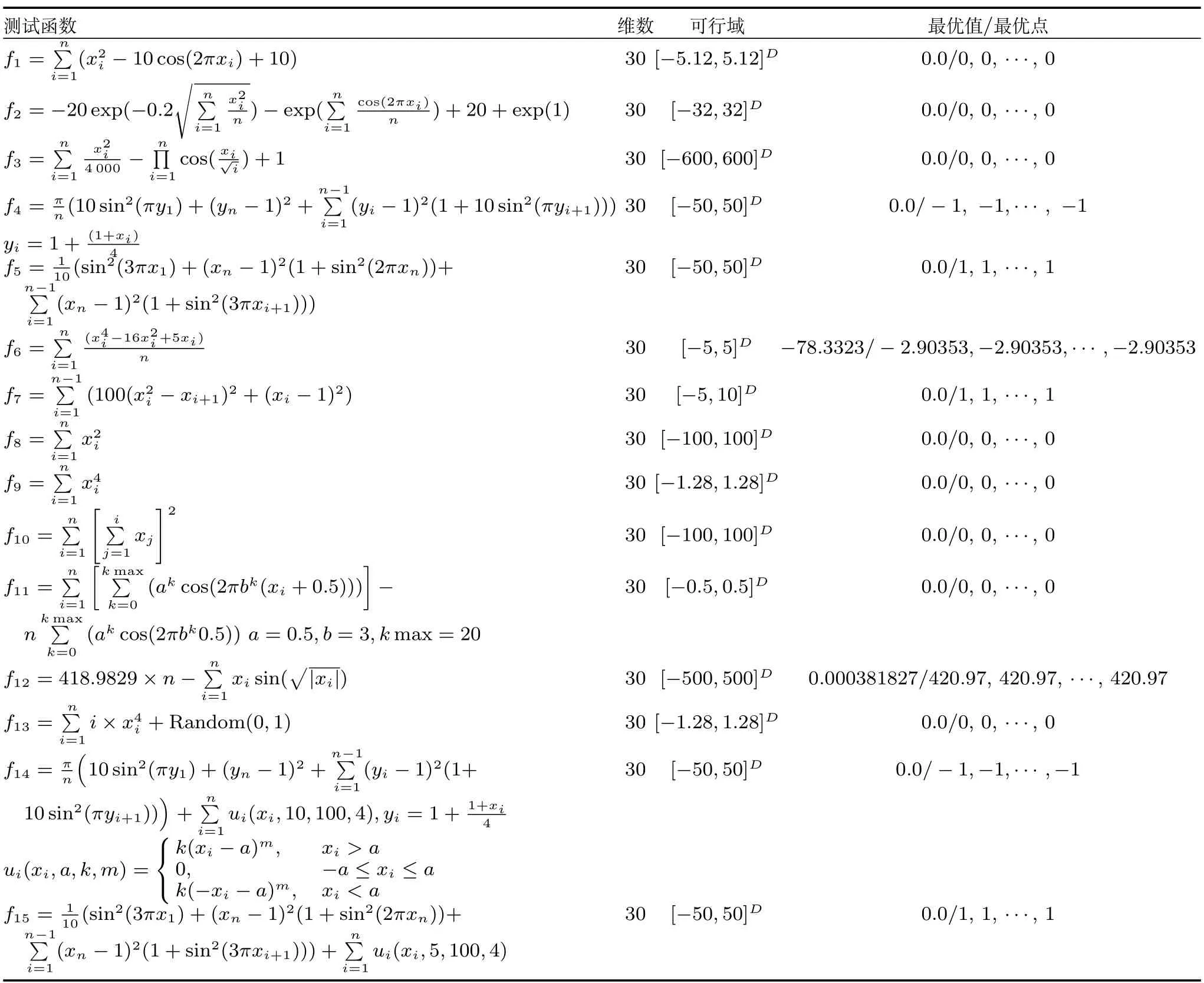

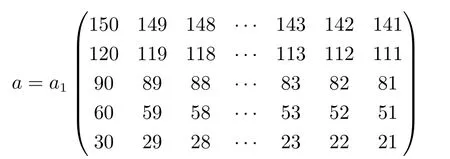

为了测试FPSO-TF算法的寻优能力,本文主要从两个方面来考核算法的性能:1)更高维函数测试;2)均值与方差. 本文选取了近年来文献给出的各种改进优化算法作为对比算法,用来作为评估本论文给出的算法性能的参照.这里表1给出了用于测试的15个基准函数,表2给出了15个测试函数初值,其中变量x的初值是在可行域内随机产生的,而参数ω0,ω1,ω2,ω3,ω4由式(7)得到.a矩阵为m×Nσ的矩阵,Nσ表示第σ个模糊子系统的模糊规则数,初值如下:

表1 测试函数Table 1 Test functions

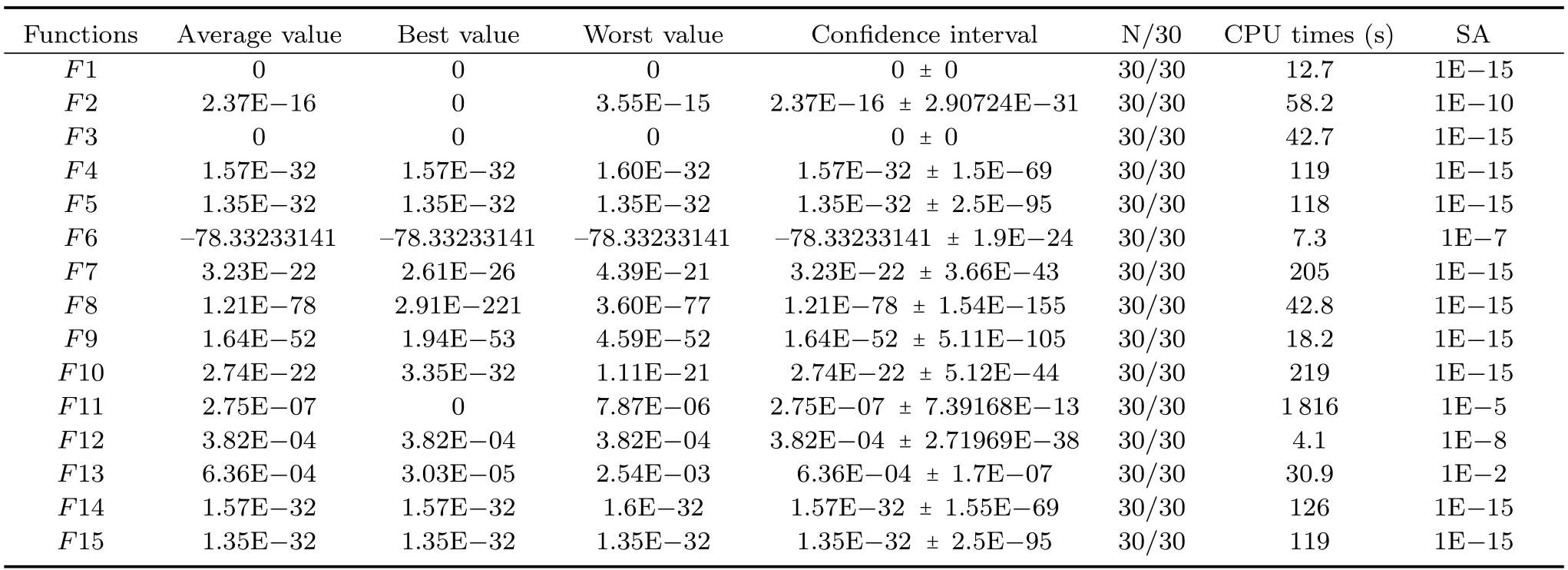

模糊子系统个数m=5,对不同的例子Nσ可以不同,如F1,Nσ=6,而F2,Nσ=5.当a=1,b= 0,x=6,变换函数这表明当|x|>6,T(aσl,bσl,f)的变化非常小,为了防止变换函数重叠,变换函数的参数bσl的初值由下式给出.采用本文提出的基于变换函数与填充函数的模糊粒子群优化算法对上述15个基准函数进行测试,按算法步骤在Matlab中编程仿真,每个函数运行30次,统计结果如下:表3给出了每个函数运行30次中的平均值,最好寻优结果,最坏寻优结果,95%置信区间,成功率和运行时间.这里成功率定义为N/30,其中N是运行结果满足|fi−fmin|<SA的次数,fi为第i次运行结果,fmin为被测函数的实际最优值.从中可以看出运行每一次都能搜索到最优值,运行30次的成功率为100%;寻优结果精度高,误差小,并且除F11外平均寻优时间短.体现了FPSO-TF算法的高效性.

表2 参数初值Table 2 The initial values of the parameters

表3 仿真结果Table 3 Results of simulation

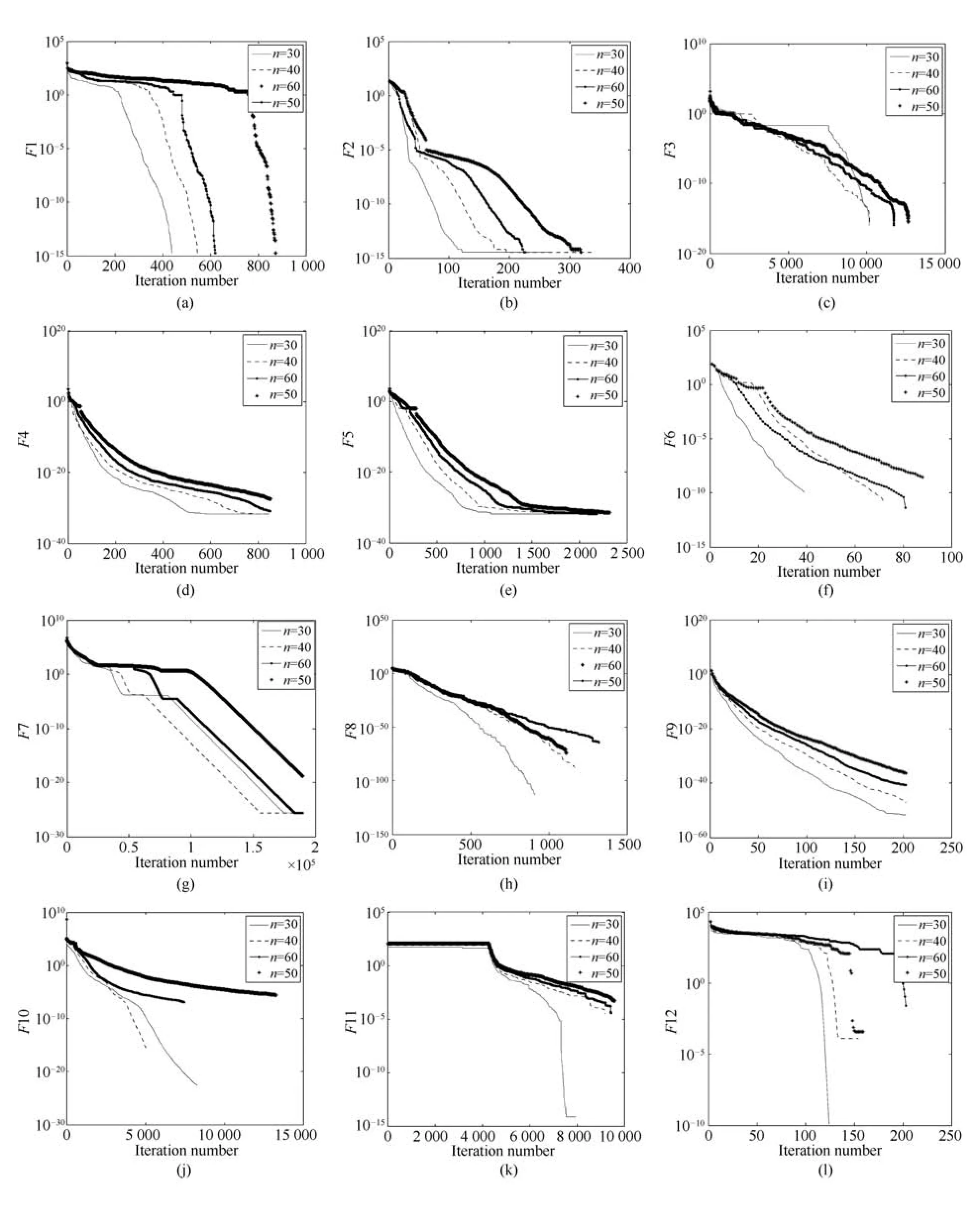

5.1 更高维函数测试

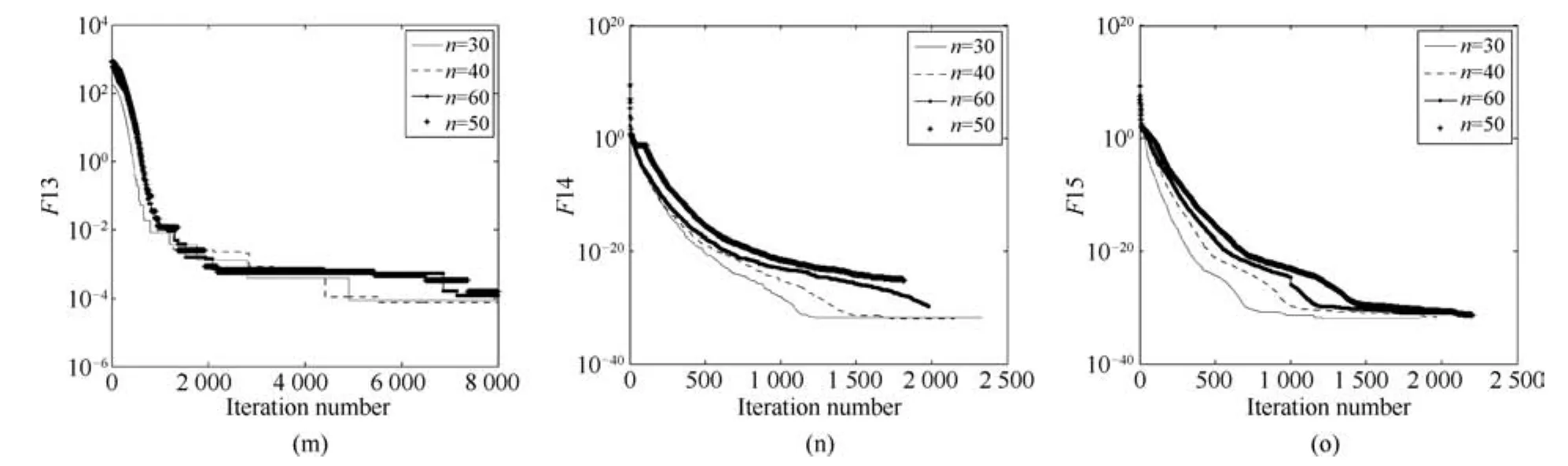

当函数的维数增加时,也就增加了问题的复杂性.为了进一步考察FPSO-TF算法的更高维寻优能力,使函数维数从30增至60,观察该算法的寻优收敛鲁棒性.设置测试函数F1∼F15的维数分别为n=30,n=40,n=50,n=60,且参数都使用维数n=30的.每个函数的寻优收敛曲线如图11所示,对于测试函数F1∼F8,F13∼F15随着维数从30增至60,其寻优曲线依然能收敛至足够精度的极值点,验证了该算法解决某些更高维多峰寻优问题的鲁棒性;虽然其他测试函数对于更高维没有表现出很好的收敛精度,但是对于30维均能收敛至高精度的极值点.这表明该算法很好地改善了传统粒子群算法的早熟收敛问题,同时验证了该算法的高效性.测试函数F7,F13的寻优曲线在收敛过程中均出现阶梯型平台,说明寻优过程陷入局部极小值点,此时体现了填充函数的有效性,使计算过程跳出局部极小值点继续寻优迭代至更小的极值点.并且大部分测试函数均能在较短时间内收敛至高精度的极值点,体现了提出的多回路模糊控制系统全局搜索和局部搜索能力.

5.2 均值与方差

表4给出了在一定精度内FPSO-TF算法与各种比较算法的均值与方差.这些指标反映了算法的优化能力强弱.其中对比的算法来源于文献[5]的各种PSO算法,参与对比的测试函数均采用30维,运行25次得到均值与方差.

表4 与现有算法的结果比较Table 4 Comparison with other algorithms

从表4可以看出,虽然仿真设定子系统个数为5个远比文献[5]所用的少,但对于F2、F7,F13用FPSO-TF算法获得的平均值与误差均比其他比较算法更小,体现了该算法的高效性;对于F1、F3、F12、F14、F15用FPSO-TF算法获得的平均值等于其他比较算法中的最优结果,误差与之相等甚至更小;只有F8的平均值比OGA/Q的差,仍然比其他算法结果的精度高.

表 4 也对这些算法按均值排序,最终顺序为:FPSO-TF、OGA/Q、JADECMAES、FEP、OLPSO-L、OLPSO-G.同时表4也给出了显著性水平为0.05,FPSO-TF和比较算法之间的t-test计算结果,当t-test为负时,意味着在均值和方差方面,FPSO-TF好于其他比较算法;反之亦然.

图11 (a)F1,(b)F2,(c)F3,(d)F4,(e)F5,(f)F6(这里曲线在每次迭代时都加78.33233140745),(g)F7,(h)F8,(i) F9,(j)F10,(k)F11,(l)F12(这里曲线在每次迭代时都加0.000381827),(m)F13,(n)F14和(o)F15的收敛曲线Fig.11 Convergence progress of the FPSO-TF on(a)F1,(b)F2,(c)F3,(d)F4,(e)F5,(f)F6(where curves are obtained by subtracting 78.33233140745 from the true value of F6 for each iteration),(g)F7,(h)F8,(i)F9,(j)F10,(k) F11,(l)F12(where curves are obtained by subtracting 0.000381827 from the true value of F12 for each iteration),(m) F13,(n)F14 and(o)F15

6 结论

本文结合粒子群优化算法与模糊控制系统,并采用变换函数与填充函数,提出了基于变换函数与填充函数的模糊粒子群优化算法(FPSO-TF).该算法通过设置m个不同宽度区间的的隶属度函数生成了m个模糊控制系统,从而控制粒子的搜索范围,使粒子更好地进行全局搜索和局部搜索,提高搜索效率与精度.同时,填充函数的引入使算法陷入局部极值点问题得到解决.最后的仿真结果与现有算法的比较结果表明该算法的有效性.

1 Kennedy J,Eberhart R.Particle swarm optimization.In: Proceedings of the 1995 IEEE International Conference on Neural Network.Perth,Australia:IEEE,1995.1942−1948

2 LvQiang,Liu Shi-Rong,Qiu Xue-Na.Design and realization ofparticle swarm optimization based on pheromone mechanism.Acta Automatica Sinica,2009, 35(11):1410−1419 (吕强,刘士荣,邱雪娜.基于信息素机制的粒子群优化算法的设计与实现.自动化学报,2009,35(11):1410−1419)

3 Wang Y P,Dang C Y.An evolutionary algorithm for global optimization based on level-set evolution and Latin squares.IEEE Transactions on Evolutionary Computation,2007, 11(5):579−595

4 Lu B Q,Gao G Q,Lu Z Y.The block diagram method for designing the particle swarm optimization algorithm.Journal of Global Optimization,2012,52(4):689−710

5 Zhan Z H,Zhang J,Li Y,Shi Y H.Orthogonal learning particle swarm optimization.IEEE Transactions on Evolutionary Computation,2011,15(6):832−847

6 Ustundag B,Eksin I,Bir A.A new approach to global optimization using a closed loop control system with fuzzy logic controller.Advances in Engineering Software,2002,33(6): 309−318

7 Lee J,Chiang H D.A dynamical trajectory-based methodology for systematically computing multiple optimal solutions of general nonlinear programming problems.IEEE Transactions on Automatic Control,2004,49(6):888−889

8 MoteeN,JadbabaieA.Distributed multi-parametric quadratic programming.IEEE Transactions on Automatic Control,2009,54(10):2279−2289

9 Nedic A.Asynchronous broadcast-based convex optimization over a network.IEEE Transactions on Automatic Control,2011,56(6):1337−1351

10 Necoara I.Random coordinate descent algorithms for multiagent convex optimization over networks.IEEE Transactions on Automatic Control,2013,58(8):2001−2012

11 Li Bao-Lei,Shi Xin-Ling,Gou Chang-Xing,Lv Dan-Ju,An Zhen-Zhou,Zhang Yu-Feng.Multivariant optimization algorithm and its convergence analysis.Acta Automatica Sinica, 2015,41(5):949−959 (李宝磊,施心陵,苟常兴,吕丹桔,安镇宙,张榆锋.多元优化算法及其收敛性分析.自动化学报,2015,41(5):949−959)

12 Lu Zhi-Jun,An Jun-Xiu,Wang Peng.Partition-based MQHOA for multimodal optimization.Acta Automatica Sinica,2016,42(2):235−245 (陆志君,安俊秀,王鹏.基于划分的多尺度量子谐振子算法多峰优化.自动化学报,2016,42(2):235−245)

13 Chen Zhen-Xing,Yan Xuan-Hui,Wu Kun-An,Bai Meng. Many-objective optimization integrating open angle based congestion control strategy.Acta Automatica Sinica,2015, 41(6):1145−1158 (陈振兴,严宣辉,吴坤安,白猛.融合张角拥挤控制策略的高维多目标优化.自动化学报,2015,41(6):1145−1158)

14 Ma S Z,Yang Y J,Liu H Q.A parameter free fi lled function for unconstrained global optimization.Applied Mathematics and Computation,2010,215(10):3610−3619

15 Gao C L,Yang Y J,Han B S.A new class of fi lled functions with one parameter for global optimization.Computers& Mathematics with Applications,2011,62(6):2393−2403