基于多维度体感信息的在线考试异常行为监测

2018-03-06范子健

范子健,徐 晶,刘 威

(华中科技大学电子信息与通信学院,湖北 武汉 430074)

1 引言

随着计算机技术和Internet的兴起与发展,利用联网的计算机进行在线考试日益成为一种趋势。目前,在线考试已成功应用于托福、雅思、在线学习、企业招聘等领域。与此同时,由于在线考试时间与空间上的不确定性,如何有效监测考试者的行为成为了一个愈发重要的课题[1]。

目前,在线考试监测主要集中在考试者的身份识别方面。例如通过对比指纹验证、虹膜识别、人脸识别、声音识别等方式判别是否存在替考现象[2]。然而,这种方式忽略了考试者在考试过程中的异常行为。考试者的行为通常表现在姿态上的变化:正常的考试者正视显示屏,双手放置在桌面上进行答题操作;而行为异常的考试者则会在考试过程中东张西望、交头接耳、低头查看资料等。

针对上述行为异常,传统的方案主要采用摄像头实时采集图像,并由监督者人工识别。近来一些图像分析技术被引入监测考试者的行为[3]。然而,这些基于2D图像的识别方法存在着一定的局限性[4]。首先,2D图像丢失了深度数据,无法精准判别人体姿态;其次,这些方法针对光照等环境条件鲁棒性较差。伴随着体感技术的进步,微软体感测量仪Kinect可以利用红外线测量深度信息并提供人体的骨骼位置和头部偏转角度信息,较之2D图像识别更加准确[5]。本研究组[6]前期利用Kinect采集的深度数据进行人体轮廓分析,从而实现了对学生举手、站立等行为的准确识别。综上所述,基于体感信息监测考试者的异常行为成为一种新的解决方案。

值得注意的是,即使获得了姿态数据,仍然面临着如何判别考试者行为异常的难题。同样的姿态在不同的情况下可能代表着不同的行为。例如同样是头部左右偏转,可能是正常的放松行为,也可能是异常的左顾右盼等等。因此,依据单一的姿态特征难以准确识别考试者的异常行为。

鉴于此,针对在线考试过程中考试者的行为监测难题,本文给出了一套基于体感信息的考试者异常行为监测解决方案,提出利用多维度体感信息判别考试者行为异常的方法,通过考试者行为事件的时间维度特征和频次维度特征综合判别考试者的当前行为是否异常。

本文组织结构如下所述:第2节介绍了本领域的相关工作;第3节详细描述了监测系统的设计方案以及基于多维度体感信息的考试者异常行为识别方法;第4节通过实验验证了监测系统和识别方法的实际效果;最后第5节对全文进行了总结与展望。

2 相关工作

Kinect是微软开发并应用于Xbox游戏机主机的体感设备,主要包含三个核心部件红外线发射器、RGB彩色摄像机以及红外线摄像机。其中,RGB彩色摄像机主要功能是采集彩色数据;红外线发射器与红外线摄像机共同构成了3D结构光深度传感器,主要用于采集深度数据。通过对深度数据和彩色数据的分析,可以得到使用者的骨骼关节点位置信息以及头部偏转角度信息等。

作为三维深度传感器,Kinect有着实时性强、价格低廉、精度高、鲁棒性强等优点,已被广泛运用于计算机视觉领域,特别是人的异常行为检测方面。Bevilacqua等人[7]提出了室内场景下的跌倒检测方法。文献[8]则将Kinect的音频检测以及骨骼检测应用到了人类攻击性行为预警上;而文献[9]则将Kinect与嵌入式系统结合,将之应用在了驾驶员的疲劳检测等方面。

近年来Kinect也出现了一些教育领域的应用。例如,Armin等人[10]利用Kinect辅助聋哑学生的教学;Vermun等人[11]利用Kinect采集姿态信息来评估学生当前的认知状态;Almohammadi等人[12]利用Kinect采集姿态信息并通过模糊判断来计算学生上课时的专注程度。

基于体感信息的考试者行为监测与教育领域的学生认知状态判别在方法和理论上有一定的相似性,但在线考试场景需要准确识别考试者的异常行为,现有方案并不完全满足在线考试监测的需求。考试中的异常行为通常表现出与正常行为类似的特征,不能通过单一的行为事件简单判别考试者的行为,而需要根据行为事件的上下文对行为进行综合分析。由此,本文提出了基于多维度体感信息的考试者异常行为监测方案。

3 监测系统的设计与实现

3.1 系统框架

系统的设计框图如图1所示,主要由数据采集模块、监测引擎以及异常行为记录模块组成。Kinect采集到的原始体感测量数据经过预处理后,由事件判别模块处理为事件向量。监测引擎不断对到来的事件进行统计分析,并依据行为模式规则综合判别考试者行为异常。当判定考试者的行为异常时,系统存档记录考试者异常行为前后一段时间内的视频数据以备查询。

Figure 1 System framework图1 系统框架图

3.2 关键模块

3.2.1 数据采集及预处理模块

本系统通过微软官方提供的Kinect API[13]获取考试者的头部偏转信息和骨骼坐标信息,即〈timestamp,pitch,yaw,(xl,yl,zl),(xr,yr,zr)〉。其中,timestamp表示采集到数据的时间戳,pitch表示头部俯仰角,yaw表示头部侧转角,(xl,yl,zl)与(xr,yr,zr)则用于表示手部坐标。利用这些信息可以确定使用者的面部朝向和手部位置,进而形成考试者的低头、侧头和手部置于桌面下方等事件。本系统将头部俯仰角、侧转角以及手部坐标作为三个原始数据输入流Xp、Xy和Xh。

由于Kinect的硬件限制,姿态测量数据存在不稳定性现象。例如:当头部偏转角度过大时,Kinect的头部追踪失效会导致测量数据丢失。一个头部侧转角度实例数据可能为“25.01,0,0,0,25.03,0,0,25.06,0,25.08,…”,其中0值即为测量数据丢失。因此,需要对原始数据的0值进行预处理,以消除其影响。鉴于人头部偏转的连续性,本文利用数据拟合的方法补齐丢失的数据。针对上述例子,预处理后的数据为“25.01,25.02,25.02,25.02,25.03,25.04,25.05,25.06,25.07,25.08,…”。

3.2.2 事件判别模块

由此,事件判别模块将数据流Xs映射为一个时间尺度上的行为事件向量,记为Vs=(e1,e2,…,ei,…),ei∈Es。整个考试过程中考试者的行为信息可以描述为V=〈Vp,Vy,Vh〉。

Table 1 Definition of single action event

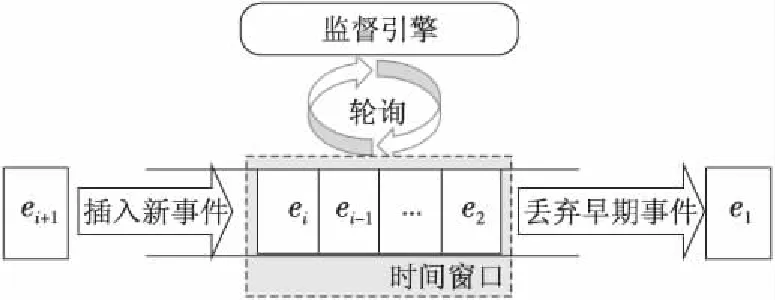

3.2.3 监测引擎

如前文所述,通过单一行为事件无法准确识别考试者的行为。因此,本文提出了基于多维度体感信息的异常行为监测引擎,如图2所示,监测引擎维持一个事件队列,并不断轮询事件队列中事件,读取事件属性,从时间维度以及频次维度统计事件特征信息。

Figure 2 Event queue in detection图2 监测引擎的事件队列

系统利用多维度特征参数σ、σs、n、ms定义考试者的异常行为模式。表2给出了若干参考异常行为模式的定义。

Table 2 Samples of misbehavior patterns

由此,系统通过匹配事件流的特征参数与异常行为模式,即可判别当前考试者的行为是否异常。值得注意的是,系统中的模式匹配规则以XML文件的方式组织,扩展性强,可以根据需求自行定义不同的模式以及相应的判别参数。具体的规则定义将作为本文的后续工作。

4 结果测试

为了验证方案的有效性,本文在实际场景下对系统进行了实验测试。

4.1 场景设置

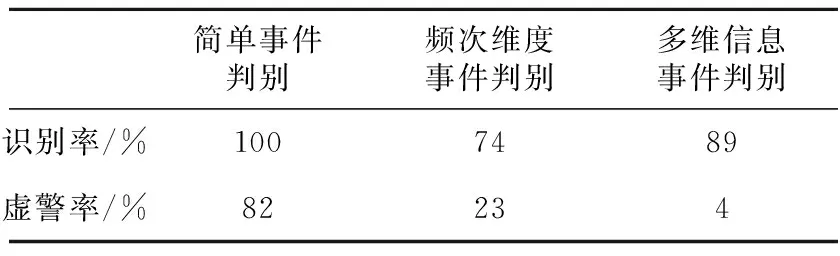

如图3所示,搭建一个单人的在线考试实验场景。其中,电脑桌尺寸为90 cm*70 cm,Kinect距离地面的高度h=120 cm,Kinect离考试者的水平距离d=100 cm,Kinect初始俯角α=10°。结合实际场景,本文对考试者的事件判别条件中的阈值进行设定,侧头的偏转角度阈值为±10°,低头的角度阈值为-15°。

Figure 3 Experiment scenario图3 实验场景示意图

实验分为数据预处理测试、行为识别功能测试以及实际监测效果测试三个部分。预处理测试主要验证了预处理的效果与必要性,在此基础上进一步验证了本系统在模拟实验环境以及真实考试过程中的异常行为识别效果。

4.2 实验结果分析

4.2.1 数据预处理测试

图4以考试者的低头角度数据说明数据预处理效果,其中纵坐标表示低头角度,横坐标表示数据产生的时间。如图4a所示,当头部偏转到一定程度的时候,Kinect采集的数据出现丢失现象。图4b表示预处理后的低头角度数据。如果原始数据未经过预处理,事件判别模块可能会将单一的低头事件误判为多个低头事件,从而造成监测引擎的误判。

Figure 4 Effect of data preprocessing on pitch angle data图4 低头角度数据预处理效果图

4.2.2 行为识别功能测试

图5为模拟实验环境下的一些具有代表性的异常检测结果。如图5a所示,模拟考试者在该时间窗口内摆头休息。其中实景图片表示几个不同时刻考试者的实景截图。下面的曲线图中,左图表示考试者的侧头角度的时间变化图,中间图表示低头角度关于时间的变化图,右图表示考试者手部y坐标关于时间的变化图。当考试者触发事件时,相应的类型状态置为1,否则为0。经统计分析可以得到时间维度信息σ1=0.28,σ2=0,σ3=0,σ=0.28与频率维度信息m1=8,m2=0,m3=0,n=8。经规则匹配σ<0.3,判定考试者行为正常。类似于图5a,图5b中的考试者发生行为异常,左顾右盼后低头翻看资料,该过程的时间维度与频率维度结果分别为σ1=0.24,σ2=0.26,σ3=0.26,σ=0.50和m1=4,m2=1,m3=1,n=6。由于满足异常判别规则σ>0.3,n>5,因此判定考试者行为异常。

Figure 5 Detection results图5 监测结果

4.2.3 系统实际监测效果测试

为了进一步验证本系统的异常行为识别效果,本文选取了20名在校大学生参与在线考试。考试时长60 min,考试过程全程录像。考试结束后组织专家进行录像分析,判定各个考试者在考试期间的行为异常,专家的人工判别结果作为基准。

此外,本实验对比了简单事件判别、频次维度判别、多维事件判别三种识别方法在考试者异常行为监测上的识别率和虚警率。其他两种方法如下所述:

(1)简单事件判别:仅仅通过一个单一的异常事件判别考试者的异常行为。

(2)频次维度判别:仅仅通过分析异常事件的发生频率判别考试者的行为异常。

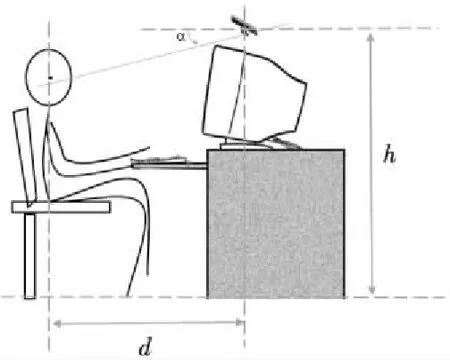

三种不同方案的监测结果如表3所示。

Table 3 Comparison results of three misbehavior recognition methods

简单事件判别虚警率高达82%;频次维度事件判别的识别率只有74%,虚警率却仍然有23%;多维事件判别则在保证识别率达到89%的基础上,虚警率仅有4%。综上所述,本文提出的方案可以较为准确地识别出在线考试过程中考试者的异常行为。

5 结束语

本文给出了一套基于体感信息进行在线考试过程中考试者异常行为监测的解决方案。通过Kinect采集的体感信息获得考试者的行为事件,并从时间维度与频率维度分析事件的特征,进而判断考试者的行为异常。实验表明,本方案可以较为准确地识别出在线考试过程中考试者的异常行为。在未来工作中,我们将继续开展多维信息综合判别规则的研究,并对综合判别机制进行完善,以减少测量误差的影响。

[1] Castella-Roca J,Herrera-Joancomarti J,Dorca-Josa A.A secure e-exam management system[C]∥Proc of the 1st International Conference on Availability,Reliability and Security(ARES’06),2006: 864-871.

[2] Sungkur R K,Beekoo I,Bhookhun D L.An enhanced mechanism for the authentication of students taking online exams[C]∥Proc of IEEE AFRICON,2013: 1-5.

[3] Zhang Guo-ling, Fan Ying.Exam taker behavior recognition in video surveillance[J].Control Engineering of China,2016,23(4):512-516.(in Chinese)

[4] Hu W,Tan T,Wang L,et al.A survey on visual surveillance of object motion and behaviors[J].IEEE Transactions on Systems,Man,and Cybernetics,2004,34(3): 334-352.

[5] Han J,Shao L,Xu D,et al.Enhanced computer vision with microsoft kinect sensor: A review[J].IEEE Transactions on Cybernetics,2013,43(5): 1318-1334.

[6] Zhang Hong-yu,Liu Wei,Xu Wei,et al.Depth image based gesture recognition for multiple learners[J].Computer Science,2015,42(9): 299-302.(in Chinese)

[7] Bevilacqua V,Nuzzolese N,Barone D,et al.Fall Detection in indoor environment with kinect sensor[C]∥Proc of 2014 IEEE International Symposium on Innovations in Intelligent Systems and Applications (INISTA),2014: 319-324.

[8] Pang J M, Yap V V,Soh C S.Human behavioral analytics system for video surveillance[C]∥Proc of 2014 IEEE International Conference on Control System,Computing and Engineering (ICCSCE),2014: 23-28.

[9] Schwiegelshohn F,Hubner M.Design of an attention detection system on the Zynq-7000 SoC[C]∥Proc of 2014 International Conference on ReConFigurable Computing and FPGAs (ReConFig),2014: 1-6.

[10] Armin K,Mehrana Z,Fatemeh D.Using Kinect in teaching children with hearing and visual impairment[C]∥Proc of 2013 4th International Conference on E-Learning and E-Tea ching (ICELET),2013: 86-90.

[11] Vermun K,Senapaty M,Sankhla A,et al.Gesture-based affective and cognitive states recognition using kinect for effective feedback during e-learning[C]∥Proc of 2013 IEEE 5th International Conference on Technology for Education (T4E),2013: 107-110.

[12] Almohammadi K, Yao B,Alzahrani A,et al.An interval type-2 fuzzy logic based system for improved instruction within intelligent e-learning platforms[C]∥Proc of 2015 IEEE International Conference on Fuzzy Systems (FUZZ-IEEE),2015: 1-9.

[13] Kinect for windows SDK[EB/OL].[2014-08]. https:∥msdn.microsoft.com/en-us/library/dn799271.aspx.

附中文参考文献:

[3] 张国玲,范颖.视频监控中的考生异常行为识别[J].控制工程,2016,23(4): 512-516.

[6] 张鸿宇,刘威,许炜,等.基于深度图像的多学习者姿态识别[J].计算机科学,2015,42(9): 299-302.