L2-SVM下的短文本情感分类动态CNN模型

2018-02-27鲁新新

鲁新新 柴 岩

(辽宁工程技术大学 辽宁 阜新 123000)

0 引 言

情感分类的目标是通过特定的方法分析、归纳和推理出该文本信息的创作者想要表达的情感、观点和立场,进而可以通过相关主观性信息将其划分为不同的情感倾向类别。这一研究在产品评价、评价分析、舆情监控等方面具有广泛的应用。

卷积神经网络(CNN)被广泛的应用到自然语言处理等领域,取得了较好的性能效果,诸如语义分析、实体识别、句子建模等。Santos等[1]提出利用两个卷积网络对短文本进行特征提取,一个提取字符特征,另一个网络提取句子特征,结合两者特征完成短文本情感。Wang[2]提出了聚合短文本语义的CNN方法,利用两层CNN网络提取短文本情感特征,采用K-mean完成文本情感聚类。Jebaseeli等[3]提出利用深度神经网络进行Twitter短文本情感分类方法,通过提取词向量中指定情感语义信息,构建情感分类系统,深度神经网络采用全连接操作,模型训练复杂。Yann等[4]提出带有门机制的CNN用于文本分类,门机制和LSTM中输出门相似,控制情感特征的选取在开放数据集取得比LSTM更好的效果。Kim[5]将卷积神经网络模型应用到文本分类中,采用三层卷积网络对文本数据进行建模,采用互熵目标函数,在不同文本评论数据集上表现出色。Kalchbrenner等[6]提出了动态卷积网络,动态池化函数加入卷积层数和当前层数等特征,对比传统的分类模型其效果有很大的提高。陈钊等[7]根据中文文本特征设计CNN结构用于中文情感分类,将情感词典特征加入到网络结构当中,构造情感字典增加人工开销。李培等[8]提出基于深层次句法分析角度进行网络数据情感倾向性分析,依存句法分析增加开销,在处理短文本时候有一定局限性。黄志勇[9]提出基于SVM和深度学习的情感分类算法,将word2vec提取的词向量直接输入到SVM分类器中,未充分提取情感特性。Zhang等[10]提出一种基于LDA的朴素贝叶斯方法处理句子级别情感倾向性方法,尽管一些监督学习[11-12]方法取得很好性能效果,但是监督学习方法依赖人工特征工程。

针对中文短文本稀疏的特点, 特征工程依赖人工规则,CNN模型参数优化过程未考虑梯度弥散问题。本文提出一种基于L2-SVM和动态CNN情感分类模型解决传统方法特征表述维数过高,文本表述稀疏问题。利用L2-SVM模型对参数进行优化,解决梯度弥散问题。在两个真实评估数据集上的实验, LDCNN能够准确地发现文本中的情感极性,性能明显高于经典同类方法。

1 卷积神经网络模型

CNN层结构各有不同,但它们的基本结构是一样的,标准的卷积结构包含卷积层、池化层和全连接层,见图1。

图1 卷积神经网络基本结构

1.1 卷积运算

卷积运算通常是对两个实值函数的一种数学运算。卷积运算公式:

(1)

第一个参数x称为输入,第二个参数w称为核。离散形式的卷积:

(2)

1.2 池化操作

CNN中的池化层是对数据特征进行压缩处理,起到数据降维作用,一定程度抑制过拟合现象。常见的池化操作分为:最大池化、K-Max池化和块池化。

1.3 激活函数

(3)

式中:类别分布概率pi:

(4)

(5)

2 LDCNN模型

LDCNN模型见图2,模型通过三次卷积操作,将原始输入的文本转化为顶层特征图谱。给定,X={xi:xi∈Rd×1,i=1,2,…,n}为原始输入文本,通过预训练词向量E,每一个文本xi映射为矩阵S∈Rd×s,其中d为词向量维数,s为文本长度,W为网络中权重向量。LDCNN模型定义一个非线性函数f(·):Rd×1→Rr×1(d≫r),能够将原始输入X转换为r维深度表述h。

图2 LDCNN结构模型

2.1 LDCNN动态池化函数

为了解决模型特征提取过程中维数过高和文本位置特征信息缺失问题,采用动态K-Max函数,动态函数可以根据实际具体参数情况进行池化尺寸的调整,使得文本中位置信息能够前向传播到顶层网络,保证文本特征提取的充分[13]。此时的k为动态函数,记为Φ(k),Φ(k)考虑到输入句子长度,卷积网络的深度,总的卷积层数。Φ(k)表达式如下:

(6)

式中:ktop为顶层最大池化数,L位总的卷积层数,|s|为句子长度,「⎤为向下取整操作。

2.2 LDCNN模型损失函数

针对经典CNN模型中互熵目标函数微分在反向传播过程中对低层次特征提取不充分,参数更新过程当中出现维度弥散现象,利用L2-SVM作为损失函数。给定训练数据(xn,yn),n=1,2,…,N,xn∈RD,tn∈{-1,1},带有约束性的支持向量机:

(7)

目标函数:

(8)

对于测试数据,预测属于的类别:

(9)

2.3 LDCNN参数优化

经典CNN分类模型当中,全连接层和卷积层利用互熵目标函数进行参数优化,学习底层的特征表述,优化过程中出现梯度弥散,低层次特征不充分的现象。L2-SVM和互熵目标函数的不同在于权重向量的优化过程。互熵函数通过极大似然估计或者最小化交叉熵,而L2-SVM挖掘不同类别数据点的最大边缘,具有较好的可微可导性,正则化项对错分数据惩罚力度更大。参数优化如下:

目标函数用J(w)表示。微分公式如下:

(10)

式中:I(·)为指示函数。对于全连接层中L2-SVM可以得:

(11)

局部连接权重和偏执向量的梯度向量为:

(12)

(13)

假设当前层为l,下一层为l+1,上一层为l-1,从l-1层到l层有:

(14)

卷积层l的各个神经元的δ只和l+1层的神经元有关,卷积层l到池化层l+1做了下采样的运算,使得矩阵维度减小,因此,δl+1需要上采样up还原卷积层维数,定义up运算为(2×2)为例:

(15)

因此,有:

(16)

(17)

(18)

公式符号见表1。

表1 公式符号

3 实验参数

3.1 数据集

本文使用携程网关于酒店评论情感数据集评估LDCNN模型。对语料进行预处理,包括中文分词、移除标点和停用词。处理完成的语料统计信息见表2。在LDCNN训练过程中,随机选取80%作为训练集调试参数,20%作为测试集。

表2 训练样本

3.2 词向量参数

为解决短文本中文本稀疏问题,针对传统Bow模型表示短文本特征纬度高、特征稀疏程度大的问题。LDCNN模型采用word2vec[14]词向量表述,word2vec超参数统计如表3所示。

表3 词向量参数

3.3 LDCNN参数

为了充分提取短文本情感特征,文中关于卷积核尺寸设定考虑到中文短文本语义特性,采用LDCNN模型,其模型的超参数见表4。

表4 LDCNN模型参数

4 数值实验

为了衡量LDCNN情感分类性能,采用准确率、错误率两个指标进行定量分析。实验方案[15-18]见表5。

表5 实验方案

SVM(Uni)和SVM(Bi)方案采用人工提取(一元、二元)词情感特征相对于LDCNN、LSCNN、SoftmaxCNN方案在准确性上不足;SoftmaxCNN方案采用互熵损失函数无法解决参数优化过程中梯度弥散问题;而LSCNN方案采用静态池化不能充分依据实际情况提取情感特征;最后SSTM方案过分依赖情感词典提取情感特征,过于局限;故通过上述分析比较可知LDCNN模型在短文本情感特征提取方面都优于上述方案。

4.1 情感分类结果分析

情感分类准确率结果见图3。

图3 情感分类准确率结果

LDCNN模型在epochs<5时保持增长的趋势,在epochs=5时,保持稳定,SoftmaxCNN模型随着迭代次数变化上下波动,稳定性差。验证L2-SVM目标函数有效性。LDCNN模型平均准确率高于LSCNN,验证动态K-Max池化操作的有效性。

为进一步验证LDCNN分类性能,从召回率评价角度对模型进行评估。情感分类召回率结果见图4。

图4 情感分类召回率结果

随着epochs增加,LDCNN和LSCNN对SoftmaxCNN召回率结果趋于稳定,说明L2-SVM损失函数相对于互熵损失函数能够改善参数更新过程梯度弥散现象。而LDCNN模型召回率结果明显高于LSCNN和SoftmaxCNN模型,说明LDCNN情感分类的有效性。

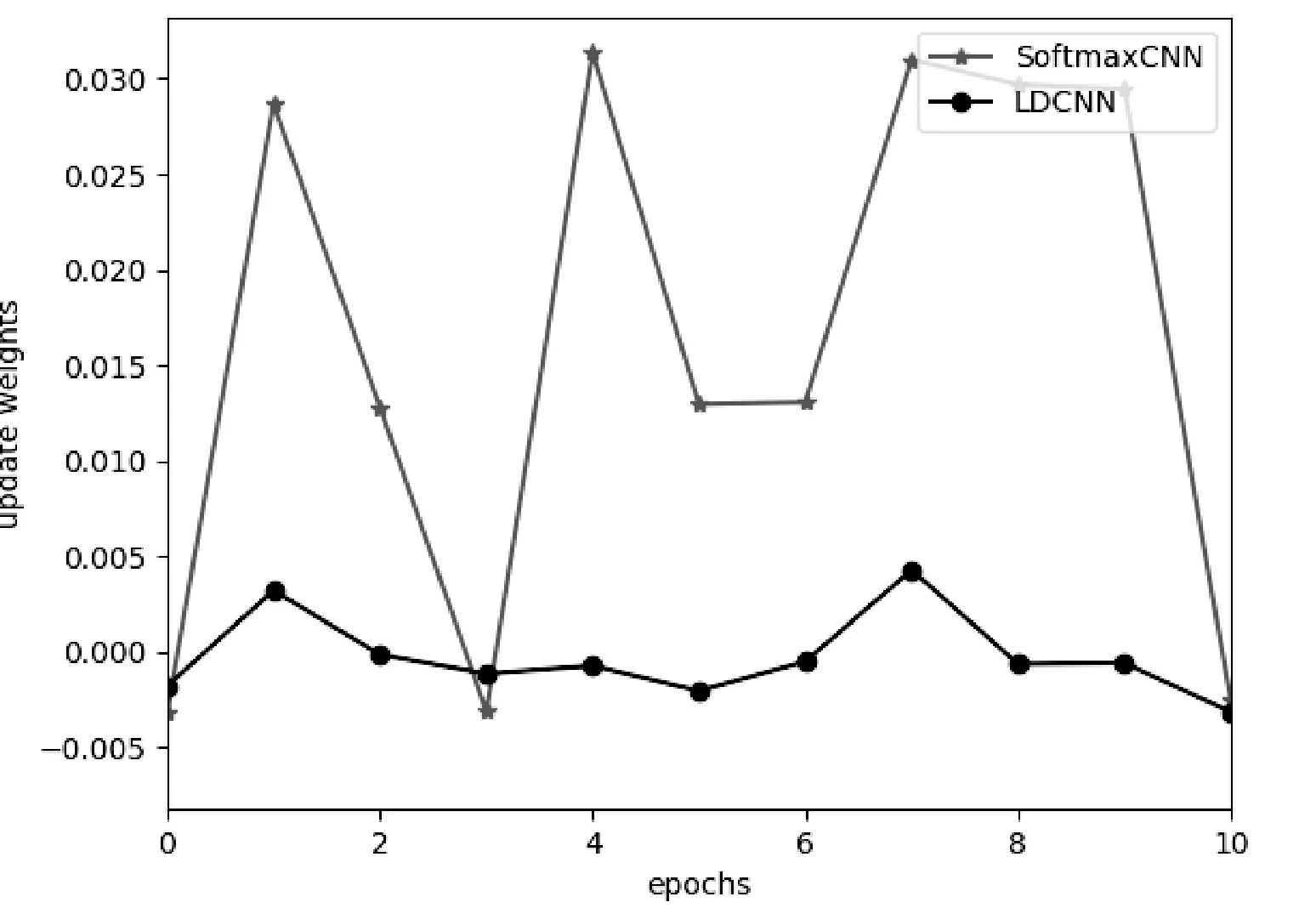

为了进一步说明L2-SVM目标函数(见2.3节)改善参数优化过程梯度弥散现象,图5列出SoftmaxCNN和LDCNN权重的更新对比。

图5 softmax和L2-SVM权重更新对比

参数更新开始时刻二者趋势相当,上下波动,二者在权重更新时有交叉的部分。当epochs=5,LDCNN模型权重趋于稳定,不再变化,反观SoftmaxCNN模型不停波动。说明L2-SVM能够改善CNN参数优化过程中梯度弥散问题,提高模型泛化能力。

为了得到情感分类的最佳表现能力,验证正则化参数对实验结果的影响。通过调整L2-SVM的惩罚系数C改善实验性能。设置不同参数C的实验结果见图6。

图6 不同惩罚系数C下实验性能

不同惩罚系数C>55对实验性能有很大影响。当C=55,得到最高准确性,当C>55时,惩罚参数对错分类别惩罚过大,造成正则化损失与数据损失失去平衡,模型性能下降。

4.2 文本稀疏性结果分析

为验证LDCNN模型够解决短文本中的稀疏性问题,各种经典方法识别情感极性错误率见图7。

图7 文本稀疏性结果

LDCNN随着样本数量的增多错误率明显下降,体现LDCNN处理大规模样本优越性。SVM模型在文本数据规模小的情况下,模型性能逼近LDCNN模型,但随着样本数据增多,SVM模型受限于时间和空间复杂度,线性不可分现象严重错误率显著增高,说明SVM在处理大样本数据具有一定局限性。

5 结 语

本文提出了一种面向中文短文本情感分析模型LDCNN。利用L2-SVM方法对LDCNN模型进行优化,解决了参数优化的问题。采用动态池化函数不仅对输入样本实际情况动态压缩文本特征,而且还保存了文本位置特征信息。在两个真实评论数据集上的实验结果说明了该模型有效性,LDCNN模型具有深度学习优越特征,随着样本数据的增多,模型性能更加稳定。LDCNN模型不同于传统的统计模型或者基于规则的模型需要大量的数据样本,将本模型应用到更多更大的文本数据集,分布式LDCNN模型是今后的研究方向。

[1] Santos C N D,Gattit M.Deep Convolutional Neural Networks for Sentiment Analysis of Short Texts[C]//International Conference on Computational Linguistics.2014:69-78.

[2] Wang P,Xu J,Xu B,et al.Semantic Clustering and Convolutional Neural Network for Short Text Categorization[C]//Proceedings of the 53rd Annual Meeting of the Association for Computational Linguistics and the 7th International Joint Conference on Natural Language Processing,2015:352-357.

[3] Jebaseeli A N,Kirubakaran E.A Survey on Sentiment Analysis of (Product) Reviews[J].International Journal of Computer Applications,2012,47(11):36-39.

[4] Dauphin Y N,Fan A,Auli M,et al.Language Modeling with Gated Convolutional Networks[DB].arXiv:1612.08083,2016.

[5] Kim Y.Convolutional Neural Networks for Sentence Classification[C]//Empirical methods in natural language processing,2014:1746-1751.

[6] Kalchbrenner N,Grefenstette E,Blunsom P,et al.A Convolutional Neural Network for Modelling Sentences[C]//Meeting of the association for computational linguistics,2014:655-665.

[7] 陈钊,需瑞峰,桂林.结合卷积神经网络和词语情感序列化的中文情感分析[J].中文信息学报,2015,30(1):71-89.

[8] 李培,何中市,黄永文.基于依存关系分析的网络评论极性分类研究[J].计算机工程与应用,2010,46(1):138-144.

[9] 黄志勇.基于SVM和深度学习的情感分类算法研究[D].重庆:重庆邮电大学,2016:20-25.

[10] Zhang Y,Ji D H,Su Y,et al.Joint Naive Bayes and LDA for Unsupervised Sentiment Analysis[M]//Advances in Knowledge Discovery and Data Mining.Springer Berlin Heidelberg,2013:402-413.

[11] Pang B,Lee L,Vaithyanathan S.Thumbs up:sentiment classification using machine learning techniques[C]//Proceedings of ACL 2002:79-86.

[12] Kharde V A,Sonawane S.Sentiment Analysis of Twitter Data:A Survey of Techniques[J].International Journal of Computer Applications,2016,139(11):5-15.

[13] Jo Johnson R,Zhang T.Effective Use of Word Order for Text Categorization with Convolutional Neural Networks[C]//North a merican chapter of the association for computational linguistics,2014:103-112.

[14] Mikolov T,Sutskever I,Chen K,et al.Distributed Representations of Words and Phrases and their Compositionality[C]//Neural information processing systems,2013:3111-3119.

[15] Zhang Y,Wallace B.A sensitivity analysis of (and practitioners’ guide to) convolutional neural networks for sentence classification[J].CoRR,2015,16(1):105-119.

[16] Tang Y.Deep learning using linear support vector machines[DB].arXiv preprint arXiv:1306.0239,2013.

[17] 张紫琼,叶强,李一军.互联网商品评论情感分析研究综述[J].管理科学学报,2010(6):84-96.

[18] 熊蜀峰,姬东鸿.面向产品评论分析的短文本情感主题模型[J].自动化学报,2016,42(8):1227-1237.