基于重大活动突发事件的预警与推演技术

2018-02-08王晓泓

王晓泓

(上海市警卫局,上海 200030)

一、引言

随着我国国际地位的不断提升,各类重大活动、重要会议频繁举办。与此同时,国际恐怖活动猖獗,国内社会矛盾凸显,突发事件频发,警卫安保任务面临严峻考验。利用前沿科技,对突发事件处置工作的指挥体系、流程、方法和效果进行科学推演,进而高效处置,确保重大活动顺利安全举办,既是构建和谐社会的需要,也是警卫安保部门亟须解决的重大课题和国际社会长期关注的焦点问题。

本文遵循重大活动“全方位、大数据、高时效、高可靠”的安全保卫工作总则,针对国内外警卫安保领域所面临的“立体、动态、智能”预警推演重大技术挑战,运用物联网、人工智能、复杂系统仿真及大数据处理等技术,克服在大范围、复杂时空环境中,对各种警卫安全工作所涉信息全方位动态采集、主动预警和高效处置所面临的特殊困难,展开“人群—事件—场景—推演”的智能化综合分析技术攻关,形成自主的技术体系和成套设备,实现重大活动安全保卫工作从“平面、静态”到“立体、动态”的跃升,为各类重大活动中突发事件的快速反应、科学决策、正确指挥、高效处置提供强有力的技术保障,确保国家安全、社会稳定和经济发展[1]。

二、面临的主要技术难题

近年来,我国成功举办的2008年北京奥运会、2010年上海世博会、2014年北京APEC峰会、2015年“9·3”抗战胜利纪念日阅兵等一系列重大活动,具有规格高、规模大、人群多、地域广、时间长、警卫对象高度集中等特点[2],对其中可能发生的突发事件预警、推演、处置,面临如下技术难题。

(一)异常目标感知分析

大范围密集人群场景下,严重遮挡和透射畸变严重影响目标群的精确提取。同时,原有的目标人群检测模型只能定位目标群,无法对异常目标人群数目、密集度、集群性、凝聚力等态势给出有效分析,致使对重大活动与警卫对象的危险评估精准度不高。亟须设计通用性强、高精准的目标人群理解算法框架,显著提升智能监测系统对特定目标群的态势感知能力,为异常、可疑、特定目标准确分析判断提供基础。

(二)高时效事件预警

重大活动现场覆盖区域广阔,警卫目标数量多,相关安保布勤工作时间和空间跨度大。例如,上海世博中心占地面积为6.654公顷,总建筑面积约14万平方米,仅世博中心建筑体内外就安装了约800路摄像头,24小时无间断工作产生海量视频数据。重大活动时将会对世博中心周边几公里的区域进行布控,则视频数据量会更大。传统的视频智能分析技术缺乏有效手段识别包含多个特定目标的、跨相机的群体协同行为,缺乏表征群体协同行为中事件序列之间相关性的聚类模型,以及事件序列中基元事件之间顺序关系和因果关系的激励模型。亟须研制基于点过程因果推断的突发事件预测模型,突破大范围跨域复杂情形下突发事件的提前预警问题。

(三)全信息融合显示

源自于多路实时视频的海量图像信息,以及手机、RFID、GPS、北斗、传感器、警务通等获得的大量零散数据,给警卫安保重点区域全场景的整体关联、综合调度和全程调度指挥带来了巨大挑战。亟须设计以警卫对象、警卫目标和突发事件为寻踪中心的多维度线索全信息融合显示平台,突破分布式监控视频中目标人群动态信息和孤立动态场景图像序列在三维图形场景中的无缝融合,解决警卫安保力量部署全信息直观展示和事件多粒度观察的问题,从过去的看得见,到现在的看得懂、将来的看得透[3]。

(四)科学高效动态处置

由于警卫重大活动处突实战演练组织难度高、经费需求多、社会影响大,尤其是众多警卫安保目标地处市中心、闹市区,周边情况复杂、敏感性高、易扰民,演练不可能成为常态。同时,面向全面实战模拟的数字推演技术面临时间瓶颈问题。亟须研究实时环境驱动的动态推演技术,通过设计元胞自动机的驱动源以及计算资源调度智能优化策略,解决警卫重大活动处突工作的最大难点——动态地为突发事件提供科学的、及时的应急预案处置。

三、主要技术体系

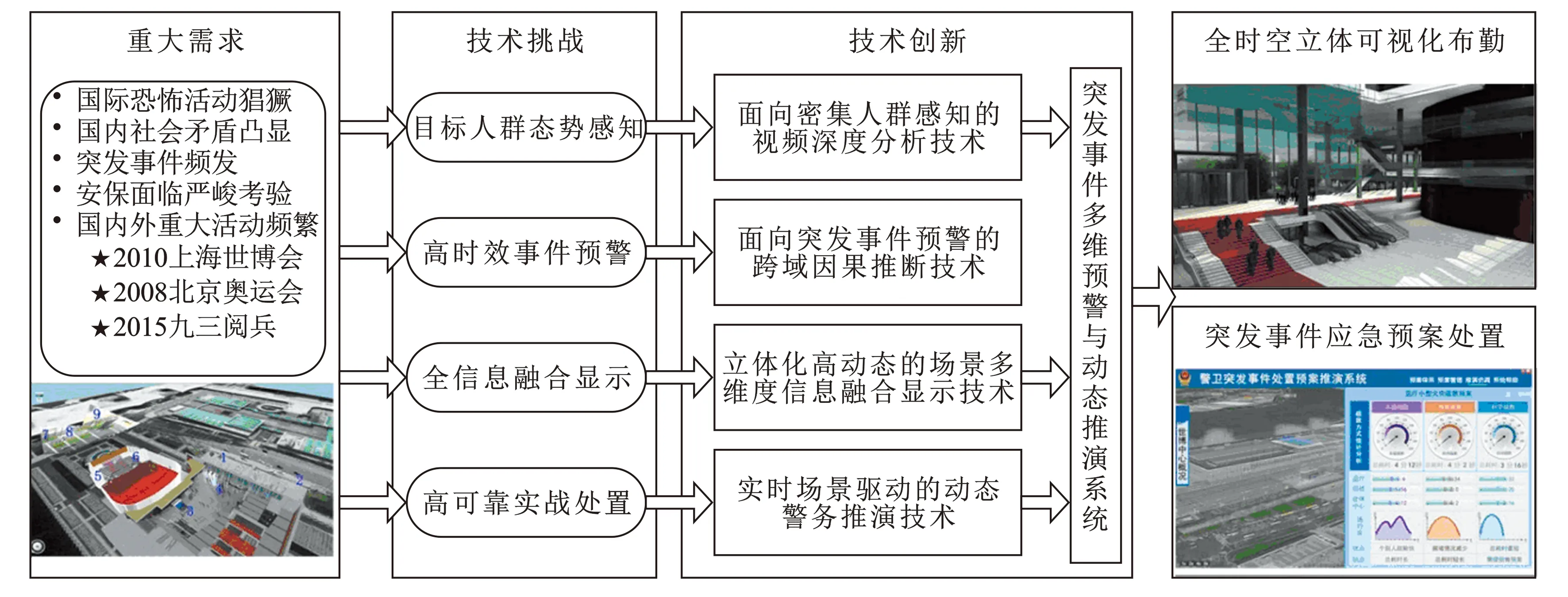

针对上述技术难题,重大活动突发事件多维预警与动态推演技术体系设计如图1所示:

图1 突发事件多维预警与动态推演技术体系

1.提出面向密集人群感知的视频深度分析技术,解决复杂、动态场景下对样本稀疏的特定目标人群自动进行高精准定位以及态势预测的难题[4]。2.提出面向突发事件检测的跨域因果推断技术,保障大范围、跨域复杂情形下突发事件的提前预警[5]。3.提出立体化高动态的场景多维度信息融合技术,解决警卫安保工作勤务部署全局直观展示和事件多粒度观察的问题。4.提出实时场景驱动的动态勤务推演技术,解决重大活动警卫安保工作的最大难点——动态地为突发事件提供科学的、及时的应急预案处置。

四、主要技术创新点

(一)面向密集人群感知的视频深度分析技术

当应用环境发生变化时,原有的计算机视觉和机器学习方法通常因样本稀少,导致对目标特征的描述能力不稳定,存在着目标检测模型对动态场景适应性差的问题。本创新点提出目标视频样本多样性增强方法和具有多层异构神经元结构的大规模视频深度分析模型,利用目标视频样本多样性增强方法和具有多层异构神经元结构的大规模视频深度分析模型,解决复杂、动态场景下对样本稀疏的特定目标群自动进行高精准定位以及态势预测的难题[6],分述如下:

1.目标视频样本多样性增强方法:对目标图像关键点进行对齐并对关键点位置进行扰动,通过采用线性变换、仿射变换、分块仿射变换等生成新的目标样本。通过增加样本的多样性和训练量,解决因样本稀疏导致的目标检测模型通用性差的问题。

2.多层异构神经元结构的视频图像分类模型:采用无监督学习的方式提取包含类间区分性和空间区域性的图像特征,具备表达图像和视频中复杂语义模式的能力,能够实现对场景类别、目标类别、目标关键部位类别的实时同步分析。

3.大范围目标人群的态势感知模型:针对特定的目标群体,采用基于大规模密集场景数据驱动的深度学习模型,自动提取对动态变化场景具有普适性的目标群体特征;在该特征空间中,基于特征匹配获得训练数据集中相似目标群体的态势数据,并通过无监督聚类方法获得目标群体的精确分割,从而实现对当前目标群体的精确定位与态势预测[7]。

(二)面向突发事件预警的跨域因果推断技术

重大活动及突发事件的现场覆盖区域广阔,涉及的特定目标人群以及协同行为时间空间跨度大,这对目标的检测、跟踪和行为识别带来了极大挑战。同时,传统的视频智能分析技术缺失有效手段实现对异常事件的预测,导致突发事件预警时效性受到极大局限。

通过设计目标的长期跟踪机制与跨相机的目标重识别机制,提取目标群体协同行为的时空轨迹;在时空轨迹约束下,基于点过程建立表征协同行为中事件序列之间相关性的聚类模型,以及表征事件序列中基元事件之间顺序关系和因果关系的激励模型;基于重大活动安保案例事件库实现突发事件的聚类分析和激励模式匹配,解决大范围跨域复杂情形下突发事件的提前预警问题。

图2为本创新点提出的面向突发事件预警的跨域因果推断技术框架,该框架包括基于四元光流和分层卷积特征相关匹配的长期目标跟踪技术、跨摄像机的重识别技术和基于点过程因果推断的事件预测等三项创新关键技术,分述如下:

1.特定目标的长期稳定跟踪技术:提取四元数颜色角点,与灰度角点共同构成良好的目标特征点集,采用四元数光流估计算法在目标特征点位置获得更准确的短期跟踪结果[8]。同时,提出基于分层卷积特征相关匹配的目标检测技术,通过跟踪—学习—检测的算法框架,解决复杂背景下目标长期跟踪任务中“跟得上、跟得准”的难题[9]。

2.跨相机的目标重识别技术:针对跨域联网监控视频中运动目标的姿态变化、远近景之间目标尺度的变化,视野盲区和遮挡情形下目标的重新捕获,采用基于加权陆地距离与步态特征的目标重识别技术,突破了特定目标的跨相机重识别难题[10]。

3.基于因果推断的事件预测技术:基于点过程建立表征协同行为中事件序列之间相关性的聚类模型,以及表征事件序列中基元事件之间顺序关系和因果关系的激励模型;基于警卫重大活动安保案例事件库对突发事件进行聚类分析和激励模式匹配,解决大范围跨域复杂情形下突发事件的提前预警问题。

(三)立体化高动态的场景融合技术

警卫重大活动安保工作面临着大量孤立的视频源时空不连续,无法展现整体场景的问题。同时,缺乏有效手段直观展示安保力量部署的全部线索信息,难以针对警卫对象、警卫目标和突发事件进行预演分析,实现指挥防控体系的高效运作。亟须突破以警卫对象和警卫目标为中心的多维度线索融合技术。

通过将分布式监控视频中目标人群的动态信息和孤立动态场景图像序列与三维图形场景进行无缝融合,实现了从孤立的分镜头画面到以警卫对象、警卫目标和突发事件为寻踪中心的全景全信息融合显示的飞跃,解决了警卫安保力量部署全信息直观展示和事件多粒度观察的问题[11]。

图3为利用本创新点实现的全时空多维线索可视化展示平台,该平台需要两个关键技术的支撑,分述如下:

1.稳健的全景图像拼接技术:全景视频图像拼接融合到三维虚拟场景数据中,即可实现全时空高动态场景展示。多个监控相机捕捉到的多视点视频图像,通常存在重叠区域小、特征点稀疏、杂乱背景干扰等现象,采用全局外观一致性约束优化局部特征点匹配结果,攻克了关键点特征匮乏以及局外点干扰显著情形下的图像匹配难题,显著提高了全景图像拼接的精确度[12]。

图2 面向突发事件预警的跨域因果推断技术框架

图3 全时空多维线索可视化展示平台

2.多维信息融合显示技术:基于相机标定技术,建立视频图像数据和三维场景空间的坐标变换关系,将实时采集的动态视频数据拼接融合到三维场景的空间数据中,实现全景立体视频显示,并将多种传感器信息、目标人群动态信息、事件预警信息等整合到全景立体视频中,以实现全方位的多维信息融合展示。

(四)实时场景驱动的动态勤务推演技术

重大活动安保工作的难点之一在于对全局资源的合理调派,以及全面的实战模拟可行性低。亟须开发实时场景驱动的动态推演软件系统,实现对突发事件的快速决策、高效组织和科学处置。

根据突发事件实际特性及周边环境设计元胞自动机的前端输入和驱动源[13],并采用资源调度智能优化策略对动态目标人群以及重点安保目标快速建立高分辨率的、精准的仿真推演模型,突破了全面实战模拟的时间瓶颈,解决了重大活动警卫安保工作的最大难点——动态地为突发事件提供科学的、及时的应急处置预案。

图4为利用本创新点实现的实时环境驱动的动态推演系统,该系统包括大规模三维场景的高效渲染技术、疏散自动模型技术和多源异构数据交互技术等三项创新关键技术,分述如下:

1.大规模三维场景的高效渲染技术:通过将三维模型无缝集成到矢量地形场景中,以及对地形分层分块集合的效率优化绘制,实现对大规模三维场景的高效渲染,获得最佳的虚拟实现效果。

2.多源异构数据交互技术:通过空间因子耦合建立起各模型参数在各空间观测尺度间的映射关系及时间因子耦合的重采样或插值实现各模型之间不同时间分辨率下数据的转换,来突破异构环境下多源实体数据的同步交融问题,确保各实时环境变化量的相互通信和协作,作为动态推演的前端驱动。

图4 实时环境驱动的动态推演系统

3.疏散自动模型技术:利用自主核心的疏散模型,结合三维场景,在微观和中观层面研究不同对象在各种复杂环境下的人群群体性运动规律。所有微观个体根据局部环境自行决策如何运动,但受中观人群数学模型的控制,并通过适时调节微观及中观建模占比,来达到实效性计算的平衡[14]。在此结果基础上,结合三维场景建立各类模拟疏散、排兵布阵推演模型。

五、结束语

基于上述技术和设备,成功研制“突发事件预警系统”“全时空立体可视化布勤系统”“警卫重大活动突发事件处置预案推演系统”三个应用系统,应用范围涵盖公共安全管理、国内反恐工作、突发事件应急指挥、重大活动警卫安保勤务部署等多个领域,研发成果被上海市政府授予科技进步二等奖。今后重点研究方向是:如何拓展监控视频深度分析技术,能够实现密集人群的意向性可能状态属性的预测,在应用领域更具挑战性的大群体、弱环境情况下进行动态推演。大群体将使计算量突变,需要从宏观层面适配大群体演化算法,再调整中观和微观的算法占比,使模拟和推演的时效性更高。

[1] 国务院.国家突发公共事件总体应急预案[Z].2006-01-08.

[2] 王晓泓.上海世博会警卫勤务信息系统建设与应用[J].武警学院学报,2012,28(7):15-17.

[3] YAN Qing, XU Yi, YANG Xiaokang.Separation of weak reflection from a single superimposed image[J]. IEEE Signal Processing Letters,2014,21(10):1173-1176.

[4] ZHANG Cong, KANG Kai, LI Hongsheng, et al. Data-driven crowd understanding: a baseline for a large scale crowd dataset[J]. IEEE Trans on Multimedia,2016:1-15.

[5] ZHU Jun, WANG Baoyuan, YANG Xiaokang, et al. Action recognition with actions[C]. Proc of IEEE International Conference on Computer Vision.2013:3559-3566.

[6] MA Lianyang, YANG Xiaokang, XU Yi, et al. Generalized EMD with body prior for pedestrian identification[J]. Journal of Visual Communication and Image Representation,2013,24(6):708-716.

[7] CHEN Erkang, XU Yi, YANG Xiaokang, et al. Robust event detection scheme for complex scenes in video surveillance[J]. Optical Engineering,2011,50(7):1-9.

[8] CHEN Erkang, XU Yi, YANG Xiaokang, et al. Quaternion based optical flow estimation for robust object tracking[J]. Digital Image Processing,2013,23(1):118-125.

[9] MA Chao, YANG Xiaokang, ZHANG Chongyang, et al. Long-term correlation tracking [C]. IEEE Conference on Computer Vision and Pattern Recognition.2015:5388-5396.

[10] ZHANG C, WANG X G, YANG X K. Cross-scene crowd counting via deep convolutional neural networks[C]. IEEE Conf on Computer Vision and Pattern Recognition.2015:833-841.

[11] ZHU Jun, WU Tianfu, ZHU S C, et al. A reconfigurable tangram model for scene representation and categorization[J]. IEEE Transactions on Image Processing, 2015,25(1):150-166.

[12] XU Yi, YU Licheng, XU Hongteng, et al. Vector sparse representation of color image using quaternion matrix analysis[J]. IEEE Trans on Image Processing,2015,24(4):1315-1329.

[13] 郭玉荣,郭磊,肖岩.基于元胞自动机理论的紧急人员疏散模拟[J].湖南大学学报(自然科学版),2011,38(11):25-29.

[14] ZHAO J, XU Y, YANG X, et al. Crowd instability analysis using velocity-field based social force model[C]. Visual Communications and Image Processing(VCIP).2011:1-4.