基于多模板的鲁棒运动目标跟踪方法*

2018-01-27陆惟见尚振宏李润鑫

陆惟见,尚振宏,刘 辉,李润鑫,钱 谦

(昆明理工大学 信息工程与自动化学院,云南 昆明 650500)

0 引 言

由于光照变化、遮挡、目标形变、摄像机抖动等诸多因素的影响,实现鲁棒的视觉跟踪[1]仍然是一件非常困难的事情。基于目标特征跟踪是视觉跟踪中最为重要的一类方法,研究发现,诸如深度去噪自编码器和卷积神经网络等深度学习[2,3]方法挖掘出的数据多层表征更能够反映数据更深层的本质,文献[4]使用了多层PCA卷积提取目标分层次特征。文献[5]使用了自编码机挖掘数据的多层表征。这些方法均通过卷积神经网络或神经网络来提取目标的特征表达,但由于过多的池化层,使目标特征丢失了其局部结构信息,在发生遮挡或目标形变时容易丢失。文献[6]提出的基于卷积网络的跟踪器(convolutional network-based tracker,CNT)算法简化了卷积网络的结构,剔除了池化层,使用由第一帧目标获得的一组滤波器与后续帧卷积,提取包含目标局部结构和内部几何布局信息的特征描述。上述算法和一些经典算法[7~9]使用的滑动平均模型更新方法过于依赖于上一帧或最近帧定位到的目标信息,跟踪的历史信息未充分利用。这种滑动平均的目标模型更新方法在跟踪精度较高的情况下,对目标外表变化较为鲁棒。但如果跟踪精度不高,错误信息的累积会导致目标发生漂移甚至丢失现象。

目标模型更新的难点在于稳定性和可塑性之间的平衡,目前主要的模型更新算法可分为滑动平均更新法[10,11]和选择特征更新法[12,13]。两种方法仅依赖于上一帧或最近帧定位到的目标信息,已经跟踪到的目标对后续跟踪没有发挥作用,跟踪的历史信息未充分利用。在跟踪过程中,若目标与初始目标模型差异较大时,较难准确跟踪。

拥有复杂记忆系统的人类可以适应各种情况下的跟踪任务[14],受此启发,并针对上述问题,本文使用历史跟踪结果构建目标特征模板库并结合CNT算法的卷积网络特征提取,提出了一种基于多模板及卷积网络的鲁棒跟踪方法。在CNT算法的基础上,通过构建并更新多样性模板库,不仅依赖上一帧,而是利用跟踪结果的历史信息为运动目标跟踪提供更完整的候选匹配信息,提高了算法的准确性和稳定性。

1 CNT目标跟踪算法

CNT算法提出了一种简化的卷积网络,使用由第一帧目标获得的一组滤波器与后续帧作卷积,提取包含目标局部结构和内部几何布局信息的特征描述。为保证论文的完整性,将CNT算法简述如下,算法的详细论述见文献[6]。

1.1 目标描述

首先,将输入图像转换为n像素×n像素的灰度图像I,对I按w×w大小进行密集采样获得一组重叠的局部图像块,图像Ii的采样样本集Υi为

Υi=Patch(Ii)={Y1,…,Yl}

(1)

式中l=(n-w+1)×(n-w+1),为减少光照变化影响,每个图像块Yi均进行均值相减和L2归一化操作。

(2)

将d个使用同一组滤波器的特征S叠加得到三维特征张量C∈R(n-w+1)×(n-w+1)×d,为使特征C对目标形变鲁棒,用稀疏向量c近似vec(C)∈R(n-w+1)2d,其可通过最小化式(3)求得

(3)

1.2 模型更新

稀疏描述子c在式(3)中作为目标模型,为适应跟踪过程中目标外观的变化,须对式(3)所表示的目标模型进行更新,CNT使用滑动平均的方法更新模型

(4)

1.3 跟踪算法

CNT的跟踪算法建立在粒子滤波框架下,其核心思想是根据t时刻系统状态的一个观测结果Ot={o1,…,ot},利用概率理论迭代估计系统t时刻的状态st,即找到后验概率分布P(st│Ot)

(5)

(6)

根据粒子滤波原理,最优的目标状态估计可以通过最大化粒子集的后验估计来实现,即

(7)

2 多模板目标跟踪算法

CNT算法基于单一模板,通过迭代更新这一模板特征进行运动目标跟踪。由于复杂背景和目标形变的影响,迭代更新过程中错误信息的累积会导致目标发生漂移甚至丢失的现象。

本文提出了改进算法通过模拟人类的记忆系统,将跟踪过程中得到的目标信息进行储存,用于构建多样性模板库,利用跟踪结果的历史信息为运动目标跟踪提供更完整的候选匹配信息。在跟踪过程中,对CNT算法得到的跟踪结果进行遮挡判定,选取合适的跟踪结果用于构建模板库,在更新过程中需剔除模板库内的冗余模板,保持模板库的多样性。经上述步骤,多样性模板库在CNT算法的目标匹配阶段为其提供了更完整的候选匹配信息。

2.1 遮挡判定

视觉跟踪任务可以看作一种时域运动估计问题。在连续视频序列中,相邻帧目标不会发生较大变化。跟踪开始时,在第一帧人为标定目标,以此目标作为目标模型对下一帧目标进行定位。随着跟踪进行,经过筛选的模板不断进入,模板库将逐渐被建立起来。

跟踪过程中,需在模板库内选择合适的模板作为目标模型进行匹配,为避免部分遮挡的目标成为模板进入模板库, 设计了一种通过比较目标和背景相似度的遮挡判定方法:对第t-1帧跟踪结果xt-1周围进行高斯采样得n个与xt-1重叠率为γ背景采样,记为Bt-1={b1,…,bn} 。在CNT算法的粒子滤波框架下,通过计算xt和Bt-1={b1,…,bn}的最大后验估计判断当前帧跟踪结果的遮挡情况

(8)

(9)

当ρo小于预设的阈值δ时,认为目标模型未被遮挡。

2.2 模板库建立

为了防止在跟踪过程中模板库的无限扩充,设模板库最多可容纳N个模板,Nt,Nt≤N为第t帧时模板库内模板的个数。则模板库可定义为

(10)

设阈值T作为衡量跟踪结果与目标的相似性度量,模板库建立的算法流程如下:

1)以第一帧选定的目标为模板库内初始模板,设置模板计数器i←1。

4)当ρs>εT,ε为用于保证入库模板质量的系数,取值范围(1,2],选择ρs所对应的xi为当前帧的跟踪结果,其中,xi∈Xt。由目标xi系统状态和式(9)可计算出ρo。

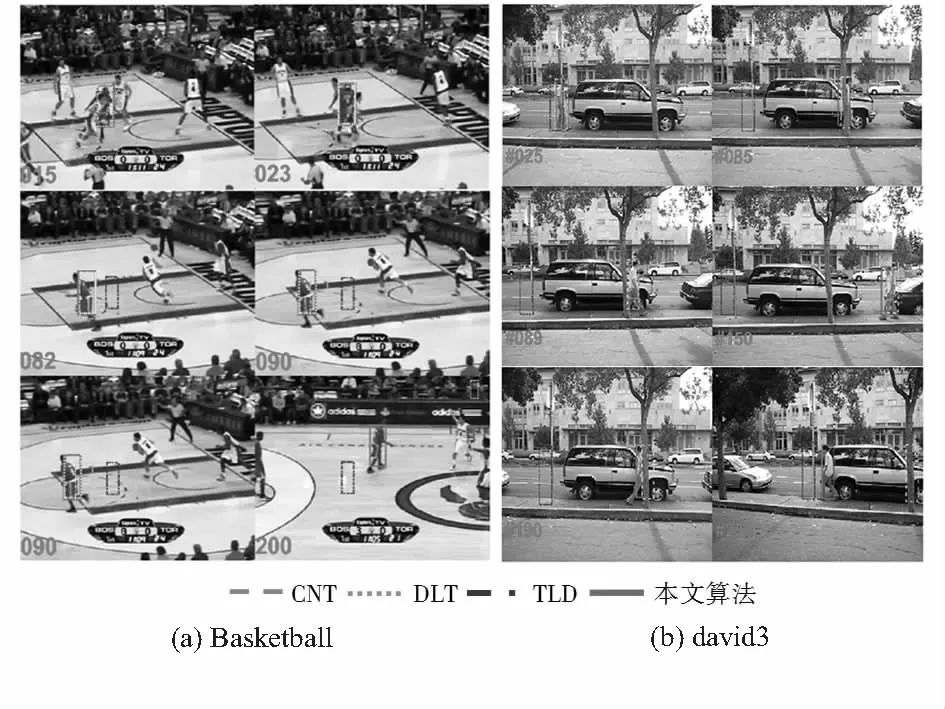

6)若ρs 阈值的确定易受目标和背景纹理结构以及跟踪窗口大小等的影响。调节阈值T可以调节模板库内模板之间的差异以及模板入库的频率。 (11) 为了验证本文算法的有效性和正确性,使用MATLAB进行编程,对国际公共测试视频VOT2015[15]中的trellis_c,Basketball和david3视频序列进行跟踪实验。实验结果按性质分成定性分析和定量分析两类,定性分析给出图像结果,定量分析给出统计结果。在定量分析中,将本文算法与近年热点算法跟踪—学习—检测[16](tracking-learning-detection,TLD)算法以及基于深度特征学习的跟踪[5](deep learning-tracking,DLT)算法在覆盖率和中心位置误差方面进行比较。 图1为基于trellis_c视频序列进行的,将本文算法和原始CNT算法进行对比实验,测试目标在发生光照变化或复杂背景纹理情况下算法的鲁棒性。 如图1所示,在130帧左右目标的形变不明显,背景和前景(目标)对比明显,背景的纹理变化相较于前景较为复杂。在跟踪过程中,原始CNT算法由于模型更新过程引入过多的背景信息其跟踪结果已经开始发生漂移,而本文算法仍旧可以对目标继续跟踪。原始CNT算法仅依赖上一帧得到的目标信息进行迭代更新,信息具有局限性和单一性,当发生形变和复杂背景时,错误信息的累积往往导致错误跟踪。本文算法维持着模板库的多样性,随着跟踪进行,模板库不断的丰富,当出现复杂背景的情况,能够从模板库找到相应的模板对目标进行较准确的定位跟踪。 图1 trellis_c场景2种算法跟踪结果 图2测试算法的抗遮挡和抗形变性能,在视频序列Basketball和david3上进行,本文算法与原始CNT算法、TLD算法和DLT算法对比实验。对于Basketball视频序列,在第18帧左右当目标发生严重遮挡时,TLD算法已经不能对目标进行跟踪,DLT算法、CNT算法和本文算法仍能够对目标进行跟踪,但在第80帧后目标形态发生较大变化,CNT算法和DLT算法出现了跟踪漂移的情况,而本文算法仍然能够继续跟踪。对于david3视频序列,在第23帧目标第一次被遮挡时,TLD算法出现跟踪失败,跟踪无法进行的情况。在随后的跟踪过程中,由于目标的形变,在150帧后DLT算法出现了跟踪框尺度异常和漂移的问题。CNT算法也在190帧左右目标被完全遮挡时跟踪失败,只有本文算法还能继续跟踪。 图2 Basketball和david3视频跟踪结果 对图3的实验结果进行定量分析,本文算法与上述算法在覆盖率[15]和中心位置误差[15]的对比结果如图3所示。由图可知,本文算法的覆盖率一直维持在一定范围内,并且中心位置误差为4种算法中最小。其他3种算法由于跟踪过程中目标的遮挡和形变出现了跟踪失败或跟踪框漂移的情况,所以覆盖率在某一时刻变为0,中心位置误差逐渐增大。其中在david3视频序列中,TLD算法在第25帧跟踪失败,跟踪框停止移动,但在235帧后目标又移动到其跟踪框范围内,所以其覆盖率曲线呈现凹形,中心位置误差曲线呈现凸形。 图3 定量分析对比 通过上述实验结果可以看出,TLD算法在目标发生遮挡时的鲁棒性较低,DLT算法和CNT算法在目标发生前形态变化前跟踪比较稳定,但在目标形态和初始状态有了较大差异或遮挡时,其模型更新方法易受到错误信息的干扰,出现跟踪框尺度变换异常或跟踪漂移的状况。CNT算法依赖初始目标特征的迭代更新,当目标的局部结构和内部几何布局发生较大变化时容易导致跟踪错误。而本文算法维持着目标的差异性和多样性模板库,当遮挡和形变后,可以从模板库内找到遮挡之前目标的相似信息,实现目标持续跟踪。 针对滑动平均模型更新法和选择特征模型更新法过于依赖于上一帧或最近帧定位到的目标信息,不能很好地应对复杂背景和目标形态变化的情况,本文使用历史跟踪结果构建目标特征模板库并结合CNT算法的卷积网络特征提取,为运动目标跟踪提供了更完整的候选匹配信息。实验证明:改进算法在保留了原始CNT算法抗遮挡能力的前提下,提升了在复杂背景和目标形变时的鲁棒性和准确性。 [1] 安 宁,闫 斌,熊 杰.基于压缩感知的多尺度绝缘子跟踪算法[J].传感器与微系统,2016,35(3):140-143. [2] Clement F,Camille C,Laurent N,et al.Learning hierarchical featues for scene labeling[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2013,35(8):1915-1929. [3] Alex K,Sutskever I,Hinton G E.ImageNet classification with deep convolutional neural networks[C]∥Advances in Neural Information Processing Systems,LakeTahoe,USA:NIPS,2012:748-764. [4] 李寰宇,毕笃彦,杨 源,等.基于深度特征表达与学习的视觉跟踪算法研究[J].电子与信息学报,2015,37(9):2033-2039. [5] Wang N,Yeung D Y.Learning a deep compact image representation for visual tracking[J].Advances in Neural Information Processing Systems,2013,26(1):809-817. [6] Zhang K,Liu Q,Wu Y,et al.Robust visual tracking via convolutional networks[J].IEEE Transactions on Image Processing,2015,25(4):1-18. [7] Zhang K,Zhang L,Yang M H. Real-time compressive tra-cking[C]∥European Conference on Computer Vision,Berlin,Germany:Springer,2012:864-877. [8] Bolme D S,Beveridge J R,Draper B A,et al.Visual object tra-cking using adaptive correlation filters[C]∥Computer Vision and Pattern Recognition,San Francisco,USA:IEEE,2010:2544-2550. [9] Bolme D S,Draper B A,Beveridge J R.Average of synthetic exact filtes[C]∥Computer Vision and Pattern Recognition,Anchorage,USA:IEEE,2009:2105-2112. [10] Collins R T,Liu Y,Leordeanu M.Online selection of discriminative tracking features[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2005,27(10):1631-1643. [11] Grabner H,Leistner C,Bischof H.Semi-supervised on-line boosting for robust tracking[C]∥European Conference on Computer Vision,Berlin,Germany:Springer-Verlag,2008. [12] 沈志熙,杨 欣,黄席樾.均值漂移算法中目标模板更新算法研究[J].自动化学报,2009,35(5):478-483. [13] Hong Zhibin.Multi-store tracker(MUSTer):A cognitive psycho-logy inspired approach to object tracking[C]∥Computer Vision and Pattern Recognition,Boston,USA:IEEE,2015:749-758. [14] Kristan M,Matas J,Leonardis A,et al.The visual object tracking VOT2015 challenge results[C]∥Computer Vision Workshops,Santiago,USA:IEEE,2015:1-23. [16] Kalal Z,Matas J,Mikolajczyk K.PN learning: Bootstrapping binary classifiers by structural constraints[C]∥Computer Vision and Pattern Recognition,San Francisco,USA:IEEE,2010:49-56.2.3 模板库更新

3 实验结果与分析

3.1 定性分析

3.2 定量分析

4 结束语