人工智能时代的责任决策

2018-01-16胡文娟

胡文娟

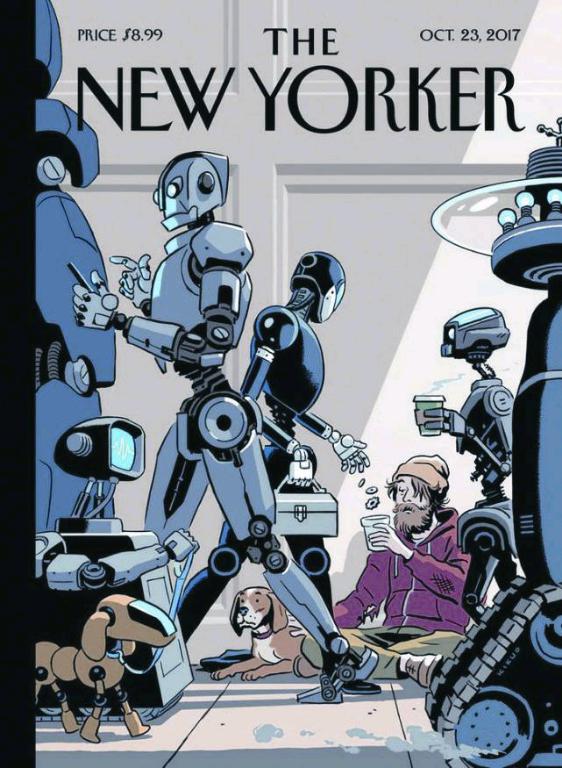

2017年10月,《纽约客》杂志的封面图再次引发对人工智能(AI)的热议。虽然图片描述的情景想象起来有些可怕——人类坐地乞讨,而机器人则扮演了施予者的角色,但不得不承认,和其他任何一种技术革新一样,AI在创造价值的同时也带来了风险。

隨着人工智能决策日益盛行,算法歧视就是常见风险之一。比如,图像识别软件就犯下过种族主义错误。2015年7月,谷歌公司的图片软件曾错将黑人的照片标记为“大猩猩”;2016年3月,微软公司的人工智能聊天机器人Tay上线后被“教”成了一个集反犹太人、性别歧视、种族歧视等于一身的“不良少女”。有些歧视或许还无关紧要,但在涉及信用评估、犯罪风险评估、雇佣评估等重大事项时,人工智能所做出的决策将影响甚至决定贷款额度、刑法选择、雇佣与否,这时歧视就会带来严重影响。

因此,在大量的资金和精力都被投入到研究加速人工智能的发展中时,这也意味着,我们应该且必须花费更多精力思考人工智能的应用给社会、经济和道德带来的影响,并采取行动弥补可能造成的负能量。本文作者DUNSTAN ALLISON-HOPE从商业与人权的角度分享了人工智能应用所带来的人权挑战及应对建议,以此启发投资和应用AI的工商界思索可能的商业风险。

当决定权在机器而不是人类手中时,如何保证人类能够获得并采取补救措施?这是一个很复杂的问题。日前,在联合国商业与人权年度论坛的联席会议上,BSR和国际企业责任圆桌会议(简称ICAR)就讨论了这个问题。

通过极大提高我们的分析能力,人工智能(AI)有可能解决人类面临的一些最紧迫的挑战,如与医疗、教育、交通、反恐和刑事审判等相关的难题。然而,人工智能也带来了前所未有的、不可预见的各种人权风险,如非歧视、隐私、儿童权利、言论自由和获取公共服务等。

例如,在法庭审判中使用了人工智能,或在决定是否提供信贷或识别潜在恐怖分子时使用了人工智能,这都有可能导致做出有歧视性的决定。同时,使用基于人工智能的语音识别设备还可能影响隐私权和儿童权利。一些人甚至明确表示担忧,他们认为让机器判断在社交媒体上发贴是否遵守服务条款,可能会消极影响言论自由。

《联合国商业与人权指导原则》(UNGPs)的第三支柱规定,应为此类侵权行为的受害者提供补救措施。我们的会议讨论了在人工智能的背景下确保获得补救的三项新挑战:

1. 当违权行为是由机器和算法而非人类做决定导致时,保证补救;

2. 当有数以亿计的权利持有人和数以亿计的决策时,提供具有操作性的申诉机制;

3. 当数十家公司而不是单一的企业参与者,通过不同的基于AI的产品和服务相互作用,与侵犯人权的行为联系在一起时,要保证获取补救措施的权利和机会。

虽然这些讨论看上去都是假设,但技术在快速发展,来自各行各业的公司正迅速将人工智能集成到他们的产品、服务和运营中。

微软副总裁兼副总法律顾问Steve Crown提出了一项挑战,即如何知道什么时候伤害开始发生、怎样识别谁犯了错并能够及时确定一种补救措施使受害者回到以前状态。Crown提供了一个年轻女性的例子,零售数据分析显示该女子怀孕了,而她又是定向投放广告的目标,于是,她的父亲从家中直接邮件广告而不是自己女儿口中得知了这个事实。在这种情况下,是否发生了侵犯隐私的行为?如果是的话,有什么恰当的补救措施?公司又该如何阻止此类事件再次发生?

牛津大学的数据伦理学方面的研究员Sandra Wachter和阿兰图灵研究所的一位博士后提出了新的《欧盟通用数据保护条例》(简称GDPR)中关于“解释权”的概念,这个概念会在一些诸如由机器决定信贷额度和雇佣与否的情境中生效。

但Wachter强调,一旦人类参与到这个过程中后,GDPR中规定的这一权利就会消失——即使人类的参与如同橡皮图章(机械地听从命令安排)一样——许多公司也会反对透露他们决策算法的细节,认为那是商业机密。

Sandra提出了一种基于反设事实的,关于“解释权”的替代模型,该模型描述了导致该决策的事实(例如收入或教育成绩),它可能为权利持有人提供有意义的信息,而不需要传达算法的内部逻辑。Sandra还提议成立一个独立的监督机构来审查公司并确保尽责。

谷歌自由表达和人权顾问Alex Walden谈到了机器是如何被部署并协助判断互联网用户上传的有争议的内容如仇恨言论和恐怖主义等。在大量内容被上传的情况下,这些机器会特别有用,但即便机器可以通过筛查大量内容识别这些争议言论,但是只有人类具备理解上下文和语言的必需能力,也只有人类才能做出最终的决定。

总之,贯穿会议始终的一个主题就是人工智能将在我们的生活中扮演越来越重要的角色,它将被许多行业,不仅仅是科技公司使用。总的来说,我对《联合国商业与人权指导原则》在人工智能时代的应用得出了三个结论。

首先,所有经济部门(如零售、金融服务、能源、医疗、交通、基础设施和公共部门)都要理解人工智能应用对人权的影响,这很重要。

其次,我们应该通过权利持有人的镜头考虑获取补救措施的问题。人工智能极其复杂,只有极少数人知道它是如何工作的。如果想要发挥人工智的潜力,同时又减轻其所带来的风险,那么重要的是公民社会、权利持有人和弱势群体要受益,要有渠道让其有意义地参与讨论AI应用以及获取补救措施等话题。

同时,从事人工智能发展的专业团队也将会从对伦理问题和权利持有人观点的深入理解中获益,而这一情况也已经开始在诸如斯坦福的Partnership in AI和美国研究机构AI Now(第一家跨领域的人工智能研究所)中发生。

最后,有必要评估一下在人工智能环境下开发的补救措施是否符合《联合国商业与人权指导原则》中所规定的补救有效性标准,如合法、可获得、可预见、公平、透明、与权利兼容、基于参与和对话。

这些问题的答案只会随着时间的推移而出现,我们需要通过鉴别使用案例来证明如何获得有效的补救措施。期待与各行业的公司展开合作,进一步探讨这些重要话题。endprint