基于多特征-多表示融合的SAR图像目标识别

2017-11-27张新征谭志颖王亦坚

张新征 谭志颖 王亦坚

(重庆大学通信工程学院 重庆 400044)

基于多特征-多表示融合的SAR图像目标识别

张新征*谭志颖 王亦坚

(重庆大学通信工程学院 重庆 400044)

针对合成孔径雷达(Synthetic Aperture Radar, SAR)图像目标识别问题,该文提出了一种基于多特征-多表示学习分类器融合的识别算法。首先,该算法提取了SAR图像3种特征,包括主成分(Principle Component Analysis, PCA)特征,小波变换特征和2维切片Zernike矩(2-Dimension Slice Zernike Moments, 2DSZM)特征。然后,将测试样本的3类特征分别输入稀疏表示分类器和协同表示分类器进行预分类,得到6个预测标签。对6个预测标签进行分类器融合,得到最终的识别决策。实验中研究了3种不同的分类器融合算法,实验结果表明利用贝叶斯决策融合得到了最佳的识别性能。基于多特征-多表示学习分类器融合的方法集成了多特征的鉴别能力,也融合了稀疏和协同表示的分类性能,实现优势互补,有效提高了识别精度。基于Moving and Stationary Target Acquisition and Recognition (MSTAR)公开发布的SAR目标数据库的实验验证了该方法的有效性。

合成孔径雷达;目标识别;稀疏表示;协同表示;决策融合

1 引言

合成孔径雷达(Synthetic Aperture Radar,SAR)是一种高分辨率微波成像雷达,其工作不受光照和气候条件的限制,可实现全天时、全天候持续对地观测,并且具有一定的地表穿透能力。SAR的优良性能使得SAR在民用和军用领域都有广泛的应用。在民用领域,SAR主要应用于地质和矿藏资源勘探、海洋生态环境监测、气候变化研究等方面[1,2];在军用领域,SAR应用包括军事测绘、军事侦察等方面[3,4]。由于SAR成像本质上是电磁散射机理,导致SAR图像不像光学图像那样具有视觉直观性,因此,SAR图像自动目标识别(Automatic Target Recognition, ATR) 作为SAR图像解译中的重要环节,一直是国内外学者的研究重点[5]。

有效的特征提取和良好的分类模型可以很好地降低目标周围环境等对目标图像的影响、目标对方位角敏感度等,提高识别方法的识别能力。SAR图像目标识别包括特征提取和分类识别两个主要内容。科研人员已经研究了众多基于2维SAR图像的目标识别算法。其中,最直接的一种方法就是将SAR图像直接作为特征。另一种特征提取方法是基于小波变换或者多尺度分析。另外,诸如目标区域描述子、阴影等图像特征也用于进行目标识别[6,7]。采用基于物理特征的散射中心模型可以提供一种精细的,物理相关的目标描述,但是其具有特征参数估计困难等缺点[8]。然而,单一的特征只能从单一角度描述图像,并不能包含图像的全部信息;另一方面,异类特征在相同域中具有不同的鉴别能力。联合多个鉴别特征对目标进行识别是一个重要的发展趋势。宦若虹等开展了基于PCA、Independent Component Analysis (ICA)和Gabor小波决策融合的SAR目标识别[9]。彭菲等开展了PCA和Kernel Principle Component Analysis (KPCA)自融合的SAR自动目标识别算法[10]。

SAR目标识别技术包括基于模板的方法、基于模型的方法和基于机器学习的方法。基于表示学习的方法,近年来已经成为了SAR图像目标识别的研究热点。稀疏表示分类模型是近些年来较为成熟的表示分类模型,具有识别率高、噪声鲁棒性强等特点,目前广泛地应用于SAR图像目标识别中。稀疏表示利用一系列已知信号的线性组合来表示观测信号,对表示系数的稀疏性进行约束,即范数最小,得到唯一的表示系数解,再根据与每类训练样本的重构误差确定目标类型[11]。H. C. Zhang等通过挖掘多个视角的微波图像之间的相关性提出了多视联合稀疏表示的目标识别方法[12]。G. Dong等研究了基于monogenic特征联合稀疏表示的微波成像传感器目标识别方法,继而又发展了Grassman流形上的monogenic特征的稀疏表示技术[13,14]。Y. Sun等提出了一种基于动态稀疏表示和字典学习的SAR图像目标识别方法[15]。S. Song等提出了一种监督鉴别字典学习的稀疏表示SAR目标识别算法[16]。H. Liu等提出了基于稀疏表示和字典Refinement的属性散射中心特征提取及目标识别方法[17]。

近年来发展起来的另一种表示学习方法是协同表示。协同表示学习实际上是范数约束下的优化问题。协同表示已经广泛应用于人脸识别[18]、高光谱分类等[19]。与稀疏表示的“竞争”关系不同,协同表示利用“合作”,从而提高了分类精度。协同表示用所有的样本特征来协同表示测试样本,利用范数可直接求得闭式解,大大降低了求解的计算量[20]。由于其凸优化的性质,稀疏表示仅从样本中选择少量原子时,可能使得表示系数过于稀疏,从而导致其残差略有偏差。在协同表示中,表示系数不需要稀疏,而当标记的样本包括混合类信息时,其判别能力受到限制。通过增加单个分类器结构的复杂度来提高分类器精度通常不能满足问题的需求,而将多个分类器利用不同的策略进行融合从而提高整体的识别精度,将是一种更好的选择。融合多分类器可集成多分类器的优良性能,在融合之前,各个分类器已独立完成分类任务,再根据一定的准则及每个决策的可信度做出最后决策,有良好的实时性和容错性[21]。M. Liu等人研究了多稀疏表示Dempster-Shafer融合的SAR图像目标识别方法[22]。H. C. Liu等研究了稀疏表示和支持向量机(Support Vector Machine, SVM)融合的SAR图像目标识别方法[23]。基于融合的思想,本文提出了一种多特征-多表示分类器融合的SAR图像目标识别方法。该方法集成了主成分分析(Principle Component Analysis, PCA)特征,小波变换特征,两维切片Zernike矩特征(2 Dimension Slice Zernike Moments, 2DSZM)的鉴别能力,通过决策融合算法融合了稀疏表示和协同表示两种表示学习分类器的优势;最终得到测试样本的目标类型。以美国Moving and Stationary Target Acquisition and Recognition (MSTAR)研究计划公开发布的SAR图像数据库进行了实验验证,实验结果验证了所提出方法的有效性和优越性。

本文组织结构如下:第2部分简述了3种特征提取;第3部分介绍了稀疏表示分类器、协同表示分类器和采用的多分类器融合方法;第4部分给出本文方法的实验结果及分析;第5部分对全文进行了总结。

2 SAR目标图像多特征提取

每种特征都是从特定角度提取图像信息的,因此不能反映图像所有的信息。而且,异类特征之间往往具有互补性。因此,在目标识别中利用多特征的鉴别能力是更合理的选择。在本文中,提取SAR目标图像的3类特征,分别为:PCA特征,小波变换特征,2DSZM特征。

2.1 PCA特征提取

通过投影到一组由样本数据求得的自相关矩阵的正交矢量上而得到的一组矢量,并且该矢量包含了样本的主要成分,被称为主分量,相比于原样本矢量,主分量维数较低,可以代替原有样本矢量表征样本,该矢量即为PCA特征。

2.2 小波特征提取

小波变换是立足于傅里叶分析基础上发展起来的多尺度分析方法。在模式识别领域,小波变换广泛应用于提取图像中的各种特征。在本文中,采用2维离散小波变换对SAR目标图像进行特征提取,将2维离散小波变换得到的一级低频子带图像列向量化后作为特征向量。小波特征提取的过程可简化表示为:其中表示2维离散小波变换特征提取算子,即为提取后的小波特征。

2.3 2DSZM特征提取

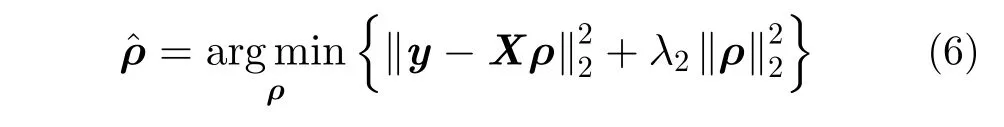

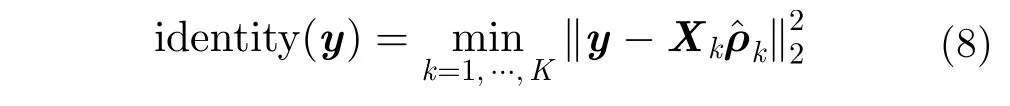

2DSZM特征是近年来提出的一种分层描述SAR目标散射特性的特征提取方法[24]。SAR目标图像包含了目标丰富的散射中心位置分布和强度分布信息。通过具有不同强度值的切片可以将不同强度程度的散射中心分层到不同的切片上。该特征提取的基本操作为通过均匀切片操作,得到SAR目标图像的多层2维切片,对每个切片层进行二值化,然后提取每层切片的Zernike矩特征,得到Zernike矩特征矢量,再将所有的切片的Zernike矩阵矢量顺序排列为列矢量即得到2DSZM特征。具体实现过程可参考文献[24]。图1即为对3类目标SAR图像的切片操作示意图,图2为提取的2DSZM特征曲线图。

3 多表示学习及决策融合

3.1 稀疏表示分类器

稀疏表示在人脸识别、图像恢复、图像分类等多种领域都有广泛的应用,该模型的成功主要源于观测信号在一组过完备基(字典)下可以稀疏表示,其最优的稀疏表示可以利用凸优化方法有效求解。

由于待测样本y的类标签未知,因此,需要用所有k类训练样本来表示。

为训练样本的总数。所以待测样本y的线性表示可写作:

上述即为稀疏表示分类器(Sparse Representation Classifier, SRC)。

3.2 协同表示分类器

Zhang等人将稀疏表示分类器视为协同表示分类器的一个特例。稀疏表示分类器寻找测试样本在字典中最稀疏的线性表示,即用最小数目的训练样本的线性组合来表示测试样本,而协同表示用所有训练样本的特征集协同表示测试样本。将SRC中的基于范数的稀疏性约束条件转化为范数最小问题,即为协同表示分类器。待测样本y在训练样本集X下的最优表示问题为:

图1 3类目标的多层2维切片Fig. 1 Multiple 2D slices of three targets

这即便是协同表示分类器(Collaborative Representation Classifier, CRC)。

3.3 决策融合

本文提出的多特征-多表示融合的方法是基于决策层的融合。基于决策层的融合可以保证不影响单个分类器的性能,而又能发挥每个分类器的优良性能。常用的决策融合方法有多数投票法、加权分数融合、贝叶斯融合等多种融合方法。在本文的决策融合中,分别采用了多数投票融合算法;自适应加权融合算法;贝叶斯融合算法。本文算法的流程图如图3所示。由于多数投票融合法的原理简单,下面主要介绍自适应加权融合和贝叶斯融合两种融合方法。

3.3.1 自适应加权融合加权分数融合既能有效实现信息融合,同时易于实现,在实际应用中有很好的应用价值。其中自动设置权值是加权融合的关键。这里,采用文献[25]中的自适应加权融合算法。为简化描述,假定现在只融合单特征SRC和CRC两种分类结果,自适应加权融合方法主要步骤如下:

步骤1 对所有测试样本和训练样本进行特征提取;

步骤2 分别利用SRC和CRC求出待测样本y与每类训练样本的重构误差,分别表示为,C为类别总数。代表用SRC测试样本与第i类的重构误差,代表用CRC时测试样本与第i类的重构误差。定义

图2 3类目标的2D-slice Zernike moments特征值比较Fig. 2 Comparisons of 2D-slice Zernike moments of three targets

图3 基于多特征-多表示学习分类器融合算法流程图Fig. 3 The procedure of based on fusion of multi-feature multiple representation classifier

3.3.2 贝叶斯决策融合贝叶斯决策是一种比较自然的融合处理方式。在此方法中,两个分类器是相互独立的。为便于描述,以单特征为例进行阐述,测试样本为从SRC和CRC获得的k1,k2的两个预测结果,两个分类器识别精度分别用PSRC,PCRC表示。测试样本使用SRC预测为Tq而属于Yn类的(1≤n≤C,1≤q≤C)的置信度可利用贝叶斯准则计算如下:

其中,P(Tc)为测试样本属于c类的概率,这里我们假设先验概率是等概率的。PSRC(Tq|Tn)表示为测试样本为第Tn类使用SRC为预测Tq类的概率。同样也可得到使用CRC方法的置信度PCRC(Tn|Tq)。利用SRC和CRC分别获得测试样本中每一类的置信度,并将通过两种方法分别得到的同一类的置信度相乘。选择具有最大置信度的类作为决策结果,可表示为:

3.4 多特征-多表示融合方法框架

多特征-多表示分类器融合框架就是在上述理论建立起来的,流程图如图3所示。首先分别提取训练样本集和测试样本集的3种特征,再将测试样本的3类特征分别输入稀疏表示分类器和协同表示分类器进行预分类,得到6个预测标签。再利用分类器融合对6个预测标签进行融合,得到最终的识别结果。这里的分类器融合分别采用了上述3种分类器融合方法,将单特征SRC和CRC以6类分类器融合的方式拓展为多特征-多表示融合。在基于多特征-多表示分类器算法中,6组分类器可独立并行处理,大大节约了时间成本。

4 实验结果及分析

4.1 实验数据集介绍

实验数据采用美国国防高等研究计划署支持的MSTAR计划所公开发布的实测SAR地面静止目标数据。该数据集是目前国内外广泛采用的SAR图像目标识别算法测试数据。该数据集的传感器为高分辨率聚束式合成孔径雷达,成像分辨率为0.3 m×0.3 m,工作在X波段。该数据包含多种车辆目标在各个方位角下的目标图像。在该数据集中包含一个该计划推荐使用的训练集和测试集。训练集是雷达工作在俯仰角17°时所得到的目标图像数据,实验中采用3大类:BTR70(装甲运输车),BMP2(步兵战车),T72(坦克),光学图像如图4所示;测试集是雷达工作在俯仰角15°时所得到的目标图像数据,实验中也使用BMP2, T72, BTR70。图5展示了相近角度下3类目标的微波图像。各种类别的目标还具有不同的型号,同类但不同型号的目标在配备上有些差异,但总体散射特性相差不大。具体来说,目标BMP2有3种配置类型BMP2-9563,BMP2-9566和BMP2-C21, BTR70有一种类型BTR70-C71, T72有3种配置类型T72-132, T72-812和T72-S7。训练和测试样本的类型和数目如表1所示。在本次实验中,为了减少目标周围的杂波干扰,提取原始图像中心60×60子图像。

4.2 实验结果及分析

多特征-多表示分类器决策融合算法的优势在于集成了目标的多特征鉴别能力,有效融合了多表示分类器的优良性能,利用结构简单的分类器就可以得到更高的识别精度,有较高的容错性。为了分析决策融合算法对识别性能的影响,实验中比较了多表示学习分类器的多数投票法(Sparse and Collaborative Majority Vote, SCMV)、自适应权重融合方法(Sparse and Collaborative Adaptive Weighted Fusion, SCAWF)和贝叶斯决策融合方法(Sparse and Collaborative Bayesian Fusion,SCBF)。

图4 3类目标光学图像Fig. 4 Optical images of three targets

表1 实验数据集的型号/数目Tab. 1 The types and numbers of training and testing datasets

4.2.1 识别性能随特征维数的变化特征维数的选取对SRC和CRC的分类性能都会产生很大的影响。实验中,设置不同的特征维数,观察各种融合算法随特征维数的性能变化,同时将3种方法的识别性能进行对比,实验结果如图6和表2所示。在本文中,3种特征的维数是不同的,以各自的维数按照20%, 40%, 60%, 80%, 100%的比例设置得到不同的维数;图6中横轴为PCA特征的维数。从图4可以看出,采用贝叶斯决策融合的算法在几乎所有维数情况下都是三者之中最好的。另外,特征维数为240时,识别率最佳,可达99.60%。但当维数增加到600维时,所有方法的识别率有所下降,但SCBF仍然保持较高的识别率,可达到97.44%。

图6 3种算法随特征维数变化的识别率Fig. 6 Recognition rate of three algorithms with feature dimension

表2 3种算法随特征维数变化的识别率(%)Tab. 2 Recognition rate of three algorithms with feature dimension (%)

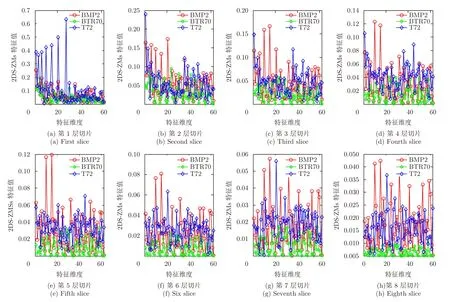

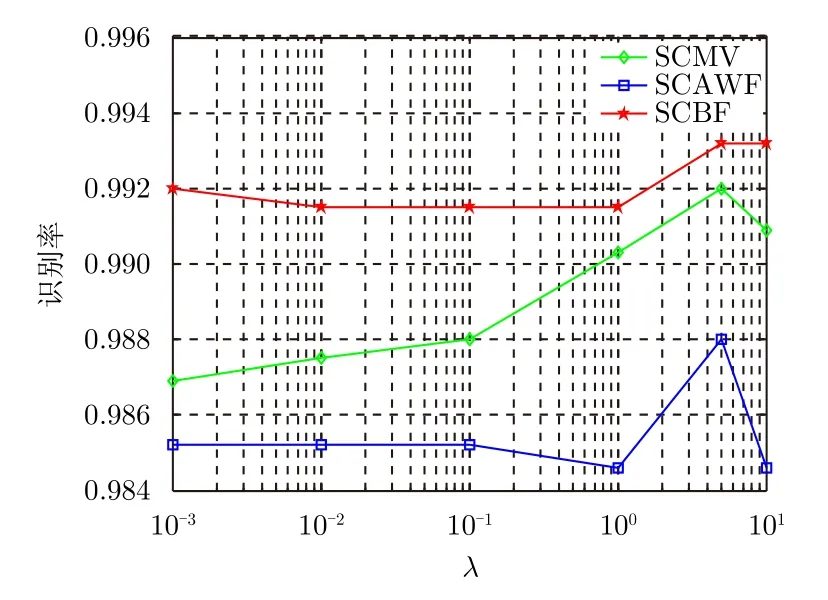

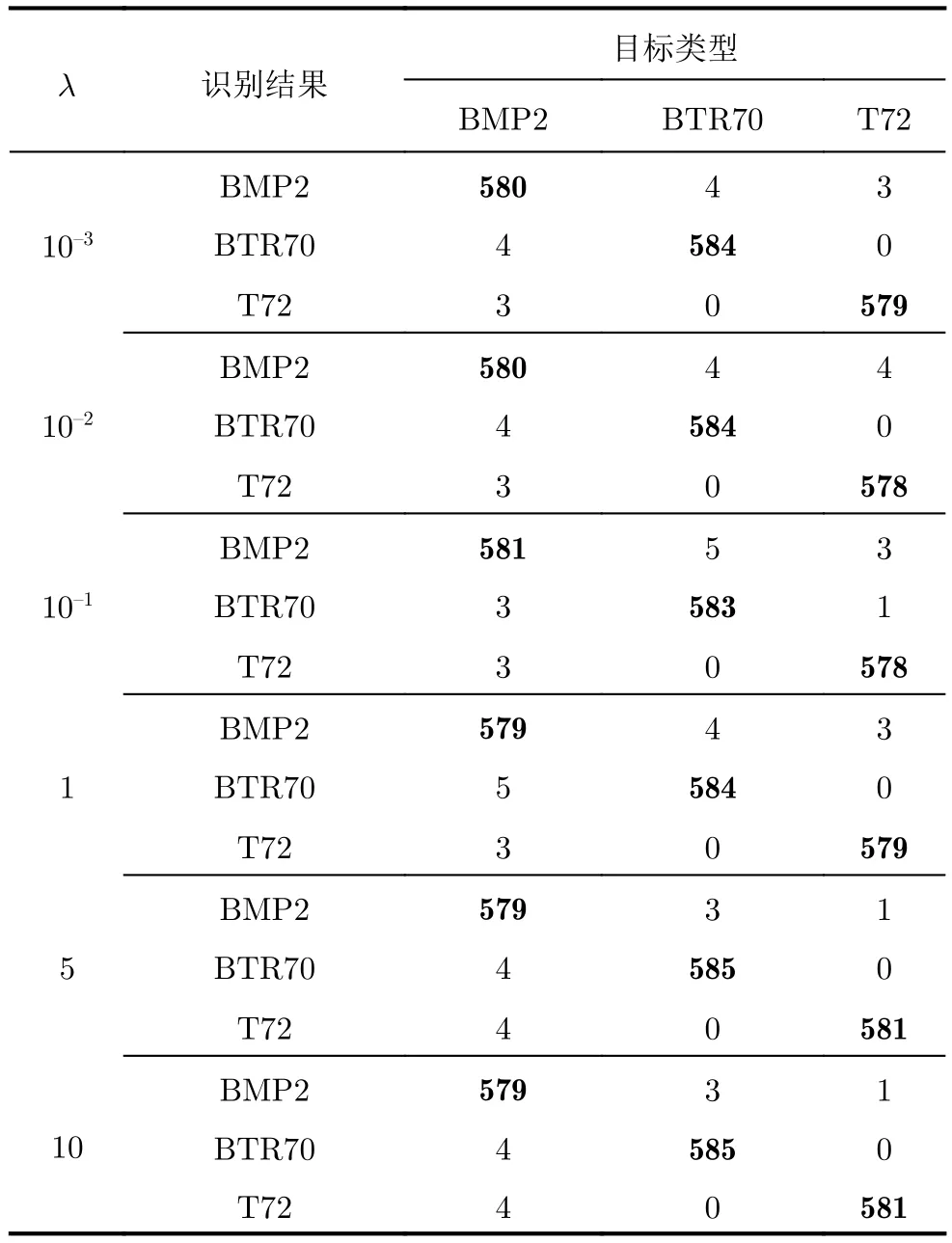

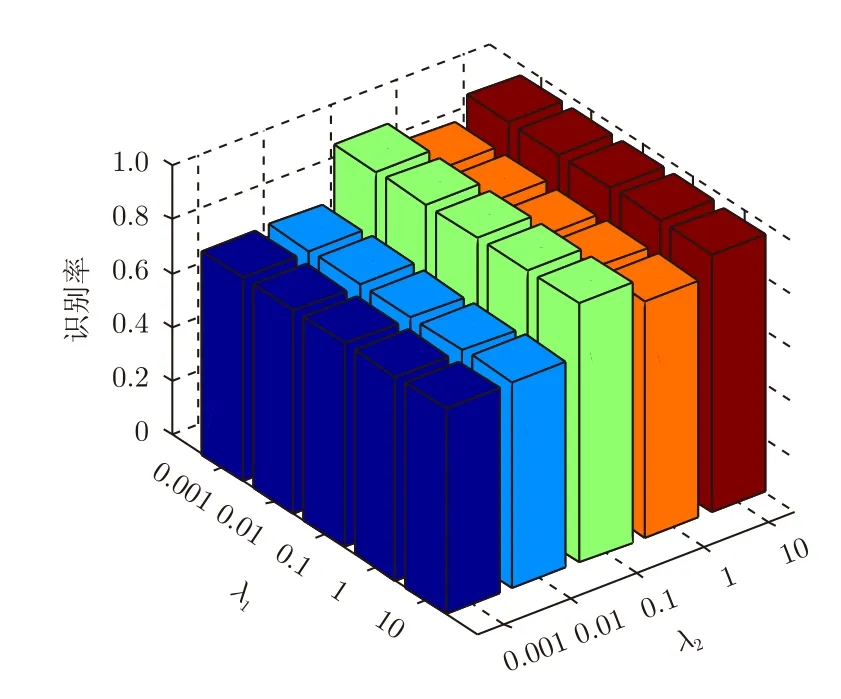

4.2.2 规则化参数对算法的影响多表示分类器融合算法中使用了两种表示学习分类器:SRC和CRC。SRC和CRC模型中的规则化参数均对各自的识别性能有不同程度的影响,也因此会影响融合后的识别性能。为探究规则化参数对本文提出算法的影响,固定3种特征维数的取值,将规则化参数分别设置为10–3, 10–2, 10–1, 1, 5和10。对3种不同融合算法开展实验,并且SRC和CRC中的规则化参数取相同的值,实验结果为图7和表3。图7中,在规则化参数为5时,3种算法的识别率达到最大,多特征-多表示学习贝叶斯融合算法的识别性能最高。表4为贝叶斯融合方法随变化的混淆矩阵。从实验结果可以看出,虽然3种融合方法都能实现分类器的优势互补,但多特征-多表示分类器贝叶斯融合性能对规则化参数的变化具有最好的鲁棒性,随规则化参数变化的性能变化起伏不大。

上述实验中SRC和CRC中的规则化参数取值相同,但实际中两者的规则化参数不一定相同。为了分析规则化参数不同时对融合算法性能的影响,实验中对SRC中的规则化参数λ1和CRC中的规则化参数λ2分别取不同的值,观测识别性能,如图8。从图8中可以看出,取值对识别性能的影响更大。

图7 3种算法随规则化参数的识别率Fig. 7 Recognition rates of three algorithms with regularized parameters

表3 3种算法随规则化参数的识别率(%)Tab. 3 Recognition rates of three algorithms with regularized parameters (%)

表3 3种算法随规则化参数的识别率(%)Tab. 3 Recognition rates of three algorithms with regularized parameters (%)

方法MFSCFMVAWFA 10–399.2098.5298.69 10–299.1598.5298.75 10–199.1598.5298.52 1 99.1598.4699.03 5 99.3298.8099.20 1099.3298.4699.09

由于各类特征具有不同的鉴别性能,各类特征对目标识别的贡献不同,置信度也不同。另外,SRC和CRC分别是ℓ1范数和ℓ2范数约束下的优化问题,其识别性能在不同的数据情况下也存在差异。多特征多表示分类器融合算法采用分类器融合技术,特别是贝叶斯融合算法,集成了多特征的鉴别能力,提高了识别的总体置信度,从而提高了识别性能。

另外,也把本文方法和最近的几种SAR图像识别方法的性能做了比较。在相同的数据集下,文献[15]中的联合动态字典的稀疏表示方法获得了96.48%的识别率;文献[24]中的2维切片Zernike矩稀疏编码算法获得了98.63%的识别率;而本文提出方法的最佳识别率可以达到99.60%,识别性能均优于上述两种方法。

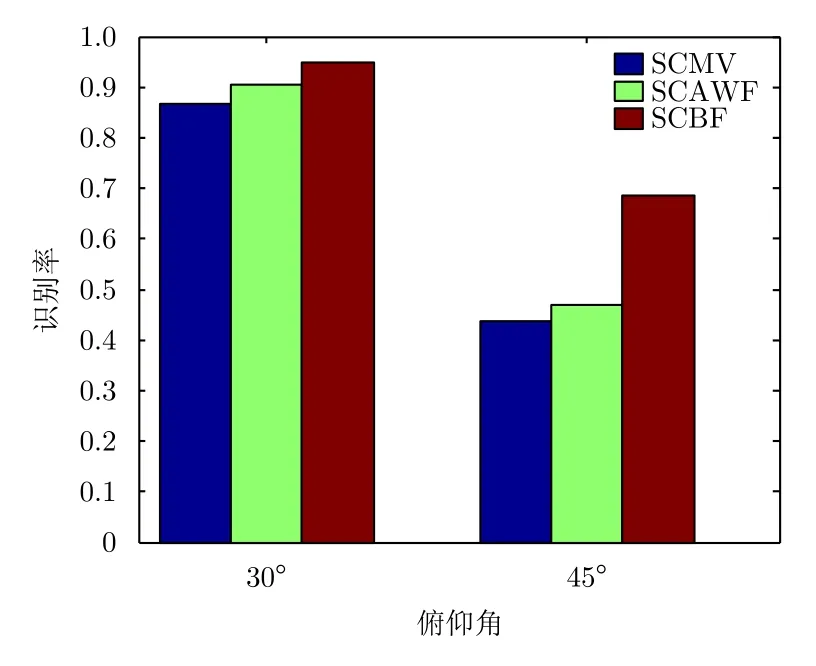

4.2.3 大俯仰角下目标识别性能与分析实际应用中,很有可能出现测试集和训练集数据的俯仰角之间存在较大的差异,为此,研究大俯仰角变化下的目标识别具有很重要的现实意义。本文基于MSTAR数据开展了大俯仰角下的实验,以数据库中17°数据为训练数据,同时分别采用30°和45°的数据集做测试集,来验证算法对大俯仰角的鲁棒性。表5为大俯仰角实验中目标类型和样本数目表。图9为各种方法的实验结果比较。从图9和表6可以看出,小波特征在大俯仰角下识别率都较低,PCA特征和2DSZM特征的识别率相对较高。30°俯仰角下,融合6种单分类器分类结果的3种算法的识别率分别为:86.56%、90.38%和94.79%。其中多表示学习分类器贝叶斯融合的识别率最佳。随着俯仰角从30°增加到了45°,训练样本和测试样本之间的类内关联减弱,目标的正确识别率显著下降,最好的识别率仅为68.65%,其中,多数投票融合方法通过简单的投票,部分错误的识别结果容易影响正确的识别结果从而导致整体的识别率的下降,自适应加权融合方法采用次最优的思想也易造成部分错误结果权值过大影响整体效果。贝叶斯融合方法在3种融合方法中具有最佳的识别性能,这也证明了多特征-多表示学习分类器贝叶斯融合方法对大俯仰角变化时具有较好的鲁棒性。

表4 SCBF随规则化参数的混淆矩阵Tab. 4 Confusion matrix of SCBF with regularized parameters

表4 SCBF随规则化参数的混淆矩阵Tab. 4 Confusion matrix of SCBF with regularized parameters

识别结果目标类型BMP2BTR70T72 10–3 BMP258043 BTR7045840 T7230579 10–2 BMP258044 BTR7045840 T7230578 10–1 BMP258153 BTR7035831 T7230578 1 BMP257943 BTR7055840 T7230579 5 BMP257931 BTR7045850 T7240581 10 BMP257931 BTR7045850 T7240581

图8 SCBF随规则化参数λ1和λ2的识别率Fig. 8 Recognition rate of SCBF with the regularization parameters λ1 and λ2

表5 大俯仰角实验中使用的数据集Tab. 5 Dataset used in large depression angle experiment

图9 大俯仰角下3种算法的识别率柱状图Fig. 9 Histogram of recognition rate of three algorithms at large pitch angle

多特征-多表示融合算法的计算复杂度依赖于所采用的是何种表示学习分类器。对于本文来说,采用的是经典的稀疏表示分类器(SRC)模型和协同表示分类器(CRC)模型,只不过是3类特征分别输入这两种表示学习分类器。另外,融合部分产生的计算量和这两种分类器的计算量相比很小,因此本文算法的总计算量是3倍SRC计算量和3倍CRC计算量的和。

5 结论

本文探讨了基于多特征-多表示决策融合的SAR图像目标识别,并使用MSTAR数据库测试了识别性能。算法中采用PCA特征,Wavelet特征和2DSZM特征,利用结构较为简单的基本SRC和CRC进行多表示决策融合。实验结果表明,采用贝叶斯融合的多特征-多表示分类器融合方法性能更为优越,对规则化参数的变化具有最好的鲁棒性,在大俯仰角下也能取得更好的结果,能够有效地提高识别精度。与其他算法相比,基于多特征-多表示学习决策融合的SAR图像目标识别具有以下优势:第一,集成了多特征的鉴别能力,实现了异类特征之间的优势互补;第二,使用多表示分类器融合代替结构复杂的分类器,简化了算法的复杂度,有效提高算法的鲁棒性。

表6 大俯仰角下不同分类方法的识别率(%)Tab. 6 Recognition rate for different classification methods at large pitch angles (%)

[1]Qi Zhi-xin, Yeh A G O, Li Xia,et al.. A novel algorithm for land use and land cover classification using RADARSAT-2 polarimetric SAR data[J].Remote Sensing of Environment,2012, 118: 21–39. DOI: 10.1016/j.rse.2011.11.001.

[2]Liu Bin, Hu Hao, Wang Huan-yu,et al.. Superpixel-based classification with an adaptive number of classes for polarimetric SAR images[J].IEEE Transactions on Geoscience and Remote Sensing, 2013, 51(2): 907–924. DOI:10.1109/TGRS.2012.2203358.

[3]Wang Hui, Chen Zhan-sheng, and Zheng Shi-chao.Preliminary research of Low-RCS moving target detection based on Ka-Band video SAR[J].IEEE Geoscience and Remote Sensing Letters, 2017, 14(6): 811–815. DOI:10.1109/LGRS.2017.2679755.

[4]El-DarymliK, Gill E W, and Mcguire P. Automatic target recognition in synthetic aperture radar imagery: A state-ofthe-art review[J].IEEE Access, 2016, 4: 6014–6058. DOI:10.1109/ACCESS.2016.2611492.

[5]Novak L M, Owirka G J, and Netishen C M. Performance of a high-resolution polarimetric SAR automatic target recognition system[J].The Lincoln Laboratory Journal,1993, 6(1): 11–23.

[6]Saghri J A and DeKelaita A. Exploitation of target shadows in synthetic aperture radar imagery for automatic target recognition[C]. Proceedings of SPIE Volume 6312 Applications of Digital Image Processing XXIX, California,United States, 2006, 6312: 631212. DOI: 10.1117/12.684401.

[7]Amoon M and Rezai-Rad G A. Automatic target recognition of synthetic aperture radar (SAR) images based on optimal selection of Zernike moments features[J].IET Computer Vision, 2014, 8(2): 77–85. DOI: 10.1049/ietcvi.2013.0027.

[8]Gerry M J, Potter L C, Gupta I J,et al.. A parametric model for synthetic aperture radar measurements[J].IEEE Transactions on Antennas and Propagation, 1999, 47(7):1179–1188. DOI: 10.1109/8.785750.

[9]宦若虹, 张平, 潘赟. PCA、ICA和Gabor小波决策融合的SAR目标识别[J]. 遥感学报, 2012, 16(2): 262–274.Huan Ruo-hong, Zhang Ping, and Pan Yun. SAR target recognition using PCA, ICA and Gabor wavelet decision fusion[J].Journal of Remote Sensing, 2012, 16(2): 262–274.DOI: 10.11834/jrs.20120457.

[10]Lin Chang, Peng Fei, Wang Bing-hui,et al.. Research on PCA and KPCA self-fusion based MSTAR SAR automatic target recognition algorithm[J].Journal of Electronic Science and Technology, 2012, 10(4): 352–357.

[11]Zhang Zheng, Xu Yong, Yang Jian,et al.. A survey of sparse representation: Algorithms and applications[J].IEEE Access, 2015, 3: 490–530. DOI: 10.1109/ACCESS.2015.2430359.

[12]Zhang Hai-chao, Nasrabadi N, Zhang Yan-ning,et al..Multi-view automatic target recognition using joint sparse representation[J].IEEE Transactions on Aerospace and Electronic Systems, 2012, 48(3): 2481–2497. DOI: 10.1109/TAES.2012.6237604.

[13]Dong Gang-gang, Kuang Gang-yao, Wang Na,et al.. SAR target recognition via joint sparse representation of monogenicsignal[J].IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2015, 8(7):3316–3328. DOI: 10.1109/JSTARS.2015.2436694.

[14]Dong Gang-gang and Kuang Gang-yao. SAR target recognition via sparse representation of Monogenic signal on Grassmann manifolds[J].IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2016,9(3): 1308–1319. DOI: 10.1109/JSTARS.2015.2513481.

[15]Sun Yong-gang, Du Lan, Wang Yan,et al.. SAR automatic target recognition based on dictionary learning and joint dynamic sparse representation[J].IEEE Geoscience and Remote Sensing Letters, 2016, 13(12): 1777–1781. DOI:10.1109/LGRS.2016.2608578.

[16]Song Sheng-li, Xu Bin, and Yang Jian. SAR target recognition via supervised discriminative dictionary learning and sparse representation of the SAR-HOG feature[J].Remote Sensing, 2016, 8(8): 683. DOI: 10.3390/rs8080683.

[17]Liu Hong-wei, Bo Jiu, Li Fei,et al.. Attributed scattering center extraction algorithm based on sparse representation with dictionary refinement[J].IEEE Transactions on Antennas and Propagation, 2017, 65(5): 2604–2614. DOI:10.1109/TAP.2017.2673764.

[18]Zhang Lei, Yang Meng, and Feng Xiang-chu. Sparse representation or collaborative representation: Which helps face recognition?[C]. Proceedings of IEEE International Conference on Computer Vision, Barcelona, Spain, 2012:471–478.

[19]Li Wei, Du Qian, Zhang Fan,et al.. Hyperspectral image classification by fusing collaborative and sparse representations[J].IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2016, 9(9):4178–4187. DOI: 10.1109/JSTARS.2016.2542113.

[20]Chi Yue-jie and Porikli F. Classification and Boosting with multiple collaborative representations[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2014, 36(8): 1519–1531. DOI: 10.1109/TPAMI.2013.236.

[21]Haghighi M S, Vahedian A, and Yazdi H S. Extended decision template presentation for combining classifiers[J].Expert Systems with Applications, 2011, 38(7): 8414–8418.DOI: 10.1016/j.eswa.2011.01.036.

[22]Liu Ming, Wu Yan, Zhao Wei,et al.. Dempster-Shafer fusion of multiple sparse representation and statistical property for SAR target configuration recognition[J].IEEE Geoscience and Remote Sensing Letters, 2014, 11(6):1106–1109. DOI: 10.1109/LGRS.2013.2287295.

[23]Liu Hai-cang and Li Shu-tao. Decision fusion of sparse representation and support vector machine for SAR image target recognition[J].Neurocomputing, 2013, 113: 97–104.DOI: 10.1016/j.neucom.2013.01.033.

[24]Zhang Xin-zheng, Liu Zhou-ying, Liu Shu-jun,et al.. Sparse coding of 2D-slice Zernike moments for SAR ATR[J].International Journal of Remote Sensing, 2017, 38(2):412–431. DOI: 10.1080/01431161.2016.1266107.

[25]Xu Yong and Lu Yuwu. Adaptive weighted fusion: A novel fusion approach for image classification[J].Neurocomputing,2015, 168: 566–574. DOI: 10.1016/j.neucom.2015.05.070.

张新征(1978–),男,山东省聊城人,博士,副教授。2009年于航天科工集团第二研究院获导航制导与控制专业博士学位,现担任重庆大学通信工程学院副教授。主要研究方向为遥感信息获取与处理、人工智能及其应用,目前已发表论文20余篇,专利获权5项。社会兼职:中国电子学会会员。

E-mail: zhangxinzheng@cqu.edu.cn

谭志颖(1994–),女,湖南郴州人,2016年在湘潭大学信息工程学院获得本科学位,现为重庆大学通信工程学院硕士研究生,研究方向为遥感图像分类。

E-mail: 20161202031t@cqu.edu.cn

王亦坚(1994–),男,江西抚州人,2016年在重庆大学通信工程学院获得本科学位,现为重庆大学通信工程学院硕士研究生,研究方向为SAR图像目标检测与识别。

E-mail: 20161202029t@cqu.edu.cn

The National Natural Science Foundation of China (61301224)

SAR Target Recognition Based on Multi-feature Multiple Representation Classifier Fusion

Zhang Xinzheng Tan Zhiying Wang Yijian

(College of Communication Engineering,Chongqing University,Chongqing400044,China)

In this paper, we present a Synthetic Aperture Radar (SAR) image target recognition algorithm based on multi-feature multiple representation learning classifier fusion. First, it extracts three features from the SAR images, namely principal component analysis, wavelet transform, and Two-Dimensional Slice Zernike Moments (2DSZM) features. Second, we harness the sparse representation classifier and the cooperative representation classifier with the above-mentioned features to get six predictive labels. Finally, we adopt classifier fusion to obtain the final recognition decision. We researched three different classifier fusion algorithms in our experiments, and the results demonstrate thatusing Bayesian decision fusion gives thebest recognition performance. The method based on multi-feature multiple representation learning classifier fusion integrates the discrimination of multi-features and combines the sparse and cooperative representation classification performance to gain complementary advantages and to improve recognition accuracy. The experiments are based on the Moving and Stationary Target Acquisition and Recognition (MSTAR) database,and they demonstrate the effectiveness of the proposed approach.

Synthetic Aperture Radar (SAR); Target recognition; Sparse representation; Collaborative representation; Decision fusion

TN959

A

2095-283X(2017)05-0492-11

10.12000/JR17078

张新征, 谭志颖, 王亦坚. 基于多特征-多表示融合的SAR图像目标识别[J]. 雷达学报, 2017, 6(5):492–502.

10.12000/JR17078.

Reference format:Zhang Xinzheng, Tan Zhiying, and Wang Yijian. SAR target recognition based on multifeature multiple representation classifier fusion[J].Journal of Radars, 2017, 6(5): 492–502. DOI:10.12000/JR17078.

2017-08-18;改回日期:2017-10-22;网络出版:2017-10-27

*通信作者: 张新征 zhangxinzheng@cqu.edu.cn

国家自然科学基金(61301224)