图像辅助智能终端定位的国内外研究进展*

2017-10-16童庆禧陈秀万刘茂林黄照强

王 媛,童庆禧,陈秀万,刘茂林,黄照强

(1.北京大学遥感与地理信息系统研究所,北京 100871;2.中国冶金地质总局矿产资源研究院,北京 100123)

图像辅助智能终端定位的国内外研究进展*

王 媛1,童庆禧1,陈秀万1,刘茂林1,黄照强2

(1.北京大学遥感与地理信息系统研究所,北京 100871;2.中国冶金地质总局矿产资源研究院,北京 100123)

图像含有丰富的目标信息,被获取并处理后用于一种新型的智能终端定位手段。对图像定位的相关概念进行介绍,对关键技术的研究情况进行评述,并分别从图像定位作为独立的定位系统和图像定位与全球导航卫星系统(Global Navigation Satellite System,GNSS)及惯性导航系统(Inertial Navigation System,INS)等其他定位方法融合的定位系统2个方面阐述其研究进展,在此基础上提出图像辅助智能终端定位研究中存在的问题及发展方向。

图像定位,智能终端,融合,消影点

Abstract:Image containing target color,texture,shape and other rich information has been successfully demonstrated to locate the smartphones for a new positioning means.Image-aided positioning includes absolute position and relative positioning.This paper introduces concepts of Image-aided position,and research of key technologies(coordinate frame,camera calibration,features detection and matching,pattern recognition and pose estimation).Further the two positioning systems are reviewed including stand-alone image-aided positioning and fusion of Global Navigation Satellite System (GNSS),Inertial Navigation System (INS)and others.Finally,the existing problems and prospects for the near future in terms of experiment and application are analyzed.

Key words:image-aided position,smartphones,fusion,vanishing point

0 引言

随着位置信息在各个领域的广泛应用,出现了越来越多的定位手段。移动智能终端的发展使其成为导航定位的研究对象,内置的卫星信号接收模块、摄像头和各种惯性传感器等硬件提供定位所需信息。一些学者发现,视觉传感器获得图像也可以用于定位,其技术原理是运动载体通过视觉设备观察场景,通过图像分析、目标识别等技术,结合卫星信号和传感器数据理解环境信息,计算载体在世界坐标系下的全局位姿,或是载体相对参照物的局部相对位姿[1]。图像能够提供丰富、准确、直观的环境信息,易于理解,并且符合人的视觉观察,利用图像辅助移动智能终端定位价格低廉、使用方便,可以使得定位系统具有更多源的数据、更多样的方式。

1 图像定位的相关概念

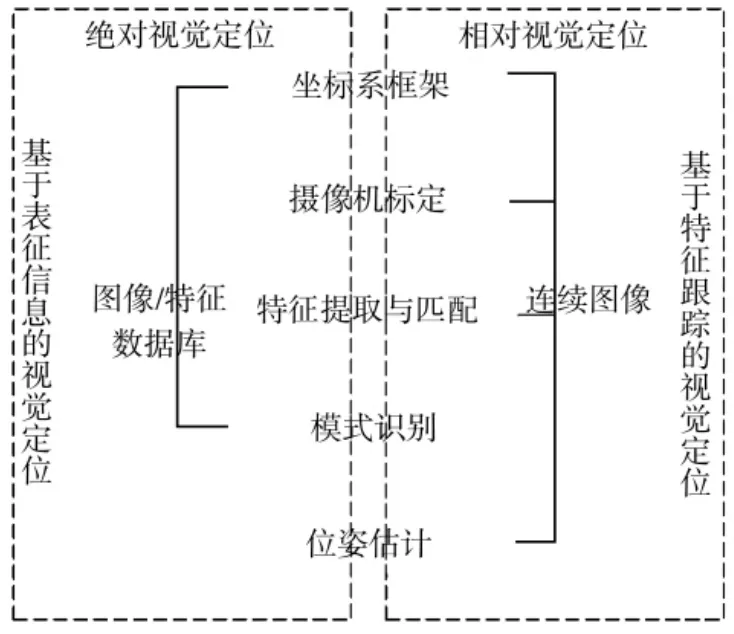

1.1 绝对图像定位

绝对图像定位能够获得用户在世界坐标系中的绝对位置,分为训练阶段和定位阶段,训练阶段获取带有位置信息的图像构建数据库,定位阶段通过图像/特征匹配确定位置。用户获取所处位置的图像,并将其发送至远程服务器,服务器将发送来的图片在数据库中进行特征匹配获得匹配结果,将位置信息返回至用户。另一种方式是用户获取图像,提取其表征信息或特定特征,并与特征数据库中信息匹配,这种方式也称之为图像指纹定位技术[2],算法流程如图1所示。

图1 绝对图像定位算法框架

1.2 相对图像定位

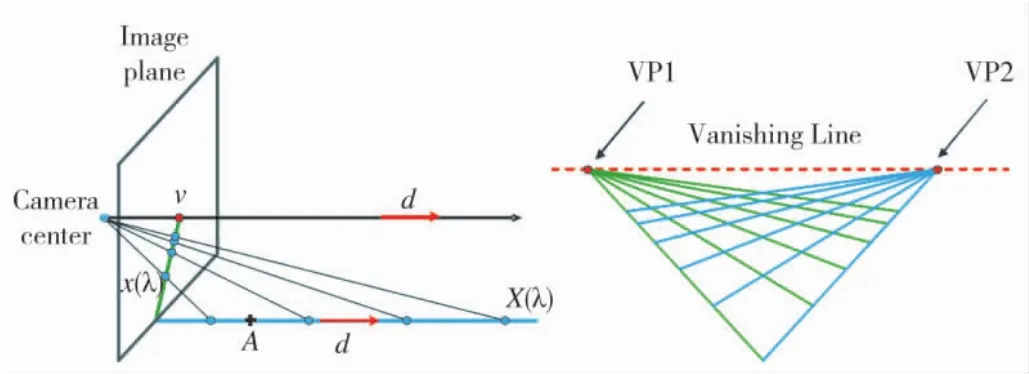

相对图像定位通过对图像序列进行处理获得运动的大致朝向。三维物体通过透视投影得到二维图像的过程会出现两个重要的特征:消影点和消影线。消影点[3](Vanishing Point)是场景中两条平行线经过透视投影后在图像上汇聚的一点,它仅仅依赖于空间直线的方向,而与其位置无关。消影线[3](Vanishing Line)是平行平面与无穷远平面相交的一条直线在平面上的投影,它仅与空间平面的法线方向有关,与其位置无关。示意图如图2所示。

图2 消影点和消影线示意图

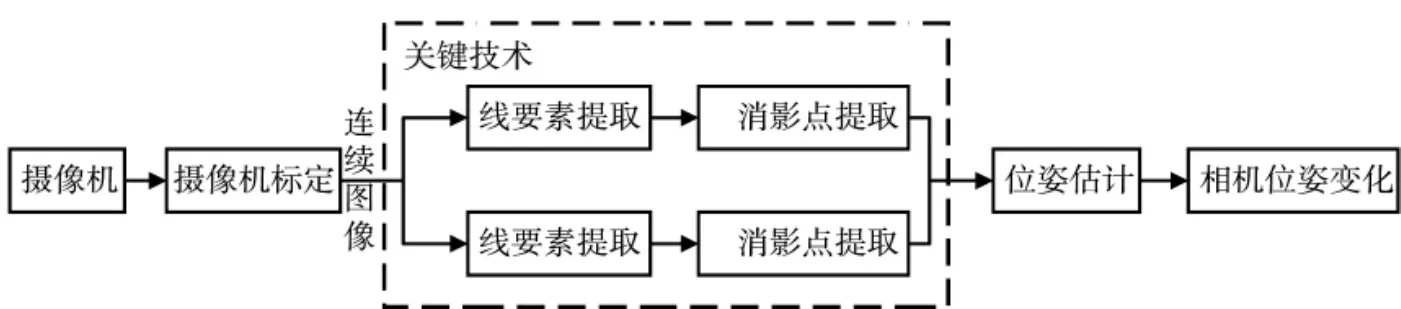

利用连续图像消影点或消影线[4]位置的变化解算相机朝向、横滚和俯仰,被称为视觉陀螺仪[5]。利用连续图像恢复深度、距离信息,被称为视觉里程计。一般情况下使用智能手机或穿戴装备,通过视觉陀螺仪和视觉里程计实时获得相机运动特征,然后将该运动特征转化为载体的运动信息,算法流程如图3所示。主要应用于基于特征跟踪的视觉定位中。

图3 相对图像定位算法框架

图4 图像定位关键技术框架

2 图像定位的关键技术

2.1 坐标系框架

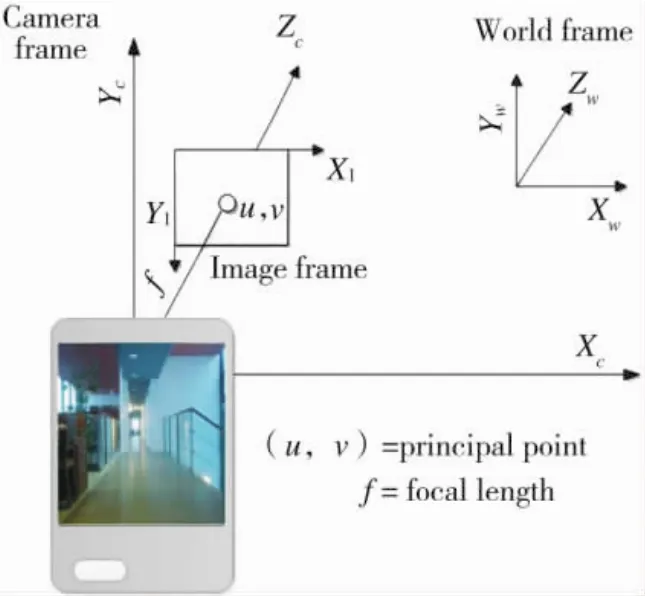

坐标系框架是图像定位的基础,建立相机、图像和世界坐标系之间的关系,实现运动特征在3个坐标系之间的转换。Richard Hartley[6]提到摄像机是三维世界和二维图像之间的映射变换,映射不会保存形状、长度、角度、距离或距离比例,但会保存直线的性质。世界坐标系、摄像机坐标系和图像坐标系及主点、焦距[5]如图5所示。

图5 相机、图像和世界坐标系

2.2 摄像机标定

摄像机标定是从二维图像获取三维信息必不可少的步骤,包括内部参数标定和外部参数标定,目前主要是研究外部参数标定,它可以确定摄像机在世界坐标系中的三维位置和方向。摄像机标定起源于摄影测量学,在19世纪出现了对摄像机镜头校正的研究,20世纪50至70年代,开始逐步提出并普遍采用镜头像差表达式,20世纪90年代,B.Caprile和V.Torre[7]首先提出消影点的3个特性,并利用这些特性对相机进行标定,之后,有大量研究者[8-10]考虑消影点受噪声影响大、标定精度较低的问题,对消影点检测算法进行改进,间接提高摄像机标定精度。

2.3 特征提取与匹配

特征提取与匹配是获取图像中目标的颜色、纹理、空间等特征的技术,然后利用匹配算法计算两幅或多幅图像之间的相似量,根据相似量判别图像间的变化情况或得出不同图像间的相似度,是图像定位的关键技术。适用于图像定位的特征提取算法主要包括线要素提取、Harris角点检测、随机抽样一致算法[11],线要素提取首先识别图像的边缘特征,然后将直线要素与其他要素分离开,为了得到更好的结果,学者们对Canny算子[12-14]和 Hough变换[15-17]作了很多研究;Harris角点检测[18]可以获得图像中关键区域的形状,为了解决角点冗余、确定阈值困难的问题,大量学者[19-23]展开研究。特征匹配算法主要使用尺度不变特征转换[24-25],可在图像中检测出关键点,是一种局部特征描述子,国内外学者通过降维提高算法效率、通过扩展提升算法效果、提高仿射不变性、增加全局信息提高相似环境适应性4方面对算法进行提升[26-29]。

2.4 模式识别

模式识别是对图像中的特征、对象分类,与数据库中的先验模型进行对比,如果参考要素中附加了位置信息,就可以获得绝对位置。在2002年Johansson[30]提出可以基于环境中建筑现存的模型,利用每个建筑固有的平行线特征,为数据库中的建筑物创建边缘模型,行人利用消影点修正新图像的方向后,再与建筑数据库中模型进行比较,最终得到位置信息。在模式识别过程中光照会影响对颜色值的判断,2007年江泽民等[31]为了减少环境中光照对颜色值的影响,采用YIQ颜色空间表示法。为了降低分类的复杂度、提高分类效率,2016年赵漫丹等[32]提出了一种基于层级分类策略的复杂模式识别方法,通过选择合适的分层标志,从多侧面反应被分类对象的属性。

2.5 位姿估计

位姿估计是相对图像定位中的关键技术,主要是利用相邻图像的消影点和消影线位置变化来计算相机的位姿。2010年Kessler等[4]使用消影点和消失线确定摄像头和行人的姿态,因为消影点在投影变换过程中是不变的,即便失去了深度信息也不影响计算,利用消失线倾斜程度和中心消影点坐标变化可以计算出相机姿态变化。一般情况下,从两幅图像分别搜索对应的要素比较耗费时间,也会影响定位导航的实时性。2015年Strelow[33]研究了使用极线约束限制第二幅图像的搜索区域,如果有连续图像之间摄像机运动(即平移和旋转)的先验知识,那么搜索范围就会被限制到相对小的范围。

3 独立的图像定位系统

3.1 基于表征信息的定位

基于表征信息的定位方法属于绝对定位,包括训练阶段和导航阶段,训练阶段记录周围环境建立数据库;导航阶段用当前采集的图像在数据库中进行匹配以确定位置。数据库中存储的数据和用来匹配的数据可以是图像特征,也可以是图像本身。

3.1.1 图像特征作为表征信息

图像特征,包括颜色直方图、颜色矩、边缘直方图、GIST、局部二值图等,也就是说在数据库中存储图像的这些信息。1999年麻省理工学院媒体实验室的Hisashi Aoki等[34]第一次提出了行人视觉导航,提出用于识别位置的连续图像匹配技术,用动态的程序算法计算不同位置的相似性,用训练序列自动生成位置字典,用摄像机通过图像匹配实时识别位置,实验结果显示系统识别位置的精度有一定提升。考虑到智能终端的传输和存储量有限,2009年斯坦福大学的Vijay Chandrasekhar[35]提出用树结构来展示梯度直方图,可以有效地压缩数据。2010年多伦多大学的Jorge Torres-Solis[36]在定位环境中事先贴好基准标记,将标记的位置存储在数据库中。另外,为了减少导航阶段在数据库中进行搜索匹配的时间,2012年北京大学的R.Ji[37]提出了一个位置判别词汇编码(LDVC)方案,可以实现极低比特率查询传输、判别地标。到目前为止,由于提取的图像特征并不能完全表达图像本身特点,所以该方法并没有广泛使用。

3.1.2 图像内容作为表征信息

图像内容,即图像本身,也就是说将图像存储到数据库中作为匹配模版。2003年日本产业技术综合研究所的Masakatsu Kourogi[38]最先利用这种方式。2004年出现第一个类似手机应用程序,剑桥大学的 Duncan Robertson 和 Roberto Cipolla[39]提出在服务器上运行算法,向手机端发送查询到的图像。为了解决建筑相似无法识别的问题,2011年斯坦福大学的David M.Chen[40]提出融合含有互补信息的中心投影图像和正视图像,可以显著提高图像匹配的正确率。2012年中国科学技术大学的刘恒[41]采用大尺度图像检索和三维模型重建技术,提高了位置估计精度。图像中含有丰富的信息,但是受到手机存储量和处理速度的限制,该方法若要广泛应用还需要对存储手段、匹配算法等进行大量的研究。

3.2 基于特征跟踪的定位

基于特征跟踪的定位方法属于相对定位,主要是利用连续图像对消影点和消影线进行提取和跟踪,确定相机的姿态和位置变化,分为视觉陀螺仪和视觉里程计。

3.2.1 视觉陀螺仪

视觉陀螺仪利用定位环境中的正交直线提取出消影点,通过相邻图像消影点变化提取位置变化信息。2007年江泽民等[31]利用走廊踢脚线在图像上投影的斜率和计算得到的消影点坐标进行摄像机内、外参数标定,利用消影点不受空间直线平移影响的特性可以实现自主移动平台的视觉伺服导航。为了提高运行速度和定位精度,2010年Christoph Kessler等[4]在惯性测量单元、磁力计和激光扫描仪的辅助下,获得了基于视觉系统的室内长期稳定姿态估计方法。2011年至2015年芬兰大地测量所的学者[42-44]对视觉陀螺仪进行大量研究,利用图像中的线要素计算消影点,并评估不同的摄像头和设置参数对视觉陀螺仪精度的影响,得出影响精度的3个重要要素为:图像质量、运动速率和导航过程中相机姿态。目前,视觉陀螺仪存在的问题[46]:①导航过程中光照条件较差,使得图像太暗;②在转角处没有延伸的线,无法提取消影点;③有些场景提取要素点的成功率低。

3.2.2 视觉里程计

视觉里程计利用连续图像之间的单应性恢复深度、距离信息[19]。目前,国内外关于视觉里程计的研究还比较少,最初介绍到视觉里程计概念的是芬兰大地测量所的 Laura Ruotsalainen[44],2013 年又提出由于视觉里程计不能准确确定距离,所以在室内可以使用如激光测距仪等特殊装置,在室外可以使用GNSS载波相位差来辅助计算。同年,中国科学院上海微系统与信息技术研究所无线传感网与通信重点实验室的夏凌楠等[47]将视觉里程计用于机器人自主定位。根据已有研究成果可以发现视觉里程计还存在很多挑战[46]:①用于计算的点必须在相机附近;②室内环境缺乏可用于计算的要素;③消影点计算错误对结果造成影响。

4 图像与其他定位方法融合的定位系统

4.1 图像/INS信息融合

智能终端的惯性导航系统主要利用加速度传感器、陀螺仪来得到加速度和角速度,图像与惯导系统融合分为两种情况,一是将图像定位得到的绝对位置信息作为惯导系统相对定位的位置校正,二是将两者获得相对位置信息融合。2003年Masakatsu Kourogi[38]提出利用卡尔曼滤波融合惯性传感器估计的相对位置与图像定位得到的绝对位置,实验证明该方法可以提高精度。随着研究成果不断更新,图像与自包含传感器的融合不仅仅用于定位,2015年上海交通大学的邹丹平[49]提出了视觉即时定位与地图构建方法(StructSLAM),使用建筑结构线进行定位和地图构建。从目前来看,除了基于图像定位自身存在的局限以外,其与惯性导航系统的融合方法还有待进一步提升。

4.2 图像/GNSS信息融合

图像与全球卫星导航系统信息融合主要用于室外卫星信号遮蔽区域,2009年出现了一些商业系统,如诺基亚的Pointand Find服务,利用手机摄像头记录的移动数据和GPS定位数据,配以先进的实时图像识别和处理技术对用户需要进行分析。David M.Chen[40]提出用GPS定位信息来辅助融合两种方式表达的街道级图像(中心投影图像和正视图像),利用图像的互补信息,可以显著提高图像匹配的正确率和图像对比度低的情况下图像部分特征检测能力。2012年中国科学技术大学的LiuHeng[41]提出了利用当前图像准确地感知地理场景信息,并融合GPS定位,然后与模型关联,进一步显示到真实地图上,实现高精度的室外定位。目前,对图像与全球卫星导航系统单独融合的研究还比较少。

4.3 图像/INS/GNSS信息融合

图像、INS和GNSS三者信息融合可以用于室内外无缝定位,该方法的研究起步较晚,主要由芬兰大地测量所的学者展开。2011年Laura Ruotsalainen[50]提出利用卡尔曼滤波算法将消影点信息与GNSS、蓝牙、WLAN和INS数据进行融合,实验表明加入图像信息后定位精度提高了1.2 m。同年,Heidi Kuusniemi[51]讨论了不同贝叶斯框架下采用不同系统模型融合多传感器、多网络解决行人定位问题。2014年Laura Ruotsalainen[52]首次提出将GNSS、消费级INS和图像信息利用卡尔曼滤波进行深组合,实验证明这种组合方式具有更强的抗干扰性。2015年我国首次将视觉定位用于行人导航,中国科学院的公续平等[45]提出面向手持智能终端的视觉陀螺仪/PDR/GNSS组合导航方法,实验证明视觉辅助PDR定位能够修正GNSS单独定位方式33%的定位误差。另外,图像、INS和GNSS三者的信息融合也被用于行人状态识别[53]。

5 结论

图像辅助定位作为一个新的研究领域,正在引起国内外的广泛关注。美国、芬兰等国家已经对智能终端的独立图像定位系统和与其他定位方法融合的定位系统进行了大量研究,我国在该领域的研究在近几年也逐步开展起来。目前,基于图像定位的理论及关键技术等正在逐步完善,图像辅助的定位系统正在尝试多方面的研究。综合以上分析,得出图像辅助智能终端定位的发展仍存在以下问题:①虽然已经进行了大量的研究,但是基于表征信息的定位方法仍然会受到智能终端存储量和传输率等性能的影响,数据库的建立模式和表征信息的匹配算法有待进一步提高;基于特征跟踪的定位中消影点提取直接影响定位精度,现有的方法仍然会受到光照条件、当前视野位置和场景内容影响。②在图像与其他定位方法融合的定位方面,融合算法局限于卡尔曼滤波和扩展卡尔曼滤波,并且应用的领域受到限制,要实现该方法的突破,需考虑更多的融合算法,可以通过利用机器学习算法将该方法应用到行人状态识别。

图像辅助定位可以提供丰富信息,并且智能终端的广泛应用,使得图像获取方便。另外,图像辅助定位能够与其他定位系统优势互补,实现室内外无缝定位。随着各个领域在各种环境下对位置信息的迫切需求,图像辅助定位作为一种新的定位手段,其研究和应用具有非常重要的现实意义和广阔的发展空间。

[1]徐宁.单目摄像头实时视觉定位[D].上海:上海交通大学,2008.

[2]KANG H W,EFROS A A,HEBERT M,et al.Image matching in large scale indoor environment[J].Computer Vision&Pattern Recognition Workshops cvpr Workshops ieee Computer Society,2009:33-40.

[3]马颂德,张正友.计算机视觉-计算理论与算法基础[M].北京:科学出版社,1998.

[4]KESSLER C,ASCHER C,FRIETSCH N, et al.Vision-based attitude estimation for indoor navigation using vanishing points and lines[C]//Position Location and Navigation Symposium(PLANS),2010 IEEE/ION,2010.

[5]RUOTSALAINEN L.Vision-aided pedestrian navigation for challenging GNSS environments[J].Suomen Geodeettisen Laitoksen Julkaisuja-Publications of the Finnish Geodetic Institute,151.2013.

[6]HARTLEY B R,ZISSERMAN A.Multiple view geometry in computervision[M].Cambridge:Cambridge University Press,2004.

[7]CAPRILE B,TORRE V.Using vanishing points for camera calibration [J].International Journal of Computer Vision,1990,4(2):127-39.

[8]BARNARD S T.Interpreting perspective images[J].Artificial Intelligence,1983,21(4):435-62.

[9]CAMBRIDGE M.A new approach for vanishing point detection in architectural environments[C]//British Machine Vision Conference,2000.

[10]BENABDELKADER C,YACOOB Y.Statistical estimation of human anthropometry from a single uncalibrated image[J].Computational Forensics,2008:200-220.

[11]FISCHLER MA,BOLLES R C.Random sample consensus:a paradigm for model fitting with applications to image analysis and automated cartography[J].Communications of the ACM,1981,24(6):381-395.

[12]CANNY J.A computational approach to edge detection[J].IEEE Transactions on,1986(6):679-698.

[13]唐路路,张启灿,胡松.一种自适应阈值的Canny边缘检测算法[J].光电工程,2011,38(5):127-132.

[14]许宏科,秦严严,陈会茹.一种基于改进Canny的边缘检测算法[J].红外技术,2014,36(3):210-214.

[15]KIRYATI N,ELDAR Y,BRUCKSTEIN A M.A probabilistic hough transform [J].Pattern recognition,1991,24(4):303-316.

[16]MATAS J,GALAMBOS C,KITTLER J.Robust detection of lines using the progressive probabilistic hough transform[J].Computer Vision and Image Understanding,2000,78(1):119-137.

[17]王竞雪,朱庆,王伟玺,等.结合边缘编组的Hough变换直线提取[J].遥感学报,2014,18(2):378-389.

[18]HARRIS C,STEPHENS M.A combined corner and edge detector[C]//AlveyVisionConference,1988.

[19]MIKOLAJCZYK K,SCHMID C.Indexing based on scale invariant interest points[C]//IEEE Computer Vision,2001 ICCV 2001 Proceedings Eighth IEEE International Conference on,2001.

[20]MIKOLAJCZYK K,SCHMID C.Scale&affine invariant interest point detectors [J].International Journal ofComputer Vision,2004,60(1):63-86.

[21]程邦胜,唐孝威.Harris尺度不变性关键点检测子的研究[J].浙江大学学报(工学版),2009,42(5):855-859.

[22]周龙萍.基于改进的Harris算法检测角点[J].计算机技术与发展,2013,23(2):11-14.

[23]张从鹏,魏学光.基于Harris角点的矩形检测[J].光学精密工程,2014,22(8):2259-2266.

[24]LOWE D G.Object recognition from local scale-invariant features[C]//Computer Vision,the Proceedings of the Seventh IEEE International Conference on,1999.

[25]LOWE D G.Distinctive image features from scale-invariant keypoints[J].International Journal of Computer Vision,2004,60(2):91-110.

[26]许佳佳,张叶,张赫.基于改进Harris-SIFT算子的快速图像配准算法[J].电子测量与仪器学报,2015,29(1):48-54.

[27]陈志雄.基于图像匹配的SIFT算法研究与实现[D].武汉:武汉理工大学,2008.

[28]颜雪军,赵春霞,袁夏.2DPCA-SIFT:一种有效的局部特征描述方法[J].自动化学报,2014,40(4):675-682.

[29]董萍.基于重复区域的图像仿射不变特征分析及其应用[D].北京:北方工业大学,2014.

[30]JOHANSSON B,CIPOLLA R.A system for automatic pose-estimation from a single image in a city scene[C]//Signal Pattern Recognition and Applications,2002.

[31]江泽民,杨毅,付梦印,等.基于平行线的室内视觉导航[J].机器人,2007,29(2):128-139.

[32]赵漫丹,郝向阳,张振杰.一种基于层级分类策略的复杂模式识别方法[J].计算机应用研究,2016,33(8):18-24.

[33]STRELOW D,SINGH S,STRELOW D.Draft submission–please do not redistribute motion estimation from image and inertial measurements [J].International Journal of Robotics Research,2015,24(5):463-482.

[34]AOKIH,SCHIELE B,PENTLAND A.Realtime personal positioning system for a wearable computers[C]//Digest of Papers Third InternationalSymposium on Wearable Computers;San Francisco,CA,USA,1999:37-43.

[35]CHANDRASEKHAR V,TAKACS G,CHEN D,et al.CHoG:compressed histogram of gradients a low bit-rate feature descriptor[C]//IEEE Conference on Computer Vision&Pattern Recognition,2009.

[36]TORRES S J,CHAU T.Wearable indoor pedestrian dead reckoning system [J].Pervasive&Mobile Computing,2010,6(3):351-361.

[37]JI R,DUAN L Y,CHEN J,et al.Location discriminative vocabulary coding for mobile landmark search [J].International Journal of Computer Vision,2012,96(3):290-314.

[38]KOUROGI M,KURATA T.Personal positioning based on walking locomotion analysis with self-contained sensors and a wearable camera[C]//Ieee/acm International Symposium on Mixed and Augmented Reality,2003.

[39]ROBERTSON D,CIPOLLA R.An image-based system for urban navigation[J].Bmvc,2004:819-828.

[40]CHEN D M,BAATZ G,KOSER K,et al.City-scale landmark identification on mobile devices [C]//IEEE ConferenceonComputerVision&PatternRecognition,2011.

[41]LIU H,MEI T,LUO J,et al.Finding perfect rendezvous on the go:accurate mobile visuallocalization and its applications to routing[C]//Proceedings of the 20th ACM International Conference on Multimedia,2012.

[42]RUOTSALAINEN L,KUUSNIEMI H,CHEN R Z,et al.Heading change detection for indoor navigation with a Smartphone camera[C]//Indoor Positioning and Indoor Navigation(IPIN),2011.

[43]RUOTSALAINEN L,BANCROFT J,LACHAPELLE G,et al.Effect of camera characteristics on the accuracy of a visual gyroscope for indoor pedestrian navigation[C]//Ubiquitous Positioning,Indoor Navigation,and Location Based Service(UPINLBS),2012.

[44]RUOTSALAINEN L,BANCROFT J,LACHAPELLE G,et al.Enhanced pedestrian attitude estimation using vision aiding[J].Journal of Location Based Services,2013,7(3):209-222.

[45]公续平,魏东岩,李祥红,等.一种面向智能终端的视觉陀螺仪/PDR/GNSS组合导航方法[C]//中国卫星导航学术年会,2015.

[46]RUOTSALAINEN L.Visual gyroscope and odometer for pedestrian idoor navigation with a smartphone[C]//Proc ION GNSS,2012.

[47]夏凌楠,张波,王营冠,等.基于惯性传感器和视觉里程计的机器人定位 [J].仪器仪表学报,2013,34(1):166-172.

[48]STEINHOFF U,OMERCEVIC D,PERKO R,et al.How computer vision can help in outdoor positioning[C]//European Conference on Ambient Intelligence,2007.

[49]ZHOU H,ZOU D,PEI L,et al.StructSLAM:Visual SLAM with building structure lines[J].IEEE Transactions on Vehicular Technology,2015,64(4):1364-1375.

[50]RUOTSALAINEN L,KUUSNIEMI H,CHEN R Z.Visual-aided two-dimensional pedestrian indoor navigation with a smartphone[J].Sensors,2011,10(1):11-18.

[51]KUUSNIEMI H,CHEN Y W,PEI L,et al.Evaluation of bayesian approaches for multi-sensor multi-network seamless positioning[C]//Ion Gnss,2011.

[52]RUOTSALAINEN L,KIRKKO J M,BHUIYAN MZH,et al.Deeply coupled GNSS,INS and visual sensor integration for interference mitigation [C]//Institute of Navigation Gnss,2014.

[53]GUINNESS R E.Beyond where to how:a machine learning approach for sensing mobility contexts using smartphone sensors[J].Sensors,2015,15(5):9962-9985.

Image-Aided Positioning:A Review of Theories and Empirical Applications on Smartphones

WANG Yuan1,TONG Qing-xi1,CHEN Xiu-wan1,LIU Mao-lin1,HUANG Zhao-qiang2

(1.Institute of Remote Sensing and GIS,Peking University,Beijing 100871,China 2.Institute of Mineral Resources Research,China Metallurgical Geology Bureau,Beijing 100123,China)

TP391

A

10.3969/j.issn.1002-0640.2017.09.001

1002-0640(2017)09-0001-06

2016-07-11

2016-08-09

国家自然科学基金资助项目(41272366)

王 媛(1992- ),女,河北承德人,博士研究生。研究方向:导航技术及应用。