基于离散Tchebichef变换的多聚焦图像融合方法

2017-10-14姜彦君李伟生王国胤

肖 斌 姜彦君 李伟生 王国胤

基于离散Tchebichef变换的多聚焦图像融合方法

肖 斌*姜彦君 李伟生 王国胤

(重庆邮电大学计算智能重庆市重点实验室 重庆 400065)

基于变换技术的图像融合是多聚焦图像融合中常采用的方法,其过程是将图像转换到变换域按照一定的融合规则进行融合后再反变换回来,具有较强的抗噪能力,融合效果明显。该文提出一种基于离散Tchebichef正交多项式变换的多聚焦图像融合方法,首次将离散正交多项式变换应用到多聚焦图像融合领域。该方法成功地利用了图像的空间频率与其离散Tchebichef正交多项式变换系数之间的关系,通过离散正交多项式变换系数直接得到空间频率值,避免了将离散多项式变换系数变换到空域计算的过程。所提方法节省了融合时间,并提高了融合效果。

多聚焦图像融合;离散正交多项式变换;空间频率

1 引言

多聚焦图像融合是图像融合的主要研究领域之一,是针对同一场景下聚焦情况不同的多幅图像融合成一幅对场景中所有景物都聚焦的图像的过程,其目的是通过融合不同聚焦区域的方法增加景深。自适应图像深度的融合方法[1]是通过多聚焦图像自适应图像的深度,并校准图像清晰度指标进行融合。因此多聚焦图像融合在很多不同的领域扮演着重要的角色,如:生物医学成像[2]和无线传感网络[3]等。

根据多聚焦图像融合技术融合图像阶段的不同,将多聚焦图像融合分成3个层次:像素级图像融合、特征级图像融合和决策级图像融合[4]。像素级图像融合[4]是最基础的信息融合技术,也是当前研究和实际应用中广泛采用的图像融合方法。它的思路是:预处理原始图像,然后直接对各个传感器获取的信号进行分析处理。特征级图像融合[4]是属于中间层次的信息融合。它的思路是:预处理原始图像并进行特征提取,然后对获得的特征信息(如:边缘、角、纹理、相似亮度或景深区域等)作进一步的分析处理。决策级图像融合[4]属于最高层次的信息融合。它的思路是:先对各个原始图像分别进行预处理、特征提取和特征分类,对同一目标建立初步的决策,然后根据相应的融合规则对从各个传感器获得的决策进行融合,从而获得最终的联合决策。

这3个层次的图像融合方法彼此相互独立,又有密切的关联。像素级图像融合由于是最基础的融合方法,直接对各个传感器获取的信号进行分析,融合规则相对简单,得到了广泛的应用。像素级的图像融合又可以细分为基于空间域的融合算法和基于变换域[5]的融合算法以及新型的基于耦合神经网络的融合算法。基于空间域的算法比较早,融合过程简单。该类算法一般只需要在图像的像素空间上进行处理,不需要变换和逆变换,但是融合效果一般,经典算法如:密集尺度不变特征变换法(DSIFT)[6]和脉冲耦合神经网络法(PCNN)[7]。图像变换作为图像处理技术领域的一项重要基础理论,是图像视频处理中的研究热点,因此被广泛应用到图像处理中的各个领域。基于变换域的图像融合算法近年来发展迅速,其融合效果得到了很大的提升,但是大多数的基于变换域的图像融合方法计算比较复杂,时间复杂度比较高。典型的算法有基于离散余弦变换(DCT)的图像融合方法[8]。其算法原理是将图像由空域转换到变换域中,然后直接对变换域系数进行处理,按照均值最大法、频带对比度最大法等各种规则将图像进行融合,最后对融合后的变换域系数进行逆变换得到融合后的图像。

离散Tchebichef正交多项式变换[9](简称离散Tchebichef变换,DTT)是一种典型的图像变换技术,其变换核函数由不同阶数的离散Tchebichef正交多项式组成。DTT具有很高的去相关性、快速迭代计算、无数值近似、极强的图像重构能力等优点,并且DTT可以整数实现,相比于DCT更有优势,因此被广泛地应用于图像分析与压缩中。空间频率(Spatial Frequency, SF)[10]是一种有效的评价图像质量的方法,被广泛应用到图像融合中,如基于脉冲耦合神经网络的图像融合方法[11]就是将空间频率与脉冲耦合神经网络相结合的方法。本文提出一种基于DTT的多聚焦图像融合算法,利用空间频率与DTT系数之间的关系,直接从DTT系数得到每一个块的空间频率大小。然后根据空间频率最大的规则融合图像。最后,将处理过的图像进行一致性验证,得到最终融合后的图像。DTT是属于图像正交变换,利用部分DTT系数即可逼近计算每一个块的空间频率。因此,相较于传统的多聚焦图像融合方法,该方法将图像的空间频率与DTT系数建立了联系,节省了融合的时间,有效地改善了图像的融合效果。与在空域上直接计算空间频率进行多聚焦图像融合的方法相比具有很好的抗噪能力。

本文将在第2节介绍DTT以及空间频率与DTT系数之间的联系,并阐述本文算法的具体融合过程。第3节通过与经典融合方法的对比实验分析本文方法的实验结果。最后在第4节中做出总结。

2 基于DTT的多聚焦融合算法

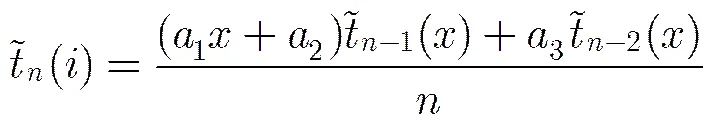

2.1 离散Tchebichef变换(DTT)

逆变换为

(2)

其中,

(4)

式(1)和式(2)所示的DTT正变换和逆变换可用矩阵的形式表示:

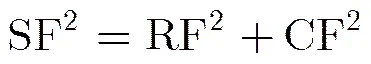

2.2 空间频率(SF)与DTT系数的联系

在多聚焦图像中,聚焦区域有着更多的细节和信息,这些细节清晰的区域通常伴随着更高的方差值。在图像处理的应用中,方差通常被用作计算图像的对比度[12]。但是,计算方差作为图像的对比度更倾向于描述图像的明暗差异程度。虽然,在现有的生物技术中很难完全理解人类视觉系统的工作原理,但是空间频率[10]用作有效的计算对比度的标准可以更好地表示图像细节的清晰程度[13]。

空间频率(SF)定义为行频率(Row Frequency, RF)与列频率(Column Frequency, CF)的平方和:

(7)

根据式(6)中SF的定义,可以得到SF与DTT系数之间的关系如下:

可以得到式(9)关系:

(9)

根据式(9),式(7)中行频率和列频率的定义可重新表示为

(11)

那么空间频率(SF)也可重新表示为

(13)

式(13)导出了图像块的空间频率和DTT系数之间的关系,其中为图像块的DTT系数,为对应的加权系数。

(15)

2.3 基于DTT的多聚焦图像融合算法流程

2.2节给出了空间频率与DTT系数之间的联系,在此基础上,利用空间频率最大的原则,可以直接利用DTT系数进行多聚焦图像融合。图1给出了基于DTT的多聚焦图像融合的框架。为了简单起见,本文仅考虑只有两幅源图像和的图像融合,关于多幅多聚焦图像可以此类似推广。具体融合过程的步骤如下:

(1)首先对需要融合的两幅图像分别进行分块处理,得到个的图像块。在位置处对应的块分别记作和;

(2)通过式(5)分别计算对应块的DTT系数;

(3)利用空间频率与DTT系数之间的推导关系式(13)分别计算对应块的空间频率大小,然后将和对应的空间频率大小分别记作和;

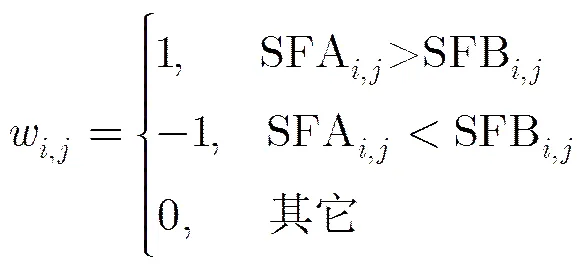

(4)比较计算后的对应图像块的空间频率值,创建一个决策图记录特征比较结果如式(16):

(5)应用一致性验证[14]处理来提高输出图像的质量。一致性验证应用多数筛选法,即如果合成图像中的某个系数来自于图像,而这个系数邻域内的其他系数以来自于图像的居多,则将其修正为来自图像。本文采用的滤波器来获得最终的决策图:

(17)

(6)最终根据决策图进行融合,融合规则如式(18):

3 实验结果和分析

3.1 客观评价指标

为了准确客观地评价融合后的图像质量,本文选取结构相似性(SSIM)、均方根误差(RMSE)、互信息(MI)、信噪比(SNR)等评价指标来验证融合后图像的质量,其中SSIM[15], RMSE[15], SNR[15]为有参考图像的评价指标,MI[15],[16],[16],[16]为无参考图像的评价指标。在这些客观评价参数中,SSIM, MI,,,值越大,代表融合效果越好,RMSE越小,表示融合效果越好。

3.2 实验结果与分析

为了证明本文方法的适用性,实验中将提出的融合方法分别应用于灰度图像和彩色图像,并分别从有理想参考图像和无理想参考图像[17]两种情况去分析融合后图像和对比评价指标,并进行抗噪能力实验对比。为验证本文方法的性能,将本文方法分别与密集尺度不变特征变换法(DSIFT)[6]、脉冲耦合神经网络法(PCNN)[7]、基于离散余弦变换的对比度融合方法(DCT+C+CV)[8]等典型的多聚焦图像融合方法进行实验对比,并与直接在空域上计算空间频率融合的方法进行实验对比验证在抗噪能力上的表现。另外,为验证各种多聚焦图像融合算法的运行效率,本文从运行时间上进行了对比。实验运行环境为CPU: Intel(R) Core(TM) i5-4590 3.30 GHz,内存:8 GB,操作系统:Windows7,软件:MATLAB2014b。每种方法运行20次,最后将运行时间平均值作为该方法的运行时间。

图1 基于DTT的图像融合流程

3.2.1有参考图像的实验分析 在实际应用中,很难产生理想的参考图像,有参考图像的实验分析是为了从理论上分析实验方法的有效性。这里,本文用如下方法构造如下4组实验中理想的参考图像:首先选取清晰的图像作为理想的参考图像,如图2(c),分别将参考图像按不同区域进行一定的乘性模糊处理作为待融合的原始图像图2(a)和图2(b)。

实验1 输入为图像融合领域经典的图像“时钟”,从图2中可以看出,基于DTT的融合方法得到的图像非常逼近于理想图像。为进一步对比各种融合方法的性能,表1给出了实验1的5种融合方法融合效果的质量评价指标。从表1中可以看出,对于图像“时钟”的各种融合方法中,本文提出的基于DTT的DTT+S+CV融合方法在SSIM, RMSE, MI, SNR,5种指标中均达到了最优的结果。这说明本文方法的融合图像最接近理想参考图像的融合效果,融合图像信息更完整,在融合效果以及时间复杂度上体现出明显的优势。

3.2.2无参考图像的实验分析 这部分实验没有理想中的参考图像,原始图像是经照相机分别针对同一场景中不同景物聚焦情况不同得到的原始图像图3(a)和图3(b),这里采用的评价指标是无参考图像的评价指标MI,,,和。

表1基于原始灰度图像“时钟”的5种融合图像的评价指标

SSIMRMSEMISNRT(s) DSIFT1.00000.00094.7065110.065236.31 PCNN0.99970.00324.1969 98.1102 3.20 DCT+C+CV0.99980.00314.2327 98.4339 1.51 DTT+S+CV10.00084.7065110.0652 0.44

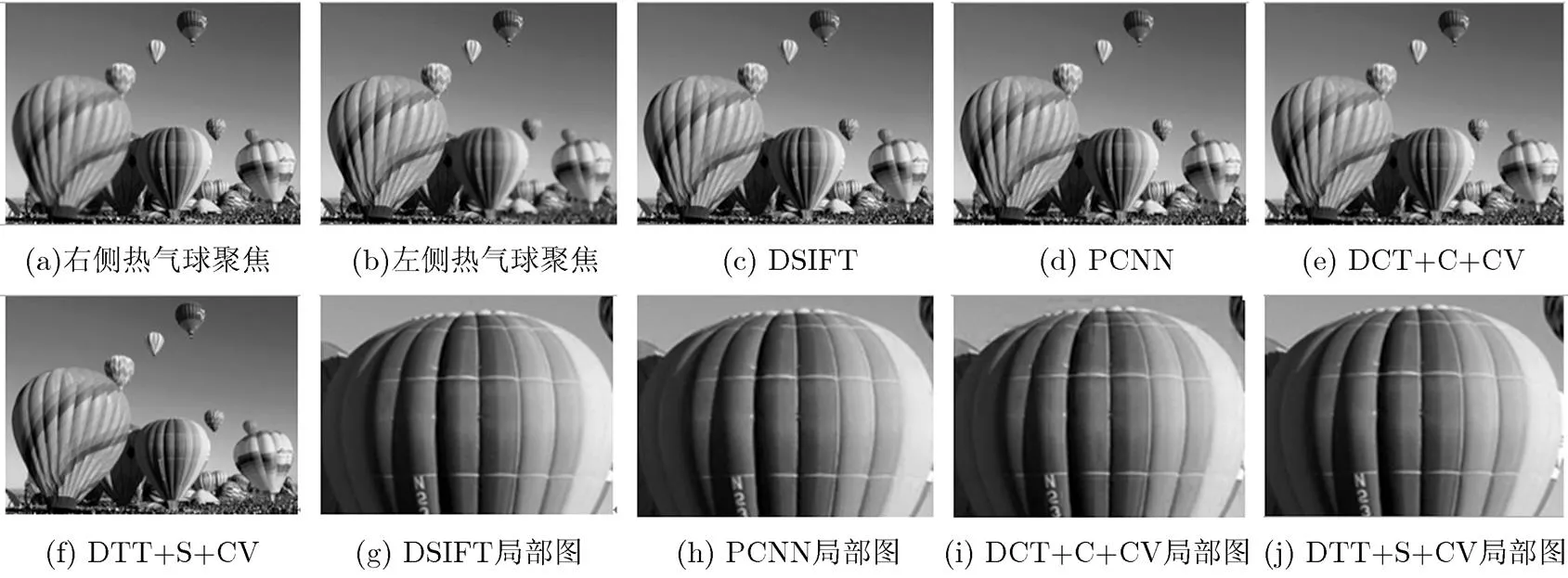

实验2 输入为灰度图像“热气球”,从局部放大图可以看出,DCT+C+CV的融合效果有明显的块效应影响,其他方法从视觉上的效果差别不是很明显。表2给出了实验2的5种融合图像的无参考图像质量评价指标。从表2中可以看出,在MI,,,,5种指标中本文方法均达到了最优的效果,这说明本文方法的融合图像具有更加丰富的信息和显著性特征,说明本文方法的融合效果在整体上具有更大的优势。

实验3 输入为彩色图像“报纸”,如图4所示。从局部放大图像中明显可以看出,本文方法和DSIFT方法的融合效果具有明显的优势,报纸的文字部分都是清晰的,细节部分比较充足,文字清晰可辨。而其他各种融合方法得到的融合效果在视觉效果上都存在不同程度的模糊现象,文字存在不同程度的重叠,融合结果没有达到预期的效果。表3给出了实验3的5种融合图像的无参考图像质量评价指标。从表中可以看出,在MI,,3种指标中本文方法均达到了最优的效果,其他两种指标,取得最佳效果的是拉普拉斯金字塔法。但是,在这3种指标中本文方法效果依旧处于比较靠前的位置,并且在时间复杂度上具有明显优势,这说明本文方法的融合效果在整体上具有更大的优势,融合效果更好。

图2 实验1的融合结果

图3 实验2的融合结果

图4 实验3的融合结果

表2基于原始灰度图像“热气球”的5种融合图像的评价指标

MIT(s) DSIFT3.87630.94280.81530.953128.83 PCNN3.85780.92320.78050.9498 3.21 DCT+C+CV3.30790.93440.77070.9498 1.77 DTT+S+CV3.87650.94290.81540.9532 0.56

3.2.3抗噪能力的实验分析 为了验证本文提出的DTT与SF结合的多聚焦图像方法相较于直接基于空域上SF的多聚焦图像融合方法在抗噪能力上的优势,本实验中将待融合图像感染噪声,然后利用本文方法和直接基于空域上SF的融合方法进行对比。

表3基于原始彩色图像“报纸”的5种融合图像的评价指标

MIT(s) DSIFT2.10080.67900.65720.73452.62 PCNN2.11730.63060.42090.69150.73 DCT+C+CV0.70350.66390.39320.71090.71 DTT+S+CV2.42960.67920.66400.74400.24

表4基于原始彩色图像“花与花盆”的5种融合图像的评价指标

DTT+S+CVSF MI1.29861.2364 0.51350.4301 0.39700.2802 0.82040.7345 T(s)2.54860.4933

4 总结

本文提出了一种基于DTT的多聚焦图像融合方法,首次将DTT应用到多聚焦图像融合领域,并巧妙地利用了空间频率与DTT系数间的关系,直接通过DTT系数得到空间频率的大小,依据空间频率最大的原则进行融合并引入了一致性验证,为多聚焦图像融合的过程节省了时间,并有效提高了融合效果。本文分别通过对灰度图像和彩色图像进行的实验,分别比较无参考图像和有参考图像的实验结果,实验结果表明,本文提出的基于DTT的多聚焦图像融合方法与一些经典算法相比,融合后的图像在互信息、均方根误差、结构相似性、信噪比等方面均取得了更好的效果,同时,在图像的显著性、对比度和边缘信息转换等方面也体现出了优势,尤其在时间复杂度和抗噪能力上优势明显。多组实验充分证明了本文方法的适用性和有效性。

[1] GUO D, YAN J, and QU X. High quality multi-focus image fusion using self-similarity and depth information[J]., 2015, 338: 138-144.

[2] LI T and WANG Y. Biological image fusion using a NSCT based variable-weight method[J]., 2011, 12(2): 85-92.

[3] Thomas C, Ranchin T, Wald L,. Synthesis of Multispectral images to high spatial resolution: A critical review of fusion methods based on remote sensing physics[J].&, 2008, 46(5): 1301-1312.

[4] GARG R, GUPTA P, and KAUR H. Survey on multi-focus image fusion algorithms[C]. IEEE Engineering and Computational Sciences, Chengdu, China, 2014: 1-5.

[5] WEI Chunyu, ZHOU Bingyin, and GUO Wei. Novel fusion rules for transform-domain image fusion methods[C]. International Conference on Mechatronics and Industrial Informatics, Paris, France, 2015: 846-850.doi: 10.2991/ icmii-15.2015.147.

[6] LIU Yu, LIU Shuping, and WANG Zengfu. Multi-focus image fusion with dense SIFT[J]., 2015, 23: 139-155. doi: 10.1016/j.inffus.2014.05.004.

[7] WANG Zhaobin, MA Yide, and GU Jason. Multi-focus image fusion using PCNN[J]., 2010, 43(6): 2003-2016. doi: 10.1016/j.patcog.2010.01.011.

[8] TANG J. A contrast based image fusion technique in the DCT domain[J]., 2004, 14(3): 218-226. doi: 10.1016/j.dsp.2003.06.001.

[9] 陆刚, 肖斌, 王国胤. 基于离散Tchebichef矩和软决策化的图像压缩[J]. 计算机科学, 2016, 43(11): 304-308.

LU Gang, XIAO Bin, and WANG Guoyin. Image compression based on discrete Tchebichef and soft decision[J]., 2016, 43(11): 304-308.

[10] LI Shutao and YANG Bin. Multifocus image fusion using region segmentation and spatial frequency[J].&, 2008, 26(7): 971-979. doi: 10.1016/j.imavis.2007. 10.012.

[11] QU Xiaobo, YAN Jingwen, and XIAO Hongzhi. Image fusion algotithm based on spatial frequency-motivatie pulse coupled neural networks in nonsubsampled contourlet transform domain[J]., 2008, 34(12): 1508-1514.

[12] PHAMILA Y A V and AMUTHA R. Discrete cosine transform based fusion of multi-focus images for visual sensor networks[J]., 2014, 95(2): 161-170. doi:10.1016/j.sigpro.2013.09.001.

[13] LI Shutao, KWOK J T, and WANG Y. Combination of images with diverse focuses using the spatial frequency[J]., 2001, 2(3): 169-176. doi: 10.1016/S1566- 2535(01)00038-0.

[14] 邓艾, 吴谨, 杨莘, 等. 基于二代Curvelet变换和区域匹配度的图像融合算法[J]. 计算机科学, 2012, 39(S1): 513-514.

DENG Ai, WU Jin, YANG Hua,Image fusion based on second generation Curvelet and regional compatibility[J],2012, 39(S1): 513-514

[15] XU Shaofan, LIU Xianfeng, and DI Hongwei. An image fusion quality assessment based on structural similarity[J]., 2007, 28(5): 470-473.

[16] PIELLA G and HEIJMANS H. A new quality metric for image fusion[C]. Proceedings of the IEEE International Conference on Image Processing, Chongqing, China, 2003, 2: III-173-6.

[17] WANG Z and ALAN C Bovik. Reduced- and no-reference image quality assessment[J]., 2011, 28(6): 29-40.

Multi-focus Image Fusion Based on Discrete Tchebichef Transform

XIAO Bin JIANG Yanjun LI Weisheng WANG Guoyin

(,,400065,)

Image fusion based on image transform technologies is always used in multi-focus image fusion. It transforms images into transform domain and fuses the transformed image according to a specific fusion rule. After that, the fused image is achieved by the inverse image transform. The transform based image fusion methods are robust to noise and the fused results are widely accepted. This paper proposes a multi-focus image fusion method based on discrete Tchebichef orthogonal polynomial transform. Discrete orthogonal polynomial transform is firstly introduced to the field of multi-focus image fusion. The proposed method combines the spatial frequency with the discrete orthogonal polynomial transform coefficients of image, and it directly achieves the value of spatial frequency by the discrete orthogonal polynomial transform coefficients of the image and avoids the process of recalculation that transforms the discrete orthogonal polynomial transform coefficients to space domain. The proposed method can reduce the fusing time in multi-focus image fusion and improves the fusion effect.

Multi-focus image fusion; Discrete orthogonal polynomial transform; Spatial frequency

TP391

A

1009-5896(2017)08-1927-07

10.11999/JEIT161217

2016-11-10;

改回日期:2017-03-01;

2017-05-02

肖斌 xiaobin@cqupt.edu.cn

国家自然科学基金(61572092),国家自然科学基金-广东联合基金(U1401252)

The National Natural Science Foundation of China (61572092), The National Natural Science Foundation of China-The Mutual fund of Guangdong Province (U1401252)

肖 斌: 男,1982年生,副教授,研究方向为图像处理、模式识别和数字水印.

姜彦君: 男,1990年生,硕士,研究方向为多聚焦图像融合与图像增强.

李伟生: 男,1975年生,教授,研究方向为智能信息处理与模式识别.

王国胤: 男,1970年生,教授,研究方向为粗糙集、粒计算、数据挖掘、机器学习、神经网络、认知计算、模式识别等.