一种混合特征高效融合的视网膜血管分割方法

2017-10-14蔡轶珩高旭蓉邱长炎崔益泽

蔡轶珩 高旭蓉 邱长炎 崔益泽

一种混合特征高效融合的视网膜血管分割方法

蔡轶珩*高旭蓉 邱长炎 崔益泽

(北京工业大学信息学部 北京 100124)

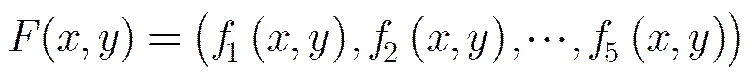

将机器学习运用到视网膜血管分割当中已成为一种趋势,然而选取什么特征作为血管与非血管的特征仍为众所思考的问题。该文利用将血管像素与非血管像素看作二分类的原理,提出一种混合的5D特征作为血管像素与非血管像素的表达,从而能够简单快速地将视网膜血管从背景中分割开来。其中5D特征向量包括CLAHE (Contrast Limited Adaptive Histgram Equalization),高斯匹配滤波,Hesse矩阵变换,形态学底帽变换,B-COSFIRE(Bar-selective Combination Of Shifted FIlter REsponses),通过将融合特征输入SVM(支持向量机)分类器训练得到所需的模型。通过在DRIVE和STARE数据库进行实验分析,利用Se, Sp, Acc, Ppv, Npv, F1-measure等常规评价指标来检测分割效果,其中平均准确率分别达到0.9573和0.9575,结果显示该融合方法比单独使用B-COSFIRE或者其他目前所提出的融合特征方法更准确有效。

机器学习;视网膜;血管分割;特征向量;支持向量机

1 引言

青光眼和白内障、糖尿病等疾病都会造成视网膜眼底血管的病变,如果不能对视网膜病变患者及时治疗,常会导致长期患有这些疾病的患者承受巨大痛苦甚至失明。因此定期做眼底检查很重要,然而目前视网膜病是由专科医生来人工诊断,首先对患者的眼底图像进行手工血管标记,然后再测量所需的血管口径、分叉角度等参数。其中手工标记血管的过程大概需要两个小时左右,因此,自动化提取血管对节约人力物力尤为重要,在减轻专科医生负担的同时更有效解决了偏远地区缺乏专科医生的问题。鉴于视网膜血管分割[1]的重要性,国内外学者做了许多研究,分为非监督和监督两类方法。

非监督方法是通过某种规则来提取血管目标,主要包括:匹配滤波[2]、形态学处理[3]、血管追踪以及基于模型的算法等,更多内容可以参阅文献[4]。

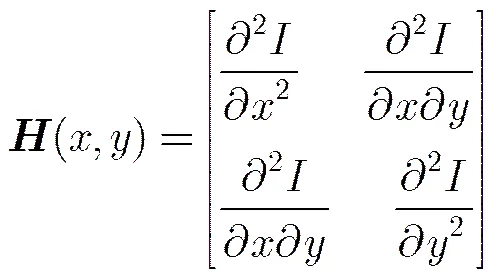

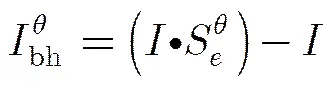

监督方法则是通过对像素分类从而获得血管分割结果。主要分为两个过程:特征提取和分类。特征提取阶段通常包括Gabor滤波[5],高斯匹配滤波,Hesse矩阵变换[6]等方法,并将其作为判断血管与非血管的特性[7]输入到分类器当中进行分类。分类阶段常用的分类器有SVM[8], RF(随机森林)等分类器[9]。Azzopardi等人[10]提出用B-COSFIRE滤波器来进行血管分割,该方法通过采用DoG滤波器模拟感受野的生物特性。且能够结合血管结构使用对称与非对称B-COSFIRE对连续血管和血管末端完成特征提取。Strisciuglio等人[11]在此基础上,通过改变构成多尺度的特征向量,再用GMLVQ进行特征向量的选择,用SVM分类器对像素点进行分类。但是,单独使用B-COSFIRE滤波使得特征提取变得更有局限性,还有很大的提升空间。Aslani等人[12]在2016年提出了17-D的特征向量,其中包括CLAHE(1-D), Hesse变换(1-D),形态学高帽变换(1-D), Gabor变换(13-D), B-COSFIRE(1-D),用随机森林进行分类。虽然它将B-COSFIRE和其他特征进行融合使用,达到了较好的效果,但高维特征向量添加了计算的复杂度。针对于此,本文提出了一种改进方法,将复杂的Gabor特征向量去掉,加入高斯匹配滤波,且将高帽变换换作底帽变换,形成每个像素的5-D特征向量,通过SVM分类器,将每个像素点分类为血管或者非血管,再经过后处理将分割错误或者没有分割的孤立噪声点去掉,从而形成简单有效的视网膜血管分割方法。

2 数据源和本文方法

2.1数据源

本文实验所用的视网膜图像数据均来自于DRIVE和STARE两个数据库,且将数据库中第一位专家手动分割的血管网络结构作为标准结果。

DRIVE(Digital Retinal Images for Vessel Extraction)眼底图像数据库中有40幅彩色眼底图像,大小为584×565, 20幅测试图,20幅训练图,其中7幅为病变图像;STARE(STructured Analysis of the REtina)眼底图像数据库包含20幅彩色视网膜图像,大小为700×605,其中10幅为病变图像,但每幅图像没有相对应的掩膜,本文通过ImageJ工具得到掩膜以方便找到感兴趣区域。

2.2方法

如图1所示,本文通过预处理来增强血管对比度,并将其作为像素的1维特征。其次,分别对预处理之后的图像进行特征提取,分别将其作为像素点的特征向量,将感兴趣区域的像素进行随机选取一定数量作为训练样本,归一化,并将专家分割的像素结果作为分类标签,进行分类器的训练形成训练模型。将测试图像的特征向量进行归一化,输入分类器判断其每个像素的分类结果,通过后处理去除孤立噪声点,并将分割图像呈现出来。

2.2.1预处理 各类研究表明,绿色通道的对比度明显比其他通道强,由此选取绿色通道。由于采集到的视网膜眼底图像的亮度往往不均匀,所以对绿色通道图进行CLAHE处理。CLAHE即受限对比度自适应直方图均衡化能够将图像分成块,分别在每个块内进行灰度直方图的裁剪限幅,从而均衡眼底图像的亮度,使其更适合后续血管提取。

2.2.2特征提取

(1)高斯匹配滤波: 经过分析视网膜血管横截面信息,高斯匹配滤波函数可以模拟视网膜血管的灰度分布,利用高斯匹配滤波函数的形状和走向来逼近视网膜图像血管。

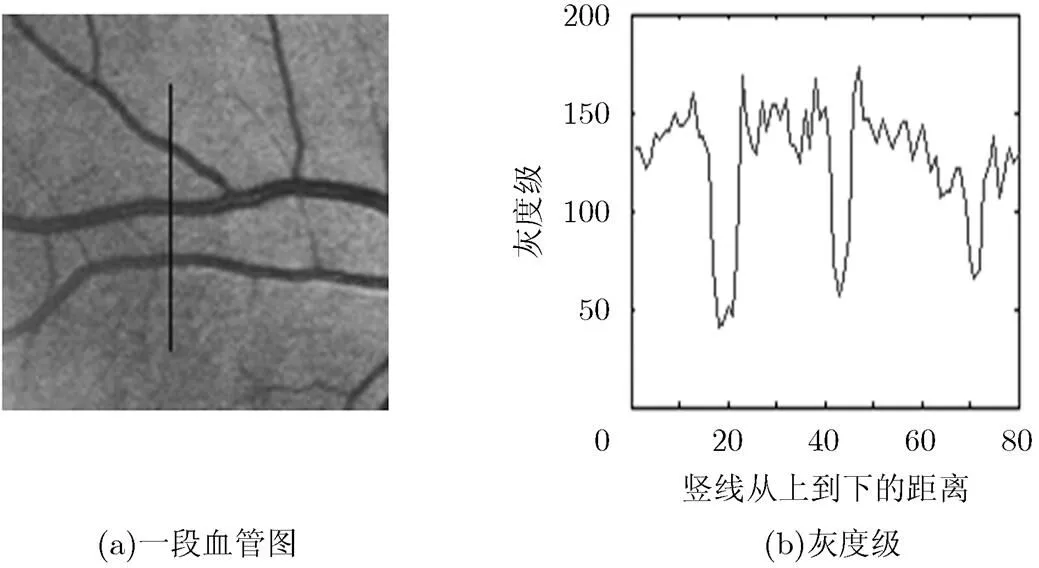

图2(a)为一段血管图,图2(b)为竖线相应的灰度级图。可以看到3个比较大的血管灰度级明显呈高斯状走向,很多肉眼无法观察到的细小血管也呈高斯状走向,因此,通过高斯匹配滤波来实现粗细血管的增强。由于血管的方向是任意的,因此,本文采用12个不同方向的高斯核模板来对视网膜图像进行匹配滤波,找到相应的最大响应作为该像素的响应值。2维高斯匹配滤波核函数为

式中,表示高斯曲线的方差,L表示y轴被截断的视网膜血管长度,滤波窗口的宽度选择。另外,理论上L越大,能够使视网膜图像平滑效果更优,同时还能够降低视网膜图像噪声,但是L的加大会引起眼底血管宽度变大,与实际宽度不同,降低准确度。进行多次实验,选定参数使得匹配滤波核为一个77的矩阵从而达最佳的视网膜血管匹配效果。

图2 血管的横截面灰度图

(3)

(3)形态学底帽变换: 文献[12]中用到的是形态学高帽变换,然而形态学高帽变换常用作提取在暗背景下的亮目标,底帽变换则相反,对于视网膜图像来说,血管与其背景相比较暗,所以,选择底帽变换来提取所需血管。本文使用线形结构元素,底帽变换可以表示为

(5)

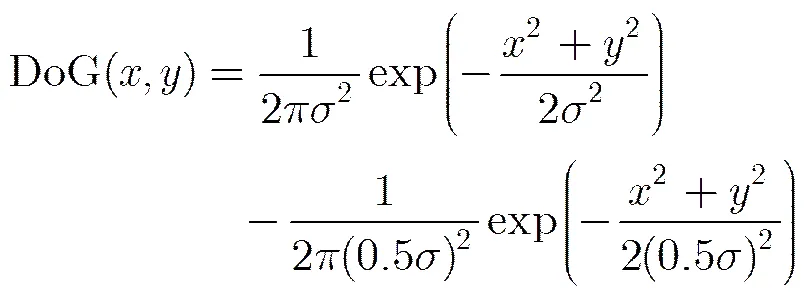

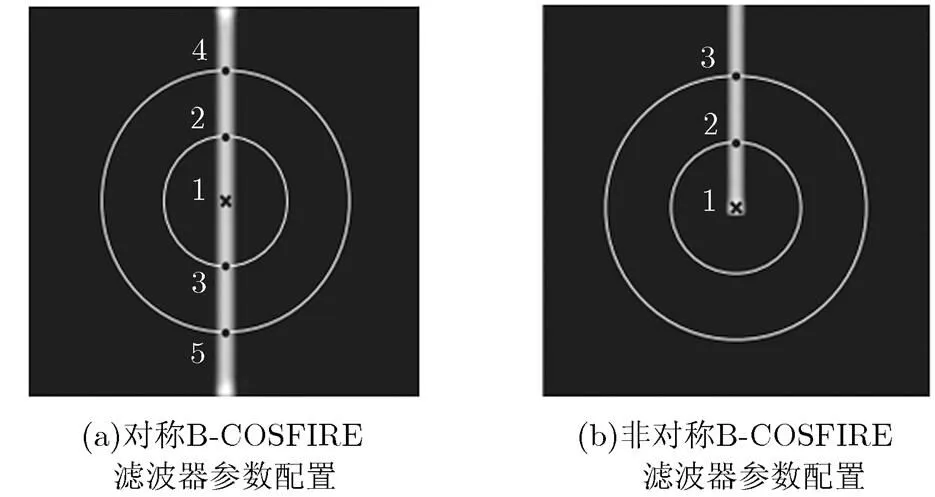

(4)B-COSFIRE: DoG模型最早用在模拟猫的视网膜神经节细胞的同心圆拮抗空间特性,根据复杂细胞感受野的生理模型和DoG的数学模型,文献[10]提出B-COSFIRE滤波模型是由一组LGN细胞计算模型的几何平均值,从而模拟了复杂细胞感受野的工作机制,其原理如图3所示,这种模型对于检测血管之类的带状结构有着很好的效果。

图3中虚线是B-COSFIRE的作用区域,黑点处的B-COSFIRE响应通过计算一组DoG滤波响应的乘积加权几何平均得到。DoG滤波器如式(6):

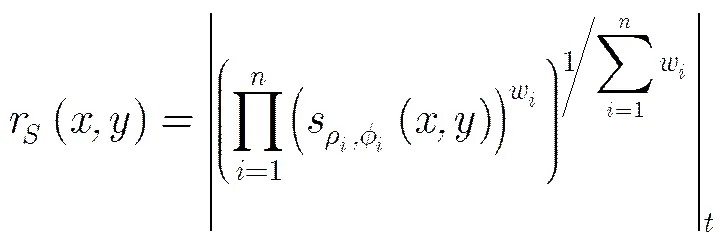

图4(a)中的5个黑点表示DoG响应最大的位置,构成了一组DoG滤波响应记为,图4(b)中的3个黑点同样。由于B-COSFIRE滤波器的中心点的输出需要利用中点的DoG滤波响应,为了提高各个点位置的容错性,对DoG滤波响应进行模糊移位操作,需计算每个位置极坐标邻域的DoG滤波器的最大加权阈值响应。权重通过DoG滤波响应与高斯函数的系数的乘积得到,,,为常数,为与中心滤波器之间的距离。模糊移位的DoG滤波响应为

其中, , B-COSFIRE滤波响应是由一组集合的模糊移位DoG滤波响应的乘积加权几何平均计算得到。如式(8)所示:

图4 B-COSFIRE参数配置

其中,

由于血管方向是任意的,经旋转滤波器12个方向来选取最大值。本文将对称和非对称B-COSFIRE滤波响应进行相加得到最后的特征图。B-COSFIRE滤波一直应用在视网膜图像处理的参数均同文献[12],也为了与文献[12]更好地比较,本文参数选取也同文献[12]。

本文中的5-D特征图如图5所示。将每个像素点用一个5维特征向量进行表示为

由于各个特征向量变换范围不一,需要将其特征训练集归一化到。

2.2.3分类过程 训练:DRIVE数据库:对每一幅训练图分别取1500个血管像素点和非血管像素点(总共60000个正反样本),选取的样本数是文献[12]的1/5,归一化后,作为训练样本,血管标签为1,非血管标签为0。STARE数据库没有进行训练集和测试集分类,需要自己将其进行分类。本文将每幅图像中取少量像素点作为训练样本,整幅图像作为测试样本,与DRIVE一样对每幅图分别选择1500个正反样本。通过libsvm工具箱进行SVM训练,所用的核函数是RBF核函数,由于样本数较多,寻优实现比较费时,本文C使用常用默认值1,选择0.01,训练得到很好的模型。

测试:对于测试集图像中的像素点同样提取特征向量,进行归一化,输入SVM模型当中,从而得到血管分割二值图。

2.2.4后处理 输出图像中有一些孤立的噪声点,被错误的当作血管,通过去除面积小于25像素的块去除这些噪声点。

3 实验结果与分析

3.1评估方法

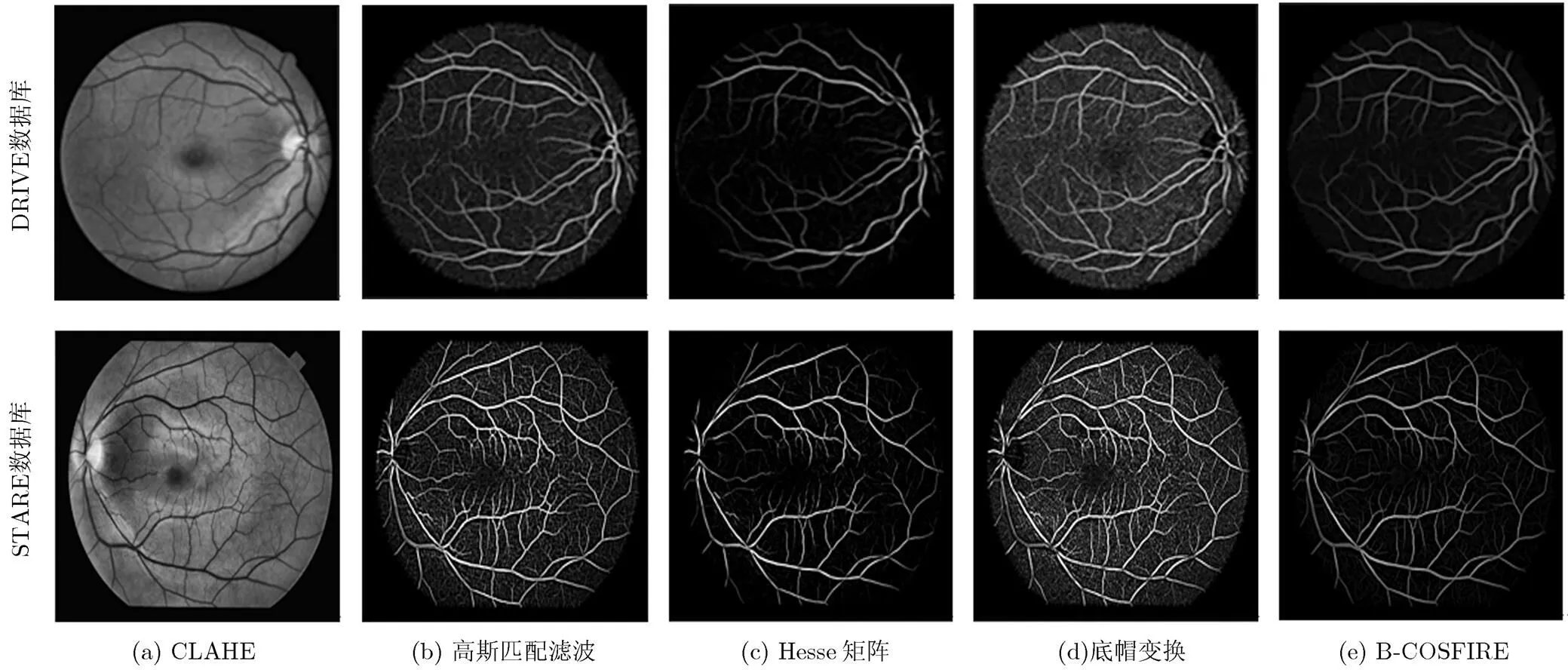

为了评价算法的分割性能,将本文方法的视网膜血管分割结果与专家手动分割结果进行比较,从而讨论视网膜图像像素点的分类效果。各种分类结果如表1。

图5 各个特征图

表1血管分类情况

血管非血管 识别为血管识别为非血管TP(真阳性)FN(假阴性)FP(假阳性)TN(真阴性)

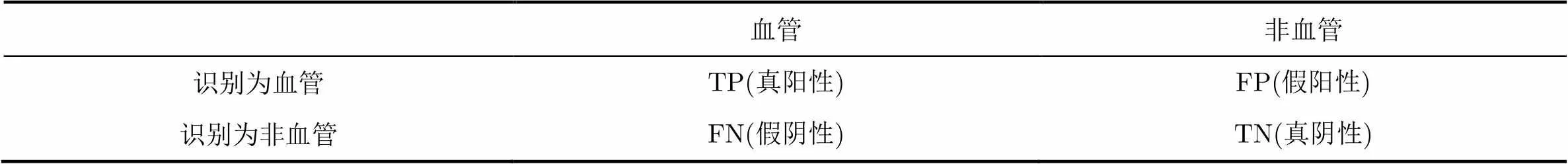

如表 1所示,对于血管像素,若算法分割结果与专家手动分割结果一致,则为真阳性,否则为假阳性;对于非血管(背景)像素,若算法分割结果与专家手动分割结果一致,则为真阴性,否则,为假阴性。为了评估本文提出的算法,并与其他方法进行比较,分别计算Se(敏感性),Sp(特异性),Acc(准确率),但由于在视网膜图像中非血管像素所占比例很大,即使没有分割出血管,Acc依然可以达到90%以上,所以本文也通过其他评估参数如Ppv(精确率),Npv, F1-measure, AUC(ROC曲线下的面积)等来进行评估。各评估参数如表 2所示。

3.2实验结果与对比

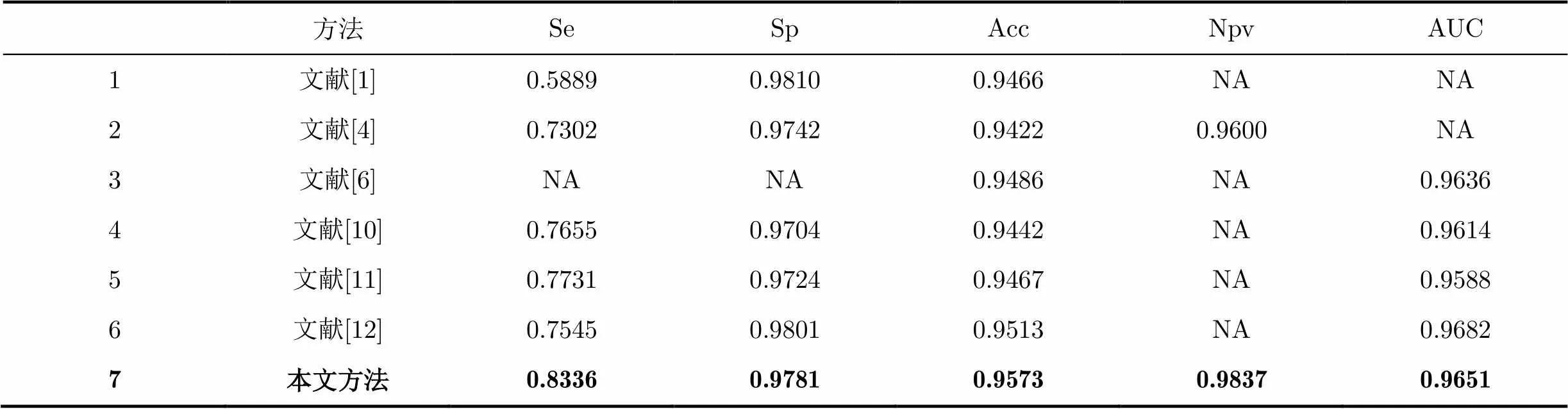

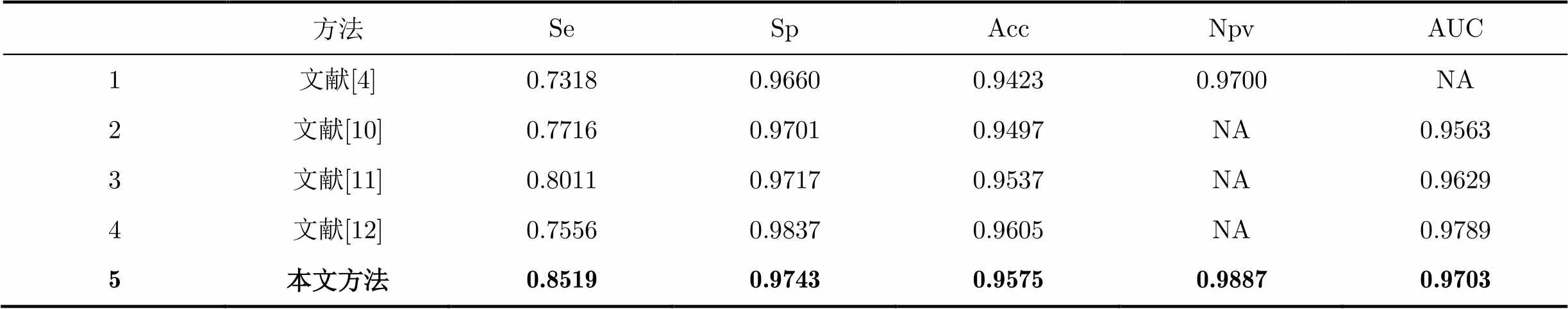

两个数据库均选择第1位专家的手动分割结果作为评价标准,每个数据库中总结评估结果如表3和表4。

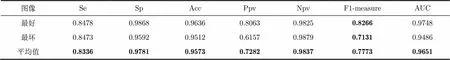

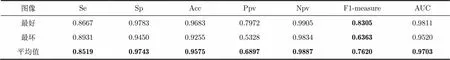

在DRIVE数据库中,Se, Sp, Acc, AUC的平均值分别达到0.8336, 0.9781, 0.9573, 0.9651, F1-measure最好可达到0.8266,此时Acc达到0.9636, F1-measure最小为0.7131,此时,Acc为0.9512;在STARE数据库中,Se, Sp, Acc, AUC的平均值分别达到0.8519, 0.9743, 0.9575, 0.9703, F1-measure最好可达到0.8305,此时Acc为0.9683,F1-measure最小为0.6363,此时Acc为0.9255,本文将最好与最坏的分割结果展示如图6。

表2分割效果评估

评估项公式 Se(TPR)TP/(TP+FN) SpTN/(TN+FP) Acc(TP+TN)/(TP+FP+TN+FN) PpvTP/(TP+FP) NpvTN/(TN+FN) F1-measure(2×Ppv×TPR)/(Ppv+TPR)

最坏情况下血管大部分被分割出来,但是由于病变的出现,导致有的部分出现了片状的区域,换言之,若出现这种情况,并非就一定是一件坏事,当医生发现这张视网膜血管图存在异象时,从而专注分析它的具体病变情况,同样给医生为病人的检查节省了大量的时间,提高了效率。

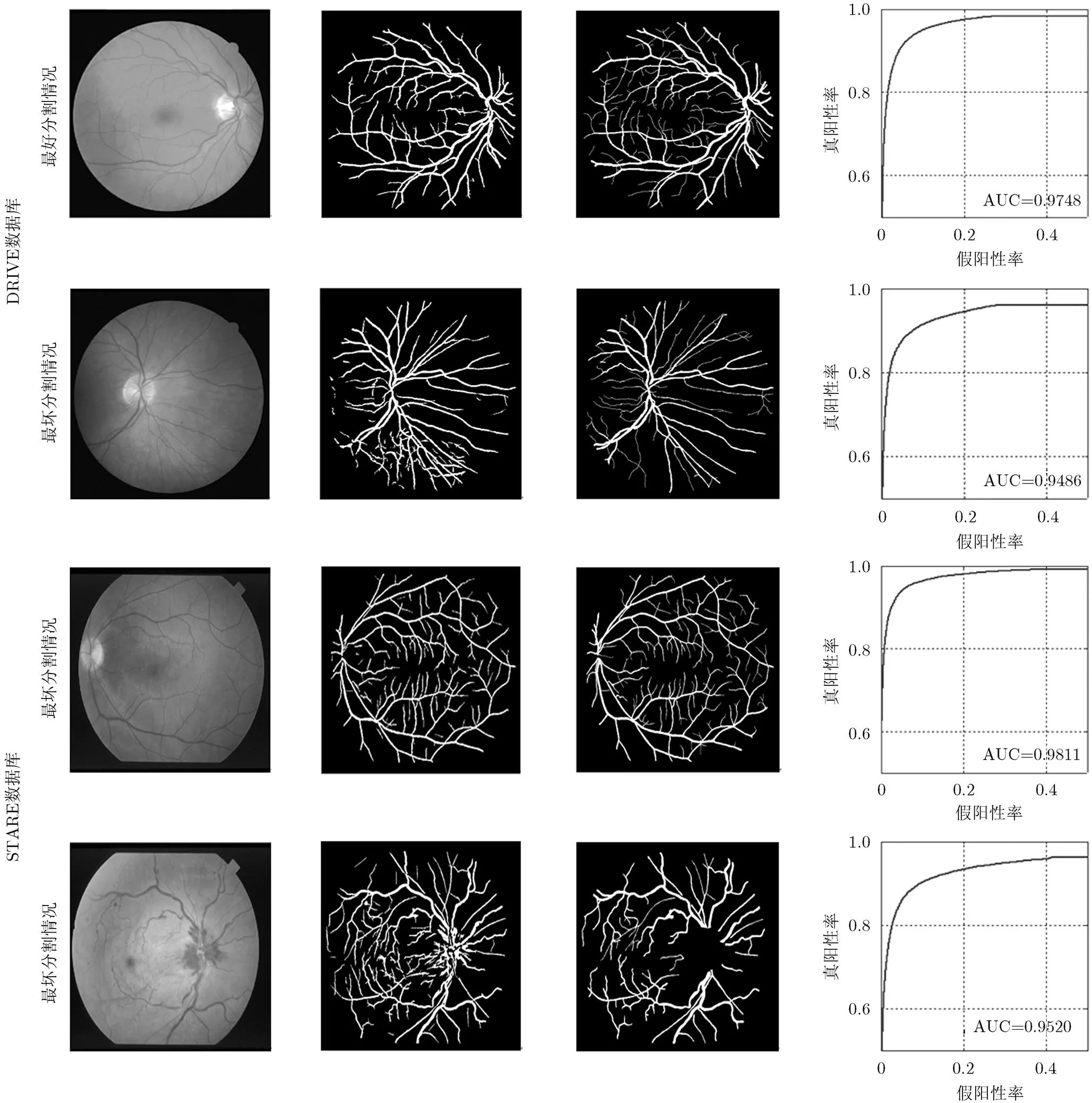

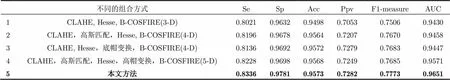

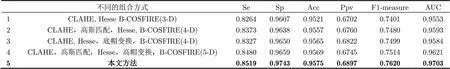

本文在文献[12]的基础上,添加了高斯匹配滤波来更好模拟血管的走向,以及将其高帽变换换做底帽变换使得血管能够从背景中很好地显现出来,为了分析各个特征的影响程度,如表5,表6所示:在CLAHE, Hesse, B-COSFIRE这3维特征向量,分别添加高斯匹配滤波和底帽变换,则Se, Sp, Acc等评估参数都明显增大。在第2种组合的基础上,若添加了高帽变换,所得到的分割结果比第2种组合有所提升,将其高帽变换换做底帽变换,也就是本文方法,则各方面的评估参数都有了明显的提升,证明了高斯匹配滤波的有效性,同时证实了与文献[12]相比,底帽变换比高帽变换能够更好地反映视网膜血管的特性。也正是各个特征向量的相互补充,使得本文方法取得很好的分割效果。

其次,将本文方法与现有的方法进行比较如表7和表8。从中看出与中外近期文献相比,本文中Se,Npv的值明显高于其他方法,在表7的DRIVE数据库实验当中,本文方法在准确率上高于所有其他方法,在表8的STARE数据库实验当中,本文方法在准确率上高于除文献[12]以外的其他方法,虽然其准确率略低于文献[12],但是,本文在文献[12]基础上去除了Gabor滤波使得特征向量从17-D降低到5-D特征向量,从而将计算复杂度降低,另外,所取的样本远远少于文献[12],训练时间大大降低,却能达到基本不相上下的测试准确率。

表3 DRIVE测试集分割结果

表 4 STARE测试集分割结果

图 6 DRIVE和STARE中的最好与最坏分割情况

表 5 DRIVE数据库

表6 STARE数据库

表7 DRIVE数据库

表8 STARE数据库

实验中所使用计算机的 CPU 为 Intel Core i5-2520M处理器,核心频率为 2.5 GHz, 4GB RAM,软件平台为 MATLAB R2014a,就DRIVE数据库而言,文献[5]处理一副图像所用时间达到2 min以上,文献[10]用时15.5 s左右,文献[11]用时53 s左右,文献[12]处理一副图像需要220 s左右,而本文方法仅需要90 s左右,相比文献[12]而言,降低用时的同时且能达到很好的准确率。

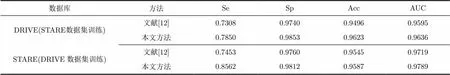

为了进一步检验本文方法的有效性,本文做了交叉训练,即在DRIVE数据库训练得到的模型测试集用STARE,反之在STARE数据库训练得到的分割模型用DRIVE数据库的测试集来检验,交叉训练结果如表9所示。本文方法的Se, Sp, Acc, AUC等均优于文献[12]。综合而言,本文在选取较少样本的情况下,选择较少的特征向量,将视网膜血管很好地分割出来,进一步证明在复杂度和分割效果上都优于文献[12]。

4 结束语

本文在其他文献的基础上提出了一种基于混合特征高效融合的视网膜血管自动分割方法,对视网膜图像中血管与非血管构建5D特征向量,包括CLAHE、高斯匹配滤波、Hesse矩阵变换、形态学变换、B-COSFIRE滤波变换,该方法选取较少的样本经过SVM分类器训练,形成用于分类血管像素与非血管像素的一种简单有效的模型。与当前其他的监督算法相比,本文方法简单且分割准确率高,分割速度快,对于视网膜病变的筛查及早期诊断具有重要意义。虽然本文方法得到很好的分割效果,但在接下来的进展中,需将传统方法与现有的深度学习等特征提取方法相结合进一步提升分割效果。

表9交叉训练结果

数据库方法SeSpAccAUC DRIVE(STARE数据集训练)文献[12]0.73080.97400.94960.9595 本文方法0.78500.98530.96230.9636 STARE(DRIVE数据集训练)文献[12]0.74530.97600.95450.9719 本文方法0.85620.98120.95870.9789

[1] 扬琴, 赵景秀. 基于主成分分析的血管分割算法[J]. 电子技术设计与应用, 2016, 3: 66-70.

YANG Qin and ZHAO Jingxiu. Blood vessel segmentation algorithm based on principal components analysis[J].&, 2016, 45(3): 66-70.

[2] SINGH N P and SRIVASTAVA R. Retinal blood vessels segmentation by using Gumbel probability distributiaon function based matched filter[J]., 2016, 129(C): 40-50. doi: 10.1016/j.cmpb.2016.03. 001.

[3] FRAZ M M, BASIT A, and BARMAN S A. Application of morphological bit planes in retinal blood vessel extration[J].. 2013, 26(2): 274-286. doi: 10.1007/s10278-012- 9513-3.

[4] FRAZ M M, REMAGNINO P, HOPPE A,. Blood vessel segmentation methodologies in retinalimages-A survey[J]., 2012, 108(1): 407-433. doi: 10.1016/j.cmpb.2012.03009.

[5] 吴奎, 蔡冬梅, 贾鹏, 等. 基于2D Gabor小波与组合线检测算子的视网膜血管分割[J]. 科学技术与工程, 2016, 16(12): 106-112.

WU Kui, CAI Dongmei, JIA Peng,. Retinal vessel segmentation based on 2D Gabor wavelet and combined line operators[J]., 2016, 16(12): 106-112.

[6] 于辉, 王小鹏. 基于HESSIAN增强和形态学尺度空间的视网膜血管分割[J]. 计算机应用与软件, 2016, 33(8): 200-205.

YU Hui and WANG Xiaopeng. Retinal vessels segmentation based on Hessian enhancement and morphological scale space[J]., 2016, 33(8): 200-205.

[7] WAHEED Z, AKRAM M U, WAHEED A,. Person identification using vascular and non-vascular retinal feature[J]., 2016, 53: 359-371. doi: 10.1016/j.compeleceng.2016.03.010.

[8] RICCI E and PERFETTI R. Retinal blood vessel segmentation using line operators and support vector classification[J]., 2007, 26(10): 1357-1365. doi: 10.1109/TMI.2007.8985551.

[9] FRAZ M M, REMAGNINO P, HOPPE A,. An ensemble classification-based approach applied to retinal blood vessel segmentation[J]., 2012, 59(9): 2538-2548. doi: 10.1109/TBME. 2012.2205687.

[10] AZZOPARDI G, STRISCIUGLIO N, VENTO M,. Trainable COSFIRE filters for vessel delineation with application to retinal images[J]., 2015, 19(1): 46-57. doi: 10.1016/j.media.2014.08.002.

[11] STRISCIUGLIO N, AZZOPARDI G, VENTO M,. Supervised vessel delineation in retinal fundus images with the automatic selection of B-COSFIRE filters[J]., 2016, 27(8): 1137-1149. doi: 10.1007 //s00138-016-0781-7.

[12] ASLANI S and SARNEL H. A new supervised retinal vessel segmentation method based on robust hybrid feature[J]., 2016, 30: 1-12. doi: 10.1016/j.bspc.2016.05006.

Retinal Vessel Segmentation Method with Efficient Hybrid Features Fusion

CAI Yiheng GAO Xurong QIU Changyan CUI Yize

(,,100124,)

How to apply machine learning to retinal vessel segmentation effectively has become a trend, however, choosing what kind of features for the blood vessels is still a problem. In this paper, the blood vessels of pixels are regarded as a theory of binary classification, and a hybrid 5D features for each pixel is put forward to extract retinal blood vessels from the background simplely and quickly. The 5D eigenvector includes Contrast Limited Adaptive Histgram Equalization (CLAHE), Gaussian matched filter, Hessian matrix transform, morphological bottom hat transform and Bar-selective Combination Of Shifted Filter Responses (B-COSFIRE). Then the fusion features are input into the Support Vector Machine (SVM) classifier to train a model that is needed. The proposed method is evaluated on two publicly available datasets of DRIVE and STARE, respectively. Se, Sp, Acc, Ppv, Npv, F1-measure are used to test the proposed method, and average classification accuracies are 0.9573 and 0.9575 on the DRIVE and STARE datasets, respectively. Performance results show that the fusion method also outperform the state-of-the-art method including B-COSFIRE and other currently proposed fusion features method.

Machine learning; Retina; Vessel segmentation; Feature vetor; Support Vector Machine (SVM)

TP391

A

1009-5896(2017)08-1956-08

10.11999/JEIT161290

2016-11-28;

改回日期:2017-04-14;

2017-05-11

蔡轶珩 caiyiheng@bjut.edu.cn

国家自然科学基金(61201360)

The National Natural Science Foundation of China (61201360)

蔡轶珩: 女,1974年生,博士,副教授,主要研究方向为医学图像处理.

高旭蓉: 女,1992年生,硕士,主要研究方向为图像处理.

邱长炎: 男,1991年生,硕士,主要研究方向为图像处理.

崔益泽: 男,1993年生,硕士,主要研究方向为图像处理.