视频序列超分辨率重构技术综述

2017-10-13樊桂花

吴 洋,樊桂花

视频序列超分辨率重构技术综述

吴 洋1,樊桂花2

(1. 装备学院研究生院,北京 101416;2. 装备学院光电装备系,北京 101416)

视频序列超分辨率重构技术可以利用来自一个或多个低分辨率视频序列信息重构一个具有高空间分辨率或高时空分辨率的视频序列。本文从视频序列的空间超分辨率、时间超分辨率以及时空超分辨率重构三个方面对视频序列超分辨率重构技术进行了详细的阐述,对视频序列超分辨率重构技术中的关键问题和应用前景进行了分析与展望。

视频序列;超分辨率重构;空间超分辨率;时间超分辨率;时空超分辨率

0 引言

在诸如医学成像,天文学,监视和遥感等许多应用中都需要捕获高质量的图像和视频,然而视频采集设备具有有限的空间和时间分辨率。空间分辨率由相机中的检测器的空间密度和它们的引起的模糊来确定,造成了视频序列的空间分辨率降低。时间分辨率由采集设备帧速率和曝光时间确定,这些因素限制了可以在视频序列中观察到的动态事件的最大速度。当高速速移动物体产生的轨迹特征高于相机的帧速率(即时间采样率)时,会产生运动混叠现象,当视频采集设备的曝光时间过长会产生运动模糊现象。超分辨率重构技术是一种通过数字图像处理技术提高视频时间和空间分辨率的方法。通过融合由于混叠、模糊和噪声等因素导致的一个或多个低分辨率(LR)序列,复原成像过程过程中损失掉的高频信息,重构出具有高空间分辨率和高时间分辨率的HR视频序列。超分辨率重构技术的优点主要体现在以下三个方面:一是通过软件实现,节约成本,代价较低;二是可以处理已经存储的数据,这是硬件改进方法无法实现的;三是具有更好的去除噪声的效果,尤其是对大气湍流、图像偏移、光学模糊、采样失真和其他误差的处理上,有更好的适应性和针对性。

1 视频序列超分辨率重构技术

20世纪60年代Harris和Goodman利用频谱外推恢复单帧图像中超出光学系统传递函数(MTF)而丢失的极限频率外的图像信息,首次提出了超分辨率重构这一概念。本节从视频序列空间超分辨率 重构、时间超分辨率重构和时空超分辨率重构三个部分对视频序列超分辨率重构技术进行论述。

1.1 视频序列空间超分辨率重构

视频序列空间超分辨率重建的基本思想是结合滑动窗口模型[1],基于视频序列中的连续帧的相似度和一些先验信息来获得高空间分辨率。国内外研究人员对此进行了广泛的研究,提出了大量的视频序列重建方法,这些方法主要可以归纳为基于插值、基于重构和基于学习的超分辨率重构方法。

1.1.1 基于插值的超分辨率重构

非均匀图像插值法(Non-uniform interpolation)计算复杂度低,易于理解,但适应性较差,相关的研究相对其他算法比较少,但非均匀图像插值法的基本思想与其他方法有所不同,因此将其单独列为一类。非均匀图像插值法现阶段的研究集中在提高重构结果的视觉效果和算法的稳定性上.文献[2]采用B样条(B-spline)基进行线性滤波。文献[3]利用加权中值滤波来提高重构算法的稳定行。另外,由于非均匀图像插值方法的运算速度较快,使其具有很好的实用价值,例如Lin等[4]将非均匀图像插值法应用于车辆车牌图像的识别。

1.1.2 基于重建的超分辨率重构

基于重构的超分辨率重构方法的基本思想是通过对视频序列的获取过程进行建模,用正则化方法构造高分辨率视频序列的先验约束条件,由低分辨率视频序列估计出高分辨率视频序列,最终将视频序列超分辨率重构问题转变为对在一个先验约束条件下的代价函数求最优化的问题。基于重构的超分辨率重构方法可以分为频域法和空域法两大类。

频域法是超分辨率重构中一类重要方法,其主要思想是利用Fourier变换在频域消除频谱混叠来恢复图像截止频率以外的高频信息,最后利用Fourier逆变换转换回空域,得到高分辨率图像。频域法具有简单直观,容易理解的特点,其主要包括解混叠重构方法[5]、递归最小二乘法[6]和基于多通道采样定理[7]等方法。Nguyen等[8]提出基于小波变换(Wavelet transform)的超分辨率重构。文献[9]对基于小波变换的超分辨率重构理论进行了系统研究,以全局运动的投影变换模型作为运动模型,获得了比较好的效果。但是频域法存在不能推广到一般非平移的帧间运动模型和在重构过程中难以包含先验约束信息的缺点。

与频域法相比,空域法能够建立包括复杂运动,运动模糊,非理性采样等因素在内的全面的视频序 列降质模型,例如基于Markov随机场(MRF)理论的降质模型和其他非线性模型等,并且可以具有融合各种图像先验约束,具有更高的灵活性,表现出较好的重构性能。空域法主要包括凸集投影法(POCS)、迭代反投影法(IBP)、贝叶斯分析法(最大后验概率方法(MAP)和最大似然估计方法(ML))、混合方法等。

1. 凸集投影法(POCS)

Ozkan[10]首次提出基于POCS的空间变换图像复原方法,该方法的新颖性来自使用一组去卷积约束(每个像素一个),允许在每个像素处使用不同的模糊点扩散函数。Stark[11]首次将POCS算法应用到图像的超分辨率重构中。

POCS方法[12]的基本思想是将目标高分辨率图像的各种约束条件分别定义为在高分辨率图像空间的闭凸集C(=1,…,)而这些闭凸集C的交C同样是一个凸集,若交集C不是空集,则凸集中的所有元素都满足约束条件,也就是目标高分辨率图像的一个可行解。对于初始点0,设p表示将高分辨率图像空间中的任一点投影到闭凸集C上的投影算子,则POCS法的迭代过程可以表示为:

Tekalp等[13]考虑传感器模糊和观测噪声的存在将频域方法和基于凸集投影的方法(POCS)进行了扩展。Eren[14]采用有效性图或分割图,利用凸集投影法(POCS)对多重运动目标进行高分辨率图像重构。Patti等[15]运用高阶插值方法描述连续图像模型,通过修改限制集有效地抑制邻近边缘的振铃现象。

凸集投影法(POCS)的优点在于算法的基本思想比较简单,能构比较容易的加入先验信息,但是凸集投影法计算复杂度高,收敛速率慢,而且目标解不唯一。

2. 贝叶斯分析法

贝叶斯分析法主要包括最大后验概率方法(MAP)和最大似然估计方法(ML),其中最大后验概率方法是被广泛应用的一种方法。最大后验概率方法的基本思想是利用条件概率,将已知的低分辨率序列作为先验约束条件,对未知的高分辨率序列进行估计。最大后验概率方法可以表示为:

可以适应性的在正则化项中加入约束条件。常用的正则项约束有Tikhonov正则项[16]、全变分(Totalvariation,TV)正则项[17]以及双边全变分(Bilat- eral TV,BTV)正则项[18],还有较为复杂的Student-t正则项[19]等。

最大后验概率法的优点在于其具有较好的灵活行,可以适用于各种成像模型(线性和非线性的成像模型),有唯一解,算法灵活性高,缺点在于计算复杂度大。

3. 混合法

混合MAP/ML/POCS法结合了两种方法的优点,通过最小化最大后验概率(MAP)或者最大似然估计(ML)代价函数,并将解约束在特定集合中来求高分辨率图像的估计值就是最大后验概率/最大似然估计/凸集投影(MAP/POCS)混合方法。Schultz和Stevenson[20,21]最早将MAP与POCS相结合,在最大后验概率法的迭代优化中加入先验约束对图像像素值的范围进行约束,在很大程度上提高了重构结果的质量。后来Elad和Feuer[22][23]提出了一种最大似然估计/凸集投影(ML/POCS)超分辨率方法。混合方法结合了MAP和POCS各自的优点,充分利用了先验知识并且收敛的稳定性也比较好,与POCS方法相比能保证只有一个最优解。

此外,Irani[24]在已知图像序列中的相对位移的条件下,提出了迭代反投影超分辨率重构算法,文献[25,[26]中将迭代反投影法(IBP)扩展到更一般的模型,文献[27]结合滑动窗口模型提出新的视频分段重建模型,利用低分辨率视频序列相邻五帧的互补信息来重建出一帧高分辨率图像,最后利用迭代反投影法(IBP)重构出一个高空间分辨率的单视频序列。Elad[28]在最小均方(LMS)和递归最小二乘法(RLS)的基础上,提出了基于自适应滤波理论的图像序列超分辨率重构算法。

总的来说,基于重构的超分辨率重构方法发展比较成熟,主要针对视频序列空间分辨率的提高和复原,在一些较理想情况下取得了不错的效果。但还需要进一步改进,以达到减小运算量,加快运算收敛速度,扩大应用范围的目的。

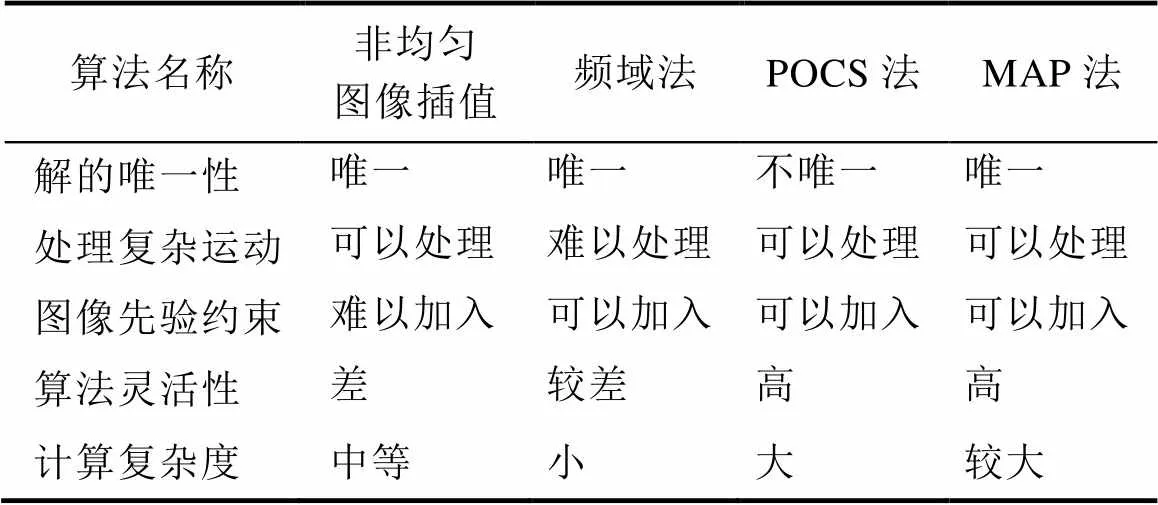

表1中,总结了基于重建的超分辨率重构各类算法的特点。

表1 基于插值和基于重建的超分辨率各类算法比较表

Tab.1 Comparison of various based on interpolation and reconstruction-based on super-resolution

1.1.3 基于学习的超分辨率重构

近年来一些研究者针对超分辨率重构问题突破原有的研究思路,提出了基于学习的超分辨率重构方法,基于学习的方法又称为图像幻感或基于例子的超分辨率。Baker和Kanade[30]针对图像先验模型提供的先验信息有限以及对于足够大的放大倍数会导致过高平滑的结果首次提出了一种基于识别的超分辨率重构算法。

算法模型的建立和训练集合的选取是基于学习的超分辨率算法相关的核心问题。早期的研究者主要着重解决算法模型建立的相关研究,Freeman 等[31,32]提出利用马尔可夫网络建模高分辨率和低分辨率补丁之间的关系以及相邻的高分辨率补丁之间的关系。Wang等[33]对马尔可夫网络模型进行了扩展,提出的概率框架联合了全局参数模型和学习的本地非参数模型。除Markov网络模型以外,QIU[34]针对单最近邻法进行放大的图像出现“块状”,以及通过线性和立方插值放大的图像出现“模糊”的问题,使用传统插值方法构建差分图像金字塔,在此基础上提出一种利用矢量量化器训练样本的方法,该方法的优点是可以与任何现有的方法结合使用,以提高其性能,是一种很有潜力的基于示例学习的超分辨率复原算法。

随着这几年稀疏表示相关理论的发展,基于稀疏表示的超分辨率重构算法得到了广泛应用。2008年,Yang[35]等首次提出训练样本集以稀疏线性表达输入的低分辨率块,此后Adler等[36]在基于学习的超分辨率重构中引入稀疏在线收缩函数来提高目标图像的分辨率。

基于学习的超分辨率重构方法起步较晚,但目前看来,该方法能够弥补基于插值和基于重构的超分辨率重构方法的很多不足,结合计算机技术和 智能技术的发展,能在超分辨率重构领域发挥巨大优势。

1.2 视频序列时间超分辨率重构

在视频序列的空间超分辨率重构过程中,往往都将运动模糊作为空间模糊处理,没有考虑视频序列动态场景中有限的时间分辨率,导致无法很好的消除运动模糊。因此研究者们提出采用视频插帧技术提高视频序列的时间分辨率,文献[37]提出一种基于插值的帧速率上变换的运动对准自回归(MAAR)模型来提高视频序列的时间分辨率,文献[38]提出一种自适应相关性的时间插值的方法。视频插帧技术原理简单,易于实现,但是没有考虑视频序列中运动物体的运动信息,为了弥补这个缺点,文献[39]将运动信息加入到帧率提升过程,采用双向估计得到更精确的运动矢量,利用前向和后向运动估计来估计运动矢量,提出基于时空运动矢量平滑的视频序列时间插值算法。Yoo等[40]提出利用运动矢量平滑的视频序列插帧方式。然而,通过使用基于运动补偿的时间序列插值来提高视频序列的时间分辨率有局限性,使用帧间运动补偿来提高视频序列的时间序列插值,只能提高低分辨率视频序列的帧速率。不能消除快速运动引起的运动模糊和运动混叠,并且由于不准确的运动估计也可能生成移动物体的错误轨迹。文献[41]利用视频序列本身具有的局部自相似性先验信息作为先验信息模型,提出基于最大后验概率(MAP)的单视频序列时间超分辨率重构算法,该算法显著提高了视频序列的帧率,有效的解决了因为快速运动引起的运动模糊和运动混叠现象。但因为最大后验概率估计运算复杂,计算量大的缺点,该方法的时间代价较大。文献[42]创造性的对来自同一场景的多个低分辨率视频序列进行超分辨率重构,重构出具有更高时间分辨率的视频序列,同时在本文中讨论了输入视频个数对时间超分辨率结果的影响,给出了能够解决运动模糊和运动混叠现象的输入视频个数最小公式。文献[43]指出在视频序列实际重构过程中,时间分辨率重构倍数不仅与输入视频的个数有关,还和输入视频序列在时间重构上能提供的冗余有关。通过对视频采集设备曝光时间的分析,提出了多视频序列时间重构倍数的计算方法。文献[44]在此基础上,针对文献[42]需要大量低分辨率视频输入的弊端,采用基于MRF-MAP的超分辨率重构方法对多视频序列时间分辨率进行重构,突破了Shechtman等人所提方法的时间重构倍数。

1.3 视频序列时空超分辨率重构

随着视频超分辨率重构技术的发展以及人们对视频质量要求的不断提高,许多的研究者开始利用超分辨率重构技术同时提高视频序列的空间分辨率和时间分辨率,提出了视频序列时空超分辨率的概念。现阶段国内外对视频序列时空超分辨率重构算法的研究主要可以归纳为两类:一类方法是时间超分辨率重构的基础上进行空间超分辨率重构,得到具有高时空分辨率的视频。例如文献[45]在Shectman等人的基础上,提出利用文献[42]的方法首先重构出一个具有高时间分辨率的临时视频序列,而后利用改进的迭代反投影法(IBP)对该临时高时间分辨率序列进行空间超分辨率,从而获得一个具有高时空分辨率的视频序列。但是这一类方法对视频序列本身的时空连续行没有很好的利用。另一类方法是将时间和空间作为一个整体,在一个总体框架下对视频序列进行时空联合重构,得到具有高时空分辨率的视频序列。文献[46]在Glasner等[47]人提出的基于例子的图像超分辨率重构的基础上,利用单个“自然视频”的小时空块在多个时空尺度的同一视频序列内重复出现多次的特点,提出以子帧精度组合来自多个时空补丁的信息来获得时空超分辨率视频的单视频序列时空超分辨率重构方法。文献[48]提出一种通过使用3D泰勒展开来对局部强度变化进行参数化建模的单视频序列空间和时间分辨率增强的方法,但是该方法容易导致局部强度的平滑升高,对运动混叠现象不能很好的消除。单视频序列时空超分辨率重构能够在一定程度上解决因快速运动引起的运动模糊和运动混叠现象,然而,由于单个视频序列中的相邻帧之间的冗余信息是有限的,超分辨率重建中的空间和时间超分辨率的重构倍数受到限制,在多视频超分辨率重建中,先验信息的丰富性和视频序列之间良好的时空联合特征有利于获得更好的重建效果并获得更高的超分辨率重建倍数。

Shechtman等[42]通过融合相同的动态场景的多个低分辨率序列组合重构超分辨率视频序列,提出了一种同时在时间和空间上进行超分辨率重构的算法,在多视频序列时空超分辨率重构领域做了一个开创性的工作。Uma等[44]针对多视频序列超分辨率重构过程中时间和空间重构倍数有效权衡的问题,提出一种采用基于MRF-MAP重构的方法,并利用图切割的近似优化进行重构,在同一框架内对视频序列时间和空间分辨率进行重构。Daniel Hazen等[49]针对多视频监控问题,提出了一种基于压缩视频的多视频序列超分辨率重构方法。

1.4 其他相关研究

与超分辨率重构问题相关的一个重要问题是序列图像帧间配准,文献[50]探讨了光流法的准确度对输入低分辨率视频序列的超分辨率重构算法效果的影响。文献[51]针对SIFT 算法运行速度较慢、时间效率不高的问题提出了一种与Harris 角点检测算法相结合的快速图像匹配算法。文献[52]分析了基于特征匹配的配准流程中特征的定位准确与否直接影响到配准算法的有效性。文献[53]提出了基于改进的 SIFT和 RANSAC的图像配准算法。该方法采用 SIFT算子进行特征点提取和特征描述,利用改进的RANSAC阈值参数设置算法去除误匹配点,进一步提高了配准算法的精度。

2 视频序列超分辨率重构技术关键问题

2.1 视频序列退化模型的建立

视频序列的超分辨率重构依赖于准确、符合成像系统特性和成像条件的退化模型。现阶段通常采用的简单线性退化模型进行近似,但是视频采集过程中成像系统会受到许多因素的影响,例如传感器噪声、物体与采集设备之间的相对移动以及大气扰动、运动(包括物体的运动或视频采集设备的运动)、散焦和噪声等因素,这些都会导致视频序列质量的降低,因此对采集到的低分辨率视频序列的退化函数和噪声进行准确的估计,建立符合实际退化情况的视频序列退化模型,是需要进一步研究的关键问题。

2.2 视频序列帧间配准

视频帧间配准是进行视频序列空间超分辨率重构的基础,配准的精度将直接影响超分辨率重构质量。对视频序列空间超分辨率进行重构前,需要对视频序列进行视频帧间配准。目前,视频序列重构过程中使用的配准方法存在一些误差,影响了重构视频的质量。因此,改进视频帧间配准算法提高算法的准确性在视频超分辨率重构过程中起着重要的作用。

2.3 多视频序列时空配准

在进行多视频序列时空超分辨率时,由于各个视频采集设备具有不同的外部和内部校准参数导致两个序列之间需要对视频序列进行空间配准,同样当两个输入序列之间具有时移(如视频采集设备未被同时激活)或当它们具有不同的帧速率(如PAL制式和NTSC制式)时需要对视频序列进行时间配准。现阶段国内外许多学者对多视频序列时空配准进行了研究,但都将实际问题进行了简化,一般假设场景为平面或视频采集设备投影中心之间的距离相对于采集设备距离场景的距离可忽略,这种假设与实际情况存在一定差距。因此,准确的对多视频序列进行时空配准,提高时空配准算法的精度和适用范围在视频超分辨率重构过程中起着关键作用。

2.4 视频序列超分辨率重构方法

基于重构的方法可以取得较好的平滑和边缘效果,但算法复杂度较高,通常情况下需要进行迭代求解,运算量较大,因此对于要求实时性较高的问题难以应用;基于学习的方法可以恢复获得原来图像中没有的纹理细节,但这类算法运算速度较慢,并且需要大量的训练数据。对于多视频序列超分辨率重构,国内外现有的重建算法对视频序列本身的时空连续性以及多视频序列之间的联合特性没能充分利用,因此提出或改进一个稳定的算法利用好视频序列间的时空联合信息是未来研究中的一个重点。

3 视频序列超分辨率重构技术应用前景

视频序列超分辨率是不仅在理论上有重要意义,而且在实际应用中也有迫切需求,成为图像处理、计算机视觉等领域的一个研究热点。在日常生活中,例如在交通管理方面,由于监控摄像头的视场较大,无法获取快速行驶的车辆的细节信息,利用视频序列超分辨率技术,可以在车辆肇事过程进行详细重现,帮助案件的侦破;在体育运动方面,视频超分辨率构技术可以获得高速运动物体的细节,有助于在出现争议时,裁判做出正确公平的判罚。同样在军事应用中,由于目前靶场现有的光学设备对高速运动目标实况记录、导弹(火箭)起飞时的离架漂移量和姿态滚动量测量等难以满足性能要求。视频序列超分辨率成像技术可以摆脱对高性能探测器的依赖,打破时间和空间分辨率的相互制约,实现时空分辨率的同时提升,并且能够抑制因高速运动引起的目标运动混叠和运动模糊效应,具有广阔的军事应用前景。

总之,随着视频超分辨率理论和技术的发展,视频超分辨率重构技术必将在各个领域得到广泛应用。

[1] Tsai R Y, Huang T S. Multi-frame image restoration and registration[J]. Advances in Computer Vision and Image Processing, 1984(1): 317-339.

[2] Sanchez-Beato A, Pajares G. Noniterative Interpolation- Based Super-Resolution Minimizing Aliasing in the Reconstructed Image[J]. IEEE Transactions on Image Processing A Publication of the IEEE Signal Processing Society, 2008, 17(10): 1817-1826.

[3] Nasonov A V, Krylov A S. Fast Super-Resolution Using Weighted Median Filtering[C]//International Conference on Pattern Recognition. IEEE Computer Society, 2010: 2230-2233.

[4] Lin S C, Chen C T. Reconstructing Vehicle License Plate Image from Low Resolution Images using Nonuniform Interpolation Method[J]. International Journal of Image Processing, 2007, 1(2): 21-28.

[5] Tsai R Y, Huang T S. Multi-frame image restoration and registration[J]. Advances in Computer Vision and Image Processing, 1984(1): 317-339.

[6] Kim S P, Su W Y. Recursive high-resolution reconstruction of blurred multiframe images[J]. IEEE Transactions on Image Processing, 1993, 2(4): 534-9.

[7] Ur H, Gross D. Improved resolution form subpixel shifted pictures[J]. CVGIP: Graphical Models and Image Processing, 1992, 54(2): 181-186.

[8] Nguyen N, Milanfar P. An efficient wavelet-based algorithm for image superresolution[J]. 2000, 2: 351-354 vol. 2.

[9] Ji H, Ller C. Robust Wavelet-Based Super-Resolution Reconstruction: Theory and Algorithm[J]. Pattern Analysis & Machine Intelligence IEEE Transactions on, 2008, 31(4): 649-660.

[10] Ozkan M K, Tekalp A M, Sezan M I. POCS-based restoration of space-varying blurred images[J]. IEEE Transactions on Image Processing A Publication of the IEEE Signal Processing Society, 1994, 3(4): 450-454.

[11] Stark H, Oskoui P. High-resolution image recovery from image-plane arrays, using convex projections[J]. Journal of the Optical Society of America A, 1989, 6(11): 1715.

[12] Banham M R, Katsaggelos A K. Digital image restoration. IEEE Signal Processing Magazine, 1997, 14(2): 24-41.

[13] Tekalp A M, Ozkan M K, Sezan M I. High-resolution image reconstruction from lower-resolution image sequences and space-varying image restoration[J]. 1992, 3: 169-172.

[14] Eren P E, Sezan M I, Tekalp A M. Robust, object-based high-resolution image reconstruction from low-resolution video[J]. IEEE Transactions on Image Processing, 1997, 6(10): 1446-51.

[15] Patti A J, Altunbasak Y. Artifact reduction for set theoretic super resolution image reconstruction with edge adaptive constraints and higher-order interpolants[J]. IEEE Transactions on Image Processing, 2001, 10(1): 179-86.

[16] A. N. Tikhonov, Regularization of incorrectly posed problems, Soviet Mathematical Doklady 4 (1963) 1624– 1627.

[17] Marquina, S. J. Osher, Image super-resolution by TV-regularization and Bregman iteration, Journal of Scientific Computing 37 (2008) 367–382.

[18] Farsiu S, Robinson M D, Elad M, et al. Fast and Robust Multiframe Super Resolution[J]. IEEE Transactions on Image Processing A Publication of the IEEE Signal Processing Society, 2004, 13(10): 1327-1344.

[19] Chantas G, Galatsanos N P, Molina R, et al. Variational Bayesian image restoration based on a product of t-distributions image prior[J]. IEEE Transactions on Image Processing, 2008, 17(10): 1795.

[20] Schultz R R, Stevenson R L. Video resolution enhancement[J]. Proc Spie, 1995: 23-34.

[21] Schultz R R, Stevenson R L. Motion-compensated scan conversion of interlaced video sequences[J]. Proceedings of SPIE - The International Society for Optical Engineering, 1996.

[22] Elad M, Feuer A. Restoration of single super-resolution image from several blurred[J]. IEEE Transactions on Image Processing, 1997.

[23] Elad M, Feuer A. Super-resolution reconstruction of an image[C]// Electrical and Electronics Engineers in Israel, 1996. Nineteenth Convention of. IEEE, 1996: 391-394.

[24] Irani M, Peleg S. Improving resolution by image registration[J]. Cvgip Graphical Models & Image Processing, 1991, 53(3): 231-239.

[25] Irani M, Peleg S. Motion Analysis for Image Enhancement: Resolution, Occlusion, and Transparency[J]. Journal of Visual Communication & Image Representation, 1993, 4(4): 324-335.

[26] Mann S, Picard R W. Virtual bellows: constructing high quality stills from video[C]// Image Processing, 1994. Proceedings. ICIP-94. IEEE International Conference. IEEE Xplore, 1994: 363-367 vol. 1.

[27] 覃凤清, 陈为龙, 余永松, 等. 视频超分辨率重建技术研究[C]// 2007中国西部青年通信学术会议. 2007. QIN, CHEN, YU. Research on Video Super-Resolution Reconstruction Technology[C]// 2007 China Youth Academic Conference in Western China. 2007.

[28] Elad M. On the origin of the bilateral filter and ways to improve it[J]. IEEE Transactions on Image Processing, 2002, 11(10): 1141.

[29] Pentland A, Horowitz B. A practical approach to fractal- based image compression[C]// Data Compression Conference. IEEE, 1991: 176-185.

[30] Baker S, Kanade T. Limits on Super-Resolution and How to Break Them[J]. Pattern Analysis & Machine Intelligence IEEE Transactions on, 2002, 24(9): 1167-1183.

[31] Freeman W T, Pasztor E C, Carmichael O T. Learning Low- Level Vision[J]. International Journal of Computer Vision, 2000, 40(1): 25-47.

[32] Freeman W T, Jones T R, Pasztor E C. Example-Based Super-Resolution[J]. Computer Graphics & Applications IEEE, 2002, 22(2): 56-65.

[33] Wang Q, Tang X, Shum H. Patch Based Blind Image Super Resolution[C]// Tenth IEEE International Conference on Computer Vision. IEEE, 2005: 709-716 Vol. 1.

[34] Qiu G. Interresolution Look-up Table for Improved Spatial Magnification of Image[J]. Journal of Visual Communication & Image Representation, 2000, 11(4): 360-373.

[35] Yang J, Wright J, Huang T, et al. Image super-resolution as sparse representation of raw image patches[C]// IEEE Computer Society Conference on Computer Vision and Pattern Recognition. DBLP, 2008: 1-8.

[36] Adler A, Helor Y, Elad M. A Shrinkage Learning Approach for Single Image Super-Resolution with Overcomplete Representations[M]// Computer Vision–ECCV 2010. Springer Berlin Heidelberg, 2010: 622-635.

[37] Zhang Y, Zhao D, Ma S, et al. A motion-aligned auto- regressive model for frame rate up conversion[J]. IEEE Transactions on Image Processing, 2010, 19(5): 1248-1258.

[38] Huang A M, Nguyen T. Correlation-based motion vector processing for motion compensated frame interpolation[J]. 2008: 1244-1247.

[39] Vinh T Q, Kim Y C, Hong S H. Frame rate up-conversion using forward-backward jointing motion estimation and spatio-temporal motion vector smoothing[C]// International Conference on Computer Engineering & Systems. IEEE Xplore, 2010: 605-609.

[40] Yoo D G, Kang S J, Lee S K, et al. Motion Vector Smoothing for Motion-Compensated Frame Rate Up-Conversion[J]. 대한전자공학회 isocc, 2010: 358-359.

[41] Shimano M, Okabe T, Sato I, et al. Video Temporal Super-Resolution Based on Self-similarity[J]. Ieice Transactions on Information & Systems, 2010, 94(8): 1376-1386.

[42] Shechtman E, Caspi Y, Irani M. Space-time super-resolution[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2005, 27(4): 531.

[43] 陈为龙, 郭黎, 雷刚, 等. 多视频超分辨率的时间重建倍数[J]. 光学精密工程, 2014, 22(9): 2518-2527. CHEN, GUO, LEI. Time Reconstruction of Multi-Video Super-resolution[J]. Editorial Office of Optics and Precision Engineering, 2014, 22 (9): 2518-2527.

[44] Mudenagudi U, Banerjee S, Kalra P. On Improving Space- Time Super Resolution Using a Small Set of Video Inputs[C]// Computer Vision, Graphics & Image Processing, 2008. ICVGIP '08. Sixth Indian Conference on. IEEE, 2008: 320-327.

[45] 宋海英, 何小海, 陈为龙, 等. 多视频的时空超分辨率重建算法[J]. 北京邮电大学学报, 2011, 34(4): 85-88. SONG, HE, CHEN. A Space-Time Super-Resolution Reconstruction Algorithm of Video Sequences[J]. Journal of Beijing University of Posts and Telecommunications, 2011, 34 (4): 85-88.

[46] Shahar O, Faktor A, Irani M. Space-time super-resolution from a single video[C]// Computer Vision and Pattern Recognition. IEEE, 2011: 3353-3360.

[47] Glasner D, Bagon S, Irani M. Super-resolution from a single image[C]// IEEE, International Conference on Computer Vision. IEEE Xplore, 2009: 349-356.

[48] Takeda H, Milanfar P, Protter M, et al. Super-resolution without explicit subpixel motion estimation[J]. IEEE Transactions on Image Processing A Publication of the IEEE Signal Processing Society, 2009, 18(9): 1958.

[49] Hazen D, Puri R, Ramchandran K. Multi-camera Video Resolution Enhancement by Fusion of Spatial Disparity and Temporal Motion fields[C]// IEEE International Conference on Computer Vision Systems. IEEE Xplore, 2006: 38-38.

[50] Zhao W Y, Sawhney H S. Is Super-Resolution with Optical Flow Feasible?[M]// Computer Vision—ECCV 2002. Springer Berlin Heidelberg, 2002: 599-613.

[51] 任忠良. 一种基于SIFT特征的快速图像匹配算法[J]. 软件, 2015, 36(6): 53-57. REN. A Fast Image Matching Algorithm Based on SIFT Features[J]. COMPUTER ENGINEERING & SOFTWARE, 2015, 36(6): 53-57.

[52] 黄全亮, 孙坤, 刘水清. 超分辨率技术对基于特征图像配准算法的影响[J]. 新型工业化, 2011, 1(4): 1-7. HUANG, SUN, LIU. Infulence of using super-resolution in feature-based image registration[J]. New Industrialization Straregy, 2011, 1(4): 1-7.

[53] 王新年, 张涛, 张毓良. 改进的基于SIFT和RANSAC的图像配准方法[J]. 新型工业化, 2011, 1(6): 72-77. WANG, ZHANGTao, ZHANG. An improved image registration method based on SIFT and RANSAC[J]. New Industrialization Straregy, 2011, 1(6): 72-77.

Survey of Super-Resolution Reconstruction Techniques for Video Sequences

WU Yang1, FAN Gui-hua2

(1. Graduate School, Academy of Equipment, Beijing 101416, China; 2. Department of Photoelectric Equipment, Academy of Equipment, Beijing 101416, China)

The video sequence super-resolution reconstruction technique can reconstruct a video sequence with high spatial resolution or high temporal resolution from one or more low resolution video sequence information.In this paper, the concept of super-resolution reconstruction is introduced. The super-resolution reconstruction technique of video sequence is described in detail from three aspects: spatial super-resolution, temporal super-resolution and spatial-temporal super-resolution. Sequence super-resolution reconstruction technology in the key issues and application prospects were analyzed and prospects.

Video sequence; Super-resolution reconstruction; Spatial resolution; Temporal resolution; Spatial- temporal super-resolution

TN911.73

A

10.3969/j.issn.1003-6970.2017.04.030

吴洋(1992-),男,硕士,主要研究方向:空间光学测量;樊桂花(1963-),女,教授,硕士,主要研究方向:空间光学测量。

本文著录格式:吴洋,樊桂花. 视频序列超分辨率重构技术综述[J]. 软件,2017,38(4):154-160