显著性目标检测中的视觉特征及融合

2017-08-12袁小艳王安志王明辉

袁小艳 王安志 潘 刚 王明辉

1(四川大学计算机学院 四川 成都 610064) 2(四川文理学院智能制造学院 四川 达州 635000)

显著性目标检测中的视觉特征及融合

袁小艳1,2王安志1潘 刚2王明辉1

1(四川大学计算机学院 四川 成都 610064)2(四川文理学院智能制造学院 四川 达州 635000)

显著性目标检测,在包括图像/视频分割、目标识别等在内的许多计算机视觉问题中是极为重要的一步,有着十分广泛的应用前景。从显著性检测模型过去近10年的发展历程可以清楚看到,多数检测方法是采用视觉特征来检测的,视觉特征决定了显著性检测模型的性能和效果。各类显著性检测模型的根本差异之一就是所选用的视觉特征不同。首次较为全面地回顾和总结常用的颜色、纹理、背景等视觉特征,对它们进行了分类、比较和分析。先从各种颜色特征中挑选较好的特征进行融合,然后将颜色特征与其他特征进行比较,并从中选择较优的特征进行融合。在具有挑战性的公开数据集ESSCD、DUT-OMON上进行了实验,从PR曲线、F-Measure方法、MAE绝对误差三个方面进行了定量比较,检测出的综合效果优于其他算法。通过对不同视觉特征的比较和融合,表明颜色、纹理、边框连接性、Objectness这四种特征在显著性目标检测中是非常有效的。

显著性检测 视觉特征 特征融合 显著图

0 引 言

人类视觉系统可以快速准确地定位目标,显著性目标检测就是通过模拟人类的这一行为提取较为完整的整体目标,即显著性区域。早期研究是基于生物刺激模型和评价人眼固定数据, 现在研究则侧重于视觉特征的研究,诸如各种颜色特征、纹理特征、形状特征以及背景特征等, 并且这些特征也应用于其他领域,如图像分割[1]、目标跟踪[2]和行人检测[3]等。每一种视觉特征都有其自身的特点,但却无法完整地描述图像的全部信息,因此多种特征融合的检测方法势在必行,能有效提高显著性检测的性能和效率,如李波等[4]融合了颜色对比度、分布与背景特征,姜霞霞等[5]融合了结构特征和颜色特征。这些研究都仅仅局限于几种视觉特征的融合,没有对视觉特征做进一步的研究。

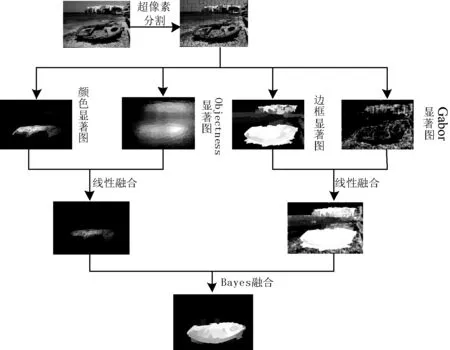

我们该如何从众多的图像视觉特征中选择出合适的特征组合?为了解决这个问题,文中对目前常用的视觉特征进行分析研究,并进一步探索这些特征的组合,从而得到显著图,其流程如图1所示。将本文算法在2个较难的数据集ESSCD和DUT-OMON中共计6 000余张图像上进行测试,并与典型的7个算法进行比较,实验验证了该算法的有效性,实验结果也优于这7个算法。

图1 本文算法流程图

1 相关工作

由于显著性目标检测的重要性, 越来越多的研究者投入到其中。Itti等[6]采用了颜色、亮度和方向特征融合, 在显著性检测方向开创了先河。程明明等[7]提出利用颜色直方图、颜色对比度来计算全局特征的显著性检测算法。Kim等[8]使用了颜色对比度、颜色直方图、颜色分布等多种颜色特征和HOG、形状特征来计算颜色相似性、差异性, 并进行高维颜色转换以得到显著图。为了使灰度旋转不变, Ojala等[9]提出了采用均匀LBP直方图降低噪音, 提取图像局部的纹理特征。MirmahdaviA等[10]采用Gabor滤波器提取全局纹理特征。针对已有的显著检测算法对背景复杂的图像检测效果较差的问题, Wang等[11]提出融合背景概率和Objectness特征的显著目标检测算法。Jiang等[12]提取了Focusness、Uniqueness、Objectness三种高级特征, 并进行融合。Achanta等[13]在频率域使用颜色和亮度特征计算中心-环绕对比度, 计算非常高效。

2 视觉特征及其融合

2.1 视觉特征

图像视觉特征是指图像的属性数据, 包含了一定的语义, 可以用来表示图像内容。研究图像必然会用到视觉特征, 如颜色、形状、方向等。每种视觉特征所包含的信息是不同的, 对显著性检测的作用也是不同的。

2.1.1 颜色特征

相较于其他特征,人类更容易辨别的是颜色特征,因此颜色特征在图像处理中被大量使用。颜色特征具有多种颜色空间, 如RGB、HIS、HSV、YIQ、CMY、CIELAB、YUV等。RGB主要描述基础彩色(红、绿、蓝)的亮度值;HIS和HSV描述颜色的色调、亮度和饱和度, 主要用于颜色的数字化处理, 比RGB更接近于人们的经验和对彩色的感知。CIELAB是与设备无关、基于生理特征的颜色系统, 描述颜色的亮度和色度, 其颜色比RGB更丰富。研究发现, 显著性检测算法均用到了颜色特征, RGB、HSV、CIELAB是最常用的三种颜色空间, 不同的颜色空间可以相互转换。颜色特征提取的常用方法有颜色对比度、颜色直方图、颜色分布。

颜色对比度是常用的获取颜色特征的方法, 用于计算局部区域或全局区域间的颜色相似性和差异性, 即局部颜色对比度和全局颜色对比度, 突出图像中显著区域,展示显著对象的独特性。Kim[8]和Li[14]等利用颜色特征计算了局部和全局颜色对比度。全局颜色对比度计算如下:

(1)

局部颜色对比度计算如下:

(2)

其中dis(ci,cj)是指区域i和j的颜色值的欧几里得距离,n是区域数量。

loci是区域i的平均位置,ρi是标准化因子。

颜色直方图是被广泛使用的提取颜色特征的方法,用于描述颜色的基本色调和组成分布、不同色彩在图像中所占的比例。Kim等[8]计算了RGB直方图、LAB直方图、色调直方图和饱和度直方图。全局直方图计算公式如下:

(3)

局部直方图计算公式如下:

(4)

其中dis(bi,bj)是指区域i和j的颜色直方图bin的卡方距离,n是区域数量。

pi是区域i的平均位置,Zi是标准化因子。

虽然显著性代表了独特性,但非显著性不一定就不独特。前景颜色分布在紧凑区域,背景颜色却分布在整张图像,颜色分布便用于测量前景与背景对象的紧凑型差异。Perazzi[15]和Cheng[16]等提出的颜色分布能够提高性能,并能更好地体现显著性目标的真实分布。颜色分布定义如下:

(5)

颜色局部对比度是将稳定性较好、可区分的区域和周围的像素、区域比较,仅在轮廓附近产生高显著值,对局部差异较大的图像效果较好。全局对比度是从整体图像出发, 和整张图像的其他像素、区域比较,能够从背景中突出大规模目标,且较均匀,具有整体一致性。颜色直方图是采用统计方法计算颜色的数量特征,反应颜色的统计分布,具有计算方法简单、平移旋转不变等特性,但其失去了颜色的空间位置,导致不同的图像可能有相同的颜色直方图,适合于难以自动分割的图像。颜色对比度测量颜色的差异,但不能反映颜色的空间变化,因此颜色分布可以作为颜色对比度的一个重要补充。

2.1.2 上下文特征

根据完形形态法则, 视觉可能具有一个或多个重心, 这表明越接近焦点的区域越重要。当焦点周围的区域传达上下文时,就会获得我们的注意力,即显著性。也就是说计算一个区域的显著性,不需要计算它与图形其他所有区域的差异,只需要计算与周围K临近区域的差异即可。Goferman等[17]将K取值为64,因此其显著图的定义为:

(6)

其中d(si,sk)是区域Si与它的K临近区域Sk的距离。

2.1.3 纹理特征

纹理特征是图像的一种重要特征,是整张图像灰度值的分布规律。通过像素及周围空间邻域的灰度分布来实现的是局部纹理特征。局部纹理不同程度的重复性, 即全局纹理特征。提取纹理特征常用的方法有Gabor小波和LBP模式。

Gabor小波是一种重要的纹理特征提取方法,选用特定的Gabor函数,采用尺度伸缩和旋转得到一组Gabor滤波器,实现图像多尺度、多方向的特征提取。Riche等[18]在八个方向(0,22.5,45,67.5,90,112.5,135,157.5)和3个尺度上采用高斯Gabor滤波器计算, 产生24张结果图, 其边界衰减为:

(7)

其中φ是相位偏移,α是正弦因子的波长,β是方向(垂直于正弦曲线的角度),δ是空间纵横比,σ是高斯包络的sigma,x′=xcosβ+ysinβ,y′=-xsinβ+ycosβ。最后对这24张结果图合并, 得到3个尺度的方向特征信息,其特征图如图2所示。Gabor滤波器还常用于提取形状特征。

Gabor小波纹理特征是符合人类对频率的感知机理的,在空域和频域都有较好的分辨能力,具有多分辨率特性。LBP纹理特征的原理比较简单,计算量小,具有灰度不变性和旋转不变性的优点,且能在各种光照下工作,但其对图像的平滑区域不敏感,需要结合其他算法。

2.1.4 HOG特征

HOG(方向梯度直方图)特征是计算图像中每个像素的梯度, 并统计每个单元的梯度值进行累加。Dalal等[20]计算每个像素的梯度时采用梯度算子[-1,0,1]和[1,0,-1]T与原图像做卷积运算,分别得到x和y方向的梯度分量GDx(x,y)、GDy(x,y), 因此像素点(x,y)的梯度大小和方向为:

(8)

2.1.5 Objectness特征

Alexe等[21]提出了Objectness特征, 并以此测量一个像素或区域周围存在完整物体的可能性。为了计算图像区域的Objectness值, Jiang等[12]先计算了像素的Objectness值:

(9)

(10)

其中W是随机样本n个窗口的集合,wx是W集合中包含像素x的窗口,pro(wx)是窗口w覆盖一个物体的概率值,Ψi是协方差矩阵,wi是窗口,z是归一化算子。

因此图像区域r的Objectness值如下定义:

(11)

2.1.6 边框连接性特征

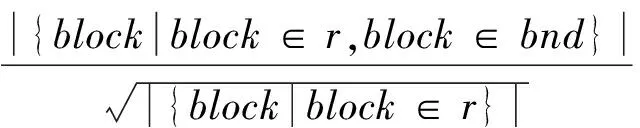

研究中发现显著性区域与边界的连接较少,因此可以用此特性来检测背景,即边框连接性。一个区域是否属于背景, 取决于它所属的图像区域与图像边界的紧密相连度。一个图像区域r的边框连接性是指边框块周长与整个图像区域周长或者面积开方的比例, 其定义如下:

(12)

其中,bnd是r区域中边框块的集合,block是r区域中的一块。Zhu等[22]采用超像素s代替了图像区域,边框连接性为边界长度Lenbd(s)和跨区域面积Area(s)的比例,如下所示:

(13)

(14)

颜色特征是显著性检测中最常用的视觉特征, 其与显著目标的相关度非常高, 有较高的鲁棒性。纹理特征是一种反映图像中同质现象的视觉特征, 在空间上以一定的形式变化, 具有局部序列不断重复、随机排列、区域内大致均匀的特点。HOG特征是在图像的局部方格单元上操作, 所以它对图像几何和光学的形变都能保持很好的不变性, 常用于获取形状和纹理特征。Objectness是指从客观物体出发, 保证物体的完整性, 能提供物体位置的分布,常使用于各种视觉实验中。边框连接性特征是背景特征的一种,采用的是图像区域空间分布的特点, 并有一个直观的几何定义, 所以它是健壮和稳定的,并且还能处理纯背景图像。

2.2 视觉特征融合

视觉特征众多, 需要进行选择。本文分别选择颜色特征和其他特征,颜色特征选择了LAB空间的局部和全局颜色对比度[8]、HSV空间的局部和全局颜色直方图[8]、LAB空间的颜色分布[8]和上下文特征[23],其他特征选择了边框连接性[22]、Objectness[12]和Gabor[18]纹理特征,如图2所示。

图2 特征图

在颜色特征中, 本文选择规则如下:

ⓐ 颜色对比度和颜色分布是互补的, 颜色直方图是对颜色的统计, 所以需要选择这三种特征。

ⓑ 结合人眼视觉注意机制和图像数字处理, 需要选择HSV和LAB空间。

根据结果比较分析,最后颜色特征的融合公式如下:

C=(LC·GC+LH·GH+Con)·D

(15)

其中LC是局部对比度,GC是全局对比度,LH是局部直方图,GH是全局直方图,Con是上下文特征,D是颜色分布。

本文将融合后的颜色特征与其它特征进行融合,根据结果比较分析,颜色与Objectness特征的融合优于其他特征的融合, 所以将四个特征分为两组:颜色、Objectness特征和Gabor纹理、边框连接性特征, 融合公式为:

SalCO=C+O,SalGB=G·B

(16)

其中C是颜色特征,O是Objectness特征,G是Gabor纹理特征,B是边框连接性。然后再采用贝叶斯方法[24]对SalCO和SalGB进行融合,最后采用单层元胞自动机[25]进行优化。

3 实验结果与分析

3.1 测试数据集

为了验证各种特征和本文算法的性能, 我们在两个较难的数据集上做了大量的实验。ESSCD数据集含有1 000张图片, 包含了丰富的语义和复杂的结构, 对显著性检测来说挑战性非常强。 DUT-OMRON数据集包含5 000余张图片,包含了多个显著物体,极具挑战性。

3.2 性能评估方法

为了和其他较优算法进行比较,我们采用了三种常用方法来评估实验。PR曲线评估实验的精准率P和召回率R,精准率是指显著像素正确检测的比率,召回率是指检测出来的显著像素与真值图中显著像素的比率。F-measure方法用于检测像素精准率和召回率的平均数。但实验不能只从正确率上评估,还要从错误率上评估,即MAE方法。 MAE方法是检测平均绝对误差,用于检测非显著区域。

3.3 实验对比与分析

本文的特征较多,因此实验分为了三组,即颜色特征比较实验、多种特征比较实验和各种显著性检测算法比较实验, 以ESSCD数据集为例。

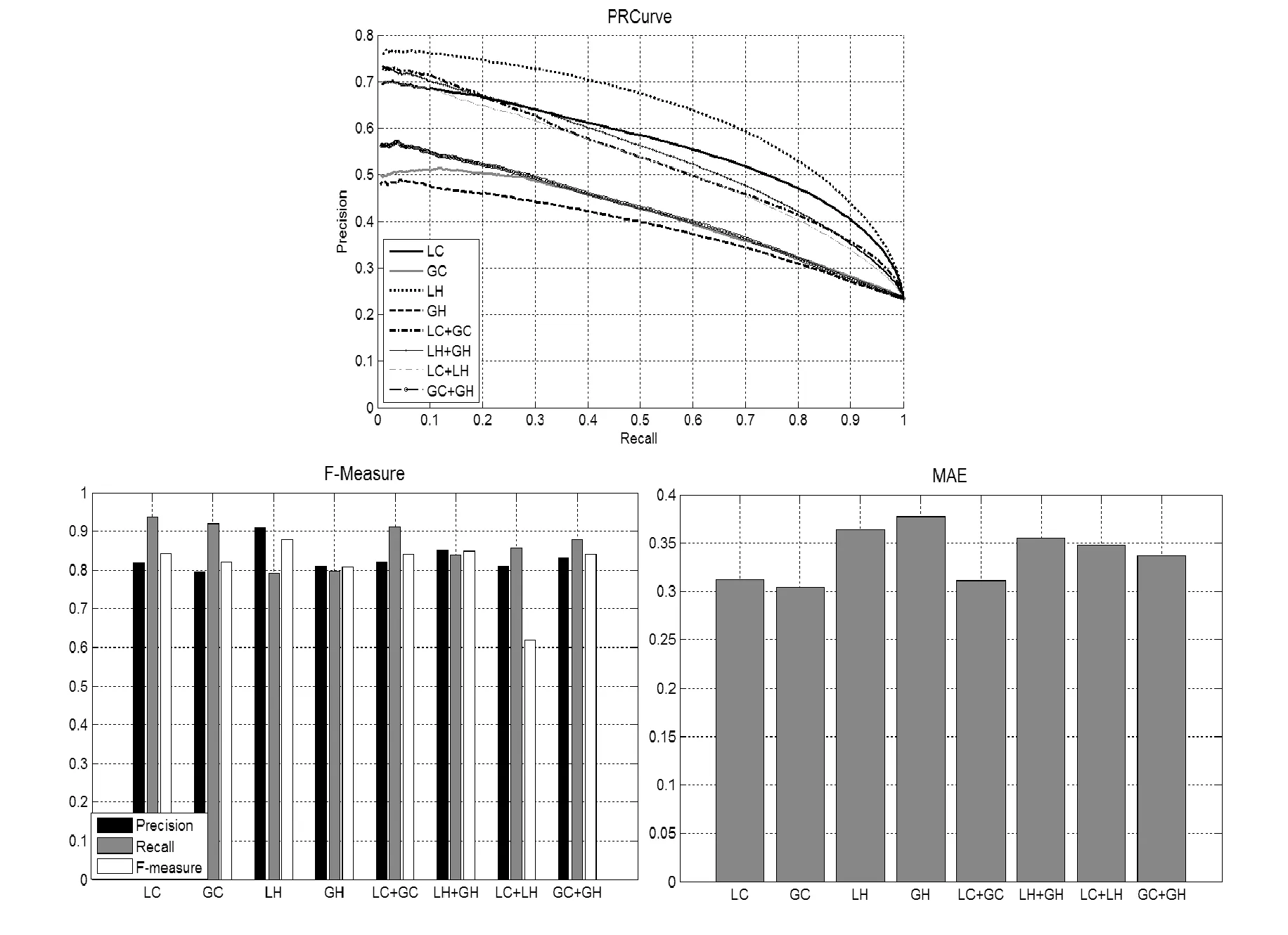

3.3.1 颜色特征比较分析

颜色特征比较是对RGB、LAB和HSV空间上颜色局部对比度、全局对比度、局部直方图、全局直方图和颜色分布进行比较。从图3中可以看到, HSV空间局部颜色直方图的精度、召回率、F-Measure、误差均优于LAB、RGB空间, 所以本文选择HSV空间的局部直方图, 但其平均精准率、平均召回率、F-Measure相差太大, 不稳定, 所以又选择相同空间较稳定的全局直方图。HSV空间局部颜色对比度的精准率、召回率、F-Measure优于LAB、RGB空间, 但其误差却低于后两者, 说明HSV空间的局部颜色对比度不稳定, 又根据规则b, 本文选择LAB空间的局部颜色对比度, 但它的误差稍高, 所以同时选择误差稍低、相同空间的全局颜色对比度。HSV空间颜色分布的精准率、召回率、F-Measure均优于LAB、RGB空间, 但其误差却低于LAB空间, 所以本文选择LAB空间的颜色分布。最后由于上下文特征的误差是最小的, 所以将上下文特征也加入。

图3 颜色特征比较

对局部、全局对比度,局部、全局直方图进行融合时, 采用了多种方法,如图4所示,对比度和直方图不能直接融合,需要将对比度、直方图分别进行融合。局部、全局对比度融合的误差比其单独两个特征降低了。局部、全局直方图融合明显优于其单独的两个特征。颜色对比度、直方图、分布和上下文特征的融合,如图5所示,只有四种特征都融合才优于前几种融合

图4 颜色对比度、直方图融合比较

图5 颜色对比度、直方图、分布、上下文融合比较。Ctr:颜色对比度,Hist:颜色直方图,D:颜色分布,Con:颜色上下文

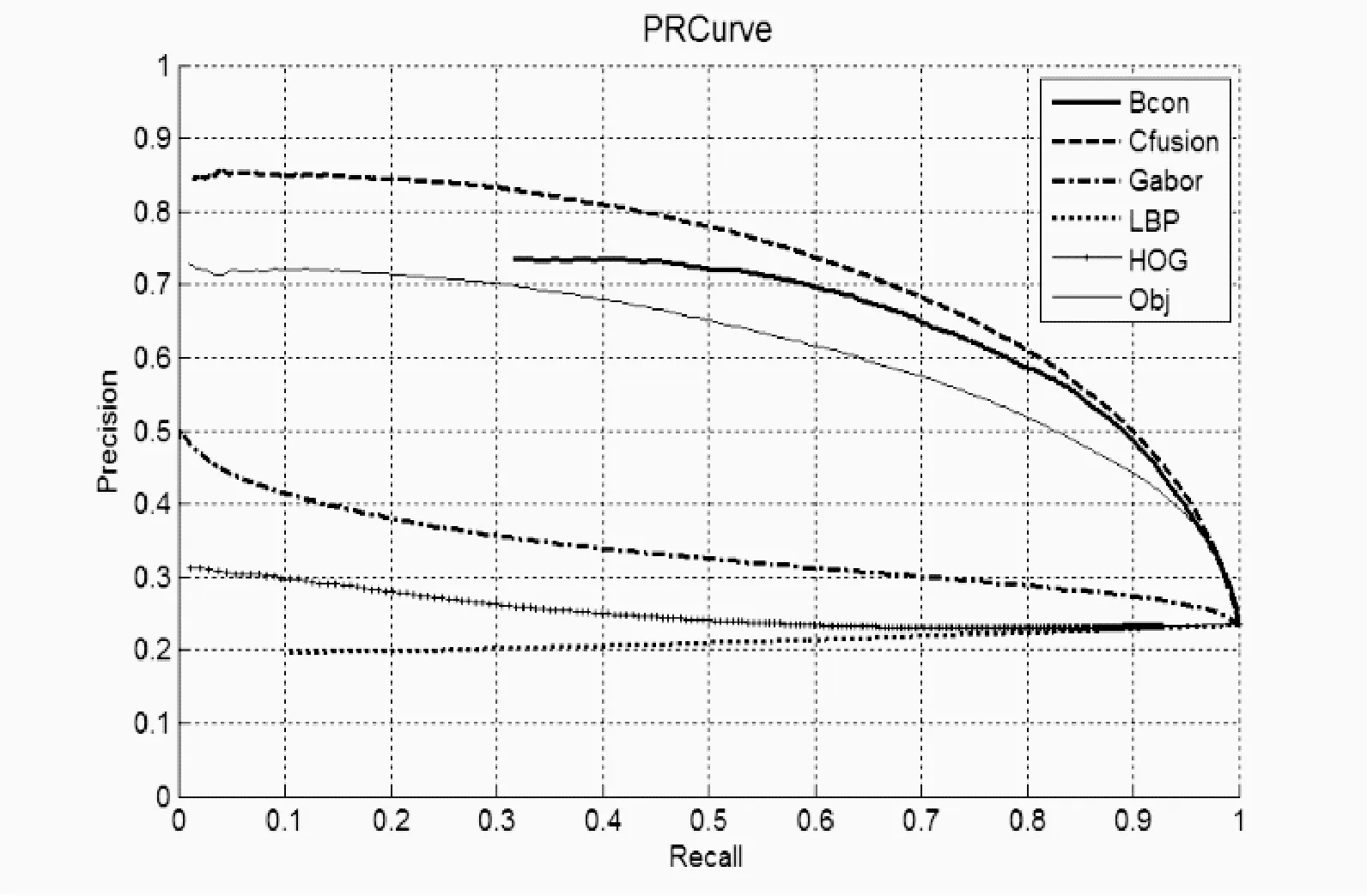

3.3.2 多种特征比较分析

将融合的颜色特征与其他特征进行比较,如图6所示。由于LBP、Gabor纹理特征和HOG特征对噪音较敏感,而本文没有对图像进行去噪处理,因此其曲线不尽人意。而边框连接性、Objectness和颜色特征的精准率和召回率都较好, 但这三个特征都没有从细节上刻画显著性对象, 所以进一步选择了稍好的Gabor纹理特征。

图6 所有特征比较

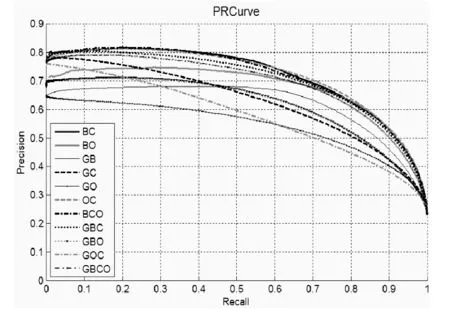

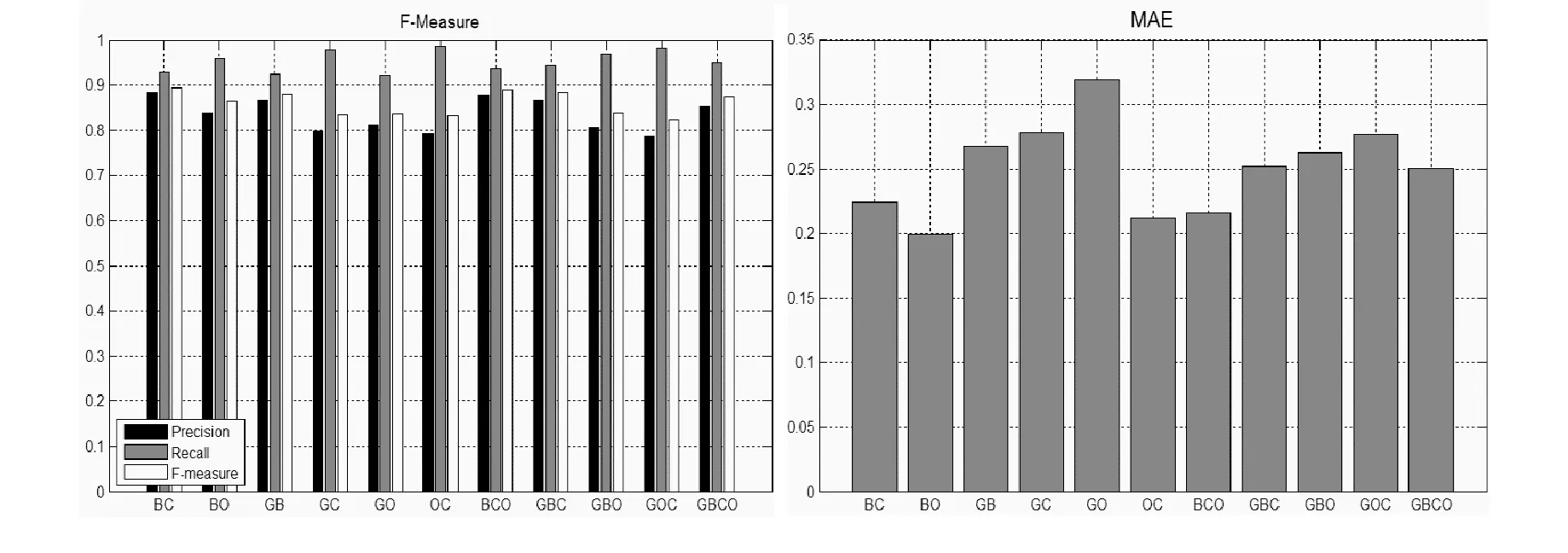

四种特征的融合,如图7所示,BC、OC和BCO的PR曲线优于其他几种融合,在F-Measure中BC与BCO差不多,但其误差高于BCO,所以舍弃BC。若选择BCO,后加入Gabor特征进行线性融合,便是此处的GBCO,而GBCO的PR曲线低于BCO融合,所以舍弃BCO,最终选择OC,另一组自然就是GB。

图7 所有特征融合比较。B:边框连接性,C:融合的颜色特征,G:Gabor纹理特征,O:Objectness特征。将这四种特征分别进行融合,如BO=B+O,即边框连接性与Objectness特征线性融合,其他的同等道理

3.3.3 各种模型比较分析

本文将算法与其他7个算法进行比较, FT[13]、HDCT[8]、GC[17]、HS[26]、RBD[22]、DSR[24]、UFO[12]。如图8所示,在ESSCD数据集, 我们的算法明显优于其他算法,虽然其F-Measure比HS算法稍低, 但召回率明显比其高, MAE也仅仅比RBD稍差一点。在DUT-OMON数据集, 虽然我们的精准率、召回率在起始状态略低于DSR算法, 但F-Measure高于DSR算法, 且误差也较低, 这说明我们的算法是稳定的。

图8 两种数据集上不同算法比较

图9比较了不同方法的显著图,从图中可以看到我们的显著图相比于其他算法来说,更接近于真值图。

图9 两种数据集上不同方法的显著图

4 结 语

显著性检测通常是提取各种图像特征,并在此基础上进行各种计算。不同特征的特性和使用都是不同的,本文对图像的多种特征进行了定性和定量的比较,从中找到了有效特征,并将这些特征进行融合,取得了较好的显著性目标检测效果。通过对实验结果的比较,在目前较难的两个数据集上本算法的性能优于其他算法,验证了该算法中提取特征的有效性。

[1] 司马海峰,米爱中,王志衡,等.显著特征融合的主颜色聚类分割算法[J].模式识别与人工智能,2016,29(6):492-503.

[2] 毕福昆,陈禾,师皓,等.机载复杂遥感场景下特定建筑区检测跟踪算法[J].电子学报,2016,44(6):1394-1399.

[3] 肖德贵,辛晨,张婷,等.显著性纹理结构特征及车载环境下的行人检测[J].软件学报,2014,25(3):675-689.

[4] 李波,金连宝,曹俊杰,等.分层信息融合的物体级显著性检测[J].中国图象图形学报,2016,21(5):595-604.

[5] 姜霞霞,李宗民,匡振中,等.融合双层信息的显著性检测[J].中国图象图形学报,2015,20(3):340-348.

[6] Itti L,Koch C,Niebur E.A Model of Saliency-Based Visual Attention for Rapid Scene Analysis[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,1998,20(11):1254-1259.

[7] Cheng M M,Zhang G X,Niloy J,et al.Global Contrast based Salient Region Detection[C]//IEEE Computer Vision and Pattern Recognition.USA Colorado,2011:409-416.

[8] Kim J,Han D,Tai Y W,et al.Salient Region Detection via High-Dimensional Color Transform[C]//IEEE Computer Vision and Pattern Recognition,2014:883-890.

[9] Ojala T,Pietikainen M,Maenpaa M.Multiresolution gray-scale and rotation invariant texture classification with local binary pattern[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2002,24(7):971-987.

[10] Mirmahdavi A S A,Amirkhani B,Ahmadyfard A.Random Texture Defect Detection by Modeling the Extracted Features from the Optimal Gabor Filter[J].Journal of Advances in Computer Research,2015,8(6):65-85.

[11] Wang A,Wang M,Pan G,et al.Salient object detection with high-level prior based on Bayesian fusion[J].Iet Computer Vision,2017,11(3):199-206.

[12] Jiang P,Ling H B,Yu J Y,et al.Salient Region Detection by UFO:Uniqueness,Focusness and Objectness[C]//IEEE International Conference on Computer Vision,2013:1976-1983.

[13] Achanta R,Hemami S,Estrada F,et al.Frequency-tuned Salient Region Detection[C]//IEEE Computer Vision and Pattern Recognition,2009:1597-1604.

[14] Li Y,Hou X,Koch C,et al.The Secrets of Salient Object Segmentation[C]//Computer Vision and Pattern Recognition.IEEE,2014:280-287.

[15] Perazzi F,Krahenbuhl P,Pritch Y,et al.Saliency filters:Contrast based filtering for salient region detection[C]//IEEE Computer Vision and Pattern Recognition,2012:733-740.

[16] Cheng M M,Warrell J,Lin W Y,et al.Efficient Salient Region Detection with Soft Image Abstraction[C]//IEEE International Conference on Computer Vision,2013:1529-1536.

[17] Goferman S,Manor L Z,Tal A.Context-Aware Saliency Detection[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2012,34(10):1915-1926.

[18] Riche N,Mancas M,Duvinage M,et al.A study of parameters affecting visual saliency assessment[J].Signal Processing:Image Communication,2013(28):642-658.

[19] Wang X Y,Han T X,Yan S C.An HOG-LBP Human Detector with Partial Occlusion Handling[C]//IEEE International Conference on Computer Vision,2009:32-39.

[20] Dalal N,Triggs B.Histograms of oriented gradients for human detection[C]//IEEE Computer Vision and Pattern Recognition,2005:886-893.

[21] Alexe B,Deselaers T,Ferrari V.What is an object?[C]//IEEE Computer Vision and Pattern Recognition,2010:73-80.

[22] Zhu W J,Liang S,Wei Y C,et al.Saliency Optimization from Robust Background Detection[C]//IEEE Computer Vision and Pattern Recognition,2014:2814-2821.

[23] Jiang H Z,Wang J D,Yuan Z J,et al.Automatic Salient Object Segmentation Based on Context and Shape[C]//British Machine Vision Conference,2011:1-12.

[24] Li X H,Lu H C,Zhang L H,et al.Saliency Detection via Dense and Sparse Reconstruction[C]//IEEE International Conference on Computer Vision,2013:2976-2983.

[25] Qin Y,Lu H,Xu Y,et al.Saliency detection via Cellular Automata[C]//IEEE Computer Vision and Pattern Recognition,2015:110-119.

[26] Yan Q,Xu L,Shi J,et al.Hierarchical Saliency Detection[C]//IEEE Conference on Computer Vision and Pattern Recognition,2013:1155-1162.

VISUALFEATUREANDFUSIONOFSALIENCYOBJECTDETECTION

Yuan Xiaoyan1,2Wang Anzhi1Pan Gang2Wang Minghui1

1(CollegeofComputerScience,SichuanUniversity,Chengdu610064,Sichuan,China)2(SchoolofIntelligentManufacturing,SichuanUniversityofArtsandScience,Dazhou635000,Sichuan,China)

The saliency object detection is a very important step in many computer vision problems, including video image segmentation, target recognition, and has a very broad application prospect. Over the past 10 years of development of the apparent test model, it can be clearly seen that most of the detection methods are detected by using visual features, and the visual characteristics determine the performance and effectiveness of the significance test model. One of the fundamental differences between the various saliency detection models is the chosen of visual features. We reviewed and summarized the common visual features for the first time, such as color, texture and background. We classified them, compared and analyzed them. Firstly, we selected the better features from all kinds of color features to fuse, and then compared the color features with other characteristics, and chosen the best features to fuse. On the challenging open datasets ESSCD and DUT-OMON, the quantitative comparison was made from three aspects: PR curve, F-measure method and MAE mean error, and the comprehensive effect was better than other algorithms. By comparing and merging different visual features, it is shown that the four characteristics of color, texture, border connectivity and Objectness are very effective in the saliency object detection.

Saliency detection Visual feature Feature fusion Saliency map

2017-01-10。国家重点研究与发展计划项目(2016YFB0700802,2016YFB0800600);国家海洋局海洋遥感工程技术研究中心创新青年项目(2015001)。袁小艳,讲师,主研领域:计算机视觉,机器学习,个性化服务。王安志,讲师。潘刚,讲师。王明辉,教授。

TP301.6

A

10.3969/j.issn.1000-386x.2017.08.038