面向微尺度对象的多视场协同测量方法研究

2017-08-12刘国华

刘国华 李 涛

1(天津工业大学机械工程学院 天津 300387) 2(天津工业大学天津市现代机电装备技术重点实验室 天津 300387)

面向微尺度对象的多视场协同测量方法研究

刘国华1,2李 涛1

1(天津工业大学机械工程学院 天津 300387)2(天津工业大学天津市现代机电装备技术重点实验室 天津 300387)

针对显微视觉下视野小,无法对微小目标对象一次测量等难题,提出面向微尺度对象的多视场协同测量方法。该方法通过谱残差视觉注意模型建立亮度显著图对低分辨率的大视场图像提取兴趣区域,分别对兴趣区域获取高分辨率的小视场图像。然后通过ORB算法将大视场图像与小视场图像匹配起来,将小视场图像融合到大视场图像中。最后对得到的高分辨率图像进行图像处理,返回需要测量的数据。实验结果表明,该方法具有较高的测量精度,并且能够实现面向微尺度对象的自动测量。

微尺度对象 自动测量 视觉注意 多视场 特征匹配

0 引 言

随着现代制造技术在微型机械领域的迅速发展,微型零件等微尺度对象的应用越来越多[1-2]。各个领域对于测量微小尺寸的精度要求愈来愈高,传统的人工测量方法费时费力,而且测量精度不稳定。基于图像处理的测量方法以其非接触、高精度、高灵敏度等独特优势[3],在工业检测领域中发挥着越来越重要的作用。

在微尺度对象的测量研究方面,国内外有很多学者做了大量的工作,国内研究一般采用直接测量或者通过图像拼接进行测量。使用图像拼接算法将很多小视场图片拼接在一起进行测量[4-5]的方法使用的比较多,国外研究多集中在超声显微镜的研究上[6-7],主要是利用接收反射的超声回波信号进行分析。Good等利用70 MHz超声波测量生物薄层的厚度,实现了薄膜微观特性的测量[6]。Raisutis等通过超声显微镜测量出三层铝泡沫薄层材料的厚度[7]。

而在实际的微尺度对象的测量中,目标对象在低倍镜下的视野大,但是很难查看到样本的全部细节[8];而在高倍镜下可以观察到样本的局部细节,但是不能观测到样本整体。显微视觉下的视野大小与分辨率大小互相矛盾。上面提到的几种方法虽然也能实现微尺度对象的几何量测量,但是超声显微镜尚无法实现多参数测量,而且需要人工进行测量部位的选取,无法实现自动测量;直接测量的精度较低,误差太大;图像拼接的方法需要获取到的图片很多,在计算过程中会很复杂,处理过程慢,而且由于小视场图像之间要有公共区域[9],很难实现自动测量。

因此,要实现显微视觉下的自动精密测量,要解决两个关键问题:(1) 显微镜视野大小与分辨率成反比的问题;(2) 如何对测量区域进行自动测量的问题。

微靶球是惯性约束聚变技术(ICF)中的一个关键元件,微靶球的尺寸及表面精度(如球形度、表面粗糙度)是影响打靶实验成功的关键[10-11]。为了保证聚变实验效果,需严格选择用于实验的微靶球样品,现有方法制备的微靶球在直径、壁厚、同心度等方面分布较宽,需大量的人力和时间来挑选满足需求的靶球,且后续涉及到的微靶球操作过程很多,单纯的人工操作已无法满足实验要求。微靶球尺寸小(外径50~400 μm),而且在检测过程中微靶球会出现粘连现象,粘连的微靶球在大视场图像中边缘模糊,无法进行高精度的检测与筛选,因此微靶球可以作为典型的微尺度对象进行实验。

1 多视场协同测量原理及其关键技术

1.1 多视场协同测量原理

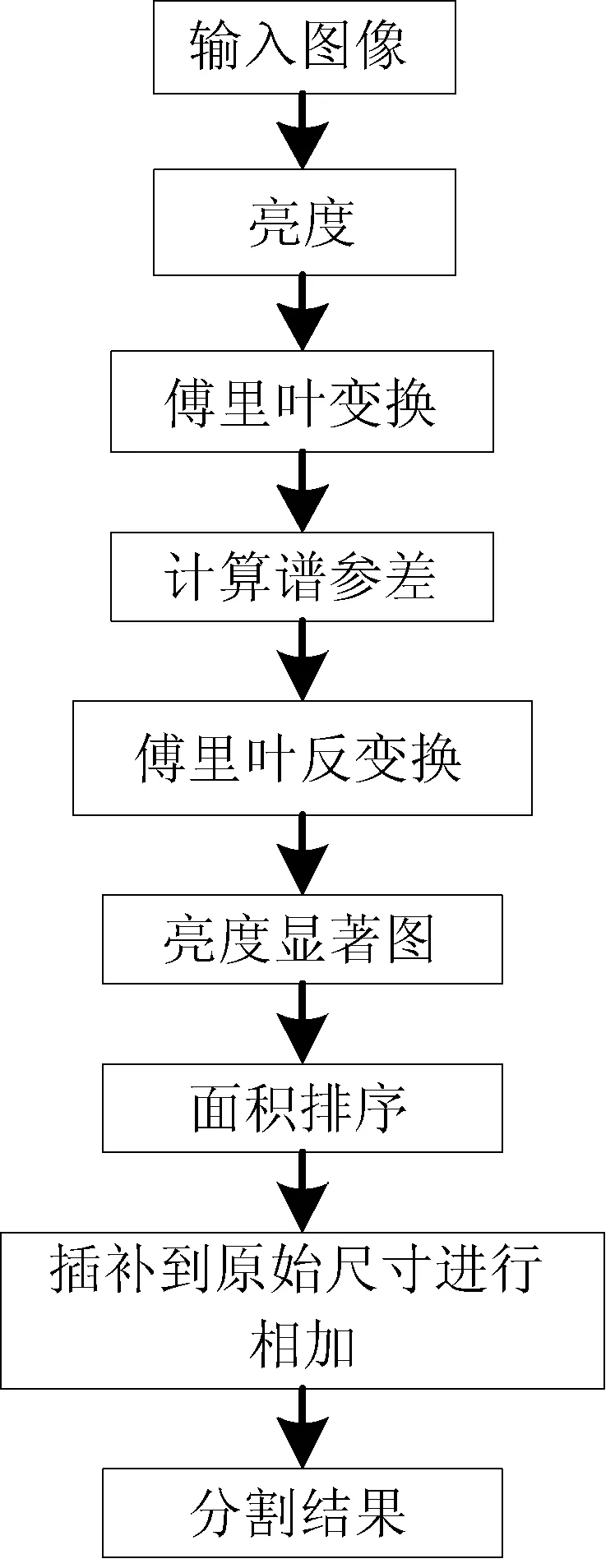

面向微尺度对象的多视场自动测量方法是:首先对待测对象进行大视场成像,通过谱残差视觉注意机制对大视场图像进行兴趣区域的提取,将需要进行获取高分辨率的目标区域提取出来,获得注意区域中心坐标。然后通过位移台控制器控制三维精密位移台移动高倍率镜头对准兴趣区域中心,进行小视场兴趣区域的成像,生成小视场图像,将大视场图像插值到小视场图像相同的分辨率。通过ORB算法对插值后的大视场图像与小视场图像进行特征提取与特征匹配,在大视场图像中找到小视场图像的对应位置,将小视场图像融合到大视场图像中。最后,利用图像处理技术对融合后的图像进行测量,得到最后的测量结果。多视场协同测量方法流程如图1所示。

图1 测量原理

1.2 多视场协同测量关键技术

要实现面向微尺度对象的多视场自动测量,要达到较高的自动化必须要解决两个关键问题:

(1) 小视场的路径规划与自动采集图像。在大视场成像之后,需要在图像中找到需要小视场高精度测量的区域。在视觉处理技术中,针对特定的图像,可以采用多种方法获取小视场区域。但是对于实时检测和自动检测,阈值处理和图像拼接的方法都不适合。本文采用的方法是通过视觉注意机制对大视场图像进行处理,对图像的亮度进行处理得到显著图,显著区域就是需要进行小视场高精度成像的区域,即得到需要进行精密测量的目标区域。

(2) 多视场图像之间的数据转换。在获取到小视场图像之后,需要将小视场数据转换到大视场中,以便进行后续的测量。但是这几种方法的问题在于需要不同的小视场图像有共同区域,但是在实际检测中,待测目标一般是分散的,共同区域的产生实际上会影响检测的速度和难度。本文采用ORB算法将大视场图像和小视场图像进行特征检测与匹配,然后将小视场图像融合到大市场中的方法,实现多视场图像的数据转换。

要进行视觉注意,需要对视觉注意机制进行研究,在现有的视觉注意理论方法的基础上进行选取与改进,选用谱残差的方法进行显著图的提取。

2 基于视觉注意机制的视场转换技术

要对小视场进行成像,需要在大视场中找到需要进行小视场高精度成像的区域,然后控制镜头的转换,对小视场成像。在进行不同视场的转换过程中,要实现对小视场区域的检索,本文采用视觉注意机制进行注意区域的检索。获得注意区域的中心坐标之后,通过控制三维精密位移台自动移动高倍镜头对准注意区域,进行小视场高分辨率成像。

2.1 视觉注意机制

本文设计采用基于谱残差的构造显著图的方法,对谱残差方法进行改进使其更适用于本实验。利用亮度的显著性检测显著图,对于检测出来的几个显著区域按照像素面积大小进行排序,即可获取显著区域的图像采集顺序。

在视觉注意中,图像由冗余部分和显著部分组成。定义R(f)来表示图像中的冗余部分,定义S(f)来表示图像中的显著部分:

S(f)=L(f)-R(f)

(1)

R(f)=hn(f)×L(f)

(2)

(3)

对谱残差注意方法进行改进后,生成显著图的具体过程如下:

1) 将图像分成HSV三个通道,提取生成的亮度图像(V);

2) 将得到的亮度图像进行傅里叶变换[12-13],得到亮度图像的幅度谱A(f)和相位谱P(f);

3) 幅度谱A(f)取对数,得到对数谱L(f),根据式(1)、式(2)计算R(f)和S(f);

4) 根据S(f)和相位谱P(f),进行傅里叶反变换得到相应的显著图。

显著图计算过程如图2所示。

图2 显著图计算过程

傅里叶变换:

(4)

傅里叶反变换:

(5)

在得到显著图之后,将显著图插值到原始分辨率,再与原始图像进行叠加,即可得到分割结果。对于可能会出现几个区域的情况,加入区域面积的大小排序,将获得的几个区域按照面积排序,即为获取图像的顺序。

由于在视觉注意后获得到的显著图分辨率会变低,将显著图插值,与原始图像相加可得到显著注意区域,得到注意区域的中心坐标。

对于微靶球的大视场图像,视觉注意过程如图3所示。

图3 视觉注意过程

2.2 控制镜头视场转换

提取注意区域的中心坐标后,计算位移台需要移动的三维位移脉冲数,通过程序将其发送到位移台控制器,自动控制小视场镜头对注意区域中心进行对准,进行高倍分辨率小视场图像的获取。考虑到工作台的位置不变,所以相机的焦距和显微镜头的放大倍数可以在实验之前预先设定好。这样只需要调整小视场镜头的三维坐标即可。大视场图像与注意区域的关系如图4所示。

图4 大小视场图像位置关系

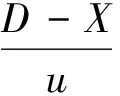

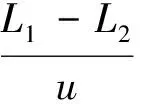

设获得到的注意区域中心坐标为O(X,Y),则:

X方向移动脉冲数:

(6)

Y方向移动脉冲数:

(7)

Z方向移动脉冲数:

(8)

其中D表示三维精密移动位移台上低倍大视场镜头与高倍小视场镜头之间的距离,u表示单位脉冲当量(μm/像素),L1表示低倍镜头的工作距离,L2表示高倍镜头的工作距离。

3 基于ORB算法的多视场数据转换技术

3.1 ORB算法

利用局部图像实现显微视觉的自动测量,需要解决大视场与小视场之间的数据转换问题。本文采用大小视场图像之间的特征检测与特征匹配,然后将重叠区域对应的数据替换的方法,将小视场图像融合到大视场图像中。

为了使测量速度更快,而且考虑到图像特征检测与匹配不涉及角度和方向的特征检测,采用改进的ORB算法进行特征点的检测与匹配。

选用ORB算法进行特征提取的优点:相对传统的SIFT和SURF算法,速度快一个数量级[14-15]。

对于图像中的一个像素点p,下面是特征点的计算公式:

(9)

其中,I(p)表示候选点p的灰度值,I(x)表示邻域某像素的灰度值,εd即为设定的阈值。一般,如果N大于圆周邻域像素点数的3/4,则认为p是一个特征点。

在特征匹配阶段,为了降低误配率,使用马氏距离对特征点的匹配进行改进,去除多余的特征点,降低误配率。

对于一个均值为u,协方差矩阵为C的数字矩阵,它的马氏距离为:

(10)

马氏距离的大小不仅与各个点集相对分布有关,而且与各个点集自身的分布有关,使得在同一个点集内的数据在所研究的指标下拥有较高的相似度,进而可以提高特征点的匹配精度,更好地剔除误配点。

马氏距离与传统的欧氏距离相比,欧氏距离的适用面更广,但是马氏距离的计算是建立在总体样本的基础上的,重复性低[16]。

3.2 数据转换

在进行特征匹配之后,得到大视场图像与小视场图像之间的匹配特征点对:{(x11,y11),(x12,y12),…,(x1i,y1i)}和{(x21,y21),(x22,y22),…,(x2i,y2i)},在匹配点对的坐标范围内,将相应的小视场图像的数据替换到大视场图像当中,得到的就是融合高分辨率图像的大视场图像。然后就可以通过图像处理技术进行测量。

4 实验与分析

为了验证测量方法的可行性与准确性,自行设计并搭建了面向微尺度对象的多视场自动测量平台。平台包括计算机、CCD相机、显微变倍镜头、三维移动位移台,其中计算机处理器为酷睿6代i5,内存8 GB,CCD相机采用德国sentech公司生产的2 448×2 056像素的CCD相机,镜头采用普密斯公司生产的PMS63100D显微镜头。采用卓立汉光公司生产的SC300系列电控位移台进行相机的自动精密控制。实验设备如图5所示。

图5 实验设备

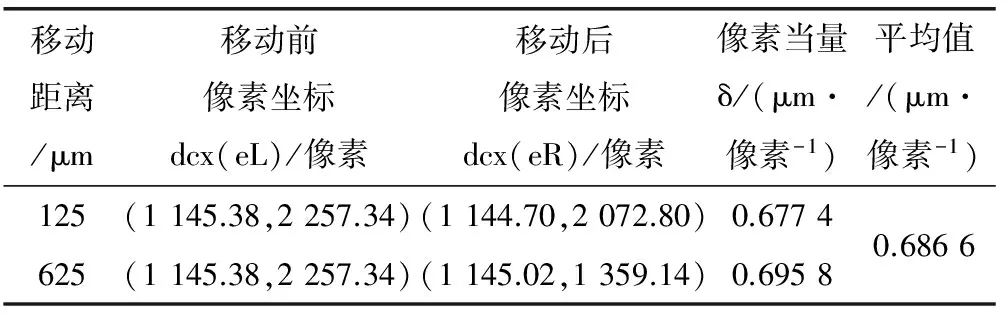

首先采用控制CCD相机移动一定距离的方式对CCD相机进行标定,标定数据见表1。

表1 视觉测量系统标定数据

最后得到的像素当量(每个像素代表的实际距离)为0.686 6 μm/像素。

在工业要求中,合格靶球的直径范围是50~400 μm,根据像素当量计算,合格靶球在图像中的直径范围是73~582像素,半径范围是37~291像素。

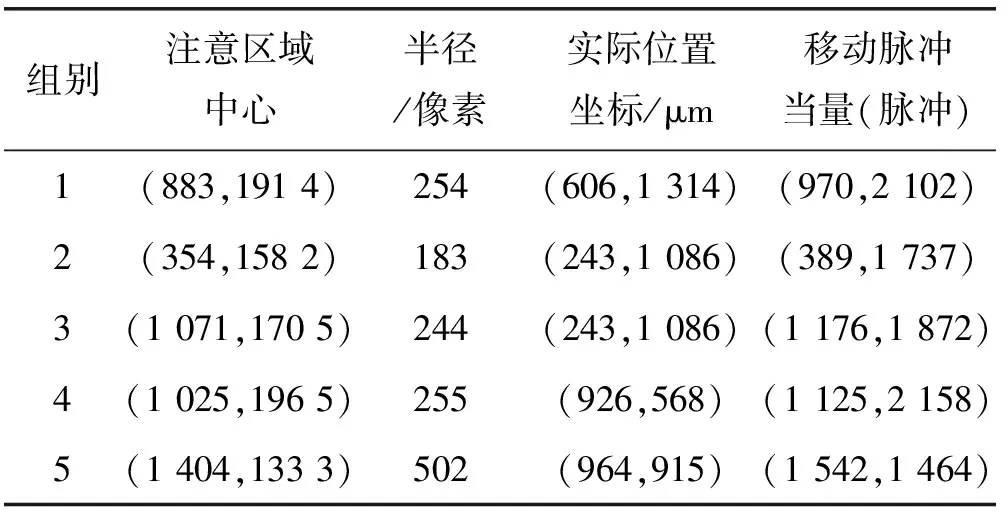

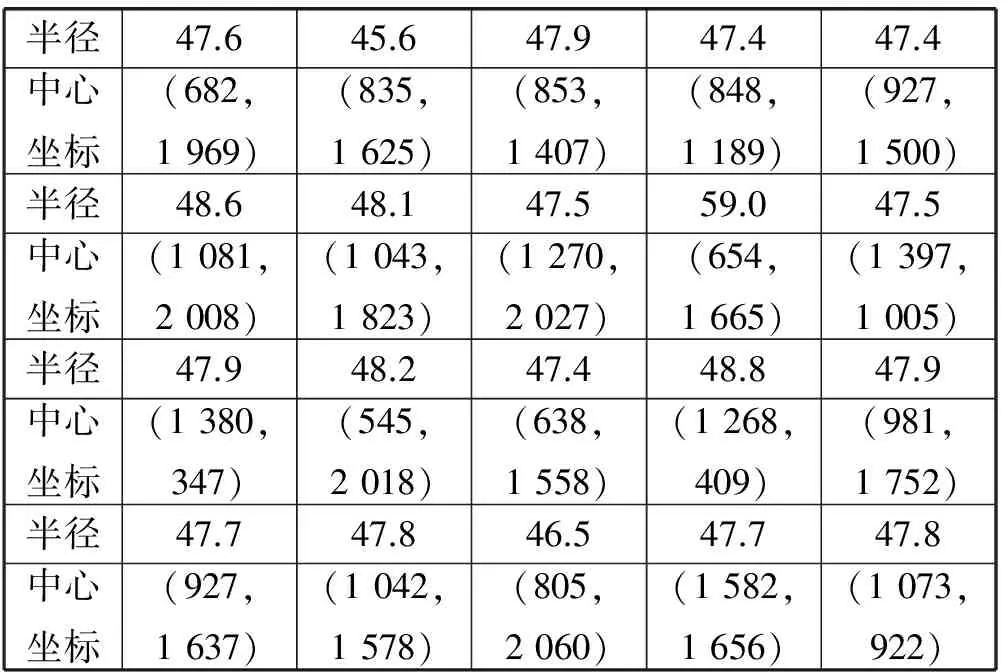

然后对待测的靶球进行大视场图像成像,为了验证视觉注意机制,尽量保证大视场图像下含有粘连堆聚的靶球。获得大视场图像之后,采用MATLAB编写程序进行注意区域的自动获取,得到5组大视场图像的视觉注意的数据如表2所示。

表2 视觉注意部分的数据

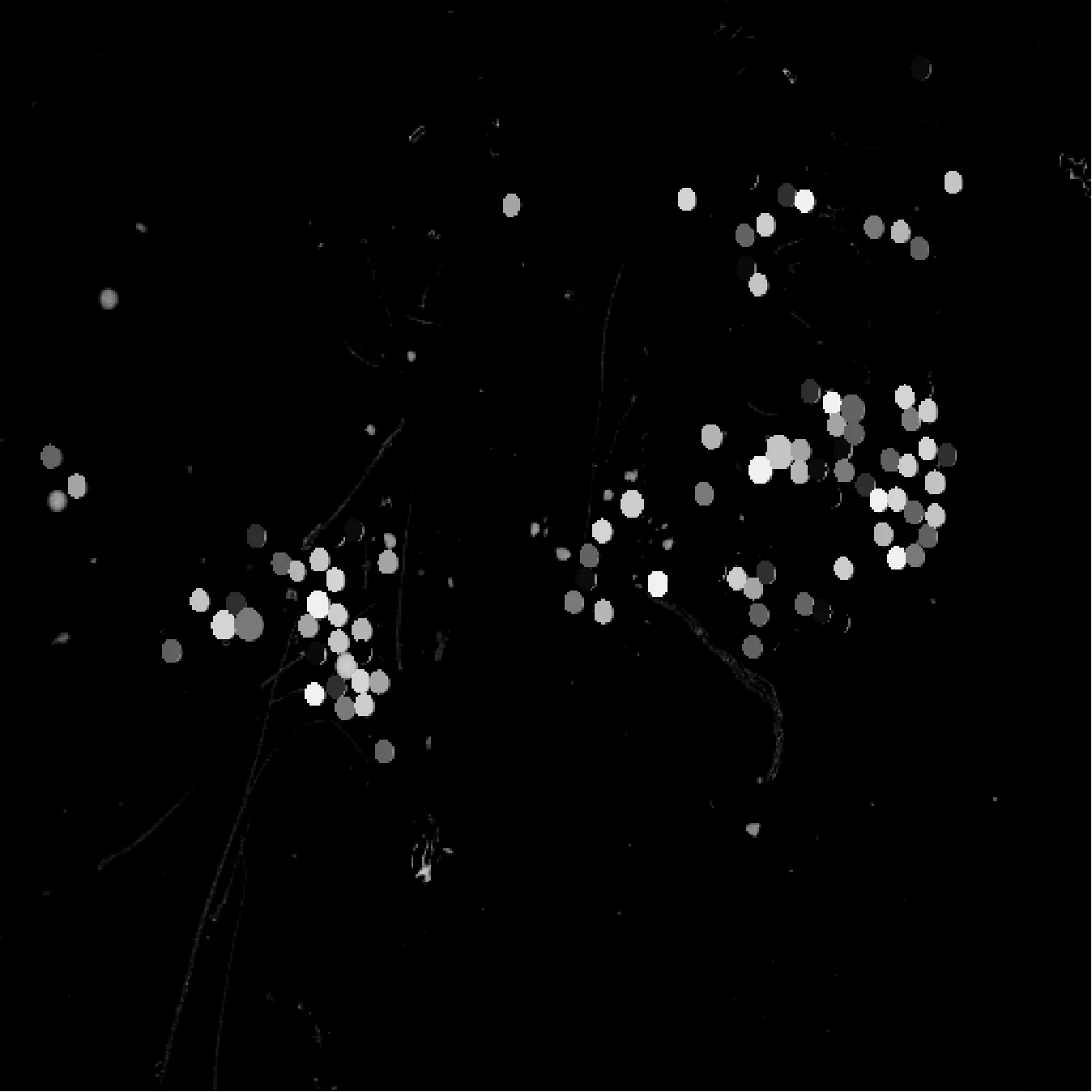

在得到注意区域的中心坐标之后,通过式(6)-式(8)得到三维精密位移台需要移动的脉冲数,控制高倍镜头移动,然后获取小视场图像。得到小视场图像之后,进行图像融合,融合前后的图像如图6所示。通过原始大视场图像与融合之后的大视场图像的局部图像之间的对比,可以看出融合之后的大视场图像清晰度明显提高,边缘接触部分更加明显,有利于进行边缘检测和提高最后的测量精度。

图6 图像融合前后的局部图像对比

在获得融合之后的大视场图像和标定数据之后,使用halcon软件对图像进行测量部分的处理:通过图像增强算子对图像对比度进行提高,采用分水岭算法对粘连边缘进行分割,使用canny算子对边缘进行提取,检测到各个单独的微靶球。然后对提取出来的微靶球进行直径、圆度、破损的测量和筛选,最后获得合格微靶球的中心坐标。

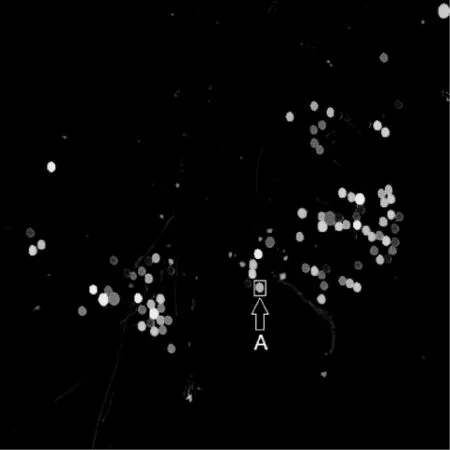

为了验证本文方法的检测精度,选用得到的五组图像中的第一组图像进行图像处理,得到的结果如图7所示。从图像中可以看到,破损、破裂等不符合要求的微靶球均已被过滤筛选掉,对于符合要求的微靶球,均可以检测到。实验证明,本文提出的方法可以准确地对微靶球进行筛选检测。

图7 测量结果图

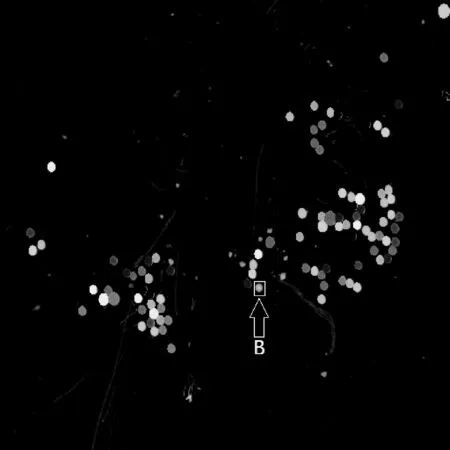

本文对选取的第一组图像进行对比实验,并使用相同的图像测量算法对原始大视场图像进行直接测量,得到的结果如图8所示。

图8 直接测量法的测量结果图

从测量结果图的对比来看,图7中标注的A所指的微靶球为合格品,但在图8中标注的B所指的微靶球却没有检测出来(原始图像中A与B的颜色不同,论文中图片压缩与灰度的原因导致差别不明显),出现了误检现象,而且对原始大视场图像进行测量时由于微靶球的粘连边缘不清晰,导致检测到的边缘与实际边缘有差距。

使用本文的方法得到的部分测量数据与直接对原始大视场图像进行测量的对应数据进行对比,如表3、表4所示。

表3 融合后图像的测量数据

表4 原大视场图像的测量数据

从两组测量数据的对比来看,直接对原始大视场图像进行测量得到的数据整体偏大,并且对应图8中的微靶球B没有测量数据。实验说明,融合小视场图像之后的大视场图像在测量时,更加准确,精度较高。

然后再使用图像拼接的方法对第一组的微靶球进行检测,比较本文方法的测量效率。在本实验中获得的大视场图像的视野大小为7.33×5.87×4.40(mm),小视场的视野大小为2.44×1.96×1.47(mm)。在对第一组图像进行测量时,使用本文的方法仅需要获取大视场图像与小视场图像各一张即可,使用图像拼接的方式至少需要获取9张小视场图像。图像拼接方法中的小视场图像如图9所示。

在获取到拼接图像的序列局部图像之后,对得到的9张局部图像进行图像拼接。得到拼接图像之后,使用相同的图像测量算法对拼接图像进行测量。图像拼接与图像测量均使用halcon进行编程。拼接方法得到的测量结果如图10所示。程序运行得到结果的时间如图11所示。

图10 拼接方法测量结果图

图11 拼接方法与本文方法运行时间图

从本文方法与拼接方法的测量结果图的对比来看,图7与图10的测量结果差别不大,两种方法都检测出了同样的合格微靶球。

使用拼接方法得到的与表3对应的测量数据如表5所示。

表5 拼接方法测量数据

从两组数据表3与表5的对比来看,两组测量的数据与测量结果图对应,差距很小,边缘接触部分的微靶球均可清晰地测量出结果,效果相同。

但是,从消耗时间的对比来看,在图像拼接方法中,由于需要控制三维位移台移动来获取9张图像,获取图像这一步骤消耗的时间过长,达到了6.5 s。而在本文的方法中,由于只需要获取2张图片,这个步骤只需要1.3 s。

在拼接方法中,获得局部图像之后的图像拼接与测量阶段运行时间由图11可得程序运行时间为158.6 ms;而在本文的方法中,最后的数据融合与测量部分程序运行时间为144.4 ms。因此,本文提出的方法能够有效提升测量的速度,大幅缩短测量时间。

综上所述,本文方法相对于直接测量的方法,测量精度高,微靶球检出率高;相对于图像拼接的方法,在保证测量精度的前提下,测量速度大幅提升,有效地提高了测量效率。

5 结 语

本文主要阐述了一种基于多视场转换的微尺度对象自动测量方法。该方法针对显微视觉下视野大小与分辨率高低的矛盾,设计采用视觉注意机制进行大视场与小视场之间的转换,使用ORB算法进行大视场图像与小视场图像之间的特征检测与特征匹配,得到融合图像最后通过图像处理进行测量。本文通过对微靶球的显微图像进行实验,实验结果表明,本文方法相对于直接测量方法能够有效提高测量精度和检测准确率,相对于图像拼接方法能够大幅提升测量效率且保证测量精度。本文方法结合了两种方法的优点,并且采用自动的方式进行测量,能够满足实际工业生产中高精度、自动化、快速化的要求。

[1] 杨晓京,王思琪.基于显微机器视觉的微纳米级构件的精密检测[J].计算机工程与应用,2017,53(5):227-230.

[2] 高媛媛.基于图像处理的CCD显微测量技术及应用[D].苏州大学,2008.

[3] 刘国阳.基于机器视觉的微小零件尺寸测量技术研究[D].哈尔滨工业大学,2014.

[4] Tohmyoh H,Suzuki M.Measurement of the coating thickness on the back side of double-sided coated structures by means of acoustic resonant spectroscopy[J].Surface & Coatings Technology,2009,204(4):546-550.

[5] Kannajosyula S P,Chillara V K,Balasubramaniam K,et al.Simultaneous measurement of ultrasonic longitudinal wave velocities and thicknesses of a two layered media in the absence of an interface echo[J].Review of Scientific Instruments,2010,81(10):105101.

[6] Good M S,Wend C F,Bond L J,et al.An estimate of biofilm properties using an acoustic microscope[J].IEEE Transactions on Ultrasonics,Ferroelectrics,and Frequency Control,2006,53(9):507-516.

[7] Raisutis R,Kazys R,Mazeika L.Ultrasonic thickness measurement of multilayered aluminum foam precursor material[J].IEEE Transactions on Instrumentation and Measurement,2008,57(12):2846-2855.

[8] 陈涛,陈立国,潘明强,等.基于压电驱动的靶球筛选操作机理及实验研究[J].压电与声光,2012,34(1):56-60.

[9] 石帅,张林,吴文荣,等.微靶装配中靶球几何量的高精度测量[J].强激光与粒子束,2012,24(8):1882-1886.

[10] 余金栋.基于计算机微视觉的亚微米特征尺寸测量理论与实验研究[D].华南理工大学,2014.

[11] 何博侠,何勇,卜雄洙,等.机器视觉多视场协同测量方法[J].光学精密工程,2012,20(12):2821-2829.

[12] 刘娟妮,彭进业,李大湘,等.基于谱残差和多分辨率分析的显著目标检测[J].中国图象图形学报,2011,16(2):244-249.

[13] 余瑞星,朱丹,高路,等.基于谱残差显著区域检测的图像分辨率归一化方法[J].西北工业大学学报,2014(6):872-876.

[14] 戴雪梅,郎朗,陈孟元.基于改进ORB的图像特征点匹配研究[J].电子测量与仪器学报,2016,30(2):233-240.

[15] 索春宝,杨东清,刘云鹏.多种角度比较SIFT、SURF、BRISK、ORB、FREAK算法[J].北京测绘,2014(4):23-26.

[16] Leng X F,Liu J Y,Zhi X.A real-time image matching algorithm for navigation system based on bifurcation extraction[J].Acta Automatica Sinca,2007,33(7):678-682.

RESEARCHONMULTIPLEFIELDSYNERGYMEASUREMENTMETHODFORTHEMICROSCALEOBJECTS

Liu Guohua1,2Li Tao1

1(SchoolofMechanicalandElectronicEngineering,TianjinPolytechnicUniversity,Tianjin300387,China)2(AdvancedMechatronicsEquipmentTechnologyTianjinMajorLaboratory,TianjinPolytechnicUniversity,Tianjin300387,China)

Aiming at the problem that the micro visual horizons is small and cannot be measured at a small target all at once, a multiple filed synergy measurement method for micro scale object is proposed. This method extracts the region of interest from low resolution large FOV(field of view) image by spectral residual visual attention model establish brightness saliency map, and obtains the high resolution small FOV image from the region of interest. Then, the large FOV image is matched with the small FOV image by the ORB algorithm, and the small FOV image is fused into the large FOV image. Finally, the obtained high-resolution image is processed by image processing, and the data needed to be measured is returned. Experimental results show that the proposed scheme has high measurement accuracy, and can realize the automatic measurement for micro scale objects.

Micro scale object Automatic measurement Visual attention Multiple field of view Feature matching

2016-08-31。天津市科技支撑计划重点项目(16YFZCSY00860)。刘国华,副教授,主研领域:机器视觉,机器人控制技术。李涛,硕士生。

TP3

A

10.3969/j.issn.1000-386x.2017.08.020