自动评价系统与大学生英语写作质量

2017-08-07冷兆杰于志涛

冷兆杰,于志涛

(山东理工大学 外国语学院,山东 淄博 255000)

自动评价系统与大学生英语写作质量

冷兆杰,于志涛

(山东理工大学 外国语学院,山东 淄博 255000)

自动写作评分系统是网络技术应用于外语写作教学一个典型的表现。借助句酷批改网在大学生中进行在线自动写作实验,旨在探讨句酷批改网的自动反馈功能对大学生英语写作质量的影响。以非英语专业的两个班为实验班和对照班,通过为期14周的教学实验,采用基于句酷自动评价系统的大学英语写作教学模式和传统大学英语写作教学模式,分别对实验班和对照班进行英语写作教学。对实验数据用SPSS17.0进行统计分析,结果显示:实验班在写作成绩及主要写作质量指标上都显著高于对照班;在线自我多次修改可以明显提高作文成绩,但作文修改次数与作文最终分数之间相关性不大。研究结果表明,句酷自动评价系统不仅对提高大学生英语写作质量产生积极影响,同时在大学英语写作教学上也发挥重要的作用。

大学英语;自动评价系统;英语写作质量

一、引言

教育信息化日新月异的飞速发展和普及,使得网络技术对高等教育的辅助教学作用日益凸显。自动写作评分系统(automated essay scoring,以下简称AES)就是网络技术应用于外语写作教学的一个典型表现[1]62-67。国内学者在逐渐关注并进行作文自动评分系统的研究之后,自主研发出了写作评分平台。北京词网科技有限公司研发的“句酷批改网”就是其中一例,该平台提供在线即时反馈、同伴互评、教师手动评分和过程监管等功能,目前已经在国内多所高校推广使用。但关于该平台对大学生写作质量的实证研究并不多见。为此,本研究借助句酷批改网,在大学生中进行在线自动英语写作实验,旨在探讨句酷批改网的自动反馈功能对大学生英语写作质量的影响。

二、文献综述

(一)自动写作评价系统(AES)

AES是依据有效、公正和可靠的原则,利用计算机专业化的程序对作文文本特征进行评估与打分。AES的研发是机辅语言测试走向智能化的具体体现[2]23-40。目前国外最著名的AES系统包括IEA(Intelligent Essay Assessor)、E-rater(Electronic Essay Rater)和PEG(Project Essay Grader)[3]25-39。IEA是基于一种潜在语义分析软件的运用,对文本的文体特征和语法进行评估,也可对其用词、组织结构、思想内容等进行诊断性和评估性评价与反馈,更多关注文章内容的质量特征,并能发现抄袭现象[4]87-112。E-rater采用基于微软自然语言处理的工具包和语料库的建模方法,从作文的句法多样性、思想的组织和词汇的丰富性等方面分析文章的语言学特征,然后对照人工评分的标准对作文进行评分。但是该系统最大的问题是不能判别内容跑题但没有语法错误的作文[5]3-29。PEG使用代理量度标准(proxy measures)来衡量作文的内在质量,更多关注作文的表层结构,完全依靠对文章的浅层语言学特征的分析对作文进行评分,根本没有涉及文章内容[6]319-330。其目的是使大规模作文评分过程更实际有效[7]37。但内在质量,如写作的流畅性、句子结构的复杂度、文章的措辞等难以用计算机直接测量。该系统不足之处就是写作者会利用对写作技巧的间接测量欺骗计算机,如写出文理不通的长句以获取句法结构复杂的高分[8]27-31。PEG虽重视语言质量,却对文章内容有所忽略;IEA重视写作内容,但对文体的篇章结构和语言分析不足;E-rater则能较好地兼顾语言、内容及篇章结构[9]18-24。但这些评分系统主要使用于英语本族语者,对中国英语学习者的英语写作不太适用。

近年来,国内有部分学者在积极探索研发适合中国学生的写作自动评价系统,梁茂成的大规模考试英语作文自动评分系统就是其中主要的研制案例。该系统基于大量人工评分的中国学生作文语料库建立评分模型,兼取PEG和IEA之长,对作文从语言、内容和架构三个方面进行评价,取得了较高的评分准确率[10]82。除此之外,还有一些有待商榷的在线英语自动评分系统,目前运用较多的有博客、“易得”及当前在国内多所高校推广使用的句酷批改网。部分学者对此类软件的教学效果进行了有益的探索和实验研究。杨永林介绍了清华大学外语系研发的“易得”写作软件的理论背景、应用功能、技术探索和系统设计过程[11]3-9。葛诗利和陈潇潇针对大学英语作文自动评分研究中存在的问题提出了如何使自动评分高效而准确的对策[12]21-26。石晓玲以句酷批改网为实验工具,对在线自动评改系统在英语写作教学中的应用模式进行了积极探讨[13]67-71。吴一安等着重分析了融入自动评价系统的英语写作实验教学对高校英语教师的影响[14]3-10。由于句酷批改网2012年初才开始投入使用,目前对这种全新的智能评改系统在大学英语写作课堂教学中的应用和效果的调查研究屈指可数。

(二)句酷评价系统简介

本研究所涉及的句酷批改网是北京词网科技有限公司研发的一套基于语料库和云计算的英语写作自动批改在线服务系统,目的在于减轻教师的作文批改工作量,帮助教师更加直观地了解学生的写作进程及英文写作水平,同时也能激励和指导学生积极修改作文,培养自主学习能力,提高其英语写作水平。该系统具有使用便捷、即刻反馈、按句点评、弱点分析、抄袭检测等功能,越来越受到高校教师的认可。教师在线布置,学生在线写作,根据要求完成后立即提交,学生只需等待几秒钟,就能得到系统给出的成绩、按句点评和综合评语等反馈信息。系统在指出作文每一句中存在的拼写、语法、词汇、搭配等错误的同时,逐一给出修改建议,学生如能根据反馈修改后再次提交,会得到比先前更高的分数和评价。另外,还为学生提供了包括词汇拼写、句法检查、同义词提示、搭配推荐、标点警示、参考例句等一系列的提示和建议,为学生提供全面的写作指导,便于学生有效创作,自主修改。系统还为老师提供了学生成长轨迹记录报告,把学生的整个写作过程、写作时间、在线学习的痕迹、修改轨迹和提交的次数等数据记录下来。通过统计、分析、归纳这些数据,教师可以更好地了解学生英语写作的状况,发现学生写作练习时常遇到的共性问题以及相关缺点,并可据此科学地调整教学方案,对学生作文进行客观且有针对性的辅导。

三、研究设计

(一)研究问题

本研究拟解决以下问题:

第一,自动评价系统(句酷批改网)是否会明显提高写作成绩?

第二,自动评价系统对作文字数、词汇、语法、篇章结构等写作质量指标是否有影响?

第三,根据句酷反馈进行的自主修改对作文平均成绩是否有影响?

第四,作文自主修改的次数与最终成绩之间有何关系?

(二)研究对象

本研究选取的对象为山东理工大学2015级非英语专业两个教学自然班,共120名学生,这两个班被随机定为实验班和对照班,每班60人,其中男生73人,女生47人。在实验周期,两个班的教学进度、课堂内容和授课方法保持一致。

(三)研究工具

本研究采用的工具为学生的作文成绩,包括两个班实验前测、后测的写作成绩。前测和后测所用的作文试题均采用英语四、六级考试中常用的议论文体裁,字数要求不少于200词,写作时间为50分钟,满分为100分。

考虑到人工阅卷工作量大、效率低等客观因素以及不可避免的人为主观因素,可能会导致评卷结果的不合理,影响实验的效度和信度。因此,本研究两个班前测和后测的作文使用了句酷批改网进行在线评阅。教师利用该系统的教师管理系统关闭相关的写作辅助功能,要求学生现场定时写作,然后原样录入计算机,提交句酷批改网进行评分。

(四)研究过程

本研究的实验周期为期14周,学生先后完成7篇写作任务,每一篇作文的修改时间均控制在二周。为确保实验相对真实有效,两个班写作练习的题目及写作时间安排是相同的。考虑到学生的专业差异,所选写作话题都属通识性内容,适合不同水平的写作学习者。

实验班利用句酷批改网在线写作平台进行英语写作,教师不对写作任务进行其他任何讲解和评价。在实验周期,研究者经常提醒学生按时提交作文及修改作文,学生根据系统的反馈功能进行自主多稿修改,多次提交,直到最终的分数满意为止。

对照班进行的是教师书面评语反馈为主的传统写作教学模式。在学生第一稿完成后,教师便从组织结构、思想内容、词汇运用、拼写及语法等方面,对学生的作文进行全面批改。批改后发回给学生,要求学生按照教师的书面点评重新修改,但是由于人工批改耗时、工作量大,对修改后的作文教师将很难重新批阅。

(五)数据收集

笔者分别提取了两个班实验前后两次写作的测试成绩,以及实验班第七次作文的提交次数、作文分数、作文字数、词汇丰富度、平均句长、从句总数、篇章连次数等信息,采取Word和Excel等软件进行存储整理,并使用SPSS17.0对实验数据进行分析,运用独立样本T检验两个班作文成绩是否存在显著差异,运用配对样本T检验分析自动作文修改对作文平均成绩的影响,运用皮尔逊相关性(Pearson Correlation)分析检验作文修改的次数与最终成绩的关系。

四、研究结果与分析

(一)自动评价系统对写作成绩的影响

1.实验班、对照班前测作文成绩对比分析

如表1所示,就前测成绩而言,实验班和对照班在相同分数段上人数非常接近,说明在相同分数段上,两个班的成绩差距不大。实验班前测作文分数的均值为69.28,对照班的均值为69.52,分差为0.24,差距甚微。独立样本T检验可以看出前测双尾T检验的显著性概率为P=0.714,大于0.05的显著水平。说明前测对照班和实验班无显著性差异,可以认为这两个班英语水平相当,符合实验条件。

表1 实验班对照班前测作文成绩对比分析(单位:篇)

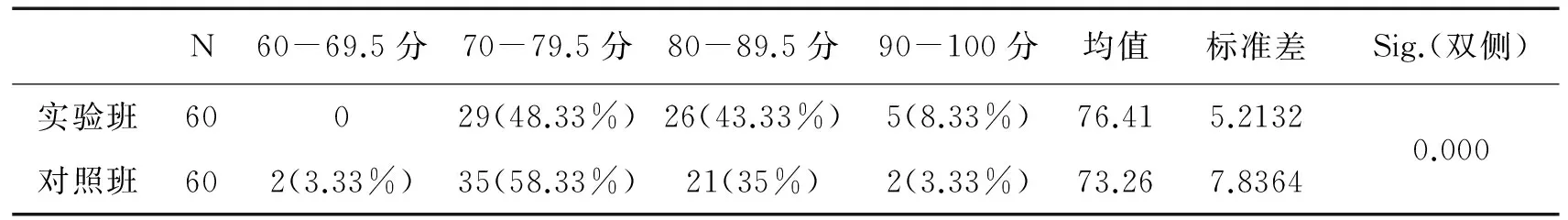

2.实验班、对照班后测作文成绩对比分析

表2显示,在实验后测,实验班所有作文均达到了70分或者70分以上,其中70—79.5分数段作文降至29篇(前测37篇);80—89.5分数段增至26篇(前测13篇),占样本总数的43.33%;90—100高分段升至5篇(前测1篇),占样本总数的8.33%。对照班60—69.5分作文2篇;70—79.5分数段作文35篇;80—89.5分数段21篇,占样本总数的35%;90—100高分段仅2篇,占样本总数的3.33%。实验班作文分数的均值为76.41,而对照班的为73.26,两个班的平均分已经有了3.15分的差距。从两个班的独立样本T检验看出,后测显著性概率为P=0.000,远小于0.05,说明后测两个班成绩差异显著,具有统计学的意义。由此可见,句酷评价系统会明显提高写作成绩。

表2 实验班对照班后测作文成绩对比分析(单位:篇)

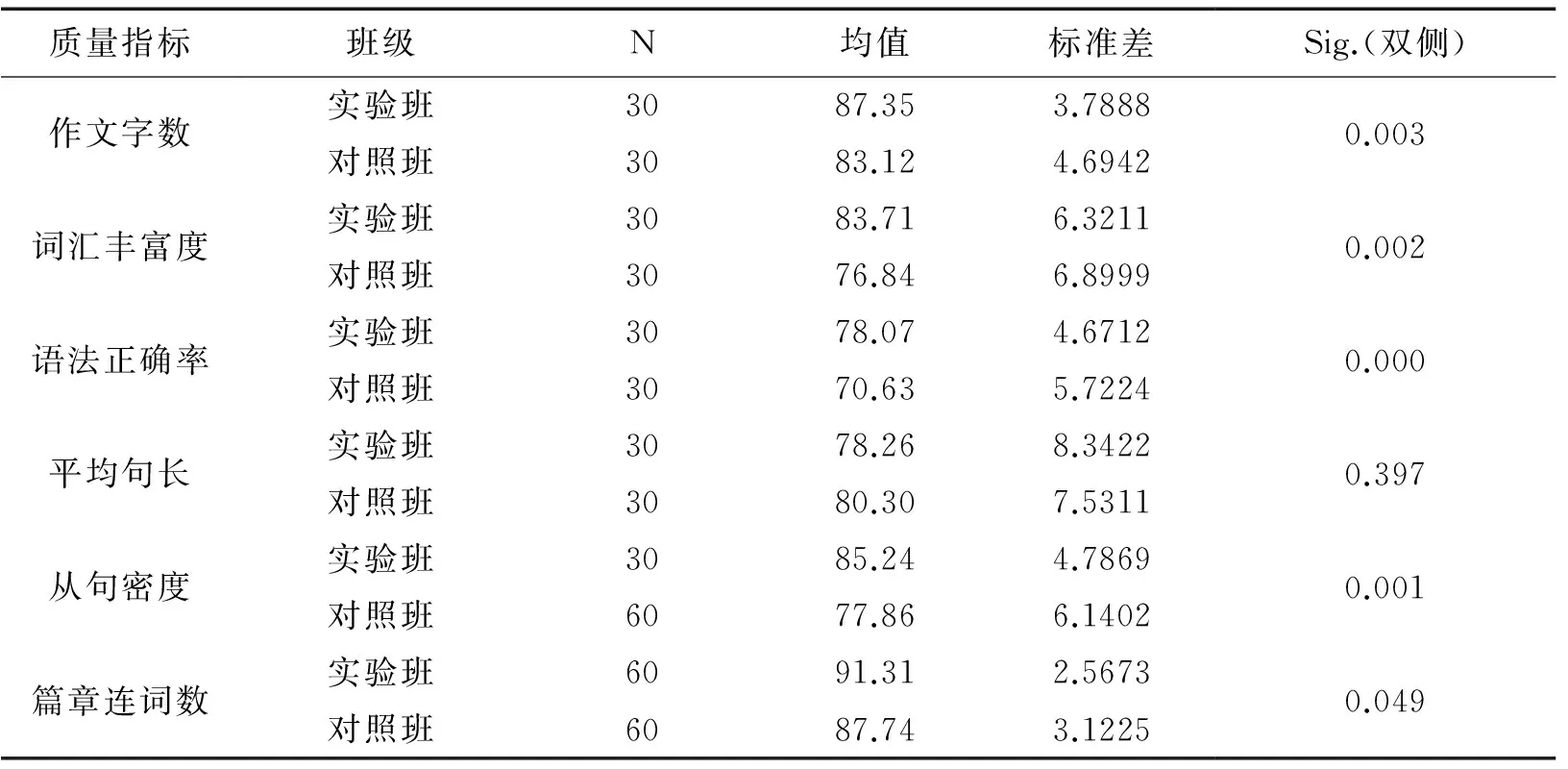

(二)自动评价系统对写作质量指标的影响

英语作文的写作质量应依据文本的字数、词汇丰富度、语法正确率、句子长度、从句密度及篇章连次数等多个质量指标进行综合考评。为了进一步了解实验班和对照班在写作质量提高上的差异,在两个班的后测作文中每个班随机抽出30篇作文作为样本进行了独立样本T检验(见表3)。

表3 两个班后测作文质量指标描述性统计*批改网评分引擎共有192个评分指标,本研究中只选取部分指标进行分析。为使指标测量数据直观且可比,已将指标测量数据转化为对应百分制分数。特别声明,在特定评分标准中各指标权重不同,故总分为各指标得分加权平均结果,而非直接求和结果。

由表3看出,实验后,除了平均句长这一指标,实验班其他质量指标的均值都比对照班的要高,尤其在词汇丰富度、语法正确率和从句密度这三个指标上的提高最为明显。

王初明等认为写长作文有助于提高学生的英语水平[15]207-212。另外,《大学英语教学要求》对写作能力所规定的一般、较高和更高的等次要求也反映在字数上,依次为半小时写出120词、160词和200词的英语短文。这说明作文字数是衡量写作能力的一个主要指标。本研究在作文字数这一指标上,实验班为87.35分,对照班为83.12分。独立样本T检验数据显示,实验班作文的长度比对照班有了显著增加(P=0.003)。

词汇丰富度主要用来衡量学生作文中使用不同单词的比重有多高,这一数值越大说明学生使用词汇的范围越宽。词汇丰富度能够较全面反映语言学习者的词汇使用情况。表3的数据显示,在词汇丰富度方面,实验班的均值比对照班高出了6.87分。独立样本T检验可以看出后测词汇丰富度显著性概率为P=0.000,小于0.05,两个班差异显著,说明实验班词汇丰富度有显著提高,学生对学术词汇及高级词汇的使用比率增大,更注重词汇选择的多样性。因为在每次提交作文后句酷批改网都会给出低频词汇和高频词汇提示,并提供一些高分词汇及习惯搭配供学生借鉴。

句子语法正确率也是衡量写作质量的重要指标。实验班在该指标上比对照班高出了7.44分,有较明显增长。独立样本T检验数据显示,显著性概率为P=0.000,小于0.05,差异显著,具有统计学的意义。究其原因,句酷系统最大的优点就是能够自动识别学生作文中常见的语言错误,给出及时的反馈及修改提示,学生按照系统反馈进行修改极大地提高了句子语法的准确度。与批改网的及时反馈相比,现实中学生从老师那里得到对英语作文的反馈相对迟滞,学生上交的英文作文往往要在半月之后才有批复,收到反馈时很多学生甚至都忘记了当时的写作内容。

虽然长难句的使用能够考查学生的语法功底,而且平均句长也属于写作的一个质量指标,但是并不意味着所写的长难句越多,作文分数就一定越高。也就是说,作文的质量并不是句子越长分数越高,关键是看句子的应用是否准确和句式的多样化。从表3的数据来看,实验班平均句长的均值比对照班低了2.04分,且两个班作文平均句长的差异未达到统计学上的显著水平(P=0.397>0.05),可见两个班的平均句长没有显著的差别。

从句密度是考核写作质量的另一个重要指标。数据显示在这一指标上,实验班的均值为85.24分,对照班为77.86分,均差7.38分。研究者发现,实验后实验班从句总数相比对照班得到显著增加,学生在接受句酷自动反馈后简单句使用量明显减少,从句的平均使用量均有大幅提高,作文中句式更加丰富,且两个班的差异达到显著性水平(P=0.001<0.05),表明句酷评价在一定程度上有助于提高学生使用不同类型从句的能力。

句子的衔接紧密、段落关系的明晰连贯,往往决定一篇文章的质量。连接词作为衔接和连贯的手段之一,也是作为衡量一篇文章好坏的又一个关键性指标。尽管本研究中两个班篇章连词数的变化不大,但差异也达到了统计意义上的显著水平(P=0.049)。

综上所述,实验班后测的作文质量在字数、词汇丰富度、语法正确率、从句密度以及篇章连词数等关键指标上均有显著提高,但在非关键指标平均句长上没有显著差异。

(三)自主作文修改对作文平均成绩的影响

在没有教师批改和反馈的情况下,学生的平均作文分数在自我多次修改后是否会得到显著提高呢?笔者将实验班第七次网上写作任务作为研究样本,通过对提交的60篇作文的初始成绩与最终成绩进行配对样本T检验,得到表4的结果。

表4 初始成绩与最终成绩的配对样本T检验

表4显示,本次写作任务平均初次成绩为72.36分,平均最终成绩为80.12分,均差7.76分,双尾t检验的显著性概率为P=0.000,说明学生的作文平均分数在自我多次修改后得到显著提高。

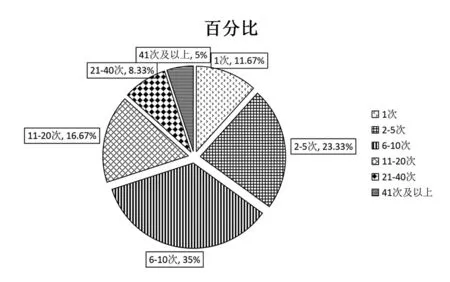

图1 修改次数分布情况

图1数据表明,参与此次写作活动的学生作文平均修改次数为4.16,即在老师看到其最终版本之前,学生已经自主修改了4.16次。修改2次及以上的篇数为53篇,占比88.33%;5%的学生修改文章超过40次以上,说明有越来越多的学生愿意根据系统提供的反馈来修改作文。

(四)作文自主修改的次数与最终成绩的关系

那么作文成绩的末首次分差与自我修改次数是不是有相关性?换句话说,学生根据系统的反馈自主修改作文是不是次数越多成绩越高呢?对此,我们通过分析实验班第七次作文的末首次分差与自主修改次数的皮尔逊关联系数,来加以说明。

由研究数据可知,60篇作文的末首次分差与自主修改次数的关联系数只有0.216,相关性不强,且显著性水平达到0.763,已远远大于0.05。由此可见,作文成绩的能否提高与学生自主修改的次数相关性不大。研究者发现导致这种情况的主要原因在于:第一,有些受试抱着“闯关游戏”的心理,受功利性目的驱使,有效修改的幅度很小,大多只会修改单词拼写、措辞和简单语法等浅层面就提交,看与前次作文分数的差别。钟彩顺认为低层次语言层面的自主修改,对作文质量的影响有限[16]81-88。其次,修改次数的增加,导致作文已经达到受试英语写作水平的上限,即使再多的修改对作文成绩的提高影响不大。

五、结论

本研究发现,相比教师书面反馈为主的英语写作教学,句酷自动评阅系统支持下的英语写作教学对更好地提高大学生英语写作成绩和写作质量,都有积极的作用和影响,尤其是对作文长度、词汇丰富度、语法正确率和从句密度的影响尤为显著,但是对句子长度的影响并不显著。本研究还发现,在句酷自动评阅环境中,在自我多次修改后学生的平均作文分数会得到显著提高,但是自我修改的次数与作文最终成绩的提高相关性不大,相比于修改次数,修改质量更为重要。

综上所述,句酷自动评阅系统以现代信息技术,特别是网络技术为支撑,使英语的教与学不受时间地点的限制,朝着个性化和自主式学习的方向发展。随着网络技术的快速发展和推广,自动作文评阅系统定将被广泛地应用到英语写作教学中去,它不仅很大程度上减轻了教师的教学负担,而且能给学生提供个性化的写作指导和反馈,进而更加有利于培养学生自主学习的兴趣与能力,从本质上激发出其学习潜能,实现大学生英语写作水平提高的终极目标,因此句酷自动评阅系统能够在大学英语写作教学中发挥重要的作用。

[1]翁克山,李青.ACMC环境下英语写作同侪互评质量与效能研究[J].解放军外国语学院学报,2013,36(4).

[2]Chung,G.K.& Baker,E.L.Issues in the Reliability and Validity of Automated Scoring of Constructed Responses[M]// Shermis,M.D.& Burstein,J.(eds.).Automated Essay Scoring:A Cross-Disciplinary Perspective.Mahwah,NJ:Lawrence Erlbaum Associates, 2003.

[3]Ramineni,C.& Williamson,D.M.Automated Essay Scoring:Psychometric Guidelines and Practices[J].Assessing Writing,2013,18(1).

[4]Landauer,T.K.,Laham,D.& Foltz,P.W.Automated Essay Scoring and Annotation of Essays with the Intelligent Essay Assessor[M]//Shermis,M.D & Burstein,J.(eds.).Automated Essay Scoring: A Cross-Disciplinary Perspective. Mahwah,NJ: Lawrence Erlbaum Associates, 2003.

[5]Attali,Y.& Burstein,J.Automated Essay Scoring with E-Rater V.2[J].Journal of Technology,Learning,and Assessment,2006,4(3).

[6]Valenti,S.,Neri,F.& Cucchiarelli,A.An Overview of Current Research on Automated Essay Grading[J].Journal of Information Technology Education,2003,24(2).

[7]Page,E.B.Project Essay Grade:PEG[M]// Shermis,M.D.& Burstein,J.(eds.).Automated Essay Scoring:A Cross-Disciplinary Perspective.Mahwah,NJ:Lawrence Erlbaum Associates,2003.

[8]Kukich,K.Beyond Automated Essay Scoring[J].IEEE Intelligent Systems,2000,15(5).

[9]梁茂成,文秋芳.国外作文自动评分系统评述及启示[J].外语电化教学,2007,(5).

[10]梁茂成.大规模考试英语作文自动评分系统的研制[M].北京:高等教育出版社,2011.

[11]杨永林.宏大叙事与技术精巧——再论“易得”文章利器的妙用[J].外语电化教学,2006,(1).

[12]葛诗利,陈潇潇.大学英语作文自动评分研究中的问题及对策[J].山东外语教学,2009,30(3).

[13]石晓玲.在线写作自动评改系统在大学英语写作教学中的应用研究——以句酷批改网为例[J].现代教育技术,2012,22(10).

[14]吴一安,唐锦兰.融入自动评价系统的英语写作实验教学对高校英语教师的影响研究[J].外语电化教学,2012,(4).

[15]王初明,牛瑞英,郑小湘.以写促学——一项英语写作教学改革的试验[J].外语教学与研究,2000,32(3).

[16]钟彩顺.基于在线自动反馈的自主写作修改研究[J].解放军外国语学院学报,2015,38(4).

(责任编辑 李逢超)

2017-04-01

山东省社科基金项目“应用型人才培养背景下大学英语多元化教学改革的研究与实践”(15CWZJ17);山东省教育科学厅级项目“元话语理论在大学英语口语教学中的应用研究”(YBW15008)。

冷兆杰,女,山东莱阳人,山东理工大学外国语学院副教授,英语语言文学硕士;于志涛,男,山东高青人,山东理工大学外国语学院副教授,教育学硕士。

H319

A

1672-0040(2017)04-0107-06