基于对称帧差和分块背景建模的无人机视频车辆自动检测

2017-07-26蔡晓禹张有节李少博

彭 博 蔡晓禹 张有节 李少博

(重庆交通大学交通运输学院, 重庆 400074)

基于对称帧差和分块背景建模的无人机视频车辆自动检测

彭 博 蔡晓禹 张有节 李少博

(重庆交通大学交通运输学院, 重庆 400074)

为了从广域的视角准确全面地识别交通流信息,针对无人机视频提出了基于对称帧差和分块背景建模的车辆自动检测方法.首先,对视频图像进行4×4降维处理和灰度化处理,并人工勾勒出感兴趣区域(ROI),以降低图像维度,划定检测区域;其次,利用对称帧间差分法提取ROI中的运动目标,并在此基础上应用分块背景建模获得背景图像;然后,通过背景差分初步提取车辆信息;最后,基于形态学处理等方法消除噪声,实现车辆识别.此外,提出了针对车辆识别算法的正检率、重检率、漏检率和错检率4个评价指标.基于150帧无人机视频图像对算法进行测试,结果表明:算法具有较高的正检率(均值92.29%)、较低的漏检率(均值7.31%)与错检率(均值0.39%),而重检率为0.

智能交通;车辆检测;对称帧间差分;背景建模;无人机;感兴趣区域

在现代交通系统中,基于视频的交通信息检测是一种重要的交通信息采集技术.由于其具有可视化、安装维护便捷、可获取多种交通参数且不破坏路面结构等优势,在交通监控管理和交通研究等领域得到了广泛的应用,国内外学者也对车辆视频检测进行了长期的研究[1].

近年来,无人机因其具有成本低、检测范围广、不受地面交通干扰、可获取多种交通参数等优势,越来越受到交通研究人员的关注[2-9].从2002年起,美国[2]、德国[3]、西班牙[4]、俄罗斯[5]、韩国[6]及中国[7-9]等国家的交通管理局和高校等机构先后展开了无人机在交通领域的应用研究.研究者一致认为,基于无人机视频进行实时的交通信息采集和交通监控具有很大潜力,但也面临着车辆识别难度高、计算量大等挑战.

为此,人们展开了一系列与无人机视频车辆检测相关的研究,例如:Coifman等[10]使用无人机采集城市道路交通流信息,结合GIS平台提取交通流量、密度、平均交通量、道路服务水平等;Cheng等[11]针对无人机图像,利用背景消除和背景配准技巧来识别动态车辆;刘慧等[12]针对背景像素的移动,提出了SURF特征稳像和光流法向量相结合的新方法来解决低空视频的道路车辆检测;谭雄等[13]针对无人机视频背景位移的特点进行全局运动补偿和背景位移消除,然后实现车辆检测与跟踪;张新[14]利用背景差分法进行车辆检测,以此为基础提取交通信息并将其用于城市道路车辆跟踪模型的标定;Azevedo等[15]基于中值背景差分法检测遥感图像中的车辆;周雨阳等[16]基于无人机视频计算交叉口行驶车辆的速度、加速度、车头间距等车辆运行参数.

综观这些既有方法,大都采用车辆检测方法对低空视频、遥感图像和无人机视频进行车辆跟踪和交通参数提取,而专门针对无人机视频车辆检测方法的研究还比较少见,也很少进行定量的评价分析.

因此,本文提出一种基于对称帧间差分处理和分块背景建模的无人机视频车辆自动检测方法,建立了车辆检测算法评价指标体系,并基于150帧无人机视频图像对算法进行了测试与分析.

1 方法简介

本文基于背景建模方法进行无人机视频的车辆检测,使用的视频数据由国内某品牌无人机悬停于道路正上方50~100 m处、摄像机镜头以-90°(即垂直朝下)拍摄,视频分辨率为3 840×2 160像素.主要步骤如下:

① 图像预处理.对无人机视频的帧图像进行降维处理和灰度化处理,同时人工勾勒出感兴趣区域(ROI).

② 背景模型建立.通过对称帧间差分处理获得初步的运动目标图像,在此基础上应用分块背景建模思想生成背景图像.

③ 车辆检测.通过背景差分、图像去噪等处理,获得车辆检测结果.

2 原始图像三重预处理方法

图像预处理方法主要包括3个步骤:图像降维、感兴趣区域绘制和图像灰度处理.

2.1 图像降维预处理

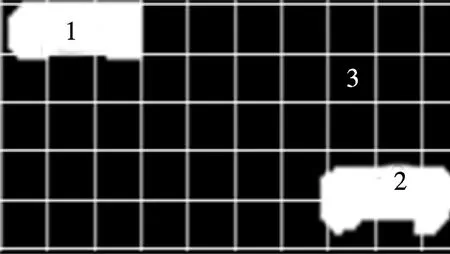

无人机视频的原始帧图像(3 840×2 160像素)如图1所示.对该图像进行4×4降维处理,图像尺寸降低为960×540像素,从而可降低计算量,缩短计算时间.

图1 无人机视频原始图像示例

2.2 图像勾画预处理

无人机视频的场景较广,但车辆识别时仅需针对特定道路范围的图像进行处理,因此需要勾画感兴趣区域,使得后续车辆检测程序只针对该区域展开运算,进而大幅降低算法复杂度,节省运行时间.绘制的感兴趣区域如图2中线框所示.

图2 绘制的感兴趣区域

2.3 图像灰化预处理

根据既有视频和图像识别研究的常见做法,将降维图像转化为灰度图像,如图3所示.

图3 降维灰度图像

3 基于对称帧间差分处理的背景图像生成

通过对称帧间差分处理获得初步的运动目标图像,在此基础上应用分块背景建模思想生成背景图像.

3.1 对称帧间差分处理

对称帧间差分处理的输入图像为连续3帧降维灰度图像(第i-1,i,i+1帧),简记为Ii-1,Ii,Ii+1.对称帧间差分处理主要包含差分处理、中值滤波和图像二值化3个处理环节.

(1)

(2)

(3)

3.2 运动目标图像初步识别

图5 运动目标初步识别结果Bi

3.3 分块背景建模

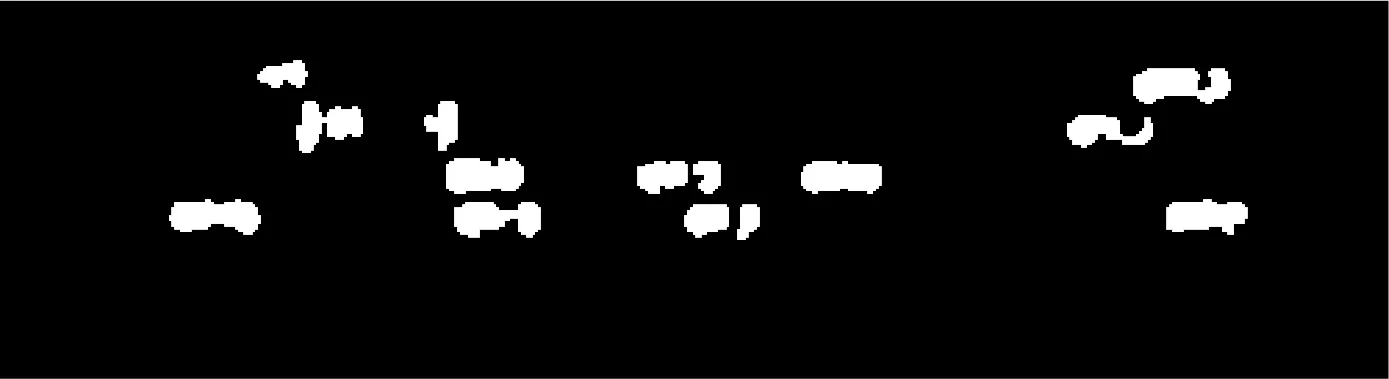

本文提出了一种基于对称帧间差分的分块建模方法,流程如图6所示,其主要步骤说明如下:

图6 背景建模流程图

① 初背景图像Ib的尺寸与对称帧间差分结果Bi及降维灰度图Ii一致.

② 子块划分.将Bi,Ii,Ib均划分为M×N个子块(子块大小根据实际情况而定,例如取M=48,N=27,则子块尺寸为20×20像素).Bi的像素分为前景像素(白色像素,代表运动目标)和背景像素(黑色像素,代表背景),因而Bi的子块可能存在如下3种情况:背景子块(全为背景像素,如图7中子块3)、含背景像素和前景像素的子块(如图7中子块2)、前景子块(全为前景像素,如图7中子块1).

③ 生成背景图Ib.当Ib中M×N个子块均生成背景时,背景图像Ib才成功生成.因此,首先经过j++循环,对Bi的所有子块进行背景判断,如果成功生成Ib,则背景建模完成.否则,需要进入i++循环,进行下一轮对称帧间差分处理,获得更新后的Bi,再进行子块背景判断,直到Ib中M×N个子块均生成背景.

图7 Bi的子块划分示例

通常情况下,背景建模过程中将多次进入i++循环,即会多次调用对称帧间差分处理程序,然后才能成功生成背景图像,如图8所示.

(a) 生成部分背景子块的Ib

(b) 成功生成的背景图像Ib

4 基于背景差分的车辆识别

对于无人机视频的任意一帧降维灰度图像(第k帧,记为Ik),通过背景差分法获得差分图像,然后进行去噪和车辆识别.

4.1 背景差分处理

对Ik与Ib进行绝对差分计算,获得差分图像Dk,如图9所示.计算公式如下:

(4)

(a) Ik

(b) Dk

4.2 图像去噪

为了初步消除背景差分图像噪声,采用2×2像素尺寸的中值滤波算子对Dk进行滤波处理,然后采用对称帧间差分处理过程中用到的图像二值化方法生成Dk的二值化图像Bk,如图10所示.

图10 去噪二值图像Bk

4.3 车辆识别

为了准确识别车辆目标,需要剔除路面标线、小型目标(摩托车、自行车和行人)等干扰因素,最终实现车辆轮廓定位.为此,对Bk进行了如下操作:① 膨胀和内轮廓填充操作,主要目的是补空洞边缘、增强目标完整性和连续性.② 腐蚀操作,主要目的是使所有目标区域向内收缩,消除部分尺寸较小的噪声.③ 去噪处理,对于图像中的任意前景区域,当其面积较小或过于狭长时,判定为噪声予以剔除.④ 车辆识别,对于任意前景区域Ωm,A(Ωm)表示Ωm的面积,R(Ωm) 表示Ωm的最小外接矩形长宽比,当其满足如下条件

(5)

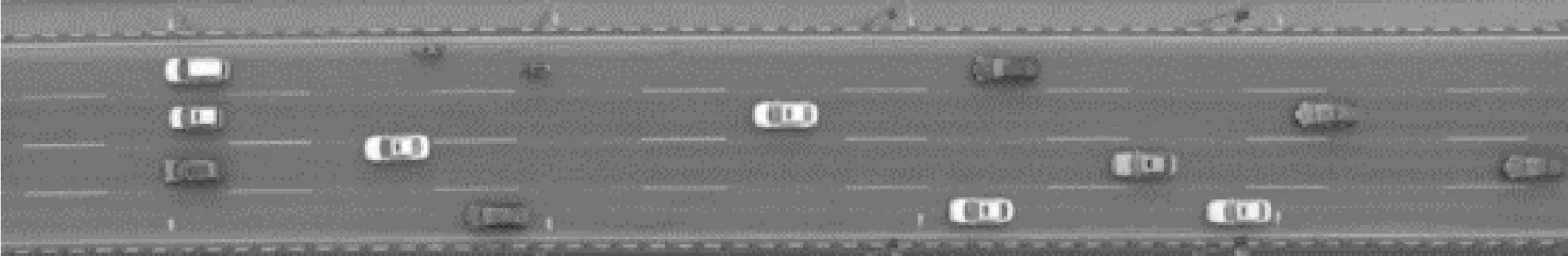

时可判定为车辆.式中,a,r分别为车辆面积阈值和车辆长宽比阈值.经过测试,a可取120,r可取6.将车辆用矩形线框标识出来,如图11所示.

图11 车辆识别结果

5 算法性能评价分析

算法需要设置3个参数:图像分割阈值调整值Δ、车辆面积阈值a和车辆长宽比阈值r.在经过大量数据测试和分析的基础上,本文取Δ=25,a=120,r=6.

5.1 既有相关评价指标简介

本文基于无人机视频进行车辆识别,本质上仍属于图像处理范畴.既有图像检测研究常用F1指标评价算法优劣[18],F1值越高算法越优.

根据F1指标评价法的思想,首先将车辆检测结果分为4种情况:① 车辆被判定为车辆,即TP;② 车辆被漏检,即FN;③ 其他物体被检测成车辆,即FP;④ 背景被判定为背景,即TN.F1计算公式如下:

(6)

式中,P为准确率(precision),P=TP/(TP+FP);R为召回率(recall),R=TP/(TP+FN).

但实际上车辆检测结果还可能存在一辆车被检测成2辆车或多辆车的情况.此时,情况①实际涵盖了2种情况:单个车辆被判定为1辆车(即真正意义上的准确检测);单个车辆被判定为2辆或多辆车(即重复检测).因此,F1指标的计算存在不足之处,并不完全适用于无人机视频车辆检测算法的评价.

5.2 新建评价指标体系

鉴于F1评价指标存在的缺陷,本文对检测结果的情况进行了更细致分类:① 车辆被正确检测,即一辆车被判定为一辆车;② 车辆重检,即一辆车被检测成2辆车或多辆车;③ 车辆漏检;④ 其他物体被检测成车辆;⑤ 背景被判定为背景.根据以上分类,提出了正检率PT、重检率PR、漏检率PM和错检率PW4个评价指标,并用这4个指标衡量算法检测效果的优劣.

PT=NT/NS

(7)

PR=NR/NS

(8)

PM=NM/NS

(9)

PW=(NR+NE)/NS

(10)

式中,NE为检测区内被检测成车辆的非车辆物体个数;NT为检测区内正确检测的车辆数;NM为检测区内被漏检的车辆数;NR为检测区内被重复检测的车辆数;NS为实际车辆数,NS=NT+NM+NR,因此有PT+PR+PM=1.

5.3 评价结果分析

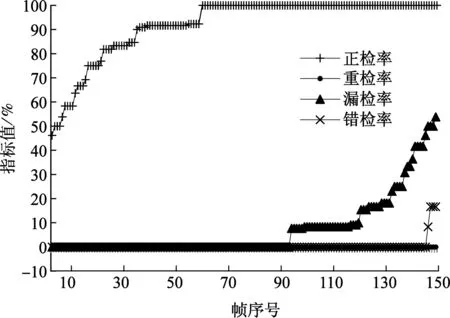

在Microsoft Visual Studio 2010和OpenCV 2.4.9环境下编制本文算法程序,并实现无人机视频检测.随机提取150帧检测图像,基于检测结果和人工判读,对于每一张图像均可计算出一组评价指标值,统计结果如表1和图12所示.

表1 算法评价指标统计结果 %

由表1可看出,算法正检率均值为92.29%;重检率均值为0,表明几乎不会将一辆车识别为多辆车;漏检率均值为7.31%,即很少发生车辆漏检情况;错检率均值为0.39%,表明很少将其他物体识别为车辆.从4个指标的均值和中值来看,本文算法均取得了较好的车辆检测效果.正检率、重检率、漏检率和错检率的方差分别为0.017%,0%,0.016%和0.001%,表明评价指标值集中分布于均值附近,离散程度较小,体现了算法检测结果具有较高的稳定性.

图12 评价指标值分布

由图12的评价指标分布情况可看出:① 约有130张图像(占样本总量的86%)的正检率高于80%,约有115张图像(占样本总量的77%)的正检率高于90%,表明对于大部分图像而言,正检率都能达到较高水平;② 对于150张图像,重检率均为0,表明检测算法对车辆的整体分割效果较好,能保证车辆的完整性;③ 漏检率为0%~54%,约有90张图像(占样本总量的60%)的漏检率为0,约有120张图像(占样本总量的80%)的漏检率小于10%,表明大多数情况下车辆漏检几率较低;④ 绝大部分图像错检率为0,只有少数几张图像错检率在8.3%~17.0%,表明算法很少将其他物体误判为车辆.

由上述分析可看出,算法在重检率和错检率方面已取得比较满意的效果;正检率平均值较高,但仍有部分图像只能获得46%~80%的正检率,根据PT+PR+PM=1,由于PR=0,要提高正检率,就需要降低漏检率.从算法测试图像来看,车辆漏检的主要原因在于部分车辆色泽比较黯淡(特别是黑色或灰色车辆)、与路面灰度十分接近,这使得对称帧间差分处理和背景差分之后车辆目标不清晰、完整,导致车辆无法识别.如何避免或减少车辆漏检情况的发生,将是下一步着重研究的课题.

6 结语

本文针对无人机视频,提出了一种基于对称帧间差分和分块背景建模的车辆自动识别方法.该方法通过图像预处理和对称帧间差分处获得初步运动目标,再应用分块建模思想建立背景模型,通过背景差分和去噪处理等程序实现车辆识别.本文还新提出了正检率、重检率、漏检率和错检率4个指标来衡量算法的性能.测试表明,本文方法可获得较高的正检率,而重检率、错检率和漏检率均较低.

该方法为基于无人机视频的广域交通流信息(如交通密度和车辆轨迹)实时采集奠定了基础,有望弥补现有交通信息采集技术的不足,推动广域交通流分析等相关研究,因此具有较广阔的工程应用价值和理论意义.由于交通场景的复杂多样性,本文方法还有待进一步提升,需要基于更广泛的无人机悬停及巡航视频数据展开测试和改进研究.

References)

[1]张晖,董育宁.基于视频的车辆检测算法综述[J].南京邮电大学学报(自然科学版),2007,27(3):88-94. DOI:10.3969/j.issn.1673-5439.2007.03.018. Zhang Hui, Dong Yuning. Survey on video based vehicle detection algorithms[J].JournalofNanjingUniversityofPostsandTelecommunications(NaturalScience), 2007, 27(3): 88-94. DOI:10.3969/j.issn.1673-5439.2007.03.018. (in Chinese)

[2]Carroll E A, Rathbone D B. Using an unmanned airborne data acquisition system (ADAS) for traffic surveillance, monitoring, and management[C]//ASME2002InternationalMechanicalEngineeringCongressandExposition. New Orleans, Louisiana, USA, 2002: 145-157. DOI:10.1115/imece2002-32916.

[3]Bethke K H, Baumgartner S, Gabele M, et al. Air-and spaceborne monitoring of road traffic using SAR movingtarget indication—Project TRAMRAD[J].ISPRSJournalofPhotogrammetryandRemoteSensing, 2006, 61(3): 243-259. DOI:10.1016/j.isprsjprs.2006.09.005.

[4]Sánchez-Oro J, Fernández-López D, Cabido R, et al. Radar-based road-traffic monitoring in urban environments[J].DigitalSignalProcessing, 2012, 23(1): 364-374. DOI:10.1016/j.dsp.2012.09.012.

[5]Kim N V, Chervonenkis M A. Situation control of unmanned aerial vehicles for road traffic monitoring[J].ModernAppliedScience, 2015, 9(5): 1-13. DOI:10.5539/mas.v9n5p1.

[6]Hoang V D, Hernandez D C, Filonenko A, et al. Path planning for unmanned vehicle motion based on road detection using online road map and satellite image[C]//ComputerVision—ACCV2014Workshops. Singapore, 2014: 433-447. DOI:10.1007/978-3-319-16631-5_32.

[7]Cao X, Gao C, Lan J, et al. Ego motion guided particle filter for vehicle tracking in airborne videos[J].Neurocomputing, 2014, 124(2): 168-177. DOI:10.1016/j.neucom.2013.07.014.

[8]彭仲仁,刘晓锋,张立业,等.无人飞机在交通信息采集中的研究进展和展望[J].交通运输工程学报,2012,12(6):119-126. Peng Zhongren, Liu Xiaofeng, Zhang Liye, et al. Research progress and prospect of UAV applications in transportation information collection[J].JournalofTrafficandTransportationEngineering, 2012, 12(6): 119-126. (in Chinese)

[9]Kanistras K, Martins G, Rutherford M J, et al. Survey of unmanned aerial vehicles (UAVs) for traffic monitoring[C]//InternationalConferenceonUnmannedAircraftSystems. Atlanta, Georgia, USA, 2013:221-234.

[10]Coifman B, McCord M, Mishalani R G, et al. Roadway traffic monitoring from an unmanned aerial vehicle[J].IEEProceedings—IntelligentTransportSystems, 2006, 153(1): 11. DOI:10.1049/ip-its:20055014.

[11]Cheng P, Zhou G, Zheng Z. Detecting and counting vehicles from small low-cost UAV images[C]//ASPRS2009AnnualConference. Baltimore, Maryland, 2009: 1-7.

[12]刘慧,李清泉,曾喆,等.利用低空视频检测道路车辆[J].武汉大学学报(信息科学版),2011,36(3):316-320. Liu Hui, Li Qingquan, Zeng Zhe, et al. Vehicle detection in low-altitude aircraft video[J].GeomaticsandInformationScienceofWuhanUniversity, 2011, 36(3): 316-320. (in Chinese)

[13]谭熊,余旭初,刘景正,等.基于无人机视频的运动目标快速跟踪[J].测绘通报,2011(9):32-34,41. Tan Xiong, Yu Xuchu, Liu Jingzheng, et al. Object fast tracking based on unmanned aerial vehicle video[J].BulletinofSurveyingandMapping, 2011(9): 32-34,41.(in Chinese)

[14]张新.基于无人机视频的交通参数提取方法及应用[D].上海:同济大学交通运输工程学院,2014.

[15]Azevedo C L, Cardoso J L, Ben-Akiva M, et al. Automatic vehicle trajectory extraction by aerial remote sensing[J].Procedia-SocialandBehavioralSciences, 2014, 111: 849-858. DOI:10.1016/j.sbspro.2014.01.119.

[16]周雨阳,龚艺,姚琳,等.无人机广域视频的机动车交通参数计算及分析[J].交通运输系统工程与信息,2015,15(6):67-73. Zhou Yuyang, Gong Yi, Yao Lin, et al. Calculation and analysis of the traffic parameters of vehicles based on the wide-area drone video[J].JournalofTransportationSystemsEngineeringandInformationTechnology, 2015, 15(6): 67-73. (in Chinese)

[17]Otsu N. A threshold selection method from gray-level histograms[J].IEEETransactionsonSystems,Man,andCybernetics, 1979, 9(1): 62-66. DOI:10.1109/tsmc.1979.4310076.

[18]Li Q Q, Zou Q, Liu X L. Pavement crack classification via spatial distribution features[J].EURASIPJournalonAdvancesinSignalProcessing, 2011, 2011: 649675. DOI:10.1155/2011/649675.

Automatic vehicle detection from UAV videos based on symmetrical frame difference and background block modeling

Peng Bo Cai Xiaoyu Zhang Youjie Li Shaobo

(College of Traffic and Transportation, Chongqing Jiaotong University, Chongqing 400074, China)

In order to recognize traffic flow information correctly and comprehensively from a regional perspective, aiming at UAV (unmanned aerial vehicle) videos, an automatic vehicle detection method is proposed based on symmetrical frame difference and background block modeling. First, 4×4 dimension reduction and grayscale processing were conducted on UAV video frames, and a ROI (region of interest) was marked manually, for the purpose of reducing the image scale and specifying the detection region. Secondly, moving objects in ROI were extracted by symmetrical frame difference, and thus the background image was obtained through background block modeling. Then, vehicles were preliminarily extracted using background subtraction. Finally, noises were eliminated using techniques such as morphological processing, and vehicle recognition results were obtained. Four evaluation indices, i.e., correct detection rate, repeated detection rate, missed detection rate and false detection rate, were put forward aiming at vehicle detection algorithms. Algorithm tests were conducted on 150 frames of an UAV video. Test results show that the proposed algorithm achieves high correct detection rate (averaging 92.29%), low missed detection rate (averaging 7.31%) and false detection rate (averaging 0.39%), while the repeated detection rate is 0.

intelligent transportation; vehicle detection; symmetrical frame difference; background modeling; unmanned aerial vehicle; region of interest

2016-11-11. 作者简介: 彭博(1986—),男,博士,讲师;蔡晓禹(联系人),男,博士,教授,caixiaoyu@vip.163.com.

重庆市社会事业与民生保障科技创新专项资助项目(cstc2015shms-ztzx30002,cstc2015shms-ztzx0127)、重庆市教委科学研究资助项目(KJ1600513)、重庆交通大学科研启动资助项目(15JDKJC-A002)、重庆市科委基础科学与前沿技术研究资助项目(cstc2017jcyjAX0473).

彭博,蔡晓禹,张有节,等.基于对称帧差和分块背景建模的无人机视频车辆自动检测[J].东南大学学报(自然科学版),2017,47(4):685-690.

10.3969/j.issn.1001-0505.2017.04.010.

U491.1

A

1001-0505(2017)04-0685-06