基于类物体采样方法的多类别物体识别

2017-07-07张志柏孙传庆

张志柏,朱 敏,孙传庆,牛 杰

(常州信息职业技术学院 电子与电气工程学院,江苏常州 213164)

基于类物体采样方法的多类别物体识别

张志柏,朱 敏,孙传庆,牛 杰

(常州信息职业技术学院 电子与电气工程学院,江苏常州 213164)

提出一种基于类物体区域检测的BoW(Bag of Words)框架物体识别方法,采用改进的BING(Binarized Normed Gradients)算子检测分割出图像中的可能物体区域后,利用RootSIFT算子提取特征,送入后续BoW框架进行物体类别识别.将该方法应用于PASCAL VOC2007图像集,试验结果表明:相较于整幅图像的特征计算,将特征提取与匹配限定在固定的可能物体区域的做法可以提高计算速度和识别效率.此外,该方法在VOC2007图像集上达到了平均33.45%的识别准确率,优于相关文献算法.

类物体采样; BoW模型; BING算子; 物体识别

目标物体识别一直是计算机视觉的重要课题.识别是跟踪、计数、分类等应用的基础,在诸如人脸识别[1]、智能交通监控[2]等领域有着较大的发展前景.

通常的目标识别方法都需要依赖图像分割技术,利用各种人工定义的分类器在一系列滑动窗口上进行特征匹配[3-5],此类方法往往计算量较大,因此出于实时性的考虑,后续的检测系统一般会选择弱特征及弱分类器以提升执行效率.方法优化的突破口主要集中在如何减少滑动窗口数量及提供分类器性能两个方面[6-7].生物学研究[8]表明:人类在观察场景时,第一步是检测出视野中的所有可能物体,然后再去识别该物体的种类信息.受此启发,文献[9]提出了类物体区域采样的概念,它代表一个窗口包含物体可能性的大小.其算法设计思路主要是基于图像中物体和背景各自的固有特征进行.物体对象性思想由于其可以减少图像的搜索空间、加快处理速度等优势受到了很多研究的关注[10-11].

本文将类物体的思想引入到复杂场景下的物体识别应用中.首先利用类物体区域检测算法标识出图像中所有可能的物体区域;然后仅在上述标识区域中利用BoW模型进行物体类别判别;最后在公开图像数据集上,与其他识别算法就执行效率及准确性进行对比分析.试验结果验证了文中方法的有效性.

1 方法框架

目标识别的通用框架是特征表述加分类器,利用滑动窗口技术设计固定或动态大小的窗口进行逐一匹配,这导致了识别算法的运算量较大,难以满足实时判别的需求.

本文受文献启发,将类物体采样方法引入到多物体识别应用中.首先利用BING算法提取图像中的可能物体区域;然后计算区域的SIFT类特征,并全部送入BoW模型进行判别[11].具体的算法流程结构如图1所示.

图1 算法整体结构框图Fig.1 Block diagram of the overall structure

2 BING算法加速物体判别

类物体概念的提出对于提升物体的识别应用有着积极意义.对于一幅N×N的图像来说,传统方法用到的滑动窗口可达N4的数量级之多.这样对于检测系统来说,为保障运行速度,只能选择弱特征及弱分类器.若能快速识别出图像中的可能物体区域,就可以在所有候选的窗口中过滤掉绝大部分,从而减少系统运算时间,甚至也可以采用性能更好的分类器,从而提升识别准确率.

文献[11]提出一种BING算法来进行类物体区域的提取,其核心思想是在梯度空间图上,无论物体是长的还是宽的,只要归一化到一个相同的尺度上(8×8),物体与背景的梯度模式会十分有共性.这时用SVM(Support Vector Machine)分类器就能把物体和背景区分出来.算法最终在测试图像集中达到了300 帧/s的速度,并且取得了良好的识别准确率.

本文在BING算法基础上,加入图像局部熵思想进行算法优化.图像熵是一种特征的统计形式,它反映了图像中平均信息量的多少.一幅由直方图表示图片的内容复杂度可以通过以下的熵值来进行体现:

(1)

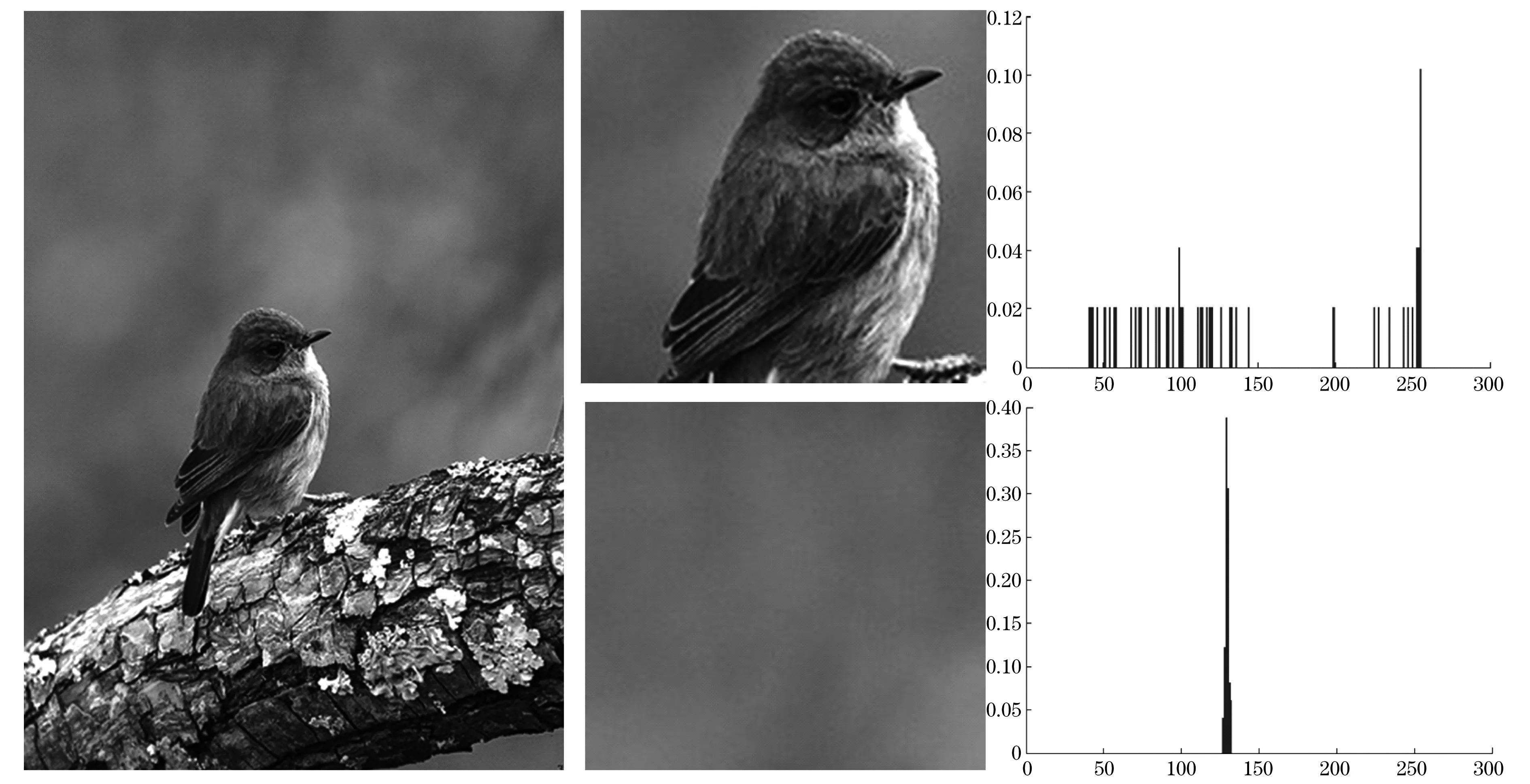

式中:Pv,Ri代表像素亮度V在区域Ri中的概率密度.一幅图像不同区域的归一化熵图如图2所示,可以看出物体和背景直方图较为明显的不同,其中图像右侧XY图是图像的局部统计直方图,横坐标是灰度值,纵坐标是归一化的统计数值.通常物体所在区域的熵值会比较大,而背景则具有一致性的特点,因此可以引入图像局部熵来优化物体类别判别.文中修改了BING算法中对于窗口大小、分类器输出分数以及最终窗口是否含有目标的模型.最终的类物体区域计算为

(2)

式中:01表示类物体区域的分数;vi,ti分别是学习系数和偏置项;ΗRi是图像熵值;α是图像局部熵权重系数,代表图像局部熵所占权重大小,文中试验取α=1.

图2 物体和背景图片局部熵对比Fig.2 Contrast of local entropy between the background and foreground region

3 基于BoW模型的目标识别

近年来,BoW模型已被广泛应用到现实的图像分类中,取得了非常不错的效果.模型的通常步骤可以分为特征提取、生成词典、构建归一化直方图三个步骤,其中特征算子常采用SIFT,SURF等尺度不变局部特征描述子.

常规的特征提取在整幅图像上进行,仅仅单纯利用匹配算法就可以直接在不同图像上对这些特征进行匹配,以用于图像的识别和分类.但是在整个图像中提取特征进行匹配会消耗大量的计算资源,同时由于是从整幅图像上进行考虑,因此对于真正需要识别的物体的特征的提取往往不够细致.

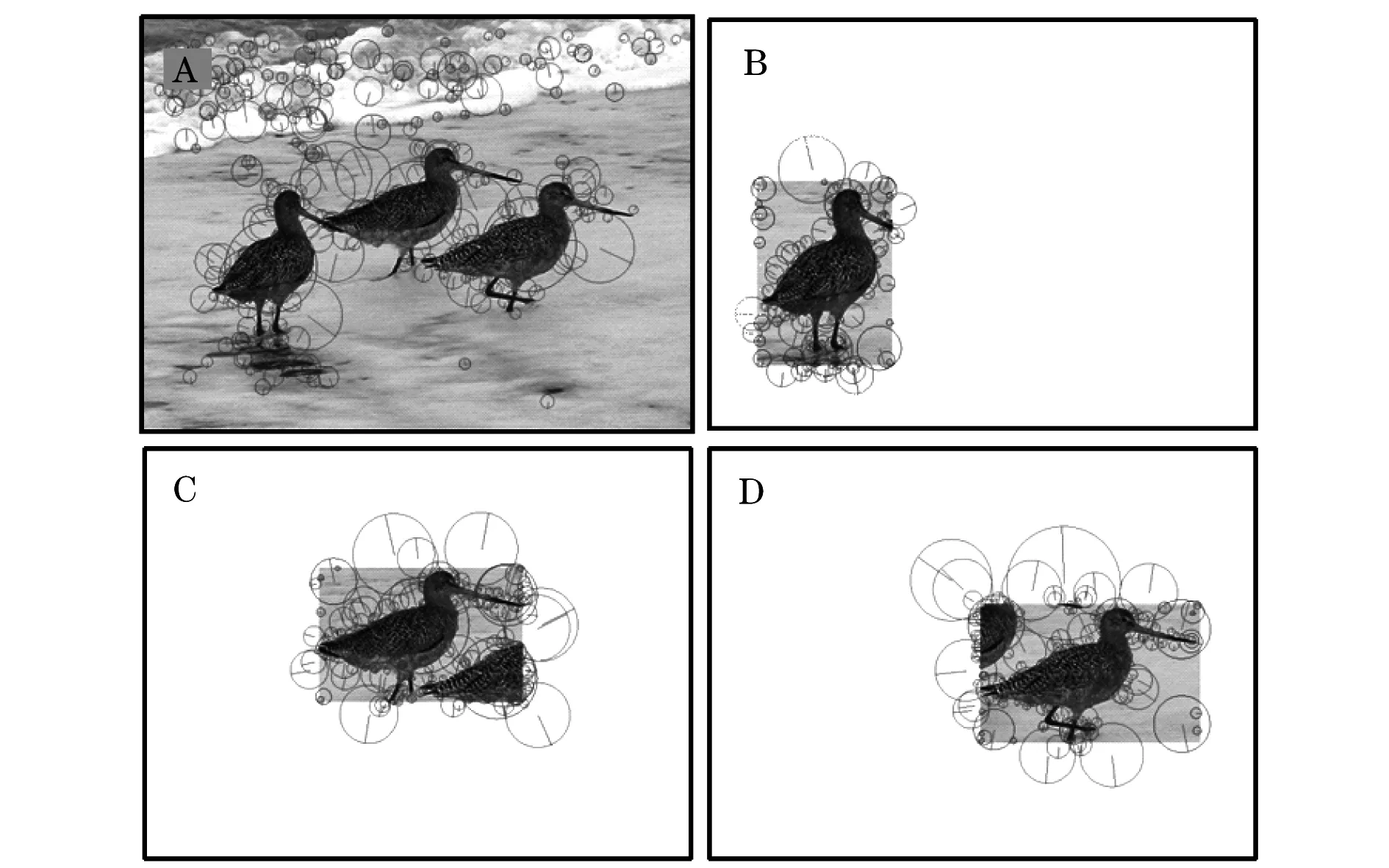

本文在特征提取之前,首先利用BING方法进行可能目标区域的提取,然后直接在目标区域上进行特征提取,对于非目标区域不作考虑.特征提取示意图如图3所示.其中图3(A)是原图提取尺度不变特征示例,图3(B~D)是类物体采样方法后,进行特征提取的图形.特征提取需要在不同尺度上进行计算,如果可以在图像上将无关物体的背景区域移除,那么将减少大量的特征提取时间.同样,在匹配阶段,仅仅需要对于可能区域范围进行识别,这将进一步节省时间,提高准确率.同时,类物体区域提取之后,我们还引入了图像边缘平滑操作以克服提取出的图像边缘强对比性对于结果的影响.文献[12]提出一种利用极小数据空间来构建特征的BRIEF算子,然而当图像复杂时,算子性能下降明显.另外,考虑到由于类物体采样方法的引入,在保证实时性前提下,可以适当放宽图像特征提取的运算时间,因此综合考虑,本文采用一种RootSIFT算子[13]提取图像特征.该算子利用Hellinger距离替代欧式距离以提供动态性能.

图3 特征提取示意图Fig.3 Block diagram of the feature extraction process

提取特征后,利用K-means方法进行聚类,根据码本生成各物体图像的直方图,然后利用RBF(Radial Basis Function)SVM进行离线训练,构建待识别物体的支持向量机.

4 试验结果与分析

为了验证文中算法性能,选择公开的PASCAL VOC2007[14]数据库图像集进行测试.在其训练集中共有9 963幅24 640个标注物体.图像集总共包含人物、鸟类、猫、飞机、自行车等20类图像.部分示例图像如图4所示.为了全面测试算法,我们从算法识别准确率、特征算子性能以及模型的泛化能力方面分别加以比较,所有试验均在Inter i72.2 GHz处理器、8 G内存的PC电脑上进行.

图4 VOC2007图像集示例Fig.4 VOC2007 example images

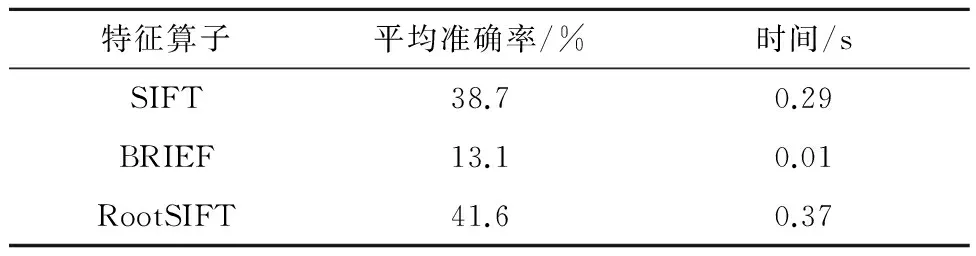

首先,对于BoW模型中特征算子的选择,从快速性和准确性的角度出发,对比了RootSIFT,SIFT以及BRIEF三类算子对于模型的影响.人工随机挑选300幅自行车类别目标图像进行测试,图像中的物体标注图像和随机抽取的背景图像用于模型训练.表1为不同特征算子的模型识别准确率及特征运算时间对比结果.可以看出:RootSIFT特征取得了最高的41.6%的准确率;SIFT特征次之;BRIEF特征的准确率下降最为明显,原因是类物体区域分割后依然存留着复杂背景信息.另一方面,BRIEF由于自身特性,运算时间仅为对比算子的1/40,因此对场景简单、实时性要求高的场合具有一定的实用价值.

表1 不同特征算子的对比结果

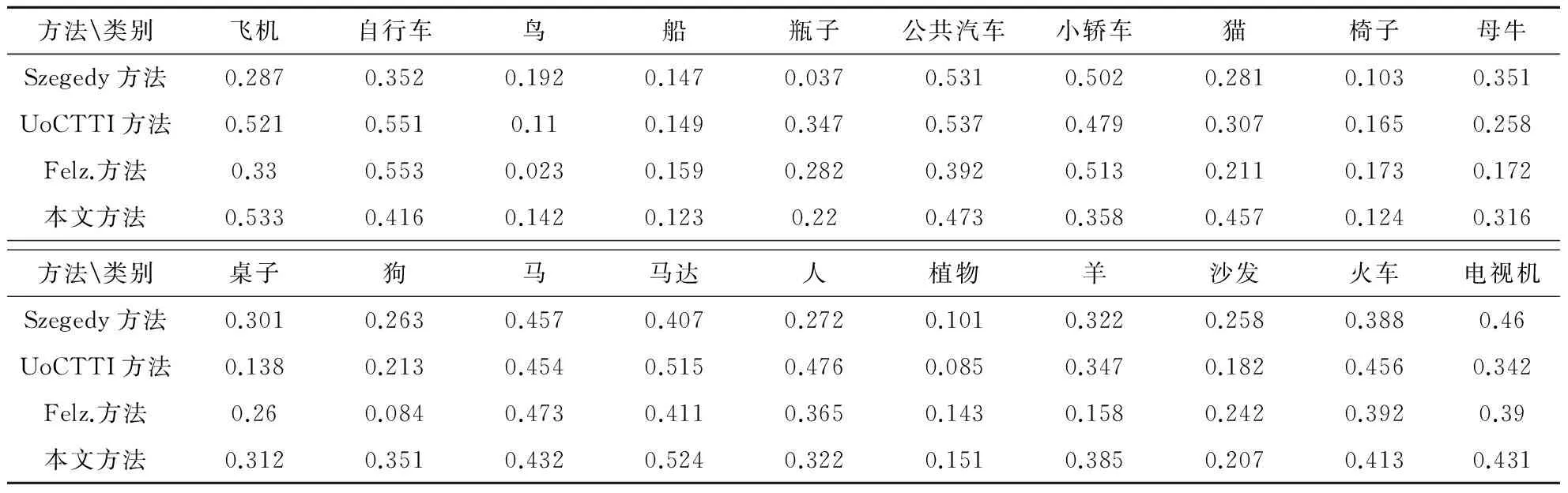

其次,文中分别选取深度学习方法[15]、分层结构学习方法[16]及DPM(Deformable Parts Model)[5]方法进行物体识别准确率指标比较.表2所示为这些方法的试验对比结果.根据结果,在20类图像中,本文方法有7类拿到最高的识别精度结果,平均准确率也达到了33.45%,处于领先水平.在所有方法中,本文方法使用常规的BoW模型框架,因此试验结果充分验证了引入类物体区域分割后对于识别结果性能提升的有效性.

表2 不同方法在VOC2007数据集上的准确率结果

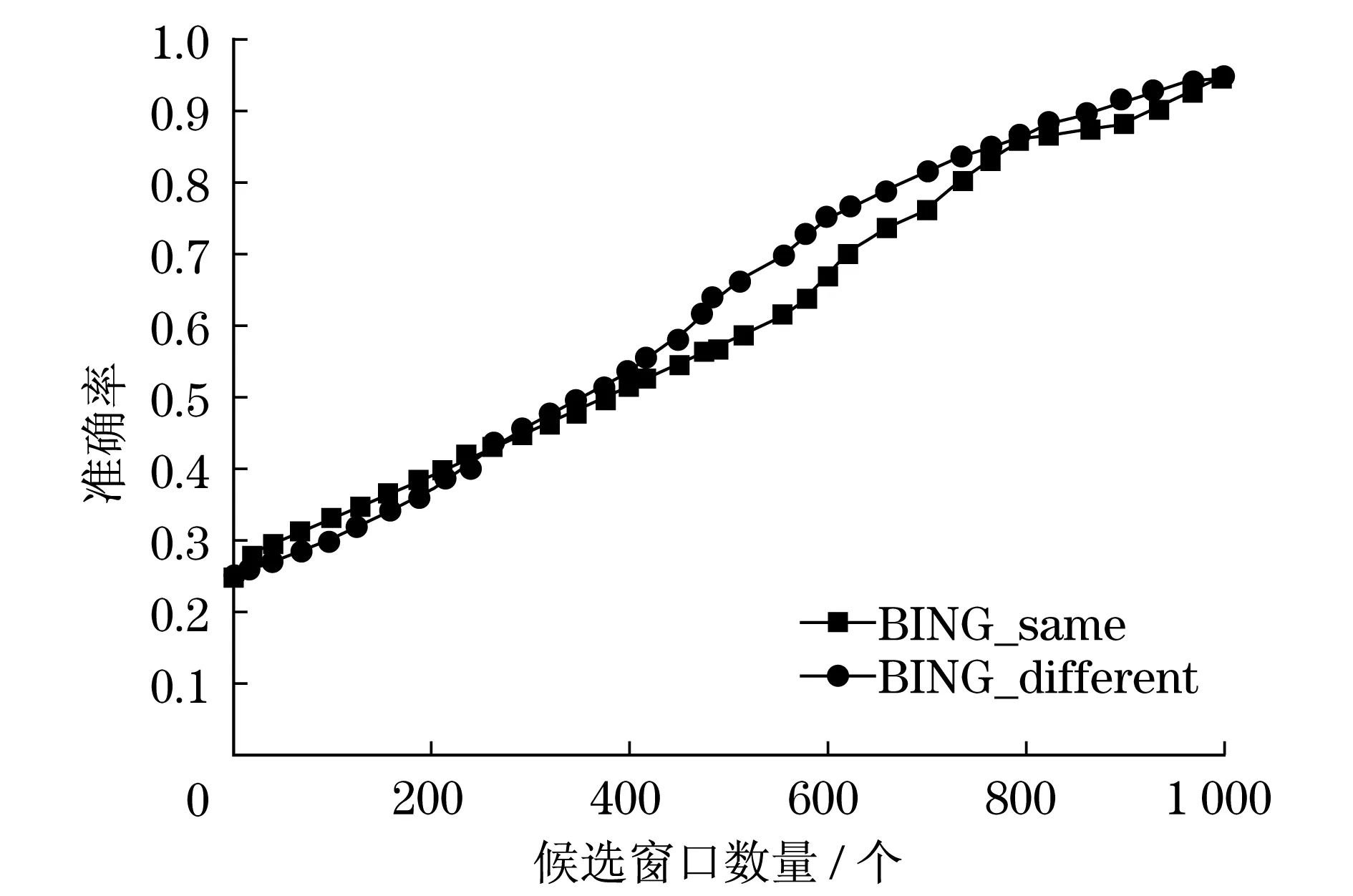

此外,我们还对文中模型的泛化能力进行了测试.图5所示BING_same和BING_different为训练物体种类和测试物体种类相同和不同的情况.可以看出,在训练好BING判别模型后,即使利用训练集中未包含的物体类别进行测试,依然可以取得良好的识别效果.将该结果扩展到物体的识别应用中,当在类物体区域中未找到匹配时,可以认为发现新类别物体,进而利用特征点信息扩展训练目标模型,从而提升算法的通用识别能力.

5 结语

针对常规物体识别框架算法存在的问题,提出了一种基于类物体区域分割算法的BoW框架实时检测方法.本文方法首先利用BING算子进行快速的类物体区域检测,然后仅需要在可能的物体区域提取特征信息以供后续的BoW和SVM模型使用.将本文方法与同领域类似应用的先进算法在公开数据集上进行了算法比较,在保证实时性的前提下,本文算法的识别准确率能够取得最优的平均准确率.此外,文中框架的核心在于BING算法的准确性,虽然BING算子在数据集上可以达到300帧/s速度以及96.2%的准确率,但是其考量方式采用VOC的“检测区域占真实面积比例大于50%”的标准显得较为宽松,试验中发现会出现类物体区域没有包含全部物体的情况,未来的工作可以考虑加入诸如GIST[17]、V1S+[18]、颜色直方图等特征,以进一步优化BING算子及BoW模型性能.

图5 BING2007图像集示例Fig.5 BING2007 example images

[1] PARKHI O M,SIMONYAN K,VEDALDI A,et al.A compact and discriminative face track descriptor[C]//Proceedings of the Computer Vision and Pattern Recognition,Piscataway:IEEE,2014:1693-1700.

[2] HUANG S C,CHEN B H.Highly accurate moving object detection in variable bit rate video-based traffic monitoring systems[J].Neural Networks and Learning Systems,IEEE Transactions on,2013,24(12):1920-1931.

[3] FERNANDO B,FROMONT E,TUYTELAARS T.Effective use of frequent itemset mining for image classification[M].Berlin:Springer,2012:214-227.

[4] HEITZ G,KOLLER D.Learning spatial context:using stuff to find things[M].Berlin:Springer,2008:30-43.

[5] FELZENSZWALB P F,GIRSHICK R B,MCALLESTER D,et al.Object detection with discriminatively trained part-based models[J].Pattern Analysis and Machine Intelligence,IEEE Transactions on,2010,32(9):1627-1645.

[6] UIJLINGS J R,VAN DE SANDE K E,GEVERS T,et al.Selective search for object recognition[J].International Journal of Computer Vision,2013,104(2):154-171.

[7] DOLL R P,APPEL R,BELONGIE S,et al.Fast feature pyramids for object detection[J].Pattern Analysis and Machine Intelligence,IEEE Transactions on,2014,36(8):1532-1545.

[8] DESIMONE R,DUNCAN J.Neural mechanisms of selective visual attention[J].Annual Review of Neuroscience,1995,18(1):193-222.

[9] ALEXE B,DESELAERS T,FERRARI V.What is an object?[C]// Proceedings of the Computer Vision and Pattern Recognition,Piscataway:IEEE,2010:73-80.

[10] ALEXE B,DESELAERS T,FERRARI V.Measuring the objectness of image windows[J].Pattern Analysis and Machine Intelligence,IEEE Transactions on,2012,34(11):2189-2202.

[11] CHENG M M,ZHANG Z,LIN W Y,et al.bING:Binarized normed gradients for objectness estimation at 300 fps[C]//Proceedings of the Computer Vision and Pattern Recognition,Piscataway:IEEE,2014:3286-3293.

[12] CALONDER M,LEPETIT V,STRECHA C,et al.Brief:binary robust independent elementary features[M].Computer Vision-ECCV 2010,Berlin:Springer,2010:778-92.

[13] ARANDJELOVIC R,ZISSERMAN A.Three things everyone should know to improve object retrieval[C]//Proceedings of the Computer Vision and Pattern Recognition,Piscataway:IEEE,2012:2911-2918.

[14] EWERINGHAM M,ESLAMI S M A,GOOL L V,et al.The Pascal,visual object classes challenge:a retrospective[J].International Journal of Computer Vision,2015,111(1):98-136.

[15] SZEGEDY C,TOSHEV A,ERHAN D.Deep neural networks for object detection[J].Advances in Neural Information Processing Systems,2013,26:2553-2561.

[16] ZHU L,CHEN Y,YUILLE A,et al.Latent hierarchical structural learning for object detection[C]//Proceedings of the Computer Vision and Pattern Recognition,Piscataway:IEEE,2010:1062-1069.

[17] OLIVA A,TORRALBA A.Modeling the shape of the scene:a holistic representation of the spatial envelope[J].International Journal of Computer Vision,2001,42(3):145-75.

[18] PINTO N,COX D D,DICARLO J J.Why is real-world visual object recognition hard?[J].PLoS Computational Biology,2008,4(1):27.

Objectness sampling based multiple-object recognition

ZHANG Zhibai, ZHU Min, SUN Chuanqing, NIU Jie

(School of Electrical and Electronic Engineering , Changzhou College of Information Technology , Changzhou 213164, Jiangsu, China)

In this study,an object recognition method for bag of words (BoW) framework is proposed via objectness measurement. Firstly,the object areas are detected and segmented using the improved binarized normed gradient (BING) operator.Then, the features are extracted by RootSIFT operator for object recognition.Finally,this method is employed for PASCAL VOC2007 image-set. Therefore,it is found from experimental results that,compared with the whole image feature computation,the computational speed and recognition efficiency are enhanced by feature extraction and matching limitation to possible object areas.In addition,the algorithm in this approach is proven better than those in other literatures with average recognition accuracy of 33.45% for VOC2007 image-set.

objectness measurement; BoW model; BING feature; object recognition

张志柏(1970-),男,副教授.E-mail:zhluluzh@yeah.net

TP 391.41

A

1672-5581(2017)01-0001-05