一种激光视觉引导的自动识别V形焊缝的算法*

2017-07-05嵇保健

凌 超, 嵇保健, 洪 磊, 沈 健

(1.南京工业大学 电气工程与控制科学学院, 南京 211800, 2.南京工程学院 汽车与轨道交通学院, 南京 211167)

一种激光视觉引导的自动识别V形焊缝的算法*

凌 超1, 嵇保健1, 洪 磊2, 沈 健1

(1.南京工业大学 电气工程与控制科学学院, 南京 211800, 2.南京工程学院 汽车与轨道交通学院, 南京 211167)

如何准确地识别线结构光在V形焊缝上留下的光带是机器视觉的一个关键技术,对此文章提出一种新的图像处理方法。首先对原图像进行中值滤波。然后选用一种新的高斯模板对其进行滤波,可以有效地去除面积较大,宽度较宽的噪声。接着采用一种新的ROI区域提取算法,可以有效地确定光带所在位置,提高运算效率。然后采取孤点滤波删除散落在图像上的曝光点。接着对其进行细化,提取激光条纹中心线。提取焊缝特征点时,运用斜率法将图像中的点进行分类随后进行最小二乘法的直线拟合,得到特征点坐标。然后将特征点坐标从图像坐标系转到基坐标系下。最后通过计算得到焊缝参数。实验结果表明:V形坡口的角度、高度、宽度的计算结果与实际值的相对误差分别为0.33%、0.585%、0.186%。满足的抗干扰能力强、精度高和实际焊接等要求。

激光视觉;最小二乘法; 直线拟合;机器人基坐标

0 引言

随着机器视觉和焊接自动化技术的发展,基于激光视觉引导的自动识别焊接焊缝技术越来越受到人们的关注[1]。通过视觉传感器进行图像的采集,运用图像处理技术将焊缝坡口的信息以数字信息形式进行图像处理。激光相对于其它结构光,它更加稳定,精度更高,能量集中,采集到的激光图像可以很好的反应焊缝特征。由于焊接过程中产生大量的灰尘、弧光、飞溅、烟雾,采集到的图像的质量容易受到影响,为了能有效地捕捉到激光焊缝条纹[2],算法要求能够正确的得到激光焊缝的条纹,而且在保证准确性的同时还要求识别速度,这些要求也成为自动识别处理焊缝的重点和难点[3]。对于有强干扰的图像,算法利用LOG滤波可以有效地去除图像中的噪声,利用新的ROI区域的提取算法,有效地提高了运算效率,同时能够提取光带所在位置,保证最后利用斜率法和最小二乘法实现直线拟合,得到特征点的坐标,最终利用三维重建得到焊缝参数,实现机器人的自动焊接。

1 图像识别算法

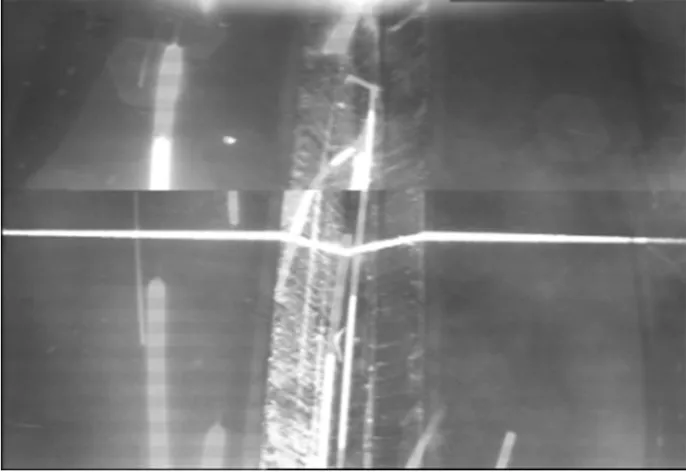

图像识别包括图像预处理、图像处理、和图像识别。图像预处理包括中值滤波、一维高斯-拉普拉斯滤波、ROI区域提取、阈值分割、形态学、标记算法对原图像进行处理,便于识别焊缝[4]。图像处理包括细化算法、直线拟合。图像识别包括特征点的提取。焊缝原始图像如图1所示。

图1 焊缝原始图像

1.1 中值滤波

中值滤波是众多滤波算法中运用的最为频繁的滤波形式,特别是针对于灰尘,飞溅带来的椒盐噪声它有明显的消除作用,处理原图噪声需要根据图像特征选取适当的滤波窗口,经过反复试验,本文选择3×3的滤波模板对焊缝图进行处理。

1.2 高斯-拉普拉斯滤波

由于激光焊缝条纹是沿水平方向,弧光、飞溅、烟雾所形成的噪声在竖直方向上的像素明显大于激光焊缝条纹,针对该特点,本文选择使用高斯-拉普拉斯滤波一维列向量模板可以有效地去掏空噪声内部,使其边缘化[5]。本文选择的模板为:

s=[-2;-2;-1;0;1;2;4;2;1;0;-1;-2;-2]

多余的噪声已经被去除,留下焊缝的光带突出,如图2所示。

图2 LOG处理

1.3 ROI区域提取

ROI区域的提取在整个实验环节中是重要的,只针对ROI进行操作,可以降低数据的规模,提高运算效率,与此同时,可以减少非ROI区域对目标处理带来的干扰。原图像宽w,高h。如图3,激光条纹是横向分布的,根据像素行的累积求和,围绕激光条纹附近的像素总和应该是最大的[6]。根据这一特性,本文提出一个寻找算法,步骤如下:

(3)将S矩阵每列的像素值相加,得到一个h行1列的矩阵N;

(5)寻找向量M中最大值,最大值所在的行t即为原图像10(t-1)+1行至10t行的索引。

引入Ymin、Ymax,分别表示所在行位置的上下纵坐标。

根据经验值,本文规定焊缝V型口的高度m为60,另外在ROI区域上下都预留了20的固定高度k,所以ROI的表达区域为:

根据算法的流程,处理结果如图3所示。

图3 提取ROI区域

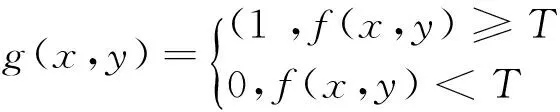

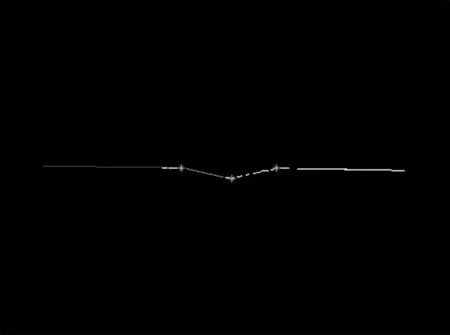

1.4 阈值分割

阈值分割的实质就是将灰度图像转化为二值图像。本文选用的是Otsu(大津法),对于原图而言,目标和背景的分割阈值记作T,即阈值分割的表达式为:

式中,f(x,y)为原图像点的像素值,g(x,y)为阈值分割后点的像素值,T为选择分割的阈值。

Otsu法使用的是聚类的思想,把图像的灰度数按灰度级分成两个部分,使得两个部分之间的灰度值差异最大,每个部分之间的灰度差异最小,通过方差的计算来寻找一个合适的灰度级别来划分。Otsu算法被认为是图像分割中阈值选取的最佳算法,计算简单,不受图像亮度和对比度的影响。效果如图4所示。

图4 阈值分割

1.5 孤点处理

针对ROI区域内存在的长线,由于没办法用形态学将其处理,它的存在影响了激光焊缝条纹的提取和拟合,所以本文的思路是将图像分成左右两半,这样做的优点在于可以有效地将图像的长线变短。又由于图像经过高斯-拉普拉斯的处理,图像中的噪声以边缘和孤立的点的形式存在,所以在该处理后,本文选择用两步进行处理。

(1)运用形态学的开运算,可以使图像的轮廓变得光滑、消除毛刺,本文选用的是3×3的正方形模板对图像进行滤波;

(2)运用标记算法去除图像中像素比较聚集的噪声,本文的标记算法是基于八连通区域的标记算法,原理是通过设置了一个像素固定值,如果白色连通区域的像素累加值低于我们设定的固定值即可滤掉,反之可保留。小窗口处理可以很好的处理ROI中的线段,这样做既不影响焊缝主要特征的提取,同时可以删除一些不需要的噪声。

效果如图5所示。

图5 孤点处理

1.6 图像细化

“图像细化”本质就是提取图像的骨架,而图像的骨架即是图像的中心线。传统的方法,不能去除V型口下方的长直线、短线。由于ROI区域提取方法,横线光带下方预留空间大,干扰线出现的位置在V型口横线的下面的概率大,根据这一特点,本文提出的细化思路大致如下:

(1) 图像沿水平方向依次找y的坐标,寻找方式是由该列从由往下依次寻找像素值为1的点,y1i和y2i分别为光带上下边界的纵坐标;

按照算法流程,效果如图6所示。

图6 细化图像

1.7 直线拟合

现如今图像的直线拟合用的比较频繁的方法有两种:一种是Hough变换;另一种是最小二乘法实现直线拟合;两种方法各有缺点。Hough变换,提取精度差,通常会多找到直线。最小二乘法,容易受到孤立的点和线段影响,不能很好地分辨多条直线,所以进行最小二乘法拟合时要先进行点的分类。

本文的方法是建立在斜率法的基础上,较之文献[7],其采用的方法过于复杂,运用投影法和曲率法计算,并且错误的认为焊缝最低点为两拐点和的一半,本文的算法直接在细化图像上进行斜率计算,以斜率直观的反应曲线的走向,最后确定拐点,进行拟合[8-10]。

本文在最小二乘法的基础上,进行了优化,可以有效地分辨不同的直线进行拟合,算法的步骤为:

(1) 首先从左向右不断计算固定点数n的斜率,将整个折线的斜率以曲线的类型表示,根据实际情况,n太大,斜率线不能准确地表示线的变化,n太小,斜率线容易受到噪声的影响,所以n的选择是根据大量实验验证而选择的。

(2) 从斜率变化曲线可以清楚地知道线的变化,通过分析得知斜率最大值所反映的点为V形坡口的自左向右第一个拐点,斜率最小值反映的点就是V形坡口的底部点。

(3) 因为斜率法所反映的点为大致位置,所以不能用该点来计算斜率,本文选择取斜率最大最小点左右5~10位置的点来进行点的分组。

(4) 最后将分完组的点进行最小二乘法的直线拟合,形成4条直线,计算得到3个图像坐标系交点p10、p20、p30。

根据算法对图像进行处理,结果如图7所示。

图7 直线拟合

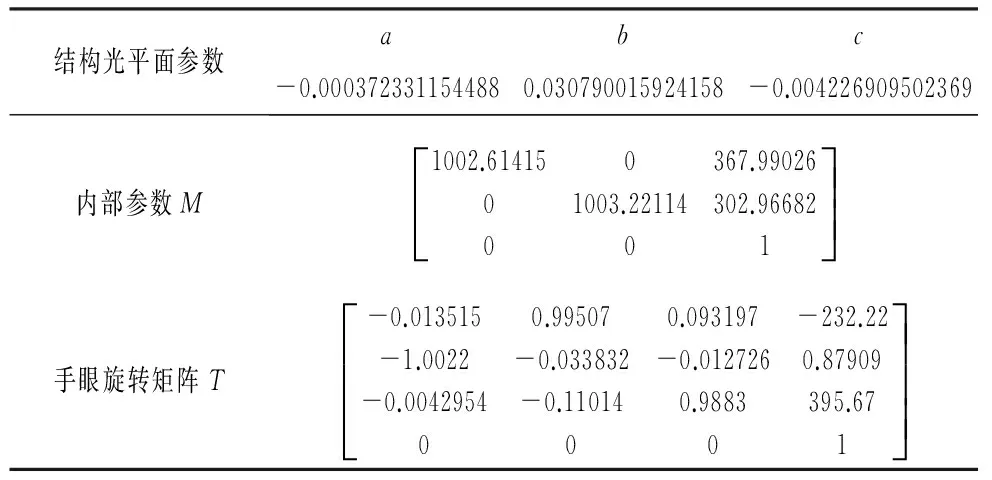

1.8 三维重建

由于特征点在结构光平面上,同时还在摄像机的光轴中心点与成像平面上的成像点之间的一条空间直线。已知摄像机的内参数M以及结构光平面方程参数,p在图像坐标系下的坐标(u1,v1),可以计算出p点在摄像机的焦距归一化成像平面的成像点P1c1的坐标:

(1)

假设平面方程式为:

ax+by+cz+1=0

(2)

由于空间点在摄像机的光轴中心点与成像点构成的直线上,即可知:

(3)

利用该直线的方程与结构光平面方程,即可得到特征点在摄像机坐标系下的三维坐标。将式(1)代入式(2),得:

(4)

通过标定可知摄像机到腕部的转换矩阵T。手腕部到基坐标的转换,同样可以从示教器上得知,经过换算得到矩阵B。

2 实验结果与分析

2.1 系统组成

焊缝跟踪焊接系统包括图像采集系统、焊接机器人、焊接设备系统[11]。焊接机器人型号为ABB IRB1410,机器人手眼系统图像采集系统包括激光发射器、摄像机,摄像机和激光发射器安装在焊接机器人的手腕部,摄像机型号为1/3InXC-ES50CE CCD,图像大小为764×576像素,焦距镜头型号为Computar工业镜头 M0814-MP2 8mm。图像采集卡型号为大恒DH CG410。激光器型号为MTO公司M-12A635-10-L,激光选用波长为635nm,输出功率为10MW的红色结构光发射器,线宽约为1mm。摄像机拍摄的图像通过图像采集卡进行采样、量化以后转换为数字图像并输入。完整的焊缝跟踪焊接系统实物图如图8所示。

图8 焊缝跟踪系统实物图

2.2 实验方法及结果

实验时,机器人作运动状,摄像机和图像采集卡同时工作,拍摄焊接过程中激光在焊板上留下的激光条纹图片,焊接过程中拍摄到的图片存在大量的烟雾、粉尘以及弧光,利用图像处理技术识别激光条纹,求取特征点的图像坐标,然后通过坐标系的转化,将图像坐标转化至机器人基坐标,通过多幅图像的拟合,计算出V形焊缝坡口的具体参数[12-13]。最终将数据传递给焊接机器人,焊接机器人可以沿着焊缝运动,搭配焊接设备系统的运作,最终实现机器人针对焊缝的自动焊接[14-15]。

实验之前必须进行摄像机标定、手眼标定以及结构光平面标定,以实现坐标系的转化。标定数据如表1和表2所示。

表1 标定参数

表2 特征提取后特征点的坐标参数

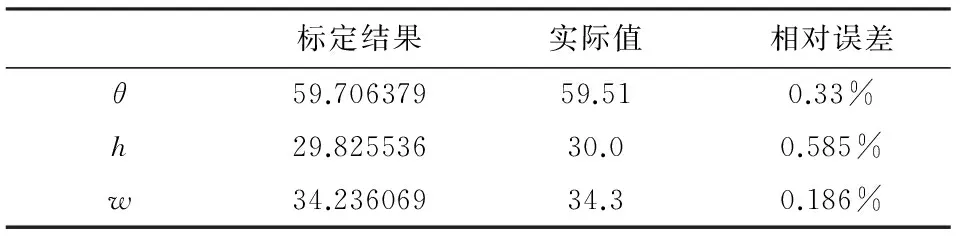

通过计算,焊缝参数实验结果如表3所示。

表3 焊缝参数比较

由表3可见,V形坡口的角度θ的相对误差为0.33%,高度的相对误差为0.585%,宽度w的相对误差为0.186%,由此表明,由此方法所得到的焊缝的参数精确,满足现场焊接的精度要求。

经过分析,实验依然存在的误差主要有下面几个原因:

(1)机器人系统存在误差;

(2)标定误差,主要来自摄像机标定、手眼标定以及结构光平面标定误差;

(3)算法误差,对于特征点的求取不准确。

3 结论

本文提出的焊缝识别算法具有很强的抗干扰性,可以针对背景复杂的焊缝图,能够准确地提取焊缝特征点的坐标。

(1)针对烟雾以及弧光噪声,选择新的LOG模板可以有效的掏空图像中面积较大的噪声,使其边缘化;

(2)采取新的ROI区域提取算法,以求像素累加值最大的方法,有效地避免了噪声的影响,可以准确的找到激光位置;

(3)运用了新的直线拟合法,选用斜率法粗略的估计特征点位置,再利用最小二乘法的拟合,能够更为准确的计算出直线的交点,即为特征点;

(4)将特征点从图像坐标系转换到机器人基坐标系实现数据的基坐标化,以便于焊缝的实际焊接。

[1] HE Y S. Autonomous Detection of Weld Seam Profiles via a Model of Saliency-Based Visual Attention for Robotic Arc Welding[J]. Journal of Intelligent & Robotic Systems,2016, 395-406.

[2] 王秀平,白瑞林. 基于线结构光视觉的焊缝类型识别与特征提取[J].电焊机, 2014,44(11):94-98.

[3] 邹媛媛,赵明扬. 激光拼焊焊缝质量自动检测技术研究及应用现状[J].焊接技术,2014,43(9):63-66.

[4] 何银水,张华,余卓骅,等. 水下焊接中V形焊缝的识别[J]. 焊接, 2007(7):49-52.

[5] Yu D H. Image detection and processing technology [D]. Xi′Xidian University Press, 2006.

[6] Qin T, Zhang K. Image Processing Methods for V-Shape Weld Seam Based on Laser Structured Light [J]. Foundations of Intelligent Systems, 2011,527-536.

[7] Liu G P. Algorithm Research on the Characteristic Parameter Extraction from the V-shape Weld Seam [J].Welding &Joining,2006(2):36-38.

[8] He Y S. Weld seam profile detection and feature point extraction for multi-pass route planning based on visual attention model [J].Robotics and Computer-Integrated Manufacturing, 2015,251-261.

[9] 秦涛. 基于改进最小二乘法的焊缝特征直线提取方法[J].焊接学报, 2012,33(2):33-38.

[10] D Rozenn. Statistical Hough transform [J]. IEEE Transactions on Pattern Analysis And Machine Intelligence, 2009,31(8):1502-1509.

[11] 张义顺,刘海波,梁盈.带状光源V字扭曲焊缝识别技术[J].沈阳工业大学学报, 2011,33(6):644-648.

[12] 李琳,林炳强,邹炎飚. 基于条纹式激光传感器的机器人焊缝跟踪系统研究[J]. 中国激光, 2015,42(5):26-33.

[13] 高岩,邵双运,冯其波. 一种激光扫描自动测量轮对几何参数的方法[J]. 中国激光, 2013,40(7):176-181.

[14] 刘燕,王刚,王国栋,等.用于机器视觉的焊缝图像获取及图像处理[J]. 计算机工程与应用, 2014,50(3):135-140.

[15] 王文建. 基于机器视觉的弧焊跟踪控制系统研究[D]. 天津:天津大学, 2008.

(编辑 李秀敏)

An Algorithm for Automatic Recognition of V Shape Weld Guided by Laser Vision

LING Chao1, JI Bao-jian1, HONG Lei2, SHEN Jian1

(1.College of Electrical Engineering and Control Science, Nanjing University of Technology, Nanjing 211800, China, 2. School of Automotive and Rail Transit, Nanjing Institute of Technology, Nanjing 211167, China)

How to accurately identify the light band that line structured light left in a V-shaped weld is a key technology of robot vision, this paper proposed a new method of image processing. First, the original image is filtered by median filter. Then use LOG filtering with a new template which can eliminate the large area and wide width noise. And next, extract the ROI region by use a new algorithm which can determine the location of the light band and improve the operation efficiency. Then delete the exposure point scattered on the image by particle filtering. After that, extract centerlines of laser stripes by thinning algorithm. In order to extract the feature points, the paper take the slope method to classify the points in the image, then the least square method is used for the linear fitting and got the welding parameters. Then, the feature point coordinates are transferred from the image coordinate system to the base coordinate system. Finally, weld parameters are obtained by calculating. Experimental results indicate that the relative error of V groove angle, height, width between the calculation result and the actual value are 0.33%, 0.585% and 0.186%,respectively. It can satisfy the requirements of the strong anti-interference ability, high precision and actual welding.

laser vision; least squares method; linear fitting; the robot base coordinate

1001-2265(2017)06-0009-04

10.13462/j.cnki.mmtamt.2017.06.003

2016-09-09;

2016-10-10

江苏省产学研联合创新资金-前瞻性联合研究项目(BY2014005-09)

凌超(1992—), 男, 江苏盐城人,南京工业大学硕士研究生, 研究方向为机器人视觉,(E-mail)1054189930@qq.com。

TH162;TG506

A