融合语义知识的深度表达学习及在视觉理解中的应用

2017-06-23张瑞茂彭杰锋

张瑞茂 彭杰锋 吴 恙 林 倞

(中山大学数据科学与计算机学院 广州 510006)

融合语义知识的深度表达学习及在视觉理解中的应用

张瑞茂 彭杰锋 吴 恙 林 倞

(中山大学数据科学与计算机学院 广州 510006)

(linliang@ieee.org)

近几年来,随着深度学习技术的日趋完善,传统的计算机视觉任务得到了前所未有的发展.如何将传统视觉研究中的领域知识融入到深度模型中提升深度模型的视觉表达能力,从而应对更为复杂的视觉任务,成为了学术界广泛关注的问题.鉴于此,以融合了语义知识的深度表达学习为主线展开了一系列研究.取得的主要创新成果包括3个方面:1)研究了将单类型的语义信息(类别相似性)融入到深度特征的学习中,提出了嵌入正则化语义关联的深度Hash学习方法,并将其应用于图像的相似性比对与检索问题中,取得了较大的性能提升;2)研究了将多类型信息(多重上下文信息)融入到深度特征的学习中,提出了基于长短期记忆神经网络的场景上下文学习方法,并将其应用于复杂场景的几何属性分析问题中;3)研究了将视觉数据的结构化语义配置融入到深度表达的学习中,提出了融合语法知识的表达学习方法,并将其应用到复杂场景下的通用内容解析问题中.相关的实验结果表明:该方法能有效地对场景的结构化配置进行预测.

深度学习;神经网络;语义嵌入;场景解析;相似性检索

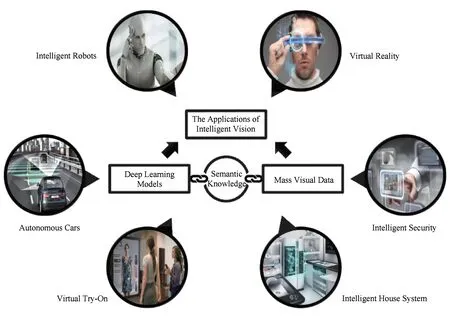

Fig. 1 Development of computer vision in various fields图1 计算机视觉在多个相关领域的发展

自1956年达特茅斯会议开始,有关人工智能的研究已经经历了50年的历史,而计算机视觉又是其中最为重要、最具有应用价值的研究领域之一.近10年来,伴随着神经网络(深度学习)研究的巨大突破[1-3],以及大型视觉数据集的不断涌现[4-6].基于深度神经网络的视觉模型对图像、视频等数据的表达能力获得了空前的提升,诸如图像分类、物体识别等传统视觉问题得到了有效解决,更加复杂多样的视觉任务也随之涌现.随着研究的不断深入,传统的深度模型(诸如卷积神经网络、递归神经网络等)已经很难满足日趋丰富的视觉应用任务.究其原因,主要集中于2个方面:

1) 深度学习植根于人工智能早期的联结主义研究.其核心目的在于构建较为通用的网络结构,进而通过组合的方式实现从简单模式到复杂模式的抽象.近几年来,深度学习作为机器学习的一个分支再次受到了学界的广泛关注[7].但是在网络结构的设计与改进方面,多数研究工作依旧侧重从学习理论入手,如使用Dropout技术[8]避免过拟合现象,使用ReLU函数[9]替代Sigmoid函数避免非线性变化过程中的梯度消失等.该类工作将视觉数据作为整体的处理对象,并没有对数据内部蕴含的信息进行深层次地挖掘,因此所能够处理的视觉任务也比较单一.而在传统的计算机视觉研究中,大量的深层次的视觉信息被用于模型的构建,使得模型能够处理的视觉任务也较为丰富.

2) 随着Web2.0技术及其周边应用的迅猛发展,互联网上的图片和视频数量在近几年呈极速增长趋势.例如,截至2014年,雅虎公司旗下的图片分享网站Flickr所托管的图片数量已经接近于100亿张.除了视觉数据本身的增长迅猛,与视觉数据相关的标题注释、文字说明以及标签描述也充斥在互联网中.这使得互联网中的视觉数据普遍包含了丰富的描述性信息以及语义知识.因此,如何利用这些语义信息[10]对视觉数据中所呈现的内容进行深层次的理解,从而更好地实现相关数据的自动标注、科学管理以及高效检索,成为了互联网信息资源高效利用的核心问题之一,受到了学术界和工业界的广泛关注.

基于以上讨论,如何更为有效地、充分地利用数据资源,挖掘数据里潜在的语义知识,进而提升深度表达模型的表达能力,实现更为丰富的视觉理解任务是当下计算机视觉领域亟待思考与解决的问题.如图1所示,深度模型表达能力的提升将进一步推动虚拟现实、增强现实、自动驾驶、无人机、智能媒体等相关领域的发展.

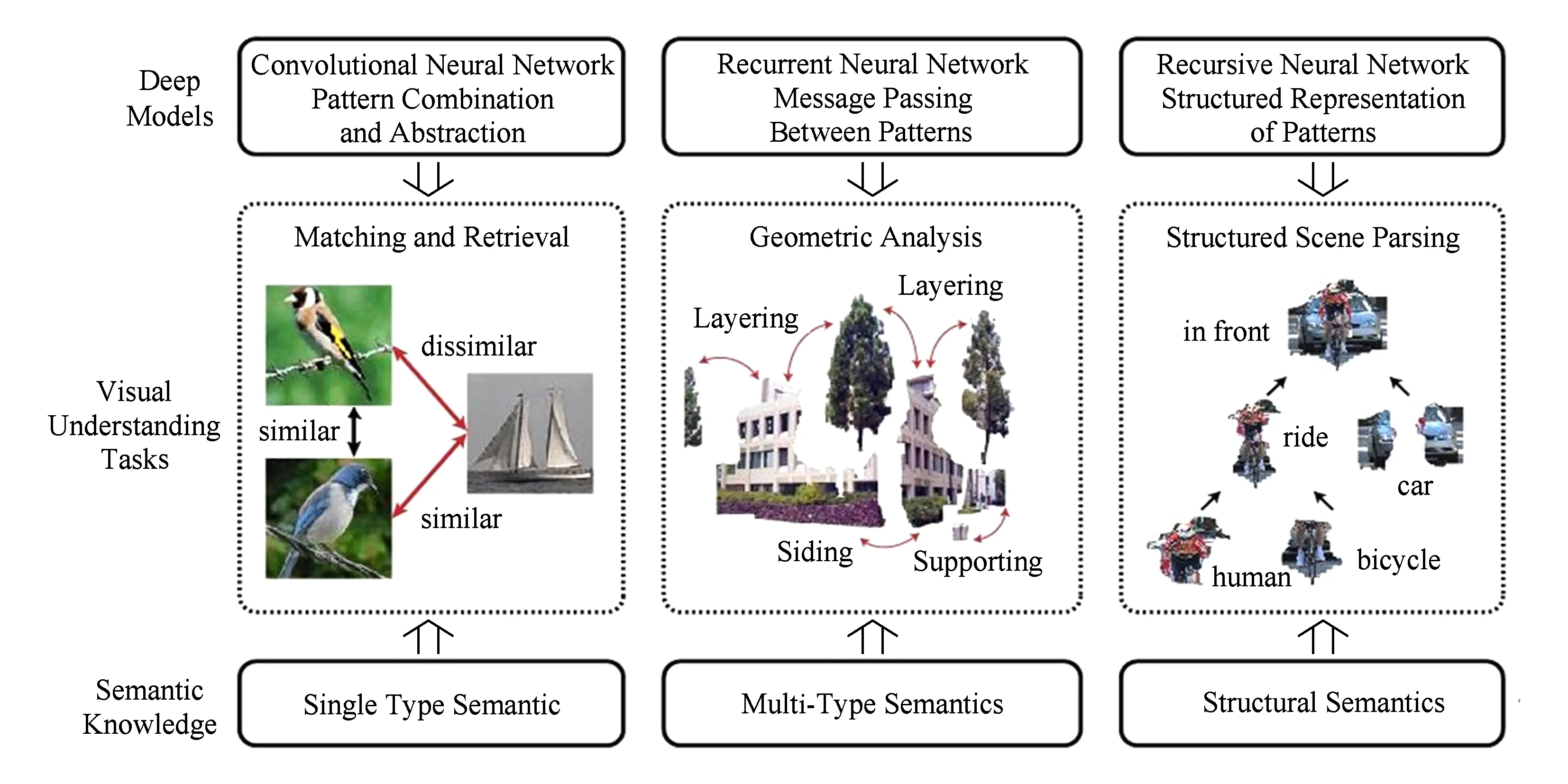

Fig. 3 This paper discusses how to combine semantic knowledge with existing deep model from three aspects图3 本文从3个方面探讨了如何将语义知识与现有深度模型相结合

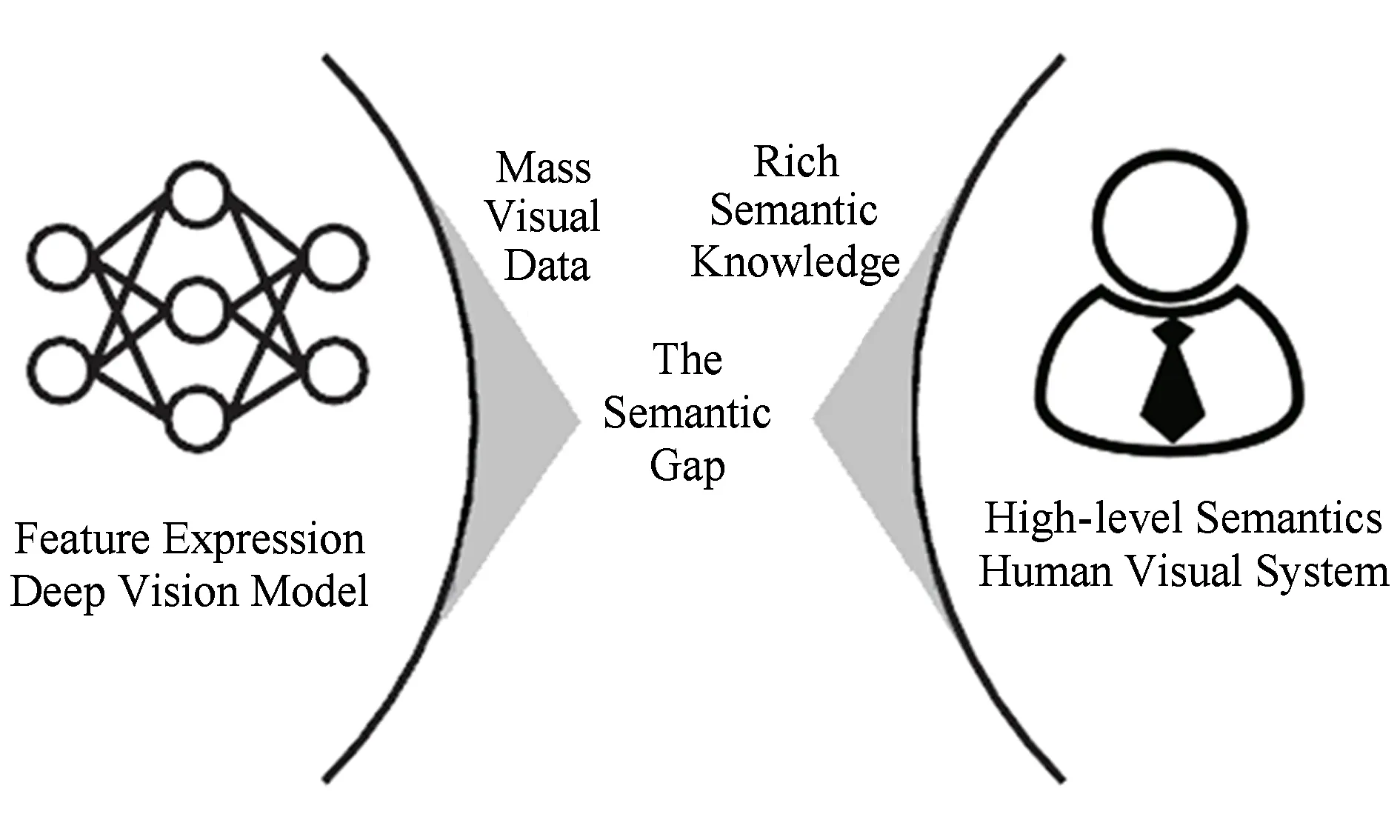

鉴于此,本课题致力于研究融合语义知识的深度表达学习.其特点在于利用多层的非线性模型来对复杂的视觉内容进行表达,同时借助丰富的语义知识来指导模型的学习和视觉特征的优化,从而实现面向特定任务的视觉理解.如图2所示,与传统的深度学习研究借助数据的体量去提升表达能力,进而填补语义鸿沟不同,本文的研究侧重从人类视觉出发,通过对丰富语义知识的建模来拓展模型的视觉表达能力,逐步消除语义鸿沟对智能视觉系统发展的桎梏.

Fig. 2 The semantic gap is eliminated by the integration of deep learning and semantic knowledge modeling图2 结合深度学习与语义知识建模逐步消除语义鸿沟

如图3所示,针对视觉理解的实际任务,本文将重点针对3个方面研究融合语义知识的深度表达学习:

1) 融合单类型语义知识的深度表达模型.即仅利用图像的类别信息来提升特征表达的判别能力.与传统的深度学习方法利用类别标签对图像的特征表达与分类器进行联合学习不同,本文通过图片之间的相似性关系来定义模型的损失函数,从而将度量学习与卷积神经网络[11]的训练集成在统一的框架中.在具体的视觉应用方面,我们将以基于内容的图像检索[12-13]问题来验证所提出模型的有效性.

2) 融合多类型语义知识的深度表达模型.对于图片中的不同场景区域,除了其自身的类别标签之外,区域之间的上下文信息也能有效地辅助模型的训练.本文利用场景区域的类别标签以及区域之间的交互关系进行建模,并通过循环神经网络[14]将上述的信息在整个场景中进行传递,从而更好地实现了场景上下文的表达学习.我们将该模型用于场景图像的几何属性分析问题,并在2个数据集上验证了其有效性.

3) 融合结构化语义的深度表达模型.人类视觉系统对复杂的场景结构具有较强的感知能力,例如场景中的物体类别、物体的空间位置、物体间的组合关系等.如何将上述具有明显结构的语义信息融入到深度模型的设计中,是视觉研究领域广泛关注的问题.本文将把一系列带有结构的语法知识融入到深度表达学习中,借助递归神经网络[15]的特性对场景中的物体、物体间的关系等进行结构化的组合与表达.最终,我们将利用该模型实现场景图像的深度层次化解析.

1 融合单类型语义的深度表达模型

随着互联网分享网站的兴起,以及拍摄设备成本的迅速降低,视觉数据呈现出爆炸式的增长,针对视觉数据的分类与快速检索技术成为了计算机视觉、多媒体领域重要研究的内容.鉴于视觉数据的Hash表示占用的存储空间少,检索时的效率极高,因此Hash技术作为一种有效的解决方式,在海量视觉检索领域[16-20]及其相关的应用领域受到了广泛的关注.近几年来,许多基于学习的Hash技术被提出[21-24],其核心的目标是学习一个紧致的、能够有效保持数据之间语义相似性的视觉表达,即相似的视觉数据在转换成为二进制编码之后具有较小的海明距离.

在所有的Hash学习方法中,监督式的方法[22,25]通过在学习的过程中嵌入单一类型的语义知识(通常是视觉数据的类别标签)获得了巨大的成功.监督式Hash学习方法通常包含2个步骤:1)数据库中存储的图像会被表达成视觉特征向量的形式;2)一系列基于单张图像或者图像对的Hash学习方法[26-27]被用于学习图像的Hash表达.但是,在先前的研究中,以上2个过程通常是被拆分成2个独立的过程,这样的拆分极大地限制了Hash表达的能力.因为第1个步骤产生的图像表达并不一定能够完美地契合Hash学习的目标.换言之,这里的图像特征表达不是面向于Hash学习这种特定任务的.所使用的语义知识也仅仅用于指导分类器或测度空间的学习.

为了解决以上问题,本文提出一种新的监督式位长可变深度Hash学习框架,该框架基于卷积神经网络(convolution neural network, CNN)构建了一个端到端的Hash生成网络,能够将输入图像直接变换成用于快速检索的二进制编码.同时,网络所输出的编码的每一位都会对应一个确定的权重.在检索的过程中,系统可以根据位的重要性,截取不同长度的Hash编码.在使用语义知识方面,该框架有别于借助类别标签对分类器和图像的特征表达进行联合学习的传统深度分类框架.本文的方法是基于三元组的相对相似性来构建模型的,即通过图像的类别标签构建图像之间的相对相似关系,并最终指导图像的特征以及Hash函数的联合学习.如前人工作所述[17,26,28],在排序优化方法中,基于三元组的方法能够有效地捕捉类内与类间的差距;同时我们也希望具有相似视觉外观的图像能够在海明空间中具有相近的Hash编码.因此通过引入一个正则项,进一步拓展了原有的基于三元组的Hash学习方法,引入部分受到了拉普拉斯稀疏编码(Laplacian sparse coding)[29]工作的启发.

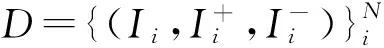

1.1 基于卷积神经网络的Hash表达学习

Hash学习的主要目标是找到映射h(x)将p维的图像特征表达x∈p,映射成q维的二进制Hash编码h∈{-1,1}p.本节我们重点介绍位长可变的深度学习框架,如图4所示,位长可变的深度学习框架将原始图片作为输入,将图像的特征表达学习与Hash函数的学习集成为一个非线性变化函数.同时,模型引入一个权重向量来表示每一个Hash位在相似性检索的过程中的重要性.

(1)

其中,Φw(·,·,·)是基于一个三元组的最大间隔损失.我们需要带权重的海明仿射[30]符合约束:

Fig. 4 The bit-scalable deep Hash learning framework图4 位长可变的深度Hash学习框架

(2)

于是有损失函数:

(3)

(4)

由于Hash编码是一种二值化的表示,因此式(4)是不连续且非可导的,无法直接使用梯度下降法来进行优化.为了解决此问题,本节提出使用类双曲正切函数o(·)来替代符号函数.而在测试阶段,我们将直接使用符号函数作为激活函数来获得离散的Hash编码.本文我们将Hash编码hi近似地表示为ri∈[-1,1]q:

r=o(φ(I)).

(5)

(6)

Hash编码在检索任务中的优势在于能够对位使用异或操作,或者使用查表的形式迅速度量Hash编码之间的距离.我们提出一种基于查表法(lookup table, LUT)的相似性计算方式来迅速地返回2个Hash编码之间带权的仿射值.令l表示Hash编码的长度,于是可以构建一个长度为2l的查询表,其长度等于2个Hash编码所有可能的异或操作结果.至此,在确定查询图片的情况下,查询结果的序列可以通过查表法迅速地返回.然而查询表的大小会随着Hash位的增长呈指数级增长.一种解决方式是将Hash编码分成等长的若干段(本节中该长度设置为8),每一段与一个子表相对应,则每一个子表所输出的带权相似性就与对定的Hash段相关联.最终,整个Hash编码的带权相似性可以通过累加每一段Hash编码的带权相似性获得,最后的排序结果也基于这一总的带权相似性.

1.2 视觉相似性检索中的应用

本节将在图像检索的标准数据集CIFAR-10上对本节所提出的位长可变的深度Hash学习框架的有效性进行验证.其中,将使用DRSCH来表示最完整的带有正则项的方法,同时使用DSCH来表述该方法的简化版本,即移除拉普拉斯正则项的版本.这里需要注意,DRSCH和DSCH均是使用了不带权重的训练方法,因此训练的过程需要预先确定Hash位的长度.而位长可变的Hash学习方法将分别使用BS-DRSCH和BS-DSCH表示.

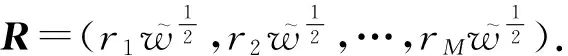

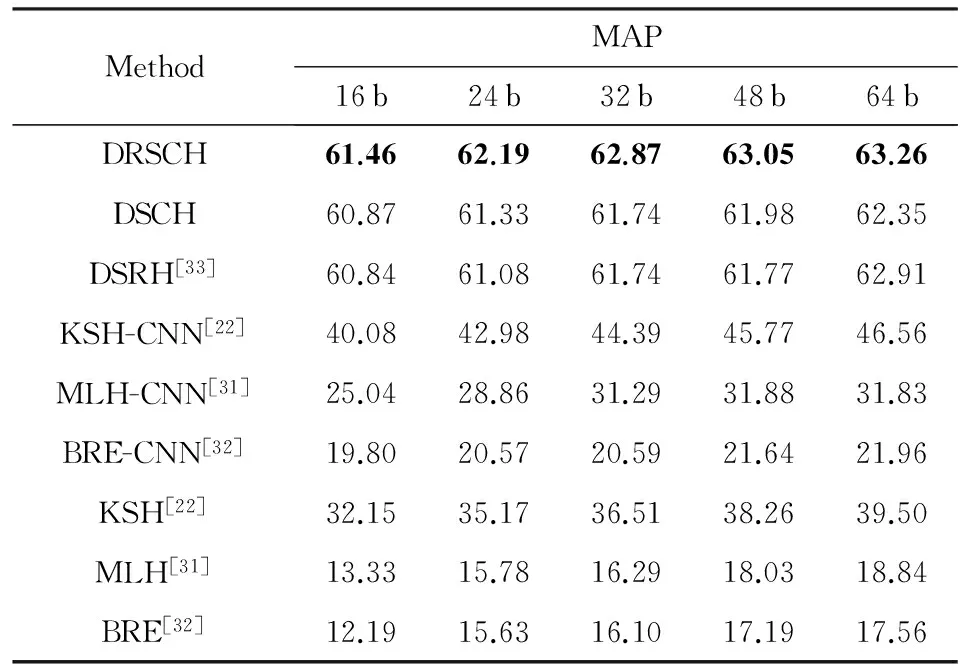

本节使用了近期提出的4种有监督的Hash学习方法作为对比方法,它们分别是最小损失Hash(MLH)[31]、二值重建嵌入(BRE)[32]、基于核方法的有监督Hash(KSH)[22]和深度语义排序Hash(DSRH)[33].为了公平比较,前3种方法我们还使用了深度特征,后文中用-CNN进行表示.提取CNN特征使用了AlexNet[34]网络,整个网络在ImageNet数据集上进行了分类任务的预训练.在这种情境下,CNN网络可以看作是一个通用的特征提取器[35].本节中所有关于DSRH的实验结果均是基于作者在Caffe框架上的自行实现结果.表1报告了具体的检索精度.图5报告了位长可变方法与直接训练方法前500张的准确率.

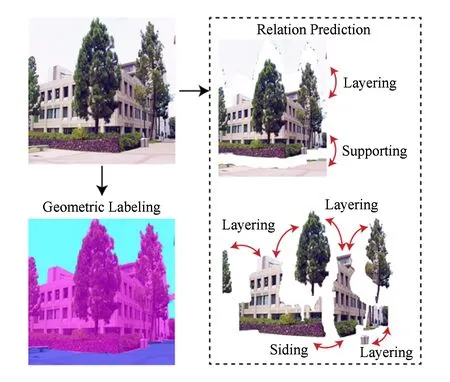

Table 1 Image Retrieval Results (Mean Average Precision, MAP) with Various Number of Hash Bit on the CIFAR-10 Dataset

Note: The bold indicates the best results.

Fig. 5 Precision on CIFAR-10 dataset图5 CIFAR-10数据集上的检索准确率

2 融合多类型语义的深度表达模型

从单张图片中感知场景的几何结构是人类视觉系统的一项基本能力,但是对于现有的多数智能系统,例如机器人、自动巡航仪,这仍旧是一项十分具有挑战性的任务.本节重点研究场景几何属性分析问题,即给定输入的场景图像,输出像素级别的场景几何面标注,同时对不同几何面之间的交互关系进行预测.与传统场景分析方法[36-40]仅仅用于分割出场景中的视觉元素(如“建筑物”、“车辆”、“树木”等)不同,场景的几何属性分析需要更深层次地理解场景中的内容.其主要包含2个难点:1)在确定的场景内容中,同一个几何区域常常包含不同的语义区域和空间配置.例如,树木和建筑物虽然属于不同语义区域,但是它们却同属于“垂直面”这一几何区域.2)除了对几何区域进行识别之外,对几何区域之间的关系预测也至关重要.一方面,几何关系的预测能够反过来约束几何面的预测;另一方面,关系的有效挖掘对于恢复场景的几何结构有着巨大的帮助.

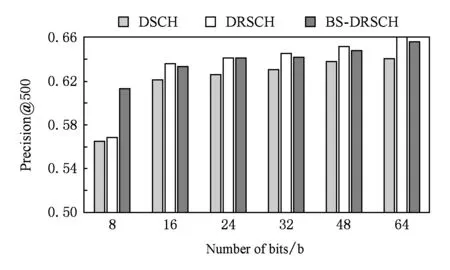

Fig. 6 An illustration of our geometric scene parsing图6 场景几何属性分析示意图

图6给出了场景的几何属性分析的示意图,其中第1列是输入图片以及算法预测出的几何标注,第2列是算法预测出的几何面之间的交互关系.针对这一问题,我们需要在模型的训练过程中引入类型丰富的语义信息.例如,场景区域的几何类别信息(天空、水平面、垂直面等),以及几何面之间的交互关系(同类关系、支撑关系、层次关系等).2种类型的语义知识可以相互作用,从3个方面共同促进几何属性分析的效果:1)相邻区块在局部的语义一致性.例如图6中,虽然“建筑物”和“树木”具有较大的外观差异,但是它们同属于“垂直面”的范畴.因此在建模的过程中,需要通过像素/超像素级的类别标签去促进较大几何区域的识别能力.2)局部区域上区块之间关系的一致性.例如,“建筑物”和“地面”之间应该存在“支撑关系”,“树木”和“地面”之间也存在“支撑关系”,则在局部关系一致性的前提下,“建筑物”和“树木”应该存在“类同关系”.3)几何面类别属性和关系属性之间的一致性,也就是说特定的几何面之间应该呈现特定的几何关系.

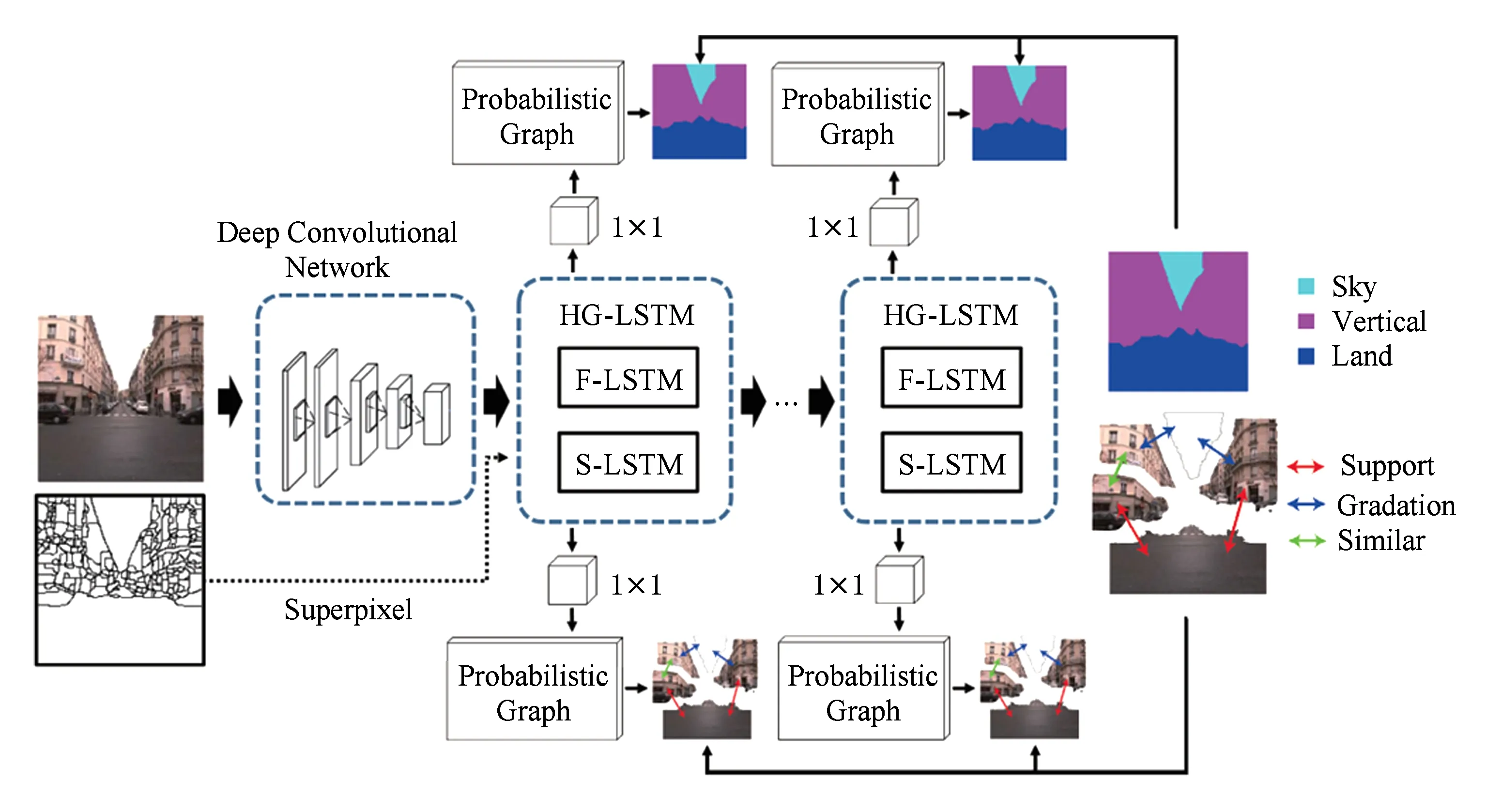

基于以上讨论,本文提出一种基于高阶图模型的长短期记忆循环神经网络(high-order graph LSTM network, HG-LSTM),并将其用于场景的上下文表达建模中,从而使得几何面的标注和几何面间交互关系的预测能够从局部到全局地保持一致性.该模型包括2个相互耦合的子网络结构:1)面向超像素本身构建的基于图模型的长短期记忆循环神经网络,用于对几何面进行像素级别的标注.由于几何面的分割是几何面关系预测基础,因此该子网络在本节中表述为First-order LSTM,简称F-LSTM.2)面向超像素之间关系构建的基于图模型的长短期记忆循环神经网络,用于对几何面之间的交互关系进行预测.这里图模型的节点用于表示任意相邻超像素之间的交互关系,因此该子网络在本节中称为Second-order LSTM,简称S-LSTM.与F-LSTM相类似,S-LSTM中的节点之间也能够相互传递信息,从而在局部上保持近邻超像素对之间语义关系的一致性.本节提出的2个子网络能够相互之间传递信息,从而使得整个网络更为全面地挖掘场景的上下文信息,联合的优化过程也有助于2个子任务的相互促进.

2.1 基于长短期记忆神经网络的上下文学习

本节提出一种新的基于高阶图模型的长短期记忆循环神经网络(HG-LSTM)模型用于对场景的上下文进行学习.借助多种类型的语义信息,实现场景几何属性的分析任务.如图7所示,输入图像首先经过卷积神经网络(CNN)生成图像的卷积特征表达.之后模型将借助第三方算法从图片中提取一系列的超像素,并将这些超像素的分割结果作用在卷积特征表达上,传入到F-LSTM网络中用于对几何面进行标注/分割.同时,任意2个相邻的超像素将产生一个关系表达,将所有的超像素对生成的关系集合构建起图模型并传入到S-LSTM中,从而进行几何面之间的关系预测.这里需要说明的是,在本模型中底层的超像素构成了一阶的图模型,图模型的边表示了2个超像素之间的关系.此关系将被抽象成二阶图模型中的节点.

Fig. 7 The proposed LSTM recurrent framework for geometric scene parsing图7 提出的基于高阶图模型的长短期记忆循环神经网络

(7)

(8)

(9)

Fig. 8 The structure of F-LSTM[41]图8 F-LSTM的结构示例[41]

(10)

(11)

(12)

2.2 场景几何属性分析中的应用

我们使用了2个数据集分别是LM+SUN数据集[42]和Cityscapes数据集[6].其中,LM+SUN数据集包含45 676张图片(21 182张室内图片、24 494张室外图片);Cityscapes数据集是一个用于对城市街道场景进行语义分割的数据集.本节使用了该数据集中的2 975张精细标注的图片作为训练图片,500张图片作为测试图片.本文使用了像素准确率、平均类别准确率和平均交并比(IoU)作为几何面标注评测指标,使用了平均准确率作为几何关系预测的评测指标.

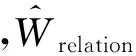

1) 几何面标注任务.表2列举了提出的方法与当前3种方法的平均IoU以及平均准确率.在2个数据集上实验结果说明了2个问题:①将F-LSTM网络和S-LSTM网络相结合能够有效捕捉复杂的上下文信息,进而对外观差异巨大的几何面进行有效地标注;②在较大的数据集LM+SUN上,效果更为明显.说明本文的方法在处理海量数据的问题时,将具有更为突显的效果.

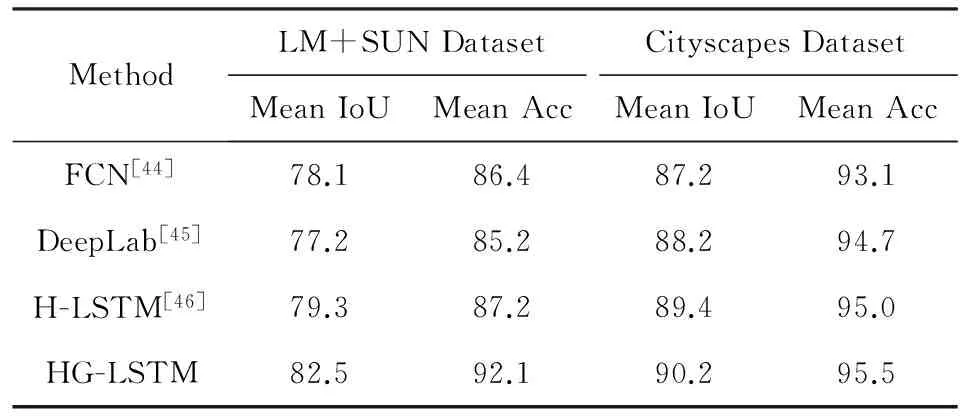

2) 交互关系预测.S-LSTM子网络可以对2个相邻超像素之间的几何关系进行预测.在所有实验中,我们将每张图片分割成1 024个超像素.任意2个相邻的超像素之间定义了其几何关系,表3展示了2个数据集上不同S-LSTM层输出的关系预测的平均准确率.通过实验可以看到,在大多数情况下,随着HG-LSTM层数的加深,预测的准确率也将进一步提升.这说明学习到的关系特征表达将随着层数的加深更加具有判别性.

3) 基于单张图片的三维重建.我们将利用文献[43]中的提出的pop-up模型,基于场景几何解析的结果实现单张图片的三维场景重建.该模型利用预测的几何面及其之间的关系对图片进行“切割和折叠”操作.这个过程可以分为2个步骤:①通过近邻超像素之间的几何关系恢复出三维的空间结构;②通过将图片汇总对应几何区域的外观、纹理信息赋值给三维空间中的不同平面,输出最终的重建结果.图9展示了部分场景图片以及在本文几何属性预测的结果之上,通过第三方软件重建出来的不同视角下的三维效果图,其中,图9(a)是输入的原始图像,图9(b)是重建后在不同视角下的结果.

Table 2 Performance of Geometric Surface Labeling Over LM+SUN and Cityscapes

Table 3 Geometric Relation Prediction with Different Number of S-LSTM Layers

Fig. 9 Some results of single-view 3D reconstruction图9 利用本节场景几何属性的分析结果实现的单张图片的三维重建结果

3 融合结构化语义的深度表达模型

场景解析任务的核心目的是通过构建模型,从图像中推断出符合人类认知的场景配置信息,例如物体的部件、物体本身以及它们之间的交互关系等.现有的场景理解工作多集中于场景的标注或分割问题[44,47-48],即为场景图像中的每一个像素赋予类别标签.但是却很少有工作针对输入的场景图片,生成有意义的结构化配置.其原因在于,该类工作通常包含两大困难:1)传统的融入语法知识的视觉模型[49]中,场景的结构化信息通常存在着多义性.相同的场景可能存在多个合理的结构化配置,因此,如何使得得到的场景结构化配置更加符合人类的认知规律,是解决该类问题的第1个挑战.2)模型训练数据的获取成本高昂.在使用传统的有监督学习方法对场景结构化解析模型进行训练时,需要包括像素级标签、物体之间关系、场景结构在内的多种语义信息.每种信息都具有较高的复杂性,且成体呈现较为明显的结构化.如果通过手工进行标注,标注的成本将极其昂贵.这也极大地限制了包括深度神经网络在内的数据驱动型模型在相关问题上的发展.

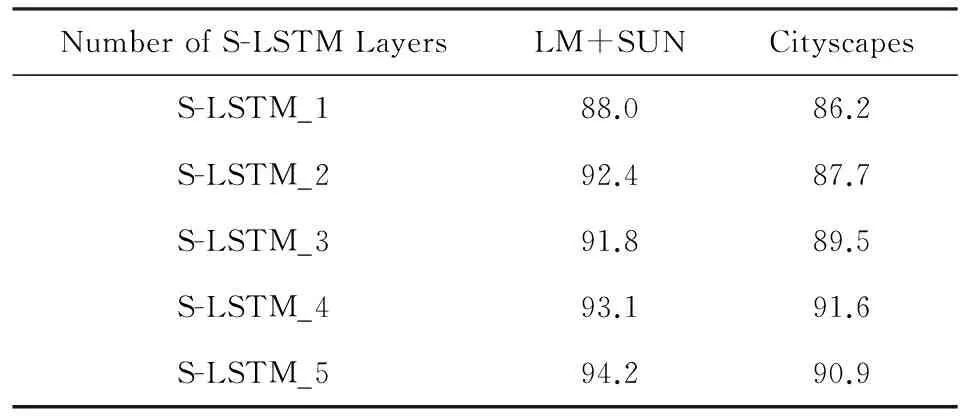

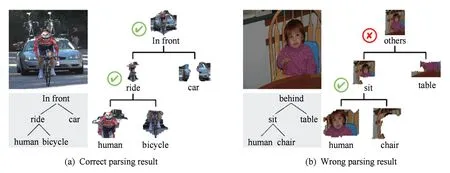

Fig. 11 The structured prediction of a scene image using our proposed CNN-RNN model图11 利用本节提出的CNN-RNN模型对场景图片进行结构化预测

图10给出了视觉场景解析的示意图,其中输入图片被自动地解析成包含分层的语义物体(黑色标签标注)以及物体之间的交互关系(红色标签标注)在内的结构化配置.当输入一副场景图片时,模型将会自动输出一个包含有物体之间交互关系的场景结构化配置.针对这一问题,我们需要在对深度模型训练过程中引入结构化的语义知识.例如,场景中像素/超像素级别的类别信息(人、马、草地等),物体之间的交互信息(人骑马、人牵马等),以及整个场景的组合配置结构,同时要尽可能降低上述语义知识获取的成本.一个直观的方法就是借助自然语言的标准解析模型[50]、WordNet词语知识库[51]以及相应的后处理操作,将图像的语句标注解析成一棵包含了名词和动词的语义树,从而廉价高效地获得场景结构化所需要的全部监督信息.

Fig. 10 An illustration of our structured scene parsing图10 视觉场景解析的示意图

为了更好地利用上述结构化语义知识,本节提出一种新的混合神经网络结构,用于深度结构化场景解析任务.该网络包含了2个相互连接的神经网络结构,底层是深度卷积神经网络(CNN)[1,44],上层是递归神经网络(RNN)[15].前者能够生成具有判别能力的图像特征表达,因此被广泛地应用于图像分类与物体识别任务中;后者则被一系列工作[48,52-53]证明能够对图像或者自然语言[15]中的结构化组合关系进行预测,其原因在于该类网络能够同时对语义和结构化表达进行递归地学习.对于本节所提出的CNN-RNN模型、CNN模型和RNN模型将协同工作.其中,CNN模型将被用作物体类别的表达学习;RNN模型将把CNN模型产生的特征表达作为输入,用于进一步生成场景的结构化配置.受图片描述生成模型[54-55]的启发,本节还提出了一种弱监督训练方法对CNN-RNN模型进行训练.

3.1 基于CNN-RNN混合神经网络的场景语义表达

本节所提出的场景内容解析模型主要完成以下3个方面工作:语义实体的标注、分层结构的生成以及物体之间交互关系的预测.图11举例说明了场景结构化解析的过程.

(13)

(14)

为了生成每一个实体类别的特征表达,算法将具有相同类别标签的像素聚合到一起获得具体的语义实体.我们将使用Log-Sum-Exp(LSE)[57]方法来融合不同像素的特征表达,最终获得物体区域的特征表达.

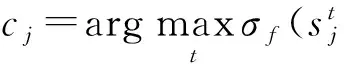

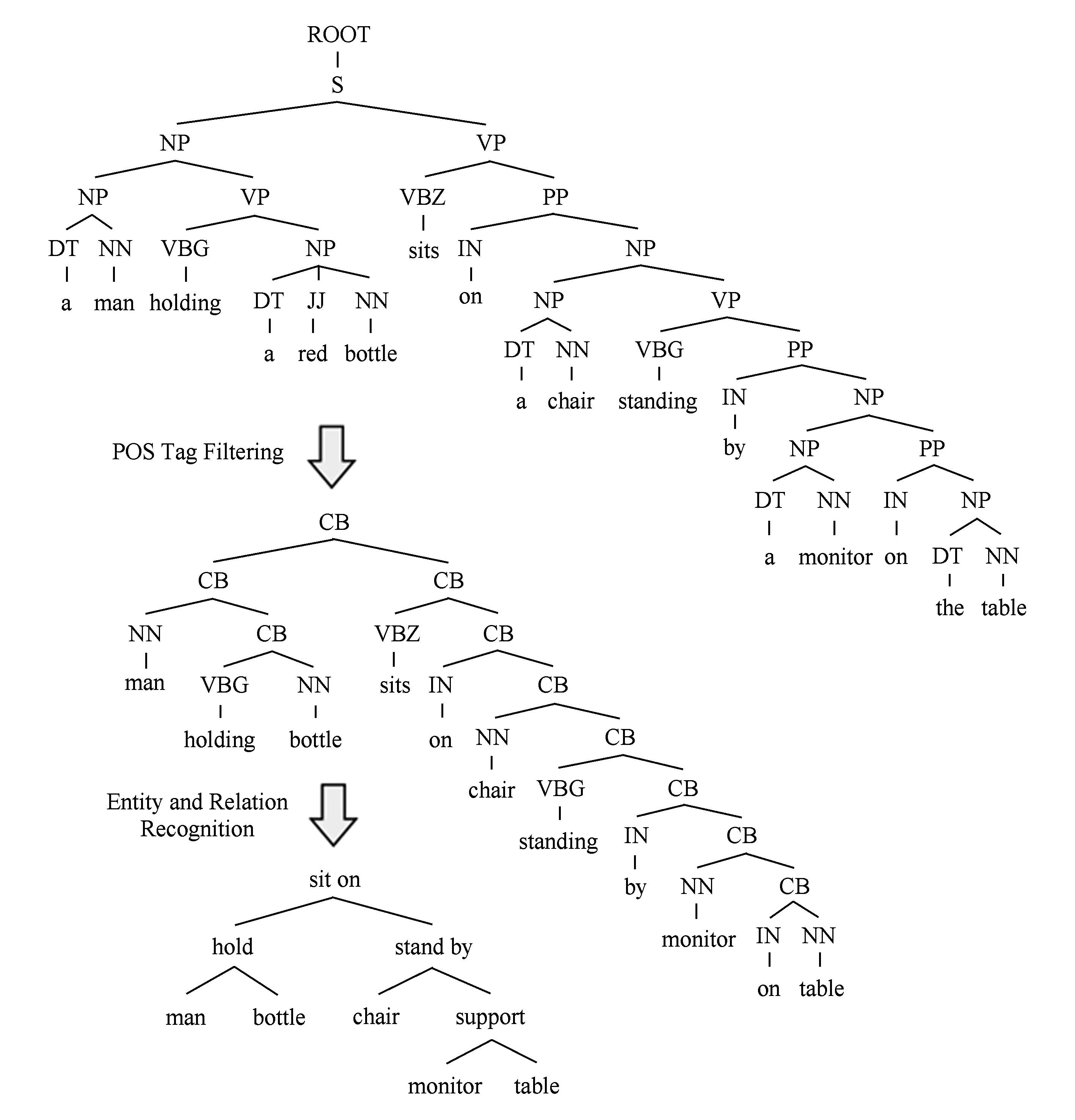

在本节的模型中,RNN模型将利用CNN模型所输出的每个语义类别的特征表达来生成图像的解析树,从而对图像进行内容上的分层表达,同时预测语义实体之间的交互关系.这里的RNN模型包含5个子网络,分别是中间转换网络(用transitionmapper表示)、节点合并网络(用combiner表示)、语义解释网络(用interpreter表示)、关系分类网络(用categorizer表示)和合并分数网络(用scorer表示),则RNN网络的参数集合可以表述为WR={Wtran,Wcom,Wcat,Wscore}.

Fig. 12 An illustrate of recursive neural network图12 递归结构示意图

如图12所示,实体的特征vk首先将被输入到中间转换网络中进行特征空间的变化,该层在神经网络中用一个全连接的神经网络表示,其中,xk表示映射的特征.而后,被变化的2个实体的特征(xk和xl)将被作为递归树种的2个子节点输入到节点合并网络Fcom,并输出父节点的特征表达xk l来表达2个子节点的语义信息及合并的结构信息.进一步,关系分类网络Fcat通过xk l预测2个节点之间的语义关系yk l.同时,合并分数网络Fscore度量出2个子节点能够合并的置信度hk l.

3.2 融入语法知识的弱监督学习方法

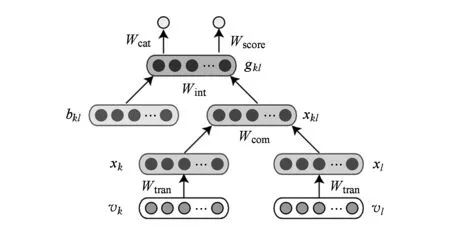

1) 语句预处理.为了能够利用图片的语句标注有效地进行场景的标注和结构化配置,本节将利用一些自然语言处理的基本技术将语句转换成为语义树.如图13所示.在图例的顶端,语言解析工具将根据输入的语句生成一个构造语法树.图例的中间展示了对构造语法树中的词语进行过滤的过程.图例的最低端展示了转换之后的语义树.

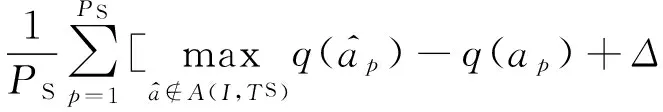

2) 损失函数. 对于输入图像Ii,假设全标记的语义图Ci和真实的语义树Ti已知.则损失函数可以定义为3个部分的累加,分别是:语义标记的损失JC,场景结构的损失JR,和模型参数的正则化约束R(W).对于一个包含Z张图片{(I1,C1,T1),(I2,C2,T2),…,(IZ,CZ,TZ)}的数据集,损失函数可以定义为

(15)

其中,W={WC,WR}表示模型所有的参数;WC,WR分别表示CNN模型和RNN模型的参数.

Fig. 13 An illustration of the tree conversion process图13 图片的描述语句变换成解析树的具体过程

① 语义表述的损失.令Cf表示最终预测的语义图,Ce表示第e个尺度下预测的语义图.则图像I在语义标注任务上的最终的损失函数可以定义为

(16)

其中,i={1,2,…,Z}.Lf表示最终预测语义图Cf以及全标记的语义图Ci之间的损失.为了考虑多尺度下的预测,我们同时定义了每一个尺度下的损失Le,{e=1,2,…,E}.

② 场景结构的损失.场景结构的损失可以进一步表示为2个部分.第1部分用于定义场景结构化的构建中的损失,第2部分用于定义物体之间关系的损失,

JR(W;I,T)=Jstruc(W;I,TS)+Jrel(W;I,TR),

(17)

Jstruc(W;I,TS)=

(18)

3.3 场景结构化解析中的应用

本节首先使用了PASCAL VOC 2012[58]的语义分割数据集作为测试本节提出方法的标准数据集.该数据集包括20个前景语义类和一个背景类,共计有1 464张标注图片用于训练,有1 456张图片用于测试.同时,我们还自行构建了一个新的用于场景语义解析的数据集SYSU-Scenes.该数据集包括5 046张图片,涉及到33个语义类别.对于每张图片,我们提供了物体的语义标注图、场景的分层结构标注和语义物体之间的交互关系在内的3种标注信息.在所有的图片中,将有3 793张图片用于训练、1 253张图片用于测试.在上述2个数据集中,我们分别定义了9种和13种常见的物体之间的交互关系.

Fig. 14 Visualized scene parsing result of weakly supervised method on PASCAL VOC 2012图14 PASCAL VOC 2012数据集上弱监督条件下的场景解析可视化结果

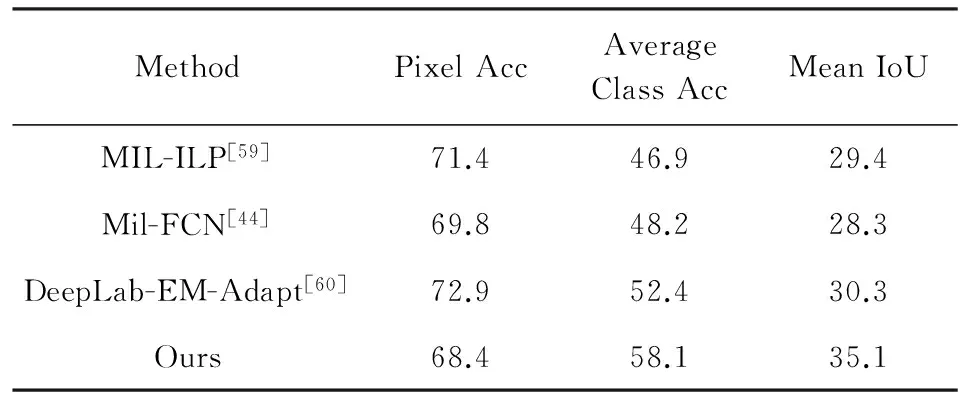

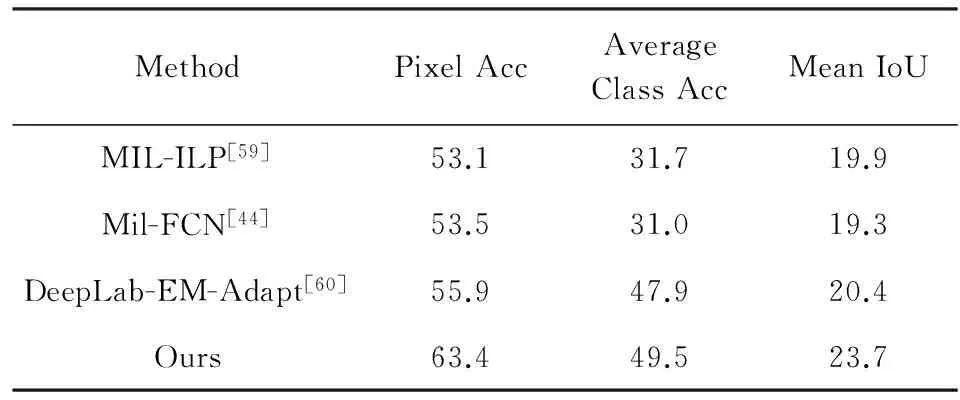

1) 语义标注任务.为了评测本节提出方法在场景的语义标注任务上的效果,我们将像素级别的标签预测图上采样到与原始的真实标注同样的大小.分别使用像素准确率、平均类别准确率和平均IoU[44]作为评测指标对本节提出的方法进行评估.对于语义标注任务,表4和表5分别列举了在3种评测指标下相关方法在PASCAL VOC 2012数据集和SYSU-Scene数据集上的结果.

2) 场景结构生成任务.本节首先引入2个用于场景结构生成的评测指标:结构准确率和平均关系准确率.令T是由CNN-RNN模型生成的图像的解析树,P={T,T_1,T_2,…,T_m}表示解析树所有子树的集合.对于叶节点,算法认为其正确当且仅当其对应的语义类别同语义树(由描述语句生成)中对应位置的名词相一致.对于非叶子节点T_i(存在2个子树T_l和T_r),我们说T_1是正确的,当且仅当左右子树都是正确的,且2棵子树之间的关系也是正确的.则关系的准确率可以定义为(#ofcorrectsubtrees)(m+1),该准确率可以通过递归遍历整个树结构而获得.而平均的关系准确率只是每个类别关系准确率的平均值.表6报告了PASCAL VOC 2012数据集和SYSU-Scene数据集上的测试结果.图14展示了场景结构化解析的可视化结果,图14(a)是解析正确的示例,图14(b)是失败的示例.在每个示例中,左边的树结构是基于图像的描述语句生成的,右边的树结构是通过本文的CNN-RNN模型预测得到的.

Table 4 PASCAL VOC 2012 Result of Weakly Supervised Methods

表4 弱监督学习方法在PASCAL VOC 2012 数据集上的结果 %

Table 5 SYSU-Scenes Result of Weakly Supervised Methods

Table 6 Comparison of Different Learning Strategies on Two Datasets

4 结束语

随着机器视觉技术、智能硬件、多媒体技术的快速发展,针对大规模视觉数据的高层次理解任务成为了当前最热门的研究方向.而如何借助丰富的语义知识提升深度模型的表达学习能力,又是处理上述任务的重要技术手段.本文主要研究了融合语义知识的深度表达学习.基于视觉数据的相似性比对,场景数据的内容解析等应用场景对该问题进行了深度探讨和研究.主要研究内容可以概括为3个方面:

1) 研究了将单类型语义知识融入到深度表达模型中,提出了嵌入正则化语义关联的深度Hash学习方法,并将其应用于图像的相似性比对与检索问题中;

2) 研究了将多类型语义知识与深度模型的学习相结合,提出了基于长短期记忆神经网络的场景上下文学习方法,并将其应用于复杂场景的几何属性分析问题中;

3) 研究了将视觉数据的结构化语义配置融入到深度表达的学习中,提出了融合语法知识的表达学习方法,并将其应用到复杂场景下的通用内容解析问题中.

本文针对融合语义知识的深度表达学习及其在视觉理解中的应用进行了相关的研究和讨论.但是针对实际的应用场景,完全解决计算视觉中各种面向高层理解的任务仍然需要长期不懈的探索.类似的任务包括如何利用更为丰富的语法知识实现深入和精确的解析算法、如何利用海量的视觉数据自动地强化模型的表达能力、如何处理高层视觉理解中的多义性和不确定性、如何针对视觉信息进行行为估计和预判、如何更为自然流畅地进行视觉问答等.上述问题的解决将对未来人工智能的发展起到积极的推动作用.从学术研究角度来说,设计和发展更为轻量化、高效化的表达模型来解决上述问题,使用无标注数据来进行模型的训练,自动地挖掘视觉数据中的语义知识都是亟待解决的学术问题.

[1]Krizhevsky A, Sutskever I, Hinton G E. Imagenet classification with deep convolutional neural networks[C] //Proc of Advances in Neural Information Processing Systems. Cambridge, MA: MIT Press, 2012: 1097-1105

[2]Ji S, Xu W, Yang M, et al. 3D convolutional neural networks for human action recognition[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2013, 35(1): 221-231

[3]Wang X, Zhang L, Lin L, et al. Deep joint task learning for generic object extraction[C] //Proc of Advances in Neural Information Processing Systems. Cambridge, MA: MIT Press, 2014: 523-531

[4]Russakovsky O, Deng J, Su H, et al. Imagenet large scale visual recognition challenge[J]. International Journal of Computer Vision, 2015, 115(3): 211-252

[5]Xiao J, Ehinger K A, Hays J, et al. Sun database: Exploring a large collection of scene categories[J]. International Journal of Computer Vision, 2016, 119(1): 3-22

[6]Cordts M, Omran M, Ramos S, et al. The cityscapes dataset for semantic urban scene understanding[C] //Proc of the 2016 IEEE Conf on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2016: 3213-3223

[7]LeCun Y, Bengio Y, Hinton G. Deep learning[J]. Nature, 2015, 521(7553): 436-444[8]Srivastava N, Hinton G E, Krizhevsky A, et al. Dropout: A simple way to prevent neural networks from overfitting[J]. Journal of Machine Learning Research, 2014, 15(1): 1929-1958

[9]Glorot X, Bordes A, Bengio Y. Deep sparse rectifier neural networks[C] //Proc of Aistats. Brookline, MA: Microtome Publishing, 2011, 15(106): 275

[10]Zhu Rong. Research on key problems of image understanding based on semantic information[J]. Application Research of Computers, 2009, 26(4): 1234-1240 (in Chinese)

(朱蓉. 基于语义信息的图像理解关键问题研究[J]. 计算机应用研究, 2009, 26(4): 1234-1240)

[11]LeCun Y, Boser B, Denker J S, et al. Backpropagation applied to handwritten zip code recognition[J]. Neural Computation, 1989, 1(4): 541-551

[12]Zhang Lei, Lin Fuzong, Zhang Ba. A forward neural network based relevance feedback algorithm design in image retrieval[J]. Chinese Journal of Computers, 2002, 25(7): 673-680 (in Chinese)

(张磊, 林福宗, 张钹. 基于前向神经网络的图像检索相关反馈算法设计[J]. 计算机学报, 2002, 25(7): 673-680)

[13]Li Qingyong, Hu Hong, Shi Zhiping, et al. Research on texture-based semantic image retrieval[J]. Chinese Journal of Computers, 2006, 29(1): 116-123 (in Chinese)

(李清勇, 胡宏, 施智平, 等. 基于纹理语义特征的图像检索研究[J]. 计算机学报, 2006, 29(1): 116-123)

[14]Elman J L. Distributed representations, simple recurrent networks, and grammatical structure[J]. Machine Learning, 1991, 7(2/3): 195-225

[15]Socher R, Manning C D, Ng A Y. Learning continuous phrase representations and syntactic parsing with recursive neural networks[C] //Proc of the NIPS-2010 Deep Learning and Unsupervised Feature Learning Workshop. Cambridge, MA: MIT Press, 2010: 1-9

[16]Jegou H, Douze M, Schmid C. Hamming embedding and weak geometric consistency for large scale image search[C] //Proc of the 10th European Conf on Computer Vision. Berlin: Springer, 2008: 304-317

[17]Wang J, Song Y, Leung T, et al. Learning fine-grained image similarity with deep ranking[C] //Proc of the 2014 IEEE Conf on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2014: 1386-1393

[18]Liu Z, Li H, Zhou W, et al. Contextual hashing for large-scale image search[J]. IEEE Trans on Image Processing, 2014, 23(4): 1606-1614

[19]Cao L, Li Z, Mu Y, et al. Submodular video hashing: A unified framework towards video pooling and indexing[C] //Proc of the 20th ACM Int Conf on Multimedia. New York: ACM, 2012: 299-308

[20]Peng Tianqiang, Li Fang. Image retrieval based on deep convolutional neural networks and binary hashing learning[J]. Journal of Electronics & Information Technology, 2016, 38(8): 2068-2075 (in Chinese)

(彭天强, 栗芳. 基于深度卷积神经网络和二进制哈希学习的图像检索方法[J]. 电子与信息学报, 2016, 38(8): 2068-2075)

[21]Li X, Lin G, Shen C, et al. Learning Hash functions using column generation[C] //Proc of ICML. Brookline, MA: Microtome Publishing, 2013: 142-150

[22]Liu W, Wang J, Ji R, et al. Supervised hashing with kernels[C] //Proc of 2012 IEEE Conf on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2012: 2074-2081

[23]Kong W, Li W J. Isotropic hashing[C] //Proc of Advances in Neural Information Processing Systems. Cambridge, MA: MIT Press, 2012: 1646-1654

[24]Zhu X, Zhang L, Huang Z. A sparse embedding and least variance encoding approach to hashing[J]. IEEE Trans on Image Processing, 2014, 23(9): 3737-3750

[25]Cheng J, Leng C, Li P, et al. Semi-supervised multi-graph hashing for scalable similarity search[J]. Computer Vision and Image Understanding, 2014, 124: 12-21

[26]Chechik G, Sharma V, Shalit U, et al. Large scale online learning of image similarity through ranking[J]. Journal of Machine Learning Research, 2010, 11(3): 1109-1135

[27]Frome A, Singer Y, Malik J. Image retrieval and classification using local distance functions[C] //Proc of the 19th Int Conf on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2006: 417-424

[28]Ding S, Lin L, Wang G, et al. Deep feature learning with relative distance comparison for person re-identification[J]. Pattern Recognition, 2015, 48(10): 2993-3003

[29]Gao S, Tsang I W H, Chia L T. Laplacian sparse coding, hypergraph laplacian sparse coding, and applications[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2013, 35(1): 92-104

[30]Weiss Y, Fergus R, Torralba A. Multidimensional spectral hashing[C] //Proc of the 12th European Conf on Computer Vision. Berlin: Springer, 2012: 340-353

[31]Norouzi M, Blei D M. Minimal loss hashing for compact binary codes[C] //Proc of the 28th Int Conf on Machine Learning (ICML-11). Brookline, MA: Microtome Publishing, 2011: 353-360

[32]Kulis B, Darrell T. Learning to Hash with binary reconstructive embeddings[C] //Proc of Advances in Neural Information Processing Systems. Cambridge, MA: MIT Press, 2009: 1042-1050

[33]Zhao F, Huang Y, Wang L, et al. Deep semantic ranking based hashing for multi-label image retrieval[C] //Proc of the 2015 IEEE Conf on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2015: 1556-1564

[34]Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[C] //Proc of Advances in Neural Information Processing Systems. Cambridge, MA: MIT Press, 2012: 1097-1105

[35]Babenko A, Slesarev A, Chigorin A, et al. Neural codes for image retrieval[C] //Proc of European Conf on Computer Vision. Berlin: Springer, 2014: 584-599

[36]Luo Xiping, Tian Jie. Overview of image segmentation methods[J]. Pattern Recognition & Artificial Intelligence, 1999, 12(3): 300-312 (in Chinese)

(罗希平, 田捷. 图像分割方法综述[J]. 模式识别与人工智能, 1999, 12(3): 300-312)

[37]Wang Xili, Liu Fang, Jiao Licheng. Multiscale Bayesian image segmentation fusin context information[J]. Chinese Journal of Computers, 2005, 28(3): 386-391 (in Chinese)

(汪西莉, 刘芳, 焦李成. 融合上下文信息的多尺度贝叶斯图像分割[J]. 计算机学报, 2005, 28(3): 386-391)

[38] He Ning, Zhang Peng. Varitional level set image segmentation method based on boundary and region information[J]. Acta Electronica Sinica, 2009, 37(10): 2215-2219 (in Chinese)

(何宁, 张朋. 基于边缘和区域信息相结合的变分水平集图像分割方法[J]. 电子学报, 2009, 37(10): 2215-2219)

[39]Guo Lei, Hou Yimin, Lun Xiangmin. An unsupervised color image segmentation algorithm based on context information[J]. Pattern Recognition & Artificial Intelligence, 2008, 21(1): 82-87 (in Chinese)

(郭雷, 侯一民, 伦向敏. 一种基于图像上下文信息的无监督彩色图像分割算法[J]. 模式识别与人工智能, 2008, 21(1): 82-87)

[40]Qiu Zeyu, Fang Quan, Sang Jitao, et al. Regional context-aware image annotation[J]. Chinese Journal of Computers, 2014, 37(6): 1390-1397 (in Chinese)

(邱泽宇, 方全, 桑基韬, 等. 基于区域上下文感知的图像标注[J]. 计算机学报, 2014, 37(6): 1390-1397)

[41]Liang X, Shen X, Feng J, et al. Semantic object parsing with graph LSTM[C] //Proc of European Conf on Computer Vision. Berlin: Springer, 2016: 125-143

[42]Tighe J, Lazebnik S. Superparsing: Scalable nonparametric image parsing with superpixels[C] //Proc of European Conf on Computer Vision. Berlin: Springer, 2010: 352-365

[43]Hoiem D, Efros A A, Hebert M. Automatic photo pop-up[J]. ACM Trans on Graphics, 2005, 24(3): 577-584

[44]Long J, Shelhamer E, Darrell T. Fully convolutional networks for semantic segmentation[C] //Proc of the 2015 IEEE Conf on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2015: 3431-3440

[45]Chen L C, Papandreou G, Kokkinos I, et al. Semantic image segmentation with deep convolutional nets and fully connected CRFS[J]. arXiv preprint arXiv: 1412.7062, 2014

[46]Peng Z, Zhang R, Liang X, et al. Geometric scene parsing with hierarchical LSTM[C] //Proc of IJCAI-16. Palo Alto, CA: AAAI Press, 2016: 3439-3445

[47]Lempitsky V, Vedaldi A, Zisserman A. Pylon model for semantic segmentation[C] //Proc of Advances in Neural Information Processing Systems. Cambridge, MA: MIT Press, 2011: 1485-1493

[48]Sharma A, Tuzel O, Liu M Y. Recursive context propagation network for semantic scene labeling[C] //Proc of Advances in Neural Information Processing Systems. Cambridge, MA: MIT Press, 2014: 2447-2455

[49]Zhu S C, Mumford D. A stochastic grammar of images[J]. Foundations and Trends®in Computer Graphics and Vision, 2007, 2(4): 259-362

[50]Socher R, Bauer J, Manning C D, et al. Parsing with compositional vector grammars[C] //Proc of ACL (1). Stroudsburg, PA: ACL: 2013: 455-465

[51]Miller G A, Beckwith R, Fellbaum C, et al. Introduction to WordNet: An on-line lexical database[J]. International Journal of Lexicography, 1990, 3(4): 235-244

[52]Socher R, Lin C C, Manning C, et al. Parsing natural scenes and natural language with recursive neural networks[C] //Proc of the 28th Int Conf on Machine Learning (ICML-11). Brookline, MA: Microtome Publishing, 2011: 129-136

[53]Sharma A, Tuzel O, Jacobs D W. Deep hierarchical parsing for semantic segmentation[C] //Proc of the 2015 IEEE Conf on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2015: 530-538

[54]Karpathy A, Li Fei-Fei. Deep visual-semantic alignments for generating image descriptions[C] //Proc of the 2015 IEEE Conf on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2015: 3128-3137

[55]Xu J, Schwing A G, Urtasun R. Tell me what you see and I will show you where it is[C] //Proc of the 2014 IEEE Conf on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2014: 3190-3197

[56]Xie S, Tu Z. Holistically-nested edge detection[C] //Proc of the IEEE Int Conf on Computer Vision. Piscataway, NJ: IEEE, 2015: 1395-1403

[57]Boyd S, Vandenberghe L. Convex Optimization[M]. Cambridge, UK: Cambridge University Press, 2004

[58]Everingham M, Eslami S M A, Van Gool L, et al. The pascal visual object classes challenge: A retrospective[J]. International Journal of Computer Vision, 2015, 111(1): 98-136

[59]Pinheiro P O, Collobert R. From image-level to pixel-level labeling with convolutional networks[C] //Proc of the 2015 IEEE Conf on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2015: 1713-1721

[60]Papandreou G, Chen L C, Murphy K P, et al. Weakly-and semi-supervised learning of a deep convolutional network for semantic image segmentation[C] //Proc of the IEEE Int Conf on Computer Vision. Piscataway, NJ: IEEE, 2015: 1742-1750

Peng Jiefeng, born in 1993. Received his BEn degree from the School of Mathematics, Sun Yat-sen University, Guangzhou, China, in 2016. Master candidate in computer science at the School of Data and Computer Science. His main research interests include deep learning, computer vision, and related applications.

Wu Yang, born in 1993. Received her bachelor degree from the School of Mathematics, South China University of Technology, Guangzhou, China, in 2016. Master candidate in computer science in the School of Data and Computer Science. Her main research interests include computer vision, data mining, machine learning and other relevant areas.

Lin Liang, born in 1981. Received his BSc and PhD degrees from the Beijing Institute of Technology, Beijing, China, in 1999 and 2008, respectively. Professor with the School of Data and Computer Science, Sun Yat-sen University, China. Associate Editor of Neurocomputing and the Visual Computer. His main research interests include new models, algorithms, and systems for intelligent processing and understanding of visual data, such as images and videos.

The Semantic Knowledge Embedded Deep Representation Learning and Its Applications on Visual Understanding

Zhang Ruimao, Peng Jiefeng, Wu Yang, and Lin Liang

(SchoolofDataandComputerScience,SunYat-senUniversity,Guangzhou510006)

With the rapid development of deep learning technique and large scale visual datasets, the traditional computer vision tasks have achieved unprecedented improvement. In order to handle more and more complex vision tasks, how to integrate the domain knowledge into the deep neural network and enhance the ability of deep model to represent the visual pattern, has become a widely discussed topic in both academia and industry. This thesis engages in exploring effective deep models to combine the semantic knowledge and feature learning. The main contributions can be summarized as follows: 1)We integrate the semantic similarity of visual data into the deep feature learning process, and propose a deep similarity comparison model named bit-scalable deep hashing to address the issue of visual similarity comparison. The model in this thesis has achieved great performance on image searching and people’s identification. 2)We also propose a high-order graph LSTM (HG-LSTM) networks to solve the problem of geometric attribute analysis, which realizes the process of integrating the multi semantic context into the feature learning process. Our extensive experiments show that our model is capable of predicting rich scene geometric attributes and outperforming several state-of-the-art methods by large margins. 3)We integrate the structured semantic information of visual data into the feature learning process, and propose a novel deep architecture to investigate a fundamental problem of scene understanding: how to parse a scene image into a structured configuration. Extensive experiments show that our model is capable of producing meaningful and structured scene configurations, and achieving more favorable scene labeling result on two challenging datasets compared with other state-of-the-art weakly-supervised deep learning methods.

deep learning; neural networks; semantic embedding; scene parsing; similarity search

mao, born in 1989.

his PhD degree from the School of Data and Computer Science, Sun Yat-sen University, Guangzhou, China, in 2016. His main research interests include computer vision, pattern recognition, machine learning, and related applications.

2017-01-03;

2017-03-30

国家自然科学基金优秀青年科学基金项目(6162200366) This work was supported by the National Natural Science Foundation of China for Excellent Young Scientists (NSFC) (6162200366).

TP391.41