VR终端时延和带宽需求分析

2017-02-06郑庆国

郑庆国,刘 雅

(中国移动通信集团公司研究院,北京 100032)

1 引言

虚拟现实(VR, Virtual Reality)是一种计算机仿真系统,是通过对三维世界的模拟创造出的一种交互系统。它利用计算机生成一种多源信息融合的交互式三维动态视景和实体行为系统仿真的模拟环境,并使用户沉浸到该环境中[1]。

早在20世纪60年代和70年代就已经出现了基于头戴式(head-mounted)设备和基于投影(projectbased)的虚拟现实技术,并在军事领域得到了应用,如飞机VR模拟驾驶、VR模拟战场等。近几年,手机终端的计算能力提高,手机逐渐能成为VR设备的计算平台,这拓宽了VR在游戏、影视等民用领域的市场。当手机可作为VR设备平台时,VR计算与蜂窝通信技术相结合成为可能,则VR应用将不再受特定场地限制,网络新业务应用空间得到极大拓展。

本文聚焦于VR承载在蜂窝通信网络上的时间延迟分析和VR终端数据带宽需求估算,分析VR在网络环境的计算模式,提出基于云端(Cloud)的VR模式和基于客户端(Client)的VR模式,并对5G网络承载VR业务进行了初步探讨(本文涉及的VR终端是基于手机平台的终端,不是专业VR设备终端)。

2 VR的时间延迟分析

2.1 VR技术介绍和时间延迟要求

(1)VR技术介绍

VR主要能实现模拟环境、感知等方面的体验。模拟环境是由计算机生成的、实时动态的三维立体逼真图像。感知是指VR应能实现人所具有的感知。除计算机图形技术所生成的视觉(vision)感知外,还包括触觉(touch and force perception)、听觉(hearing)、嗅觉(smell)、味觉(taste)等。

◆可视感知(Visual Perception):人看周围的世界时,由于两只眼睛的位置不同,获取到的图像略有不同,这些图像在脑子里融合起来,就形成了周围世界的整体景象,这个景象中包括了距离远近的信息。距离信息也可以通过眼睛焦距的远近、物体大小的比较等其他方法获得。

◆声音感知(Sound Perception):人能够很好地判定声源的方向。在水平方向上,靠声音的相位差及强度的差别可确定声音的方向,因为声音到达两只耳朵的时间或距离有所不同,常见的立体声效果就是靠左右耳听到在不同位置录制的不同声音来实现的。所以人们对声音会形成一种方向感。

◆触觉感知(Touch and Force Perception):触觉感知是指人通过触碰获得环境信息的方式。皮肤感应器和肌肉等其他身体部位的受体将信号传送到大脑加以解释,可形成能让人理解的环境表示,使人能识别压力等感觉。

◆嗅觉感知(Olfactory Perception):嗅觉是一种由感官感受的知觉,它由两个感觉系统:嗅神经系统和鼻三叉神经系统参与,嗅觉和味觉会整合和互相作用。嗅觉是外激素通讯实现的前提。嗅觉是一种远感,即为通过长距离感受化学刺激的感觉。

◆味觉感知(Taste):是指食物在人的口腔内对味觉器官化学感受系统的刺激并产生的一种感觉。从味觉的生理角度分类,传统上有4种基本味觉:酸、甜、苦、咸。

(2)VR时间延迟要求

在VR系统中,双目立体视觉起了很大作用。用户的两只眼睛看到的不同图像是分别产生的,显示在不同的显示器上。有的系统采用单个显示器,但用户带上特殊的眼镜后,一只眼睛只能看到奇数帧图像,另一只眼睛只能看到偶数帧图像,奇、偶帧之间的不同产生了视差,则形成了立体感。

在模拟环境中,每个物体相对于系统的坐标系都有一个位置与姿态,而人体也是如此。人所看到的景象是由用户的位置和头(眼)的方向来确定的,VR系统需要对人体位置和头、眼的方向进行跟踪,根据所处的位置相关信息计算出人所看到的景象。

VR时延(motion-to-photons latency)指VR设备头部运动与视觉感知的匹配程度。人类生物研究表明,人类头部转动和视野回传的延迟须低于20 ms,否则将因视觉和位置差异导致强烈眩晕[2-3]。

2.2 VR终端时间延迟分析

(1)VR时间延迟分类

单机版VR是指其整个VR系统没有通过外部通信网络承载,而是直接通过内部线缆连接而构成系统。

单机版VR时延=位置跟踪时延(Position Tracking Sensor Report Time)+图像处理计算时延(Picture Rendering time)+可视屏幕刷新时延(Refresh Rate Time)+屏幕显示延时(Pixel Switching Time) (1)

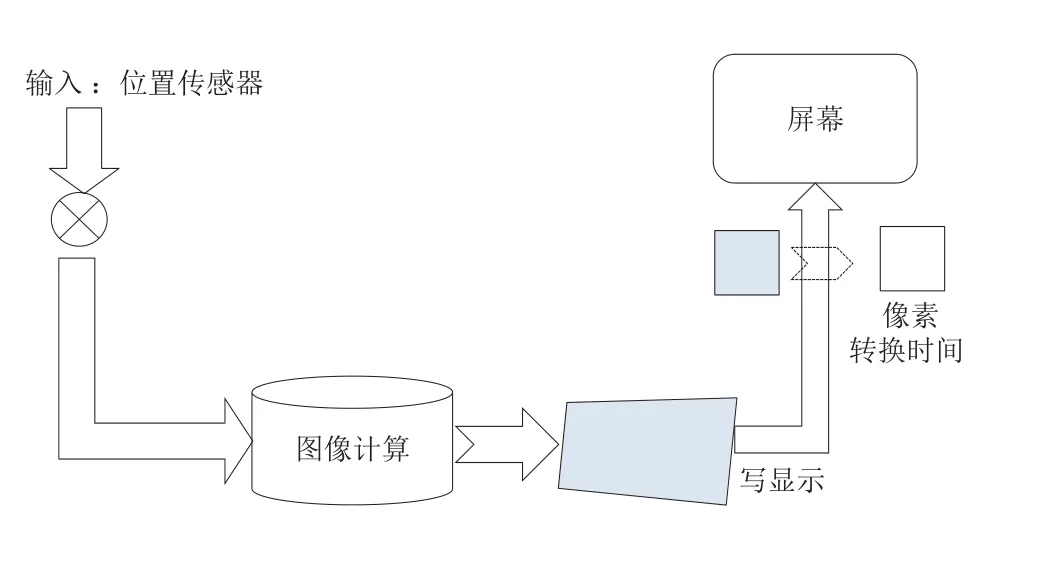

VR单机版时间延迟分析示意图如图1所示:

图1 单机版VR时间延迟分析示意图

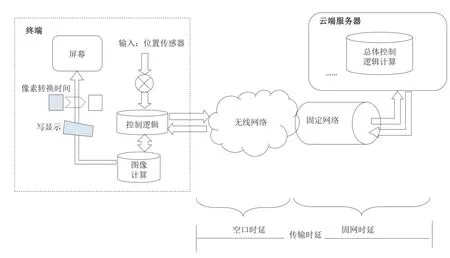

网络版VR:相关VR图像的形成被集中控制在服务器端中进行。VR客户端把传感器信息上传给服务器,根据上传的信息服务器计算出新的控制信息,并把控制信息下发给客户端,其中对VR图像的计算处理可在服务器端或用户端进行。

网络版本VR时延=位置跟踪时延+上行网络传输时延(无线网络时间延迟+固定网络时间延迟)+图像处理计算时延(Picture Rendering Time)+下行网络传输时延(固定网络时间延迟+无线网络时间延迟)+可视屏幕刷新时延(Refresh Rate Time)+屏幕显示时延(Pixel Switching Time) (2)

VR网络版时间延迟分析示意图如图2所示。

(2)网络承载VR时间延迟分析

关于网络承载VR的业务架构,根据进行VR图像计算时的位置,将其分成两种模式:1)基于云(Cloud)模式:VR图像计算和控制管理都在云端(Cloud)集中处理;2)基于客户端(Client)模式:VR图像计算放在终端(Client)集中处理,云端服务器主要做集中控制逻辑方面的处理。

◆基于云(Cloud)模式的VR时间延迟估算

VR图像的相关计算均由服务器端处理,VR终端把传感器信息上传至位于云端的VR图像计算程序,VR图像在计算完成后再被下传到VR终端,并在终端屏幕侧显示出来。基于云端(Cloud)的VR模式如图3所示。

VR时延=上行总时延(传感器信息上传)+下行总时延(图像计算及下传) (3)

VR终端的上行时间延迟=位置跟踪时延+发送时延+传输时延+接收时延 (4)

VR终端的下行时间延迟=图像计算时延+图像编码时延+发送时延+网络传输时延+接收时延+解码时延+显示时延(可视屏幕刷新时延+屏幕延时) (5)

基于云端(Cloud)模式的VR时延分析如图4所示。

◆基于客户端(Client)模式的VR时间延迟估算

VR图像相关计算都放在客户端,VR终端把传感器信息上传给位于云端的VR控制程序,服务器侧将计算后的新控制信息下传到客户端,最终客户端将计算出的VR图像显示到屏幕上。若VR业务是多用户版,则对于多个用户相互之间需要协调控制的VR业务,要在云端服务器上做总体控制逻辑计算;如果VR业务是单用户版,则不需要做集中控制,在终端侧就可以完成VR业务,不需要连接到云端服务器。基于客户端(Client)的VR模式如图5所示。

图2 网络版VR时间延迟分析示意图

VR时延=上行总时延(传感器信息上传)+下行总时延(控制信息下传+图像计算及显示) (6)

图3 基于云端(Cloud)的VR模式

图4 基于云端(Cloud)模式的VR时延分析

图5 基于客户端(Client)的VR模式

上行总时延=位置跟踪时延+发送时延+传输时延+接收时延(7)

下行总时延=控制计算时延+网络传输时延+发送接收时延+接收时延+图像计算时延+显示时延(可视屏幕刷新时延+屏幕显示延时) (8)

基于客户端(Client)的VR模式时间延迟分析如图6所示。

(3)网络承载VR时间延迟估算

LTE网络非预调度模式下数据面单向时延可达到10 ms左右,往返时延则超过20 ms,在预调度的模式下小区好点、极好点往返时延可控制在17 ms左右,小区中点、差点的用户面往返时延在20 ms左右,所以基于LTE网络很难满足承载VR时延20 ms的要求。5G网络用户面时延在eMBB场景中的目标要达到4 ms[6],更短的网络时延使5G承载VR业务成为可能。

下文将对基于云端(Cloud)和基于客户端(Client)的VR业务进行时延分析,参考文献[8-10]中的相关数据估算时延。

1)基于云(Cloud)的VR模式时间延迟估算

◆上行总时延=位置跟踪时延+发送时延+传输时延+接收时延=1~2 ms+2~5 ms+1 ms=4~8 ms

◆下行总时延=计算时延(5~10 ms)+编码时延(10~20 ms)+发送时延(1~2 ms)+网络传输时延(2~5 ms)+接收时延(1~2 ms)+解码时延(5~15 ms)+显示时延(可视屏幕刷新时延11.11 ms +屏幕延时1~2 ms)=5~10 ms+10~20 ms+1~2 ms+2~5 ms+1~2 ms+5~15 ms+11.11 ms+1~2 ms=36.11~67.11 ms

注:屏幕帧率90FPS,1080p。

◆总响应时延=上行总时延+下行总时延=4~8 ms+36.11~67.11 ms =40.11~75.11 ms

由以上的分析可知,目前要实现基于云端的VR难度较大,主要瓶颈在于图像处理计算的占用时延。故可以将云端计算进一步下沉,采用边缘计算方式,随着图像处理计算硬件能力的提升,云端VR模式值得期待。

2)基于客户端(client)的VR模式时间延迟估算

◆上行总时延=位置跟踪时延+发送时延+传输时延+接收时延=1~2 ms+2~5 ms+1 ms(发送时延+接收时延)=4~8 ms

◆下行总时延=控制计算时延(1 ms)+网络传输时延(2~5 ms)+(发送接收时延+接收时延)(1 ms)+图像计算时延(5~10 ms)+显示时延(可视屏幕刷新时延11.11 ms +屏幕延时1~2 ms)=1 ms+2~5 ms+1 ms+5~10 ms+11.11 ms+1~2 ms=21.11~30.11 ms

注:屏幕帧率90FPS,1080p。

3)总响应时延=上行总时延+下行总时延=4~8 ms+21.11~30.11 ms =25.11~38.11 ms

根据目前的分析,基于客户端的VR模式基本可行,随着手机终端硬件能力的进一步提升,基本可达到目前VR时延20 ms的要求。

图6 基于客户端(Client)的VR模式时间延迟分析

2.3 VR终端带宽需求分析

(1)VR屏幕分辨率分析

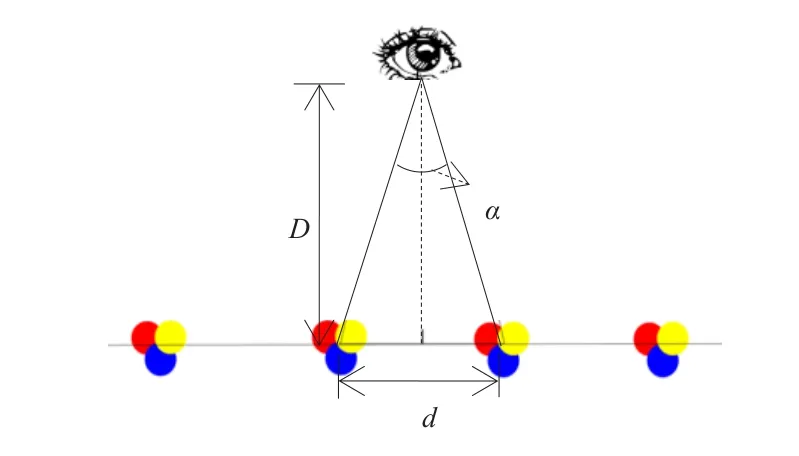

人眼睛的角度分辨率大约是1/60度(即1个弧分,one arcminute),这主要取决人瞳孔、背景光和被观测物体的颜色。人眼睛的角分辨率示意图如图7所示:

图7 人眼睛的角分辨率

根据图7中的三角关系,可以得出如下公式:

tan(α/2)=(d/2)÷D (9)其中,D为眼睛到屏幕的距离;α为角分辩率(angle resolution),是眼睛可看清楚的最小角度;d为两个像素之间的距离。

根据公式(9)可以计算出:

d=2Dtan(α/2) (10)

智能手机屏幕与眼睛之间的距离一般为D=12英寸(30.48 cm),而α=1/60,则可计算出d=0.003 5英寸,即PPI=286.5,也就是手机屏幕每英寸有286.5像素点,是人眼睛在30.48 cm处所能看清楚的最小分辨率。不同场景要求的屏幕最小分辨率如表1所示(注:1英寸=2.54 cm;像素密度(PPI, Pixels Per Inch)所表示的是每英寸所拥有的像素数量):

表1 不同场景要求屏幕的最小分辨率

手机屏幕PPI的计算公式如下:

根据公式得出计算结果如表2所示:

表2 不同屏幕分辨率对应的PPI值

由上文分析可得出初步结论:

D=4英寸的头戴式设备,需要其屏幕像素密度达859.4 PPI,目前4K(3 840×2 160)分辨率的屏幕(5英寸)为881 PPI,可满足VR分辨率要求。

(2)VR承载带宽分析

根据终端屏幕分辨率和像素点色彩的位数可以计算出一帧的数据量(bit),按终端支持帧率可计算出数据带宽。网络传输需要对图像数据进行编码,根据编码压缩比可估算出数据带宽大小,公式整理如下:

数据未压缩带宽=屏幕分辨率×色彩位数×帧率(12)

数据编码后的带宽=屏幕分辨率×色彩位数×帧率/编码压缩比 (13)

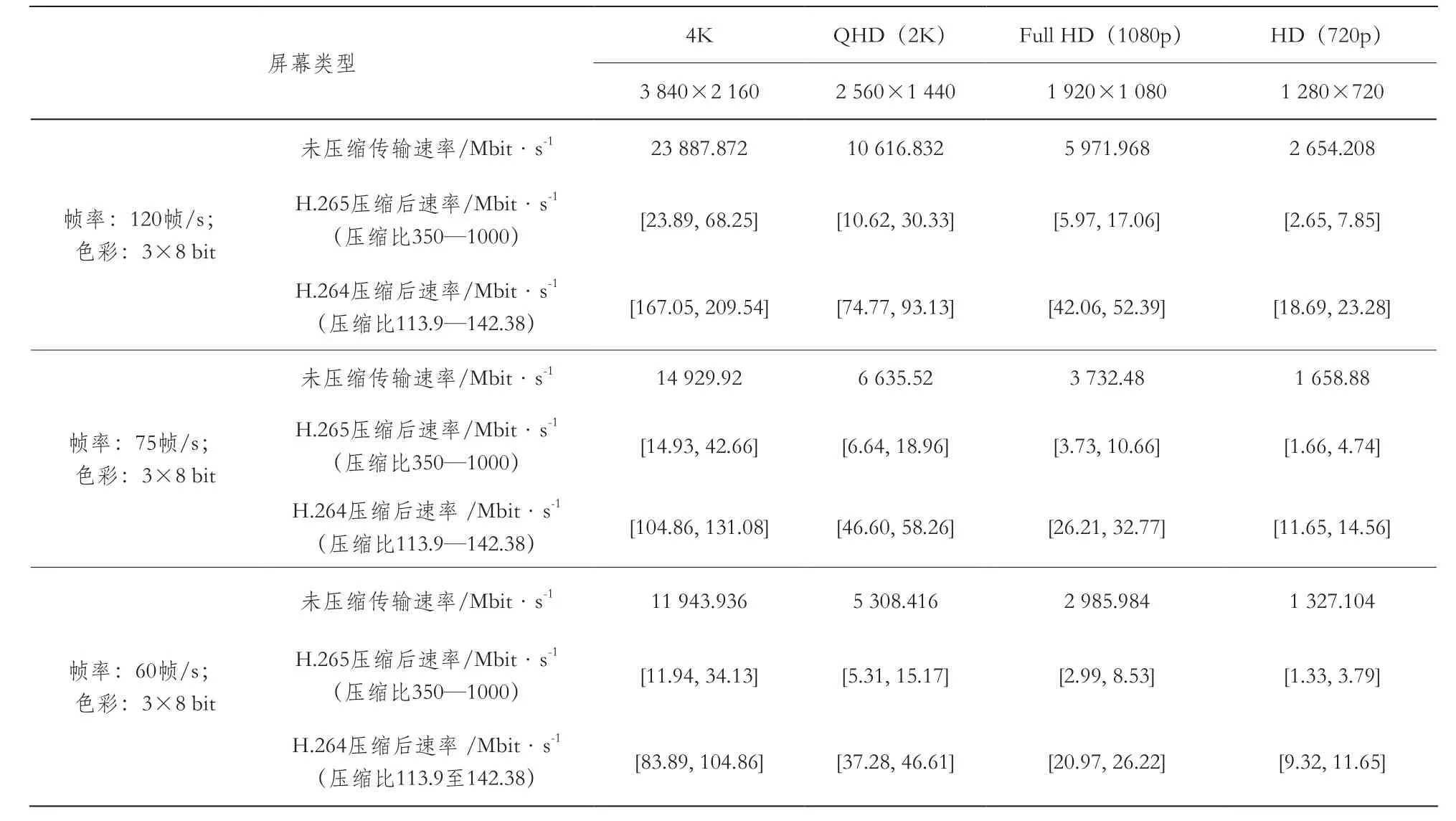

由上述计算公式及下文的典型参数取值,可估算出典型屏幕采用H.264和H.265编码时对应的带宽需求,具体如表3所示(帧率:120帧/s、75帧/s、60帧/s;色彩:3×8 bit)。

图像压缩标准以H.265和H.264为准,H.264压缩比率按经验值[113.9, 142.38]计算,H.265压缩比率按经验值[350, 1000]计算。

终端屏幕分辨率4K,帧率75帧/s,采用H.265和H.264编码实现VR需要的带宽如下:

◆采用H.265编码标准,传输带宽的需求

1个屏幕对应两个眼睛(通过分割)需要带宽范围:[14.93, 42.66] Mbit/s;2个屏幕分别对应两个眼睛需要总带宽范围:[29.86, 85.32] Mbit/s。

◆采用H.264编码标准,传输带宽的需求

1个屏幕对应两个眼睛(通过分割)需要带宽范围:[104.86, 131.08] Mbit/s;2个屏幕分别对应两个眼睛需要总带宽范围:[209.72, 262.16] Mbit/s。

表3 不同屏幕分辨率对应的估算数据带宽值

3 结束语

未来的5G网络预计将满足承载VR业务所需的低时延和高速率。针对基于手机平台的头带式VR终端,客户端(Client)VR模式是基本可行的方式。随着终端硬件能力的进一步提升,VR 20 ms的时延要求将能得到满足,但对于云端(Cloud)VR模式来说,时延挑战仍非常大,主要瓶颈在于目前对图像处理计算需要的时间较长,随着图像处理方面硬件能力的提升及边缘计算等新技术的采用,云端模式VR值得期待。

目前手机终端4K(3840×2160)分辨率的5英寸屏幕可满足头带式(VR设备屏幕与面部的距离为5英寸)VR设备的分辨率要求。在屏幕分辨率为4K,VR图像帧率为75帧/s,采用H.265编码标准,估算传输数据带宽范围为[30, 100] Mbit/s,这远小于5G终端要求支持单用户的最大峰值速率[6]。

随着5G网络技术的发展和相关硬件处理技术能力的提高,VR业务将能实现更好的网络承载,VR业务或将成为推动5G发展的重要动力之一。

[1] 中国电子技术标准化研究院. 虚拟现实产业发展白皮书[Z]. 2016.

[2] S M LaValle, A Yershova, M Katsev, et al. Head tracking for the Oculus Rift[C]//IEEE International Conference on Robotics & Automation. 2014: 187-194.

[3] B Iribe. Virtual Reality-A New Frontier in Computing[Z].2013.

[4] R S Allison, L R Harris, M Jenkin, et al. Tolerance of temporal delay in virtual environments[C]//Virtual Reality,IEEE. 2001: 247-254.

[5] 中国网. VR产业三大硬件技术标准 深度解析[EB/OL]. (2016-04-21)[2017-06-15]. http://www.csdn.net/article/a/2016-04-21/15837649.

[6] 3GPP TR 38.913 V14.0.0. Study on Scenarios and Requirements for Next Generation Access Technologies[S]. 2016.

[7] Ivan Lin, Brian Jeff, Ian Rickard. ARM Platform for Performance and Power Efベciency -Hardware and Software Perspectives[Z]. 2016.

[8] M U Yaseen, M S Zarfa, R Hill. High Performance Video Processing in Cloud Data Centres[C]//IEEE Symposium on Service-Oriented System Engineering. 2016: 152-161.

[9] W Pasman, S Persa, F W Jansen. Realistic lowlatency mobile AR rendering[C]//Virtual and Augmented Architecture (VAA’01). 2001: 81-92.★