基于时空一致性的立体视频稳像改进方法

2016-12-21孔悦,周军,谷潇

孔 悦,周 军,谷 潇

(上海交通大学 图像通信与网络工程研究所,上海 200240)

基于时空一致性的立体视频稳像改进方法

孔 悦,周 军,谷 潇

(上海交通大学 图像通信与网络工程研究所,上海 200240)

随着立体拍摄设备的普及,立体影视的后期稳像需求大大增加。直接观看带有抖动的立体视频,极易造成视觉疲劳。利用传统2D稳像方法分别稳像合成的立体视频很可能引入新的垂直视差,并且会导致水平视差的不稳定,大大影响视觉体验。因此,提出了一种改进的立体视频稳像方法,在3D运动模型进行单目稳像的基础上,增强两路视频的时空一致性约束,更好地稳定水平视差及消除垂直视差。最后对稳定后的序列进行合理的裁切放大。对几组不同的立体抖动视频进行了试验,测试结果表明所提出的方法是有效的。

立体视频稳像;视差;时空一致性

近年来,3D电影引发了一阵数字风潮,立体拍摄设备也正从专业级别转向大众消费级别。除了立体摄像机,一些手机也具备了立体照片和短片的拍摄功能。因此,对于立体视频处理的需求也日益增多。虽然2D稳像已被广泛研究,并且有些成熟的算法已被整合进日常软件,但是立体视频稳像处理还处在起步阶段,相关研究并不多。本文即探讨如何进行立体视频稳像,以获得较好的视觉效果。

视频稳定,即从视频中去除无意识、不需要的相机抖动,使得消费级的设备拍摄出来的视频,经过稳像处理,可以达到较为专业的效果。如果原视频存在抖动,不经处理直接观看的话,会产生视觉疲劳,可能会对眼睛造成短暂性的损伤,长期观看,则会造成视力下降。观看不稳定的立体视频时,除了两路视频原本的抖动之外,还会引入垂直视差,并造成水平视差的不稳定,更容易造成视觉疲劳,并产生明显的不舒适感。

只利用传统的稳像方法对左右两路视频序列进行单独稳像,无法保证立体视频模式下的观看效果。由于地面的不平整性或拍摄人员移动拍摄时对摄像机控制的不稳定性,以及垂直支架的两路摄像机位置是相对垂直的,产生抖动时,各自的抖动是不一致的。而对于双目摄录一体机来说,两个镜头水平固定,产生的同步抖动可以直接利用单目稳像的方法进行去除。然而由于左右两路视频的水平视差是个较小的固定值,无法调节,双目摄录一体机拍摄适用范围较小。因此在研究的时候,视频素材的获取都是利用垂直支架的立体摄像机进行拍摄的。

为了达到较好的立体视频稳像效果,本文提出了一种改进的基于时空一致性的立体视频稳像方法。首先使用SURF算法进行特征点的检测以及匹配,接着使用基于特征点追踪的SFM[1-3]算法获取摄像机的内置参数和外部参数,对两路相机参数分别进行平滑。然后加上改进的基于特征点时域和空间匹配的左右关联一致性约束来解决视差问题。最后对视频序列进行合理的裁切及放大,呈现出视觉效果较好的立体稳定视频。

1 稳像算法的研究现状

传统的单目视频稳像按所使用的运动模型,可以分为2D、2.5D和3D稳像。

2D视频稳像,这里主要讨论电子稳像。利用一系列2D图像变换方法,如相似变换、单应变换、仿射变换等,来表示相机的运动,并且通过平滑这些变换以达到视频稳像的目的。早期的2D视频稳像算法应用了连续帧之间的仿射变换估计算法[4-5],仿射变换和相似变换相结合的估计算法[6],仿射变换和单应性变换相结合的估计算法[7-8]等,并且通过低通滤波来减少高频的相机抖动,以达到稳像的目的。陈等人[9]大量运用仿射变换,使用了多项式曲线来拟合理想的相机轨迹,达到抑制相机低频抖动的效果。Gleicher等人[10-11]将相机路径进行分割,然后分段进行平滑,并且运用了摄影规则,最终得到效果比较理想的相机路径。Grundman[12]使用了仿射变换和高维的单应变换相结合的方法,提出了利用L1范数进行相机路径优化的稳像算法。

2.5D视频稳像,即在2D稳像算法的适用性和3D稳像算法的复杂度上做了一个权衡,虽然不要求完整的3D重建,减少了计算成本,但是需要长时间的特征追踪,例如连续30帧以上。早在1998年,朱等人[13]就提出了2.5D稳像的概念,即在2D稳像基础上加入深度信息。该算法分为4个模块:基于金字塔的运动检测、运动识别和2.5D运动参数的估计、惯性运动滤波和基于仿射变换的运动补偿。算法中每一个点都引入了一个深度相关的参数。这个运动模型又包含了3个子模型:2.5D移动摄影车模型、2.5D水平运动跟踪模型和2.5D垂直运动跟踪模型。近年来刘等人[14]利用从连续50帧以上的特征跟踪中提取出来的子空间的轨迹进行平滑,达到了类似3D稳像的效果。

3D视频稳像,即建立在明确的三维结构上的单目视频稳定方法,需要知道摄像机的三维姿态以及场景的深度。利用SFM算法[2-3]或者采用额外的深度传感器[15],根据原先抖动的3D相机路径,经过平滑处理得到虚拟的理想相机路径。也有人利用RGBD照相机[16]获取深度信息,来进行3D稳像。刘等人[17]提出了一种基于内容保持的翘曲的3D视频稳像算法。

以上方法都是针对单目稳像,而对于双目甚至多目稳像,相关研究很少。刘等人[18]将子空间稳像的方法延伸到了双目稳像上。Chu等人[19]将陀螺仪和加速剂嵌入3D手机,获取相机的几何结构信息,以进行运动补偿。但是这种移动设备上的双镜头是非常同步的,用传统方法进行稳像也可以得到不错的效果。笔者所讨论的是垂直支架式3D立体摄像机进行拍摄时的情形,水平机位与垂直机位的抖动并不完全同步。那么在单目稳像的基础上,就要考虑添加双目立体稳像的特殊性,即需要呈现较为稳定的水平视差和零垂直视差。

2 算法介绍

本文所要介绍的是基于3D模型进行的双目立体视频稳像的改进方法,主要包含运动估计、运动平滑以及图像合成三个模块。和传统2D稳像不同的是,运动估计是在SURF特征点匹配并经过RANSAC[20]去除异值之后,利用张等人基于特征跟踪的SFM[3]算法得到摄像机的内置参数以及外部参数。然后利用其结果,对摄像机的运动进行平滑,通过最小化相机的旋转、平移以及尺度变化的加速度来对相机自身运动进行平滑,并且同时考虑未定义区域的控制[21]。接着,本文将文献[21]中利用3D模型进行的单目稳像方法扩展到立体稳像上,为了控制左右序列的一致性,除了在时域上进行了特征点的匹配和跟踪,在空间上也进行了左右视点特征点的匹配,通过控制左右视点水平视差的相对稳定程度以及最小化垂直视差来达到左右一致性的约束。C.W. Liu[22]在传统2D稳像方法上加入了一种视差约束。本文将其与3D运动估计模型相结合,并且对视差约束方法进行了改进。最后图像合成,利用摄影规则对稳定后的视频进行合理裁切和修复。本文立体视频稳像方法的流程图如图1所示。

图1 立体稳像算法流程图

第一步,在单目稳像部分,本文利用SURF快速特征点检测算法对原抖动的左右两路视频序列VΙ,l,VΙ,r的每一帧进行检测,在时域上进行前后关联帧的特征点匹配,并且在每一帧,对左右图也进行特征点的匹配,并使用RANSAC去除误匹配的点,得到内点所占比例最高的最小点集。得到有效特征匹配点集后,进行特征跟踪,得到多条鲁棒的特征轨迹。但是对于视频稳像来说,轨迹越长,说明特征点越有可能属于相对静止的背景,越有利于稳像,轨迹越短,说明特征点很可能属于运动物体,这样的轨迹在稳像处理时会产生干扰。这里,设最短有效轨迹长度为20帧(根据不同视频可以调整设置),剔除较短的轨迹之后,得到一个有效特征轨迹的集合。

第二步,利用基于特征追踪的SFM算法获取摄像机的内部参数和外部参数。内部参数K为一个3×3的矩阵,包含了焦距的初始值f以及原点坐标的初始值(cx,cy)(一般选取图像的中心),η为像素长宽比,这里处理的都是方形像素,即η=1。

(1)

外部参数由一个3×3的旋转参数矩阵和一个三维的平移向量构成,其中旋转参数矩阵由欧拉角表示。世界坐标系和相机坐标系之间的关系可以表示为

Xworld=R·Xcam+t

(2)

利用得到的相机参数,进行相机轨迹的优化。对于单目稳像,进行两方面的约束。一是视频的平滑程度Esm,二是对于未定义区域的控制项Esl。

Es=Esm+Esl

(3)

视频的平滑程度Esm用摄像机运动的旋转、平移、尺度变换的平滑度Erm,Etm,Efm的加权和来表示。而平滑度,这里用其加速度来表示。

(4)

Erm,Etm,Efm定义[21]如下:

(5)

(6)

(7)

未定义区域的控制项Esl是为了让稳定后的视频边缘出现的黑边不会过大,避免稳像后需要过多的裁切处理。

(8)

其中Erl,Etl,Efl定义[21]如下:

(9)

(10)

(11)

使用SFM算法得到相机运动参数后,进行平滑处理,相应的视频抖动也就可以去除,得到较为稳定的效果。旋转、平移、缩放相对独立,转化成式(12),可分别利用最小二乘法进行线性最优化求解,这里权值均用平方项,是为了计算方便。

(12)

第三步,利用得到的左右两路视频平滑后的相机参数和轨迹,如果直接将两路单独稳像的视频以立体模式呈现,会有比较差的视觉体验。立体视频左右帧的水平视差需要保持稳定,以免造成视觉疲劳。同时,需要消除引入的垂直视差,在立体观看模式下,扭曲的画面会对人眼造成一定的伤害。

(13)

其中θi表示第i帧的旋转角,Δi,x和Δi,y是第i帧平移向量的x和y分量,i为第i帧的缩放系数。

双目约束Ed原定义[22]如下:

(14)

(15)

(16)

本文对双目约束进行改进,增强左右视点的视差约束:

(17)

(18)

(19)

第四步,图像合成。对视频序列进行合理裁切,去掉边缘少量未定义区域,尽量保证立体视频窗口中主要物体不触及边缘,且始终在窗口中,如果此时某些帧还存在未定义区域,则利用相邻帧进行图像边缘缺失信息的修复。

3 实验结果及分析

本文是利用MATLAB2013进行编译,在Intel Xeon F5-2643四核,主频3.30 GHz的CPU,内存16 Gbyte的DELL Precision T7600台式机上进行的测试,测试视频为立体摄像机实拍的室外场景,视频原格式均为HD1080 25i,分辨率为1 920×1 080,25 f/s(帧/秒)。

本文选取了3段不同的测试视频,如图2所示,一段是摄像机不动人动的视频“茶”,一段是摄像机在动人也动的视频“世博”,还有一段是摄像机在动,拍摄静态景物的视频“盛宣怀”。视频长度均为10 s,即250 f。这三段实拍的立体视频均出现了不同程度的抖动,可见立体视频稳像算法研究的必要性。

图2 实验视频序列

这里以“世博”视频序列为例。图3为左右视点进行特征点匹配的示例。可以看到有点误匹配情况,后面可以利用RANSAC去除。匹配点对基数相对较大,即使不能完全去除误匹配点对,对整体并没有太大影响。

图3 左右视点SURF特征点匹配

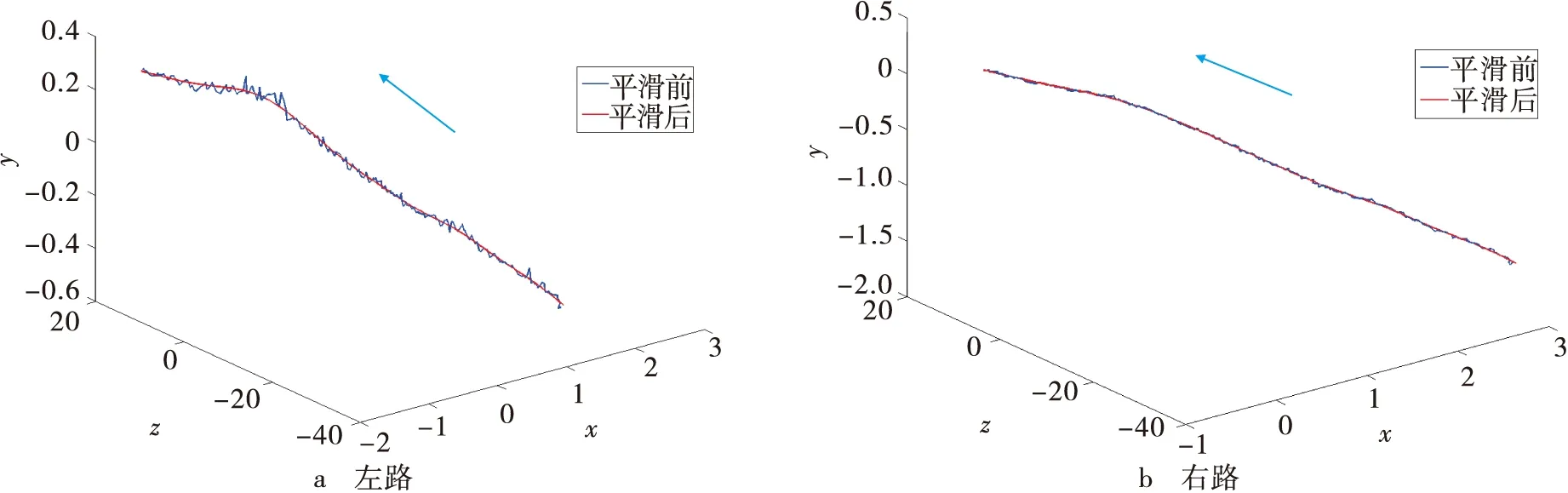

得到特征点轨迹后,利用SFM算法获取相机参数,得到250 f每一帧所对应的内置参数矩阵以及外部旋转参数矩阵和平移向量。取λrm=λtm=λfm=100,λrl=λtl=λfl=1,对相机外参进行平滑。相机平移参数平滑前后的路径如图4所示。从抖动的幅度可以看到左路比右路受到的影响更大,说明水平机位比垂直机位更容易受到影响。

图4 左右两路相机平滑前后运动路径

该视频序列在时域和空域上特征点的匹配的关系如图5所示。利用特征匹配点对的位置信息控制左右视点水平视差的相对稳定程度以及最小化垂直视差进行左右一致性约束,兼顾视差的稳定度与相似度,这里取ρ=1进行处理。

图5 特征点时域空域匹配关系示意图

立体视频稳像结果如图6所示。截取视频的序列相同位置观察其中运动物体的稳像效果,并选取第177帧、第208帧和第248帧进行观察比对。第一排为利用3D模型进行单目稳像[21]输出的序列,垂直视差较为明显,第二排为使用刘[22]的弱视差约束方法输出的稳像序列,垂直视差得到了一定的控制,第三排为本文提出方法的稳像结果,垂直视差得到了进一步减小,说明本文方法是有效的。

图6 稳像结果

图7 “世博“稳像后视差绝对值均值的变化量的绝对值

图8 3种方法主观评分

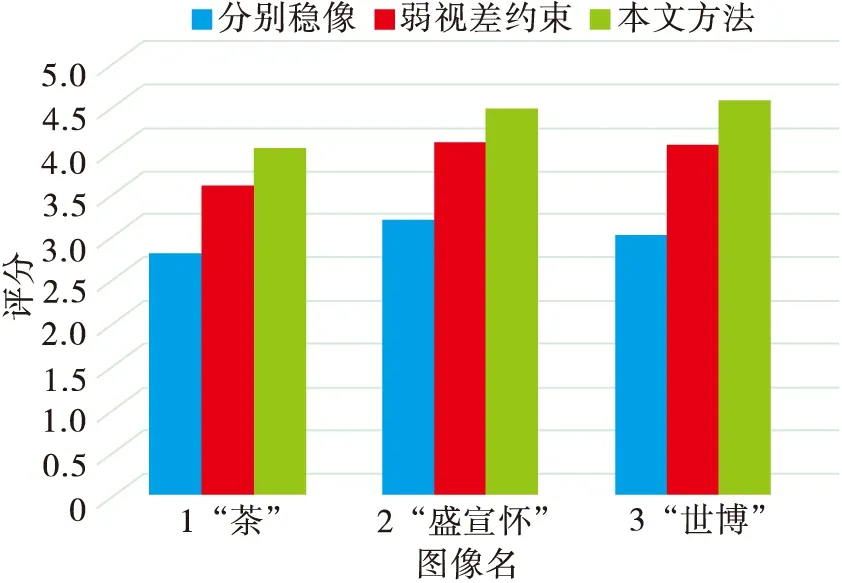

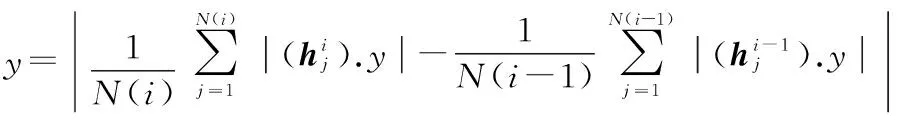

为进一步验证视差处理效果,本文将3种方法稳像后水平视差以及垂直视差绝对值均值的变化量的绝对值进行计算,如式(20)~(21),对比结果如图7所示。弱视差约束方法比分别稳像的视差变化量要小,本文提出的约束方法则进一步稳定了水平视差以及减小垂直视差。

(20)

(21)

本文将这3种方法分别对“茶”“盛宣怀”“世博”这3个立体视频进行处理,然后邀请20个对立体视觉有感知能力的测试者对视频的稳像效果进行主观评价。测试时,3个视频的顺序是随机的,但对同一个视频进行主观评价时,3种处理后的序列会连续出现,但3种方式出现的顺序依然是随机的。20组评分结果如图8所示,可以看到经本文方法处理后,立体视频的稳像视觉体验较好。

4 小结

本文提出了一种改进的基于时空一致性的立体视频稳像方法,在单目稳像的基础上,进行了立体视频稳像的特殊性研究,提出了一种视差的强约束,以达到更加有效的稳定水平视差以及最小化垂直视差的目的。本文方法经过一系列视频序列测试,结果表明可以获得较好的立体稳像效果。本文方法的局限性在于运动估计的结果依赖于SFM算法对相机参数估计的准确性。在未来工作中,将会对这方面的问题进行更深入的思考。

致谢:

本论文成果要感谢周军老师的指导,以及参与主观测试的同学。

[1]HARTLEY R, ZISSERMAN A. Multiple view geometry in computer vision[M]. Cambridge: Cambridge University Press, 2000.

[2]TOMASI C, KANADE T. Shape and motion from image streams under orthography: a factorization method[J]. International journal of computer vision, 1992, 9(2): 137-154.

[3]ZHANG G, QIN X, HUA W, et al. Robust metric reconstruction from challenging video sequences[C]//Proc. IEEE Conference on Computer Vision and Pattern Recognition.[S.l.]:IEEE, 2007: 1-8.

[4]CHO W, HONG K S. Affine motion based CMOS distortion analysis and CMOS digital image stabilization[J]. IEEE transactions on consumer electronics, 2007, 53(3): 833-841.

[5]CHANG H C, LAI S H, LU K R. A robust and efficient video stabilization algorithm[C]//Proc. IEEE International Conference on Multimedia and Expo.[S.l.]:IEEE,2004: 29-32.

[6]LEE K Y, CHUANG Y Y, CHEN B Y, et al. Video stabilization using robust feature trajectories [C]//Proc.IEEE 12th International Conference on Computer Vision.[S.l.]:IEEE,2009: 1397-1404.

[7]MATSUSHITA Y, OFEK E, TANG X, et al. Full-frame video stabilization[C]// Proc. IEEE Computer Society Conference on Computer Vision and Pattern Recognition.[S.l.]:IEEE,2005: 50-57.

[8]MATSUSHITA Y, OFEK E, GE W, et al. Full-frame video stabilization with motion inpainting[J]. IEEE transactions on pattern analysis and machine intelligence,2006, 28(7): 1150-1163.

[9]CHEN B Y, LEE K Y, HUANG W T, et al. Capturing intention-based full-frame video stabilization [C]//Computer Graphics Forum.[S.l.]:Blackwell Publishing Ltd., 2008, 27(7): 1805-1814.

[10]GLEICHER M L, LIU F. Re-cinematography: improving the camera dynamics of casual video [C]//Proc. the 15th International Conference on Multimedia. [S.l.]:ACM, 2007: 27-36.

[11]GLEICHER M L, LIU F. Re-cinematography: Improving the camerawork of casual video[J]. ACM transactions on multimedia computing, communications, and applications (TOMM), 2008, 5(1): 2.

[12]GRUNDMANN M, KWATRA V, ESSA I. Auto-directed video stabilization with robust l1 optimal camera paths[C]// Proc. 2011 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). [S.l.]: IEEE, 2011: 225-232.

[13]ZHU Z, XU G, YANG Y, et al. Camera stabilization based on 2.5 D motion estimation and inertial motion filtering[C]// Proc. IEEE Int. Conf. on Intelligent Vehicles. [S.l.]:IEEE,1998: 329-334.

[14]LIU F, GLEICHER M, WANG J, et al. Subspace video stabilization[J]. ACM Transactions on Graphics (TOG), 2011, 30(1): 4.

[15]SMITH B M, ZHANG L, JIN H, et al. Light field video stabilization[C]//Proc. 2009 IEEE 12th International Conference on Computer Vision. [S.l.]:IEEE, 2009: 341-348.

[16]LIU S, WANG Y, YUAN L, et al. Video stabilization with a depth camera[C]//Proc. 2012 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).[S.l.]:IEEE, 2012: 89-95.

[17]LIU F, GLEICHER M, JIN H, et al. Content-preserving warps for 3D video stabilization[C]// Proc.ACM Transactions on Graphics (TOG). [S.l.]:ACM,2009,28(3): 44.

[18]LIU F, NIU Y, JIN H. Joint subspace stabilization for stereoscopic video[C]//Proc. the IEEE International Conference on Computer Vision. [S.l.]:IEEE,2013: 73-80.

[19]CHU C H. Video stabilization for stereoscopic 3D on 3D mobile devices[C]// Proc. 2014 IEEE International Conference on Multimedia and Expo (ICME).[S.l.]:IEEE, 2014: 1-6.

[20]FISCHLER M A, BOLLES R C. Random sample consensus: a paradigm for model fitting with applications to image analysis and automated cartography[J]. Communications of the ACM, 1981, 24(6): 381-395.

[21]ZHANG G, HUA W, QIN X, et al. Video stabilization based on a 3D perspective camera model[J]. The visual computer, 2009, 25(11): 997-1008.

[22]LIU C W, HUANG T H, CHANG M H, et al. 3D cinematography principles and their applications to stereoscopic media processing[C]//Proc. the 19th ACM international conference on Multimedia. [S.l.]:ACM, 2011: 253-262.

孔 悦,女,硕士生,主研3D视频处理;

周 军,副教授,主要研究方向为网络多媒体信息处理;

谷 潇,女,高工,主要研究方向为多媒体内容制作与设计呈现。

责任编辑:闫雯雯

Improved stereoscopic video stabilization method based on spatial-temporal consistency

KONG Yue, ZHOU Jun, GU Xiao

(InstituteofImageCommunication&NetworkEngineering,ShanghaiJiaoTongUniversity,Shanghai200240,China)

With the prevalence of stereo shooting equipment, there is an increasing need for stereoscopic video stabilization. Directly watching stereoscopic videos with jitter will easily generate visual fatigue. If traditional 2D video stabilization method is applied independently to left and right videos, additional vertical parallax will be introduced and horizontal parallax will become unsteady, which will lead to bad viewing experience. Therefore, an improved stereoscopic video stabilization method based on 3D-modeled monocular image stabilization is presented, strengthening spatial-temporal consistency constraint to stable horizontal parallax and minimize vertical parallax more effectively. Finally, the video sequences are cropped and enlarged properly. Several different shaky stereoscopic videos have been tested, and the results show that the method is effective.

stereoscopic video stabilization; parallax; spatial-temporal consistency

孔悦,周军,谷潇. 基于时空一致性的立体视频稳像改进方法[J]. 电视技术,2016,40(11):100-106. KONG Y, ZHOU J, GU X. Improved stereoscopic video stabilization method based on spatial-temporal consistency [J]. Video engineering,2016,40(11):100-106.

TN919.82

A

10.16280/j.videoe.2016.11.021

国家科技支撑计划项目(2015BAK05B03);国家自然科学基金项目(61471234)

2016-03-02