一种基于HSV和LBP特征融合的眼疲劳诊断方法

2016-11-04彭亦功

李 东 彭亦功

(华东理工大学信息科学与工程学院,上海 200237)

一种基于HSV和LBP特征融合的眼疲劳诊断方法

李东彭亦功

(华东理工大学信息科学与工程学院,上海200237)

针对色调饱和度亮度(HSV)颜色空间特征提取方法在低光照条件下人眼状态识别率低、局部二值模式(LBP)特征提取方法在复杂光照下鲁棒性不强的问题,根据人眼在不确定光照情况下的状态识别需求,提出了基于HSV颜色特征和LBP纹理特征融合的眼疲劳诊断方法。仿真试验表明,该方法可有效提高单独使用HSV和LBP特征提取方法仿真时的人眼状态识别率和眼疲劳诊断精度,具有很好的眼疲劳诊断效果,应用前景广泛。

特征提取 HSVLBP鲁棒性特征融合眼疲劳诊断状态识别

0 引言

近年来,因用眼过度引起的健康问题越来越多,因眼疲劳引起的交通意外造成了诸多人员伤害和社会危害[1-2]。因此,人眼状态识别和诊断方法的研究引起了众多专家、学者的关注[3-4]。基于颜色空间(hue saturation value,HSV)和局部二值模式(local binary pattern,LBP)是人眼状态识别和诊断常用的特征提取方法。HSV是将图像从红绿蓝(red green blue,RGB)颜色空间转换到HSV颜色空间提取特征的方法[5],其在低光照条件下的识别率较低[6-8];LBP是一种提取图像局部纹理的算子,用于描述局部像素间的对比度[9],但其在复杂光照下的鲁棒性不强[10-12]。

本文在具体分析HSV和LBP特征提取方法基础上,提出基于HSV和LBP特征融合的眼疲劳诊断方法,并对相关仿真试验进行分析、对比。仿真结果表明:基于特征融合的方法弥补了单一特征提取方法的不足,其人眼状态识别率和眼疲劳诊断精度较HSV和LBP有明显提高。

1 常用特征提取方法

1.1HSV颜色空间特征提取方法

颜色特征主要有颜色直方图、颜色矩、颜色相关图等,而颜色直方图是最简单、有效的颜色特征,常用于构成HSV颜色空间。因此,HSV常作为一种用于图像特征识别的特征提取方法。其中H、S、V分别表示色调(hue,H)、饱和度(saturation,S)和亮度(value,V)。HSV颜色直方图特征提取方法具体如下[13]。

①颜色空间转换。

根据式(1),将图像从RGB颜色空间转换到HSV颜色空间,V、S、H分别为:

(1)

式中:R、G、B分别为RGB图像中红、绿、蓝这三种颜色分量;θ为角度。

(2)

②HSV颜色空间与直方图的转换。

采用等量间距量化法,将HSV颜色空间均匀量化为256维直方图。其中,H、S、V三者的颜色量分别均匀量化为16份、4份和4份,即三者的量化等级分别为16、4和4。

③直方图编码化。

采用Haar变换法,编码上述256维直方图特征,编码后的直方图特征即为所需的基于HSV颜色空间的特征。

1.2LBP局部二值模式特征提取方法

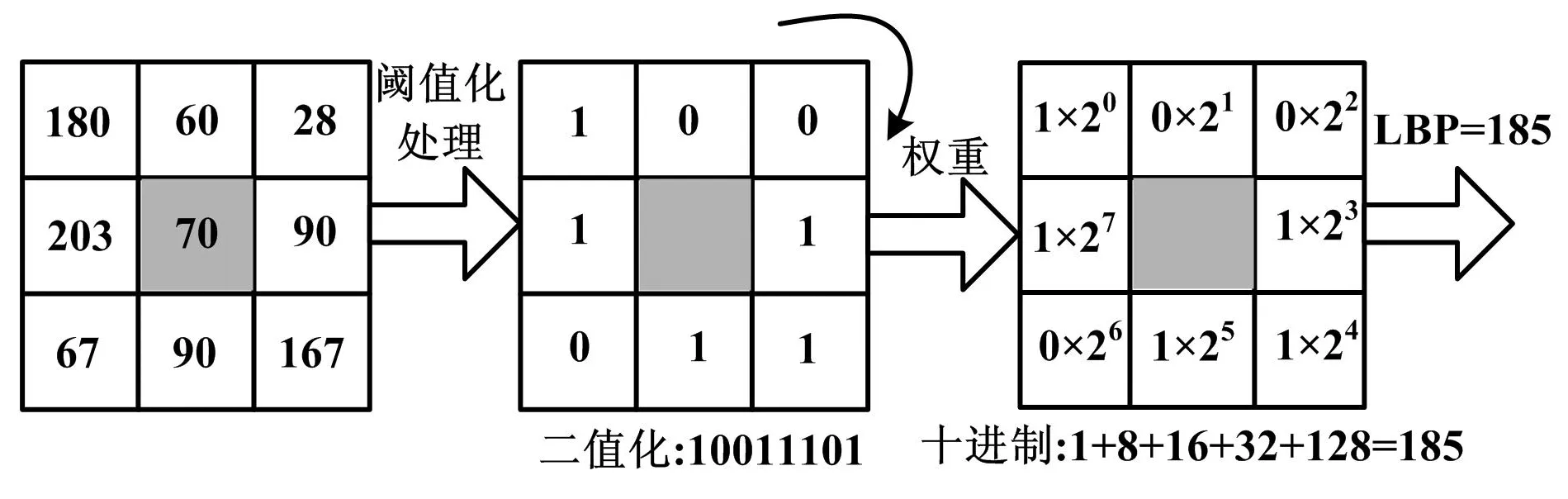

LBP主要通过比较图像中任意像素点灰度值与以该像素点为中心的矩形邻域内其他像素点灰度值的大小,来确定该像素点的LBP码。基本LBP算子运算过程如图1所示。在邻域中,将8个邻域像素点的灰度值与中心像素点的灰度值作阈值化处理。即当邻域像素点的灰度值大于等于中心像素点的灰度值时,将该点置为1;反之,则置为0。然后,以顺时针方向记录,得到二进制序列。再根据权重规则将二进制序列转化为十进制,所得十进制数值即代表中心像素点的LBP码。

图1 基本LBP算子运算过程示意图Fig.1 Operational process of basic LBP operator

基于基本LBP算子,Ojala等人提出一种扩展的LBP算子,即圆形邻域LBP算子[14]。该算子表示为:

(3)

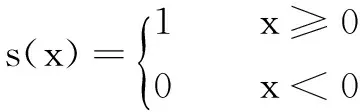

式中:gc为中心像素点灰度值;gp为以gc为中心的圆形邻域像素点灰度值;R为半径;P为邻域采样点;s(x)为符号函数。

(4)

鉴于这种圆形邻域LBP算子提取的特征维数过多,在此基础上,Ojala等人又进一步提出统一化LBP算子。其表示为:

(5)

(6)

在由式(6)计算所得的二进制序列中,如包含从0~1或从1~0的、转变次数不多于2次的模式,即称为统一化局部二进制模式;反之,则称为非统一化局部二进制模式。统一化局部二进制模式具有反映重要信息的特性,而非统一化局部二进制模式往往由噪声引起过多的转变,因而不具有良好的统计意义。因此,统一化局部二进制模式LBP算子可保留所描述图像的绝大部分纹理信息,减少了图像特征的数量,进而加快了数据处理的速度。

2 特征融合方法

特征融合方法常分为判决层融合和特征层融合两种。判决层融合方法即分别建立子特征模型,通过融合权值来实现子模型的融合。这种融合方法,并未建立特征之间的联系,融合权值的选择也较为依赖子特征模型的判别结果,显然在实际应用中可靠性不足。特征层融合方法即直接构建融合特征的模型,这种方法可关联特征内在属性,且其模型更具一般性,与判决层融合方法相比更具优势。

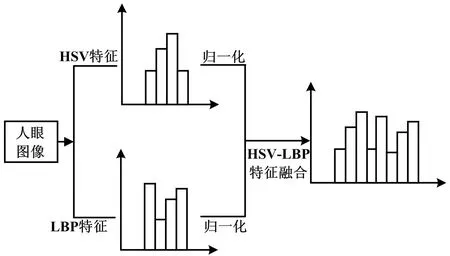

本文采用特征层融合方法,对基于人眼图像提取的HSV特征和LBP特征进行直接融合,其具体过程如图2所示。首先,分别提取人眼图像的HSV颜色直方图特征和人眼图像的LBP特征,采用[0,1]归一化方法处理特征,并将归一化后的特征向量化;然后,直接把向量化后的HSV颜色直方图特征和LBP特征融合,形成HSV-LBP融合特征。

图2 特征融合过程示意图Fig.2 Schematic diagram of process of feature fusion

3 试验

3.1试验模型构建

①基于SVM的人眼状态判别模型。

人眼状态的判别属于二分类问题,常用支持向量机(supportvectormachine,SVM)来解决。SVM以结构风险最小化为原则,寻找能够成功分开两类样本且具有最大分类间隔的最优分类超平面。显然,SVM具有良好的分类正确率和模型泛化能力,且在处理小样本问题时具有较好表现。因此,采用SVM构建人眼状态判别模型。

利用SVM建立模型,实际上是建立一组最优判别函数的过程。对于一组给定的训练样本{(x1,y1),…,(xi,yi),…,(xN,yN)},xi和yi分别为第i个样本的特征向量和类别标志,xi∈Rd,yi∈{-1,1},N为训练样本数。对于线性可分和不可分两种情况,SVM的最优判别函数分别如式(7)和式(8)所示:

(7)

(8)

在建立SVM模型时,核函数的选择和参数优化对其分类性能起着至关重要的作用。常见的核函数类型主要有线性、多项式、径向基(radialbasisfunction,RBF)、Sigmoid这四种。由于RBF核函数具有可将样本映射到更高维空间以解决非线性问题、需要确定参数少的优点,故选择其为SVM人眼状态判别模型的核函数。其中,涉及惩罚因子C和核参数r两参数的优化。优化C可实现分类间隔最大和误分样本最少之间的平衡。r主要会影响训练样本数据在高维特征空间中的分布复杂度,若选择过高,会导致训练数据不可分;反之,则对任意的训练数据都将映射为线性可分,从而导致过拟合。因此,采用基于交叉验证与网格搜索相结合的方法进行C和r的优化选择。

②疲劳诊断标准。

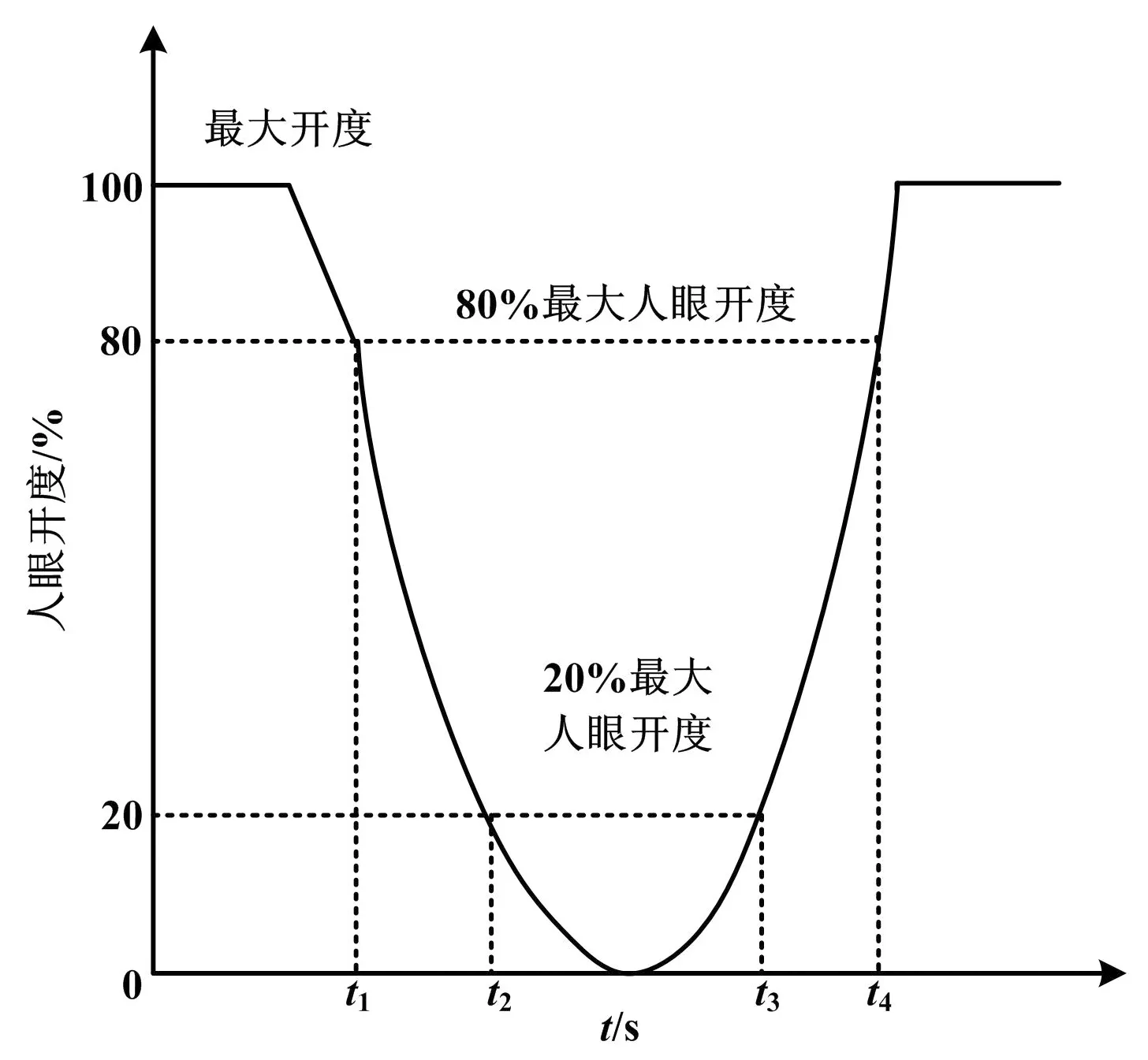

依据构建的SVM模型判别人眼状态,再根据疲劳诊断标准确定人眼疲劳状态。常用眼疲劳诊断标准分为眨眼频率、眼睛平均闭合速度及眼睑闭合时间占特定时间百分比(percentage of eyelid closure over the pupil over time,PERCLOS)。与其他疲劳诊断标准相比,PERCLOS所反映的疲劳状态更加精确[15]。PERCLOS的计算标准有三种,即P70、P80和眼睛度量(eye measure,EM)。其中,P70表示眼睛闭合至少70%所占的时间比例,P80表示眼睛闭合至少80%所占的时间比例,EM表示眼睑闭合率的均方百分比。Dinges等研究发现:三种计算标准中,基于P80的疲劳诊断准确率最高,应用最广泛[16]。PERCLOS原理如图3所示。

图3 PERCLOS原理图Fig.3 Schematic diagram of PERCLOS

若将人眼开度为100%时的眼睛高度定义为眼高,在图3中,t1为眼睛从张开最大即眼高到闭合至80%眼高所需的时间;(t2-t1)为眼睛从80%眼高闭合至20%眼高所需的时间;(t3-t2)为眼睛从20%眼高至完全闭合再到睁开20%眼高所需的时间;(t4-t3)为眼睛从20%眼高睁开至80%眼高所需的时间。根据P80,可得PERCLOS,记为P。则P为:

(9)

由式(9)可见,P值即为给定时间窗中的时间比,其也可通过计算规定时间内总闭眼数目Ec和在相同时间内总人眼数目Et的比值得到。P值计算公式为:

(10)

式(10)中,P值越大,则疲劳程度越高,反之亦然。通过式(10),可以计算由SVM人眼状态判别模型识别的总闭眼数目Ec1占总人眼数目Et的比例P计算,以及真实的总闭眼数目Ec2占总人眼数目Et的比例P实际。它们的计算公式分别为:

(11)

(12)

Ec1=TP+FN

(13)

Ec2=TP+FP

(14)

Et=TP+TN+FN+FP

(15)

式中:真阳性(truepositive,TP)为SVM人眼分类判别模型正确分类的闭眼数目;真阴性(truenegative,TN)为SVM人眼状态判别模型正确分类的睁眼数目;假阳性(falsepositive,FP)为SVM人眼状态判别模型错误分类的闭眼数目;假阴性(falsenegative,FN)为SVM人眼状态判别模型错误分类的睁眼数目。

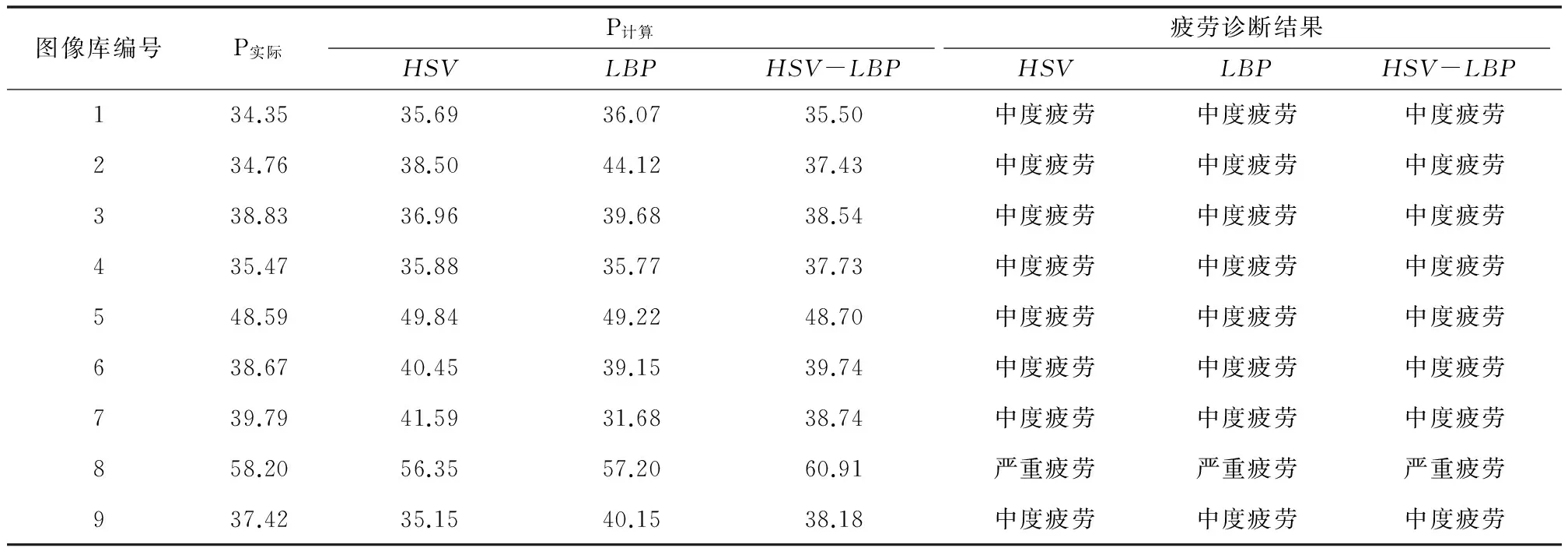

由此可见,通过P计算可判断当前人眼是否处于疲劳状态。为了更精确地判断疲劳状态,可按式(16)计算P的误差值[17]:

P误差=|P计算-P实际|

(16)

式中:P误差越小,疲劳诊断的精度越高;反之,则越低。

在实际应用过程中,常常在确定疲劳状态后,根据P值的大小范围来判断疲劳的程度,并予以分级警示。一般来说,基于P值的眼疲劳程度诊断标准可设置为[18]:当0≤P<10%时,不疲劳;当10%≤P<30%时,为轻度疲劳;当30%≤P<50%时,为中度疲劳;当P≥50%时,为严重疲劳。

3.2仿真试验

(1)试验条件。

仿真试验软件为Matlab,其版本为R2013a。仿真软件运行环境为:联想笔记本、Windows7旗舰版系统、双核IntelCorei5CPU、2.3GHz频率、4GB内存。

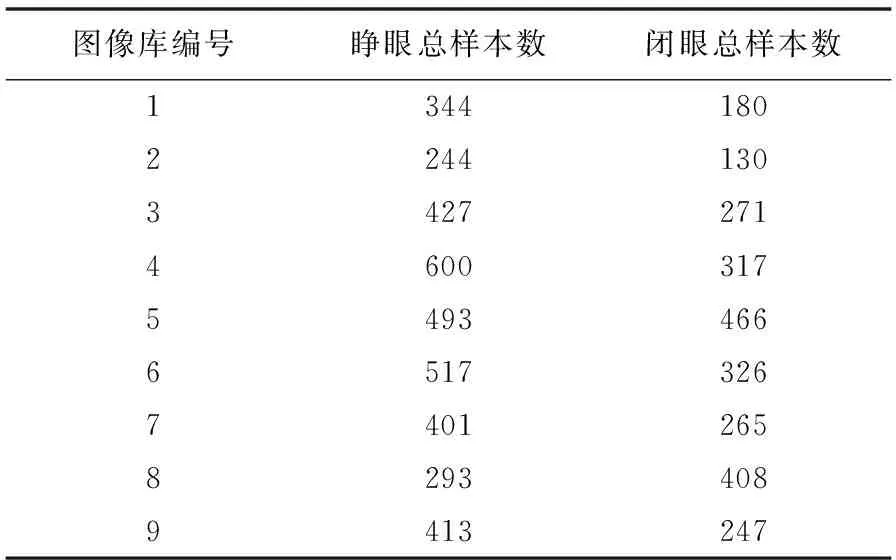

构建SVM人眼状态判别模型所用的数据均来自于自建的人眼图像库,图像库中包含9组人眼图像子库,分别由3名测试人员在均匀正常光照、非均匀较弱光照和均匀正常光照戴眼镜3种条件下采集得到。其中,均匀正常光照下所得的图像库编号为1、2、3;非均匀较弱光照下所得的图像库编号为4、5、6;均匀正常光照戴眼镜下所得的图像库编号为7、8、9。9组图像库共包含睁眼图像4 393幅,闭眼图像3 810幅。

训练SVM人眼状态判别模型时,分别将1 200幅闭眼和1 200幅睁眼图像作为训练的正负样本,样本随机、均匀地选自每个图像子库。剔除训练样本后,

将每个图像子库中剩余的人眼图像作为测试样本,测试样本数如表1所示。

表1 测试样本数Tab.1 The numbers of test samples

(2)试验过程。

①模型训练过程。

首先,将训练正负样本的大小统一为31×36像素,并分别提取每幅图像的HSV、LBP和HSV-LBP特征;然后,将其中800幅闭眼和800幅睁眼图像的3组特征分别作为模型训练样本,剩下各400幅闭眼和睁眼图像的3组特征分别作为其训练模型的测试样本;最后,将训练正负样本输入SVM进行训练,并采用测试样本进行模型性能的验证。整个训练和测试结束后,得到基于HSV、LBP和HSV-LBP特征的SVM人眼状态判别模型。

②试验结果。

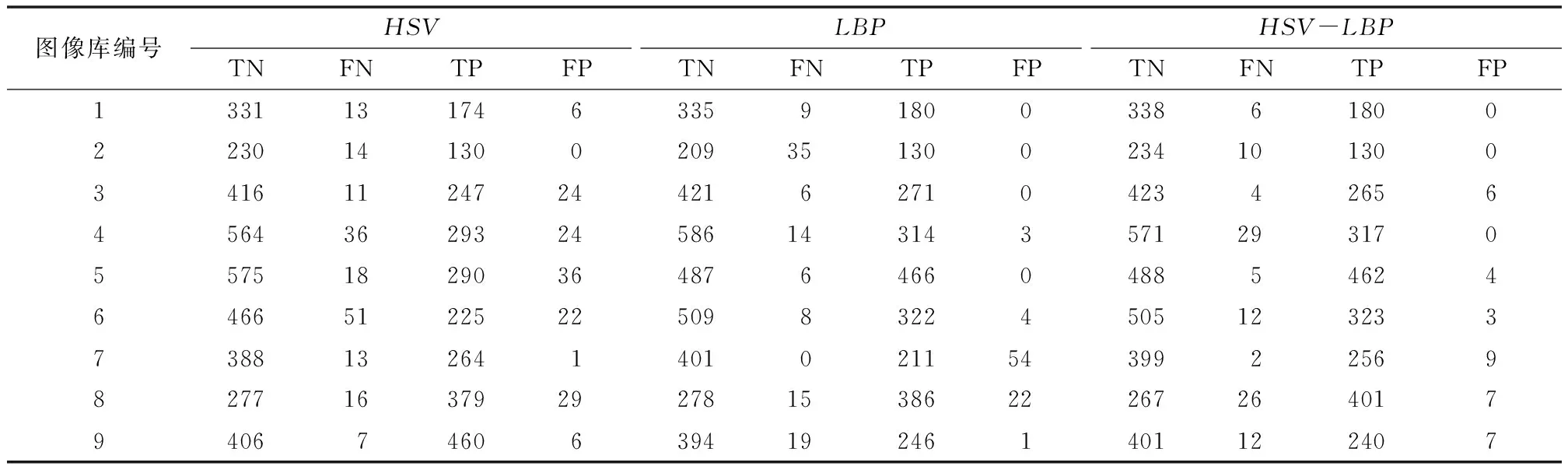

利用上述3种模型,分别识别9组图像库中测试样本的人眼状态,可得不同特征提取方法识别的TN、FN、TP、FP值,结果如表2所示。

表2 不同特征提取方法成功识别人眼状态的数目Tab.2 Success numbers of eye state recognition of different feature extraction methods

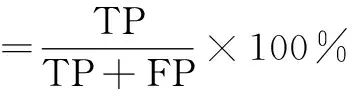

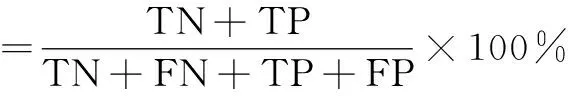

根据表2的识别结果,可利用式(17)~式(19),计算不同特征提取方法的睁眼识别率、闭眼识别率和总识别率[16]。

(17)

(18)

(19)

不同特征提取方法的人眼状态识别率如表3所示。

表3 不同特征提取方法的人眼状态识别率Tab.3 Eye state recognition rate of different feature extraction methods

从表3可以看出,基于HSV-LBP特征融合方法的人眼状态识别率较HSV和LBP特征提取方法的人眼状态识别率有了很大的提升。对比结果表明:基于HSV-LBP特征融合方法弥补了融合前单一特征提取方法在人眼状态识别方面所存在的不足。究其原因,单一特征在不同环境下描述人眼状态的能力不同,而融合特征在一定程度上增强了准确表达图像信息的能力。

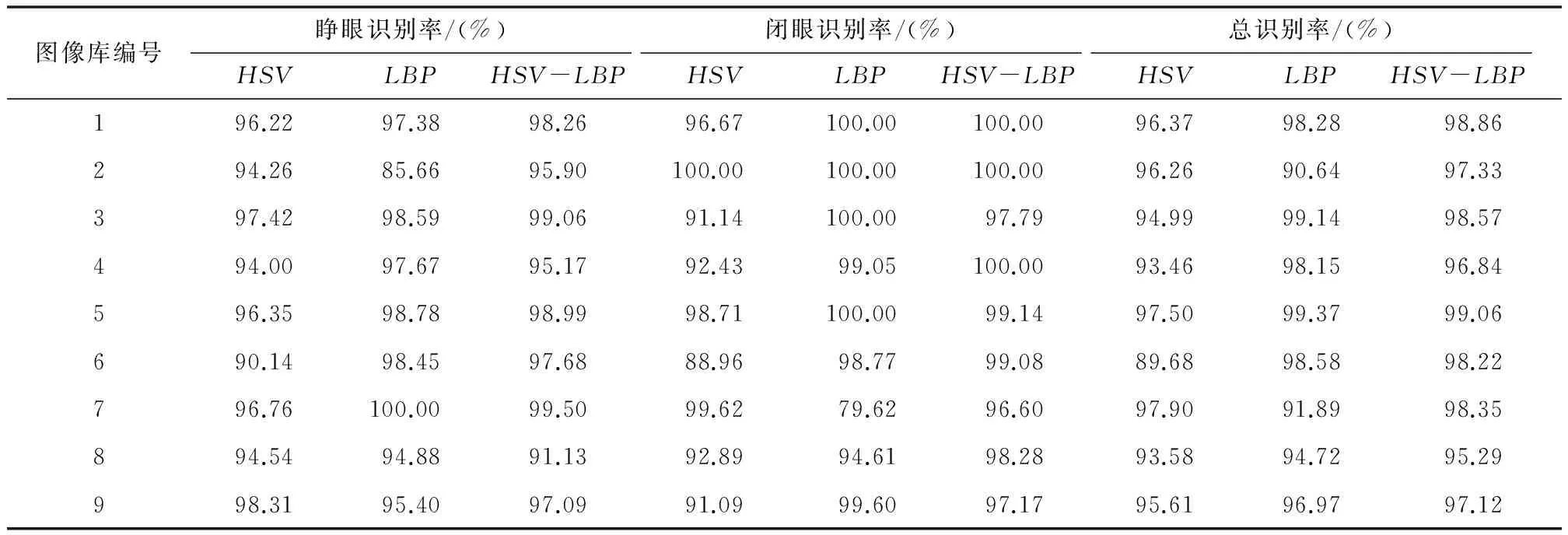

根据表2的数据,利用式(11)和式(12),计算三种特征提取方法的和,并诊断疲劳程度,结果见表4。

表4 不同特征提取方法的眼疲劳诊断结果Tab.4 Results of eye fatigue diagnosis of different feature extraction methods

从表4可以看出,三种特征提取方法的眼疲劳程度诊断结果一致,但根据表4中P计算结果及式(16)可得三种特征提取方法的P误差,其结果如图4所示。

图4中,对于每个图像库而言,利用三种特征提取方法所得到的P误差不同。其中,基于LBP-HSV特征融合的眼疲劳诊断方法的P误差基本均小于其他两种方法的P误差。对比结果表明,基于HSV-LBP特征提取融合的眼疲劳诊断方法精度较高,诊断效果好,可靠性更高。

图4 P误差对比图Fig.4 Comparison of the Perror values

4 结束语

鉴于HSV和LBP特征提取方法的各自特点,提出了基于HSV和LBP特征融合的眼疲劳诊断方法。利用SVM构建基于融合特征的人眼状态判别模型,并根据PERCLOS疲劳诊断标准进行眼疲劳诊断。仿真试验表明,相比单一特征提取方法,基于HSV和LBP特征融合的眼疲劳诊断方法提升了人眼状态识别准确率,且提高了眼疲劳诊断的可靠性,具有广阔的使用前景。

[1]BENEDETTOS,CARBONEA,DRAI-ZERBIBV,etal.Effectsofluminanceandilluminanceonvisualfatigueandarousalduringdigitalreading[J].ComputersinHumanBehavior,2014,41:112-119.

[2]CYGANEKB,GRUSZCZYNSKIS.Hybridcomputervisionsystemfordrivers′eyerecognitionandfatiguemonitoring[J].Neurocomputing,2014,126(126):78-94.

[3]SHAOL,LIUL,LIX.Featurelearningforimageclassificationviamultiobjectivegeneticprogramming[J].IEEETransactionson.NeuralNetworksandLearningSystems, 2014,25(7): 1359-1371.

[4]THEPADES,DASR,GHOSHS.Anovelfeatureextractiontechniquewithbinarizationofsignificantbitinformation[J].InternationalJournalofImagingandRobotics,2015,15(3): 164-178.

[5]SOLEIMANIZADEHS,MOHMAND,SABAT,etal.Recognitionofpartiallyoccludedobjectsbasedonthethreedifferentcolorspaces(RGB,YCbCr,HSV)[J].3DResearch,2015,6(3): 1-10.

[6]ROYS,BANDYOPADHYAYSK.FacedetectionusingahybridapproachthatcombinesHSVandRGB[J].InternationalJournalofComputerScience&MobileComputing,2013,2(3):127-136.

[7]ALNABRISSHA,ABUHAIBAISI.Improvedimageretrievalwithcolorandanglerepresentation[J].InternationalJournalofInformationTechnology&ComputerScience,2014,6(6):68-81.

[8]TSAGARISA,MANITSARISS.Colourspacecomparisonforskindetectioninfingergesturerecognition[J].InternationalJournalofAdvancesinEngineering&Technology,2013,6(4): 1431.

[9]YANGB,CHEN.Acomparativestudyonlocalbinarypattern(LBP)basedfacerecognition:LBPhistogramversusLBPimage[J].Neurocomputing,2013,120(10):365-379.

[10]HONGX,ZHAOG,PIETIKAINENM,etal.CombiningLBPdifferenceandfeaturecorrelationfortexturedescription[J].IEEETransactionsonImageProcessingAPublicationoftheIEEESignalProcessingSociety,2014,23(6):2557-2568.

[11]TAFRESHIM,FOTOUHIAM.Afastandaccuratealgorithmtodistinguishbetweenopenandclosedeyebyefficientcombiningoftextureandappearancefeatures[C]//ElectricalEngineering(ICEE),2014 22ndIranianConferenceon.IEEE,2014: 1013-1017.

[12]ZHANGY,HUAC.Driverfatiguerecognitionbasedonfacialexpressionanalysisusinglocalbinarypatterns[J].Optik-InternationalJournalforLightandElectronOptics,2015,126(23):4501-4505.

[13]MANJUNATHBS,OHMJR,VASUDEVANVV,etal.Colorandtexturedescriptors[J].IEEETransactionsonCircuitsandSystemsforVideoTechnology,2001,11(6): 703-715.

[14]OJALAT,PietikainenM,MaenpaaT.Multiresolutiongray-scaleandrotationinvarianttextureclassificationwithlocalbinarypatterns[J].IEEETransactionsonPatternAnalysis&MachineIntelligence,2002,24(7):971 - 987.

[15]DINGESDF,MALLISMM,MAISLING,etal.Evaluationoftechniquesforocularmeasurementasanindexoffatigueandthebasisforalertnessmanagement[R].1998.

[16]DASGUPTAA,GEORGEA,HAPPYSL,etal.AVision-basedsystemformonitoringthelossofattentioninautomotivedrivers[J].IEEETransactionsonIntelligentTransportationSystems,2013,14(4):1825-1838.

[17]GONZALEZ-ORTEGAD,DIAZ-PERNASFJ,Antón-RodríguezM,etal.Real-timevision-basedeyestatedetectionfordriveralertnessmonitoring[J].FormalPatternAnalysis&Applications,2013,16(3):285-306.

[18]DAZAIG,BERGASALM,BRONTES,etal.FusionofoptimizedindicatorsfromAdvancedDriverAssistanceSystems(ADAS)fordriverdrowsinessdetection[J].Sensors,2014,14(1):1106-31.

Eye Fatigue Diagnosis Method Based on Feature Fusion by HSV and LBP

Under low light conditions,the color space feature extraction method of HSV (Hue Saturation Value) provides low recognition rate of eye state; while under complex lighting conditions,the feature extraction method of LBP (Local Binary Pattern) features low robustness,in accordance with the demands for recognizing eye state under uncertain illumination conditions,the eye fatigue diagnosis method based on HSV and LBP,that fusing color feature and texture feature is proposed.Simulation experiments show that the proposed method can effectively improve eye state recognition rate and eye fatigue diagnostic accuracy obtained by using HSV or LBP separately.Besides,it has a good effect on eye fatigue diagnosis and a wide prospect in application.

Feature extractionHSV LBPRobustnessFeature fusionEye fatigue diagnosisState recognition

李东(1990—),男,现为华东理工大学控制科学与工程专业在读硕士研究生;主要从事信息处理、模式识别、人工智能等方向的研究。

TP391.9;TH166

ADOI:10.16086/j.cnki.issn 1000-0380.201610022

上海市重点学科建设基金资助项目(编号:B504)。

修改稿收到日期:2016-05-02。