Kinect传感器的植株冠层三维数据测量

2016-10-27刘慧徐慧沈跃李宁

刘慧,徐慧,沈跃,李宁

(江苏大学电气信息工程学院,江苏 镇江212013)

Kinect传感器的植株冠层三维数据测量

刘慧,徐慧,沈跃,李宁

(江苏大学电气信息工程学院,江苏 镇江212013)

植株三维信息重构能为植株生长状态监测和精确喷雾施药提供有效数据。提出一种基于Kinect传感器技术的植株冠层三维数据测量的方法。由Kinect传感器进行植株彩色和深度图像数据的采集,提取和处理所采集的植株冠层目标有效三维信息,完成对植株深度数值和水平投影面积的计算。以规则形状物体与不规则植株为实验对象,对三维数据测量方法进行准确性实验测试,并将实验结果与人工测量结果进行比对。实验结果显示,该方法的深度和面积测量的准确性较高,深度测量误差小于1.0%,面积测量误差小于3.6%。选取温室吊兰作为场地实验对象,采用由测量机构和控制处理机构组成的冠层三维检测系统对吊兰冠层进行三维数据测量,并实时输出深度以及水平投影面积信息,其深度测量的相对误差为1.77%。研究表明,该方法具有较高的可行性,适用于温室植株冠层三维数据测量。

Kinect传感器;植株深度;冠层结构;水平投影面积;三维数据

刘慧, 徐慧, 沈跃, 李宁. Kinect传感器的植株冠层三维数据测量[J]. 农业现代化研究, 2016, 37(5): 995-1000.

Liu H, Xu H, Shen Y, Li N. Measurement and 3D-reconstruction of plants based on Kinect sensor[J]. Research of Agricultural Modernization, 2016, 37(5): 995-1000.

基于图像的植株三维重构是指利用机器视觉原理通过相机获取图像对农作物的三维重构方法[1],主要应用于农作物植株生长状态的实时监测、药物肥料的精确喷洒以及病虫害的及时防治等研究领域。由于该方法能够快速有效的对目标物体进行三维重构,在计算机等相关科学领域引起广泛关注,成为一大研究热点[2]。

基于图像的作物三维重构主要分为两类:基于双目或多目视觉测距方法[3]的作物三维重构和基于深度摄像机测距方法[4]的作物三维重构。国内外学者对其在农作物果实识别以及植株的三维重构等进行了深入研究,Hayashi等[5]设计的草莓采摘机器人视觉系统,通过两边的两个摄像机和中间的摄像机确定果柄的位置,对草莓果实进行三维重构。王传宇等[6]利用两个位置相对固定的摄像机组成双目立体视觉系统,对室内的玉米叶片结构进行了准确的三维重构。宋健等[7]通过单摄像机在距离一定的位置获得不同角度的图像,由图像特征的差值实现对茄子果实的三维重构。Chéné等[8]提出了一种植物深度图像叶子的分割算法,该算法通过低成本的深度摄像机对多种植物冠层的深度图像进行拍摄,并对植物冠层进行了三维重构。周薇等[9]采用一个彩色相机和一个深度相机对目标物进行图像的获取,提出了一种利用深度摄像机对果树的冠层三维重构的配准算法。但这类方法采用单一的或分离式的彩色相机和深度相机进行目标的图像采集处理,同时对于形状不规则、复杂颜色干扰下的植株作物冠层无法进行有效地测量。

目前,Kinect作为一种同时具有彩色摄像头和深度摄像头的传感器,主要集中应用于体感游戏、教育、医学等[10-14]领域,Kinect传感器在温室植株三维重构与测量中的应用还鲜见报道。本文以温室吊兰为场地实验研究对象,提出了一种基于Kinect传感器技术的植株冠层三维数据测量方法,由Kinect对植株进行彩色和深度图像数据的采集,提取和处理所采集的植株目标有效三维信息,对其进行冠层深度和水平投影面积的计算,完成植株冠层三维数据的检测。

1 原理与方法

Kinect传感器是微软发布的XBOX360体感周边外设,摄像头部分由红外投影机和一组彩色摄像头、深度摄像头光学部件组成(图1)[15]。

图1 Kinect结构示意图Fig. 1 Structure schematic drawing of Kinect

1.1Kinect原理

Kinect传感器通过彩色摄像头获取空间的彩色图像,同时由红外投影机向空间发射红外线,根据结构光技术[16]通过红外摄像头即深度摄像头,捕捉空间物体的深度数据并生成深度图像。

Kinect深度图像获取速度默认为30 FPS (Frames Per Second),每一帧深度图像中每个像素点存储的数值为深度值,即为目标物体与Kinect摄像头之间的平面距离,通过这些深度数据辅以计算处理构建空间中物体的三维模型。其纵向的视野角度为43°,横向为57°,深度探测的最佳范围为1 m左右,在农作物检测应用方面,为了更好的获取植株的枝叶细节特征,一般选取0.9-1.5 m的距离进行农作物的检测,理想条件下使用,深度数据的精度可达毫米级[17]。

1.2目标深度数据获取

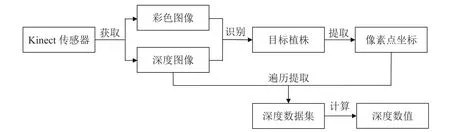

图2 深度数据获取步骤Fig. 2 Process of depth data acquisition

由Kinect深度摄像头获取原始深度图像,所存储的数据为空间中所有物体的深度数据,在实际的植株冠层三维数据测量的应用中,需要去除其他非植株杂物的干扰,仅获取目标植株的深度数据。本文的目标深度数据获取步骤见图2,首先通过彩色图像和深度图像匹配的方法去除颜色和深度杂物的干扰,得到目标植株的图像,由该图像像素提取获得目标的像素点坐标,通过遍历深度图像像素点坐标的方法,将对应的像素点深度数据提取出来形成深度数据集,并进行计算得到目标的实际深度数值。

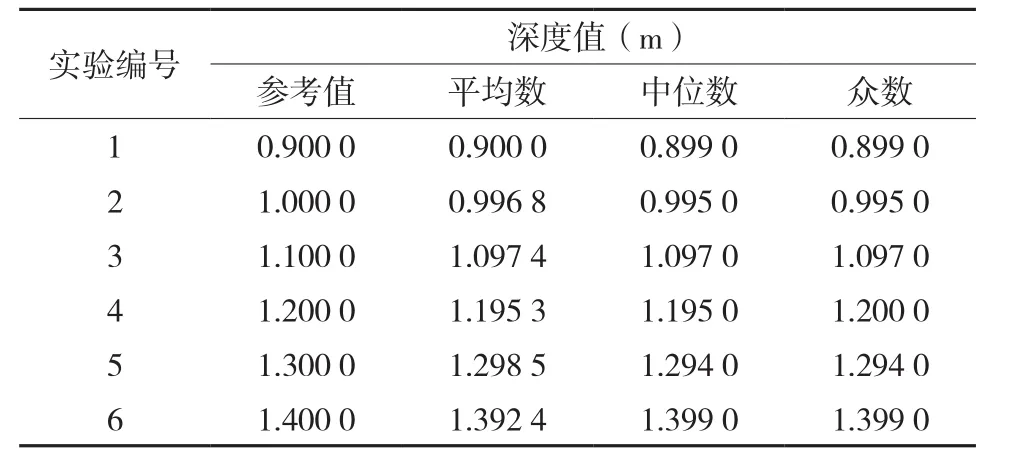

用平均数、中位数和众数3种统计方法进行计算,并与实际测量所得数据比较。选取背景墙面上20 cm × 20 cm绿色方块区域为检测目标,区域厚度可忽略不计,依据传感器有效使用范围参数,设置Kinect与墙面深度距离分别为0.9 m、1.0 m、1.1 m、1.2 m、1.3 m、1.4 m,进行6次重复实验,获取绿色方块区域的深度数据(表1)。

在相同的测量环境中,分别对同一深度数据集进行3种方法的计算,实验结果显示,选用平均数进行计算的深度值与参考值最为接近,可达到最优的处理效果。

表1 多种计算方法与深度数据值Table 1 Depth data to different calculation methods

1.3目标水平投影面积计算

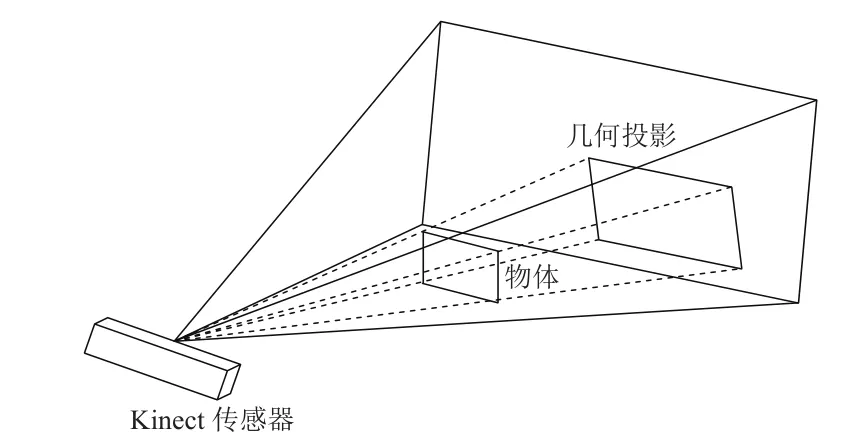

Kinect红外摄像机的视场呈金字塔形(图3),根据射影几何[18-19]的性质,物体在彩色和深度图像中的几何投影面积并不是物体的实际水平投影面积,根据所得的深度值由三角关系对物体的实际水平投影面积进行计算。

图3 Kinect红外摄像机的视场Fig. 3 Field view of Kinect infrared camera

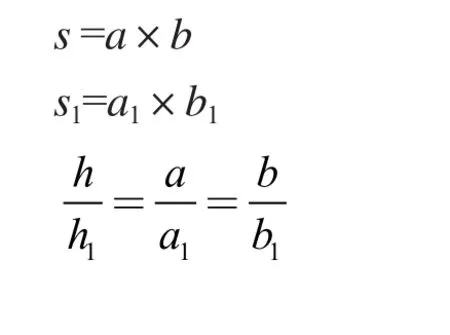

以规则的表面为例,其检测的深度值h与实际面积s的关系为:式中:a、b、h、s分别为目标检测区域的实际长、宽、深度值和面积,a1、b1、h1、s1为其几何投影区域的长、宽、深度值和面积。可得检测区域的实际面积s的计算公式为:

由目标深度数据获取的方法,可计算得检测区域实际深度值h,几何投影区域的深度值h1由Kinect初始的深度图像获取,同时计算得初始图像的实际面积,几何投影面积s1则选择由几何投影面像素点占总像素点的百分比,通过初始图像的实际面积计算得到。

计算过程中,物体的实际水平投影面积与其形状无关,只与其深度值、像素点的百分比以及几何投影面积有关,因此公式同样适用于不规则物体的水平投影面积的计算。

2 实验与数据

为检测本文提出的基于Kinect传感器技术的植株冠层三维数据测量方法的准确性,选用微软公司发布的“Kinect for Windows”版本的Kinect设备,分别以规则的绿色长方体和绿色盆栽植株进行实验,并用Matlab软件中的mesh函数对空间矩阵中的深度数据进行三维色图重构,同时自定义Colorbar函数设置渐变色彩对不同深度的信息进行标识,对绿色盆栽植株进行冠层的三维重构。

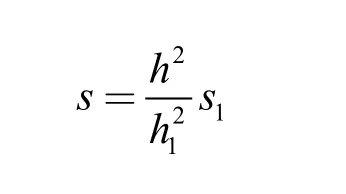

2.1规则物体测量

规则物体选取绿色长方体,检测面为30 cm × 10 cm长方形,依据传感器有效使用范围参数,选取Kinect传感器与长方体正面的深度距离分别为0.9 m、1.1 m、1.3 m进行3次重复实验,对长方体的深度数据以及水平投影面积等信息进行计算输出,其中绿色长方体识别图像中,白色区域即为识别出的绿色目标物体。将测出的数据与实际的距离和面积信息相比对,3次实验中深度数据的相对误差均小于1%,水平投影面积的相对误差均小于4%(表2),可见本文基于Kinect传感器技术的测量方法测量规则物体的深度值和水平投影面积具有较高的准确性。

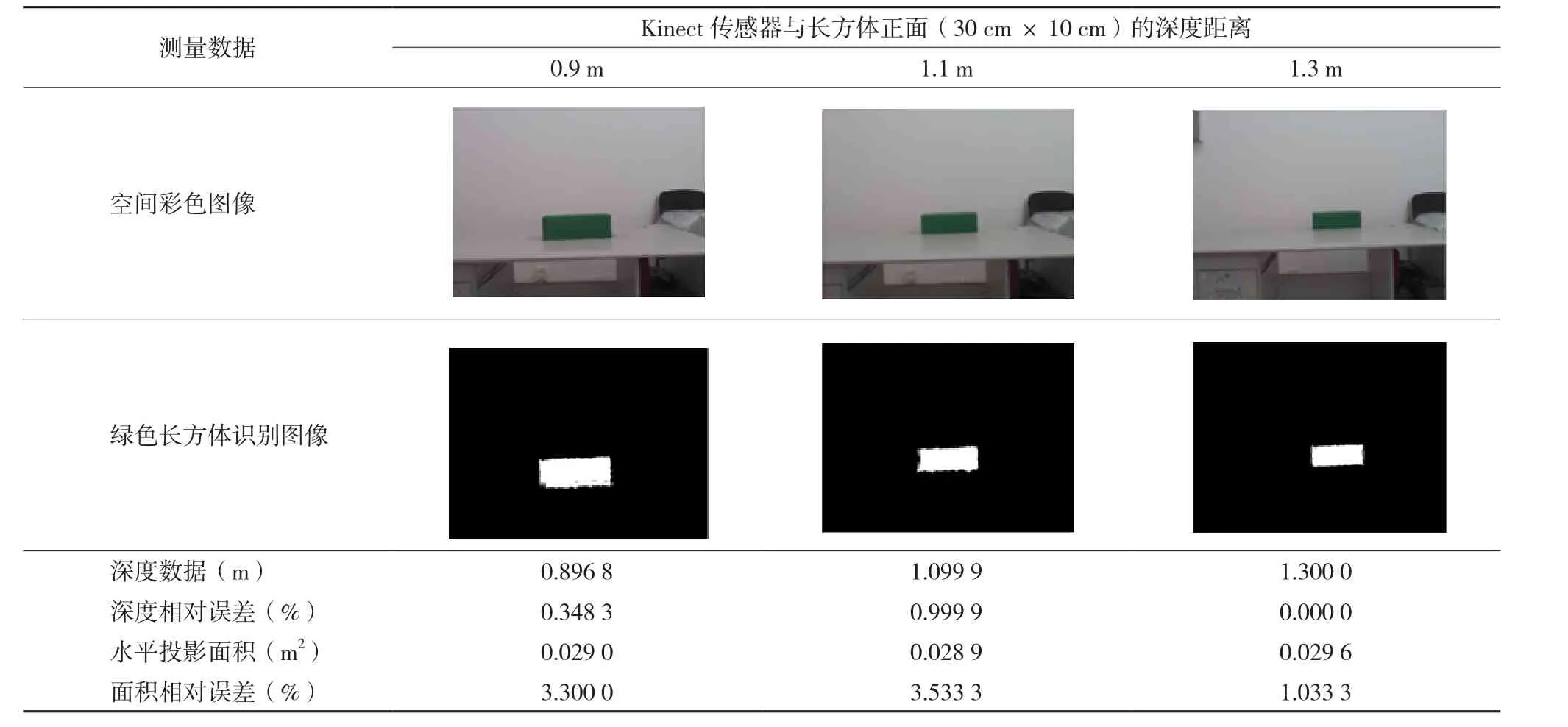

2.2植株测量和三维重构

绿色植株选取非洲茉莉盆栽进行测量与三维重构,盆栽底部半径约为0.12 m,以盆栽底部前端为参考点,与Kinect的距离为植株的深度距离,设置1.1 m、1.3 m、1.5 m的深度距离进行3次重复实验。绿色植株识别图像中的白色区域即为所需识别的绿色植株目标,三维重构图形中,蓝色部分代表深度值为0的区域,彩色渐变区域代表对应的深度值区域,即检测区域内植株的三维重构图形(表3)。对3次实验数据进行分析,由于测量时以盆栽底部前端为参考点,实验所测得不同深度处的水平投影面积分别为:1.1 m处为0.045 5 m2,1.3 m处为0.045 3 m2,1.5 m处为0.045 8 m2,三种深度距离所测得的面积具有很高的一致性。

表2 Kinect对绿色长方体检测面的测量Table 2 Measurement of green square detection surface by Kinect

3 场地实验

表3 Kinect对绿色植株的测量和三维重构Table 3 Measurement and 3D reconstruction of green plant by Kinect

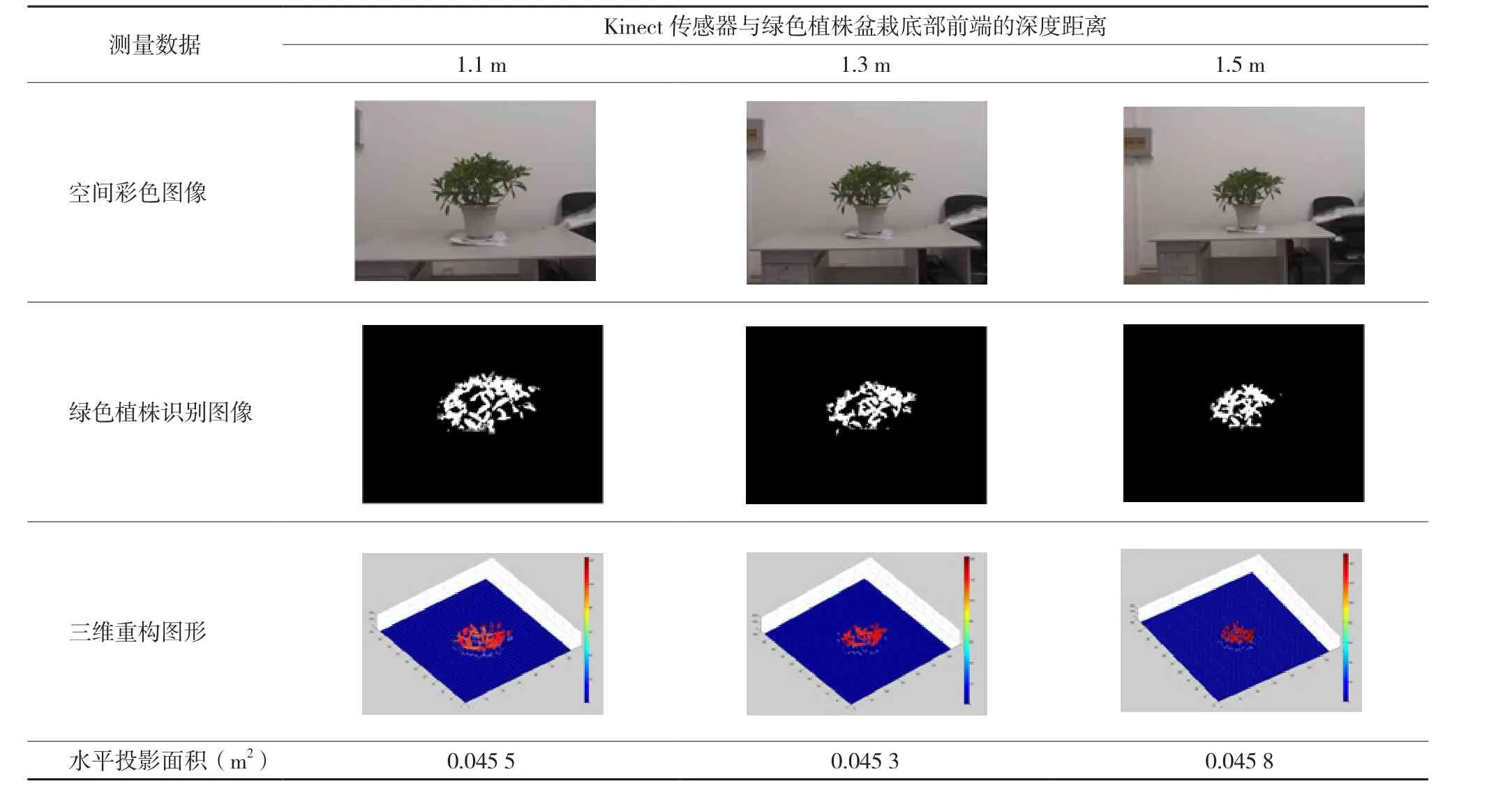

在检测实验方案中,提出的一种基于Kinect传感器技术的植株冠层三维数据测量方法能够实现规则绿色物体和不规则植株深度面积的准确测量以及植株三维重构。为了进一步验证该方法的有效性,选取温室吊兰作为场地实验对象,采用冠层三维测量与重构系统对吊兰冠层进行三维重构,并实时输出深度以及水平投影面积信息。

3.1实验方案

冠层三维测量与重构实验平台包括测量机构和控制及处理机构。测量机构主要由Γ型铝型材支架和Kinect传感器等组成,支架高度在0.5-2 m内可调,Kinect传感器固定于Γ型铝型材支架横梁尾端,检测方向由上往下,检测区域为以地面作背景的平面矩形框。控制及处理机构由PC机和USB延长线等组成,Kinect传感器通过USB延长线接口连至PC机,由PC机内自主编写的Matlab程序对传感器进行控制,采集区域图像信息,实测数据由USB延长线传输至PC机中,同时进行处理和计算,并输出相应的数据、图像结果。

实验场地位于江苏大学温室实验基地,大棚宽度约4.85 m,高度约2.2 m。吊兰盆栽种植区域长10 m,宽1.8 m,占地18 m2。由前期室内规则物体与植株深度数据检测实验效果,场地实验条件设置为Kinect传感器与地面的垂直高度1.9 m,随机抽取植株检测区域长约1.9 m,宽约1.4 m,植株盆栽数约40株,花盆高0.2 m,即吊兰盆栽枝叶的深度值约1.7 m。

3.2实验结果

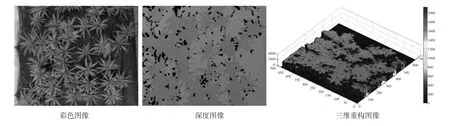

Kinect传感器获取的温室吊兰盆栽的原始空间彩色图像,吊兰盆栽为不规则摆放,盆栽间的空隙较大,边缘空隙明显(图4)。Kinect传感器获取的温室吊兰盆栽的原始深度图像,从图中可以看出,传感器所获取的深度图像效果并不理想,如果直接用于植株的识别,其中杂物对目标的干扰大,获取的深度数据量也非常大,不利于对植株目标的实时检测和数据处理。

本文的植株测量和重构方法通过对吊兰盆栽的枝叶进行色彩特征和深度范围限制匹配识别处理,去除盆栽底部、地面等背景杂物的干扰,同时由深度数据获取方法和水平投影面积计算方法,对吊兰植株与传感器之间的深度距离进行计算,并得出水平投影面积,通过函数重构图形,即为植株深度空间矩阵进行的三维色图重构效果图(图4)。

图4 温室吊兰冠层检测和三维重构图形Fig. 4 Detection and 3D reconstruction of greenhouse potted bracket-plants

对实验测得的植株深度值和水平投影面积分析:检测的吊兰盆栽枝叶深度值为1.73 m,与设置的吊兰盆栽枝叶深度值相对比,即Kinect的传感器与地面的垂直高度去除花盆高所得的实际深度值基本吻合,相对误差为1.77%,准确性非常高。计算得该检测区域内吊兰盆栽冠层的水平投影面积为1.29 m2。

4 结论

针对植株三维信息的采集和重构,本文提出了一种基于Kinect传感器技术的植株冠层三维数据测量方法,该方法中深度数值的计算,采用平均数作为衡量的标准,得到的深度值与实际值最为接近,可达到最优的处理效果,规则物体的测量实验中,深度值的相对误差小于1%;水平投影面积的计算,通过几何投影的像素点百分比,由几何投影面积计算获得实际面积,规则物体的测量实验中,水平投影面积的相对误差小于4%。温室场地实验中,由三维测量与重构系统通过测量机构和控制及处理机构的结合,运用数学方法和Matlab软件程序进行处理,完成了温室吊兰冠层的深度以及水平投影面积信息的输出和三维重构,较好地达到了预期的效果。

通过检测实验和温室场地实验的验证,本文基于Kinect传感器技术的植株测量与三维重构的方法,能够应用于温室吊兰植株的三维重构和深度、面积信息的测量。该方法也可进一步推广应用于其他不规则形状的植株三维重构与测量,实现基于Kinect传感器的农业植株生长状态的实时监测、药物肥料的精确喷洒以及病虫害的及时防治等过程中植株信息的采集和处理。

[1] 刘刚, 司永胜, 冯娟. 农林作物三维重建方法研究进展[J]. 农业机械学报, 2014, 45(6): 38-46, 19.

Liu G, Si Y S, Fen J. 3D Reconstruction of agriculture and forestry crops[J]. Transactions of the Chinese Society for Agricultural Machinery, 2013, 45(6): 38-46, 19.

[2] Zhu J, Wang L, Yang R G, et al. Reliability fusion of time-of-flight depth and stereo geometry for high quality depth maps[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011,33(7): 1400-1414.

[3] 项荣, 应义斌, 蒋焕煜, 等. 基于双目立体视觉的番茄定位[J].农业工程学报, 2012, 28(5): 161-167.

Xiang R, Ying Y B, Jiang H Y, et al. Localization of tomatoes based on binocular stereo vision[J]. Transactions of the Chinese Society of Agricultural Engineering, 2012, 28(5): 161-167.

[4] 李长勇, 曹其新. 基于深度图像的蔬果形状特征提取[J]. 农业机械学报, 2012, 43(S1): 242-245.

Li C Y, Cao Q X. Extraction method of shape feature for vegetables based on depth image[J]. Transactions of the Chinese Society for Agricultural Machinery, 2012, 43(S1): 242-245.

[5] Hayashi S, Shigematsu K, Yamamoto S, et al. Evaluation of a strawberry-harvesting robot in a field test[J]. Biosystems Engineering, 2010, 105(2): 160-171.

[6] 王传宇, 赵明, 阎建河, 等. 基于双目立体视觉技术的玉米叶片三维重建[J]. 农业工程学报, 2010, 26(4): 198-202.

Wang C Y, Zhao M, Yan J H, et al. Three-dimensional reconstruction of maize leaves based on binocular stereovision system[J]. Transactions of the Chinese Society of Agricultural Engineering, 2010, 26(4): 198-202.

[7] 宋健, 孙学岩, 张铁中, 等. 开放式茄子采摘机器人设计与试验[J]. 农业机械学报, 2009, 40(1): 143-147.

Song J, Sun X Y, Zhang T Z, et al. Design and experiment of opening picking robot for eggplant[J]. Transactions of the Chinese Society for Agricultural Machinery, 2009, 40(1): 143-147.

[8] Chéné Y, Rousseau D, Lucidarme P, et al. On the use of depth camera for 3D phenotyping of entire plants[J]. Computers and Electronics in Agriculture, 2012, 82: 122-127.

[9] 周薇, 冯娟, 刘刚, 等. 苹果采摘机器人中的图像配准技术[J].农业工程学报, 2013, 29(11): 20-26.

Zhou W, Fen J, Liu G, et al. Application of image registration technology in apple harvest robot[J]. Transactions of the Chinese Society of Agricultural Engineering, 2013, 29(11): 20-26.

[10] 刘晋钢, 刘卫斌, 刘晋霞. Kinect与Unity3D数据整合技术在体感游戏中的应用研究[J]. 电脑开发与应用, 2014, 27(11): 7-11, 14.

Liu J G, Liu W B, Liu J X. Application research of somatosensory game based on Kinect and unity3D data integration technology[J]. Computer Development & Applications, 2014, 27(11): 7-11, 4.

[11] 李卉, 王蔚. 基于Kinect体感交互的儿童注意力测评系统[J].现代教育技术, 2014, 24(7): 120-126.

Li H, Wang W. An attention measuring technology for children based on somatosensory interaction using Microsoft Kinect[J]. Modern Educational Technology, 2014, 24(7): 120-126.

[12] 陈燕军, 汪地, 杨浩, 等. 基于Kinect的手术辅助系统研究[J].计算机技术与发展, 2014, 24(9): 81-83, 88.

Chen Y J, Wang D, Yang H, et al. Research on operation auxiliary system based on Kinect[J]. Computer Technology and Development, 2014, 24(9): 81-83, 88.

[13] 张克华, 王书平, 尹晓红, 等. 复杂室内环境下的单一的Kinect导盲系统[J]. 光学 精密工程, 2015, 23(8): 2419-2427.

Zhang K H, Wang S P, Yin X H, et al. Blind navigation aid system with Kinect sensor in complex indoor environments[J]. Optics and Precision Engineering, 2015, 23(8): 2419-2427.

[14] 李东年, 周以齐. 采用改进粒子群优化粒子的三维人手跟踪[J].光学 精密工程, 2014, 22(10): 2870-2878.

Li D N, Zhou Y Q. Three dimensional hand tracking by improved particle swarm optimized particle filter[J]. Optics and Precision Engineering, 2014, 22(10): 2870-2878.

[15] 余涛. Kinect应用开发实战:用最自然的方式与机器对话[M].北京: 机械工业出版社, 2012.

Yu T. Dialogue with the Machine in the Most Natural Way[M]. Beijing: Machinery Industry Press, 2012.

[16] 苏显渝, 张启灿, 陈文静. 结构光三维成像技术[J]. 中国激光,2014, 41(2): 1-10.

Su X Y, Zhang Q C, Chen W J. Three-dimensional imaging based on structured illumination[J]. Chinese Journal of Lasers, 2014,41(2): 1-10.

[17] 吴俊, 夏军. 基于Kinect的景深提取算法研究[J]. 光电子技术,2014, 34(2): 113-116, 120.

Wu J, Xia J. Depth map extraction algorithm based on Kinect[J]. Optoelectronic Technology, 2014, 34(2): 113-116, 120.

[18] 孙瑜, 李占利. 基于射影几何的CCD相机几何模型研究[J].计算机工程, 2015, 41(5): 270-273.

Sun Y, Li Z L. Research on geometric model of CCD camera based on Projective geometry[J]. Computer Engineering, 2015,41(5): 270-273.

[19] 吴海斌, 于晓洋. 应用市售设备的结构光系统模型及标定[J].光学 精密工程, 2008, 16(4): 617-623.

Wu H B, Yu X Y. Structured light system model using off-theshelf components and its calibration[J]. Optics and Precision Engineering, 2008, 16(4): 617-623.

(责任编辑:童成立)

Measurement and 3D-reconstruction of plants based on Kinect sensor

LIU Hui, XU Hui, SHEN Yue, LI Ning

(School of Electrical and Information Engineering, Jiangsu University, Zhenjiang, Jiangsu 212013, China)

The image reconstruction for three dimensional (3D) plant structures could be used to monitor plant growth automatically and provide real-time spray amount information for precision agriculture. A 3D image reconstruction method based on Kinect sensor technology was proposed to measure canopy stereoscopic structures. The color images and depth images of plants were detected with a Kinect sensor at the same time. The depth distances between objects and sensor were obtained based on average calculations after multiple depth image measurements. The horizontal projection area of plants and 3D canopy structure reconstructions of plants were achieved by extracting useful data and fusing color image and depth image information. Some regular-shaped objects and irregular-shaped plants were chosen as scanning targets to test the accuracy of the proposed method for depth distance and horizontal projection area estimation. The experiment results showed that the new method could detect both regular-shaped objects and irregular-shaped plants accurately with depth distance error less than 1.0% and horizontal projection area error less than 3.6% in all three depth detection distances from 1.1 m to 1.3 m. A planting area for potted chlorophytes in a greenhouse were used as scanning targets to verify the performance of the new method for detecting depth distances, measuring horizontal projection area,and reconstructing 3D canopy structures in real time. A 3D image detection and reconstruction system integrated with a Kinect sensor measuring mechanism and a position controller was used to conduct the experiments. The experiment results showed the average depth distance error was less than 1.77% and the proposed method has a high feasibility for 3D canopy structure measurements of greenhouse plants.

Kinect sensor; plant depth; canopy structure; horizontal projection area; 3D-reconstruction

National Natural Science Foundation of China (51505195); Natural Science Foundation of Jiangsu Province (BK20130501);Chinese Postdoctoral Science Foundation (2014M550272).

LIU Hui, E-mail: amity@ujs.edu.cn.

21 November, 2015;Accepted 11 May, 2016

S491

A

1000-0275(2016)05-0995-06

10.13872/j.1000-0275.2016.0055

国家自然科学基金项目(51505195);江苏省自然科学基金项目(BK20130501);中国博士后科学基金(2014M550272)。

刘慧(1980-),女,江苏南京人,博士,副教授,硕士生导师,主要从事电能质量检测与控制、农业电气化与自动化、嵌入式系统与开发、生物医学信号处理研究,E-mail: amity@ujs.edu.cn;徐慧(1991-),女,江苏扬州人,硕士研究生,主要从事农业电气化与自动化、机器人控制和智能喷雾控制研究,E-mail: xuhui_ujs@163.com。

2015-11-21,接受日期:2016-05-11