机载复杂遥感场景下特定建筑区检测跟踪算法

2016-08-12毕福昆章菲菲

毕福昆,陈 禾,师 皓,章菲菲

(1.北方工业大学电子信息工程学院,北京 100144;2.北京理工大学雷达技术研究所,北京 100081)

机载复杂遥感场景下特定建筑区检测跟踪算法

毕福昆1,陈禾2,师皓2,章菲菲2

(1.北方工业大学电子信息工程学院,北京 100144;2.北京理工大学雷达技术研究所,北京 100081)

特定建筑区域的自动检测及跟踪在机载遥感视频数据处理中具有重要意义,是非悬停机载平台面向任务对地搜寻及火控系统引导的关键技术之一.针对实际复杂应用场景,提出一种特定建筑区检测跟踪算法.首先,将离线获得的目标区参考图进行局部描述子特征提取.目标区在线检测阶段,为保证时效性,提出基于边缘显著性的快速SIFT (Scale Invariant Feature Transform) 特征提取方法,对待检测大视场图像中疑似建筑区域提取局部描述子特征;并通过设计层次化的特征点匹配方法实现目标区的高可靠检测.目标区在线跟踪阶段,通过自适应开窗及轨迹预测技术有效圈定疑似目标区,并在圈定的有限范围内进行最终目标确认及稳定跟踪.实测数据仿真结果表明,本文提出的算法能在复杂场景条件下,实现对特定建筑区域的快速检测及稳定跟踪.可为将来实际系统应用提供关键技术支撑.

机载视频跟踪;建筑区检测;局部描述子;复杂场景

1 引言

特定建筑区域的自动检测及跟踪在机载遥感视频数据处理中具有重要意义,是非悬停机载平台面向任务对地搜寻及火控系统引导的关键技术之一.该技术主要包括特定建筑区的检测及跟踪两个阶段.针对复杂视场遥感图像建筑区检测问题,Thales等考虑到顶视遥感图像中建筑往往表现为具有局部同质特性(homogeneous)的矩形区域,通过同质区细分割结合区域邻近图(Region Adjacency Graph,RAG)整合的方法成功提取建筑区[1].但该方法难以解决结构复杂建筑的检测问题.为此,近期有学者采用了图像检测领域较为成功的局部描述子技术进行改进[2~4],但这类方法提取局部描述特征时需要扫描整个视场,将产生巨大的运算量;此外,复杂大视场关键点匹配阶段往往容易出现误配,严重影响检测效果.这些缺陷都使该类算法在遥感视频应用中具有局限性.当特定建筑区得到检测后,算法会转入跟踪阶段.已有利用局部描述子技术的跟踪算法中[5~8],虽然引入了不少如粒子滤波等新技术,但对实时图中目标确认的阶段往往候选范围较大,且缺乏目标整体运动趋势的预测,容易导致跟踪失败.

针对以上技术存在的局限性及复杂背景下高时效应用的需求,结合建筑区域的结构特点,本文提出一种复杂场景下特定建筑区快速检测跟踪算法.

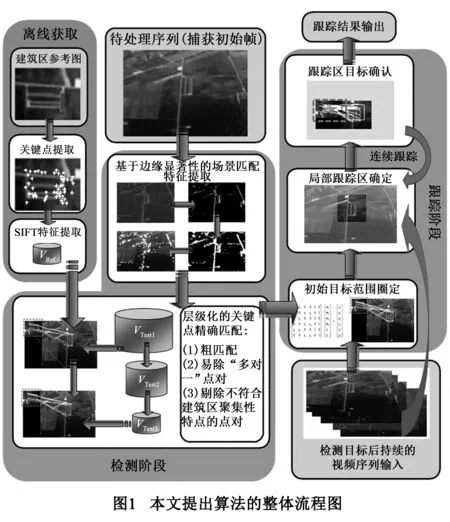

首先,在离线状态下,对参考图进行局部描述子特征提取.在线状态下,根据边缘显著性只对大视场实时图的疑似建筑边缘邻域进行局部描述子特征提取;接着,以层次化的筛选方式获得正确的匹配点对,实现目标初始区域快速检测.最后,通过抛物线外推轨迹预测及自适应开窗方法截取仅包含目标的有限区域,进行目标动态确认和跟踪.算法整体流程如图1所示.

2 特定建筑区域检测跟踪算法

2.1参考图SIFT特征离线提取

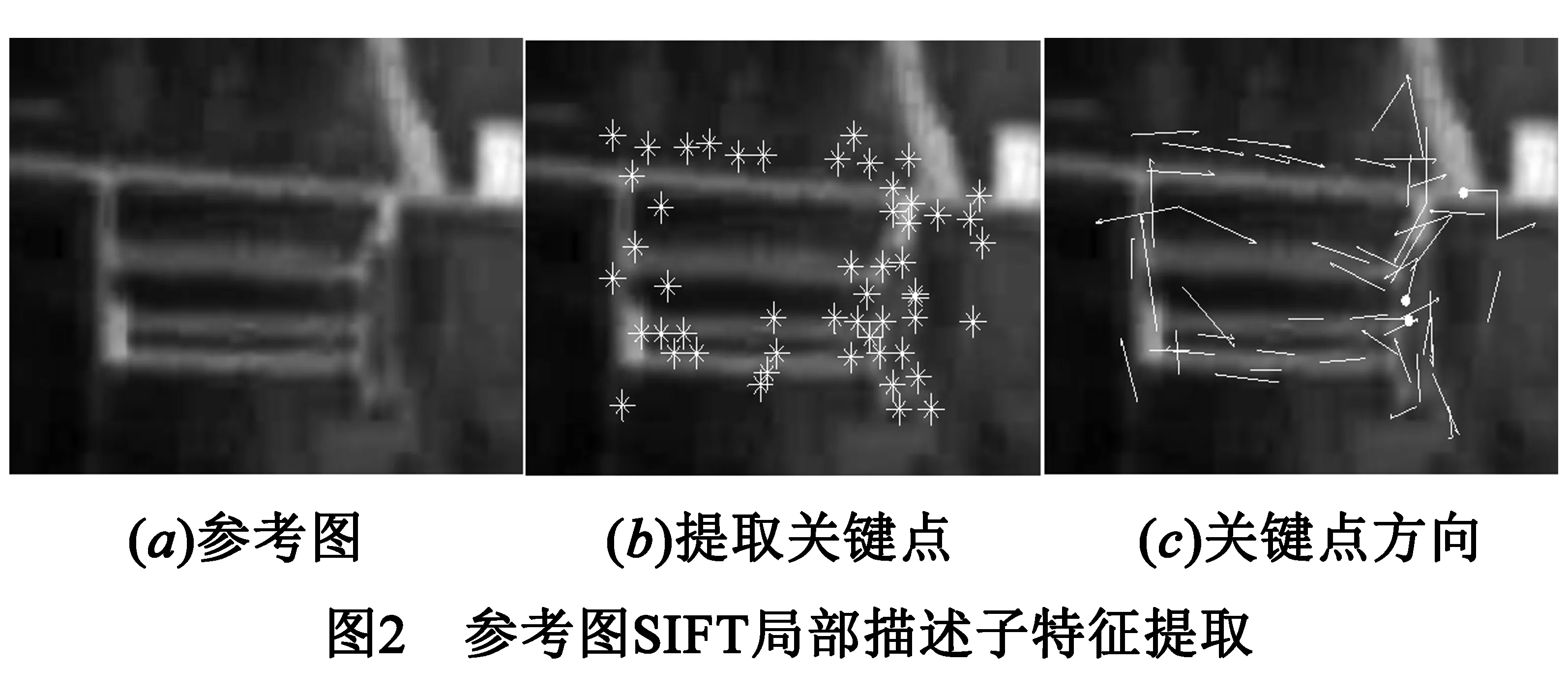

对选定的建筑区参考图离线提取SIFT(Scale Invariant Feature Transform)局部描述子特征[9].该特征对图像缩放、旋转甚至仿射变换具有不变性,对视角变化及噪声也具有一定鲁棒性[9~11].提取过程简述如下:

(1)对参考图像连续进行Gaussian卷积和2倍下采样,产生高斯金字塔L:

L(x,y,σ)=G(x,y,σ)*I(x,y)

(1)

(2)

其中,G为尺度可变高斯函数,I表示原始输入图像.高斯金字塔中相邻两图相减,得到差分金字塔D(x,y,σ)=L(x,y,kσ)-L(x,y,σ),并对其进行极值点检测.

(2)关键点筛选.对尺度空间DOG函数按照Taylor公式展开并进行三维二次曲线拟合.设定阈值,剔除对比度低的极值点,并利用二阶Hessian矩阵去除边缘响应强烈的极值点,最后剩下的称关键点.

(3)利用邻域像素梯度方向分布特性,为每个关键点指定方向.计算关键点邻域像素梯度的幅度和方向,按梯度角度进行幅度直方图统计以确定关键点的主、辅方向.

(4)对所有关键点的邻域按照关键点主方向进行旋转,邻域半径确定如下式:

(3)

其中:d=4,σoct为关键点的组内尺度.然后对关键点周围图像区域分块,计算块内梯度直方图,生成具有独特性的128维向量,并对该向量进行梯度幅度限制和向量归一化,最终得到SIFT局部描述子特征.

2.2特定建筑区快速检测

2.2.1基于边缘显著性的场景匹配特征快速提取

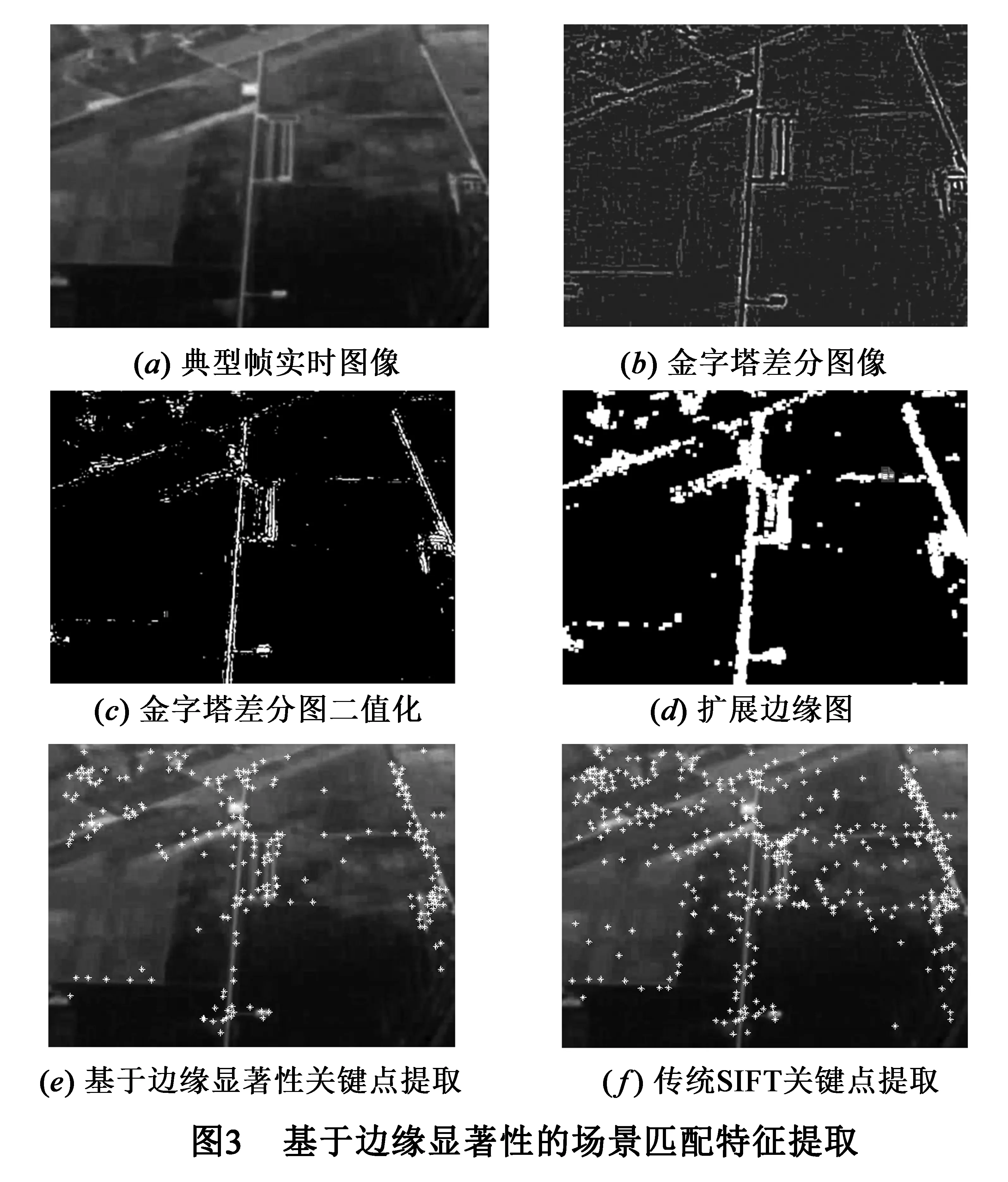

待搜寻的实时图具有范围大、场景复杂等特点.若按传统SIFT算法进行整图范围的局部描述子特征提取,将会由于产生大量的关键点而需要过多的局部描述子计算时间.使整个算法流程无法从检测阶段稳定可靠地转为跟踪阶段.

边缘显著性是建筑区相对于其它地物的明显差异特性,也是产生高可靠匹配局部描述子的主要聚集区域.根据该特性,本文首先对由原图产生的高斯差分金字塔每组第一层图像进行基于OTSU自适应阈值分割,获得实时图中的显著边缘区域.为保证建筑区匹配点的充足性,再进行形态学二值膨胀操作使显著边缘的周围邻域也纳入搜寻关键点的范围.

Msalient=DL(Otsu(D(x,y,k1σ))

(4)

其中D(x,y,k1σ)表示每组金字塔的底层图像,Otsu(·)表示Otsu自适应阈值分割操作,DL(·)表示形态学二值膨胀操作.接着在关键点生成环节,只对D(x,y,σ)对应的边缘显著区Msalient进行极值点检测,并由此产生关键点.最后按SIFT局部描述子生成方式可快速计算出少量稳定的待匹配局部描述子.由图3(e)和图3(f)的对比可看出相比于传统的SIFT算法,本文对整图提取得到的关键点总数明显减少,但具有建筑边缘显著性的区域关键点数并未显著下降,保证了后续有效匹配局部描述子的数量.

2.2.2层级化的关键点精确匹配

在离线获取参考图的局部描述子特征,及在线快速提取基于边缘显著性的场景匹配特征后,为实现关键点的精确匹配,本文采用层级化由“粗”到“精”的匹配策略.主要分为以下3个递进的匹配层次:

(1)初步匹配.在该阶段,本文采用最邻近距离比例的方法(Nearest Neighbor Distance Ratio,NNDR)[9].首先对实时图像中的每个关键点,计算参考图像中与之SIFT特征向量间欧氏距离最近及次近的关键点;其次,计算这两个距离的比例,以确定是否需要将测试图中的最近关键点作为当前参考图中所考察关键点的匹配点.

(2)剔除“多对一”的误匹配点.由于实时图相对于参考图来说存在噪声及各种空间变化,而初步匹配是从实时图中寻找与参考图中关键点匹配的点对,可能在实时图的关键点中存在两个甚至多个匹配上参考图同一个关键点的情况.去除这种“多对一”的误匹配点,只需将匹配对的坐标按照实时图中的匹配结果排序,剔除多余的匹配点,即可得到一一对应的匹配点对.

(3)剔除不符合建筑区聚集性的错误匹配对.由于真实场景的复杂性,匹配上的局部区域可能具有近似的局部特点但位于不同建筑区中.考虑到本文应用中一次只对同一指定建筑区进行检测跟踪,匹配上的关键点应集中于同一建筑区域内.利用该特性剔除不符合建筑区聚集性的错误匹配对:

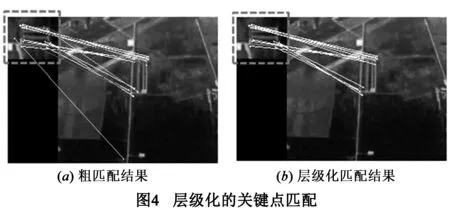

将参考图中匹配关键点i的位置定义为ri=(xi,yi),其所有匹配点的质心坐标为c1;实时图中匹配关键点j的坐标定义为sj=(xj,yj),其所有匹配点的质心坐标为c2,对于一个匹配对(ri,sj)定义比值R(i,j)=d(ri,c1)/d(sj,c2).其中d(·)表示欧氏距离.由于建筑区域的聚集性,匹配点对距离各自质心的距离比值应当相近.利用这一特性可进行离群错误点对的剔除.进一步考虑到如果某一错误匹配点与目标建筑区的距离较远,会将质心坐标拉到远偏离目标区域的位置,使剔除失效.因此需首先定位可靠质心再剔除离群点.为此,本文设计的策略是第一次剔除中只保留比值与均值很接近的少量点对,以确定各自的可靠质心位置.第二次再遍历所有的匹配点对将比值偏离比值均值较大的点对剔除.典型示例如图4所示.

2.3特定建筑区稳定跟踪

由于本文研究的是非悬停状态机载平台,目标区相对于机载平台有相对运动.因此,在对目标建筑区域检测后,需要对其进行稳定的锁定跟踪,主要包括以下三个环节:

2.3.1实时图初始目标区域范围圈定

在完成特定建筑区检测后,整个算法可转到跟踪阶段.该阶段首先需要对实时图进行初始目标区域范围的圈定.从检测阶段最终确定的局部特征匹配点对中随机选取3对,参考图匹配点为:(x1,y1),(x2,y2),(x3,y3),与之对应实时图的匹配点为:(x1′,y1′),(x2′,y2′),(x3′,y3′),代入仿射变换模型:

(5)

为方便表示,将上式写成:AX=b,则可以得:

(6)

通过上式可得到仿射变换矩阵X.实时图中初始目标范围的确定,可通过将参考图四个顶点坐标带入变换模型得到实时图中对应目标区的顶点位置.因为当前帧与下一帧间机载平台相对于目标可能存在运动,因此需对计算出的目标初始位置进行适当外扩.由此得到的范围就是下一帧图像待匹配跟踪的区域.同法,由参考图中的质心坐标可以获得实时图中的目标初始质心坐标.

2.3.2动态局部跟踪区域确定

2.3.3跟踪目标确认

在获得可能存在目标的局部跟踪范围后,在下一帧实时图中只需提取该局部跟踪范围的SIFT局部描述子特征,与参考图进行特征匹配确认.若无法确认则表示目标已消失或移除视场之外.对跟踪阶段的后两个环节循环往复可实现对特定建筑区域的稳定跟踪锁定.

3 实验结果及分析

为了验证所提出检测跟踪算法的性能及效率,本文设计了定性及定量的实验方法,将算法在真实复杂视频场景中进行测试.实验数据来源于网络公开无人机视频,特定建筑区参考图从视频近视场中截取,指定为其中的小型机场区域尺寸为160*110像素,如图2(a).测试视频数据场景尺寸为384*512像素,典型帧如图3(a)所示,其中包含了农田、路网、植被及其它人造区域.随着机载平台的无规则移动,测试视频中目标区域从无到有,并且包括多种典型空间变换:旋转、尺度变换、照明变换、仿射变换及部分移出视场之外.所有的实验均以Matlab2013a编程实现,实验平台为Intel 2.4G CPU,4G内存的PC机.

3.1检测阶段实验及分析

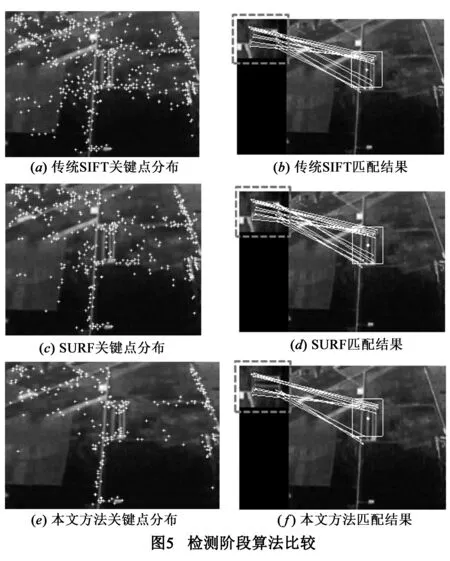

为验证检测阶段的性能,采用传统SIFT匹配检测算法[9]及最新提出以效率著称的SURF(Speeded-Up Robust Features)匹配检测算法[12],与本文检测阶段算法比较,并对比分析它们的计算效率.图5各子图分别是各算法对典型测试场景提取有效关键点的情况及与参考图匹配检测的情况.

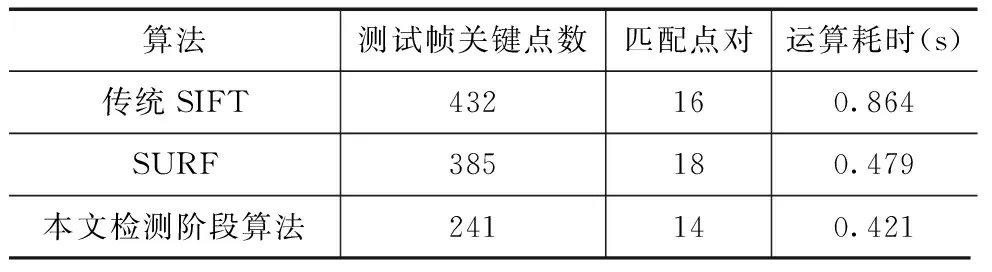

为定量分析三种算法的性能和效率,提取视频中非连续的300帧图像进行匹配检测实验,并统计测试帧关键点数,匹配对点数及运算时间三种衡量指标,下表给出所有测试帧指标的统计平均值.

表1 定量比较实验结果

对比分析三种算法的关键点提取情况:传统SIFT算法提取到的关键点数量较多且分布广泛,非平坦区域均有分布;SURF算法就是为了解决传统SIFT算法处理时间过长而提出的,其关键点数量相比于传统SIFT算法有所减少;本文检测阶段算法由于考虑了建筑区的边缘显著性,关键点总数明显下降,仅为传统SIFT算法的55.78%,并且从图5可以看出筛减掉的关键点大多位于植被、地表等非建筑区灰度突变处,所提取的关键点密布于边缘特性显著的区域,这些区域是存在建筑的高概率区域.

从表1匹配上的关键点对情况看,三种算法正确匹配上的关键点对数目相近.所提出的算法并没有因为提取的关键点总数明显少于两种比较算法而使正确匹配点对数急剧下降.这说明在检测阶段本文算法通过边缘显著性筛减了大量与建筑区检测无关的关键点,同时保证了检测特定建筑区所需的足够关键点数.

从表1检测效率看,本文的算法与SURF算法的运算时间都明显优于传统的SIFT算法,与SURF相比本文算法运算时间略有优势.但值得注意的是SURF算法产生的描述子是64维,本文算法是128维能更好描述局部区域信息,在复杂场景时具有更优的鲁棒性.

3.2跟踪实验及分析

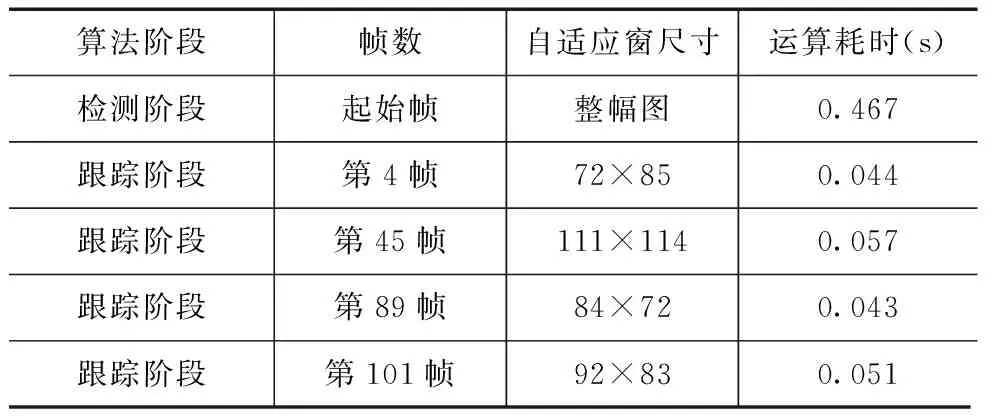

根据本文算法的整体检测跟踪流程,首先完成对视频流中目标的搜索检测.一旦检测出参考图目标,就立即转入跟踪阶段.下图给出算法转入跟踪阶段后的运行结果示例.图6第1列为选取视频流中各时间段的典型帧,其中的非掩膜区域为当前帧的自适应开窗区域,其由本文在跟踪阶段提出的动态局部跟踪区域确定技术截取得到.第2列是参考图与待确认目标局部区域图的匹配确认结果.表2是对应视频流检测阶段及跟踪过程的耗时情况.

表2 跟踪结果定量统计

算法阶段帧数自适应窗尺寸运算耗时(s)检测阶段起始帧整幅图0.467跟踪阶段第4帧72×850.044跟踪阶段第45帧111×1140.057跟踪阶段第89帧84×720.043跟踪阶段第101帧92×830.051

由图6可以看出,经过前3帧图像的积累,从视频流第4帧图像开始算法流程成功转入跟踪阶段.通过本文提出的动态局部跟踪区域确定技术,自适应开窗截取当前帧中包含目标较完整的区域,且外围无关区域较小,为低运算量高精度的目标匹配确认打下了基础.其次,由图6第1列可看出随着视频流目标位置、尺度、光照及角度不断变化,自适应跟踪窗(图6第1列中非掩膜区域)的尺寸和范围随之只适应变化.但始终能够稳定的锁定目标所在的局部区域,并在匹配确认中正确确认目标(图6第2列).

从表2可以看出,初始目标检测阶段耗时较大,但转入跟踪阶段后耗时急剧下降.这是因为检测阶段算法需要对整幅实时图的场景进行目标搜索检测,而转入跟踪阶段后只需对自适应跟踪窗中的小范围目标区域进行匹配确认,运算量低.从在普通PC机的仿真实验结果可以看出,如果将算法移植到机载平台的嵌入式设备中有望实现实时处理.

4 总结

本文针对实际复杂应用场景,提出一种特定建筑区快速检测跟踪算法.基于边缘显著性的实时图局部特征提取保证了检测阶段的时效性,层级化的特征点匹配策略保证了该阶段的准确性.转入跟踪阶段后,算法通过自适应开窗及轨迹预测技术有效圈定疑似目标区,并在圈定的有限范围内进行最终目标确认,确保了跟踪的时效性及稳定性.实验结果表明该算法能在复杂场景中对指定建筑区实现准确地检测及高时效性的稳定跟踪,且对实时图中的目标区域相对于参考图有典型图像空间变换时,也具有良好的适应性.此外,该算法只需一幅任务目标区域参考图进行离线局部特征提取,无需大量训练样本,具有较高的实用性.但另一方面,也可看到本文算法仍存在一定的局限性有待改进:即当对目标的观测视角发生超大角度快速变化时,本文跟踪阶段可能丢失目标.因此,参考图特征的动态更新,将是未来工作改进的方向.

[1]Thales S K,Luciano V D,Leila M G F.A resegmentation approach for detecting rectangular objects in high-resolution imagery[J].Geoscience and Remote Sensing Letters,IEEE,2011,8(4):621-625.

[2]Sirmacek B,Unsalan C.A probabilistic framework to detect buildings in aerial and satellite images[J].Geoscience and Remote Sensing,IEEE Transactions on,2011,48(1):211-221.

[3]Tao C,Tan Y H,Cai H J,Tian J W.Airport detection from large IKONOS images using clustered SIFT keypoints and region information[J].Geoscience and Remote Sensing,IEEE Transactions on,2011,8(1):128-132.

[4]何林远,毕笃彦,等.基于SIFT和MSE的局部聚集特征描述新算法[J].电子学报,2014,42 (8):1619-1623.

Lin-yuan H,Du-yan B,et al.The new descriptor algorithm of local aggregation features based on SIFT and MSE[J].Acta Electronica Sinica,2014,42 (8):1619-1623.(in Chinese)

[5]Qiao Y,Wang W.A theory of phase singularities for image representation and its applications to object tracking and image matching[J].Image Processing,IEEE Transactions on,2009,18(10):2153-2166.

[6]Chen C,Schonfeld D.Aparticle filtering framework for joint video tracking and pose estimation[J].Image Processing,IEEE Transactions on,2010,19(6):1625-1634.

[7]Imai J I,Li W M,Kaneko M.Online object modeling method for occlusion robust tracking[A].Robot Human Interactive Communication,2009[C].Toyama:IEEE,2009.58-63.

[8]Nasser H,Nicolas D.Real-time hand gesture detection and recognition using bag-of-features and support vector machine techniques[J].Instrumentations and Measurement,IEEE Transactions on,2011,60(11):3592-3606.

[9]Lowe D G.Distinctive image features from scale-invariant keypoint[J].International Journal of Computer Vision,2004,60(2):91-110.

[10]Apostolos P,Christos N.Vehicle logo recognition using a SIFT-based enhanced matching scheme[J].Intelligent Transportation Systems,IEEE Transactions on,2010,11(2):322-328.

[11]Zhao W L,Chong W N.Flip-invariant SIFT for copy and object detection[J].Image Processing,IEEE Transactions on,2013,22(3):980-991.

[12]Bay H,Ess A,Tuvtellars T,Gool L V.Speeded-up robust features (SURF)[J].Computer Vision and Image Understanding,2008,110:346-359.

毕福昆(通信作者)男,1982年9月出生,云南昆明人.2011年在北京理工大学获得工学博士学位,2013年北京大学信息科学与技术学院博士后流动站出站,现为北方工业大学电子信息工程系讲师.主要研究方向为:遥感目标检测与识别、遥感图像自动解译.

E-mail:bifukun@163.com

陈禾女,1970年3月出生,辽宁沈阳人,1998年在哈尔滨工业大学获得工学博士学位,2000年北京理工大学通信与信息工程博士后流动站出站,现为北京理工大学信息与电子学院教授,博士生导师.研究方向为:遥感图像及雷达信号处理、超大规模集成电路设计.

Identifying and Tracking Specific Building Areas in Airborne Remote Sensing Video with Complicated Scenes

BI Fu-kun1,CHEN He2,SHI Hao2,ZHANG Fei-fei2

(1.SchoolofElectronicInformationEngineering,NorthChinaUniversityofTechnology,Beijing100144,China;2.LabofRadarResearch,BeijingInstituteofTechnology,Beijing100081,China)

Automatic identification and tracking for specific building areas is not only of great significance in airborne remote sensing video data processing,but also one of the key technologies for task-oriented non-hovering airborne platform to search ground and boost fire control system.This paper proposes an identification and tracking algorithm of specific building areas for real complex application scenes.First,to extract local descriptors for offline reference images with target areas.At the stage of target area online identification,in order to ensure the timeliness,a fast SIFT (Scale Invariant Feature Transform) feature extraction method based on significant edges is proposed to extract local descriptors for suspected areas in large field of view images to be detected.In addition,the hierarchical feature point matching method is designed to achieve a highly reliable identification of target areas.At the stage of online tracking for target area,adaptive window and trajectory predicting technologies can effectively delineate suspected target areas,and within the limited range to recognize the final targets and track them.Real-measured data simulation results show that the proposed algorithm in complex scene conditions can realize the quick identification and stable tracking for a particular building area.It can also provide a key technical support for the future application of real systems.

airborne video tracking;building area identification;local descriptor;complex scenes

2014-12-10;修回日期:2015-06-01;责任编辑:梅志强

国家自然科学基金(No.61171194);北京市教委科技计划面上项目(No.KM201610009004)

TP751

A

0372-2112 (2016)06-1394-06