基于全参考“高分二号”卫星图像融合质量评价

2016-02-13孟凡晓陈圣波张国亮

孟凡晓 陈圣波 张国亮

(吉林大学地球探测科学与技术学院,长春 130026)

基于全参考“高分二号”卫星图像融合质量评价

孟凡晓 陈圣波 张国亮

(吉林大学地球探测科学与技术学院,长春 130026)

利用八种常用的遥感图像融合方法对中国首颗亚米级卫星——“高分二号”(GF-2)进行全色与多光谱图像融合,并对融合结果做主客观评价。为充分考虑人眼视觉系统的参与,文章选取通用图像质量(Quality,下同)评价指数、视觉信噪比模型、多尺度结构相似度、视觉信息保真度准则、信息保真度准则、噪声质量检测六种经典的基于全参考图像质量客观评价模型作为长春市城区融合图像客观评价指标。结果表明:对于GF-2卫星图像融合,八种方法均在一定程度上增加了空间信息,同时保持了原始光谱信息。其中,融合效果最好的是HPF方法,Gram-Schmidt方法次之,Multiplicative、PCA、Subtractive、HCS、High Pansharp方法融合效果依次下降,Pansharp方法效果最差。

图像融合 人类视觉系统 全参考图像质量评价 “高分二号”卫星

0 引言

随着遥感技术的发展,越来越多的数据产品涌入人类的视野中。而人类对数据质量(Quality,全文同)的要求也与日俱增,希望数据既能保持原始多光谱图像的光谱完整性,又同时具有全色图像的高空间分辨率,故需对其进行数据融合。如何选择恰当的融合方法使融合效果达到最佳,信息保真度最好,是目前融合的关键技术之一。我国“高分二号”(GF-2)卫星图像,由于刚刚发射投入使用,探索合适的融合方法是目前形势的迫切需求。

20世纪70年代,图像融合的概念首次在美国出现,文献[1-4]对遥感图像融合进行了初步研究。多种遥感图像数据处理的软件如美国Intergraph公司的ERDAS IMAGINE、RSI公司的ENVI,加拿大的PCI,澳大利亚ERM公司的ER Mapper和德国Definiens Imaging公司的eCogniton等现成为当今图像处理必备的软件。

我国对图像融合研究始于20世纪80年代,特别是将信息融合技术列为“863”计划和“九五”规划中的重点研究内容后[5],开启了对信息融合的广泛研究。1998年以后我国图像融合技术的发展如雨后春笋,能够自主地将各种类型的数据进行融合。同源数据融合有高分辨率光学遥感数据[6]、高光谱数据[7]、雷达数据融合[8]等;异源传感器之间TM与SAR[9]、TM与航空数据[10]等。

本文采用多种方法对GF-2卫星分辨率0.8m全色图像与分辨率3.2m的多光谱图像进行融合,并对融合效果进行主观评价和基于全参考图像质量客观评价,得出最佳融合方法。

1 数据源及预处理

GF-2卫星,搭载两台高分辨率相机(全色/多光谱相机,简称PMS),星下点全色分辨率为0.81m、多光谱分辨率为3.24m,它是我国首颗亚米级分辨率的遥感卫星。本文数据源选取GF-2卫星PMS1相机全色图像和多光谱图像进行融合。研究区位于吉林省长春市城区,共5 060×5 118个像元,数据采集时间为2015年9月20日。

本文旨在对GF-2卫星全色与多光谱图像融合,以获得具有高分辨0.8m的多光谱融合图像。而保证图像融合效果的首要前提是必须要求融合前的两类图像精确配准。GF-2卫星原始多光谱与全色图像自动配准方法不仅能保证配准精度,且能缩短图像预处理时间,是规模化数据应用中较好的配准策略[11]。笔者对GF-2卫星正射校正后多光谱与全色数据进行自动配准,自动生成79个控制点,配准精度在0.22个像元内,满足精度要求。

2 融合方法

分析前人经验得知HSV、Brovey、Wavelet、Ehlers四种融合方法的融合效果较差[12],故选用当今常用的对光谱信息与空间信息保持相对较好的Gram-Schmidt、HCS、HPF、Pansharp、High Pansharp、PCA、Multiplicative、Subtractive八种融合方法对GF-2卫星图像的全色图像与多光谱图像融合。

2.1 Gram-Schmidt融合方法

Gram-Schmidt融合方法简称G-S,首先对多光谱图像进行G-S正变换,其次将全色波段替换第一分量进行G-S逆变换,从而获得融合图像[13]。基于G-S变换的融合方法无波段数限制,可避免使用主成分变换时信息集中于第一主成分的情况,该方法具有较高的光谱信息保持度。

2.2 HCS融合方法

HCS(Hyperspherical Color Space)方法是针对WorldView-2图像融合处理的一种基于超球面彩色变换的融合方法[14]。其原理是将全部多光谱数据一次性地从原始空间转换到超球面彩色空间后,对全色图像及I分量进行建模,获得全色锐化后I′分量,最后进行色彩空间的变转换获得融合图像。

2.3 HPF融合方法

HPF(High-Pass Filtering Fusion)融合方法又称高通滤波融合方法[15]。首先对全色图像进行傅里叶变换,通过一个卷积模板即高通滤波器抑制其低频光谱信息。滤波的结果是对多光谱图像数据信息平均,用来抵消亮度值的增加,然后对全色图像与多光谱图像叠加实现融合。

2.4 Pansharp与High Pansharp融合方法

Pansharp融合方法也称超分辨率贝叶斯法,是一种针对颜色失真和数据运算依赖关系的新型自动化融合方法。其原理是用最小二乘法拟合原始全色与多光谱图像的灰度值和融合结果的灰度值[16]。由于Pansharp融合方法保留了每个原始图像灰度值的均值、标准偏差和直方图特征,因此能最大限度地保留多光谱图像的颜色信息。High Pansharp融合方法是对Pansharp方法的改进[17]。

2.5 PCA融合方法

PCA(Principal Component Analysis)融合方法也称主成分变换,它是一种基于统计特征的多图像正交线性变换实现的融合方法[3]。首先,对多光谱图像进行主成分正变换,假设变换后的第一主成分量包含了与全色图像相同的全部目标空间信息,因此就可以通过将全色图像代替第一主成分量,再通过主成分逆变换得到高分辨率融合图像。

2.6 Multiplicative融合方法

Multiplicative融合方法即乘积变换融合方法,是通过光谱替代实现的。文献[18]指出,在乘积变换方法是不仅对颜色信息不扭曲,同时还提高融合后图像的信息量。乘积变换公式为

式中MS,fusedDN为融合前全色图像像素值。

2.7 Subtractive融合方法

Subtractive融合方法是专门为QuickBird、IKONOS等卫星图像融合而设计的方法。它不但能保留多光谱图像颜色信息,还能保留全色图像的纹理信息[19]。它要求输入融合图像类型必须是无符号整型8bit或16bit,4个多光谱波段,1个全色波段,全色图像和多光谱图像的像元大小应有大致14∶的关系且同时获取。GF-2卫星图像满足要求,所以选择该方法作为研究方法之一。

DN为融合后多光谱像素值;MS

DN为融合前多光谱像素值;Pan

3 融合质量评价

对遥感图像融合效果评价方法有主观评价和客观评价[20]。

3.1 主观评价

主观评价即结合大脑中的专业知识,通过人的肉眼对融合图像目视解译,根据图像的实际采集背景,包括采集时间等,判断色彩是否接近自然真彩色,色调是否均匀,图像地物边界是否清晰,纹理是否丰富,整体亮度是否适中等方面进行目视判别与比较。

3.2 客观评价

客观评价是基于数学模型利用图像的某些统计特征参数对图像进行评价。根据参考图像即原始图像对其评价贡献大小,图像质量评价方式分为三种:全参考、半参考与无参考图像质量评价[21]。本文采用发展最成熟的全参考图像质量评价,融合前的图像作为参考图像。

全参考图像质量客观评价是利用原始图像的全部信息,通过计算原始图像与失真图像在某些数学统计特征的变化差异完成图像质量评价。传统全参考图像质量客观评价主要用基本的数学统计特征完成,但这些参数只表达某一方面的质量特征,没有考虑人类视觉系统(Human Visual Systems,HVS)对图像的作用。这是因为人眼是图像最终接收端,可对图像亮度、对比度、频率及不同信号组分之间的相互作用进行识别[22],具有心理学和精神型视觉特征。因此,本文除了基本的全参考图像质量指标外,选用应用普遍、精度高的五种基于HVS的全参考图像质量指标进行客观评价。

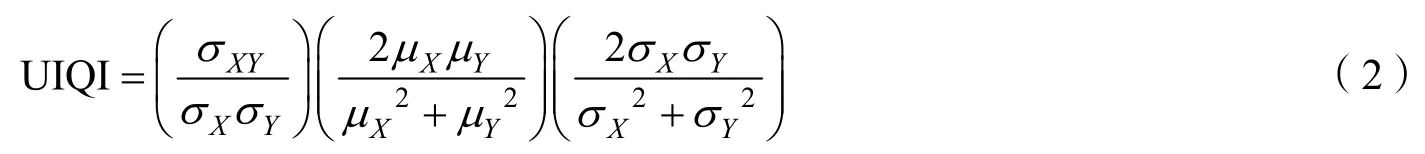

3.2.1 UIQI模型

UIQI(Universal Image Quality Index)是文献[23]于2002年提出的一种新型通用图像客观质量评价指标。其认为,图像的失真是由三个因素决定的:相关性失真、亮度失真和对比度失真。尽管该指标没有人类视觉系统参与,但试验表明它的效果显著地高于传统全参考图像质量客观评价指标均方根误差与峰值信噪比的评价精度。假设X为原始图像,Y为待评价图像,则UIQI表达为

式中 UIQI的范围是[-1,1],-1是效果最差的,相反1是最佳效果,认为待评价图像无失真;分别是原始图像像素值的均值、方差;分别是待评价图像像素值的均值、方差;σXY是原始图像与待评价图像像素值之间的协方差。

3.2.2 VSNR模型

VSNR模型即基于小波域的视觉信噪比模型(Visual Signal-to-Noise Ratio),是文献[24]于2007年提出的。VSNR模型认为原始图像是基于近-阀值和超-阀值的人类视觉特性的。VSNR指标分为两部分:为了确定失真图像上的畸变是否存在,检测扭曲的对比阈值经过视觉掩蔽和视觉累加的小波模型计算。如果失真低于阈值,认为图像具有理想视觉保真效果,无需再做分析;若失真高于阈值则对其进行低级视觉特性和最优全局中级特性计算。

式中 ()H X是原始图像X的均方根对比度;()()σμ分别表示原始图像物理亮度()L X的标准差与L XL X ,均值;VD为视觉畸变;[]0,1 a∈,决定了每个距离的相对贡献大小;pcd为图像畸变差异;gpd表示整体优先的破坏程度。

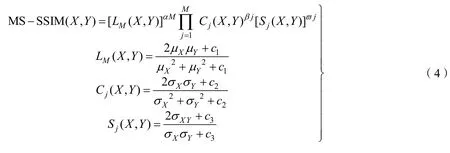

3.2.3 MS-SSIM模型

结构相似度(Structural Similarity Metric)主要是针对图像的结构失真、亮度失真与对比度失真由Z.Wang等人提出的。后来Wang和Simoncell等人对SSIM指标进行补充,提出了多尺度结构相似度(Multi-Scale Structural Similarity)模型,简称MS-SSIM模型[25]。

式中 j为图像尺度大小,1≤j≤M,M为图像最大尺度;LM(X, Y)为尺度为M下的图像亮度因子;Cj(X, Y),Sj(X, Y)分别为第j层尺度下的对比度和结构度因子;c1、c2与c3是防止分母为零的小正常量,为图像像素值动态范围(如8bit图像l=255),k1≪1,k2≪1;α, β ,ϖ是用来调节各个组分在评价中权重大小的非零值。

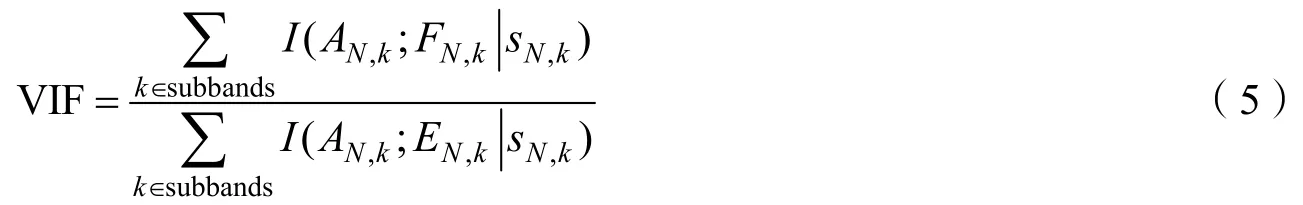

3.2.4 VIF模型

VIF模型即视觉信息保真度准则(Visual Information Fidelity)是Hamid Sheikh等人于2006年提出的图像质量评价模型[22]。假设源图像信息在失真过程中分为两个部分:一部分不经过“失真通道”直接通过HVS通道的信息称为参考图像信息,另一部分通过“失真通道”与HVS通道后的信息称为失真图像信息,VIF模型就是二者之比

式中 I表示信息量;k为图像第k个子带;N为向量维数;AN,k表示图像第k个子带的N个非零系数向量;sN,k是一个正值的随机场RF(Random Field,以下同);EN,k是参考图像第k个子带中的N维非零向量;FN,k是失真图像第k个子带中的N维非零向量。I(AN,k;EN,k)表示参考图像经由HVS输出后大脑能够提取的信息量,相应地I(AN,k;FN,k)为失真图像经由HVS后大脑能够提取的信息量。

3.2.5 IFC模型

IFC(Information Fidelity Criterion)即信息保真度准则,它由Hamid Sheikh于2005年提出的图像质量评价模型,用来测量参考图像与失真图像之间的交互信息的指标。模型认为,参考图像通过一个“失真通道”产生不同程度的失真变形后被人眼感知,参考图像和失真图像之间的交互信息损失需要通过一个畸变模型来计算[26]。IFC指标的表达式为

(;)

N kN k

式中 I'表示交互信息量;P是集合的元素个数,k表示第k个子带;表示参考图像第k个子带随机场RF的含P个元素的集合;是失真图像第k个子带随机场RF的含P个元素的集合;表示第k个子带的正标量随机场RF的含P个元素的集合。

3.2.6 NQM模型

NQM(Noise Quality Measure)即噪声质量检测模型是由Niranjan等人于2000年提出的一种基于加性噪声质量的图像客观质量评价方法,它考虑了噪声对人类视觉系统的影响,通过非线性空间频率产生的模拟图像计算而得[27]。NQM的表达式为

式中 O( U, V)代表模型修复图像(Model Restored Image),它是由原始图像通过修复算法得到的;R( U, V)代表修复图像(Restored Images),是由逆修复算法还原的;U、V代表图像像素行列数。

为验证八种融合方法的优劣,本文采用MOS(Mean Observation Score)平均观察分数排序[28]。主要步骤:

1)分别对每一个指标排序,效果最好为1,次之为2,以此类推,最差效果为8;

2)将以上各个方法的所有指标排序列表;

3)分别计算每种融合方法的MOS值,然后再排序,得出最优融合方法。MOS值最低表明该融合方法最佳,反之值最高,则认为该方法效果最差。

4 融合试验及评价

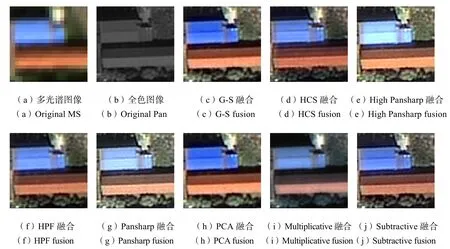

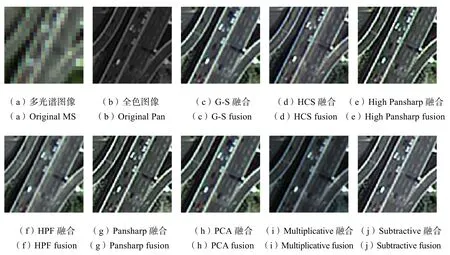

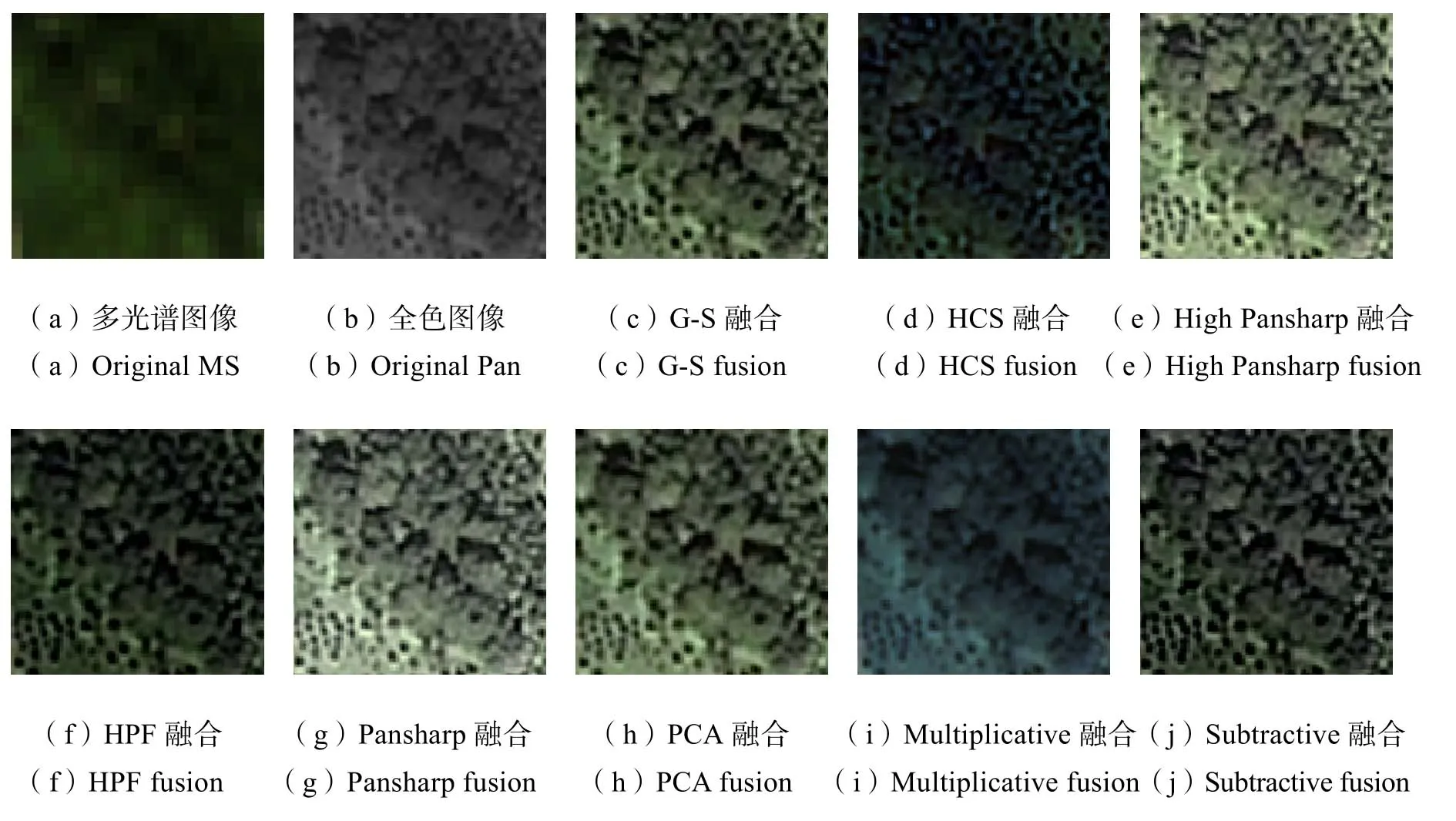

根据以上融合原理,对长春市城区GF-2卫星全色与多光谱图像融合,得到RGB真彩色合成图。选取研究区内主要地物类别建筑物、道路、林地予以截图显示,融合结果及局部细节对比见图1~图3。

图1 建筑物融合图像Fig.1 Fusion images of buildings

图2 道路融合图像Fig.2 Fusion images of roads

图3 林地融合图像Fig.3 Fusion images of woodlands

4.1 主观评价

主观评价认为,八种融合方法在一定程度上提高了空间分辨率并保持了原始多光谱信息。从纹理细节及清晰度来看,G-S、High Pansharp、Pansharp、PCA、Subtractive融合图像对空间细节和清晰度表现能力较好,原始多光谱图像上有些细小地物边界纹理无法辨别,如车辆、树木冠层等细节信息,通过这些方法融合后得到的图像均能清楚地分辨出来。HPF、HCS、Multiplicative融合图像在一定程度上出现了边界模糊,影响了对目标地物的目视解译。

就光谱保持情况来说,HCS、HPF融合方法最接近原始图像颜色,说明对原始多光谱信息保留最佳。G-S、High Pansharp、Pansharp、PCA、Subtractive融合效果比较接近原始图像颜色。Multiplicative融合后图像颜色与原始图像颜色出现严重偏差,说明光谱信息出现了严重的丢失。

在对比度方面,Multiplicative融合图像的对比度很低,图像整体色调暗。Pansharp、High Pansharp融合图像整体色调过于均一,有些细节纹理显示受到一定影响。而G-S、HPF、PCA、Subtractive、HCS对比度适中,适合常规目视解译要求。

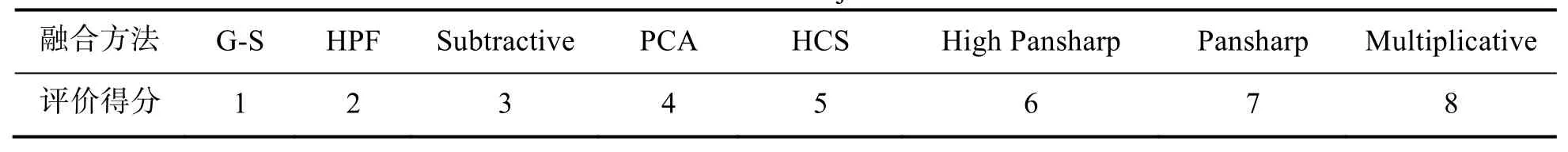

为便于后续工作,笔者挑选了10位解译经验丰富的专业人员,通过对融合图像的目视解译,根据国际规定的五级质量尺度和妨碍尺度进行主观评判打分,除去最高与最低分再取平均值,最后排序得出每种融合方法的主观评分(Scores of Subjective Evaluation,SSE),并由高到低排序,排序结果见表1。

4.2 客观评价

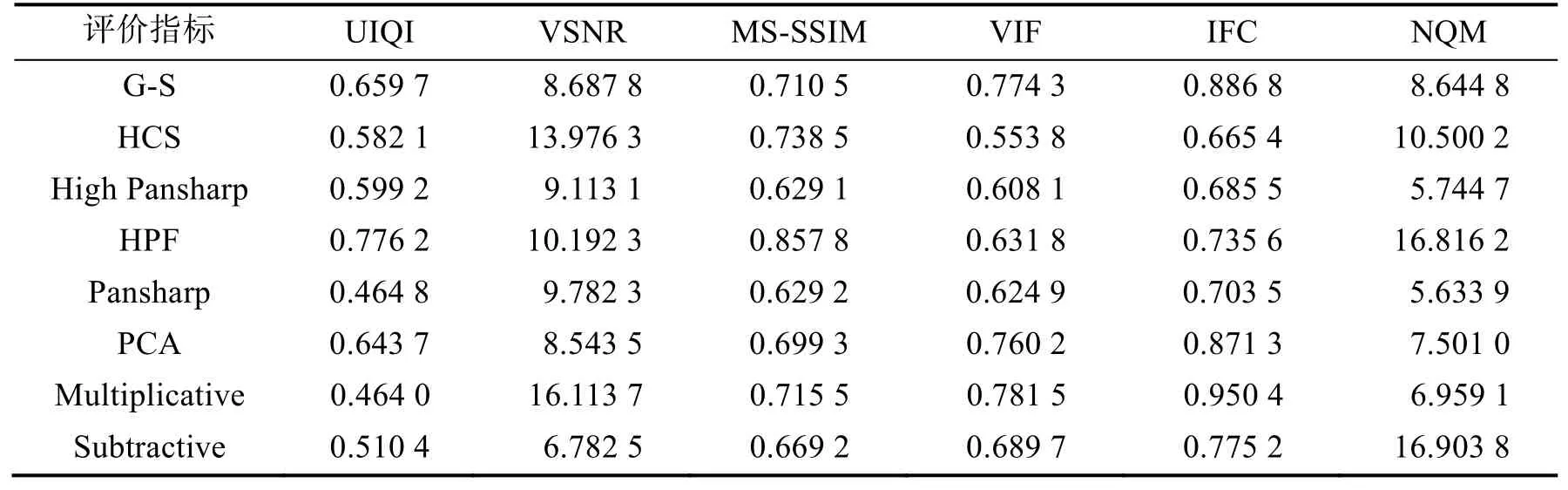

采用UIQI、VSNR、MS-SSIM、VIF、IFC、NQM六种基于全参考客观评价指标对融合结果进行评价。由于受篇幅限制,本文只列出每种方法的平均值,见表2。

表1 主观评价得分Tab. 1 The scores of subjective evaluation

表2 客观评价指标值Tab. 2 The value of quality metrics

客观评价认为:

1)MS-SSIM、VIF、UIQI三个指标值范围位于0~1之间,值越高代表融合效果越好,理想状态下为1。HPF融合图像的MS-SSIM值最大,达到0.85以上,说明与原多光谱图像具有很好的结构相似度。HCS、Multiplicative、G-S的MS-SSIM值在0.7~0.8之间,其余融合图像位于0.6以下。VIF指标方面,Multiplicative融合图像的VIF值在0.78以上,效果最佳;G-S方法次之,HCS方法最差;其余方法的VIF值位于0.54~0.76之间。HPF融合图像的UIQI值是所有方法中的最大值,达到0.77以上。G-S与PCA融合图像的UIQI指标次之,位于0.6~0.7之间,其余方法UIQI值在0.5以下。

2) IFC、VSNR与NQM值最小为0,值越大,说明基于对比度与互信息的视觉质量越好。Multiplicative融合图像IFC值最大,达到0.95以上;G-S、PCA、Subtractive、HPF、Pansharp融合图像的IFC值在0.70~0.89之间依次下降;High Pansharp、HCS融合图像的IFC值最小在0.7以下。Multiplicative融合图像的VSNR值最高达到16以上,HCS次之;HPF方法的VSNR值达到10,Pansharp、High Pansharp、G-S、PCA、Subtractive融合图像的VSNR依次变小。Subtractive与HPF融合方法的NQM值达到16以上,Pansharp方法的NQM值最低,其余方法图像的NQM值居中。

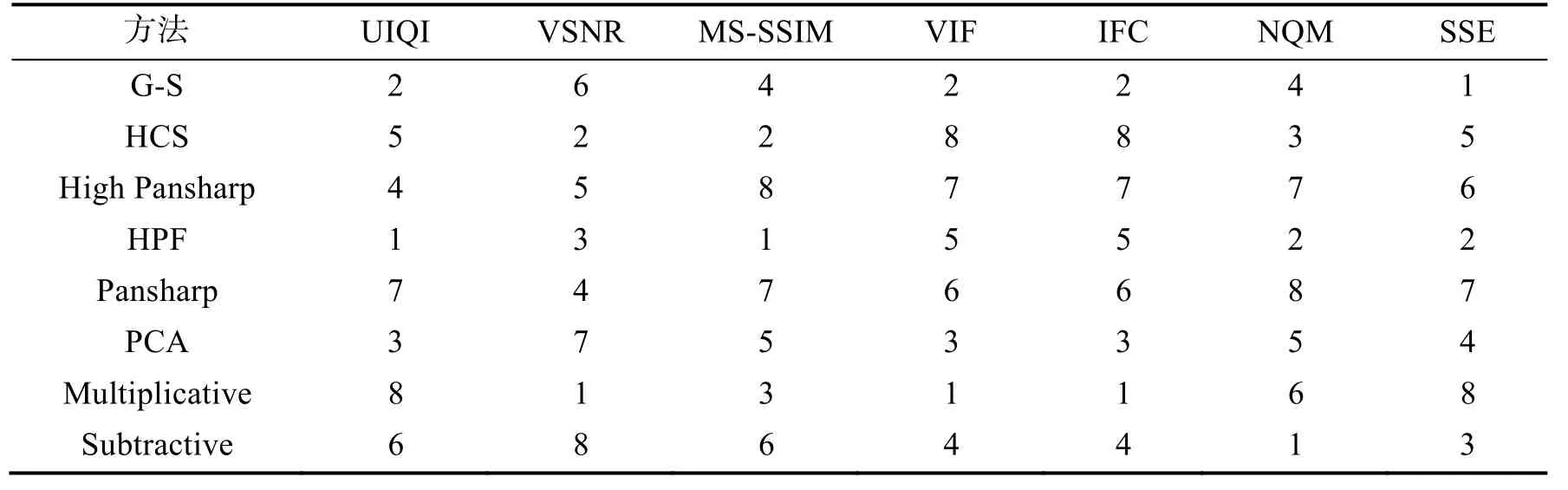

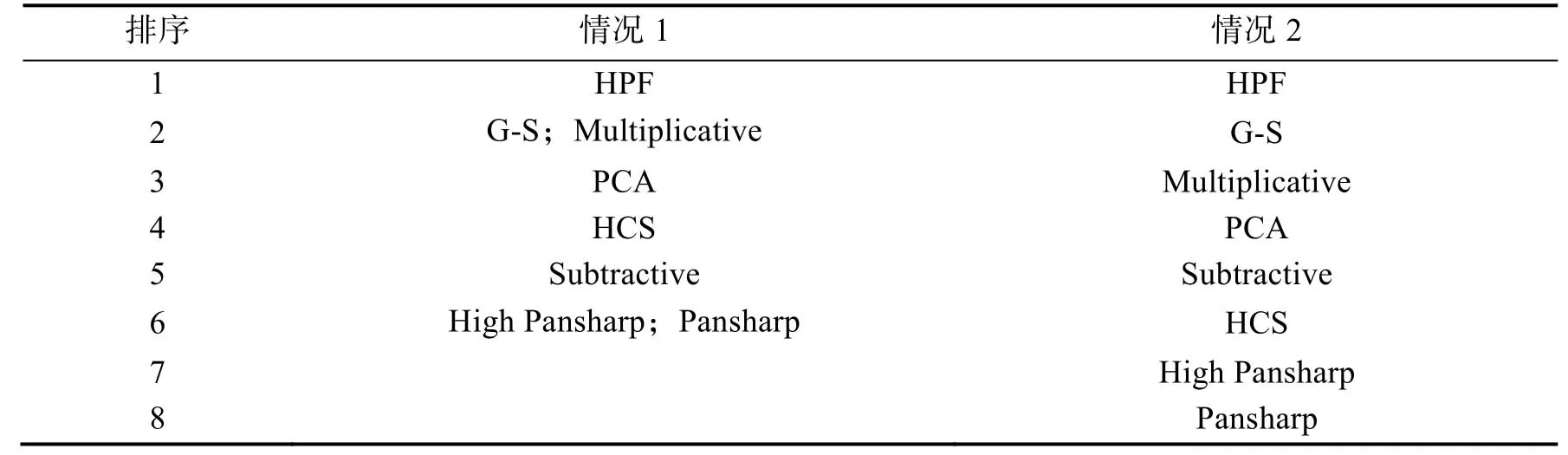

以上客观评价不能找出最佳融合方法,因为一个指标仅表达图像在某一方面的质量,评价指标不同,融合效果也不同,故对这些指标值进行标准化。本文采用MOS平均观察分数进行排序,客观评价与主观评价指标排序如表3所示,融合方法排序如表4所示。

表3 客观评价与主观评价指标分数值Tab. 3 The scores for fusion methods based on quality metrics and subjective evaluation

由表4可知,不管是否考虑主观评价,得出的最佳融合方法都是HPF方法。客观评价中G-S与Multiplicative方法,High Pansharp与Pansharp方法分别并列第二、第六,而在主客观综合评价中,无并列现象,并知Pansharp融合效果在八种方法中效果较差。此外,两种情况下各个方法优劣顺序稍微变动,说明主、客观评价的大体趋势是一致的。之所以会出现差异,是因为人眼虽能对图像有视觉上的整体辨别,但不能对噪声、信息量及结构相似度等方面做出定量评价。

表4 融合方法排序Tab. 4 The ordering of fusion methods

5 结束语

本文采用常见的八种融合方法,对我国最新发射的GF-2卫星全色图像与多光谱图像进行融合试验,并对其进行了主观、客观评价。结果表明:

1)本文突破常规基于光谱信息、空间信息与对比度等方面的客观评价,采用了基于全参考并充分考虑人类视觉系统参与的图像质量评价方法,并对融合图像做出了正确的评价。

2)GF-2卫星图像融合综合效果最佳的融合方法是HPF方法,这与前人相关研究结果是一致的。通过不同角度的综合评价,发现没有一种方法同时最大程度地保持光谱信息与增加空间信息。如HPF融合方法虽然很好地保留了原始多光谱信息,但目视观察发现空间信息的增加程度不是最好的,以致边界出现轻微“双眼皮”现象。

3)本文中没有考虑各个客观评价指标各自的权重大小,在未来研究中需根据各自指标在其评价中的意义大小赋予权重,然后对其做出评价。

References)

[1] DAILY M I. Geologic Interpretation from Composited Radar and Landsat Image [J]. Photogrammetric Engineering and Remote Sensing, 1979, 45(8): 1109-1116.

[2] BURT P J. Multiresolution Image Processing and Analysis [M]. Berlin: Springer-verlag, 1984: 6-35.

[3] CHAVEZ P S Jr, SLIDES S C, ANDERSON J A. Comparison of Three Different Methods to Merge Multiresolution Data: Landsat TM and SPOT Panchromatic[J]. Photogrametry Engineering and Remote Sensing, 1991, 57(3): 295-303.

[4] LI H, MANJUNATH B S, MITRA S K. Multisensor Image Fusion Using the Wavelet Transforms [J]. Graphical Models and Image Processing, 1995, 57(3): 235-245.

[5] 冯建辉. 遥感影像融合技术研究[D]. 昆明: 昆明理工大学, 2009: 7-62. FENG Jianhui. Study on the Technology of Remote Sensing Fusion [D]. Kunming: Kunming University of Science and Technology, 2009: 7-62. (in Chinese)

[6] 孙丹峰. IKONOS全色与多光谱数据融合方法的比较研究[J]. 遥感技术与应用, 2002, 17(1): 41-45. SUN Danfeng. Study on Fusion Algorithms of IKONOS PAN and Multi-spectral Images [J]. Remote Sensing Technology and Application, 2002, 17(1): 41-45. (in Chinese)

[7] 马一薇. 高光谱遥感图像融合技术质量评价方法研究[D]. 郑州: 解放军信息工程大学, 2010: 7-54. MA Yiwei. Research on Hyper Spectral Remote Sensing Image Fusion and Quality Evaluation Method [D]. Zhengzhou: The PLA Information Engineering University, 2010: 7-54. (in Chinese)

[8] 凌飞龙. SAR图像去噪及多源遥感数据融合算法研究[D]. 福建: 福州大学, 2004: 12-58. LING Feilong. The Study on SAR Image Speckle Suppression and Multi-sensor Image Fusion [D]. Fujian: Fuzhou University, 2004: 12-58. (in Chinese)

[9] 贾永红. TM和SAR影像主分量变换融合法[J]. 遥感技术与应用, 1998, 13(1): 46-49. JIA Yonghong. Fusion of Landsat TM and SAR Images based on Principal Component Analysis [J]. Remote Sensing Technology and Application, 1998, 13(1): 46-49. (in Chinese)

[10] 曹建君. 航空影像和TM影像融合及应用研究[J]. 遥感技术与应用, 2002, 17(6): 394-397. CAO Jianjun. Study on Fusion of Aerial and TM Image and its Application [J]. Remote Sensing Technology and Application, 2002, 17(6): 394-397. (in Chinese)

[11] 王忠武, 刘顺喜, 戴建旺, 等.“高分二号”卫星多光谱与全色影像配准策略[J]. 航天返回与遥感, 2015, 36(4): 48-53. WANG Zhongwu, LIU Shunxi, DAI Jianwang, et al. Registration Strategy for GF-2 Satellite Multispectral and Panchromatic Images [J]. Spacecraft Recovery & Remote Sensing, 2015, 36(4): 48-53. (in Chinese)

[12] 童庆禧, 张兵, 郑兰芬. 高光谱遥感——原理、技术与应用[M]. 北京: 高等教育出版社, 2006. TONG Qingxi, ZHANGBing, ZHENG Fenlan. Hyperspectral Remote Sensing [M]. Beijing: Higher Education Press, 2006. (in Chinese)

[13] LABEN C A, BERNARD V, BROWER W. Process for Enhancing the Spatial Resolution of Multispectral Imagery Using Pan-Sharpening: US6011875 [P]. 1998-04-29.

[14] PADWICK C, DESKEVICH M, PACIFICI F, et al. WorldView-2 Pan-sharpening[C]. ASPRS 2010 Annual Conference, San Diego, California, 2010.

[15] SCHOWENGERDT R A. Reconstruction of Multispatial, Multispectral Image Data Using Spatial Frequency Content [J]. Photogrammetric Engineering and Remote Sensing. 1980, 46(10): 1325-1334.

[16] ZHANG Yun. A New Automatic Approach for Effectively Fusing Landsat 7 as well as IKONOS Images [C]. 2002 IEEE International Geoscience and Remote Sensing Symposium. Toronto: IEEE International, 2002.

[17] ZHANG Yun. Problems in the Fusion of Commercial High-resolution Satellite Images as well as Landsat 7 Images and Initial Solutions [C]//Proceedings of the International Society for Photogrammetry and Remote Sensing, Ottawa, 2002.

[18] CRIPPEN R E. A Simple Spatial Filtering Routine for the Cosmetic Removal of Scan-line Noise from Landsat TM P-Tape Imagery [J]. Photogrammetric Engineering and Remote Sensing, 1989, 55(3): 327-331.

[19] ASHRAF S, BRABYN L, HICKS B J. Alternative Solutions for Determining the Spectral Band Weights for the Subtractive Resolution Merge Technique [J]. International Journal of Image and Data Fusion, 2013, 4(2): 105-125.

[20] 王治中, 张庆君.“资源一号”02C卫星PMS数据融合方法比较研究[J]. 航天返回与遥感, 2015, 36(5): 83-95. WANG Zhizhong, ZHANG Qingjun. Study of Fusion Methods of ZY-1-02C Satellite PMS Data [J]. Spacecraft Recovery & Remote Sensing, 2015, 36(5): 83-95. (in Chinese)

[21] WANG Zhou, BOVIK A C, SHEIKH H R, et al. Image Quality Assessment: from Error Visibility to Structural Similarity [J]. IEEE Trans on Image Processing, 2004, 13(4): 600-612.

[22] SHEIKH H R, BOVIK A C. Image Information and Visual Quality [J]. IEEE Transactions on Image Processing, 2006, 15(2): 430-444.

[23] WANG Z, BOVIK A C. A Universal Image Quality Index [J]. IEEE Signal Process Letters, 2002, 9(3): 81-84.

[24] CHANDLER D M, HEMAMI S S. VSNR: A Wavelet-based Visual Signal-to-noise Ratio for Natural Images [J]. IEEE Transactions on Image Processing, 2007, 16(9): 2284-2298.

[25] WANG Z, SIMONCELLI E P, BOVIK A C. Multi-scale Structural Similarity for Image Quality Assessment [C]. Proceedings of the 37th IEEE Asilomar Conference on Signals, Systems and Computers. Pacific Grove, 2003.

[26] SHEIKH H R, BOVIK A C, VECIANA G. An Information Fidelity Criterion for Image Quality Assessment Using Natural Scene Statistics [J]. IEEE Transactions on Image Processing, 2005, 14(12): 2117-2128.

[27] DAMERA-VENKATA N, KITE T D, GEISLER W S, et al. Image Quality Assessment based on a Degradation Model [J]. IEEE Transactions on Image Processing, 2000, 9(4): 636-650.

[28] ANIRUDDHA GHOSH, JOSHI P K. Assessment of Pan-sharpened Very High-resolution WorldView-2 Images [J]. International Journal of Remote Sensing, 2013, 34(23): 8336-8359.

Image Fusion Quality Assessment of GF-2 Satellite Based on Full Reference

MENG Fanxiao CHEN Shengbo ZHANG Guoliang

(College of Geo-exploration Science and Technology, Jilin University, Changchun 130026, China)

The image fusions of panchromatic image and multispectral image provided by GF-2 satellite which is the first Chinese sub-meter satellite, are produced by using eight image fusion methods, and estimated in the objective rating and subjective evaluation. In order to consider the performance of the human visual system, the paper chooses six classical indicators based on full reference image quality assessment as the objective evaluation indices for Changchun urban area fusion images, including universal image quality index, visual signal-to-noise ratio, multi-scale structure similarity, visual information fidelity criterion, information fidelity criterion and noise quality measure. The results show that eight fusion algorithms can to some extent improve the spatial information and keep the original spectrum information as well for GF-2 images. The effect of HPF fusion method is the best and the Gramm-Schmidt fusion method is the second. The effects of Multiplicative fusion method, PCA fusion method, Subtractive fusion method, HCS fusion method, and High Pansharp fusion method are decreased by the mentioned order, with the effect of Pansharp fusion method being the worst.

image fusion; human visual system; full reference image quality assessment; GF-2 satellite

TP751

A

1009-8518(2016)06-0085-10

10.3969/j.issn.1009-8518.2016.06.010

孟凡晓,女,1990年生,2013年获东北林业大学地理信息系统专业学士学位,现在吉林大学地图学与地理信息系统专业攻读硕士学位。研究方向为遥感数据处理及定量遥感、高分数据应用。E-mail:mengfx1030@163.com。

(编辑:王丽霞)

2016-05-03

中国地质调查局项目“航空高光谱遥感调查”(12120113072901)