机器人智能抓取系统视觉模块的研究与开发*

2016-02-07张为民1brgenFleischer

叶 卉,张为民,1b,张 欢,Jürgen Fleischer

(1.同济大学 a.机械与能源工程学院; b.中德学院; c.先进制造技术中心, 上海 201804;2.卡尔斯鲁厄理工学院 生产技术研究所, 德国 卡尔斯鲁厄 76131)

机器人智能抓取系统视觉模块的研究与开发*

叶 卉1a,张为民1a,1b,张 欢1a,Jürgen Fleischer1c,2

(1.同济大学 a.机械与能源工程学院; b.中德学院; c.先进制造技术中心, 上海 201804;2.卡尔斯鲁厄理工学院 生产技术研究所, 德国 卡尔斯鲁厄 76131)

以ABB机器人、快换手爪、双目相机为硬件基础,搭建了基于双目立体视觉的工业机器人智能抓取系统,旨在实现随机放置物体的识别定位和自动抓取。基于视觉模块,研究了图像处理、立体匹配和深度计算以及坐标转换,以C++为开发平台,结合OpenCV图像开发库和Triclops库,开发了视觉识别与定位算法,实现对圆柱体和长方体薄板对象的分类和位姿识别。最后,通过实验验证,表明该视觉算法有较高的识别定位精度,满足抓取系统的要求。

工业机器人;机器视觉;智能抓取;立体匹配;坐标转换

0 引言

随着“中国制造2025”战略口号的提出,机器人在生产制造领域的应用越来越广泛。工业机器人自身可实现复杂动作的自动化,但难以实现自适应作业的自动化[1]。在装配、分拣、搬运和码垛等工业环境中,机器人的应用大多停留在示教阶段,机器人与人、与环境之间的交互不够,机器人的感知能力较差,这种情况下单一的机器人作业往往只能应对结构化环境,早已不能满足现代生产对柔性化和智能化的要求。

“中国制造2025”的核心就是以智能制造为主攻方向,对于工业机器人智能化研究来说,从工作场景中识别并抓取指定物体是其一大热点,其关键技术就在于识别并提取目标物体相对于机器人的位姿[2]。机器视觉技术在目标识别和目标位姿求取方面具有强大的技术优势,它具有信息量大、精度高、非接触测量、响应快速等特点[3],可以快速自动处理大量信息, 并且易于与控制信息实现集成。同时将机器视觉技术与机器人技术结合,通过对机器人操作对象及其所处环境的智能化处理,从一定程度上降低了对对象的具体要求,使机器人能更好地适应非结构化的环境,从而提高了工业机器人系统的智能化程度。

目前,应用机器视觉的机器人系统的主要搬运对象是形状规则的扁平物体,此类系统多采用配有吸盘式末端执行器的工业机器人[4-8],搬运对象相对局限;且摄像机多采用单目相机,固定在物体上方,视觉研究多是基于二维图像层面。本文初步建立了智能抓取系统的系统架构,并针对机器人智能抓取系统视觉模块的关键技术进行研究。本文构建的机器人智能抓取系统,使用ABB六轴串联工业机器人,和SCHUNK的气动手爪以及快换夹具,能够实现对不同对象的处理操作。系统采用双目相机开发视觉模块,通过边缘特征将目标识别出来,基于立体视觉的视差原理完成对空间三维物体的空间定位[9-10],并通过上位机实现智能抓取过程的控制。

1 智能抓取系统整体设计

本文构建的智能抓取系统架构如图1所示。视觉模块作为智能抓取系统的感知模块,主要获取系统需要处理的对象信息,并将信息传递给上位机,例如类型和位姿信息,从而解决了处理对象“是什么”和“在哪儿”的问题;机器人结合末端执行器,作为抓取操作的执行模块,完成智能抓取系统的快速换爪和抓取搬运操作;各类传感器的引入,例如力传感器、位置传感器,可以对末端手爪的开合位置和抓取力进行监控,并反馈给机器人控制器;上位机集成各模块,并对各模块起决策作用,控制机器人根据视觉模块的处理结果智能选择合适的末端执行器,并对物料采取对应的动作响应处理。本文根据机器人智能抓取系统对视觉模块的要求,重点研究视觉平台的搭建和视觉处理算法的开发。视觉模块自身和机器人的运动控制过程相对独立,通过上位机集成控制,因而视觉模块可以快速集成到现有的工业机器人系统中。

图1 智能抓取系统原理

如图2所示为机器人智能抓取系统的硬件结构,系统采用CCD相机进行图像拍摄,通过图像采集卡采集图像信息,气动快换手爪装在机器人末端并作为抓取动作的执行机构,用上位机集成控制,同时配备光源等辅助设备。

图2 智能抓取系统硬件结构图

2 视觉模块硬件平台

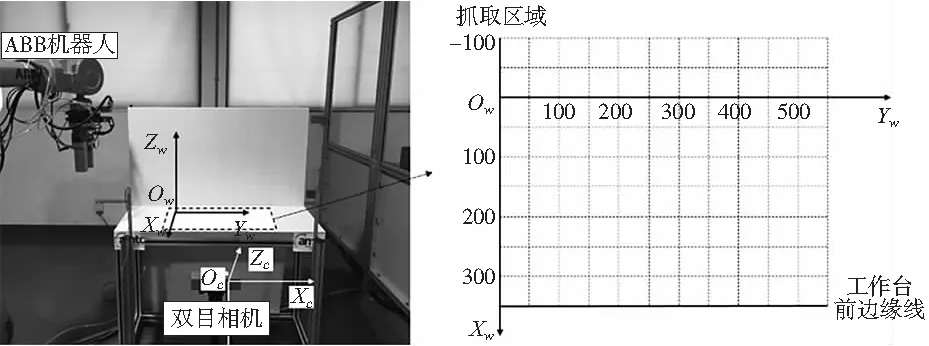

本文机器人智能抓取系统平台搭建在同济大学先进技术制造中心实验室,机器人所处环境周围受自然光影响较大,识别物体为圆柱体和长方体薄板工件。机器人智能抓取系统视觉模块的硬件平台如图3所示。相机选用Point Grey 公司的BB2双目立体相机,置于工作台前侧,距离工作台前端面1m,距地面高度85mm,稍高于工作台平面;LED条形光源随支架置于工作台两侧,与工作台前端面约成45°角放置;机器人型号为ABB-IRB4600,在工作台右前方;快换手爪的支架置于工作台右后侧。

图3 机器人智能抓取系统视觉模块平台布局

3 视觉模块软件开发

视觉模块是整个系统的核心,机器人准确而稳定地抓取依赖于视觉算法的精确处理。视觉算法基于C++平台开发,使用的开发包有Point Grey research公司BB2系列相机基于图像获取和3D识别的开发包——FlyCapture2和Triclops Stereo Vision SDK及图像处理开源库——OpenCV。

如图4所示为软件算法的视觉处理流程,双目相机首先同时拍摄同一场景左右两副图像,调用标定信息并进行矫正畸变获得矫正后的图像,矫正后图像经过立体匹配获得匹配点,再进行相关计算得到整个场景的深度信息,供后续处理调用;另一方面,矫正后图像经过滤波降噪等预处理后,提取包含目标的感兴趣区域(ROI),ROI图像经过图像分割处理得到目标轮廓,再经过特征计算得到相机坐标系下的目标位姿,继而通过坐标转换得到机器人坐标系下目标的三维信息,至此完成视觉模块目标识别和定位的任务。

图4 视觉处理流程

3.1 立体匹配

立体匹配是实现空间立体测量的基础,它是通过对所选特征进行计算从而建立特征之间的对应关系,将同一个空间物理点在不同图像中的映像点对应起来的过程。建立立体匹配由三个基本步骤组成[11]:①从立体图像对中的一幅图像中选择与实际物体结构相应的图像特征;②在另一幅图像中确定出同一物理结构的对应图像特征;③确定这两个特征之间的相对位置,得到视差。

立体匹配的关键在于建立相关性,这里使用绝对偏差和的方法,其原理是:在遍历参照图中每一个像素后,按照给定的正方形尺寸选择一个邻域,将这个邻域沿着同一行与另一幅图像中的一系列邻域相比较,据此找到最佳的匹配。

邻域的比较方法如下面的公式所示:

(1)

其中,dmin和dmax是最小和最大视差;m是模板尺寸;Ileft和Iright是右面的图像和左面的图像;x和y是图像平面的坐标。

3.2 深度确定

建立图像间的特征匹配后即可根据相机的结构参数通过计算恢复目标场景的三维信息。

本系统采用的双目立体相机两镜头光轴沿Z向平行,焦距相同,可以完成立体视觉空间测量的任务。如图5所示,设两镜头在同一时刻观看空间物体的同一特征点P(xc,yc,zc),分别在左、右镜头上获取了点P的图像,其图像坐标分别为pl=(Xl,Yl),pr=(Xr,Yr)。现两摄像机的图像在同一个平面上,则特征点P的图像坐标Y坐标相同,即Yl=Yr=Y,则由三角几何关系可得:

(2)

图5 双目立体视觉示意图

其中,d=Xl-Xr,为视差;f为相机焦距;B为基线距。

设图像坐标u=Xl,v=Y,由式(2)可得空间点的三维坐标计算公式:

(3)

确定两图像平面所有的匹配点并进行相关计算,即可得到整副图像各个匹配点的三维信息,恢复场景3D信息并保存成深度图像。

3.3 ROI提取

对预处理后的图像提取目标所在的区域,去除背景和平台边缘所在部分,可以专注和简化工作过程,有效减少后续特征提取的工作量,提高图像处理的实时性。本文采用表示矩形区域的Rect,通过指定矩形的左上角坐标和矩形的长宽定义一个矩形区域——即ROI。实际操作时,可根据对象对ROI区域范围进行调整。

3.4 图像预处理

由于实验室环境特殊性,机器人所在区域受外界自然光照影响较大,即便使用了合适的光源,原始图像也不适合直接进行特征处理操作,因此,本文采用的预处理算法可根据当前的光照环境对图像各参数进行调整,使目标特征更加易于提取,将原始图像变成适合计算机进行特征提取的形式。系统以ROI图像为输入,基于像素处理,图像先后经过双边滤波降噪、直方图均衡化、亮度和对比度调节等处理,得到易于特征提取的图像。

3.5 图像分割

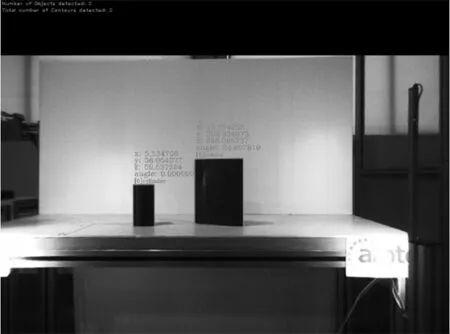

图像分割就是把图像分成若干个特定的、具有独特性质的区域,并提取出需求目标的技术。本文首先使用Canny边缘检测[12]提取出图像中物体的边缘特征,再通过腐蚀膨胀处理得到精确的闭合轮廓。由于抓取对象的形状和大小已知,因此通过设置相关参数,可以将任务规定机器人要抓取的对象从工作区域的其他非抓取目标中分割出来,实现目标的识别,由闭合轮廓的数量可以实现目标的数量识别。图像分割效果如图6所示。

图6 图像分割的效果

3.6 特征计算

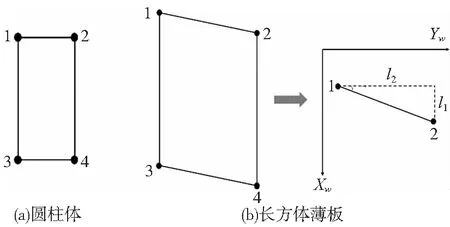

获取目标在三维空间的精确位姿是实现机器人准确抓取的关键。本文以圆柱体和长方体薄板两种类型工件作为例进行分析。经过图像分割获取对象的闭合轮廓后,基于两种类型对象的尺寸特征进行分类,进而根据对象的几何特征计算其位姿。如图7所示,对于圆柱体工件,由于旋转体不存在姿态信息,只需得到其中心点的位置信息。根据图像分割得到的矩形轮廓的顶点信息,取四个顶点坐标的平均值即可得到圆柱体工件的中心坐标。

(4)

图7 目标轮廓示意图

对于长方体薄板,由于放置角度的不同,其质心计算公式与圆柱体相同,从ZW负方向看过去薄板的边与YW轴正向的夹角为α其计算方法如下(α角以YW轴正向转向XW轴正向为正):

(5)

(6)

如图8所示,通过特征计算实现对圆柱体和长方体薄板工件的分类的位姿信息的获取。

图8 视觉识别定位结果

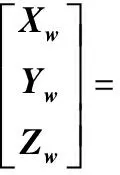

3.7 坐标转换

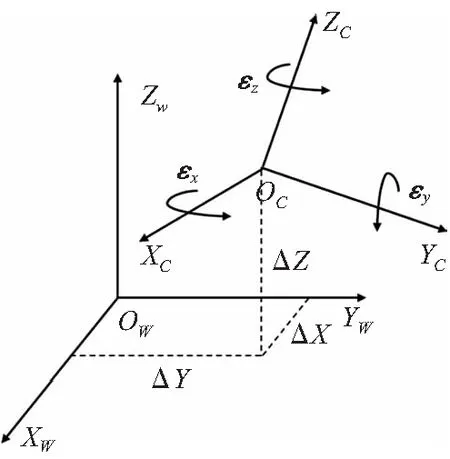

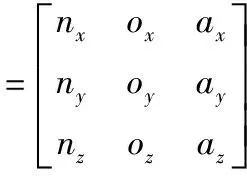

在本文系统相机固定方式采用eye to hand系统[13]。如图9所示,首先在ABB机器人系统中,以物料工作台为参考面建立工件坐标系wobj_user,其中XW-YW平面与桌面平行,ZW垂直于桌面正方向朝上;以快换系统法兰盘中心点为TCP点建立工具坐标系tool_sws。建立坐标系操作通过示教控制器实现。ABB机器人的运动路径控制可以通过描述工具坐标系的TCP点在工件坐标系中的位置实现,因而坐标转换需要标定工件坐标系wobj_user与相机坐标系的转换关系,即转换矩阵HFZ(〗WTBX〗wc。

图9 系统坐标系示意图

如图9所示,两个空间坐标系为工件坐标系OW-XWYWZW和摄像机坐标系OC-XCYCZC,两坐标系间存在三个平移参数△X、△Y、△Z和三个旋转参数εx、εy、εz。同一点在两个坐标系中的坐标分别是(XW,YW,ZW),和(XC,YC,ZC)。两坐标系可通过坐标轴的平移和旋转变换成为一致,坐标间的转换关系为:

(7)

图10 坐标转换示意图

其中,λ为两坐标系间的比例因子,称R为旋转矩阵,与三个旋转参数有关,可以化为一个3×3矩阵(独立参数只有3个),T为平移矩阵。

本文采用基于罗德里格矩阵的坐标转换方法[14],通过采集四套公共点坐标,即可求得现有硬件布局下的坐标转换关系。

4 实验

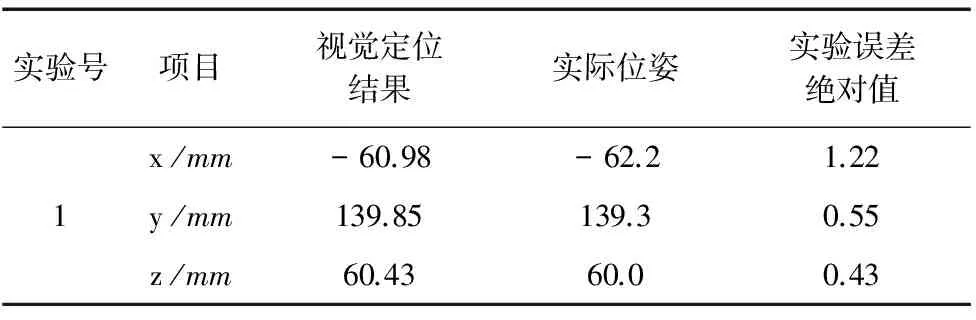

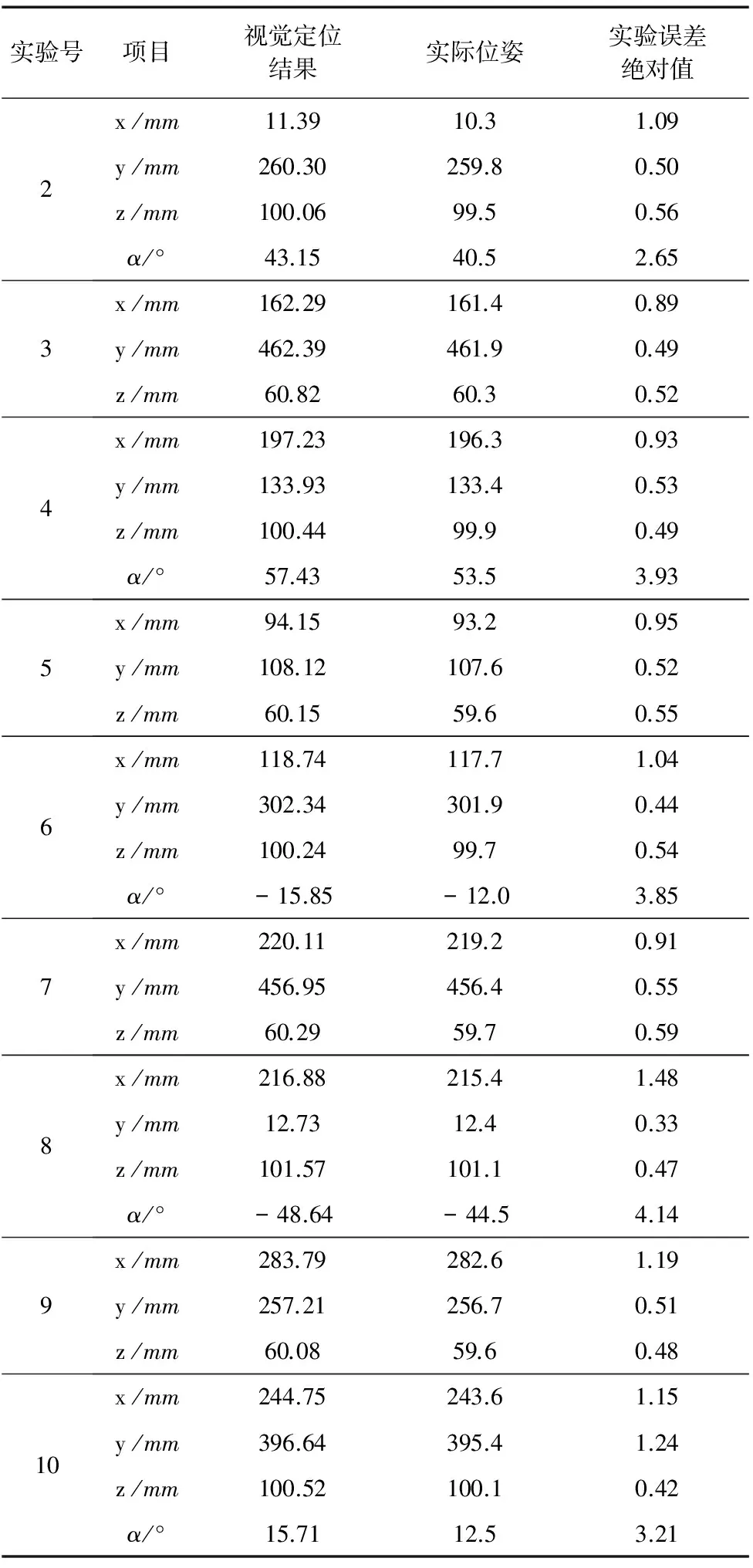

如图11所示,完成硬件设备连接,将双目相机固定好。将圆柱体和长方体薄板工件随机摆放在抓取区域不同位置,启动视觉程序,如图8所示,程序可准确识别工件种类。并且得到10组视觉定位数据,视觉定位结果取小数点后两位记录,如表1所示,其中奇数组为圆柱体工件,偶数组为长方体薄板工件。

图11 视觉实验布局

实验号项目视觉定位结果实际位姿实验误差绝对值1x/mmy/mmz/mm-60.98139.8560.43-62.2139.360.01.220.550.43

续表

实验号项目视觉定位结果实际位姿实验误差绝对值2x/mmy/mmz/mmα/°11.39260.30100.0643.1510.3259.899.540.51.090.500.562.653x/mmy/mmz/mm162.29462.3960.82161.4461.960.30.890.490.524x/mmy/mmz/mmα/°197.23133.93100.4457.43196.3133.499.953.50.930.530.493.935x/mmy/mmz/mm94.15108.1260.1593.2107.659.60.950.520.556x/mmy/mmz/mmα/°118.74302.34100.24-15.85117.7301.999.7-12.01.040.440.543.857x/mmy/mmz/mm220.11456.9560.29219.2456.459.70.910.550.598x/mmy/mmz/mmα/°216.8812.73101.57-48.64215.412.4101.1-44.51.480.330.474.149x/mmy/mmz/mm283.79257.2160.08282.6256.759.61.190.510.4810x/mmy/mmz/mmα/°244.75396.64100.5215.71243.6395.4100.112.51.151.240.423.21

由实验结果可知,在实验区域内,工件坐标系x方向即相机深度x方向误差在1.5mm以内,y和z方向误差在0.6mm以内,长方体薄板的摆放角度误差在5°以内,精度较高,满足智能抓取系统对位置精度的定位要求。相对于现有制造工业中应用较广泛的单目相机,往往固定在物体正上方特定高度,深度信息固定,本系统采用的双目相机可以获取深度随机的目标的三维信息,并且可以得到较高的定位精度。

5 结束语

本文搭建了一个视觉识别平台,结合立体视觉技术,实现对圆柱体和长方体薄板的识别和位姿信息提取。基于视觉程序的模块流程化结构,能实现不同环境、不同对象条件下视觉算法的快速更新;同时,视觉处理流程清晰,通用性好,具有较高的定位精度。另一方面,视觉模块的控制和机器人的运动控制独立开,由上位机集成控制,便于视觉模块的移植和开发。由此可见,视觉技术的引入有效提高了机器人的灵活性和适应性,以及抓取作业的稳定性、快速性和准确性。

[1] 金桂根, 穆建军. 视觉识别机器人在物流作业中的智能应用[J]. 制造业自动化, 2013(11):103-105.

[3]BatchelorBG,Maschine.MachineVisionHandbook, 3Vols.[M].Berlin:Springer, 2010.

[4] 游素亚. 立体视觉研究的现状与进展[J]. 中国图象图形学报, 1997,2(1):17-24.

[5]XuL,HeX,LiX,etal.Amachine-visioninspectionsystemforconveyingattitudesofcolumnarobjectsinpackingprocesses[J].Measurement, 2016, 87: 255-273.

[6]TsarouchiP,MichalosG,MakrisS,etal.VisionSystemforRoboticHandlingofRandomlyPlacedObjects[J].ProcediaCirp, 2013, 9(4):61-66.

[7] 翟敬梅, 董鹏飞, 张铁. 基于视觉引导的工业机器人定位抓取系统设计[J]. 机械设计与研究, 2014,30(5):45-49.

[8] 晏祖根, 李明, 徐克非,等. 高速机器人分拣系统机器视觉技术的研究[J]. 包装与食品机械, 2014,32(1):28-31.

[9]YangY,GaoM,ZhangJ,etal.Depthmapsuper-resolutionusingstereo-vision-assistedmodel[J].Neurocomputing, 2015, 149:1396-1406.

[10]GordonI,LoweDG.WhatandWhere: 3DObjectRecog-nitionwithAccuratePose[C]//TowardCategory-LevelObjectRecognition,2006:67-82.

[11]ComlekcilerIT,GunesS,IrginC,etal.Measuringtheoptimumluxvalueformoreaccuratemeasure-mentofstereovisionsystemsinoperatingroomofOrthognathicsurgery[C]//Electronics,ComputerandComputation, 2014:1-6.

[12]CannyJ.AComputationalApproachtoEdgeDetection[J].PatternAnalysis&MachineIntelligenceIEEETransactionson, 1986,PAMI-8(6):679-698.

[13]FlandinG,ChaumetteF,MarchandE.Eye-in-hand/eye-to-handcooperationforvisualservo-ing[J].IEEEInt.conf.onRobotics&Automation, 2000, 3: 2741-2746.

[14]YuanYL,JiangLX,LiuLJ.ApplicationsofLodriguesmatrixincoordinatestransformation[J].ScienceofSurveying&Mapping, 2010, 35(2): 178-177.

(编辑 李秀敏)

Development of Intelligent Robot Grasping System Based on Machine Vision

YE Hui1a, ZHANG Wei-min1a,1b, ZHANG Huan1a, Jürgen Fleischer1c,2

(1 a.School of Mechanical Engineering, b.Chinese-German College for Postgraduate Studies, c.Advanced Manufacturing Technology Center, Tongji University, Shanghai 201804, China;2. Institute of Production Science, Karlsruhe Institute of Technology, Karlsruhe 76131, Germany)

With ABB industrial robot, quick-change gripper, and binocular Camera being as hardware foundation, this paper develops an intelligent industrial robot grasping system based on binocular stereo vision,aiming at the recognition, location and automatic grasping of randomly placed objects. Based on the vision module, the principles of camera calibration, coordinate transformation, image processing and stereo matching are researched, and based on C++, visual recognition and location algorithm is developed combined with OpenCV library and Triclops SDK, and the vision module can realize objects classification and pose recognition of cylinder and rectangular plate. Finally experiments are carried out to validate that the vision module can recognize cylindrical and rectangular plate objects successfully, and the positioning accuracy can meet the requirements.

industrial robot;machine vision;intelligent grasping; stereo matching;coordinate transformation

1001-2265(2016)12-0001-05

10.13462/j.cnki.mmtamt.2016.12.001

2016-07-20;

2016-08-22

“高档数控机床与基础制造装备”科技重大专项(2012ZX04005031)

叶卉(1992—),女,安徽芜湖人,同济大学硕士研究生,研究方向为机器人视觉,(E-mail)1432527@tongji.edu.cn。

TH166;TG659

A