一种基于区分能力的多类不平衡文本分类特征选择方法

2015-04-21张延祥潘海侠

张延祥,潘海侠

(北京航空航天大学 软件学院,北京 100191)

一种基于区分能力的多类不平衡文本分类特征选择方法

张延祥,潘海侠

(北京航空航天大学 软件学院,北京 100191)

文本分类中的不平衡数据问题在现实应用中比较普遍。传统的特征选择方法在不平衡问题上倾向于多数类而忽略稀有类。针对这种倾向性该文提出了一种主导性分析量化方法,并基于对该方法的优化提出了一种基于类别区分能力的特征选择方法,即DA(Discriminative Ability)方法,该方法使用文档概率的最小绝对值差作为评分标准,一定程度上保证了特征选择在稀有类与多数类上的公平性。实验表明,DA优于CHI、IG、DFICF,尤其在F1宏平均指标上,DA在不平衡问题上能够取得更好的降维效果。

文本分类;不平衡问题;特征选择;主导性分析;区分能力

1 引言

互联网的快速发展使得信息呈现爆发式增长的态势,如何有效管理这些数据成为当前的热点问题。文本分类作为海量数据管理的关键技术,在信息检索、数据挖掘、舆情监测等方面均有着广泛应用。

近年来,基于机器学习的分类方法被应用到文本分类中,取得了很好的效果。但在实际应用中,数据集分布偏斜仍是一个亟待解决的问题[1],尤其在具有高维特点的文本分类问题上。

数据集分布不平衡问题一般是指样本在类别间可能存在数量级的差别,在这种情况下,样本无法准确地反映整个空间的类别分布,特征降维方法与分类算法都倾向于被大类主导而忽略小类,是导致分类效果不理想的重要因素。有很多种策略可以对不平衡问题进行改进,如重采样技术、新的分类策略、更好的效果评估方法等[1]。本文从特征选择的角度出发,针对不平衡问题下的特征选择方法存在的缺陷进行改进。

特征选择是文本分类的重要步骤,直接影响到模型的构建与分类的性能,因而通过改进特征选择方法来解决不平衡问题是可行的。特征选择方法应用于分类问题上有很多优势,比如分类模型的快速构建、减小过拟合的概率、降低内存与硬盘的占用、提高处理速度等;劣势在于可能会过滤掉一些重要的特征,降低分类效果[2]。

本文对不平衡数据集下特征选择方法的特点进行了研究,分析了如下两个问题。

a) 不平衡数据集下特征选择方法倾向于被大类主导而忽略小类,如何定义与量化“主导”?

b) 如果存在着一种可以较好地解决不平衡问题的特征选择方法,那么该方法会有什么样的特点?

针对以上问题进行研究后,本文提出了一种基于区分能力的特征选择方法,一定程度上符合本文对问题b的解答,实验表明,该方法在不平衡问题上达到了比传统特征选择方法更好的分类效果。

本文的其余内容安排如下,第2节对特征降维尤其是特征选择方法的研究成果进行了介绍;第3节对不平衡问题的研究现状进行了总结;第4节对不平衡数据集下的特征选择的特点进行了探讨,对主导性进行了定义与量化分析;第5节提出了基于区分能力的特征选择方法;第6节对第4、5节提出的假设与方法进行实验验证;第7节为结论与展望。

2 特征降维

2.1 特征降维方法分类

根据选择特征集合方式的不同,特征降维方法可以分为两类,特征选择和特征抽取。特征选择一般是依据某个准则,从原始特征集合中选取最能反映类别统计特性的特征,即从集合中选择一个子集;特征抽取则是基于特征之间的语义相关性、类别特征集对类内文本聚合程度、类间离散程度的影响力等方面考量而对文本特征集的一种压缩[3]。

常见的特征选择方法包括文档频度(DF)、互信息(MI)、信息增益(IG)、统计量(CHI)、期望交叉熵、文本证据权、几率比等。而常见的特征抽取方法则包括主成分分析、隐含语义索引、非负矩阵分解等。

本文所提出的方法是一种特征选择方法。

2.2 特征选择方法

本节介绍针对主要特征选择方法的研究成果,各个主要特征选择方法的计算公式参考文献[4],本节不再赘述。

自从机器学习技术被成功应用于文本分类以来,针对特征选择方法的研究与改进越来越多且日趋成熟。对特征选择方法的研究主要集中在以下三个方面。

第一,针对各种现有的成熟方法进行性能对比,文献[4]总结了IG、MI、CHI、DF、TS五种特征选择方法的分类性能,发现IG和CHI是较优的特征选择方法,在容许少量性能损失的情况下,DF则有较好的扩展性与计算性能。文献[5]则对100余种特征选择算法的变体进行了比较,得到了CHI效果最好但在低频词上不可信等结论。文献[6]将主要的特征选择方法在中文语料上重新实验,得到了与文献[5]相似的结论,即将CHI与IG等与DF组合形成更好地特征选择方法。

其次,不同于组合传统方法,有些研究将其他原则引入到传统方法中作为改进,也达到了较好的效果。文献[7]将概念特征引入,提出了基于概念屏蔽层的特征选择方法,通过概念统计和语义层次分析的方法,能够更好地利用VSM模型,提高分类效率;文献[8]将最小冗余原则引入,一定程度上避免特征独立假设的不足,提高了分类的效果。

再者,也有些研究直接提出新的特征评价函数,并在实验中证明了其实用性。如文献[9]提出了一种新的基于类间集中度、类内分散度和类内平均频度(CDF)的特征选择方法, 文献[10]则提出了一种用概率分布刻画的基于区分类别能力的特征选择方法的表达形式。

以上研究在文本分类实验中都被证明是有效的,它们虽然都没有考虑到数据集倾斜的情况下的特征选择问题,但改进思想却可以引入到不平衡数据问题上。

3 不平衡问题的研究现状

不平衡问题由来已久,在其他领域有很多应对方法,包括过采样、欠采样、样例加权、分类器阈值调整等方法。文献[11]在二类不平衡文本上将标准的SVM与过采样、欠采样等方法进行了对比,具体参加对比的改进方法为随机采样、基于聚类的欠采样、SMOTE过采样、样例权重、基于F1宏平均的阈值调整;但实验表明这些改进方法均不如标准的SVM算法的分类结果,证明了SVM在两类不平衡问题上的优越性。这并不意味着这些通用技术在不平衡文本分类中完全无用,文献[12]使用基于聚类的欠采样方法训练多个SVM分类器在高维不平衡数据集上达到了比标准SVM更好的效果,一定程度上也可以借鉴到文本分类中。

文献[11]的实验中没有考虑特征选择方法的影响。但在文献[2]中则考虑了在高维不平衡问题上将特征选择与采样方法、样例加权、性能指标整合来解决问题,评估了这些技术对特征选择的影响,其缺点在于其实验是针对特征选择方法的相关性而不是针对不平衡文本分类来设计的,不能证明特征选择方法在这些技术的影响下效果变好。将解决不平衡问题的通用方法如过采样、样例加权等与特征选择函数融合确实是解决不平衡文本分类问题的一个可研究方向,但鉴于这些通用技术在SVM中并没有优越性且与特征函数之间的相关性较为复杂,本文先从在不平衡文本分类问题中改进特征选择入手,将特征函数与通用技术的融合作为后续研究方向。

在实际应用中,即便是均衡文本,特征选择方法也可能会遇到一个陷阱,即过多的提取某些类中具有强预测性的特征,而忽略分类需要的特征[13],即特征选择方法被大类主导。这里需要注意的是,强预测性特征往往有助于分类,但强预测性特征只是可以将某些特定类别区分出来,为了使全局的分类性能更好,分类需要的性能还要包括一些预测性并不强但却能提高强预测性特征覆盖不到的类别的分类性能的特征。为了解决被大类主导的问题,文献[13]提出轮转法在各个类别间选择特征,文献[14]提出将正例和反例按照一定比例融合的方法来达到好的效果。轮转法与比例融合法在平衡数据集下可以达到较好的效果,但当数据集不平衡时却值得怀疑,直观上看,不平衡问题中的各个类别所需的分类特征数目是不相同的,文档数目多的类别会拥有更多的有效分类特征,轮转法达到的特征在类别间的完全均衡会使得多数类的性能降低,而比例融合法在多类不平衡问题下的比例的设定比较复杂,且当训练集与测试集分布不一致时基于训练集中的类别分布设定的比例未必在测试集中有效。

文献[15]则对不平衡问题上的特征选择的改进进行了总结,得出了通过提高稀有类别的准确率来解决不平衡问题的思路,并提出了使用倒转类别频率对特征选择函数如IG等进行加权,在不平衡问题上提升了F1宏平均值。本文提出的特征选择方法客观上也是通过提高稀有类别的准确率来解决不平衡问题,因而在实验中采用文献[15]中的DFICF方法作为与之前研究成果进行比较的基准线。

综上所述,基于特征选择方法改进不平衡文本分类问题主要有以下三个方向。

a) 与不平衡问题的通用解决方法如过采样、样例加权等融合;

b) 使用传统的特征选择方法在各个类别上分别选取特征,按照比例融合;

c) 在特征选择函数中通过提高稀有类别中特征的权重来提高稀有类别的特征的比例,从而提高稀有类别的准确率。

本文提出的特征选择方法正是基于第三个方向的思想,通过特征选择方法使各个类别间的特征数目更加平衡,提高稀有类的性能从而提高整体性能。但前两个方向仍然不失为改进不平衡文本分类问题的研究方向。

4 不平衡数据集下的特征选择的特点分析

文献[13]中提出了特征选择方法容易选取某些类的强预测型特征,而忽略分类需要的特征。在不平衡数据集中,由于稀有类的文档数目少,其特征空间更为稀疏,一方面稀有类的强预测型特征会比多数类要少,一方面稀有类的强预测型特征的预测强度一般也会比多数类要小,使得传统的特征选择方法在不平衡问题下会被多数类所主导,造成选取的特征子集中能够区分稀有类的特征很少,从而导致稀有类在分类过程中准确率低。

在上面的分析中,隐含了一个弱假设,即只有当某个类的强预测型特征被选择,该类才可能被正确的分类。该假设在两类分类中并不成立,因为两类中非此即彼,极端情况下即使全都选择了正类的强预测型特征,在负类中的样例仍然会因为不符合正类的判别条件而被归为负类。但在多类分类中则不如此,尤其是存在多个稀有类的情况时。这也是两类不平衡分类与多类不平衡分类的不同之处,也可能是svm在两类不平衡问题上表现优异的原因。

通过上面的分析,可得到如下推论。

推论1 在保证多数类性能的前提下,越不被多数类主导的特征选择方法,在不平衡文本问题上就越能提高稀有类的准确率,从而提高整体性能。

该推论一般情况下对于单一的特征选择函数成立,当使用轮转法或按比例融合法时不能保证成立,因为本文也假设了在不平衡数据集下多数类与稀有类所需的分类特征数目存在差异,完全的均衡不能保证多数类的性能,整体性能会变差。

使用平均方差对特征选择后的特征子集的主导性进行量化分析,平均方差越大,说明该特征选择方法越被某些类别主导,反之亦然。

下面对主导性平均方差的计算进行定义。

首先,对特征与类别是否存在强预测型关系进行判断,特征的强预测型是指该特征在某个类或某些类中出现频繁而在其他类中较少出现,可以使用特征在某个类中的出现的文档概率或者词频概率来衡量该特征在某个类中的频繁性,本文使用文档概率来衡量,即:

(1)

其中,Count(Ci,tj)表示特征tj在类别Ci中出现的文档数目,|Ci|为类别C的文档数目。

然后,定义特征tj与类别Ci存在强预测性关系的判定条件:

Predict(Ci,tj)=

(2)

式(2)中,k=10,这表示当特征tj与类别Ci的文档概率与特征tj与所有类别的文档概率中的最大值在同一数量级时,认为特征tj与类别Ci存在强预测型关系。

由式(2)可以得到某类中拥有强预测型特征的个数公式:

(3)

式(3)中,n为特征总数。由式(3)可以继续得到平均方差的计算公式,如下:

(4)

使用主导性平均方差对主导性进行量化分析后,根据推论1,可得推论2。

推论2 在保证多数类性能的前提下,使得主导性平均方差越低的特征选择方法,在不平衡文本分类问题上越能提高稀有类的性能,从而提高总体性能。

至此,对引言中的两个问题进行了回答。即主导性的定义与量化问题,不平衡问题下的较好特征选择方法的特点问题。在第5节中,以推论2的论点为指导,提出了一种新的特征选择方法;第6节的实验结果则证明了推论2的正确性以及本文特征选择方法的有效性。

5 基于区分能力的特征选择方法

根据第4节的讨论,本文构造了一种特征选择函数,它能够降低主导性平均方差,从而能较为平衡地在稀有类和多数类之间选取特征,在不降低或较少降低多数类分类性能的前提下,提高稀有类的分类性能。该方法基于区分能力(Discriminative Ability),所以称该方法为DA特征选择法。

DA方法基于两点考虑来降低主导性平均方差。首先,使用文档概率来表示特征与类别的相关程度,使得特征选择避免受到先验分布的影响,特征在稀有类和多数类的相关程度得到相对公平的度量,不会偏向于选择文档数目多的类别的特征。其次,使用最小距离来衡量特征对于某类的区分能力的贡献,使得对区分类别有贡献的特征更容易被选中,弱化了大类强预测型特征的影响。

基于上述考虑,DA方法使用式(1)中所示的文档概率来表示特征与文本类别的相关度,在文献[9]中,文档概率被称为类内分散度。然后利用特征在类别之间的相关程度的差异,计算出特征在各个类别间的区分能力。直观上来看,一个特征词在某个类别上出现的越多,在其他类别中出现的越少,该特征就越能把某类从其他类别中区分出来。

某特征词在某个类别上的区分能力是指该特征在该类上的相关度与该特征在其他类上的相关度的差的最小值,该值越大,该特征区分该类与其他类的能力越大。计算公式如式(5)所示。

(5)

其中,DAjk表示特征tk在类别Cj上的区分能力,min(|P(Cj,tk)-P(Ci,tk)|),i≠j表示DAjk是文档概率P(Cj,tk)与最接近P(Cj,tk)的相关度的差的绝对值,即相关度的最小绝对值差。

特征tk针对所有类别的区别能力的计算方法有两种,一种是对该特征在各个类别上的区分能力求和,衡量特征针对数据集的平均区分能力,如式(6)所示;另一种是取该特征在各个类别上的区分能力的最大值,衡量特征针对数据集的最大区分能力,如式(7)所示。

(6)

(7)

由DA方法的定义可知,DA方法的基本思想是选择对分类贡献最大的特征。其与文献[10]不同之处在于,DA方法使用特征在类别之间的差异而不是特征出现与否造成的类别分布的变化来衡量区分能力的。DA方法使用统一评分标准对每个特征进行评分,按照评分高低进行特征选择,并不是如DFICF提高稀有类特征评分权重那样显著倾向于选择稀有类特征。多数类与少数类的候选特征空间大小存在固有差别,因而经DA方法得到的特征子集中的多数类特征仍然多于少数类特征,从而保证了多数类的性能。

6 实验设计与分析

6.1 实验数据集

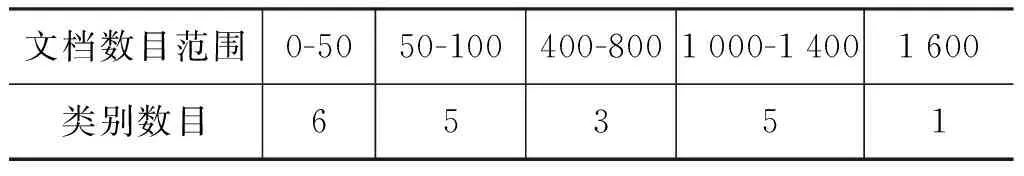

本实验使用复旦大学的中文文本分类语料库tc-corpus,复旦大学语料库语料有20个类别,其中训练集和测试集中的每个类别的文档数目比例都为1∶1。训练集共9 804篇,测试集共9 833篇。训练集与测试集的类别分布如表 1所示。

本文以100篇文档以下的类别为稀有类,400篇文档以上的类别为多数类。则由表1可知,数据集中共有11个稀有类,九个多数类。

表1 训练集与测试集的文档数目分布

6.2 实验设计及评测指标

本文的实验目标有两个,其一是通过对比各种特征选择方法在不平衡文本分类问题上的分类性能,验证本文提出的DA特征选择方法的优越性。其二是通过使用主导性平均方差对各种特征选择方法得到的特征子集进行分析,验证本文第4节推论2的正确性,同时也得到了在不平衡数据集上表现优越的特征选择方法的特点。

对于目标一,本文实验将DA特征选择方法与传统特征选择方法CHI、IG进行对比,CHI即取CHI评分在所有类别上的最大值,另外使用之前针对不平衡数据集设计的特征选择算法DFICF[15]作为与之前研究成果对比的基线。DFICF特征选择方法的计算公式为:

(8)

其中,IG(t)是特征t使用信息增益方法得到的评分值,M为类别数目,mt为特征t出现的类别数目。

实验过程中,采用中国科学院ICTCLAS[16]分词系统进行中文分词,向量化时采用TF-IDF方法对向量进行加权,分类器则使用目前性能较好且应用广泛的支持向量机(SVM)和朴素贝叶斯两种分类算法;其中,SVM分类器基于liblinear[17]程序包,该程序包是SVM使用线性核时的优化版本,朴素贝叶斯算法则使用效果较好的多项式事件模型[18]。

为了使实验结果具有可信性。实验首先在两类不平衡问题上进行,包括两类较不平衡问题与两类极不平衡问题。然后在多类不平衡问题上进行特征选择方法的对比,在多类不平衡问题上的实验使用全部数据集。

对于分类预测结果,本文使用F1值的宏平均和微平均作为效果的评价指标。F1值是准确率与召回率的调和平均值,是一种综合的测量指标。微平均是指对于每一个实例的性能指标的平均值,它将整个文档集合看作一个整体。对于同一个数据集来说,它的准确率、召回率和F1值的微平均值是相等的。宏平均是指对于每一个类别的性能指标的平均值,它是将类别等同看待,这样就避免了结果评测被大类支配的问题。

对于目标二,本文在各特征选择方法在多类不平衡问题对比实验的基础上,对各个特征选择方法产生的特征子集的主导性平均方差与分类性能的相关性进行分析。

6.3 特征选择对比的实验结果

6.3.1 较不平衡两类分类对比实验

在较不平衡两类分类实验中,使用数据集中的C34经济类与C37军事类两类进行实验,其中,训练集中C37有74篇文档,C34中有1 600篇文档,从C34中随机选取约1 500篇文档,使得不平衡比为20∶1,测试集与训练集保持相同分布且文档数目比例为1∶1。

由图1与图2可以看出,在两类较不平衡问题中,F1宏平均与微平均的趋势较为一致。当特征数小于3 000时,DA方法处于劣势,但当特征数大于3 000时,不论是F1宏平均还是F1微平均,本文提出的方法优于其他方法。就峰值而论,也是DA方法高于其他方法。

图1 两类较不平衡分类问题中F1宏平均随特征数目变化趋势图

图2 两类较不平衡问题分类中F1微平均随特征数目变化趋势图

需要注意的是,在两类问题下,式(6)与式(7)就退化成了同一种方法。

为了节省篇幅,在两类不平衡问题下不展示朴素贝叶斯算法的结果。由下文的多类不平衡问题下的实验结果可知,无论朴素贝叶斯算法与支持向量机算法,得到的结果是相似的。

6.3.2 极不平衡两类分类对比实验

在该实验中,少数类仍然使用C37军事类。多数类使用C19计算机类、C34经济类、C31环境类、C39运动类、C32农业类、C38政治类的组合。多数类从这六类的集合中随机选取约7 400篇文档,不平衡比例为100∶1,测试集与训练集分布一致且文档比例为1∶1。

由图3和图4可以看出,在两类极不平衡问题中,本文提出的特征选择方法在F1宏平均上的优势进一步扩大,在F1微平均上的优势有减小的趋势。表明了本文的特征选择方法是在保证大类分类性能的情况下提高少数类的分类性能来提高总体性能的。

图3 两类极不平衡问题中F1宏平均随特征数目的变化趋势

6.3.3 多类不平衡分类对比实验

多类不平衡分类实验中,使用复旦大学语料的全部类别进行实验,语料信息如6.1中所述。

在图5与图6中,DA-sum对应式(6)的计算策略,DA-max对应式(7)的计算策略。

图5 多类不平衡问题中F1宏平均随特征数目的变化趋势(SVM)

图6 多类不平衡问题中F1微平均随特征数目的变化趋势(SVM)

由图5与图6可知,在svm分类器下,五种特征选择方法的微平均值相差不大,但DA-sum与DA-max仍然保持了微弱的优势。相比而言,在宏平均值的比较中,DA-max与DA-sum保持了较大的优势,DA-sum方法在500-5 000的任一特征数目下都优于其余四种方法,DA-sum在特征数为4 000-5 000时与IG方法重合,但却在特征数为2 000时达到了本次实验宏平均值的峰值。

图7和图8则分别展示了使用朴素贝叶斯分类器时IG、CHI、DA-sum、DA-max、DFICF五种特征选择方法随特征数目的不同F1微平均与宏平均指标的变化。

图7 多类不平衡分类问题中F1宏平均随特征数目的变化趋势(NB)

图8 多类不平衡分类问题中F1微平均随特征数目的变化趋势(NB)

由图7和图8可知,使用朴素贝叶斯分类器时,在宏平均上仍然是DA-max与DA-sum保持优势,但显然,DA-max优势较为明显,DA-sum优势较小。在微平均中,DA-sum则处于弱势,与IG、DFICF相近;但DA-max仍然保持优势,与CHI相近。这表明,同样的特征选择方法,使用不同的分类器也能得到不同的结果,说明特征选择方法与分类器之间存在着一定的相关关系。

6.3.4 实验结果分析总结

通过在二类较不平衡问题、二类极不平衡问题、多类不平衡问题上的实验,可以得出如下结论。

1. 在二类分类问题中,当特征数目较大时,DA方法拥有较大的优势;在多类分类中则不论特征数目均有明显优势。

2. 在朴素贝叶斯下的多类分类实验中,DA-max优势依旧,但DA-sum在宏平均中优势较小,在微平均中逊于IG与DFICF。表明特征选择方法与分类算法之间具有一定的相关性。

3. 在二类较不平衡问题中,CHI与DFICF的峰值高于IG,但在其他两个实验中,均有IG>IGICF>CHI。表明IG方法在不平衡问题上相比其他特征选择函数仍有优势;

4. 在二类较不平衡问题的实验中,DFICF相对IG略有优势,在其他实验中,则表现与CHI相仿,表明单纯地提高出现文档数目少的特征的权重在多类不平衡问题下不能达到较好的改进效果。

综上所述,可以得到五种特征选择函数在不平衡问题上的最终排名,即:

DA-max > DA-sum > IG > DFICF > CHI

6.4 特征选择的主导性平均方差对比

本节针对多类不平衡问题分类实验中的特征选择方法,按照第4节的主导性平均方差分析方法进行了统计分析。特征数为3 000与5 000时的各特征选择方法的分类性能与方差对比数据如表2与表3所示。其中,各项指标的最优值与次优值用不同颜色标出。

由表2与表3可以看到,宏平均值与平均方差的相关性比较强烈,主导性平均方差越低,宏平均值呈现越高的趋势。对于特征数为3 000时的SVM宏平均与特征数为5 000时的NB宏平均,这一趋势拟合的较好。对于特征数为3 000时的NB宏平均与特征数为5 000时的SVM宏平均,虽然存在着异常,但总的趋势仍然一致。

由表2和表3还可得到,DA方法拥有较低的主导性平均方差与较高的宏平均值与微平均值,表明基于减小主导性平均方差来改进特征选择方法的思路是可行的。

表2 特征数为3 000时各特征方法分类性能与主导性平均方差数据对照表

DA-sumDA-maxIGCHIIGICFSVM微平均/%90.4790.5389.9789.6389.85SVM宏平均/%71.9671.7466.6964.3364.43NB微平均/%79.3181.9278.8481.4279.82NB宏平均/%61.7966.6359.0960.2059.14平均方差4.0604.3414.9315.5416.030

表3 特征数为5 000时各特征方法分类性能与主导性平均方差数据对照表

DA-maxDA-sumIGCHIIGICFSVM微平均/%90.3590.9790.8689.9390.28SVM宏平均/%68.9171.6768.6266.3867.63NB微平均/%82.2880.7680.9482.5481.20NB宏平均/%67.0763.9662.6663.0662.38平均方差4.6174.8735.7946.1706.666

在特征选择后的子集上进行的主导性分析的结果证明了本文推论2的正确性,即在不平衡问题上越不被大类主导的特征选择方法越能达到好的效果,表明主导性平均方差可以作为不平衡问题上指导特征选择方法选取特征的一种原则。同时,也证明了本文提出的DA特征选择方法在不平衡问题上是通过较为平衡的在稀有类和多数类之间选择特征,以提高稀有类的性能且保证多数类的性能来提高整体性能。

7 结论与展望

文本分类中的不平衡问题是一个在实际应用中很常见的问题,本文借鉴了前人在改进特征选择方法时的保证大类性能提高稀有类性能的思想,总结出了不被大类主导的特征选择方法在不平衡问题上有更好效果的推论,并提出了主导性平均方差作为主导性的量化分析方法。在推论与量化方法的指导下,本文提出了DA特征选择方法。该方法在与传统特征选择方法IG、CHI与针对不平衡改进的DFICF特征选择方法进行的对比实验中,在宏平均上表现出了较大的优势,同时保证了微平均值,一定程度上可以解决不平衡分类问题。在五种特征选择方法的主导性分析实验中,也进一步证明了本文推论的正确性。这也对不平衡问题上的特征选择方法的衡量提供了一种标准。

但是,本文提出的主导性分析方法在不同分类算法上的对应趋势存在一定的异常情况,表明本文的只有某类的强预测型特征被选中该类才可能被正确分类的弱假设可能存在着一定的缺陷,如何对主导性进行更加准确的分析是一个可研究方向。另外,特征选择函数与分类算法的交互也是影响主导性分析的一个重要的因子。

本文提出的主导性分析方法的一个限制在于不能使用轮转法等策略进行特征在类别间的绝对或相对平衡,该限制基于本文提出的不平衡问题中各类别所需的用于分类的特征数目存在差异的假设,如何对基于该假设改进特征选择函数与主导性分析方法是本文的后续研究方向。

[1] 苏金树, 张博锋, 徐昕. 基于机器学习的文本分类技术研究进展[J]. 软件学报, 2006, 17(9): 1848-1859.

[2] Van Hulse J, Khoshgoftaar T M, Napolitano A, et al. Feature selection with high-dimensional imbalanced data[C]//Proceedings of IEEE International Conference. 2009: 507-514.

[3] 刘海峰, 王元元, 张学仁, 等. 文本分类中基于位置和类别信息的一种特征降维方法[J]. 计算机应用研究, 2008, 25(8): 2292-2294.

[4] Yang Y, Pedersen J O. A comparative study on feature selection in text categorization[C]//Proceedings of the ICML. 1997, 97: 412-420.

[5] Rogati M, Yang Y. High-performing feature selection for text classification[C]//Proceedings of the eleventh international conference on Information and knowledge management. ACM, 2002: 659-661.

[6] 代六玲, 黄河燕, 陈肇雄. 中文文本分类中特征抽取方法的比较研究[J]. 中文信息学报, 2004, 18(1): 26-32.

[7] 廖莎莎, 江铭虎. 中文文本分类中基于概念屏蔽层的特征提取方法[J]. 中文信息学报, 2006, 20(3): 22-28.

[8] 张希娟, 王会珍, 朱靖波. 面向文本分类的基于最小冗余原则的特征选取[J]. 中文信息学报, 2007, 21(5): 56-60.

[9] 熊忠阳, 蒋健, 张玉芳. 新的CDF文本分类特征提取方法[J]. 计算机应用, 2009, 9(7): 1755-1757.

[10] 徐燕, 李锦涛, 王斌, 等. 基于区分类别能力的高性能特征选择方法[J]. 软件学报, 2008, 19(1): 82-89.

[11] Sun A, Lim E P, Liu Y. On strategies for imbalanced text classification using SVM: A comparative study[J]. Decision Support Systems, 2009, 48(1): 191-201.

[12] Yin L, Ge Y, Xiao K, et al. Feature selection for high-dimensional imbalanced data[J]. Neurocomputing, 2013,105:3-11.

[13] Forman G. A pitfall and solution in multi-class feature selection for text classification[C]//Proceedings of the twenty-first international conference on Machine learning. ACM, 2004: 38.

[14] Zheng Z, Wu X, Srihari R. Feature selection for text categorization on imbalanced data[J]. ACM SIGKDD Explorations Newsletter, 2004, 6(1): 80-89.

[15] 徐燕, 李锦涛, 王斌, 等. 不均衡数据集上文本分类的特征选择研究[J]. 计算机研究与发展,2007,44(22):58-62.

[16] Zhang H P, Yu H K, Xiong D Y, et al. HHMM-based Chinese lexical analyzer ICTCLAS[C]//Proceedings of the second SIGHAN workshop on Chinese language processing-Volume 17. Association for Computational Linguistics, 2003: 184-187.

[17] Fan R E, Chang K W, Hsieh C J, et al. LIBLINEAR: A library for large linear classification[J]. The Journal of Machine Learning Research, 2008, 9: 1871-1874.

[18] McCallum A, Nigam K. A comparison of event models for naive bayes text classification[C]//Proceedings of the AAAI-98 workshop on learning for text categorization. 1998, 752: 41-48.

A Feature Selection Method Based on Discriminative Ability for Multiclass Text Categorization on Imbalanced Data

ZHANG Yanxiang, PAN Haixia

(School of Software,BeiHang University, Beijing 100191, China)

Imbalanced data in text categorization is pervasive in reality. Conventional feature selection(FS) methods prefer to choose features in large classes rather than rare classes. This paper proposes a quantitative method to measure the dominance. Then, this paper dscribes a new FS method, namely DA method, based on category discriminative ability takes the minimum absolute difference of documental probability between classes as a criterion to partly ensure the fairness of FS method on large classes and rare classes. Experimental results show the DA method outperforms CHI, IG and DFICF especially on macro-average F1 measure.

text categorization; imbalanced problem; feature selection; dominance analysis; discriminative ability

张延祥(1989—),硕士研究生,主要研究领域为机器学习、文本挖掘。E-mail:zhangyx@buaa.edu.cn潘海侠(1972—),博士研究生,副教授,硕士生导师,主要研究领域为云服务、服务科学与管理、软件工程、人工智能等。E-mail:haixiapan@buaa.edu.cn

1003-0077(2015)04-0111-09

2013-09-05 定稿日期: 2014-01-10

TP391

A