夜视环境下激光助视成像与红外热像的融合

2015-03-29郝延福

蒋 涛,左 昉,郝延福

(北京科技大学自动化学院,北京100083)

1 引言

图像融合[1]是指将多个图像传感器或同一图像传感器在不同工作模式下获取的关于同一场景的图像信息加以综合,充分利用待融合图像的冗余和互补信息,得到关于此场景更准确的描述。近年来,关于对可见光与红外热像的融合研究比较多,融合方法也是层出不穷。针对夜视环境下图像融合的研究则比较少,主要有微光图像与红外图像的融合[2]、微光图像与激光助视成像的融合[3]。对于激光助视成像与红外热像的融合几乎是空白。由于不同波长的传感器成像原理不相同,导致其成像特点也不尽相同,很难有一种通用的融合算法适合所有的图像融合,必须针对不同的融合图像采取相应的融合算法。因此,本文将根据夜视环境下激光助视成像的特点和红外热成像的特点对其进行融合算法优化研究。

2 基于NSCT的图像分解

NSCT(Nonsubsampled Contourlet Transform)[4]是一种基于Contourlet变换的多尺度、多方向的图像分解重构框架,与Contourlet变换类似,NSCT包括非下采样塔形滤波器组(Nonsubsampled Pyramid Filter Bank,NSPFB)和非下采样方向滤波器组(Nonsubsampled Directional Filter Bank,NSDFB)两部分,NSPFB对信号进行多尺度分解,NSDFB对信号进行多方向分解。由于NSCT利用Z变换的等效位移特性,去掉了Contourlet变换中信号进入分解滤波器后的下采样和进入重构滤波器之前的上采样,而是改为对分解滤波器进行上采样,对重构滤波器进行下采样,所以具有平移不变性。避免了Contourlet变换由于采样所引起的吉布斯(Gibbs)效应。图1为NSCT分解过程示意图。

图1 NSCT分解过程示意图Fig.1 NSCT decomposition process

如果对图像进行N级NSCT变换,li为在尺度i(其中i=1,2,…,N)下的方向分解级数,则图像经过N级NSP分解,会得到(N+1)个与原图像一样大小的子带图像,对NSP分解后尺度下的子带图像进行li级方向分解,则得到2li个与源图像相同尺度的方向自带图像,所以对一幅图像进行N级非下采样Contourlet变换,会得到个与源图像尺度相同的子带系数[5]。

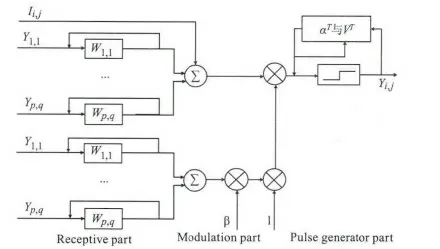

3 脉冲耦合神经网络(Pulse Coupled Neural Network,PCNN)

PCNN[6]起源于20世纪60年代,该网络模型通过模拟猫的大脑皮层细胞对信号的处理机制而产生的,有着重要的生物学背景。PCNN是由若干个神经元互相连接而构成的反馈性网络,每个神经元由三部分组成:接受部分(receptive field)、调制部分(modulation field)和脉冲产生部分(pulse generator),如图2所示。

用PCNN对M×N的图像进行处理时,把图像中每个像素的灰度值作为神经元的输入,因此M×N的图像对应着M×N个PCNN神经元,每个神经元的离散数学表达式如下:

图2 神经元模型Fig.2 neural cell model

其中,n表示迭代次数;Fij(n),Lij(n)表示第(i,j)个神经元的反馈输入和连接输入;Iij(n)表示外部输入信号。Mijpq,Wijpq分别是反馈输入和链接输入中神经元之间的连接权系数矩阵,β表示神经元之间的连接强度常数,Uij(n)为内部活动项,Tij(n)为动态门限,Yij(n)表示脉冲耦合神经网络的输出,VF,VL,VT表示输入反馈放大系数、连接放大系数和动态门限放大系数,αF,αL,αT分别表示输入反馈函数、连接函数与动态门限函数的时间常数。

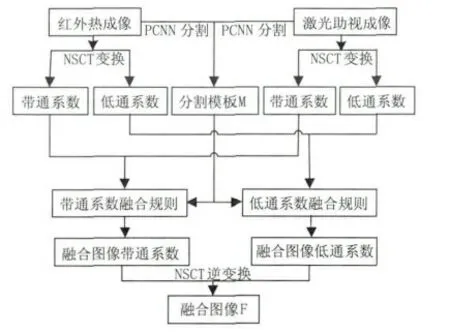

4 图像融合规则

本文所采用的融合规则思路:根据激光助视成像上的光斑分布和红外热成像的目标信息提取图像分割模板,利用图像分割模板对NSCT分解系数进行分区域处理[7],得到融合图像的带通方向子带系数和低通方向子带系数,最后经过NSCT逆变换得到融合图像。其融合规则如图3所示。

图3 基于NSCT的图像融合框图Fig.3 Schematic diagram of image fusion based on the NSCT

4.1 基于PCNN的图像分割模板提取

二维图像矩阵M×N可以理解为M×N个PCNN神经元模型,当内部连接矩阵Mijpq,Wijpq所在邻域内有灰度值相似的像素存在时,则其中某个像素激发产生的脉冲输出将会引起附近相似灰度值像素对应的神经元激发,产生脉冲输出序列Yij(n),输出序列Yij(n)就构成了分割的二值图像[8]。

根据分割的二值图像将原图像分为前景A和背景B两部分,计算A,B两部分之间的类内方差σα与类间方差σβ:

其中,μA,μB分别为A,B的均值,σ2A,σ2B分别为A,B的方差,μ=PAμA+PBμB均值。则其方差比为:

δ反应了图像中目标与背景之间的差别,δ越大说明类与类之间的差别比较大,类内部的差别比较小。所以δ越大表明分割效果越好[9]。

对输入的激光助视成像和红外热像进行分割融合得到融合模板M。将红外热像的目标区域记为M1,激光照射到的区域去除红外热像的目标区域记为M2,激光照射不到的区域去除红外热像的目标区域记为M3。

4.2 低通系数融合规则

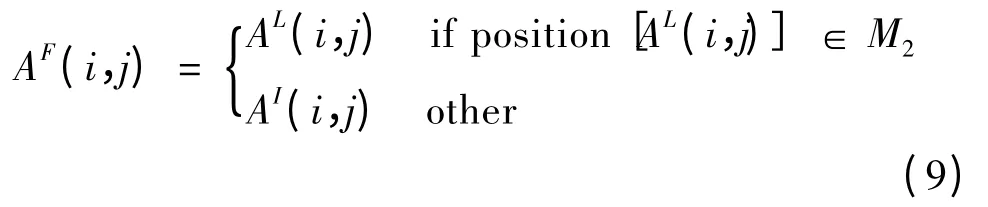

图像的低通子带集中了图像的主要能量,决定图像的轮廓。对于激光助视成像和红外热像的融合,主要目的是为了在激光助视成像上体现出红外目标,并且能够用红外信息来弥补激光照射的盲区。由此可以归纳出低通系数融合规则如下:

其中,AF(i,j)为融合图像的低通系数;AI(i,j)为红外热像经过N级NSCT变换后的低通系数;AL(i,j)为激光助视成像经过N级NSCT变换后的低通系数。

4.3 带通系数融合规则

带通子带系数包含了原图像中边缘、区域轮廓等细节,反映的是图像突变特性。激光助视成像中激光照射到的区域细节信息比较丰富,应多反映在图像中,从而有如下规则[10]:

其中,DKil(i,j)表示图像在尺度i、方向l、点(i,j)处NSCT的带通方向子带系数;K分别代表融合图像、激光助视成像、红外热像;NM1表示区域M1中像素的数目;fKM1(i,j)表示图像K在区域M1中像素(i,j)处的灰度值。

5 实验结果与分析

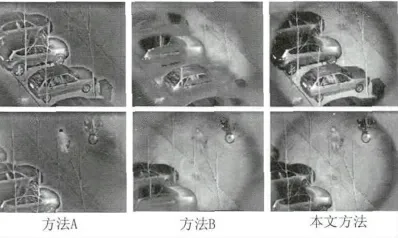

为了验证本文融合算法的融合效果,在Matlab2013环境下进行实验。实验中采用了两组图像,一组是在夜间采集某小区露天停车场的激光助视成像和红外热像的照片,如图4(a)和图4(b)所示;另一组停车场边有行人路过的照片,如图5(a)和图5(b)所示。两组图像已经经过严格配准。选取两种不同的融合算法与本文的融合算法进行比较,分别是方法A:经NSCT分解后,低频系数选取红外信息,高频融合系数选取方差最大法;方法B:采用OSTU提取分割模板,其余步骤与本文方法相同。方法A是为了表明简单融合算法对激光助视成像和红外热像的融合效果,方法B是为了对比OSTU与PCNN提取不同分割模板,对融合效果的影响。此外还需说明的是本文算法中NSCT分解级数为4级,方向分解级数依次为3,2,2,2。金字塔分解滤波器为“pyrexc”,方向分解滤波器为“dmaxflat7”。在PCNN中连接因子为0.4,衰减因子为0.3,阈值为240。所用图像大小均为352×288。两组图像经不同算法融合后结果如图6所示。

图4 第一组激光助视与红外热像Fig.4 First set of laser assistant vision image and infrared image

图5 第二组激光助视与红外热像Fig.5 Second set of laser assistant vision image and infrared image

图6 融合结果比较Fig.6 Comparison of fusion results

从主观评价的角度来看,方法A虽然既能反映红外信息,又能体现出激光助视成像中的细节信息。但在激光可以照射到的区域反映的图像信息失真,不符合人眼的视觉习惯,且弱化了小物体的红外目标信息。在方法B中,由于OSTU不能反映某个像素与其邻域之间的关系,无法使分割后的二值图像尽量形成连通区域,这样对分割后的红外图像影响很大,从而使提取到的分割模板不够准确,导致融合图像中很多细节信息被红外图像覆盖。而在本文方法中,PCNN每次形成的脉冲都要受到该像素自身与其邻域像素值的影响。然后再选取前景和背景类间方差最大的分割图像作为分割模板,这样就使分割模板兼具两者优良特性,可以准确的提取到夜间热成像中的红外信息。在激光照射到的位置能清楚地看到符合人类视觉习惯的景物,在激光照射弱的区域可以选择性的显示更多细节信息。同时也能在融合图像中准确地反映出红外信息。

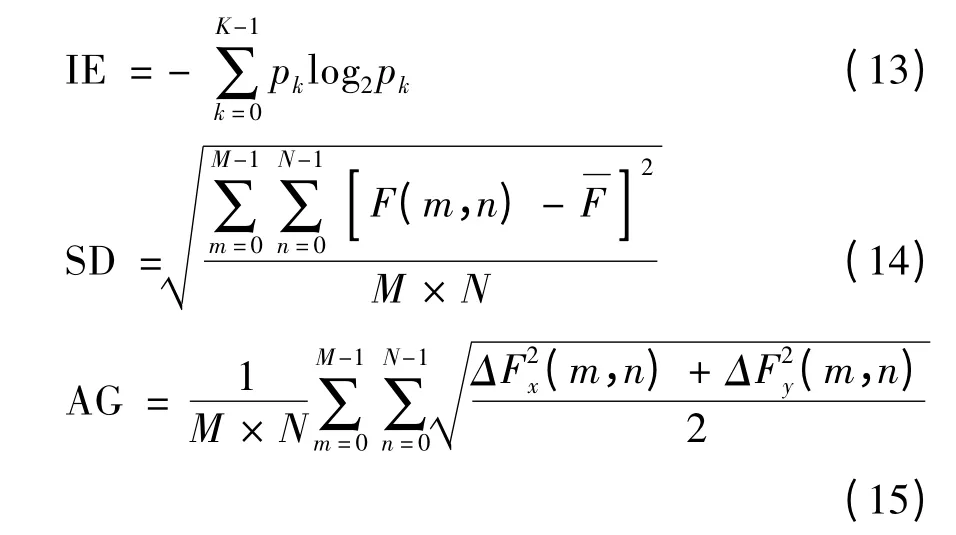

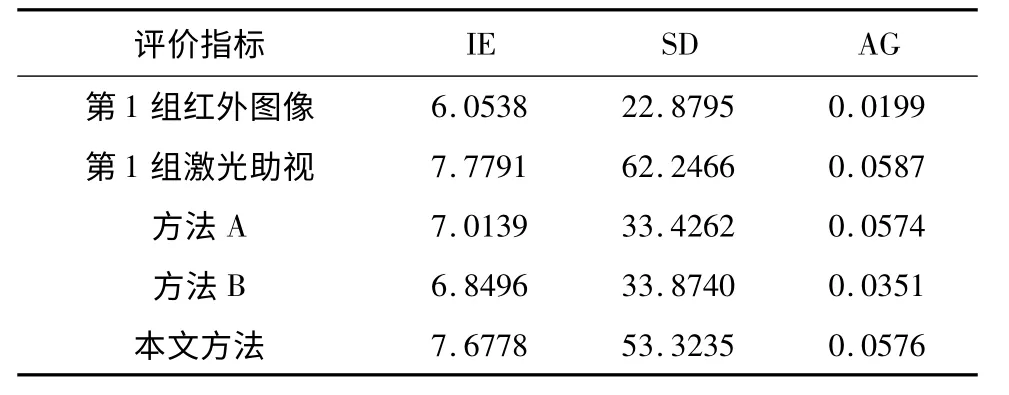

从客观评价角度来看,本文采用信息熵(IE),标准差(SD),平均梯度(AG)三项指标评价三准方法的融合效果。它们的定义如下:

其中,pk为灰度k的分布概率,其范围为[0,1,…,K-1];ΔFx、ΔFy分别为融合图像F在x和y方向上的方差。评价结果见表1和表2。从表中可以看出本文方法的信息熵和标准差明显优于方法A和方法B,平均梯度也明显优于方法B,与方法A和激光助视成像的平均梯度不差上下,表明本文方法一方面能充分反映两幅源图像的信息量,另一方面又能够体现激光助视成像的细节信息即清晰度。

表1 第一组实验结果对比表Tab.1 Experimental results comparison fo first set

表2 第二组实验结果对比表Tab.1 Experimental results comparison fo second set

6 结束语

由于成像机理和波谱接受频段的不同,夜视环境下,激光助视成像和红外热像所反映的信息差异很大,图像之间的相关性弱,但互补明显。本文根据二者成像特点引入了分区域融合的思想。实验证明本文方法能够在融合图像中最大程度保留激光助视成像细节信息和红外热像目标信息。不论从视觉效果方面还是客观指标方面来看,本文算法都要好于其他算法。但是本文算法运行时间过长,图像亮度分布不均匀,分割连接处不够自然。这些都是下一步研究的内容。

[1] JING Zhongliang,XIAO Gang,LI Zhenhua.Image fusion:theory and application[M].Beijing:China Higher Education Press,2007.(in Chinese)敬忠良,肖刚,李振华.图像融合—理论与应用[M].北京:高等教育出版社,2007.

[2] BO Lianfa,CHEN Qian,SUN Jie,et al.Study on the fusion technology of infrared and low light level image[J].Journal of Infrared and Millimeter Waves,1999,(1):47-52.(in Chinese)柏连发,陈钱,孙婕,等.红外与微光图像融合技术研究[J].红外与毫米波学报,1999,(1):47-52.

[3] SUN Shaoyuan,ZHANG Baomin,WANG Liping,et al.Fusion of low light level image and laser assistant vision image based on contrast modulation[J].Infared and Laser Engineering,2003,32(2):171-172,190.(in Chinese)孙韶媛,张保民,王利平,等.微光图像与激光助视图像的对比度调制融合[J].红外与激光工程,2003,32(2):170-172,190.

[4] Arthur L da Cunha,Zhou Jianping,Minh N Do.The nonsubsampled contourlet transform:theory,design and applications[J].IEEE Transactions on Image Processing,2006,15(10):3089-3101.

[5] XU Yuemei.Study on multi-focus image fusion based on multi-scale transform[D].Xuzhou:China University of Mining&Technology,2012.(in Chinese)徐月美.多尺度变换的多聚焦图像融合算法研究[D].徐州:中国矿业大学,2012.

[6] Deng Zhang,Shingo Mabu,Kotaro Hirasawa.Image denoising using pulse coupled neural network with an adaptive pareto genetic algorithm[J].IEEE Transactions on Electrical and Electronic Engineering,2011,6(5):474-482.

[7] YANG Yuetao,ZHU Ming,HE Baigen,et al.Fusion algorithm for infrared and visible light images based on region segmentation and NSCT[J].Laser&Infrared,2010,40(11):1250-1257.(in Chinese)杨粤涛,朱明,贺柏根,等.基于区域分割和非采样Contourlet变换的红外和可见光图像融合[J].激光与红外,2010,40(11):1250-1257.

[8] YU Ruixing,ZHU Bing,ZHANG Ke.New image fusion algorithm based on PCNN[J].Opto-Electronic Engineering,2008,35(1):126-130.(in Chinese)余瑞星,朱冰,张科.基于PCNN的图像融合新方法[J].光电工程,2008,35(1):126-130.

[9] XIN Guojiang,ZOU Beiji,et al.Image segmentation with PCNN model and maximum of variance ratio[J].Journal of Image and Graphics,2011,16(7):1310-1316.(in Chinese)辛国江,邹北骥,等.结合最大方差比准则和PCNN模型的图像分割[J].中国图象图形学报,,2011,16(7):1310-1316.

[10]ZHANG Jinglei,ZHAO Eying.Fusion method for infrared and visible light images based on NSCT[J].Laser&Infrared,2013,43(3):319-323.(in Chinese)张惊雷,赵俄英.基于NSCT的红外和可见光图像融合方法[J].激光与红外,2013,43(3):319-323.