基于CMOS 传感器的图像质量评价*

2015-03-27焦淑红申维和

齐 欢,焦淑红,王 斌,刘 伟,申维和

(1.哈尔滨工程大学 信息与通信工程学院,黑龙江 哈尔滨150001;2.空间物理重点实验室,北京100076;3.北京宇航系统工程研究所,北京100076)

0 引 言

图像传感器是数字成像设备的核心器件,其性能的优劣直接影响所获取图像的感官效果。其中,CMOS 传感器具有设计简单、功耗低、速度快以及集成度高等优点[1],在数码产品、医疗设备、航天航空等领域表现出巨大的优势和潜力。但CMOS 图像传感器的高集成度使得各元件相互干扰严重,大大影响图像的质量[2]。图像质量评价技术是图像获取、处理和存储等领域的基础,根据图像的质量调整参数可以改进图像算法和图像系统的性能[3,4]。获取高质量的图像是设计成像设备的目标,通过比较相机获取图像的质量可以有效评估成像设备中传感器的性能,并为改善传感器的设计提供合理的依据。

本文充分考虑人类视觉系统的特性和CMOS 传感器的工作原理,提出了一种基于CMOS 传感器的图像质量评价算法。实验结果表明:该算法的评价结果与人眼感知保持较高的一致性,在CMOS 图像传感器的设计和性能评估等方面具有广阔的应用前景。

1 方向梯度直方图

方向梯度直方图(histograms of oriented gradients,HOG)[5]是一种图像特征的局部描述子,由Dalal N 等人在2005 年的CVPR 会议上首次提出。最初的目标是建立描述人体形状的特征描述子并将其用于行人检测。HOG 特征描述子的基本思想是图像中目标的外观和形状可以通过图像局部梯度或边缘方向刻画,该特征描述子在行人检测方面取得了很好的效果,并被广泛应用于目标检测与识别领域。

对于给定输入图像的HOG 描述子,首先对图像进行Gamma/色彩标准化以便消除光照和阴影等对图像或视频中行人检测的影响。由于算法的后续步骤包含对比度的标准化,因此,Gamma/色彩标准化对检测性能的改善效果并不明显,在具体的实现中通常将这一步省略。其次,在每个彩色通道上计算图像的梯度。HOG 描述子利用图像的梯度和方向信息表达图像中的重要目标,梯度和梯度方向的计算是建立HOG 描述子最为关键的步骤。接着,将图像划分为若干个单元格,并以梯度大小为权值建立每个单元格内像素的方向梯度直方图。最后,将多个单元格合并成一个图像块,并在图像块上进行对比度标准化操作。

2 图像质量的表示

2.1 图像的亮度相似性

CMOS 图像传感器存在输入上限阈值,当输入的光信号超过该阈值时,像素单元会由于饱和而发生溢出模糊[1]。此时,像素单元无法进行光电转换,图像上会出现一片类似于过曝光的区域,过高的亮度将直接影响图像的感知质量。因此,本文通过以下方式计算图像在亮度上的变化[6],用以判断CMOS 传感器是否出现溢出模糊

式中 Ix,Iy分别为原始图像和干扰图像的灰度值;l 为图像灰度值的动态范围,对于8 bit 灰度图像,l=255。

2.2 图像结构的规则度

结构是图像重点目标的关键信息。HOG 描述子可以很好地描述目标的外观和轮廓即目标结构[5]。对于纹理丰富的区域(结构不规则区域),各像素的梯度方向不同,均匀地分布于方向梯度直方图的各区间内;对于平坦区域(结构规则区域),各像素的梯度方向一致性较强,在方向梯度直方图中的分布较为集中。因此,图像局部区域的方向梯度直方图可以体现图像中不同结构区域的特点。

干扰信号会改变图像的结构信息,进而影响图像结构的规则度[7]。本文利用与图像结构密切相关的HOG 描述子提取图像的结构信息。为了体现图像中每一细微之处的结构情况,对原始HOG 算法做出一定的调整。首先,利用Prewitt 算子计算图像每个像素的梯度大小和方向。然后,将0°~180°均匀划分为3 个方向区间,即[0°,60°],[61°,120°],[121°,180°]。最后,以图像中的每个像素为中心划定3×3 的图像区域,并针对每个区域,统计落入各方向区间内像素的个数。同时,以每个像素梯度的大小作为权值,得到以该像素为中心的图像区域的方向梯度直方图,通过这种方式描述每个像素所处区域的图像局部梯度方向分布情况。

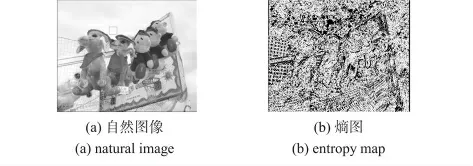

随机变量的不确定程度越大,其信息熵[4]越大。因此,本文利用方向梯度直方图的熵来衡量局部图像结构的规则度。为了计算信息熵,首先利用每个像素所处局部区域的方向梯度直方图,计算该区域内像素落入各方向区间的概率。由于上述方式计算的方向梯度直方图是以每个像素的梯度大小为权值的,因此,将直方图中各区间的加权频数与所有区间的加权频数和的比值作为每个区间方向发生的概率。通过计算图像中每个像素邻域方向梯度直方图的熵得到与原始图像尺寸相等的熵图[8]。图1 给出了一幅自然图像及其熵图。从图中可以看出,熵图可以大致描绘出图像中目标的外观。但值得注意的是,人眼感知平滑背景区域的熵值同样较大。这是因为人眼在感知图像内容变化时存在对比度阈值,只有当图像区域的对比度大于这一阈值时,人类视觉系统才可以感知到图像灰度值的变化,当背景区域的梯度值小于对比度阈值时,人类感知其为相对平滑的区域。由于上述计算熵值的方式仅与梯度方向有关,与梯度大小无直接联系,而背景区域的梯度方向各异,因此,背景区域的熵值同样较大。

图1 自然图像及其熵图Fig 1 Natural image and its entropy map

将人眼无法感知梯度变化的区域视为完全平滑区域更能体现人类视觉系统感知图像变化的特点。因此,当区域内各像素梯度值小于等于阈值T 时,将该点的梯度方向改为0°,然后再计算直方图的熵。根据经验,T=5。考虑人类视觉系统对比度阈值现象的熵图如图2 所示。从图中可以看出,图像中平滑的区域具有较小的熵,而纹理丰富的区域具有较大的熵。调整后的熵图更能体现图像中人眼可感知目标的结构。

图2 调整后的熵图Fig 2 Modified entropy map

为了表达干扰图像的梯度方向分布相对于原始图像的变化情况,计算干扰图像熵图与原始图像熵图的相似度[9]

式中 Ex,Ey分别为原始图像和干扰图像梯度方向的熵图;C 为避免分母为0 的常数,这里,C=0.001。

3 全参考图像质量评价算法

图像质量的变化既体现在图像的结构规则度上,也与图像的亮度信息有关。将干扰图像与原始图像的结构相似图与亮度相似图结合即可得到图像质量的相似程度

式中 a 为各部分影响图像质量变化的权重参数。由于图像中目标的结构能够体现图像传达的主要信息,因此,在算法实现中,a=0.8。

在计算熵图时,虽然将人眼无法感知的梯度变化区域进行了调整,但通过前面的分析可以看出,熵图只与局部区域梯度方向分布的多样性有关,与图像中目标的重要性不存在任何联系。也就是说,即使这一区域的梯度非常小(非目标区域),但只要该区域的梯度变化超过了人类视觉系统可感知的阈值,熵图中就可以体现出来,且梯度方向越丰富,熵值越大。为了能够突出图像中重点目标对图像质量变化的影响,将原始图像的局部方差[10]作为图像各区域质量变化的权值

式中 (M,N)为图像的尺寸;(i,j)为空间位置索引;σ(i,j)为(i,j)处图像像素的局部方差

式中 wk,l为二维对称高斯权重函数。由于在统计方向梯度直方图时利用了每个像素的3×3 邻域,因此,计算局部方差时仍选用3×3 窗口,即K=L=1。μ(i,j)为图像的局部均值

为了使该算法得到的客观分数与主观分数之间有更好的线性关系,将质量分数变换到对数域

根据经验,当b <1 时,可以得到更好的质量评价性能,在本文的实现中,b=0.5。

4 实验结果与分析

为了系统、全面地评定所提算法与人眼感知的一致性,本文利用LIVE 主观评估数据库[11]进行客观分数与主观分数的相关性验证实验。LIVE 数据库包含29 幅RGB 彩色自然原始图像和五种类型的干扰图像,其中,白噪声(white noise,WN)、高斯模糊(Gaussian blur,GB)和快衰落(fastfading,FF)三种类型的干扰图像各145 幅,JPEG2000(JP2K)干扰图像169 幅,JPEG 干扰图像175 幅。实验分别利用斯皮尔曼等级相关系数(Spearman rank-order correlation coefficient,SROCC)和皮尔逊线性相关系数(Pearson linear correlation coefficient,PLCC)衡量客观分数与主观分数之间的单调性和准确性。

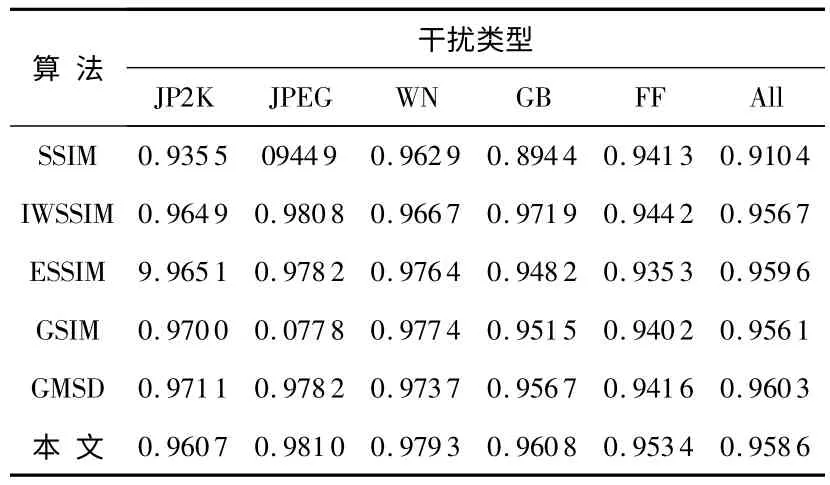

实验选取了五种通过计算干扰图像与原始图像相似度来评 价 图 像 质 量 的 客 观 算 法:SSIM[9],IWSSIM[12],ESSIM[13],GSIM[6]和GMSD[14]作为对比算法。SSIM 利用图像间的结构相似度评价图像的质量;IWSSIM 将干扰图像和原始图像各区域的互信息量作为SSIM 质量图合并的权值;ESSIM 将图像边缘强度的相似度作为干扰图像质量分数;GSIM 和GMSD 通过计算图像间梯度的相似度评价图像的质量。表1、表2 分别列出了各算法的客观分数与主观分数之间的SROCC 和PLCC。

表1 客观算法在LIVE 库上的SROCCTab 1 SROCC of objective algorithms on LIVE database

表2 客观算法在LIVE 库上的PLCCTab 2 PLCC of objective algorithms on LIVE database

从实验结果可以看出:无论SROCC 还是PLCC,本文所提算法在大多数类型干扰图像上的实验结果均优于其他几种算法。特别是,在所有干扰图像混合的情况下,所提算法具有最高的PLCC,就SROCC 而言,该算法也能与表现最好的算法相匹敌。因此,本文所提算法是一种与主观评估接近的客观算法,完全可以满足实际应用的需求,并且,该算法主要基于图像结构建立,适用于多种类型图像。

5 结 论

本文提出了一种基于CMOS 传感器的图像质量评价算法。算法充分考虑了CMOS 传感器的特点,并与人类视觉系统的感知特性高度契合。仿真结果显示:无论单一类型干扰图像还是混合类型干扰图像,本文算法的客观分数与主观分数的相关系数均达到0.95 以上,能够为评估和提升CMOS 传感器性能提供有效依据。

[1] 邹义平.CMOS 图像传感器的图像降噪技术的研究[D].北京:北京邮电大学,2009.

[2] 徐 忠,刘洪英,余 巧,等.医用内窥镜微型摄像模组设计[J].传感器与微系统,2014,33(10):91-103.

[3] Demirtas A M,Reibman A R,Jafarkhani H.Full-reference quality estimation for images with different spatial resolutions[J].IEEE Transactions on Image Processing,2014,23(5):2069-2080.

[4] Min Z,Muramatsu C,Zhou X,et al.Blind image quality assessment using the joint statistics of generalized local binary pattern[J].IEEE Signal Processing Letters,2015,22(2):207-210.

[5] Dalal N,Triggs B.Histograms of oriented gradients for human detection[C]∥IEEE Computer Society Conference on Computer Vision and Pattern Recognition(CVPR),San Diego,CA,USA.2005:886-893.

[6] Anmin L,Weisi L,Narwaria M.Image quality assessment based on gradient similarity[J].IEEE Transactions on Image Processing,2012,21(4):1500-1512.

[7] 吴金建.基于人类视觉系统的图像信息感知和图像质量评价[D].西安:西安电子科技大学,2014.

[8] 刘 倩.基于HOG 的熵流导航方法[D].武汉:华中科技大学,2013.

[9] Wang Z,Bovik A C,Sheikh H R,et al.Image quality assessment:From error visibility to structural similarity[J].IEEE Transactions on Image Processing,2004,13(4):600-612.

[10]Mittal A,Moorthy A K,Bovik A C.No-reference image quality assessment in the spatial domain[J].IEEE Transactions on Image Processing,2012,21(12):4695-4708.

[11]Sheikh H R,Wang Z,Cormack L,et al.LIVE image quality assessment data-base release2[DB/OL].[2009—12—14].http:∥live.ece.utexas.edu/research/quality.

[12]Zhou W,Qiang L.Information content weighting for perceptual image quality assessment[J].IEEE Transactions on Image Processing,2011,20(5):1185-1198.

[13]Zhang Xuande,Feng Xiangchu,Wang Weiwei,et al.Edge strength similarity for image quality assessment[J].IEEE Signal Processing Letters,2013,20(4):319-322.

[14]Xue Wufeng,Zhang Lei,Mou Xuanqin,et al.Gradient magnitude similarity deviation:A highly efficient perceptual image quality index[J].IEEE Transactions on Image Processing,2014,23(2):684-695.