面向高铁无线网络覆盖与容量优化的多agent模糊强化学习算法*

2015-03-25王子瑞

王子瑞

(兰州交通大学 电子与信息工程学院,甘肃 兰州 730070)

面向高铁无线网络覆盖与容量优化的多agent模糊强化学习算法*

王子瑞

(兰州交通大学 电子与信息工程学院,甘肃 兰州 730070)

为了提升高铁沿线LTE无线网络服务质量,提供最理想的覆盖与容量性能,在传统单agent学习算法的基础上,提出了通过多agent联合调整相邻eNodeB的天线下倾角从而实现覆盖与容量优化的模糊强化学习算法。并在LTE网络下的高速场景中进行仿真,仿真结果表明多agent学习算法与传统学习算法相比在高速环境下达到全局最优解的速率更快,特别是在应对环境突变的情况时恢复到最优解的速率有所提升。

高铁;覆盖与容量优化;多agent

0 引 言

近几年来随着高铁的迅速发展,高速环境下的无线通信质量面临着巨大的挑战,同时,人们对于无线网络服务质量的要求也越来越高,所以对铁路沿线无线网络性能的提升成为了一项迫在眉睫的工作[1]。在评估网络性能时,覆盖和容量性能是两个重要指标,网络的优化工作通常是针对两者的平衡优化来进行。在早期的网络部署工作中,通常优先对覆盖性能进行优化,但是,随着不断增长的移动用户数量,容量性能逐渐成为限制系统性能的主要因素。因此,3GPP提出了覆盖与容量优化(coverage and capacity optimization,CCO)的概念,旨在维持网络覆盖目标的同时最大化容量性能。

中外已经有部分文献对覆盖与容量优化进行了一定程度的研究。文献[2]中Yilmaz等人详细讨论了不同天线下倾技术对LTE网络覆盖和容量的影响,并证明了电子调节可以获得更好的优化效果,为以后天线技术在覆盖与容量优化领域的研究提供了理论基础。文献[3]提出了联合调整天线倾角与功率方式,并做了全面的性能验证,但其忽略了边缘用户的吞吐量表现。文献[4]利用非合作博弈模型将上行功率作为调节参数,使得各个小区性能达到Nash均衡,这样虽然使小区间的性能达到了均衡,但是这种场景是一个停滞状态,对动态环境的适应性较差,同时,该方法的收敛时间通常不够快,在高铁环境中用处不大。文献[5-7]应用模糊强化学习理论,通过调节天线下倾角对覆盖与容量进行优化,也提出应用多智能体multi-agent的概念,把每个eNodeB看作一个智能体agent,但是由于其在实际执行优化算法时每个agent均单独执行,把其余agent看做是外部环境的一部分,所以其本质仍然是单agent系统,当网络性能恶化时也只能对众多小区依次进行优化,这样不仅会导致算法收敛速度慢,出现次优化现象,而且易出现覆盖空洞与过度重叠覆盖问题。

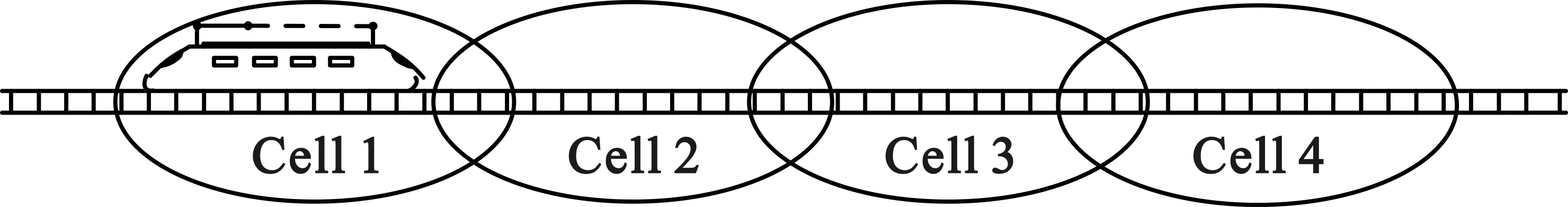

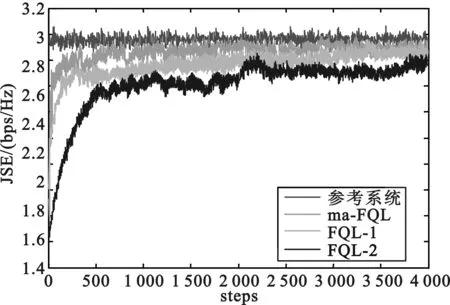

此外,研究表明覆盖与容量问题一般都是局部性的,而且天线参数的调整通常只会对本小区以及相邻小区产生影响,因此优化过程中只包含有一到两个小区,而且铁路沿线都是链状小区,如图1所示,可见针对相邻两小区进行联合调整是可行的。

图1 铁路干线小区链状网结构

在上述研究的基础上,针对高速列车速度快、用户多的特点,以及单agent学习不全面的缺点,将multi-agent[8]与强化学习算法结合来应对这一挑战。多agent强化学习算法在算法执行时采用组合动作,每个agent都必须考虑到算法中其他agent将要采取的动作,以决定应该采取的动作,这一特点可以克服传统强化学习算法易出现次优化以及达到全局最优时间过长的缺点。最终仿真结果也表明,该文介绍的算法在高速环境下达到全局最优解的速率优于传统的强化学习算法。

1 多agent模糊Q学习算法

强化学习(reinforcement learning,RL)算法主要有瞬时差分(temporal differences,TD)算法、Q学习(Q-learning,QL)算法、自适应启发评价(adaptive heuristic critic,AHC)算法。其中,QL算法可以根据经验找到最佳的策略,而不需要知道环境的动态模型的特点,使得QL算法非常适合用于自组织网络机制。

基于以上分析,该文采用多agent模糊Q学习算法(multi-agent fuzzy Q-learning algorithm,ma-FQL)。

1.1 参考指标

对于自优化任务,频谱效率(spectral efficiency,SE)是评估系统性能的常用指标并且频谱效率可以通过每个eNodeB收集到的激活用户的信干噪比值得到。为了实现覆盖与容量的均衡,定义小区综合频谱效率(joint spectral efficiency,JSE)和平均小区综合频谱效率[5](average of joint spectral efficiency)作为参考指标,表示为:

JSEc=SE50%+λSE5%

(1)

(2)

rt+1=JSEavg,t+1-JSEavg,t

(3)

1.2 多agent Q学习算法

设置S为状态空间,A为动作空间,r(s,a1,a2)表示在状态s∈S下执行联合动作a1,a2∈A得到的回报值。agent的目标是为状态s∈S找到最优策略π*(s),从而使效用函数(utility function)R达到最大,效用函数定义为折扣回报的长期和:

(4)

学习算法一般通过更新质量函数Qπ(s,a1,a2)(s∈S,a1,a2∈A)来实现最大化效用函数R。其中,基于策略π的最初状态s0的长期折扣回报期望值通过式(5)得到:

(5)

为了应对高速列车运行快的特点,该文采用联合两个agent的QL算法,Q值更新规则[8]为:

(6)

(7)

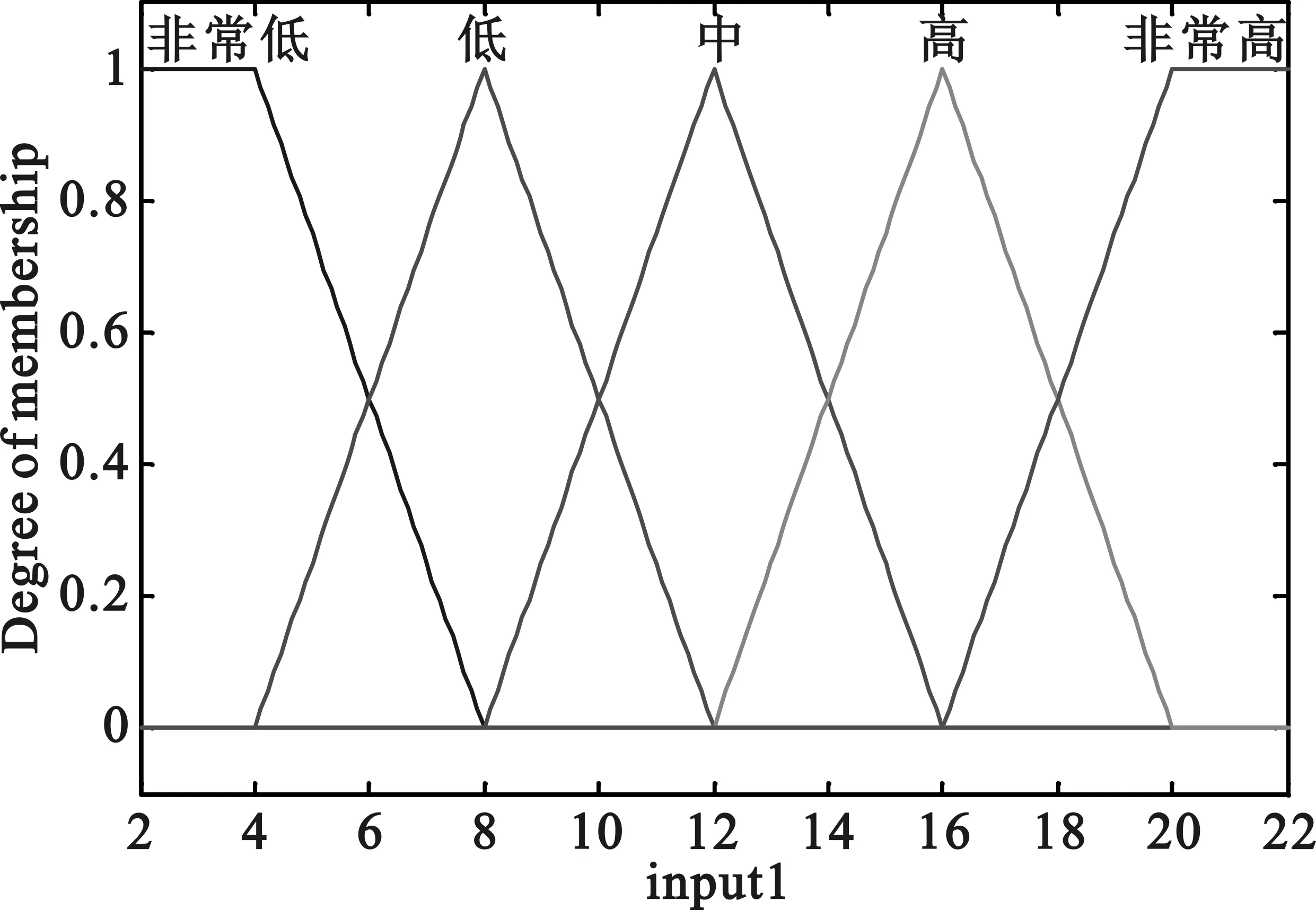

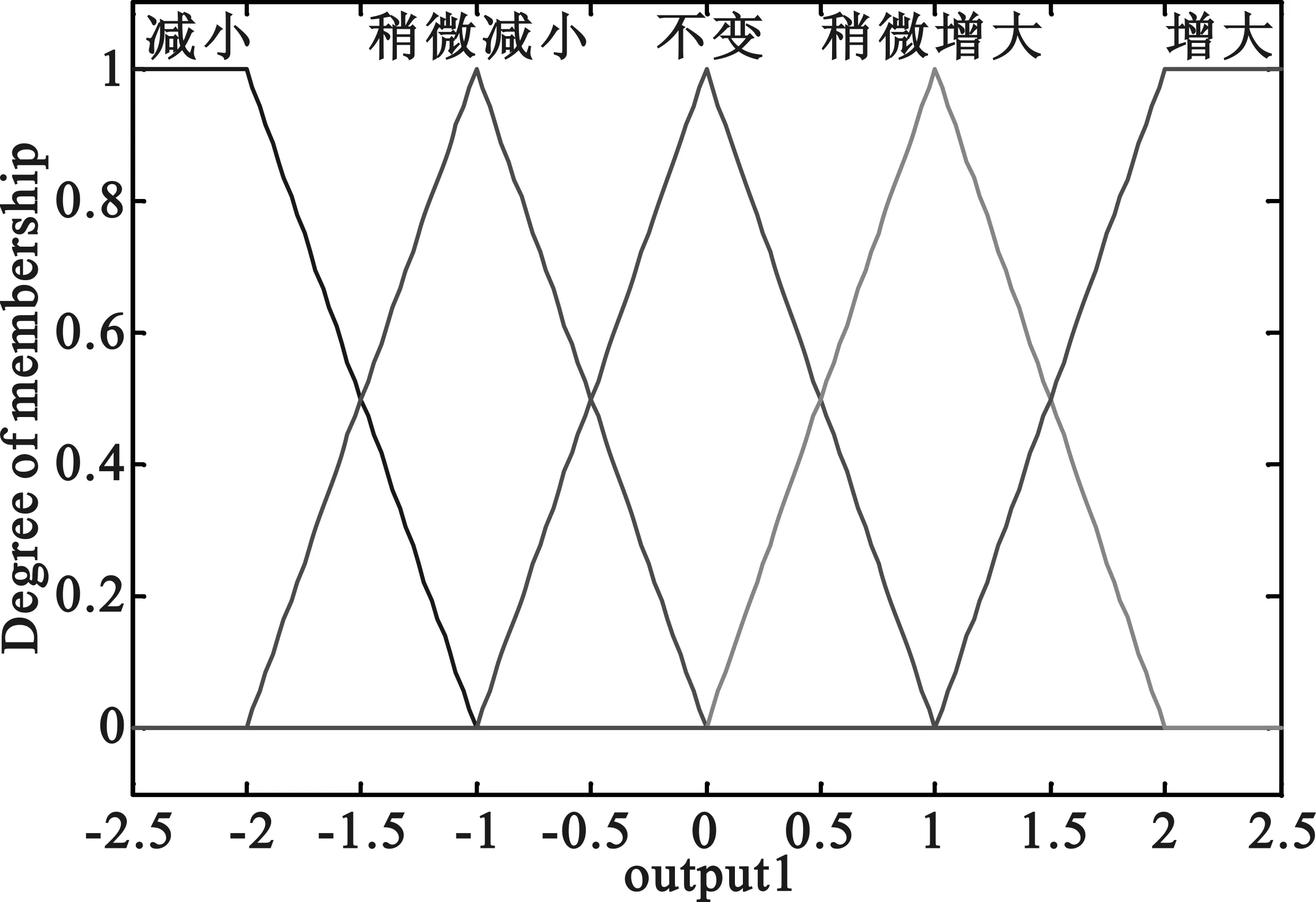

1.3 模糊推理系统设计

模糊推理系统(fuzzyinferencesystems,FIS)的引入使得可以处理连续的状态和动作空间,采用每个eNodeB当前的下倾角作为输入,由5个隶属度函数(membershipfunction)进行模糊化,并把对天线下倾角的调节角度作为输出。FIS模糊规则描述如下:

ifsisSi,then

……

(8)

(a)输入:下倾角

(b)输出:调节角度

(9)

在ma-FQL算法中,状态s通过所选择的动作可以计算出在实际连续域中的动作以及质量函数的值:

(10)

(11)

(12)

质量函数增值ΔQ为:

(13)

最终,FIS规则的q值得到更新:

(14)

2 算法仿真

2.1 仿真设置

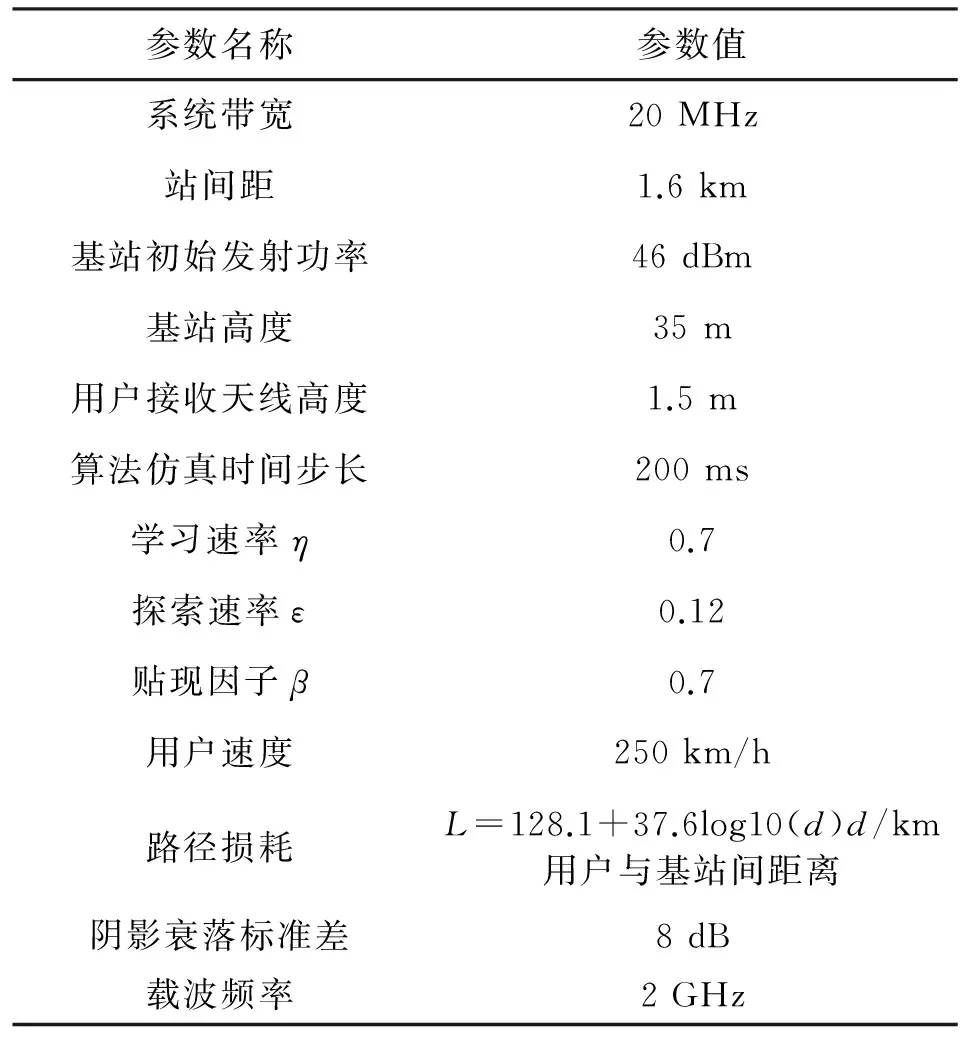

利用Matlab工具箱开发的LTE网络系统级仿真平台进行仿真,该仿真环境基于LTE下行链路,设置3个小区,3个基站,用户以一定的速度穿过该链状小区,仿真关键参数[5,7-10]由表1列出。

表1 仿真参数

为了达到比较的目的,在仿真阶段加入一个参考系统,以及未对小区进行联合优化的传统FQL算法与ma-FQL算法进行性能比较。参考系统设置为一个静态环境,所有小区的天线下倾角固定为15°,系统其他参数设置与表1相同。传统FQL算法没有采用多agent方法对小区进行联合优化,根据算法中回报函数r是小区间的联合回报值[5],或者是单个小区的单独回报值[6],将这两种FQL算法分别定义为FQL-1和FQL-2,为以后进行算法间的性能对比提供方便。

2.2 仿真结果与讨论

该节主要展示仿真结果,图3表示仿真系统中各个算法的小区间综合频谱效率的仿真图。图中,x轴表示仿真步数,每时间步长为200 ms,y轴为小区综合频谱效率(JSE),由式(2)得到。以参考系统为标准,将FQL-1和FQL-2同ma-FQL算法进行比较,从图3可以看出,ma-FQL算法优于FQL-1和FQL-2算法,主要的性能提升体现在对于全局最优的搜索时间上,ma-FQL算法达到理想性能所需的时间步均少于FQL-1和FQL-2算法。由此可知,通过联合调整小区的天线下倾角,使小区间同时对环境做出动作选择的多agent强化学习算法可以使整体网络更快的达到全局最优状态。

图3 小区间综合频谱效率的平均

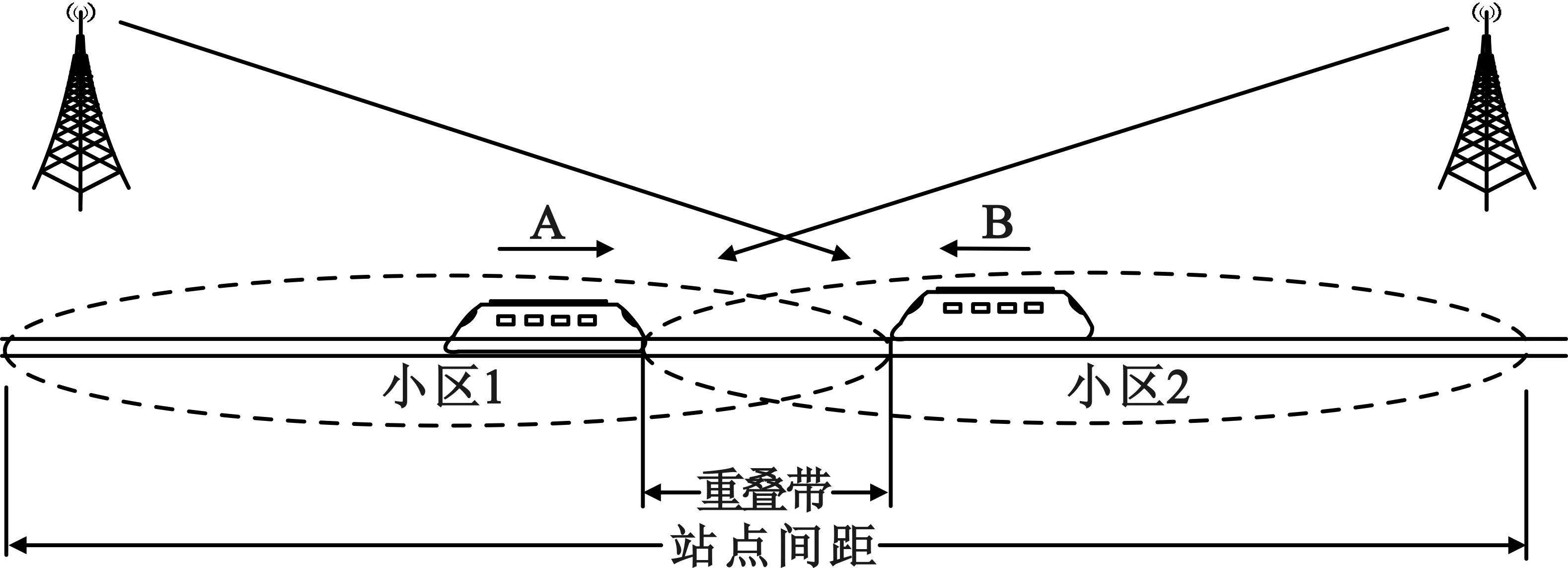

同时,为了进一步展现ma-FQL算法对动态环境中突发不利条件的适应能力,文中设定达到最优状态的列车A,在到达小区1和小区2之间的重叠区域时遇到对向以相同速度驶来的高速列车B,如图4所示。

图4 两车交会示意

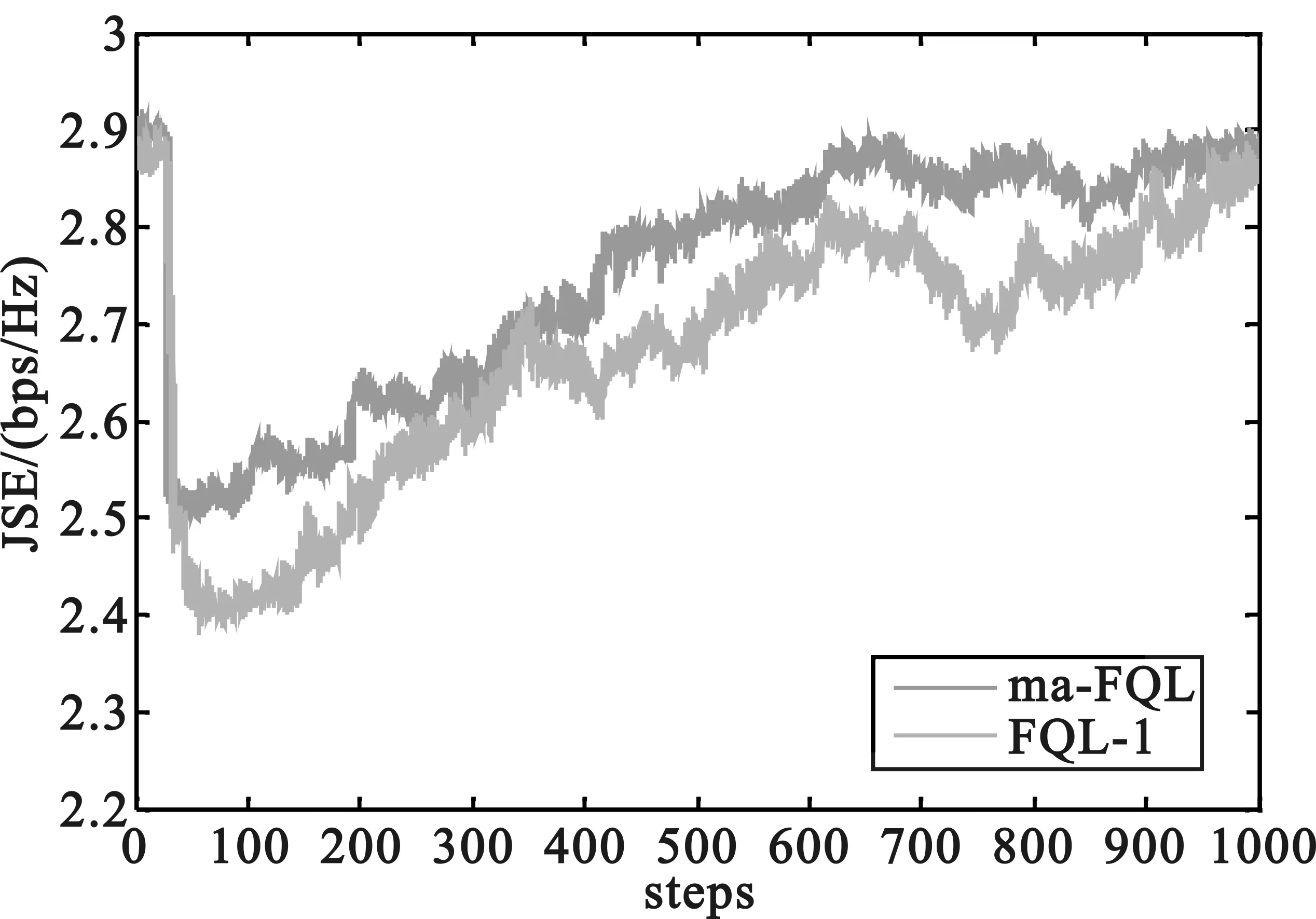

通过 ma-FQL算法与FQL-1对该场景进行仿真,观察两种算法对由于两车交会引起用户数突增而导致的性能的下降的情况的适应能力,从而对算法性能进行比较。两车相遇列车用户性能仿真图如图5所示。

图5 两车交会算法性能比较

图5展示了在大约第40学习时间步两车交会后,ma-FQL算法与FQL-1算法对当前环境变化的应对情况。从仿真图中可以看出,两车交会时由于用户数的突增,用户性能会从之前达到的最优状态下滑到次优状态,虽然两种算法都成功的从突变环境中恢复到了最优状态,但相比较而言,在大约第650时间步时ma-FQL算法就已经恢复到了最优状态,FQL-1算法则在大约1000时间步时才逐步接近最优状态。与FQL-1算法相比,ma-FQL算法的优化速率大约提升了35%,由此可以看出ma-FQL算法在动态环境中具有更强的适应能力,从而印证了多agent模糊Q学习算法的优越性。

3 结 语

高速铁路速度越高,对无线通信的影响越大,优化难度就越大,文中针对高速铁路速度快、用户多的特点,采用多agent方式联合模糊推理系统以及强化学习算法的混合机制,通过多agent的方式联合调整算法涉及到的小区间的天线下倾角,实现铁路沿线覆盖与容量优化的目的。

仿真结果表明,同传统单agent方式相比,多agent方式可以更快的使整体用户性能达到全局最优,减少次优化现象,并且在突变环境的考验下,具有更加显著的适应能力。

[1] 李泰, 李烨.高速铁路场景移动通信系统切换研究综述[J].通信技术,2015,48(05):566-572. LI Tai, LI Ye. Mobile Communications Handover Schemes in High-Speed Railway Scenario[J]. Communications Technology, 2015,48(05):566-572.

[2] Yilmaz O, Hamalainen S, Hamalainen J. Comparison of Remote Eelectrical and Mechanical Antenna Downtilt Performance for 3GPP LTE[C]// Vehicular Technology Conference Fall(VTC 2009-Fall), 2009 IEEE 70th. Espoo, Finland:IEEE, 2009: 1-5.

[3] Engels A, Reyer M, Xu X, et al. Autonomous Self-Optimization of Coverage and Capacity in LTE Cellular Networks[J]. Vehicular Technology, IEEE Transactions on, 2013, 62(5): 1989-2004.

[4] XU S, HOU M, NIU K, et al. Coverage and Capacity Optimization in LTE Network based on Non-Cooperative Games[J]. Journal of China Universities of Posts and Telecommunications, 2012, 19(4): 14-42.

[5] Naseer Islam M, Mitschele A. Cooperative Fuzzy Q-Learning for Self-Organized Coverage and Capacity Optimization[C]// Personal Indoor and Mobile Radio Communications (PIMRC), 2012 IEEE 23rd International Symposium on. Ilmenau, Germany:IEEE,2012:1406-1411.

[6] Razavi R, Klein S, Claussen H. Self-Optimization of Capacity and Coverage in LTE Networks using a Fuzzy Reinforcement Learning Approach[C]//Personal Indoor and Mobile Radio Communications (PIMRC), 2010 IEEE 21st International Symposium on. Istanbul, Turkey: IEEE, 2010: 1865-1870.

[7] LI J, ZENG J, SU X, et al. Self-Optimization of Coverage and Capacity in LTE Networks based on Central Control and Decentralized Fuzzy Q-Learning[J]. International Journal of Distributed Sensor Networks, 2012, 11(2):1018-1020.

[8] HU J, Wellman M P. Multiagent Reinforcement Learning: Theoretical Framework and an Algorithm[C]//ICML’98 Proceedings of the Fifteenth International Conference on Machine Learning. San Francisco, USA: Morgan Kaufmann, 1998: 242-250.

[9] HE R, ZHONG Z, AI B. Path Loss Measurements and Analysis for High-Speed Railway Viaduct Scene[C]// IWCMC’10 Proceedings of the 6th International Wireless Communications and Mobile Computing Conference. New York, USA: ACM, 2010:266-270.

[10] 刘留, 陶成, 陈后金等.高速铁路无线传播信道测量与建模综述[J]. 通信学报, 2014,35(01):115-127. LIU Liu, TAO Cheng, CHEN Hou-jin, et al. Survey of Wireless Channel Measurement and Characterization for High-speed Railway Scenarios.[J]. Journal of Communications, 2014, 35(01): 115-127.

Multi-Agent Fuzzy Reinforcement Learning Algorithm for Wireless Network Coverage and Capacity Optimization in High-Speed Railway

WANG Zi-rui

(School of Electronic and Information Engineering, Lanzhou Jiaotong University,Lanzhou Gansu 730070,China)

In order to enhance the service quality of LTE wireless network along high-speed railway and provide the optimal coverage and capacity performance, based on the traditional single-agent learning algorithm, a fuzzy reinforcement learning algorithm that jointly adjusts the neighboring eNodeB’s downtilt angle for network coverage and capacity optimization by means of multi-agent is proposed. In addition,simulation of LTE network in high-speed scenario indicates that the multi-agent learning algorithm could fairly improve the convergence rate of global optimal configurations in high-speed environment as compared with traditional reinforcement learning algorithm, in particular the restoration rate when dealing with the sudden environmental change.

high-speed railway; coverage and capacity optimization; multi-agent

10.3969/j.issn.1002-0802.2015.11.015

2015-06-21;

2015-10-12 Received date:2015-06-21;Revised date:2015-10-12

TN929.5

A

1002-0802(2015)11-1280-05

王子瑞(1991—),女,硕士研究生,主要研究方向为高速铁路无线网络性能的优化。