计算机自适应测试研究进展与展望

2015-02-19周东岱

路 鹏,丛 晓,宋 克,周东岱

(1.东北电力大学媒体技术与传播系,吉林吉林132012;2.东北电力大学理学院,吉林吉林132012;3.东北师范大学教育部数字化学习支撑技术工程研究中心,长春130117)

计算机自适应测试(Computerized Adaptive Testing,CAT)是根据被试特征进行个性化测试的一种测试形式。从测试的发展历程可以看出,对被试进行自适应测试的思想与测试本身一样悠久,其原型是教育与心理学领域中进行诊断的口试[1],教师遵循可比性原则对被试进行测试或诊断,后来产生的各种项目反应模型都源自于这种朴素的想法。

自适应测试最早的例子可以追溯到20世纪初期由心理学家Binet.Alfred开发的一个智力测试,该测试对被试的反应与项目(item)选择之间的关系进行了精确的描述。他认为,对于一个标准化的测试,只要采用相同的项目选择规则,就可以对所有被试进行合理的评价,没必要为所有被试都提供相同的项目。因此,Binet测试最主要的创新就是直观的反应模型[2]。后来心理学家Louis L.Thurstone[3]在对度量化方法的研究中便使用了Binet测试的数据集。但是,此时教育和心理测试领域已经广泛采用基于经典测验理论的群体测试,并使用观测分数来维护分数的可比性。这种测试形式便于实施,但是却不允许任何适应性的改变。对被试来说,测试中包含的项目太难或者太简单,结果导致测试效率较低。

自适应测试的发展依赖两个方面的不断发展。最主要的是测试基础理论的发展,这方面产生了项目反应理论(Item Response Theory,IRT)。IRT利用项目特征曲线(ICC)对被试在项目上的反应概率分布进行了解释。第一个模型是由Lord提出的双参数正态卵形模型(Normal Ogive Model,NOM)[4],该模型采用正态分布函数来描述ICC,如下式所示:

式中:θ表示被试的能力参数;区分度ai表示和ICC拐点处的斜率K成正比的值;难度bi表示ICC拐点处相对应的能力值。NOM曲线的形状和位置由拐点和斜率两个因素决定,曲线拐点处的斜率越大表示项目的区分度越高,而拐点的位置越靠右表示项目的难度越大。

另外一个著名的IRT模型是Rasch模型[5],该模型中包括能力参数θ和一个项目难度参数b,它将被试在一个项目i上的正确反应概率表示为:

式中:θ表示被试的能力参数;bi为项目i的难度参数,通过校验,bi已被估计的足够精确。

除了以上模型,此后Birnbaum又提出了Logistic模型、Lazarsfeld和Henry提出了潜在线性模型和潜在距离模型、Samejima提出了连续反应模型、Masters提出了部分记分模型等等。IRT的不断发展为自适应测试提供了坚实的理论基础。

除了基础理论,另一方面是计算机技术的发展。早在20世纪70年代,学者们便对使用计算机实施自适应测试进行了有意义的尝试。例如,美国明尼苏达大学的David Weiss对CAT的研究做了开创性的工作[2],而Lord则对计算机化的项目参数估计和项目选择方法进行了研究。自80年代以来,随着计算机技术的发展以及计算能力的不断提高,使其作为测试工具成为可能。使用计算机便于测试中采用复杂的统计方式来估计被试的能力水平并根据能力水平实时的从项目池(item pool)中选择最佳的项目。而对自适应测试的大规模应用则出现于90年代中期,其不仅应用在心理测试上,也广泛应用于大学入学资格考试、职业认证以及军事等领域中。

随着CAT在实际中的深入应用,学者们对于基础理论以及实施过程中面临的实际情况进行了更加深入的思考,不断的推动了测试基础理论和计算机技术的深入应用两个方面不断的向前发展。下面我们对近年来的研究进展进行总结并对未来的发展趋势进行展望。

1 基础理论的发展

近年来,随着IRT在自适应测试中的应用,为了对被试进行更加科学的评价,学者们通过添加重要的参数、修改IRT的基本假设等方式对项目反应模型进行不断的完善,下面对主要的研究内容进行详细介绍。

1.1 项目反应时间

通常情况下,被试在测试项目上的反应时间(response time,RT)不同,更难的项目需要更多的时间。而自适应算法往往为能力水平高的被试提供更加耗时的项目,结果导致测试不够科学合理。因此,在CAT中通过自动记录被试的RT,将RT的差异体现到测验结果之中是新的研究重点。这方面代表性的成果是由Tianyou Wang和Bradley A.Hanson提出的四参数Logistic计时模型[6],具体形式如下式所示:

式中:ρm表示被试m的速度参数,该值越大表示被试m在解决项目时所需时间越多;di是项目i的速度参数,该值越大表示正确解决项目i所需要的时间越多;tmi是被试m在项目i上的反应时间。

通过模型可知,当速度参数ρm和di不变,则随着项目反应时间tmi增大,正确反应概率P随之增大;而在项目反应时间tmi一定的情况下,ρmdi越大则被试m正确作答项目i的概率越小;当tmi趋于无穷时,指数收敛于a(θ-b)。这意味着,即使当时间无限时也并不能保证被试一定会答对项目。因此,该模型更加适用于能力测试。通过该模型可以对限时的能力测试进行合理的项目参数估计、能力估计,并使能力估计快速收敛于真实能力水平。此外,也可以研究被试是否可以解决问题及精度信息和最优的测试策略。

应当指出,该模型仅仅是一个测试过程的部分描述,更完整的描述应该包括RT在项目池中所有项目上的分布,形成更加合适的统计模型。因此,部分学者提出了在能力参数θ和速度参数ρ的联合分布基础上,使用分层框架实现了提高能力估计的收敛速度[7],以及基于被试的项目反应时间遵循正态分布的假设,提出了对数正态RT模型[8]。

使用RT的另一个好处是可以检查CAT中可能存在的异常,例如项目的功能差异、项目中答案的欺骗、项目的先前知识等。对于这些行为,基于传统模型的测试失去了功效,而RT在异常行为上面包括了更多的信息,因此不受此影响[9]。带参数结构的RT模型允许我们根据被试的实际速度调整被试的RT,并且检查他们对测试中的项目反应结果是否符合时间敏感模式。所以,即使对于具有丰富经验的作弊者,都不可能找出有规律的模式。

1.2 多等级评分

到目前为止,大多数可操作的CAT都是基于二级评分项目反应模型的基础上,用以处理客观题[10]。而在实际中,测验更重视被试在主观题上的反应,许多测试项目都是多等级评分的项目,如计算题、论述题等。事实证明,使用多级评分项目比使用二级评分项目可以获取更多的被试信息[11]。因此,采用多点计分模型更加合理。最为著名的多点计分模型为Samejima提出的等级反应模型(Graded Response Mode,GRM)[12],该模型描述如下:设项目 i的满分为S(S ≥ 1),则有S+1 个计分点,x=0,1,2,...,S;表示能力为 θ的那一类被试在项目i上得分不低于x分的概率,令所有得分大于等于x的被试为“通过”(1分),得分小于x的被试为“不通过”(0分),那么就成为二值评分中的项目特征函数;再令在这个模型下,使用两个阶段来获得被试在某一个确定项目上分类得分的概率。

(1)第一个阶段,计算具有能力水平 θ的被试在项目 i上可以接受分数的累计概率,取为 3PLM:

式中:bix为项目i与等级x相关的一个阈值参数,该参数符合约束bix-1<bix<bix+1。对于一个项目,所有的反应曲线共享相同的区分度ai。

(2)第二个阶段,获得被试在一个给定等级上的反应概率。这个概率通过累积概率的相减来获得,如下所示。

图1和图2分别展示了一个三等级项目的运算特征曲线和项目等级反应曲线(a=2,b1=-1,b2=0,b3=1.5,c=0.1)。

图1 项目运算特征曲线

图2 项目的等级反应曲线

基于多级评分的IRT模型突破了过去项目反应模型只能用于二级评分项目的限制。因此,学者们越来越倾向于用多级评分替代传统的二级评分方法,也引起了更为复杂的评分模型的研究。GRM比较适用于一般主客观题的评分形式,数学处理较为方便。在未来的几十年中,GRM在应用和理论探索方面必定会有更加广阔的前景,具有较好的推广价值。

1.3 多维自适应测试

随着IRT在实际工作中的广泛运用,人们渐渐发现传统IRT的单维性假设与许多心理或教育测验的实际情况并不相符[13]。测验数据的多维性与人在完成一项测验任务时需要多种能力的共同配合是相符的,很少有测验只测量单一能力或特质[14]。因此,对多维项目反应理论(Multidimensional Item Response Theory,MIRT)的研究显得十分必要[15],研究者们逐渐转移到多维项目反应模型。尽管这类模型在20世纪60年代就已被提出,然而由于其统计模型复杂,需要计算能力强的设备支持,所以在当时很难使用。但是,随着统计学和计算机技术的发展,这种情况发生了巨大的变化。所以,近年来对多维项目反应理论的研究和使用逐渐流行起来。

Reckase和Mckinley在回顾以往大量MIRT模型基础上,提出了当前最实用的Logistic多维项目反应模型,该模型的项目反应函数为[16]:

式中:θj=(θj1,...,θjk,...,θjm)为被试j的m维能力向量参数,aj=(aj1,...,ajk,...,ajm)是与测验项目区分能力有关的项目参数向量;di是与测验项目难度有关的参数,但意义不同于单维模型中的bi;ci是项目猜测参数。

从模型中可以看出,每个被试有m维能力,而与之相应的,每个项目有m维区分度;但每个项目只有一个猜测度参数ci和一个与项目难度相关的参数di。

所有的项目都需要显示出令人满意的反应模型的拟合,所以自适应测试中多维问题更具主导,应该对其使用多维模型进行建模以及调整自适应测试算法。如果目标是进行诊断,那么每个维度都应该仔细的测试。从一维到多维的自适应测试的改变涉及一个重要的修改,即项目选择标准。例如,基于项目信息函数的项目选择方法在测试过程中存在多个参数,由于信息函数被p×p矩阵所取代(p是项目参数的数目),项目选择过程变得显著复杂[17]。这不仅反应了估计的精度,也反应了它们的相关性。

如何把多维的实体降低到单维的标准取决于实际测试的目的。对于一个二维的测试,应区分三个不同的目标:1)两个维度的能力参数都是主要的,并应该进行精确的估计;2)只有一个参数是主要的,另一个是干扰参数;3)对两个参数进行合并,如它们的(加权)平均。对于这些不同的目标,项目选择以及项目池组装的规则可以使用统计学中的优化设计原则,以优化实验设计或取样程序。

2 计算机技术的深入应用

在CAT的实施过程中,仍面临很多实际的问题,如:1)为了维护测试的有效性,使得项目选择成为复杂的带有大量约束的序列优化问题,如何快速选择最佳的项目;2)项目池面临风险高和成本高的问题,如何自动大规模生成高质量的项目。这些问题的解决都依赖于计算机技术深入应用于自适应测试的实施过程中。

2.1 约束处理

从测量学的视角来看,考虑到测试有效性,实施CAT仅需满足内容要求。而在应用中,自适应测试也必须满足测试安全、测试全面等许多实际的要求。相对于使用特别的方法逐一处理这些具体的要求,近年来学者们思考采用通用的方法同时处理任何类型的要求。这类方法把测试要求作为项目选择方法的约束,把自适应测试作为受约束的组合优化问题的实例[18]。下面,我们对当前几种主要的通用约束处理方法进行论述。

(1)加权离差模型方法

加权离差模型方法(Weighted deviation modeling,WDM)是由Swanson Stocking提出的[19],该方法是一种启发式的项目选择方法。项目选择的目标函数定义为加权离差的和WDM,如下式所示:

式中:K为约束的数目,C为项目和约束之间的关系矩阵,wk表示约束k的权重,wI表示测试信息量的权重;lk和uk代表约束k的下界和上界;dlk为相对于约束下界的差额,duk为相对于约束上界的超额,dI为相对于目标测试信息量It的差额;elk为相对下界的超额,euk为相对于上界的差额。而WDM受到上界约束uk、下界约束lk以及最大信息量约束It三个约束的限制。

WDM方法把项目选择的约束问题转化为数学规划,通过不断的计算上界和下界来选择合适的项目。在WDM方法中,所有的约束差额与信息量差额的和作为总体的目标函数。然而,各种约束差额和信息差额并不在相同的尺度上,如曝光率约束被表达为百分比,而内容约束被表达为数量,因此不应在一起进行比较。此外,该方法需要不断的调整各种边界以达到期望的结果,这样非常耗时[20]。

(2)分层方法

分层方法是由伊利诺伊大学香槟厄巴纳分校教育心理系张华华教授等提出的方法[18]。他们针对CAT中存在的项目曝光率不均匀以及测试内容平衡问题,先后提出了STR_A分层法、STR_B分层法以及STR_C分层法。

1)STR_A分层法。区分度高的项目在测试中的曝光率比较高,因此,STR_A分层法的思路是根据项目区分度对项目池进行分层,然后把测试划分为几个相应的阶段。研究表明,在保证测试精度的情况下,该方法提高了低区分度项目的使用率[21]。但是,由于项目的区分度参数和难度参数经常是正相关的,该方法仍存在部分项目曝光率过高的问题。

2)STR_B分层法。在STR_A方法的基础上,学者们又提出了STR_B方法[22]。在该方法中,按照项目难度把项目池分为若干块,并依照项目区分度把各个块中的项目合并为不同的层。这样,所产生的项目池在各层中的难度分布类似。研究表明,在降低项目曝光率和提高项目池使用率方面,STR_B方法优于STR_A方法,但是仍未解决内容平衡问题。

3)STR_C分层法。为了解决内容平衡问题,学者们提出了STR_C[23]。该方法在对项目池进行分层的过程中同时考虑了项目区分度、项目难度和测试内容三个因素,根据测试内容把一个项目池分为若干组;然后在每个组中使用STR_B方法来获得所有阶层。这样,设计的项目池在各层的内容覆盖与整个项目池是相似的,以此来解决内容平衡问题。

分层方法在曝光控制和内容平衡方面具有很大的进步。然而,测试之前需要对项目池进行排序、分组、分块、分层和组装等操作,因此需要大量的计算时间。当面对不同的被试对象以及项目池更新时需要重新排序以及组装等,使得教师把过多的精力用在前期的准备中,不便于实施。

(3)Shadow-test方法

针对项目选择过程中所面临的约束问题,van der Linden等提出了Shadow-test方法[24]。该方法首先从项目池中选择一个完整的测试,它满足所有的约束;然后根据被试的初始能力水平θ0从这个测试中选择最佳的项目;接着记录被试对项目的反应并对其能力水平进行重新估计;根据新的能力水平θ1重新组装测试;重复以上步骤直到测试结束。

完整的CAT被不断重组装为Shadow-test,在实施过程中,它们仅作为项目选择的中间步骤,如图3所示。

图3 使用shadow-test方法进行自适应测试

由于每个Shadow-test满足了所有的约束,并在测试过程中从Shadow-test中使用了最佳的项目,所以给定约束下自适应测试也是最佳的。研究表明,由于该方法选择最优项目的速度远远快于无约束的自适应测试[24]。此外,学者们也对控制被试速度[25]、保证项目池中项目曝光率[26]等很多实际的约束进行了研究。

(4)循环题库法

针对约束问题,部分研究者从项目池构建的角度提出了循环题库方法(Rotating Item Pools,RIP)[27]。该方法通过两个阶段来构建题库来处理所有的约束。

1)第一阶段:把题库中的项目分配到临时集合中。通过目标函数计算题库中任一对项目之间差异并最小化,把题库划分为两个相似的临时集,以此类推。具体的,可以采用顺序分配或者采用启发式方法同时进行分配。

2)第二阶段:把临时集合中的项目分配到子题库中。根据不同的使用目的,可以构造非重叠题库或重叠题库。具体方法可以采用随机分配方法或者数学规划方法。

循环题库法从题库的设计角度来解决约束问题。在测试前,通过把总题库划分为各种参数几乎相同的子题库为被试使用。在测试过程中,系统从不同的子题库中为被试选择合适的项目。然而该方法也存在一些问题,如测试开始前需要花费大量的时间在子题库的划分上以及需要针对被试的规模设计子题库的数目。

(5)最大优先指数法

最大优先指数法(Maximum Priority Index,MPI)[28]把所有的约束变量进行加权之后与项目最大信息量MI的值相乘,形成积PI。用这个最大化的积PI代替MI作为衡量项目的指标,乘积越大则项目的优先级越高。通过下式计算项目的优先指数:

式中:K为所有约束的总数;C表示项目与约束的关联矩阵;Ii为项目i的信息量;其余部分为与该项目相关约束的权重积,fk表示约束k的剩余配额,wk表示约束k的权重。在实际中,采用两阶段的项目选择框架来处理每个灵活的约束(同时涉及上界与下界)。在第一个阶段处理下界,在第二个阶段处理上界,而每个阶段中计算fk的方法不同。

MPI方法可以处理多种约束,计算的效率也比较高。重要的是,该方法中的目标函数为所有约束的fk与信息量的乘积,因此所有的优先指数都是在相同的尺度上,便于项目之间的比较。然而,作为一种启发式的方法,它不能保证所选择的项目一直都是最佳的。

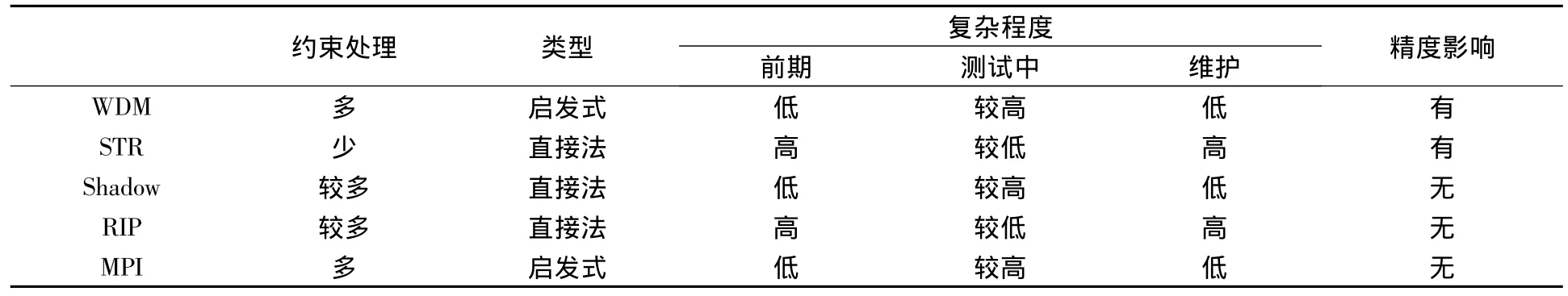

下面从约束处理、方法类型、复杂程度和精度影响四个方面对以上几种方法进行对比,结果如表1所示。

表1 项目选择方法对比分析

通过以上对比分析可以看出,启发式方法可以同时处理项目曝光率、内容平衡等多种约束,而其它方法主要针对部分约束问题进行了解决;在实施的复杂程度上,这类方法也比较简单;由于考虑到多种约束问题,启发式方法在项目选择时的计算量比较大。总体来说,启发式方法是约束处理方面比较好的方法,是以后的研究重点。

2.2 基于规则的项目生成技术

在传统的测试中,需要针对一次具体的测试开发相应的项目并进行预测试。如果CAT也按照这样的思路,那么每一次新的测试都需要更换整个项目池,这样会涉及大量的资源(人力、财力等);而如果被试连续使用同一个项目池进行测试,结果会导致安全风险。对于这个问题,早期的解决方案是使用项目曝光控制技术来保证测试安全以及更好地利用项目池。但是学者们随后意识到,这类方法虽然可以提高项目池中项目的使用率,但往往很难使用[29]。一个更加根本的解决办法是采用一定的规则自动生成大规模的、高质量的项目。早在20世纪60年代,学者们就已经对基于规则的项目生成技术进行了研究[30]。而随着计算机技术的发展,采用计算机化的方法自动生成项目并直接用于CAT中的可能性促使学者们对这一领域进行了深入的研究。

目前,学者们已经研究了多种类型的项目自动产生方法,最具代表性的方法是使用项目模板[31]。

在这种方法中,通过选择出一批高质量的项目成为模板,每个项目中的一些元素(例如:题干中的部分内容、正确答案等)都被相应的集合所替代。通过目标并利用规则形成若干项目族(item family),这样,整个项目池便由若干项目族组成,如图4所示。

图4 项目池中的项目族

实际中,采用两阶段的项目选择过程进行自适应测试:首先根据当前估计的被试能力θ,利用项目池中不同项目族之间的差异选择一个最佳的项目族;再从这个族里随机产生一个项目提供给被试进行测试,这样做的目的是期望产生较小的族内部的差异。因此,需要把项目反应模型修改为一个具有两级结构的模型。设项目族为f=1,…,F,族f中的项目表示为if。则对于Rasch模型,适当的两级结构表示为:

式中:每一个族f的难度参数b为正态分布(平均值μf、方差)。这样,可以通过参数μf来获得不同项目族之间的差异,而通过参数获得每个族内部项目之间的差异。

基于规则的项目生成方法一个未解决的问题是项目前测的代价。部分研究者认为,由于从一个项目的参数自动产生其它项目的参数,所以可以省去一些前测活动。而实际上,由于自动生成的项目涉及更加广泛的项目审查、项目校验以及不同项目族之间的项目参数差异很大,所以其代价远远高于由教师自主开发的项目。而在这个模型下,项目校验就转变为项目族校验。因此,对项目校验代价的节省与项目样本的数量以及从族中生成项目的总数两方面的差异直接相关。

目前,对基于规则的项目产生的研究包括,通过一组有限的规则可以生成大量的测试项目并进行图形推理[32],采用贝叶斯估计方法进行项目族校验进行了研究[33],将三参数Logistic的项目池建模为项目族集合的方法[34]。因为广阔的应用前景,基于规则的项目生成方法的研究逐渐成为CAT领域中的一个新的研究热点[35]。

3 总结与展望

随着项目反应理论以及计算机技术两个方面的发展,也不断促进了CAT的发展,取得了很多重要的研究成果。通过项目反应理论解释了被试在项目上的反应概率分布,实现了根据被试的反应从项目池中适应性的项目选择以及自动的进行能力参数估计,却并有失去分数的可比性;而通过计算机技术,使得采用复杂的统计方式进行实时的被试能力估计和选择最优的项目成为可能。

虽然自适应测试取得了长足的进步,但在多年的实际应用中也逐渐暴露了一些问题和不足,有待于进一步研究和完善,主要集中在以下几个方面:

(1)更加合理的项目反应模型。针对大多数测试项目均是多级评分、在项目解决上被试会运用多种能力、被试的反应时间也体现出了被试能力上的差异等实际情况,不论是等级反应模型、计时模型,还是多维项目反应理论都仅从一个侧面提出了解决方案,还没有一个统一的模型来解决这些问题。因此,有必要结合认知心理学、统计学等对项目反应模型进行更加深入的研究,提出更加符合被试特征并且能够实际应用的项目反应模型。

(2)通用的约束处理方法。像标准化的线性测试一样,为了维护测试的有效性,CAT不得不满足广泛的约束。相对于使用特别的算法来注意处理各个约束,应提出一种通用的约束处理方法,并且仍可以保证比较高的执行效率,不影响用户体验。人工智能领域的启发式算法计算高效,可以避免计算量过大和不可行性两个问题,为约束处理提供了可行的解决方案。虽然该方法得到最终结果不一定是“最优”的,但通过适当延长测试长度仍可以保证测试精度。

(3)项目池的组织与建设。采用项目模板并基于规则自动的生成高质量的项目以及通过分析测试记录对项目的参数进行维护,可以降低项目的开发成本;此外,采用本体技术构建领域本体,完整描述测试领域的详细知识点或内容之间的详细关系。在此基础上,教师根据构建的本体把开发的项目分配的相应的知识点上。通过两者的结合,以保证测试项目与内容域的关系更加的合理。

(4)认知诊断与评估。认知诊断与评估是CAT的一个重要发展方向,通过诊断不仅可以获得常规的测试分数,而且在评价被试心理特质方面,提供了更加细致的评估结果。对此,可以采用多维项目反应理论与人工神经网络相结合的方法形成新的认知诊断模型,实现对被试特定认知领域的技能和知识、知识结构和认知过程的测量。

以上是CAT在未来一个阶段内的发展趋势,如何在实际中更好的实施自适应测试还有待进一步的研究和探索。我国《教育信息化十年发展规划(2011-2020)》发展任务部分中的提高教育管理公共服务质量与水平明确指出“…,完善国家教育考试评价综合信息化平台,支持考试招生制度改革…”。因此,通过对CAT基础理论与相关支撑技术的深入研究,促进CAT的发展,对于学生综合素质的评价以及教育教学的发展具有重要的现实意义。

[1]L·克罗克,J·阿尔吉纳.经典和现代测验理论导论[M].上海:华东师范大学出版社,2004.

[2]WimJ.van der Linden.Some New Developments in Adaptive Testing Technology[J].Journal of Psychology,2008,216(1):3-11.

[3]Thurstone,L.L.A method of scaling educational and psychological tests[J].Journal of Educational Psychology,1925,16(7):433-451.

[4]路鹏,周东岱,钟绍春,丛晓.面向多类终端的计算机自适应测试系统的设计与实现[J].现代教育技术,2012,22(6):88-92.

[5]Rasch,G.Probabilistic models for some intelligence and attainment tests[M].Chicago:University of Chicago Press,1960.

[6]Tianyou Wang,Bradley Allanson.Development and calibration of an Item Response Model that Incorporates Response Time Applied Psychological Measurement[J].2005,29(5):323-339.

[7]Van der Linden,W.J.Using response times for item selection in adaptive testing[J].Journal of Educational and Behavioral Statistics,2008,33(1):5-20.

[8]Van der Linden,W.J.A lognormal model for response times on test items[J].Journal of Educational and Behavioral Statistics,2006,31(2):181-204.

[9]Van der Linden,W.J.,&Guo,F.Bayesian procedures for identifying aberrant response-time patterns in adaptive testing[J].Psychometrika,2008,73(3):365-384.

[10]罗芬,丁树良,王晓庆.多级评分计算机化自适应测验动态综合选题策略[J].心理学报,2012,44(3):400-412.

[11]陈平,丁树良,林海菁,等级反应模型下计算机化自适应测验选题策略[J].心理学报,2006,38(3):461-467.

[12]Samejima,F.Estimation of ability using a response pattern of graded scores[J].Psychometrika,1970,35(1):139-139.

[13]Reckase,M.D.Multidimensional Item Response Theory[M].New York:Springer-Verlag,2009.

[14]康春花,辛涛.测验理论的新发展:多维项目反应理论[J].心理科学进展,2010,18(3):530-536.

[15]涂冬波,蔡艳,戴海琦,等.多维项目反应理论:参数估计及其在心理测验中的应用[J].心理学报,2011,43(11):1329-1340.

[16]Reckase,M.D.,& McKinley,R.L.Some Latent Trait Theory in a Multidimensional Latent Space[M].Iowa City,IA:American College Service.1982.

[17]Mulder,J.,& van der Linden,W.J.Multidimensional adaptive testing with optimal design criteria for item selection[J].Psychometrika,2009,74(2):273-296.

[18]路鹏,周东岱,钟绍春,等.基于模拟退火算法的计算机自适应测试项目选择方法研究[J].计算机应用与软件,2012,29(10):175-179.

[19]Swanson,I.,& Stocking,M.I.A model and heuristic for solving very large item selection problems[J].Applied Psychological Measurement,1993,17(2):151-166.

[20]Leung C.K.,Chang,H.H.andHau,K.T.Computerized adaptive testing:A mixture item selection approach for constrained situations[J].British Journal of Mathematical& Statistical Psychology,2005,58(2):239-257.

[21]Hau,K.T.,& Chang,H.Item selection in computerized adaptive testing:Should more discriminating items be used first?[J].Journal of Educational Measurement,2001,38(3):249-266.

[22]Chang,H.,Qian,J.,& Ying,Z.a-stratifiedmultisage CAT with b-blocking[J].Applied Psychological Measurement,2001,25(4):333-341.

[23]Yi,Q.,& Chang,H.a-stratified CAT design with content blocking[J].British Journal of Mathematical and Statistical Psychology,2003,56(2):359-378.

[24]van der Linden,W.J.Linear models for optimal test design[M].New York:Springer-Verlag,2005.

[25]van der Linden,W.J.,Breithaupt,K.,Chuah,S.C.,& Zhang,Y.Detecting differential speededness in multistage testing[J].Journal of Educational Measurement,2007,44(2):117-130.

[26]van derLinden,W.J.,& Veldkamp,B.P.Conditional item exposure control in adaptive testing using item-ineligibility probabilities[J].Journal of Educational and Behavioral Statistics,2007,32(4):398-418.

[27]Ariel,A.,Veldkamp,B.P.,& van der Linden,W.J.Constructing rotating item pools for constrained adaptive testing[J].Journal of Educational Measurement,2004,41(4):345-360.

[28]Cheng,Y.,& Chang,H.The maximum priority index method for severely constrained item selection in computerized adaptive testing[J].British Journal of Mathematical and Statistical Psychology,2009,62(2):369-383.

[29]Chang,H.,& Ying,Z.a-Stratified multistage computerized adaptive testing[J].Applied Psychological Measurement,1999,23(3):211-222.

[30]Osburn,H.G.Item sampling for achievement testing[J].Educational and Psychological Measurements,1968,28(1):95-104.

[31]Irvine,S.H.,&Kyllonen,P.C.(Eds.).Item generation for test development[M].Mahwah Erlbaum,2002.

[32]Freund,Ph.A.,Hofer,S.,&Holling,H.Explaining and controlling for the psychometric properties of computer-generated figural matrix items[J].Applied Psychological Measurement,2008,32(3):195-210.

[33]Sinharay,S.,Johnson,M.S.,& Williamson,D.M.Calibrating item families and summarizing the results using family expected response functions[J].Journal of Educational and Behavioral Statistics,2003,28(4):295-313.

[34]Glas,C.A.W.,& van der Linden,W.J.Computerized adaptive testing with item cloning[J].Applied Psychological Measurement,2003,27(4):247-261.

[35]王欣,张毅.基于“项目驱动”的新型教学模式研究[J].东北电力大学学报,2012,32(2):108-111.