一种基于滑动窗口优化算法的行人检测算法

2015-02-19邵奇可颜世航

邵奇可,李 路,周 宇,颜世航

(浙江工业大学 计算机科学与技术学院,浙江 杭州 310023)

一种基于滑动窗口优化算法的行人检测算法

邵奇可,李路,周宇,颜世航

(浙江工业大学 计算机科学与技术学院,浙江 杭州 310023)

摘要:行人检测是计算机视觉中的关键技术之一,在智能交通领域有大量实际应用,如何在提高行人检测精度的同时提高检测速度一直是研究的热点.首先采用基于高斯混合模型的背景建模方法分离出运动目标,将原始视频序列转换为二值图片,得到大量固定大小的训练样本;然后提取样本图片的HOG特征,通过SVM训练得到分类器;接着用固定大小的滑动窗口检测行人,并提出了一种滑动窗口优化算法来筛选检测结果;进而用前景像素密度估算方法调整检测结果,输出最终统计人数,最后实验表明方法的有效性。

关键词:行人检测;高斯混合模型;HOG;背景建模

Pedestrian detection in videos based on optimization

algorithm using sliding window

SHAO Qike, LI Lu, ZHOU Yu, YAN Shihang

(College of Computer Science and Technology, Zhejiang University of Technology, Hangzhou 310023, China)

Abstract:Pedestrian detection is one of the key technologies in computer vision. It has applied in intelligent transportation field widely. How to improve the detection precision as well as the detection speed is a hot research topic. Background modeling method based on Gauss mixture model is used in this paper to separate the moving target from the background. Then the original video sequence can be converted into binary image for training. Then the HOG feature in the sample images are extracted through the Support Vector Machines. A size-fixed sliding window is used to detect pedestrians. Here an optimization algorithm using sliding window is proposed to screen the test results. Then the foreground pixel density estimation method is used to adjust the detection result. Finally the experimental results show the proposed method is effective。

Keywords:pedestrian detection; Gaussian mixture model; HOG; background modeling

随着计算机视觉技术的发展,基于行人检测技术的应用给人们的生活和出行带来了诸多便利[1-2],尤其是在城市智能交通领域中的应用,对开展交通规划和控制人流起着至关重要的作用[3].近年来,行人检测技术的应用领域也在不断扩展[4-6],这对行人检测技术提出了更高的要求,复杂的环境(如光照变化,遮挡,天气变化等)下,如何提高行人检测的速度以及精度一直困扰着众多研究者[7].目前行人检测方法主要有基于运动特性的方法、基于模版匹配的方法以及基于机器学习的方法等.大多数基于运动特性的方法为了提取运动节奏特征要求一些重要部位(如腿、脚)是可见的,这对检测目标有了过高的要求,在复杂场景下很难得到保证.Pedro F. Felzenszwalb等提出的图形结构匹配算法是基于模版匹配的典型代表,该算法能较准确地检测出复杂的行人姿态,但是匹配算法过于复杂,匹配速度过慢,且对复杂环境下的匹配精度无法保障[8].文献[9]中Broggi等人提出了一种基于形状的局部匹配算法,以大量不同大小的二值图像为模板,对人的头肩部分进行建模用于匹配和识别行人,提高了检测速度,但这个方法过于依赖模版的质量.Mohan和Poggio提出的通过检测人体部位来检测行人的算法是基于机器学习的方法,能兼顾检测速度和检测精度,但训练阶段工作量过于庞大[10].针对训练工作量大且耗时的问题,文献[11]中提出了一种基于场景模型与统计学习的鲁棒行人检测算法,利用GMM(Gaussian mixture model)来建模[12],用Haar-like特征描述行人特征,以AdaBoost级联结构作为分类器,并提出一种改进的弱分类器选择算法,提高了弱分类器选择和分类器重新训练的速度.Dalal和Triggs提出的HOG(Histogram of oriented gradients)行人检测算法有很好的检测效果[13],为之后的行人检测算法建立了良好的基础,但HOG行人检测算法对于检测场景与训练样本有较高要求,场景的变化会对检测精度和检测稳定性造成影响,并且检测速度过慢。

鉴于目前的研究状况,笔者提出了一种基于滑动窗口优化的行人检测算法,前期通过高斯混合模型的背景建模方法提取目标[14],降低背景因素的干扰,减少负样本的训练量,同时缩减检测区域,提高检测速度;然后提取目标的HOG特征[15],用SVM(Supportvector machines)训练大量样本得到自己的分类器[16],再用固定大小的滑动窗口检测行人;并提出了滑动窗口距离优化算法对检测到的行人进行筛选,最后通过特定的前景像素密度估计方法调整检测结果[17],进一步提高检测精度,输出最终统计人数。

1总体概述

文中行人检测算法是基于机器学习的行人检测研究方法,前期需要对摄像机进行标定,检测距离在3~7 m之间。

具体步骤如下:

Step 1:读入特点区域视频序列,用基于高斯混合模型的背景建模方法处理,得到大量二值图片。

Step 2:从处理后图片中截取固定大小为64×128像素的样本图片,提取正负样本图片的HOG特征,训练自己的分类器。

Step 3:读取待测区域的视频序列,结合自己训练的分类器,用固定大小的滑动窗口遍历图片,检测行人目标,将检测到的目标存入内存。

Step 4:用滑动窗口距离优化算法筛选检测到的目标,调节阈值,去除一个目标重复检测和一个检测窗口多个分离目标的情况。

Step 5:用前景像素密度估计的方法调整检测结果,输出最终人数。

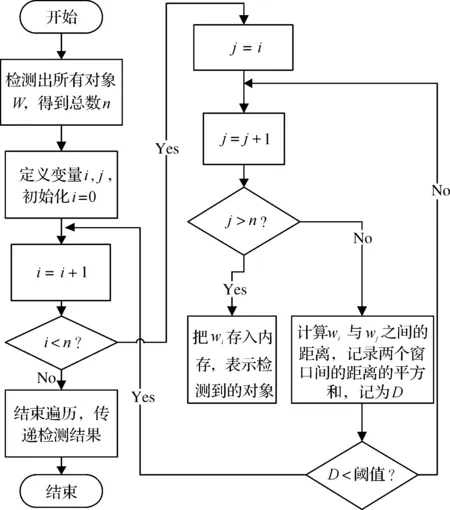

系统的总体流程图如图1所示。

图1 系统总体流程图Fig.1 The overall flow chart

Step 2中图片的HOG特征计算公式如下:

图像某点(x,y)水平方向梯度值Gx(x,y)方程式为

Gx(x,y)=H(x+1,y)-H(x-1,y)

(1)

垂直方向梯度值Gy(x,y)为

Gy(x,y)=H(x,y+1)-H(x,y-1)

(2)

式中H(x,y)为图像原始点像素值。

梯度值G(x,y)为

(3)

梯度方向∂(x,y)为

(4)

Step 3的检测结果为固定大小的滑动窗口检测到的所有目标,其中包括很多重复检测,Step 4是笔者提出的优化算法用于去除重复检测的目标,并保证一个检测窗口中不存在多个分离的目标,Step 5是针对一个窗口中有多个重叠的目标而加入的人数调整方法,具体内容将在下节展开。

2滑动窗口距离优化算法和前景像素密度估计方法

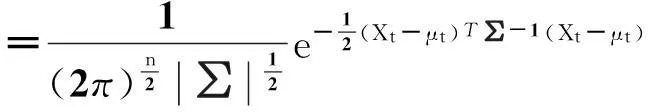

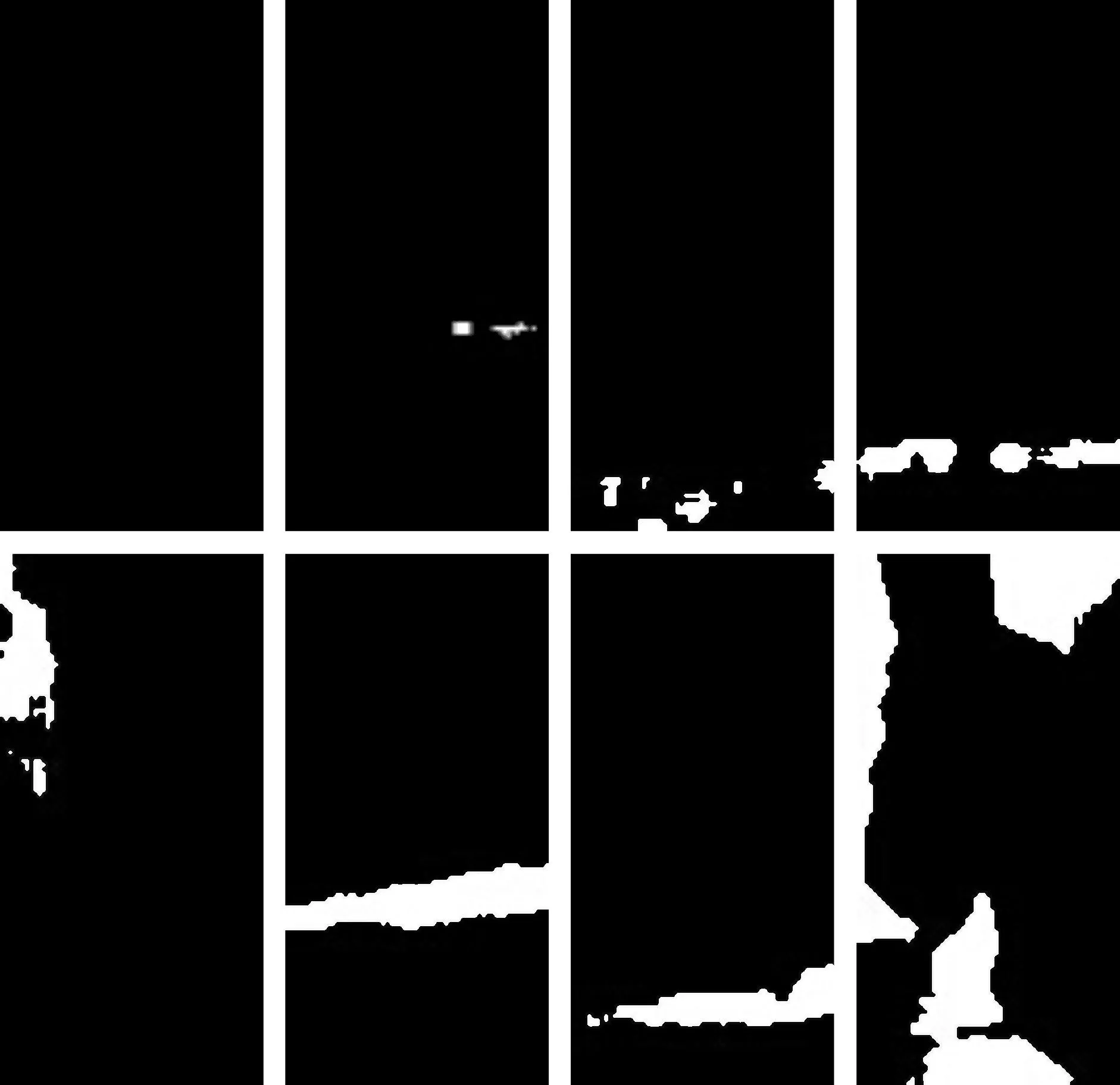

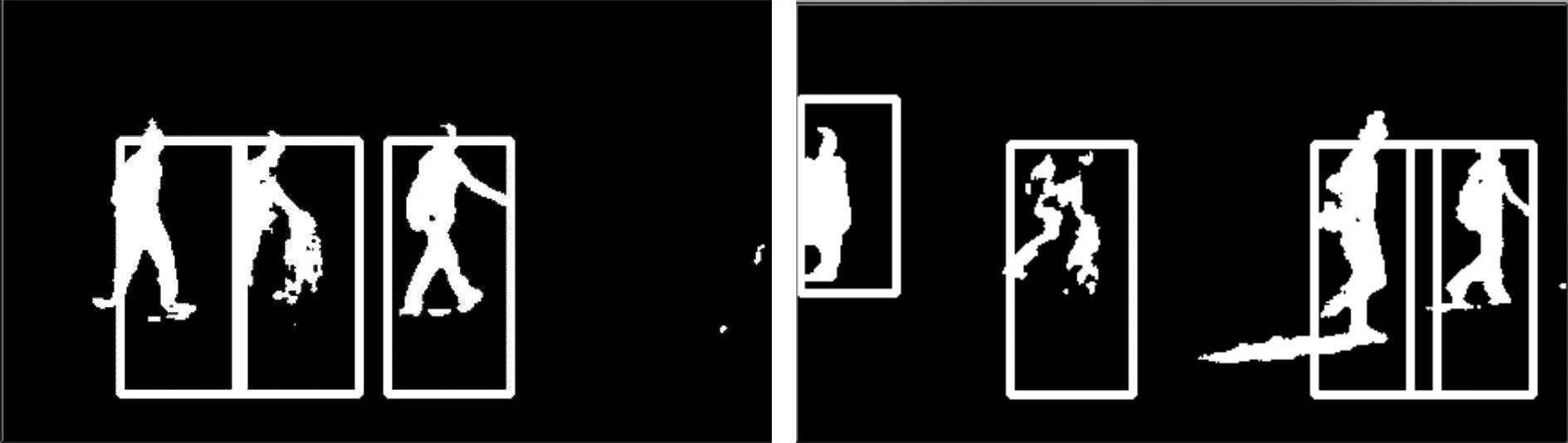

用固定大小的滑动窗口检测出所有对象W,定义一个变量i(0≤i 图2 滑动窗口优化算法流程图Fig.2 The flow chart of optimization algorithm using sliding window 测试可知:在当前场景下,阈值取值为410~600时,检测效果最佳,误检和漏检率最低,在研究过程中,为了能检测到完整行人,为后续用前景像素密度估计的方法调整检测结果作铺垫,将阈值D设置为510.另外,由于对滑动窗口间距离的优化,有效去除了两个人不互相遮挡但在一个检测窗口的情况,笔者对1 000张不同图片进行测试,都不存在此类情况,证明了算法的可靠性。 在前后两人出现遮挡的情况下,由于无法通过距离优化算法将两人分开检测,采用了前景像素密度估计的方法来调整检测结果[17].将经过距离优化算法检测后的结果取出来,遍历整个窗口,统计所有像素值为255的点,将统计数量记为N,检测到的矩形窗口大小记为S,并将N/S的值作为调节阈值,记为TH,经检测,当TH<0.28,检测窗口内只有一个人,当0.28 3分类器的训练与检测结果 样本主要来自校园人行道,公路人行道以及公交站台等行人较多的场合,摄像机需要提前标定.为了得到检测目标并尽量减少背景因素的干扰,笔者采用基于混合高斯模型的背景建模来处理视频序列。 对于视频帧中的某一点p(x,y),在一段时间内,它的像素值序列{X1,…,Xt}可以用K个混合高斯分布来描述.其中Xt表示t时刻点p的像素值.点p在t时刻的概率分布为 (5) 式中:K为该模型中高斯分布的个数;ωi,t为t时刻第i个高斯分布的权重;μi,t为t时刻第i个高斯分布的均值;∑i,t为t时刻第i个高斯分布的协方差矩阵;η为一个高斯概率密度函数,即 (6) 这里采用OnlineK-means算法初始化参数μ、ω和∑,具体如下: 1) 猜测每一类别的均值,标记为{m1,m2,…,mk}。 2) 为每一个类别设置一个计数变量,标记为n1,n2,…,nk,并且初始化为0。 4) 用各类的均值作为μ,并计算协方差∑,样本的比例作为ω。 每个新到达的像素值Xt+1,都会与K个高斯分布进行比较,直到找到匹配的分布为止.匹配的条件为 (7) 式中k普遍认为取值为2.5时效果最佳。 当匹配过程结束时,若匹配到某个高斯分布时,更新如下: ωi,t+1=(1-α)ωi,t+α (8) μi,t+1=(1-ρ)μi,t+ρ·Xt+1 (9) (10) 式中:α为学习率,取值范围为0~1,初始化背景时若α过大,虽然有利于背景模型的建立,但是背景模型建立后会导致模型不稳定,而过小则不利于模型的建立,此处取值为0.02;ρ=α·η(Xt+1,μi,∑i)为权值更新率.每次更新完成后,重新对高斯混合分布按从高到低的顺序进行排序。 当未匹配到某个高斯分布时,用新的高斯分布代替最小的高斯分布,参数作相应修改。 经过基于混合高斯模型的背景建模方法处理视频序列后,得到大量二值化图片,从中提取正负样本来训练得到自己的分类器。 笔者共训练了5 000张正样本,2 115张负样本.其中正样本是形态各异的行人,负样本是各种带有噪声点的背景图片以及正样本中误检的图片,图3是部分正样本图片示例,图4是部分负样本图片示例。 图3 部分正样本图片Fig.3 Part of the positive samples 图4 部分负样本图片Fig.4 Part of the negative samples 采用大小为64×128像素的样本图片来训练分类器,每8×8个像素为一个单元,梯度方向(0~180度)分为9个,每个20度,再对单元内各个像素所属方向做一个投票统计,得到的票数就是该像素的边缘强度.每2×2个单元构成一个块,块每次滑动的步长为一个单元(即8个像素),如此,每个块中有4×9=36个特征,水平方向有7个步长,竖直方向有15个步长,共36×7×15=3 780个特征,对各个块的梯度方向加权直方图进行统计后,得到每个块的特征,把检测窗口内所有的块的特征串联起来,就构成了人体特征向量。 利用SVM训练得到分类器后,用固定大小的滑动窗口遍历整个待检图片,检测窗口中是否有目标,若检测到目标则存储到内存,再用滑动窗口距离优化算法对检测到的行人进行筛选,将筛选结果传递,最后通过特定的前景像素密度估计方法调整检测结果,输出最终统计人数。 笔者共测试了1 000张行人图片并与原始HOG算法检测效果进行比较,原始HOG算法检测效果如图5所示,笔者方法的检测效果如图6所示。 图5 HOG检测算法检测效果Fig.5 The effect of HOG algorithm 图6 笔者方法的检测效果Fig.6 The effect of this method 在1 000张测试图片中,同样的训练样本,检测的结果如表1所示。 表1 检测效果比较 从以上检测结果可知:当两个检测目标分离较远时,原始HOG算法能有效地检测出运动目标,但当两个目标距离接近时,原始HOG算法会出现漏检或误检现象.而提出的算法在两个目标靠近时仍能精确地检测出目标,在检测精度上有了很大的改进。 同时,检测结果显示检测一帧视频序列的时间一般在140~260 ms(已将前期用混合高斯建模处理视频时间约3 ms/帧计入)之间,而普通HOG算法检测行人需要1 s以上的时间,可见在检测速度上也有明显的提升,符合实时性的要求。 4结论 提出了一种高效且较精确的行人检测算法,用基于混合高斯模型的背景建模方法削弱背景的干扰,用HOG来描述行人特征并训练自己的分类器,用固定大小的滑动窗口来检测行人,同时提出了一种滑动窗口优化算法来筛选检测结果,提高检测精度,最后用前景像素密度估计的方法调整检测结果,进一步提高检测精度.在理论上分析和实际应用中,都具有良好的检测效果.下一步研究工作主要是在确保检测精度的基础上,进一步提升高密度人群的检测精度。 参考文献: [1]汤一平,陆海峰.基于计算机视觉的电梯内防暴力智能视频监控[J].浙江工业大学学报,2009,37(6):591-597。 [2]陈敏智,汤一平.基于支持向量机的针对ATM机的异常行为识别[J].浙江工业大学学报,2010,38(5):546-551。 [3]王为,姚明海.基于计算机视觉的智能交通监控系统[J].浙江工业大学学报,2010,38(5):574-579。 [4]SILBERSTEIN S, LEVI D, KOGAN V, et al. Vision-based pedestrian detection for rear-view cameras[C]//Intelligent Vehicles Symposium Proceedings. Dearborn: IEEE publisher,2014:853-860。 [5]PRIOLETTI A, MOGELMOSE A, GRISLIERI P, et al. Part-based pedestrian detection and feature-based tracking for driver assistance: real-time, robust algorithms and evaluation[J]. IEEE Transactions on Intelligent Transportation Systems,2013,14(3):1346-1359。 [6]OLMEDA D, PREMEBIDA C, NUNES U, et al. Pedestrian detection in far infrared images[J]. Integrated Computer-Aided Engineering,2013,20(4):347-360。 [7]DOLLAR P, WOJEK C, SCHIELE B, et al. Pedestrian detection: an evaluation of the state of the art[J].Pattern Analysis and Machine Intelligence, IEEE Transactions on,2012,34(4):743-761。 [8]FELZENSZWALB P F, HUTTENLOCHER D P. Efficient matching of pictorial structures[C] //Computer Vision and Pattern Recognition. Hilton Head Island: IEEE publisher,2000:66-73。 [9]BROGGI A, BERTOZZI M, FASCIOLI A, et al. Shape-based pedestrian detection[C]//IEEE Intelligent Vehicles Symp. Dearborn: IEEE publisher,2000:215-220。 [10]MOHAN A, PAPAGEORGIOU C, POGGIO T. Example-based object detection in images by components[J]. Pattern Analysis and Machine Intelligence, IEEE Transactions on,2001,23(4):349-361。 [11]杨涛,李静,潘泉,等.基于场景模型与统计学习的鲁棒行人检测算法[J].自动化学报,2010,36(4):499-508。 [12]STAUFFER C, GRIMSON W E L. Adaptive background mixture models for real-time tracking[C]//Computer Vision and Pattern Recognition. Fort Collins: IEEE publisher,1999:1063-1069。 [13]DALAL N, TRIGGS B. Histograms of oriented gradients for human detection[C]//Computer Vision and Pattern Recognition. San Diego: IEEE publisher,2005:886-893。 [14]STAUFFER C, GRIMSON W E L. Learning patterns of activity using real-time tracking[J]. Pattern Analysis and Machine Intelligence, IEEE Transactions on,2000,22(8):747-757。 [15]ZHU Qiang, YEH M C, CHENG K T, et al. Fast human detection using a cascade of histograms of oriented gradients[C]//Computer Vision and Pattern Recognition. New York: IEEE publisher,2006:1491-1498。 [16]CHAPELLE O, HAFFNER P, VAPNIK V N. Support vector machines for histogram-based image classification[J]. Neural Networks, IEEE Transactions on,1999,10(5):1055-1064。 [17]ZIVKOVIC Z, FERDINAND V D H. Efficient adaptive density estimation per image pixel for the task of background subtraction[J]. Pattern Recognition Letters,2006,27(7):773-780。 [18]原春锋,王传旭,张祥光,等.光照突变环境下基于高斯混合模型和梯度信息的视频分割[J].中国图象图形学报,2007,12(11):2068-2072。 (责任编辑:陈石平) 中图分类号:TP391 文献标志码:A 文章编号:1006-4303(2015)02-0212-05 作者简介:邵奇可(1976—),男,浙江舟山人,副教授,博士,研究方向为网络控制系统,E-mail:sqk@zjut.edu.cn。 基金项目:国家自然科学基金资助项目(61104095) 收稿日期:2014-11-20