融合背景模型及颜色特征的感兴趣目标检测*

2015-02-13张艳邦

张艳邦,张 芬

(咸阳师范学院 数学与信息科学学院,咸阳712000)

近年有关视觉注意机制的研究受到了国内外学者的关注,在无任何先验知识的情况下,自底向上的感兴趣目标检测模型可以检测多样性和不确定性感兴趣的目标.现有的感兴趣目标检测模型[1-2]主要依据数据驱动,找到图像特征具有奇异性的区域,即为感兴趣目标.这些研究主要是研究图像中哪些目标或哪些区域更能引起人们的注意.而文中关注的是不吸引人们注意的区域,如图像中的天空、大海、草地等在图像边缘区域分布往往是人们不关心的背景部分.通常图像边缘部分可表示为图像背景部分.根据内部区域像素与边缘背景区域像素的对比度分析,文献[3]提出了基于背景先验知识的显著性检测模型.文献[4]对图像进行了光滑预处理,然后将图像等分成5×5的子图像块,计算图像内部图像块与背景图像块的颜色欧氏距离,并将距离的最小值定义为该点的显著性特征值.文献[5]将各超像素块的中心距离图像边缘小于一定的阈值的像素块定义为背景.当其他的像素块与背景像素块相比较时,只选取特征最相似的k个背景像素块作为背景的代表区域,计算它的颜色对比度特征.然而,由于图像边缘区域之间相距较远,将图像所有边缘区域看作一个背景模型是不合适的,文中以位于图像中心的椭圆外面的区域为背景区域,同时将这个区域分割成互补重叠的四个相等的子区域,记为图像的四个背景模型,然后分别计算内部区域与这四个背景区域的差异性得到显著性特征.为了避免感兴趣目标在图像边缘时带来的漏检现象,文中同时考虑图像背景区域内部颜色特征的奇异性,特征奇异区域即为感兴趣目标,以期为感兴趣目标的检测提供参考.

1 图像预处理

人类视觉在观察和认识世界时并不是以像素为单位的,而是以图像区域为单位的,因为单独一个像素或几个像素无法表示任何物体,只有一个区域内的像素才能表示一个确切的物体.超像素可确定每个区域的大小及形状.超像素算法可以用来将一些像素聚集成一些可以理解的有意义的子区域,这些区域可以用来代替一些像素的刚性结构,其捕获图像的冗余信息,提供一种简便原始的方法去计算图像的特征,减少了后续图像处理过程中的复杂度.现有计算超像素的算法有多种,其中简单线性迭 代 聚 类 (Simple Linear Iterative Clustering ,SLIC)法[6]受到许多学者的关注.因此,文中采用SLIC超像素分割算法对图像预处理分割.

2 感兴趣目标检测算法

2.1 图像背景模型

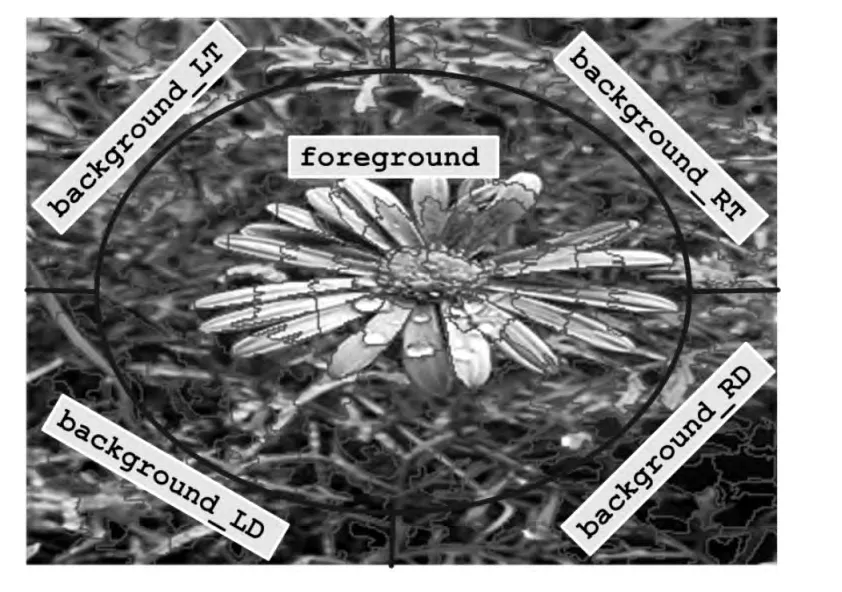

感兴趣的目标一般位于图像的中心区域,图像边缘部分通常是人们不感兴趣的背景区域.已有研究将边缘区域看作一个背景模型,计算内部区域与边缘区域的差异性得到显著性特征.由于在某些情况下,感兴趣目标可能位于图像边缘区域,并且图像的上边缘区域和下边缘区域,以及左边缘区域和右边缘区域相距较远具有不同的特征,为了能够更好描述图像背景的特征,将图像的边缘区域分为四个互不重叠区域,如图1所示.

图1 图像背景模型Fig.1 Background model

由图1可见,background_LT,background_LD,background_RT,background_RD分别位于图像的四个角,这部分区域通常是图像背景.中心区域是以图像中心为中心的椭圆,现以x,y为坐标轴,则椭圆方程为

式中:width为图像的宽;height为图像的高.

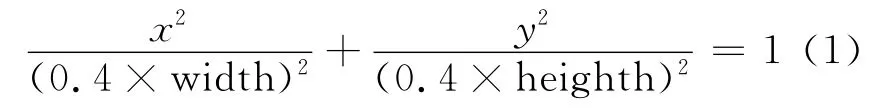

2.2 显著性特征计算

分别计算图像内部区域与四个背景区域的颜色特征差异性,得到显著性特征.当两区域的距离较近时,相互之间的影响较大,而距离较远时,相互之间的影响较小,因此,在计算内部区域四个背景区域差异性时须加入距离因素.例如,内部区域与左上角背景区域的差异性计算公式为

式中:SLT(pi)为内部区域第i个超像素与左上角背景区域的差异性;D(pi,LTn)为内部区域第i个超像素pi与左上角背景区域中第n个超像素LTn的欧式距离;NLT为左上角背景区域中超像素的个数;|pi-LTn|为内部区域第i个超像素与左上角背景区域中第n个超像素的颜色距离.

按照式(2),同样可计算得到内部区域第i个超像素的其他三个显著性特征SLD(Pi)、SRT(Pi)和 SRD(pi).

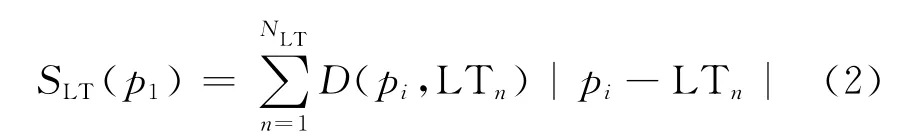

2.3 背景模型中的奇异性

有些情况,感兴趣目标位于图像的边缘区域或者图像边缘区域的一部分,为了避免漏检现象,计算四个背景区域中颜色特征奇异的区域,这些即为图像的感兴趣目标.例如,计算左上角背景区域中第n个超像素的显著性特征为

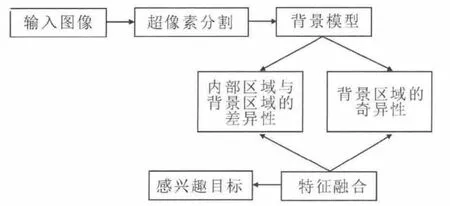

式中:LT,LD,RT,RD分别为图像左上角、左下角、右上角、右下角背景区域内平均颜色特征;LTn为左下角背景区域中第n个超像素的像素值;mean(LT+LD+RT+RD)为四个背景区域的平均颜色特征.通过同样的方法,可以得到其余三个背景区域的显著性特征SLD(n)、SRT(n)和SRD(n).根据线性融合可得到最终显著图,其计算过程如图2所示.

3 实验结果及分析

为客观地验证基于背景模型的改进感兴趣目标检测算法(Background method,BG)的有效性,在公开的Achanta数据库[7]中与目前主流六种算法:频率协调算法(Frequency Tuned,FT)[7],基于图论算法(Graph-Based,GB)[8],视觉注意测量算法(Visual Attention Measure,IT)[9],模糊增长算法 (Fuzzy Growing,MZ)[10],时空线索算法(Spatiotemporal Cues,LC)[11]及谱残余算法(Spectral Residual,SR)[12]进行比较.Achanta数据库包含了1 000幅图像及对应人工标记的具有清晰边界的显著物体基准图,这些图都是从原始库(Microsoft Research Asia,MSRA)[13]中挑选出来的.该数据集是目前最大的对显著物体精确标记的数据集.

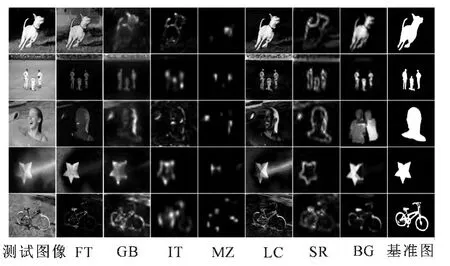

实验结果直观对比如图3所示.第1列是输入图像,第2~7列分别是算法FT,GB,IT,MZ,LC和SR的检测结果,第8列是基于背景模型的改进感兴趣目标检测算法的检测结果,最后1列是标出显著目标的基准图.从图3中可以直观的看出,第1列第1张图和第3张图中的显著性目标比较大,而其余目标较小;第3张图中包含了3个目标,其余图像中只包含1个目标,第5张图中背景是草地,具有复杂纹理特征,可以看出上述主流6种算法在对这几种图像的检测中都存在着漏检和误检现象,而文中提出的基于背景模型的改进感兴趣目标检测算法的检测结果和基准图基本吻合,明显优于上述主流6种算法,这说明了基于背景模型的改进感兴趣目标检测算法对检测目标尺度的大小、目标个数以及复杂背景都有较好的鲁棒性.

图3 在MSRA数据库中BG算法与现有文献直观比较Fig.3 Comparison between existing algorithms and BG in MSRA

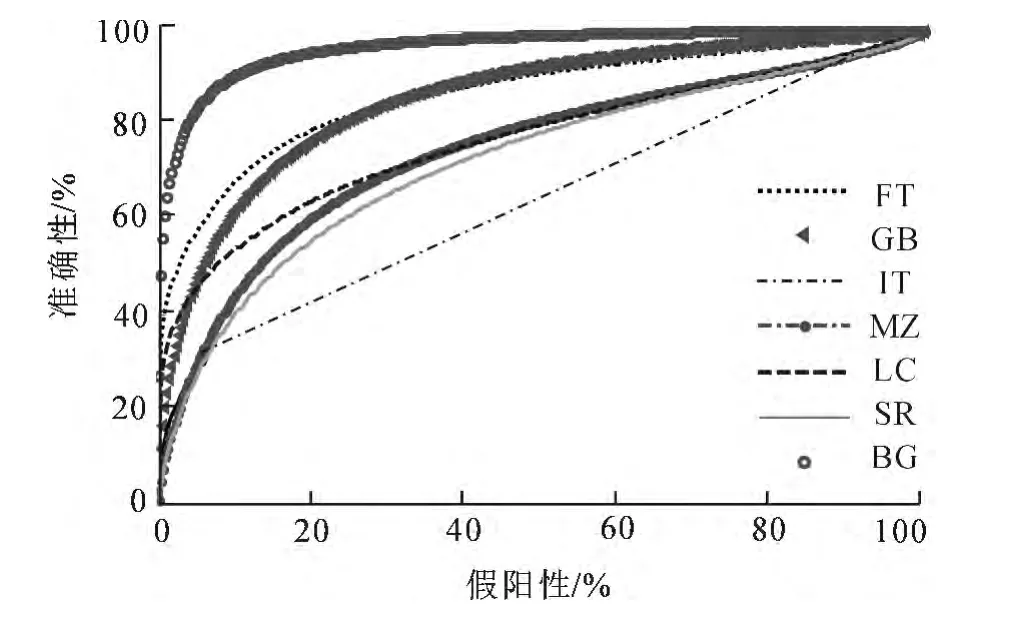

为了客观评价算法性能,文中采用本领域目前通用的衡量标准接受者操作特征曲线 (Receiver Operating Characteristic Curve,ROC)和 ROC曲线下 方 的 面 积 (Area Under the ROC Curve,AUC).ROC曲线通过描述准确性和假阳性比例关系来实现,而AUC则可以定量衡量各种算法的性能.图4和表1分别给出了基于背景模型的改进感兴趣目标检测算法与6种主流算法的ROC曲线和AUC对比结果.从图4中可以看出BG算法的ROC曲线明显高于其他的6中主流算法,表1中的结果也表明文中提出的BG算法具有较高的AUC值,检测结果提高了10%以上,因此,从对比结果可以看出文中提出的BG算法在Achanta数据库上的检测效果优于6种主流算法.

图4 BG算法与6种主流算法的ROC曲线对比Fig.4 Comparison between the ROC curves of 6algorithms and BG

图2 显著性特征计算过程Fig.2 The process of salient feature calculation

表1 BG算法与6种主流算法的AUC对比Tab.1 Comparison between AUC of 6algorithms and BG

4 结 论

文中将图像背景先验信息应用到自底向上的感兴趣目标检测模型中,提出了一种结合图像背景先验信息及颜色特征的感兴趣算法.该算法通过对图像边缘区域的特征构建背景模型,定义显著性特征为与背景区域颜色特征的差异性,同时计算背景区域内部的奇异区域,有效避免了由于感兴趣目标靠近图像边缘而造成的漏检现象.实验结果表明基于背景模型的改进感兴趣目标检测算法在显著性目标的尺度和个数不确定以及复杂背景下的检测准确率优于其他算法.

[1] ZHANG Y B,HAN J W,GUO L.Image Saliency Detection Based on Histogram[J].Journal of Computational Information Systems,2014,10(6):2417.

[2] BORJI A,ITTI L.State of the Art in Visual Attention Modeling[J].IEEE Transactions on Pattern A-nalysis and Machine Intelligence,2012,35(1):185.

[3] WEI Y C,WEN F,ZHU W,et al.Geodesic Saliency Using Background Priors[C]// Proceedings of the 12th European Conference on Computer Vision.Florence:IEEE,2012:29.

[4] HUA M,BIE X H,WANG W C.Contrast Based Saliency Detection Using Representative Background[C]//IEEE International Conference on Image Processing.Melbourne:IEEE,2013:3422.

[5] ZHANG Y B,HAN J W,GUO L.Salient Region Detection Using Background Contrast[C]//IEEE International Conference on Image Processing.Paris:IEEE,2014:1184.

[6] ACHANTA R,SHAJI A,SMITH K,et al.SLIC Superpixels Compared to State of the Art Superpixel Methods[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2012,34(11):2274.

[7] ACHANTA R,HEMAMI S,ESTRADA F,et al.Frequency-Tuned Salient Region Detection[C]//IEEE Conference on Computer Vision and Pattern Recognition.Florida:IEEE,2009:1597.

[8] HAREL J,KOCH C,PERONA P.Graph-Based Visual Saliency[J].Advances in Neural Information Processing Systems,2007,19:545.

[9] ITTI L,KOCH C,NOEBUR E.A Model of Saliency-Based Visual Attention for Rapid Scene Analysis[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,1998,20(11):1254.

[10] MA Y F,ZHANG H J.Contrast-Based Image Attention Analysis by Using Fuzzy Growing[C]//Proceedings of the 11th ACM International Conference on Multimedia.Berkeley:IEEE,2003:374.

[11] ZHAI Y,SHAH M.Visual Attention Detection in Video Sequences Using Spatiotemporal Cues[C]//Proceedings of the 14th ACM International Conference on Multimedia.Santa Barbara:IEEE,2006:815.

[12] HOU X D,ZHANG L Q.Saliency Detection:A Spectral Residual Approach[C]//IEEE Conference on Computer Vision and Pattern Recognition.Minneapolis:IEEE,2007:1.

[13] LIU T,SUN J,ZHENG N N.Learning to Detect A Salient Object[C]//IEEE Conference on Computer Vision and Pattern Recognition.Minneapolis:IEEE,2007:1.