基于语言模型的有监督词义消歧模型优化研究

2014-02-27杨陟卓黄河燕

杨陟卓, 黄河燕

(北京理工大学 北京市海量语言信息处理与云计算应用工程技术研究中心,北京 100081;北京理工大学 计算机科学与技术学院,北京 100081)

1 引言

词义消歧是确定多义词在给定上下文语境中的意义,它是自然语言处理领域中重要的研究课题之一。相关研究表明,词义消歧对机器翻译、信息检索、文本分析、自动文摘、知识挖掘等多方面都具有十分重要的作用。

目前,基于语料库的词义消歧方法可分为有监督和无监督方法[1]。无监督方法无需训练语料,可以有效克服数据稀疏问题,但是该方法的消歧效果却不尽如人意,很难达到实用的目的。有监督方法的消歧效果要远远优于无监督方法,但是该方法需要大量的高质量的训练语料支持,而获取大规模高质量的训练语料费时费力,因此它存在较为严重的数据稀疏和数据获取瓶颈问题。

在有限的标注语料条件下,提高有监督词义消歧效果的有效途径之一是充分利用句子中的各种特征,并且对这些特征进行优化。目前经常使用的特征包括[2]: 词法层面的特征、语法层面的特征以及语义层面的特征。词法层面的特征包含局部词、局部词性、局部词及词性、局部共现、词袋和搭配特征。文献[3]认为对于不同的歧义词,应当采用不同词法层面的特征,并且提出一种自动选择词义消歧模板特征的方法,该方法取得了不错的效果。语法层面的特征包括主谓关系、动宾关系等。文献[4]采用与歧义词具有语法关系的词语,作为特征训练分类模型。语义层特征主要包括实体信息和语义角色信息等。文献[5]将词义消歧和语义角色标注两个任务在同一个模型中建模,通过两种任务的内在联系,相互辅助提高词义消歧和语义角色标注的准确率。文献[6]在进行动词消歧时,采用语义分析技术,识别句法树中各个名词的命名实体类型,并以这些语义信息作为特征训练分类器。文献[7]不仅利用歧义句的上下文特征,而且将语义词典中词语的义原搭配信息也引入到消歧模型中,应用隐最大熵原理对歧义词消歧。

除了考察各个特征对有监督消歧效果的影响外,近年来,一些学者利用可获得的知识,对消歧模型进行优化。例如,文献[8]利用词语间的依存关系优化模型中的词语特征,加强与歧义词具有依存关系的词语在消歧中的作用。文献[9]利用信息增益改进有监督消歧模型,通过信息增益的计算,挖掘上下文中词语的位置信息,优化消歧模型中的词语特征的权重。文献[10]在基于多分类器集成的消歧模型基础上,提出一种动态自适应的多分类器融合算法,优化各个分类器的权重以提高词义消歧性能。

语言模型是语言中所有句子或部分语言单位的概率分布,可以将它看作是生成某种语言文本的统计模型。它已经成功应用于信息检索、语音识别、中文输入法等领域中。以往的有监督词义消歧方法利用语言模型时,仅仅将歧义词附近的n-gram词语(局部共现词语)作为一种特征,加入到消歧模型中进行训练。实验证明,利用该词语组合特征可以有效地提高词义消歧效果。但是,本文认为,这些方法都没有充分利用语言模型的消歧优势。本文提出一种基于语言模型的有监督词义消歧模型优化方法,利用语言模型优化传统的有监督消歧模型。它不仅利用有监督消歧模型记录在训练语料中歧义词附近的特征,而且通过大规模语料库,计算歧义词的各个词义在特定上下文中的语言模型概率, 利用该语言模型概率的大小,辅助推断歧义词的词义。该模型在训练数据较少,不足以训练出一个完备的有监督模型时,通过语言模型的辅助,可以显著地提高词义消歧效果。

本文第2节首先介绍有监督词义消歧模型;第3节描述基于语言模型的有监督词义消歧模型,说明该模型的工作原理,并且在此基础上,给出模型的消歧流程。最后测试并分析该模型的词义消歧性能。

2 有监督消歧模型

近年来,机器学习方法已经成功应用于词义消歧的研究,在国际词义消歧测评中,消歧效果最好的词义消歧系统都用到了有监督的学习方法,这些方法包括最大熵模型[3]和贝叶斯模型[11]等。本文就以这两种最流行的有监督模型为基线方法,测试本文所提出的方法。下面简单地介绍有监督词义消歧系统的原理。

有监督消歧模型的基本思想是先训练分类函数,然后将待消歧的句子的上下文作为输入,通过分类函数计算歧义词属于各个词义的概率,选取概率最大的词义作为歧义词最终的词义,如式(1)所示。

(1)

(2)

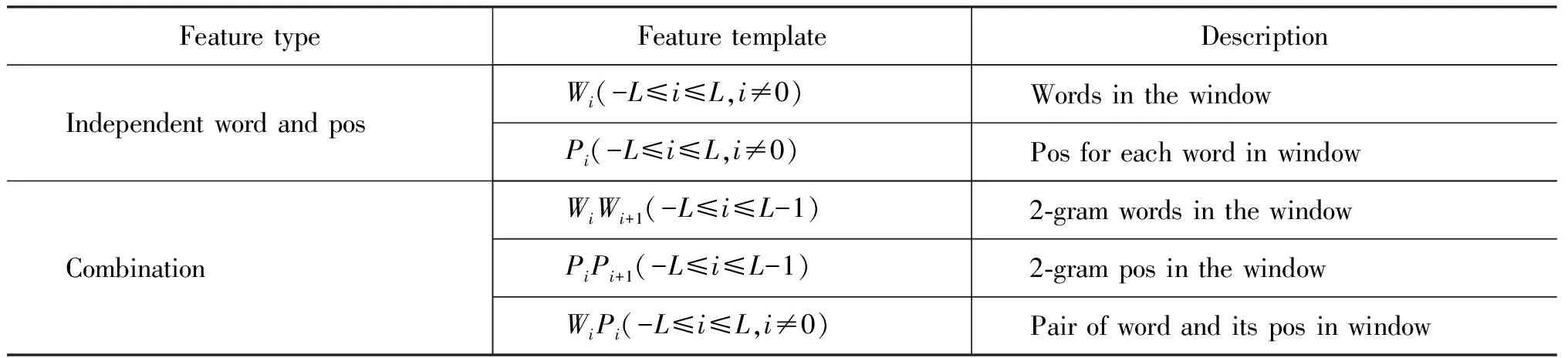

其中f1…fj…fn表示歧义词的上下文特征集合,这些特征可以是词法层面的特征、语法层面的特征以及语义层面的特征。由于本文的目标并不是考察各个特征对词义消歧的影响,而是考察语言模型的辅助消歧效果,因此,只选用了一些最常用的特征[3],这些特征如表1所示。

在表1中,这些特征可以分为两类: 一类是一定窗口大小内的词语和词性, 另一类是词语和词性的组合。其中,W表示词语,P表示词性,L表示窗口大小。

表1 消歧特征模板

3 基于语言模型的有监督消歧模型

统计语言模型[12]最初诞生在语音识别领域,识别给定语言信号对应的词序列。如果用W表示文本中顺序排列的n个词,即W=w1w2...wn,则统计语言模型的任务是给出序列W在文本中出现的概率p(W),利用概率的乘积公式,p(W)可以展开为式(3)。

p(W)=p(w1)p(w2|w1)p(w3|w1w2)...

p(wn|w1w2...wn-1)

(3)

从式(3)可以看出,估计词语wn出现的概率,必须首先估计wn前面所有词语出现的概率。但是从计算上来说,太复杂了。因此,N元语言模型假设任意一个词wn,只与它前面的N-1个词有关,此时问题就可以得到很大的简化,如式(4)所示。

(5)

其中,c(wiwi-1wi-2)表示wiwi-1wi-2在语料库中出现的次数,而c(wi-1wi-2)表示wi-1wi-2在语料库中的出现次数。

语言模型可以计算语言片段的概率大小。由于出现概率较大的语言片段会更加符合语言的一般规律,因此本文将语言模型应用在词义消歧中。已有相关研究将语言模型应用在无监督词义消歧中,并且取得了良好的效果[13]。该文献假设,如果歧义词的某个词义sik与上下文组成的语言片段,比其他词义与上下文组成的语言片段的概率值大,那么该词义sik就越有可能是歧义词的最终词义,如式(6)所示。

wi-L...wi...wi+L表示歧义词和附近的上下文词语,wi表示歧义词,歧义词wi一共有m个词义。在公式中,sik表示歧义词wi的第k个词义,p(wi-L...sik...wi+L)表示将歧义词词义sik替换歧义词wi,所组成语言片段的概率。在词义决策时,模型选择概率值大的语言片段所包含的词义作为歧义词的最终词义。例如,在语句“西医出身的她,转而钻研中医理论,试图吸取前人的经验”中,“中医”是歧义词。它的词义有2个,一个是“中医学”,另一个是“医生”。用语言模型进行词义决策时,由于语言片段“钻研中医学理论”相比“钻研医生理论”更可能在语料库中出现,利用式(6)进行决策,词义“中医学”更有可能是歧义词“中医”的最终词义。

缺少高质量标注的训练语料是有监督词义消歧所面临的最大问题。本文利用语言模型的消歧优势,提出一种基于语言模型的有监督词义消歧方法,该方法可以在不增加训练语料的情况下,有效地提高词义消歧效果。综合式(2)和式(6),改进的词义消歧模型如式(7)所示。

在式(7)中,α用于调整语言模型对歧义词词义的影响,如果加强语言模型对歧义词的词义决策作用,则α取较大的值,反之亦然,它的取值将在实验中估计。在优化的模型中,由于加入了语言模型的推荐作用,概率值p(wi-L...sik...wi+L)较大时所对应的歧义词词义sik更有可能成为歧义词的最终词义。从式(7)可以看出,优化的有监督模型在词义决策时,不仅考虑一定窗口大小内歧义词的特征fj对歧义词的影响,而且还考虑由上下文词语wi-L...wi+L和歧义词的各个词义sik,所组成的词语序列的概率大小对消歧效果的影响。该模型在训练数据不够充分时,利用语言模型对词义消歧的决策作用,提高歧义词的消歧性能。

语言模型的估计可以有很多种方法,有些学者使用搜索引擎衡量包含语言片段的页面数[14]。该方法有个假设: 如果一个语言片段被较多的页面所包含,那么该语言片段出现的概率就较大,反之,如果一个语言片段被较少的页面包含,该语言片段在语料库中的概率就较小。但是,这种估计方法是有缺陷的: 因为互联网中充斥着各种各样的数据,并且随着时间的增加,各种垃圾、广告以及不均衡的新闻主题网页也会被搜索引擎所索引。因此互联网作为语料库,并不能很好的反应真实文本中语言片段的概率。本文利用Kylm(Kyoto language Modeling toolkit)语言模型工具包*http://www.phontron.com/kylm/在大规模真实文本语料库估计模型概率,大规模语料采用1998年《人民日报》半年语料*http://icl.pku.edu.cn/icl_res/和搜狗新闻数据语料库*http://www.sogou.com/labs/dl/ca.html。在实验中应用Kneser-Ney平滑策略。

本文提出方法的总体流程图如图1所示。该方法分为三步: ①利用训练数据训练出一个传统的有监督消歧模型;②利用Kylm工具包通过大规模真实语料库建立语言模型,统计包含歧义词词义和上下文的语言片段的语言模型概率;③综合利用有监督消歧模型和语言模型,共同决策歧义词的词义。

图1 词义消歧模型优化流程图

4 实验与结果讨论

4.1 测试语料评价标准与基线方法

利用ACL2007的一个组成部分SemEval-2007[15],国际语义评测的中英文词汇任务(task#5 multilingual Chinese English lexical sample task)对本文方法进行评测。该任务共含40个歧义词,语料由训练语料,以及测试语料两个部分组成,如表2所示。同时,采用其提供的标准评测工具及相应评价指标pmar(macro average accuracy),如式(8)所示。

其中N为所有的目标词数,mi是对每一个特定的词所标注正确的例句数,ni是对该特定词所有的测试例句数。

表2 训练语料与测试语料

实验比较3个baseline方法和本文所提出的方法,3个baseline方法分别为:

(1) Bayes: 原始的贝叶斯词义消歧模型,该模型利用式(2)进行词义决策,并且利用表1的特征进行训练。

(2) ME: 原始的最大熵词义消歧模型,该模型利用式(2)进行词义决策,并且利用表1的特征进行训练。

(3) SRCP_WSD[16]: 该系统是参加SemEval-2007评测的有监督系统,获得了SemEval-2007Task#5评测第一名(pmar=74.9%)。

本文所提出的方法为:

Optimized_Bayes: 经过语言模型优化后的贝叶斯词义消歧模型,同时利用贝叶斯模型和语言模型进行词义决策,并且利用表1的特征进行训练。

Optimized_ME: 经过语言模型优化后的最大熵词义消歧模型,同时利用最大熵模型和语言模型进行词义决策,并且利用表1的特征进行训练。

4.2 实验结果

笔者在实验中发现,歧义词句中并不是所有的词对词义消歧决策都有积极的作用,例如,句中的标点符号、连词和助词会给消歧模型带来噪声,因此本文在训练模型时,去掉了这三类词。并且在以往的实验中,窗口大小设置为1时,消歧效果最好。因此在实验中,对于所有的歧义词,窗口大小都统一设置为1。

1) 各种方法的实验结果比较: 从表3中的数据可以看出,本文提出的方法相比传统的贝叶斯模型和最大熵模型,消歧准确率都有所提高,并且经过语言模型优化的最大熵模型的消歧准确率超过了SRCP_WSD系统0.4%。说明语言模型确实可以帮助有监督模型提高消歧效果。同时可以看出,基于最大熵的词义消歧模型的性能要优于贝叶斯模型,这是由于贝叶斯模型为了简化计算,假设特征之间是相互独立的,但真实的语料并不能满足上述条件;而最大熵模型并没有做上述假设,可以将各种不同的特征聚集在统一的框架下,因此,最大熵模型消歧性能要略优于于贝叶斯模型。

表3 各方法实验结果比较

经过优化的消歧模型相比传统的消歧模型,优势并不明显,准确率只提升了1.6%。笔者在查看实验结果时发现,在绝大多数情况下,经过优化的消歧模型在词义决策时,相比传统的消歧模型,虽然各个歧义词词义的分数发生了变化,但是歧义词词义的排序并没有发生变化,因此并没有影响先前有监督模型对歧义词词义的选择。

2) 不同阶数n-gram对消歧效果的影响。为了考察不同阶数语言模型对消歧效果的影响,实验以歧义词为中心,分别利用不同位置的2-gram和3-gram语言模型优化有监督消歧模型。本文以前文中“西医出身的她,转而钻研中医理论,试图吸取前人的经验”为例,说明具体的语言模型选取情况,如表4所示。

表4 n-gram的选取

不同阶数不同位置的语言模型对有监督词义消歧模型的影响如表5所示。从表5可以看出,3阶语言模型的消歧效果要优于2阶语言模型,并且在位置-1,0,1时3阶语言模型取得了最佳的消歧效果。这是由于该位置的语言模型能够更全面的衡量歧义词词义与上下文的搭配情况。

表5 各方法实验结果比较

3) 不同规模无标记语料对消歧效果的影响。为了考察语言模型的好坏对消歧效果的影响,本文使用不同规模的语料库训练语言模型。实验采用消歧效果最好的3-gram训练语言模型。实验的结果如图2所示,横坐标表示语料库的规模,数据量以兆为单位,纵坐标表示消歧准确率。由于1998年《人民日报》的语料和词义消歧任务的测试语料领域最近,因此本文首先利用50兆的人民日报语料库训练语言模型,然后在该语料库的基础上依次增加搜狗新闻语料,从图中可以看出,无论对于基于优化的贝叶斯模型还是最大熵模型,增大语料库的规模,对词义消歧模型的性能提升是有帮助的,但是当语料库的规模增加到一定程度的时候,消歧准确率就不再有提高,说明语言模型对消歧性能的提高是有限的。除此之外,可以看出,与词义消歧测试语料领域更相近的人民日报语料库训练出的语言模型,对词义消歧效果的提升要优于搜狗新闻语料库。

图2 语料库规模不同对消歧性能的影响

图3 α取值不同时的模型消歧性能

4) 不同规模有标记训练语料对本文所提出模型的影响。为了客观的比较本文的方法在不同规模训练数据中的消歧性能,笔者做了如下一组实验。 实验中,语言模型采用3-gram,训练语言模型的数据规模采用Optimaized_ME模型取得最佳效果时的语料库规模(350兆),基于优化的最大熵消歧模型的实验结果如图3所示。其中,纵坐标表示消歧准确率,横坐标表示使用的训练数据规模,例如,0.1表示利用了10%的训练数据。在每个横坐标刻度上有一组柱列,每一个柱列均按照α的取值不同依次排列(α=0,α=3,α=5,α=7)。应当注意到,当α=0时,消歧模型退化为传统的最大熵模型。从图中的结果可以看出,随着训练语料规模的增加,各种方法的消歧准确率都在逐渐增大,而且在所有规模的训练数据中,本文所提出的方法都要优于传统的最大熵方法(α=0),特别是在训练数据较少的情况下(少于70%的训练数据),该模型的消歧优势比较明显。但是随着训练数据的增加,语言模型的消歧作用在逐渐减少,这一点是合理的。因为语言模型相当于一种无监督的词义消歧知识,它的消歧性能还是比不上训练数据中包含的有监督消歧知识,因此本文的方法在训练数据较少的情况下,能够更加显著的提高消歧性能。

同时可以看出,当训练数据较少时,α取较大的值,模型的消歧准确率较高,而在训练数据较多时,α取较小的值,模型的消歧准确率较高。例如,在训练数据少于70%的情况下,α取值5时消歧效果总体最好,并且在含有30%的训练语料时,消歧准确率相比传统的有监督模型提高了3.3%。而在训练数据大于70%的情况下,α取值3时消歧效果最好。实验结果说明: 当训练数据不足以训练出一个完备的有监督消歧模型时,应当为语言模型设置较大的权重,而当训练数据较充足时,应当为语言模型分配较小的权重,这样语言模型可以在不同规模的训练数据中均发挥适当的消歧作用。同时可以看出,没有必要将α设置很大的值,例如,当α取值为7时,消歧效果并不好。因为当α很大时,消歧模型会过于依赖语言模型的消歧作用,而忽略了训练数据所提供的消歧知识。

5 总结与未来工作

本文提出一种基于语言模型的有监督词义消歧模型,该模型在传统的有监督模型基础上,利用语言模型的词义消歧优势,弥补有监督消歧模型存在的数据稀疏问题。最后的实验结果表明,在缺乏训练数据的条件下,该模型可以显著的提高传统有监督模型的消歧效能。

当前的实验结果表明,在有限的标注语料条件下,语言模型确实可以帮助有监督模型提高词义消歧性能。 未来的工作,可以从两个方面进行。①深入分析大规模中文词义消歧数据集的特征,挖掘更多可用的词义消歧知识。例如,利用词语的相似性和相关性优化有监督词义消歧模型。②研究如何优化其他有监督词义消歧模型,如SVM等消歧模型,测试各种有监督模型被优化后的消歧效果。

[1] Chan Y S, Ng H T. Scaling up word sense disambiguation via parallel texts[C]//Proceedings of AAAI. 2005, 5: 1037-1042.

[2] Navigli R. Word Sense Disambiguation: A survey [J]. ACM Computing Surveys, 2009, 41(2): 1-69.

[3] 何径舟, 王厚峰. 基于特征选择和最大熵模型的汉语词义消歧.软件学报[J] ,2010, 21(6):1287-1295.

[4] Mart nez D, Agirre E, Mrquez L. Syntactic features for high precision word sense disambiguation[C]//Proceedings of the 19th International Conference on Computational Linguistics-Volume 1. Association for Computational Linguistics, 2002: 1-7.

[5] Che W, Liu T. Jointly modeling wsd and srl with markov logic[C]//Proceedings of the 23rd International Conference on Computational Linguistics. Association for Computational Linguistics, 2010: 161-169.

[6] Dang H T, Palmer M. The role of semantic roles in disambiguating verb senses[C]//Proceedings of the 43rd Annual Meeting on Association for Computational Linguistics. Association for Computational Linguistics, 2005: 42-49.

[7] 张仰森,黄改娟,苏文杰. 基于隐最大熵原理的汉语词义消歧方法.中文信息学报[J], 2012, 26(3):72-78.

[8] 卢志茂,刘挺,张刚,等.基于依存分析改进贝叶斯模型的词义消歧.高技术通讯[J], 2003, 13(5): 1-7.

[9] 范冬梅, 卢志茂, 张汝波,等. 基于信息增益改进贝叶斯模型的汉语词义消歧. 电子与信息学报[J], 2008,30(12): 2926-2929.

[10] 张仰森, 郭江. 基于隐最大熵原理的汉语词义消歧方法. 中文信息学报[J], 2012,26(1):3-8.

[11] Escudero G, Màrquez L, Rigau G. Naive Bayes and exemplar-based approaches to word sense disambiguation revisited[J]. arXiv preprint cs/0007011, 2000.

[12] Song F, Croft W B. A general language model for information retrieval[C]//Proceedings of the eighth international conference on information and knowledge management. ACM, 1999: 316-321.

[13] 刘鹏远, 赵铁军.利用语义词典Web挖掘语言模型的无指导译文消歧木. 软件学报[J], 2009, 20(5):1292-1300.

[14] Bergsma S, Lin D, Goebel R. Web-Scale N-gram Models for Lexical Disambiguation[C]//Proceedings of IJCAI. 2009, 9: 1507-1512.

[15] Jin P, Wu Y, Yu S. SemEval-2007 task 05: multilingual Chinese-English lexical sample[C]//Proceedings of the 4th International Workshop on Semantic Evaluations. Association for Computational Linguistics, 2007: 19-23.

[16] Dong Zhendong, Dong Qiang. Hownet[OL]. 1999.[2010-11-5], http://www.keenage.com

[17] Carpuat M, Wu D. Word sense disambiguation vs. statistical machine translation[C]//Proceedings of the 43rd Annual Meeting on Association for Computational Linguistics. Association for Computational Linguistics, 2005: 387-394.