基于技术和伦理角度的机器人的发展趋势

2013-11-23王东浩.

王 东 浩.

(南开大学 哲学院,天津 300071)

机器人是当今社会技术成就上非常成功的一个典型。人类对这个领域的研究开始于20世纪30年代,最初,机器人主要应用在工业和制造业部门,后来扩展到社会服务部门和个人生活领域。近年来,机器人在军事领域发挥着越来越重要的作用。可以说,机器人应用范围越来越广泛,甚至我们在报纸、杂志等媒介中经常可以看到有关机器人的介绍。

然而先进技术的快速发展,往往会带来一些负面影响。机器人技术的发展也是如此。随着机器人应用领域和范围的逐步深入和广泛,它所表现出来的社会和伦理方面的问题也日益突出。基于此,人们开始关注机器人伦理问题。并逐步从技术和伦理相结合的角度研发机器人。在本文中,我们从机器人的概念出发,就机器人在工业、医疗和军事等领域的应用,以及它所表征的伦理问题进行分析,进而说明机器人在未来的发展趋势。

一、何谓机器人

对于机器人的定义,国际上较为统一的观点为:“一种可编程和多功能的操作机;或是为了执行不同的任务而具有可用电脑改变和可编程动作的专门系统。”但这一定义却不能涵盖当今机器人所具有的内涵特征。更不能引起机器人专家及其使用者的共鸣。因此,我们需要一个更精确化、更合理的定义。

随着机器人感知能力的出现并加强,机器人所具有的模拟与“认知”能力也越来越精细。这样以来,具有自主意识的机器人就有可能出现。而这种自主意识的前提是具备“思考”的能力。即通过“思考”,机器能够借助传感器或其他途径来做出自主决策。机器人的自主决策能力在此解释为:一旦机器的一部分被启动,那么该机器就能够根据现实环境进行自我反馈运作,而在一定时间内不受外部控制的一种能力。

据此,我们认为传统的对于机器人的定义已不能诠释现代机器人的内涵。那些完全远程或遥控的机器不具有自主决策能力,它们基本上依赖于外部控制,没有独立“思考”的能力,也不能进行独立行动,因此它不能称为机器人。生产力的发展,社会的进步要求机器人必须具备自主决策能力,而这正是人类社会发展的必然趋势。

二、机器人应用上的广泛性

从第一台机器人诞生距今短短几十年间,机器人技术不断革新。从当前和未来发展的前景看,伴随着新系统频繁研发问世,机器人功能会更加明显和多样化。具体表现在:

·人机交互

·机器人的情感显示和识别

·类人型机器人

·多样化的机器人系统

·自主体系

新型技术的发展和应用带来了巨大的生产力,而同时生产力的发展也促进了技术研发的飞跃。然而,人们更多关注的是它在技术层面的快速发展,对于机器人发展所带来的社会影响人们却很少关注。事实上,从机器人出现并且融入到社会生活中的时候,伦理问题就会出现在相关领域。从人机交互最先出现的工业领域开始,然后扩展到健康护理和医疗保健等领域。例如,在今天,社交型机器人(尤其是类人型机器人)已然参与到我们的家庭或社会聚会;另外,无论是现在或将来军用机器人都会发挥着重要的作用。可以说在所有可能的应用领域,机器人与人类的互动已非常广泛和深入。

三、工业或制造业中作为合作者的机器人引发的伦理问题

机器人广泛应用在各类型的实验室中。除此之外,伴随着 Unimate(第一代工业机器人)机器人的出现,它已开始在制造业中发挥作用。

在早期,机器人应用于制造业的时候,首先引起人们对伦理问题的关注是通过一个死亡事件。1979年 1月 25日,事发密歇根(Michigan)的弗林特(Flint)福特制造厂,在一次罢工中有位工人试图从仓库取回一些零件而被机器人“杀死”;另外,在 1981年也发生了一起死亡事件,一个日本维修工人在对机器进行维修的时候也被机器人“杀死”。继这两个事件之后,制造业部门开始在一些重大和存在潜在危险的环节安装防护措施。即使如此,在 1984年,还是发生了工人致死的案例。很明显,工厂的雇佣工人和机器人是以合作者的关系出现,这种合作本身就包含了伦理责任,那么就需要确保工人的安全和幸福。然而,却没有一个安全的防护能够保证人们远离危险。

设置防护确实在很大程度上缓解了机器人在工作中给人类带来的伤害。然而,在使用它们的过程中却带来了很多其他方面的伦理问题,尤其体现在人类的情感问题上。

(一)人类在被机器替代的过程中产生恐惧情感

机器人进入工厂,雇佣工人就会减少,从而导致失业,这必然要引起担忧和恐惧。因此,这就需要管理人员有责任去阻止或至少是减少这些恐惧。例如,在工厂中对机器人和工人进行一定数量比例的限制。另外,既然机器人在重复性的动作上具有很大的优势,那么在其缺乏判断和决策的位置上就应该充分发挥工人的力量。

(二)人类对于作为合作者的机器人从情感上的抵触

原则上,在制造业领域,科学家应该尽可能地设计能够完成枯燥和危险任务的机器人,同时,对于一些需要判断和解决问题的任务由人类工作者完成。然而,在自动化工厂发展的过程中,在与机器人一起工作时,人类工作者可能会产生自卑情绪。更进一步来说,他们可能担心工厂的管理者会进一步用机器人代替他们,因为他们认为机器人(原则上来说)可以完全代替人类的工作。在这样一种信念的引导下,他们可能会不高兴甚至对机器人进行一些破坏性活动。与此相关的一个案例是 19世纪英国工人破坏机器的一个事件。所以管理者应该具有伦理方面的义务以允许工人在一定的任务范围内去工作,并充分利用他们极高的机器人所不具有的认知能力。

(三)人机合作工作已成为当前的发展趋势

在当前生产生活领域一个重要的发展趋势是人机合作,以及机器人在工作时要和人类一起分担责任。在 20世纪 90年代初期,美国西北大学教授 Peshkin& Colgate首先研发这样一个机器人系统[1]。这种具有合作性的机器人称为“Cobots”。基本上,“Cobots”和人类可以共同完成某一项任务,但是行动的能量完全由人类提供,“Cobots”提供向导,并可以控制行动方向。因为人类为这个过程提供了能量,那么这个系统的作用还表现在它能够进一步解决人类在机器人行动过程中所面临的危险。

在最近几年,人机合作在很多场合的增加已经引起了人们的注意。新的感应器的出现更加增进了人机关系,从而将潜在危险降低。这样,当机器人和人类在工作的过程中接近的时候,传感器就会发出预警。同时,为了降低任何可能的危险,未来的制造业机器人将具有识别人类手势和行动而后运作的能力。这一合作也意味着机器人能够向人类学习一些限制性的活动。最终,这一效果的目标是通过吸取机器人和人类各自的优势,为最大可能地实现机器人和人类之间的分享和合作而创造更多的机会。

显然,人机之间的分享和合作可能会优化工作环境,但是也可能会降低他们之间的互动与交流。因此,在工厂开始提高机械化的过程中,这些伦理问题就需要先行处理。

四、健康护理领域的人机互动

健康护理方面的机器人应用是另一个人机交互快速发展的领域。它主要包括护理、手术、理疗和康复等。可以说,这个领域的机器人应用极大地拉近了人与机器之间的距离。对此,我们能够推测,机器人在这一领域的应用有助于减弱其对人类的潜在危险。在此我们就机器人在这个领域的快速发展指出一些典型的应用。

健康护理方面的工作通常是病人和护理者之间一对一的关系,这种人机交互的工作模式是非常重要的。因此,这也就是很多实验室正在发展“护理助理”机器人的原因。这方面最早的机器人是由 Pyxis公司制造的轮式助理机器人(Wheeled Helpmate)。HelpMate旨在帮助护士或医院工作人员运送药物、实验样本、设备、食物等工作。HelpMate还能够为医院的各个地点导航,从而避免人员间的碰撞。除此之外,它还能够使用电梯以及锁定某个特定的病房。Carnegie Mellon 大学和Pittsburgh大学已经制成了命名为Pearl的“机器人护士(nurse-bot)”。它能够从一个助理的角度来检查医院的老年病人,从而为医护人员提供信息,提醒病人用药,记录相关信息以及引导相关人员就医等。这种机器人的形状大体是在滑动的轮子上安装直立的身躯,并具有类似于人类的头部一样的物体,上面装有便于交流的摄像头和声音识别与记录装置。在头部或腰部的位置,它们通常也会有数字显示的功能,从而提示某些信息。

在助理机器人(Aassistive robots)中有这样一个设备,它可以提供口头引导、鼓励,使中风和脊髓损伤的人在与机器的交互中走向恢复。同时它还可以帮助患有自闭症的孩子进行治疗。这一类型的机器人不会与对象进行身体上的接触,而是通过声音和示范予以交流。例如图1。

图 1 助理机器人

在诸如这些护理型或助理型机器人中,经常存在这样一些伦理方面的问题:

·病人可能会对机器人产生感情,这样如果撤回机器人就可能会触发病情甚至加重。

·除了遵守人类的指令之外,机器人自身不能就病人的情绪,诸如生气或失望等做出回应。例如,一个病人可能拒绝机器人喂药,并把药片扔到地板上,甚至试图打击机器人。

·机器人会面对很多病人而不是唯一,而且它不能优先考虑一些特殊情况,这就会引起病人的生气和失望情绪。

图 2 da Vinci外科机器人

另外,我们经常提到的“机器人外科手术”,通常指的是外科手术中的人机合作活动。在今天,著名的 da Vinci外科机器人[2]已经广泛应用在很多医院。参见图2。实际上da Vinci是一个遥控机器人,因为它通过外科手术专家进行远程操作,但并不是全自动化的。外科手术专家通过一个远程的控制台,用两个手柄把握内窥镜的位置以及手术仪器。事实上,他对计算机发送指令来控制机器人的手臂,使得机器人可以完成外科手术。手术的工具装有感应器,从而可以把实时情况反馈到外科医生的手上,以防过度操作。这样可以消除医生在手术过程中手臂抖动的现象,并能够提供及时的反馈从而确保手术顺利进行。因此,使用da Vinci机器人进行手术已成为治疗中的一个趋势。在此,我们设想这样一个场景:当外科手术机器人变的更具自主性并且和人类外科专家成为真正的合作者,但其行动却不是来自于简单的远程控制,那么其结果如何?

我们再来考虑这样一个情况。机器人完成了一个手术操作,然后病人出现很多并发症并且较之之前病情加重。那么谁来为这个责任负责?如果这一外科手术可能存在一个众所周知的潜在问题,那么由此出现的伦理责任又由谁来承担?还有,伤害在什么样的情况下可以定义为不道德?或者换句话说,伤害的程度在什么范围内是道德所允许的?

借助机器人做手术存在一定的风险,或者它独立完成,或者与外科医生合作完成,手术所面临的风险也许要比独立的人工操作低。另外,从手术费用上来看,机器人手术要比纯粹的人类医生所做的手术费用要低。然而,如果这一情况变为现实,那么必然会在手术中增加机器人的应用,我们可能就会在医院看到更多的“Luddite” 分子。那么,对于机器人的破坏是否也是伦理方面的问题,或者说机器人是否应该得到尊重?

五、作为协作者的机器人

我们期望在未来的 10年里,能有更多的机器人出现在我们的家庭里,帮助我们打扫卫生,处理内务,照顾孩子,或者处理文秘工作等等。协作者机器人这一发展趋势开始于 Roomba真空吸尘器机器人的问世,此类机器人是2002年由iRobot公司生产的。从那时开始,超过400万个此类型的机器人在世界各地销售。因此在很多情况下,我们把它定义为一个商品,而不是奢侈品。然而,Roomba在一些重要的事情上还不能与人进行交流。这极大地限制了具有类人属性的机器人与人之间的交互。换句话来说,类人型机器人,诸如真空吸尘器和割草机可能是机器人,但是它们却不是当前意义上的类人机器。

类人型机器人在一些方面具有人类的特征。它们可能有两个手臂但是没有腿(通过轮子移动);它们可能有一个或多个手臂或者甚至没有;它们可能有一个类似于人类的头,并装配视觉和听觉工具;并且它们可能具有说话的能力以及辨识语音的能力。

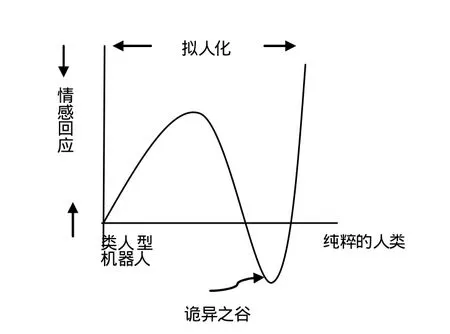

饶有兴趣但仍需注意的是类人型机器人为了取得人类的信任而不会与人类完全一致。众所周知,人类可以与玩偶、雕塑相互作用,并且玩具只具有与人类最低限度的相似性。事实上,与人类能力相关的类人型动物已然恶化,因为它们在发展的过程中与人类的差别已很小,直到这个相似性完全变成等同。这种矛盾的结果被Mori称为“诡异之谷(Uncanny Valley)”[3],参看图 3。这个图示表明当它们变得越来越像人类的时候人类的情绪反应,直到它们达到一个相似点,也就是它们和人类之间的相似度近乎完美,但实际上可怕的是两者根本不同,以至于我们不再信任它们——曲线滑到谷底代表这种关系的突然改变。

图 3 诡异之谷(Uncanny Valley)

机器人分享人类空间的能力对人类的居住环境不会构成威胁,当然这主要依靠技术上的改进。包括新的或更好的感应器(它能够使机器人充分了解周围环境),这种能力可以通过声音、手势与人类进行交流,并可及时控制制动器来控制运动的速度和可能造成的危险。另外还有很多待改进的软件,包括社会和人类相互影响的能力。这些都是高阶的命令,但是机器人满足这些要求的能力逐渐显露。例如:日本三菱公司的机器人Wakamaru以及法国Aldebaran Robotics的机器人Nao,参见图4。

Wakamaru是以人类伙伴的角色出现的,我们称之为“伙伴机器人(Companion Robot)”。它大概有 4英尺的高度,有头和大大的眼睛,有可移动的手臂但是没有腿,它的移动是靠轮子,因此它的运动需要相对平整的路况。它可以识别1万个单词,能够打电话和使用互联网。它备有一个摄像装置,如果通过互联网联系的话,它可以拍摄图像,并且能够识别 10张脸谱,以及可以按照程序完成相应的任务。它可以读邮件和浏览新闻,并通过声音传递信息。它可以同时运用语言和手势予以交流。

Nao也是一个机器人,当前主要应用在许多大学的实验室里。它只有 2英尺的高度,也就是Wakamaru的一半。它的行进主要是通过惯性测量装置和超声测量仪来保证的(或者是借助一个持续计量位置、速度和方向的系统并使用感应器和陀螺仪装置)。它的手有抓住物体的能力。它具有两个摄像机。它能够通过4个麦克风进行全方位的试听。它有两个扬声器。和 Wakamaru一样,它能够进入互联网。它的处理器是一个嵌入式的操作系统。它能够识别很多手势和肢体动作。

另外,类人型机器人在我们家庭中占有一定的地位,参考图 5,这是机器人在德国的新发展,主要是在厨房中提供帮助。

图 4 Nao机器人

图 5 类人型机器人

很明显,这些机器人是复杂的类人型机器人,它具有和人类交流的各种能力。可以说,伙伴型机器人技术即将到来,而相应的风险和伦理问题业已提出。如下:

·如果此类机器人可以自由进入人类房间,就会暴露很多隐私。

·机器人识别命令的能力会引起不道德的行为。(例如,盗取邻居的摄像或盗听电话)。

·机器人的权力和责任。例如,当机器人把盘子或食物掉在地板上时,它如何感应人的愤怒或语言?换句话来说,对机器人进行吼叫是否属于伦理方面的问题?我们能够或是否应该对机器人的过失行为进行惩罚?而又如何惩罚?

·机器人如何应对来自不同人发出的复杂的指令并做出反应?例如,孩子招唤一个机器人过来玩耍,同时妈妈又对该机器人下达了到厨房洗刷盘子的命令,机器人如何面对?

·机器人计算机能否被黑客侵入,并窥测和发送图片给潜在的窃贼?

很明显,在当前我们不能就这一系列问题给出明确的答案。

六、与社会互动的机器人

上面我们已经讨论过机器人是“社会交互式”的。就人机交互而言它本质上是行为之间的一种结合。正如大量调查研究[4]中所指出的那样,这个短语涵盖了一个关于机器人更宽泛的范围。广义上来说它需要一个共同的甚至多个机器人系统(机器人可能会彼此合作)。这就需要机器人能识别彼此并尽可能地出现交互行为,这包括彼此之间的互相学习。同时对这个领域的大量调查研究正在发生,由于篇幅限制我们不能在此予以讨论。然而,很明显的是,这样一个共同的关系将引发一些伦理问题的思考。例如,某个机器人毁坏或摧毁小组里的另一个机器人是不是伦理问题?如果不是,那么我们如何能确保这种情况不会再次发生?

从长远来看,对于社会型机器人的发展,我们期待高水平编程语言的出现,可以使机器人具有自己个性,相互间可以进行交流。以至于我们可以通过思考机器人的社会性来研究其社会行为的一面。比如,在完成一项任务中,其中一个机器人可以无私地帮助另一个机器人,即便助人者最后可能会受到损害[5]。

在交互式机器人中还涉及到另一个主题,那就是机器人自身的情感问题。在机器人实验室里这是一个深度研究的主题。关于机器人所揭示的“人工情感”存在广泛的讨论。如果人类和机器人都可以表达愤怒、高兴、厌烦和其他一些情感,那么对于人机交互应该是有利的。例如,感情可能会通过数字显示器上人造的脸或三维立体的头而表现出来。脸或头部可能会有翘动的眉毛、嘴,可以变成某种形状,或者通过眼睛的张闭来表达情感。麻省理工学院最早设计出称为Kismet机器人的头部[6],它与人类有细微的相似之处,但是却存在很多可以调整的面部形状。同时我们可以证明机器人表达情感并不是真实的,而人类作用于它之后的反应可能更加显著[7]。人类有赋予机器人人性的趋势,然而,机器人所表现出的任何情感(真的或人造的),可能不会被人类接受。

七、军用机器人

机器人在军事领域的应用已成为很多书①或报告②的主题。从其中可以看出,我们不会讨论自主性或半自主性的无人飞行机(UUVs),无人驾驶机(UGVs)或者临时的爆炸装置(IEDs)和地雷。很明显,这些装置可以保护士兵和海员的安全,参见图 6。成千上万个这样的机器人出现在伊拉克和阿富汗战争中。这些防护型机器人也同样被普通人使用,诸如就家庭安全、政府设施、商业设施、厂房检查等。警察部门也可能会用到这些机器人,以进入某一可能危及人员的建筑物。

图 6 军用机器人

为了解决军事领域中机器人所面临的日益升温的道德困境,我们考虑以下场景:

1) 智能信息显示,GPS定位到某一个房子中存在危险的敌对分子。因此一个军用机器人接到命令去接近这个房子,其目的是杀掉这个房子里的所有敌对分子。可是当机器人接近房子时,它检测(从几个联合的感应器,包括视觉、X射线、听觉和嗅觉等)到房子里除了有敌对分子外还有一些孩子。因为机器人具有战争中所应遵守的规则和法律程序,所以它应避免或至少最小化无辜人员伤亡。当面对这一矛盾的指令时,机器人可能会把这一困境反馈到指挥中心,以求解决之道。但是这可能不具有可行性,因为此时机器人可能会被敌对分子发现,以致伤害自己的力量。更为特别的是,当机器人面对这一矛盾的指令时,运行中的计算机可能会被“冻结”或“锁定”。

2) 另一个场景涉及到一个高性能的无人驾驶机。这个无人机突然遭到不明身份的由人操纵的飞机攻击。这种情况下,机器人只能通过伤害人类来保全自己。而这个决定反馈到远程控制台以及做出相关决定的时间是用毫秒计算的,在这种情况下控制台不可能迅速做出反应,那么无人机应该如何做出决定?

因此,军用机器人的应用带来了很多伦理方面的问题。就此,Arkin试图发明一个可控制的程序,即嵌入一个机器人控制软件来解决这个问题。原则上来讲,这个软件可以确保机器人遵守交战规则。但这能否保证机器人在所有情况下都能具有伦理道德?答案肯定是否定的,Arkin仅仅就此宣称这样的机器人较之纯粹的战士“更具有伦理道德”。事实上,可悲的是,具有更高道德素养的机器人在机器人伦理方面不可能有更大的进步。很明显,在之前的讨论中就军事机器人还存在很多未解决的伦理问题。具体如下:

·如果一个机器人进入建筑物,我们如何确保它不会侵犯居住者的权利?

·该机器人是否有权利进入?哨兵损坏或摧毁该机器人是否是犯罪?

·如果一个机器人在保护人类或逮捕罪犯的过程中对财产构成破坏,谁为这一损失负责?

·既然可以减少自己一方的人员伤亡,那么是否可以增加军用机器人的自主权?

·军用机器人技术的普遍应用要多久才可以扩展到其它国家?它们具有了这项技术后的影响是什么?

·对于编程此类遵守战争规则或交战规则的软件是否过于困难?

·军用机器人技术的充分发展是否能够保证它们可以区分战斗人员和平民?

·自动防故障装置是否与计划外的使用相冲突?例如,我们能否确定敌人的“黑客”不会控制我们的机器人并转而对付我们?

学者 Arkin,Asaro,Sharkey,Sparrow 以及Weber对这些问题进行了深层的探讨,并出版了相应的著作。

八、结论

在本文中,我们对机器人伦理总的发展趋势已经做了分析。另外,在当前的研究中,我们揭示了机器人伦理领域的一些变化。随着这一领域的快速发展,我们意识到机器人群体中所面临的伦理方面迟迟未能解决,其主要原因是缺乏关注。基于此,本文就这一领域发展过程中所出现的问题抛砖引玉,以期能有学者在这方面有更加深入的研究。

注释:

① 参见 Singer P,Wired for War,New York: Penguin Press,2009。

② 参见 Lin P, Bekey G A, Abney K. Autonomous Military Robotics: Risk, Ethics and Design,Office of Naval Research-funded report. San Luis Obispo: California Polytechnic State University, 2008。

[1] Peshkin M A, Colgate J E. Cobots[J]. Industrial Robot,1999(5):335-341.

[2] Taylor R H, Lavallée S, Burdea G S. Computer Assisted Surgery[M]. Cambridge, MA: MIT Press, 1995:12.

[3] Mori M. Bukimi no tani: The uncanny valley[J]. Energy,1970(4):33-35.

[4] Fong T I, Nourbakhsh, Dautenhahn K. A survey of socially interactive robots[J]. Robotics and Autonomous System,2003(3-4):143-166.

[5] Clark C M, Morton R, Bekey G A. Altruistic relationships for optimizing task fulfillment in robot communities[M].Berlin: Springer-Verlag, 2009:261-270.

[6] Breazeal C. Designing Sociable Robots[M]. Cambridge,MA:MIT Press, 2002:35.

[7] Ogata T, Sugano S. Emotional communication between humans and the autonomous robot WAMOEBA-2(Waseda Amoeba)which has the emotion model[J]. JSME Intenational Journal. Series C, Mechanical Systems, Machine Elements and Manufacturing, 2000(3):568-574.