基于光度立体视觉的织物褶裥等级评定

2013-09-17刘瑞鑫李立轻

刘瑞鑫,李立轻,汪 军,b,陈 霞

(东华大学a.纺织学院b.纺织面料技术教育部重点实验室,上海 201620)

基于光度立体视觉的织物褶裥等级评定

刘瑞鑫a,李立轻a,汪 军a,b,陈 霞a

(东华大学a.纺织学院b.纺织面料技术教育部重点实验室,上海 201620)

针对目前织物褶裥等级依赖专家主观评定存在不确定因素的问题,提出了利用光度立体视觉算法进行织物褶裥等级评定的方法.在8个不同方向的光照下拍摄多幅织物图像,得到二维灰度图像,并通过一次差分运算重建织物表面各点的高度,利用三维重建获取织物表面形状信息.通过试验提取高度值和尖锐度来表征褶裥特征,以此客观评估织物褶裥的等级.

织物褶裥;等级评定;光度立体视觉;三维重建

织物经洗涤后褶裥外观的评定是评价纺织品性能的一项重要指标.目前,依照文献[1],将带有褶裥的织物试样经过模拟洗涤操作程序后再进行褶裥性能的评定.评定级数时,在悬挂式照明设备的适当位置补充一个聚光灯以加强褶裥区域的光照,然后在规定的照明条件下对试样和褶裥外观立体标准样板进行目测比较[1].但是,此评定方法会受到心理因素、环境因素、人眼视觉效果的多义性和容错性等人工视觉检测中不可避免的因素的影响,所以主观评定洗涤后纺织品褶裥等级的结果往往具有不确定性和不唯一性.

机器视觉技术以其速度快、信息量大、功能多等特点在织物褶皱和接缝处等级评定中得到了广泛的应用,极大地提高了织物检测的精度和效率.文献[2]利用CCD(charge-coupled device)摄影的方法获得了服装表面接缝处的外表图像,用人工智能法预测了服装接缝处的平整度等级.文献[3]提出了用折皱灰度表面积、阴影面积对织物折皱评级.文献[4]提出了用折皱强度、轮廓、功率谱密度、尖锐度、随机分布程度、总体外观等来表征织物起皱程度.文献[5]利用灯光照射起皱织物得到侧面投影的技术客观评定织物的平整度等级.文献[6]开发了基于光度立体视觉法的织物平整度等级的客观评估系统,在不同光照条件下拍摄织物的多幅图像,利用光度立体视觉技术对织物表面进行3D重建,并将该算法运用到 AATCC (American Association of Textile Chemists and Color)织物平整度模板图像的三维重建,获取三维深度信息,结合4个特征值表征织物的起皱程度.目前国内还没有对褶裥性能客观评级方法的研究,所以,本文借鉴前人对褶皱和接缝处平整度等级客观评定的研究方法,提出了客观评定织物褶裥等级的方法.本文在采集图像时采用封闭的系统,以避免外界灯光对照射的影响,从而利用光度立体视觉技术对图像进行三维重建,提取反映褶裥性能的特征参数.

1 光度立体视觉技术

光度立体(photometric stereo)技术是20世纪80年代中期开始形成的一种在光源可控情况下恢复物体表面向量场的技术.根据光学原理,当光照射到物体表面时,除了部分光被物体表面吸收而转换成热以外,其余光则根据物体的性质产生反射光和透射光.当物体不透明时,物体表面的颜色仅由反射光决定.把反射光考虑成环境反射、漫反射和镜面反射3个分量的组合.多幅不同光源下的图像,计算物体表面的向量场相对容易,而且不会受到表面反射系数的影响[7].

对于表面粗糙的织物而言,可将其看作为表面反射仅有散射光引起的朗伯体反射模型,则织物表面一点的亮度只与其表面反射系数和表面法向线性相关[6].

设图像一点的亮度为I0,其表面的单位法向量为N0,光源方向为S0,则根据朗伯体表面反射模型有:

其中:η为物体表面的反射系数;N0= (Nx,Ny,Nz)T;S0= (Sx,Sy,Sz)T.

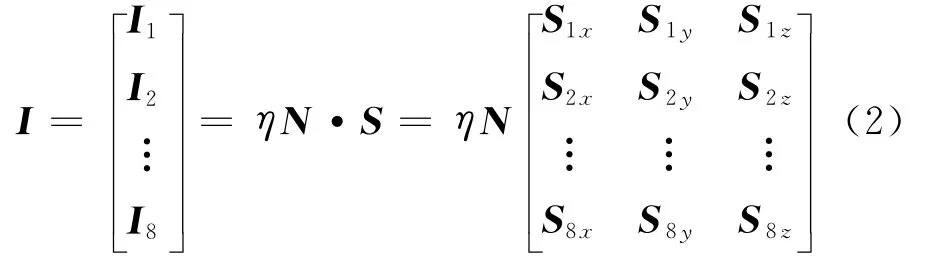

式(1)是关于各分量的线性方程,如果可以建立3个这样的方程,就可以确定物体一点的法方向N.但是,CCD读入的灰度图像通常含有噪声,使得光源放在3个位置上得到的方程组不准确.因此,本系统利用广义逆的概念,使用8个光源,用最小二乘法得到方程组的最优近似解,此时,重建精度也可得到进一步的提高.式(1)可变为

光矢量矩阵S为已知矩阵,只要其为列满秩矩阵,它的广义逆矩阵就一定存在,且是唯一的[6].所以,由式(2)可得:

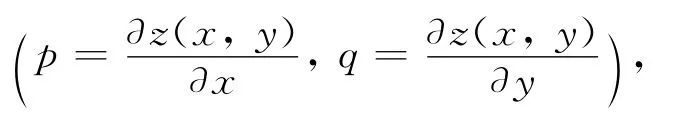

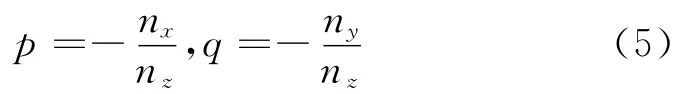

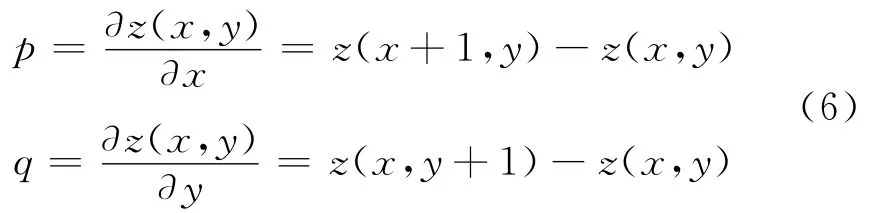

由于图像已经离散化[8],因此(p,q)可用它们的一次差分近似地表示:

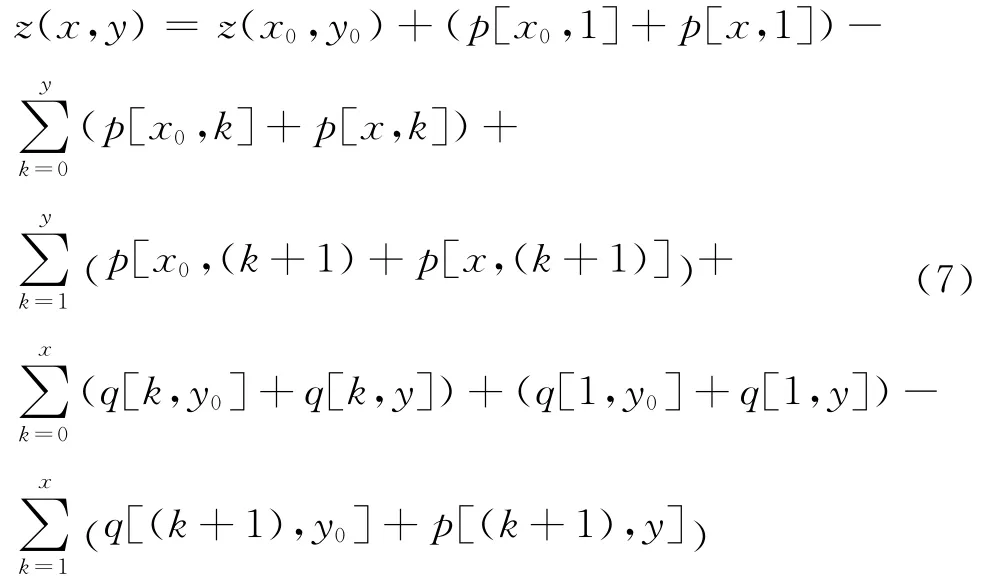

设起始点高度为z0=z0(x0,y0)=0,本文起始点为(0,0),由式(7)可以求出离散图像点的高度值,从而获得织物的表面形状.

2 褶裥织物表面三维重建

2.1 三维重建算法偏差纠正

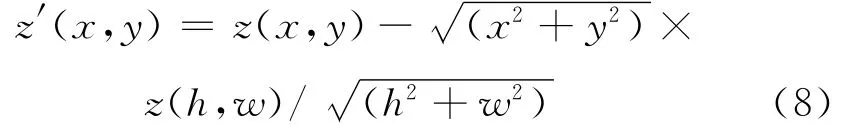

根据式(7)可计算得到织物表面各点的相对深度,但是由于在计算中会产生数值的积累,使得计算结果在离起始点比较远处的偏差较大,使得图像有很大程度的倾斜,因此,本文采用式(8)算法对各点进行修正,得到初步的重建表面.

其中:w为图像像素宽度;h为图像像素高度.

2.2 三维重建表面的迭代和修正

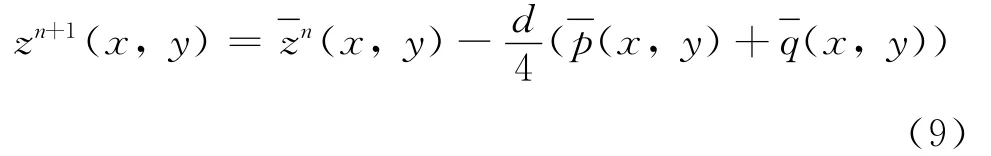

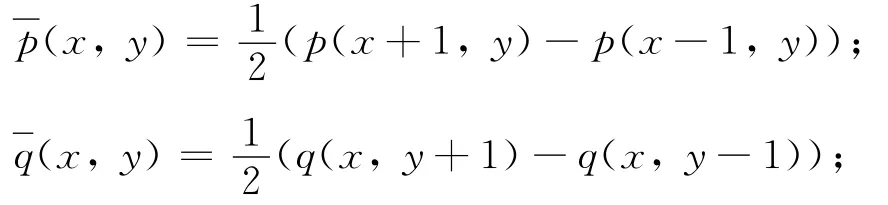

为了使三维重建算法的稳定性和精确性得到进一步的加强,考虑邻域的平均值,结合变分和有限差分的思想对所得表面进行迭代和修正,从而得到最佳的拟合表面.可用如下的迭代形式[9]:

其中:d为离散点之间的间距;

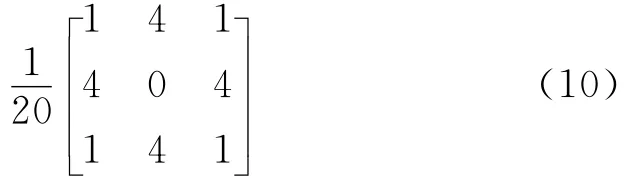

zn(x,y)为邻域平均值,可用以下模板计算:

2.3 褶裥特征值的选取

由上述可知,用光度立体视觉重建褶裥织物表面能够比较准确地反映褶裥织物表面的三维信息.本文在继承前人工作的基础上,从重建的高度值中提取有效反映褶裥的特征值,以尖锐度和高度值来测试基于光度立体视觉的褶裥织物等级评定的精度.

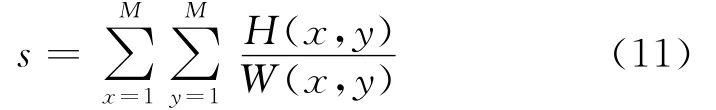

尖锐度(s):褶裥是有一条类似于波峰和波谷组成的曲线,波峰高度与波谷宽度的比值即为尖锐度[10],如式(11)所示.

其中:M为褶裥织物行(列)的高度点数,在本文中行列高度点数是相等的,且M=512;H为波峰高度;W为波谷宽度.

高度差(h):对重建高度值按列求平均,可得到褶裥织物的二维图像,从而求得波峰高度最高值与最小值的差值,即高度差.

3 试验与分析

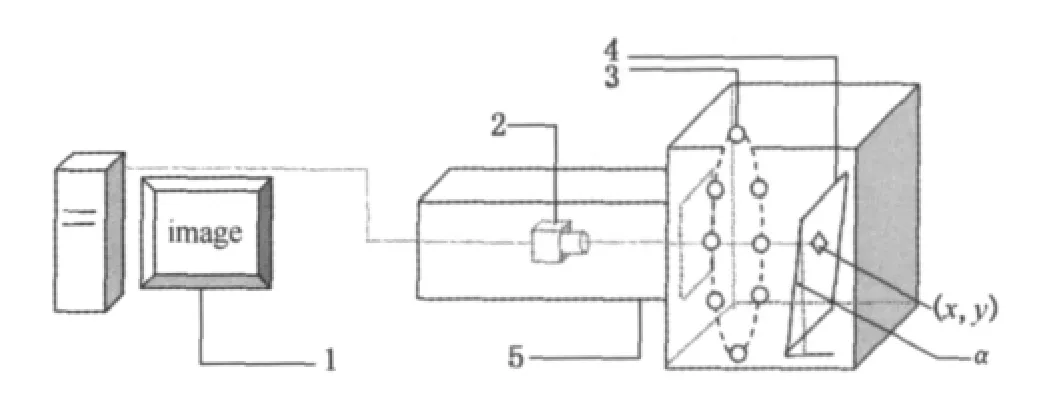

3.1 图像采集装置

图像采集装置如图1所示.采用北京嘉恒中自图像技术有限公司的OK-SC3010型CCD摄像机,分辨率为1 027像素×768像素,摄像头到织物的距离为100mm.光源系统为8只Philip 40磨砂白炽灯均匀分布的同一圆周平面,开发主机采用CPU大于600MHz,内存大于128Mbyte,5G以上的硬盘容量的配置.编程软件为VC++6.0.

图1 图像采集装置示意图Fig.1 Device for capturing images

此外,密闭的照明室可以防止外界光线的影响,从而提高织物重建的精度.鉴于人工评定时织物试样需倾斜5°,因此,将织物放置区设计成与竖直平面夹角呈5°,试样可以自然悬垂,保持褶裥形态不变.

3.2 褶裥织物表面重建

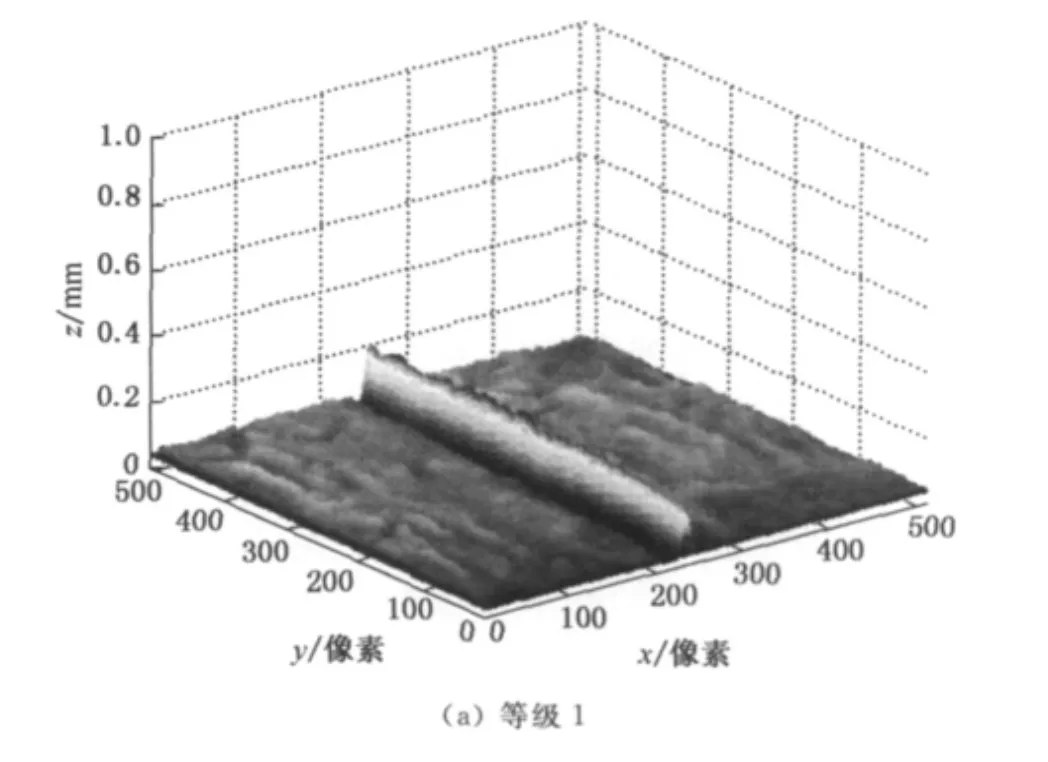

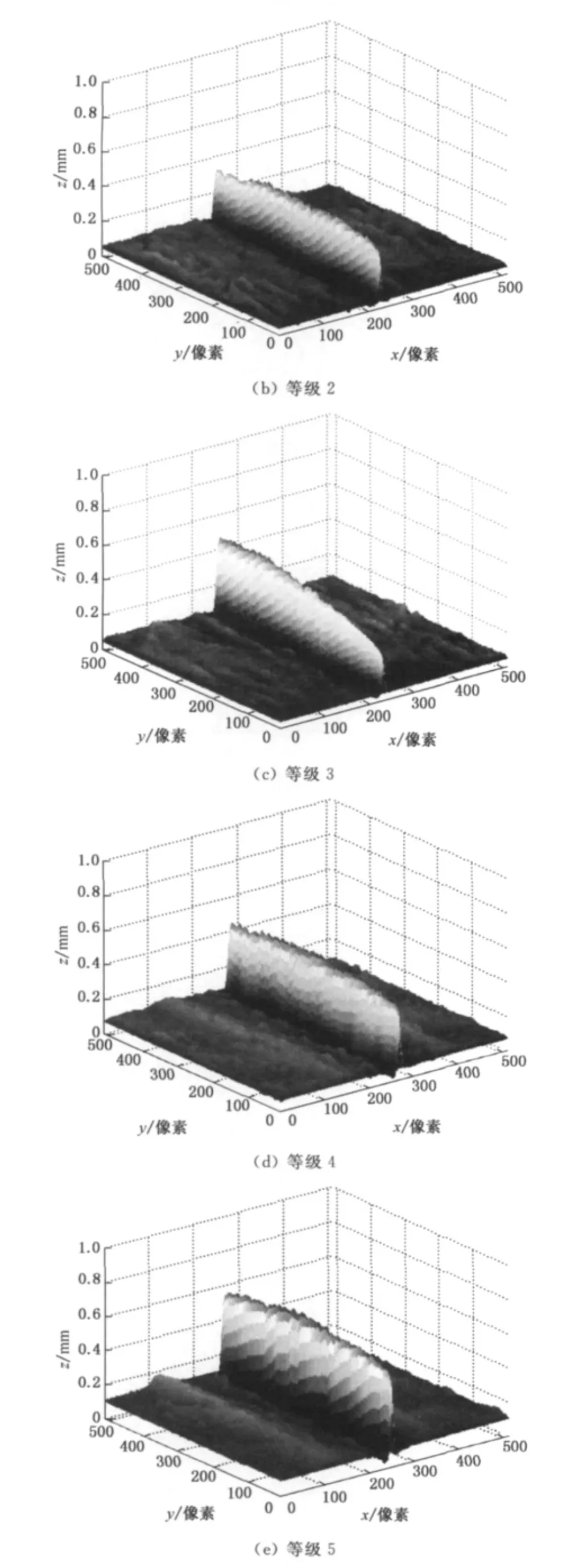

利用主观目测的方法,将具有褶裥特征的5块纯白色平纹棉织物分成1,2,3,4,5等级,依次对织物进行三维重建,并计算其特征值作为标准.根据织物褶裥等级的顺序把织物放在织物样品区,使织物自然悬垂,依次开启8个光源,分别得到8幅大小为30mm×30mm(512像素×512像素)的图像,经过换算每个像素约等于0.059mm.利用上述光度立体视觉算法分别得到5块织物表面各点的高度,并绘出织物的三维图像,如图2所示.

图2 褶裥织物表面重建图像Fig.2 Re-modeled surface shape of pleated fabrics

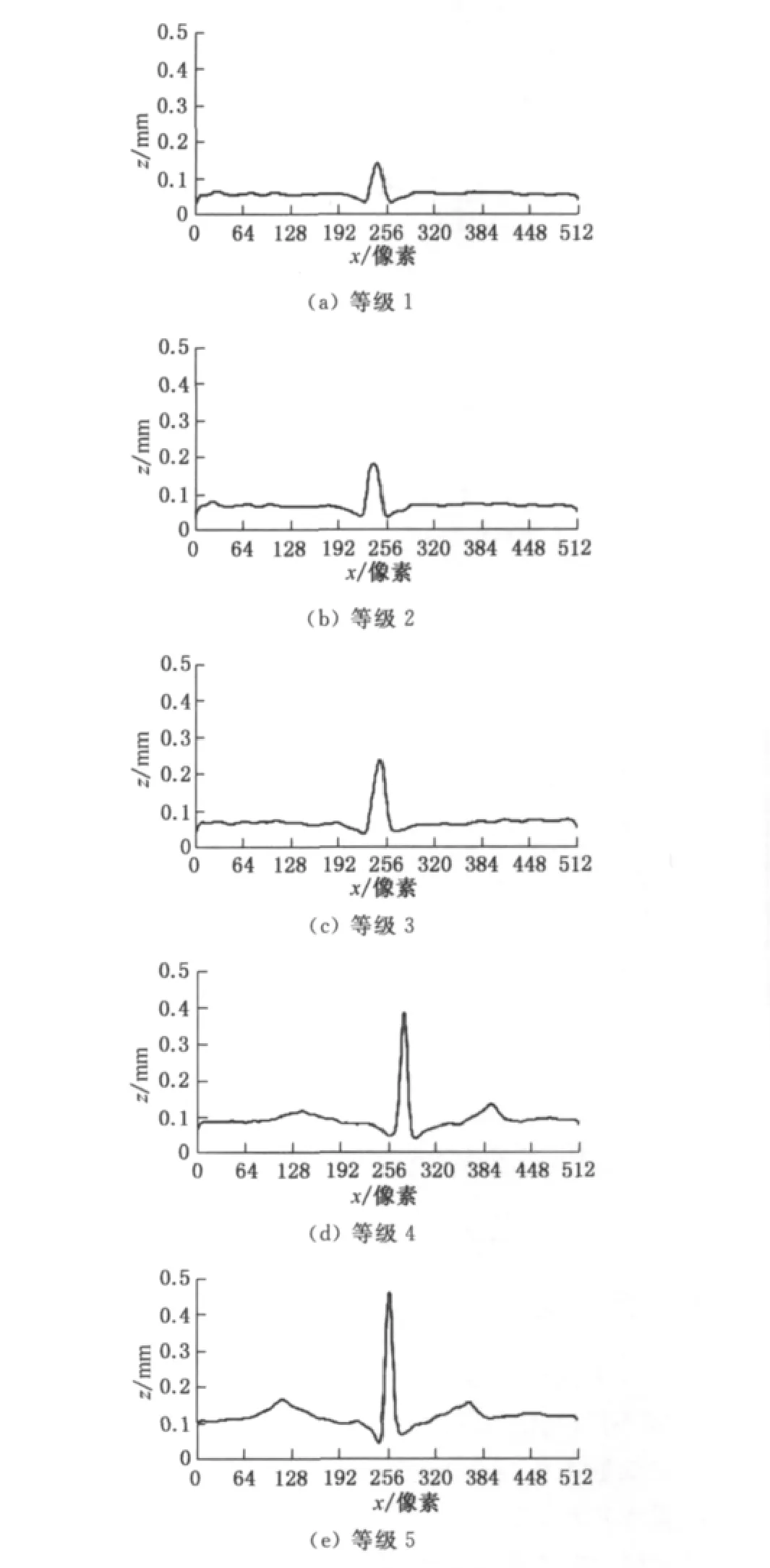

图2中,x轴和y轴分别为与褶裥垂直和平行方向,z轴为织物表面高度方向.由图2可知,织物重建图像随着褶裥等级的增大,织物褶裥高度有明显的增加,突出比较明显.将三维高度数据沿y轴求平均,得到织物侧面投影图,如图3所示.

图3 褶裥织物侧面投影图Fig.3 Projection of pleated fabric side

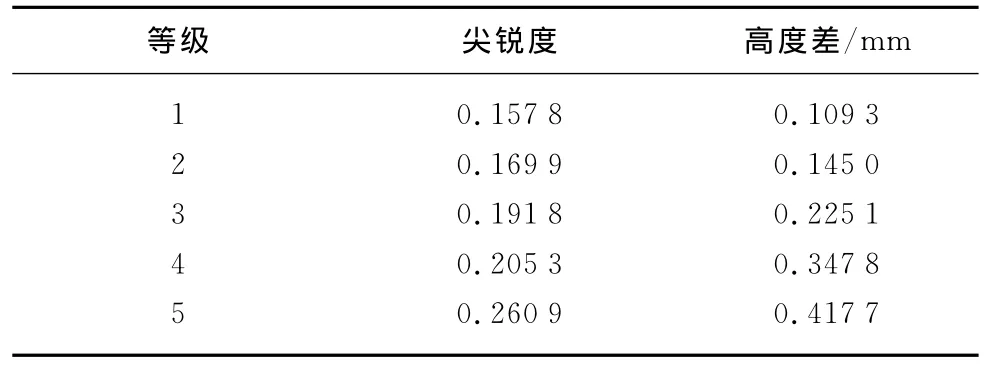

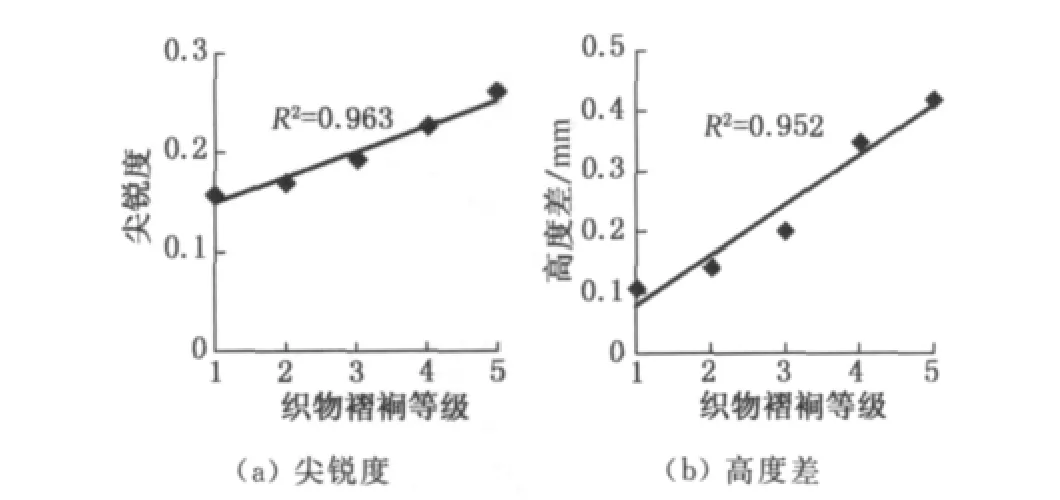

表1为5个等级褶裥织物计算所得到的特征值,图4为褶裥等级与特征值的相关性.将特征值与褶裥织物等级进行线性拟合,其相关系数均在0.95以上,这说明尖锐度和高度差能够较好地表征褶裥织物的特征.

表1 5个等级褶裥织物计算特征值Table 1 The features of fabric pleat with five grades

图4 褶裥等级与特征值相关性Fig.4 Correlation of feature index with pleat grade

从图4可看出,随着褶裥等级的增大,图像的尖锐度和高度差也会随之增大,这样便可很好地区分褶裥特征相近的织物.

3.3 试验验证

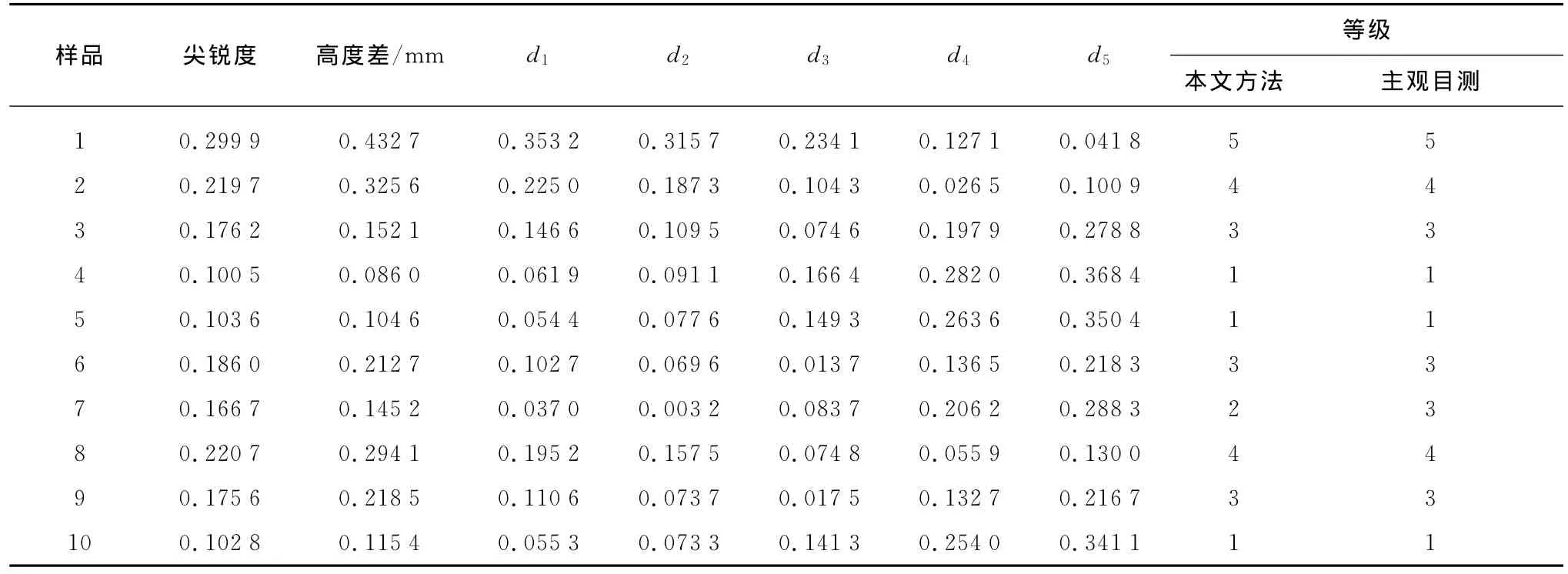

分别取褶裥织物样品10块,对其进行三维重建,计算特征值,依据欧氏距离判别法对其进行评级.欧氏距离也称欧几里得度量,这是一个常用的距离定义,它是在m维空间中的两个点之间的真实距离,在二维中的欧氏距离计算式为

其中:a和b分别代表尖锐度和高度差.

褶裥织物样品的尖锐度和高度差,以及与5个标准等级的欧氏距离计算如表2所示,其中,d1,d2,d3,d4,d5分别为与1,2,3,4,5等级的欧氏距离.与主观评定相比较,客观评定准确率为90%.

表2 褶裥织物样品等级评定Table 1 The grade evaluation of pleated fabric samples

4 结 语

本文利用光度立体视觉法重建褶裥织物表面形状,采用封闭的照明系统,避免了外界光照的影响,使之能够采集到更加精确的二维灰度图像,提高织物重建精度,并选取尖锐度和高度差评价织物褶裥的等级.经过试验证明,本算法能够有效地区分褶裥的特征,并能够对其进行评级,从而克服了主观评定法中人眼存在盲斑及心理等主观因素的影响,能够客观地评价织物经洗涤后褶裥保持性的等级.

参 考 文 献

[1]GB/T 13770—2009纺织品评定织物经洗涤后褶裥外观的试验方法[S].

[2]STYLIOS G,SOTOMI J O.Investigation of seam pucker in lightweight synthetic fabrics as aestheic property,part 1:A cognitive model for the measurement of seam pucker[J].The Journal of the Textile Institute,1993,84(5):593-600.

[3]XU B G.An overview of application of image analysis to objectively evaluate fabric appearance[J].Textile Chemist and Colorist,1996,28(3):18-23.

[4]NA Y,POURDEYHIMI B.Assessing wrinkling using image analysis and replicate standards[J].Textile Research Journal,1999,65(3):149-157.

[5]HESARIAN M S.Evaluation of fabric wrinkle by projected profile light line method[J].The Journal of the Textile Institute,2010,101(5):463-470.

[6]徐建明,汪军.织物平整度等级客观评估系统的研究[D].上海:东华大学纺织学院,2006:13-25.

[7]张军,彭国华,戴霞.一种基于光度立体图像的3D模型重建算法[C]//中国计算机图形学进展2004.西安:西北工业大学出版社,2004:193-194.

[8]李昊宇,李伟,徐小波.基于光度立体法的翘板黑瓜子识别方法研究[J].农业工程学报,2007,23(5):159-163.

[9]郭东明,周伟峰,吴秀春.一种基于单目多幅图像的三维曲面重构方法[J].计算机工程与应用,2002(9):55-57.

[10]杨晓波,黄秀宝.基于阴影恢复形状的起皱织物表面形态重建研究[J].中国图象图形学报:A版,2003,8(2):181-186.

The Evaluation of Fabric Pleat Grade Based on Photometric Stereo

LIURui-xina,LILi-qinga,WANGJuna,b,CHENXiaa

(a.College of Textiles;b.Key Laboratory of Textile Science &Technology,Ministry of Education,Donghua University,Shanghai 201620,China)

The assessment of pleated fabric mostly depends on experts'subjective appraisement and the results are uncertain.A method to evaluate fabric pleat grade was proposed based on photometric stereo algorithm.Two-dimensional gray-scale images of fabric were captured under the illuminations from8 different directions,and the heights of the fabric's surface points were rebuilt with one time difference calculation.Then the surface shape information of the fabric was acquired with 3D reconstruction.The fabric pleats'altitude difference and sharpness could be characterized for the pleat features.The grade of fabric pleat could be evaluated from the features objectively.

fabric pleat;grade evaluation;photometric stereo;3D reconstruction

TS 102.6

A

1671-0444(2013)01-0048-05

2011-10-25

刘瑞鑫(1986—),女,山西长治人,硕士研究生,研究方向为数字化纺织.E-mail:liuruixin@mail.dhu.edu.cn

李立轻(联系人),男,副教授,E-mail:liliqing@dhu.edu.cn