一种基于背景重建和视差图的立体视频对象分割算法

2013-05-11王凌云李朝晖李冬梅

王凌云,李朝晖,李冬梅

(中国传媒大学 信息工程学院,北京 100024)

1 引言

随着计算机视觉技术的快速发展,人们已经不满足于二维图像所传递出的信息,而是更希望获得能使人产生强烈沉浸感和临场体验的立体视频,因此立体视频技术获得了越来越多的关注。立体视频分割是基于对象立体视频编码的关键步骤,同时也是立体视频编辑与合成、三维场景重建的基础,故而对立体视频对象分割技术的研究具有十分重要的理论和实际意义。

立体视频对象分割技术是在图像分割技术和单通道视频分割技术的基础上发展起来的。不同的是,立体视频具有单通道视频所不具有的深度信息,它包含了三维场景中物体的空间信息,这些信息可以用来分割处于不同深度层面的目标对象。

中国传媒大学的吕朝晖[1][2]等人提出了基于分水岭算法和均值漂移的立体视频对象分割算法,两种算法均采用直接对视差图进行分割的方法获取视频对象。这种算法对视差图精度要求比较高,而且没有利用视频序列在时域上的相关性。宁波大学的朱仲杰[3]等人在单通道视频对象分割的基础上采用轮廓跟踪匹配算法提取立体视频目标对,然后提出一种基于目标的视差估计算法来得到视频对象,这种算法运算时间短,但对初始轮廓的精度比较敏感。吉林大学的王世刚[4]等人结合视差图提取和二次帧差运动提取,提出了一种新算法:对立体图像对进行一维窗匹配,初次提取出不同深度层面上的目标对象;然后在模板范围内进行二次帧差提取,再结合边缘检测得到较为精确的运动对象。这种算法对视差图精度的要求比较大,不适用于遮挡区域较大的视频序列。

不难看出,对于立体视频分割技术的研究已经取得了不少成果,但依然还有很大的研究空间。本文提出了一种基于背景重建和视差信息的分割算法,将广泛应用于单通道视频分割的背景重建算法与立体视频特有的视差信息相结合,实验结果表明,该算法能够有效地分割出立体视频中的运动对象,同时解决了背景中存在运动物体时,运动对象的提取问题。

2 立体视频分割算法

2.1 算法基本思想

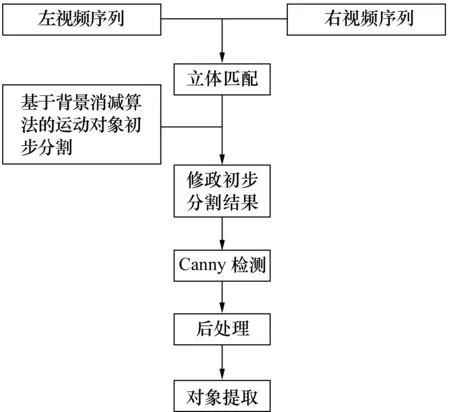

本算法的基本思想是:先采用基于块的背景重建方法获取立体视频序列的背景信息,然后利用背景消减算法获得运动对象的初步分割结果,再利用通过立体匹配获得的视差图对初步分割结果进行修正,最后利用边缘信息和后处理操作获得最终的立体视频运动对象。图1为本算法的基本流程图。

图1

2.2 基于背景消减算法的运动对象初步分割

计算每个差分子块的亮度:

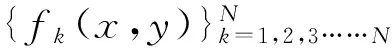

如果子块属于背景区域,那么该子块的亮度应该很小,根据这一准则可以得出子块B(k,i,j)属于背景条件为:F(DB(k,i,j))≤T,理想状态下,T的值应该为0。但是由于光照、噪声等因素的影响,T的值一般都大于0,具体数值由实验获取。如果B(k,i,j)属于背景子块,则将该子块复制到背景帧的对应位置。每处理一帧图像,判断背景帧是否已经被填满背景数据,如果没有填满,则继续处理下一帧,直到背景帧完全填满,背景帧获取的流程图可以用图2表示。

图2 背景重建流程图

在获得重构背景帧之后,通过将背景帧与当前帧相减的方法获得运动对象的初步分割结果,但直接相减的图像通常存在噪声、空洞和毛刺等,而且若视频序列背景中也存在运动物体,则不能一次检测出运动主体,这些问题将通过视差图和边缘信息等进行修正。

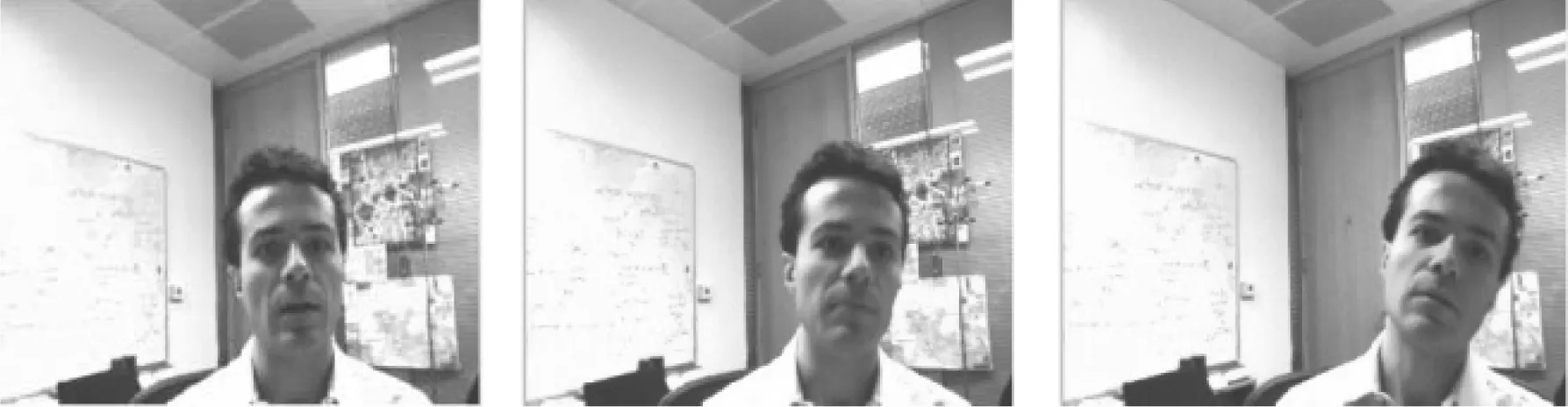

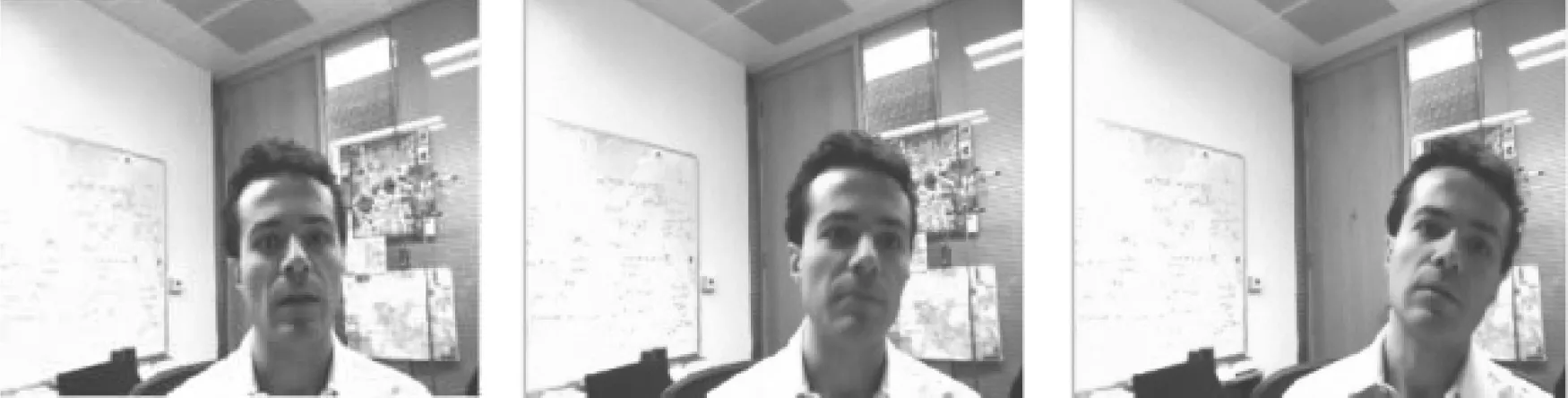

图3和图4分别是典型立体视频序列AC和IU的重建背景图和运动对象的初步分割结果,从图3和图4中可以看出,背景帧中下部均有一部分背景不够完整,这主要是由于运动对象肩膀或者上身部分的运动范围很小,始终挡住了背景,但不完整的部分均在运动对象内部,因此不会影响检测到运动对象的边缘,也不会对最终结果产生影响。另外,IU序列除了前景中的运动主体以外,背景中也存在运动物体,若只采用背景消减的方法,显然不能起到分割出运动主体对象的效果,因此,还需要利用视差图来将位于不同深度层上的运动对象区分出来,完成运动对象分割的目的。

第5帧 第30帧 第100帧 重建出的背景

第5帧 第30帧 第100帧图3 典型立体视频序列AC的重建背景图和初步分割结果

第20帧 第30帧 第80帧 重建出的背景

第20帧 第30帧 第80帧图4 典型立体视频序列IU的重建背景图和初步分割结果

2.3 视差图估计

所谓视差是指立体成像系统中,三维场景的一个点在不同图像中投影点位置的差异,包括各摄像机的摄像角度、相对运动及场景中对象的运动所产生的差异。假设摄像机的焦距为F,图像对的基线距离为B,令pl和pr分别代表点P在左右图像上的投影,(x1,y1)、(xr,yr)分别代表p1和pr的坐标,则视差矢量为:

d=(x1-xr,y1-yr)

(1)

在平行双目摄像系统中,y1=yr,因此视差d与景物深度z的关系可以简化为:

(2)

由式(2)可知,如果两摄像机的相对位置及焦距已知,由视差图就能计算出场景中可见点的深度信息。

从目前的研究成果来看,视差图通常是根据立体匹配算法获取的,而立体匹配算法大致可分为基于特征和基于区域两类方法[5]。其中,基于特征的方法,主要是通过提取点、线或边缘等特征,然后对特征点进行匹配。但基于特征的方法只能得到稀疏的视差图,不利于修正对象的运动范围。而基于区域法可以得到高密度深度图[6],尽管有在遮挡区域、无纹理区域以及深度不连续处可能得不到正确结果的缺陷,但基本可以满足分割的需求。

在平行双目摄像系统中,右图像可近似看作是左图像中各像素点沿水平轴平移的结果,即左图中第N行中某点若在右图中存在匹配点,则该匹配点必然在右图中的第N行。另外,进行由左图像至右图像的立体匹配时,实际是在右图像中找左图像中某点的匹配点,因此,视差在水平方向上的分量是负的。因此,只需在水平方向进行负向匹配,匹配范围为0到最大视差。

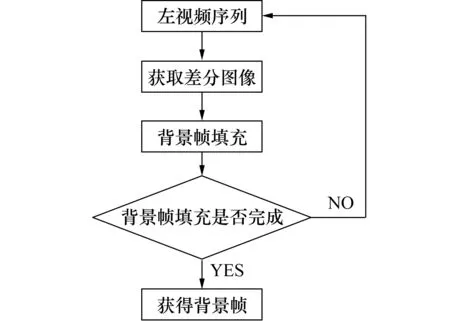

本算法采用基于区域的累计绝对误差和(sum of absolute difference,SAD)算法进行每个像素的视差提取,其定义如下:

-fR(x+i-j,y+i)|

(3)

其中,win表示窗口大小,j的取值范围为[0,最大视差值]。fL(x+i,y+i)和fR(x+i-j,y+j)分别表示左图像和右图像中对应像素的像素值。[0,最大视差值]范围内,SAD最小值对应的j值即为左图像(x,y)点的视差值。该算法具有不需要乘法运算、实现简单方便的优点。

匹配点搜索的具体流程如下:

(1)以左图像的点(x,y)为中心,构造一个M*M的小窗口,M=2*win+1。

(2)用M*M窗口覆盖右图像以点(x,y)为中心的同样区域。

(3)按照(3)式计算(x,y)点的SAD值

(4)在[0,最大视差值]的范围内,水平负向逐像素移动右边图像的窗口,重复(2)和(3)的操作,此时右图中窗口的中心为(x-j,y)。

(5)找到搜索范围内使SAD值最小的j值,即找到了左图(x,y)点的匹配点(x-j,y),而j的值则表示(x,y)的视差。

图5和图6分别给出了AC和IU序列的视差图,从图中可以看出,采用SAD算法计算出的视差图并不十分准确,但是前景中的运动主体和背景中的运动物体在视差上的差别很容易区分,而且,右边缘的视差边缘十分明显(由于该算法采用的是以右图为参照,在左图上计算视差的方法,因此遮挡的干扰使得运动对象左边的边缘不明显),因此,该视差图已经足够用于修正初步分割结果。但同时,计算出的视差图还存在很多噪点,会对修正效果产生影响,因此,本算法采用低通滤波去除噪声。

第5帧 第30帧 第100帧

第5帧 第30帧 第100帧图5 AC序列的视差图

第20帧 第30帧 第80帧

第20帧 第30帧 第80帧图6 IU序列的视差图

2.4 运动对象检测和后处理

运动对象通常深度较小,根据视差与深度的反比关系,可以通过设定阈值的方法,提取出对象的大致范围。将根据视差图获取的对象范围与经过运动检测获得的初步分割结果进行“与”操作,即可修正根据运动检测获得的初步分割结果,但修正后的分割结果仍然存在边缘不明显、内部存在空洞、边缘存在毛刺的缺点。

为此,本文采用了Canny检测来处理边缘信息,然后选取合适的结构元素并利用数学形态学对目标内部的空洞区域进行填充,以得到比较精确的分割效果。最终采用先膨胀后腐蚀的方法来达到填充空洞和去除毛刺的目的。

3 实验结果

采用典型立体视频序列AC和IU对本算法进行仿真,仿真结果分别如图7和图8所示。

第5帧 第30帧 第100帧

第5帧 第30帧 第100帧图7 AC序列分割结果

从实验结果可以看出,该算法可以有效的将运动对象分割出来。

第20帧 第30帧 第80帧

第20帧 第30帧 第80帧图8 IU序列分割结果

另外,AC序列背景固定且只有一个运动对象,采用单通道视频分割已经可以分割出比较完整的运动对象,视差图主要对初步分割结果进行二次分割,使分割更为精确。而对于有两个运动对象(深度存在差异)的IU序列,采用基于背景消减的单通道视频分割算法只能检测出运动对象,而不能准确区分出运动主体和背景中的运动物体,而立体视频所独有的视差信息则具备将位于不同深度层面的物体区分出来的能力,因此,对于背景中也存在运动物体的双目立体视频序列,本算法可以有效地分割出运动对象。

4 小结

本文提出了一种基于背景重建和视差图的立体视频对象分割算法,实验结果表明,该算法不仅能够有效地解决固定背景序列中运动对象的提取,还能够解决背景中存在运动物体时,运动对象的提取问题。但是本算法仅适用于背景中的运动和主动主体距离较远的情况,若两者在深度上差距不大,则需要进一步提高视差提取的精度,因此下一个阶段将对视差图的精确提取进行研究,以便使本文提出的算法应用于更为广泛的立体视频序列。

[1]吕朝辉,王晖.基于改进分水岭算法的立体视频对象分割[J].光电子·激光,2009,(09).

[2]沈萦华,吕朝辉.基于均值漂移的立体视频对象分割[J].电视技术,2010,(12).

[3]朱仲杰,蒋刚毅,郁梅,等.目标基视频编码中运动目标提取与跟踪新算法[J].电子学报,2003,31(9).

[4]Zhou qian,Wang shigang,Yang hong.Research on disparity-based object segmentation in stereo[C]/ / Proceeding of the Asia-Pacific Workshop on Visual InformationProcessing.Beijing:2006:115-118.

[5]Massicott J F,WilllsonS D,Wyatt R,et a1.1 480nm pumped erbium doped fiber amplifier with all optical automatic gain contml[J].Electron Lett,1994,30(12):962-964.

[6]An Ping,Zhang Zhao-yang,Ma Ran.Hierarchical MRF/GRF modelbased disparity estimation and segmentation for stereo images[J].ACTA Electronic Sinica,2003,31(4):597-601.