水冷背板在云计算机架中应用的可行性探讨

2012-09-25钟志鲲

钟志鲲

(中国电信上海公司电源空调中心)

0 引 言

云计算现在炙手可热,但云计算的定义却众说纷纭。对于运营商来讲,云计算是一种商用计算模型,它将计算任务分布在大量计算机构成的资源池上,使各种应用系统能够根据需要获取计算能力、存储空间和信息服务。

云计算系统架构分为服务系统和管理系统两大部分。在服务方面,主要以提供用户基于云的各种服务为主,共包含3个层次:基础设施即服务IaaS、平台即服务PaaS、软件即服务SaaS。在管理方面,主要以云的管理层为主,它的功能是确保整个云计算中心能够安全、稳定地运行,并且能够被有效管理。对于一个优秀的云系统,一定是从基础设施开始的,而动力系统,又是IaaS的重点,是可靠的高容量电源和良好的散热途径。

散热问题一直是机房安全稳定运行的关键和难点。对于目前应用的空调系统而言,风仍然是机房载冷的主体,因此问题就变得复杂,甚至会成为云机房发展的瓶颈。

1 云计算机架的容量问题

在云计算的潮流下,云计算数据中心具有超大规模和降低运维成本等特点。迫于市场竞争的压力,云计算的机架必须是高密度。由于目前并没有规范性的要求,因此各运营商所建设的云机房容量也不一致,就目前的实际情况看,8~10 k W/机架是起始点,32 k W甚至更高是目标点。

由此,云机架的热密度已经完全颠覆了传统的观念:例如,2 k W、3 k W、4 k W或2 k W、4 k W、6 k W等低、中、高密度的分法。热密度不大于6 k W/机架、6~12 k W/机架、大于12 k W/机架将成为新的三段热密度门限。

在十多年IDC机房的维护过程中,大量的经验和教训告诉我们,散热是数据机房的一个难题,也是必须解决的问题,即使在低密度机房,问题都很突出。而高密度,会使问题变得更尖锐和难于解决。

2 载冷问题

传统机房一般使用风为直接载冷,这种情况目前还没有很大的改观,主要是服务器目前还是使用风扇散热的。但是,从输送冷量的方式上分析,水输送冷量还是有很大的优势的。以专用空调10KJ/KG的冷风比计算,1个6 k W的机架,每小时需要2 160 kg的空气,折合1 670 m3/h,以风速3 m/s计,需要0.155 m2的通风截面。若以水来载冷,6 k W冷量需要5℃温差的水1.04吨,DN40的水管在2 m/s的流速下就可以满足。因此水系统只需要风系统的1%~1.5%的通道截面即可,可以节约大量机房空间。

而在载冷物质驱动能耗方面,气流是需要空调的风机作为驱动源的,而水系统是水泵作为驱动。一般风系统,每输送15 k W的冷量,就会需要1 k W的风机功耗。水系统的输送能耗会低一半,600 k W的冷量大约20 k W的电机驱动的水泵即可,折合30 k W/1 k W。并且,风机马达的热量是耗散在室内的,功率将全部需要冷量充抵,水泵的电机只是通过联轴器把机械功传递给水系统,电机的发热是隔绝在冷水系统之外的。

在利用自然冷源方面,虽然直接利用室外空气是最直接的、最高效的方法,但直接的质交换使灰尘、湿度的控制难度比较大,而且需要对增加不少通风设备、开凿大面积的墙洞。而利用水系统,只需要改变外围管路,可以直接利用冷却塔供冷,即使考虑水质问题,也只需要增加干式冷却塔即可,无需改动室内机组,避免了灰尘、加湿等难题。

3 计算机爱好者的实践

从奔腾5的CPU芯片应用开始,计算机的爱好者就开始进行原始的DIY方式,解决CPU发热量大且速度慢的问题,用水冷的散热器替代原来的金属铝散热片+风扇的方式,取得了很好的效果,甚至可以将CPU的主频提高30%以上,而工作温度比设计问题还低(见图1)。

后来,国外的一些厂商,研制了大量的高品质的液冷散热器,象 KOOLANCE、Heat Killer、Bitspower等(见图2)。对于提高液冷系统的安全性,起到了很好的推动作用,也为在大型数据机架上使用奠定了基础。多达数百万台的应用表明,只要采用质量可靠的部件,安装(尤其是接头部分)牢固,漏水的几率非常小,并且由于系统水量小,漏水也很少造成严重伤害。

图1 计算机的水冷系统

图2 各种CPU冷却头

4 数据机架应用液冷的方式

液冷是空气冷却能力的几十到上百倍,而且由于液体的比热容大,热稳定性很好,能对发热部件提供相对恒定的温度环境。因此,液冷衍生出几种运用方式:

(1)冷冻水专用空调方式:集中制备冷冻水,专用空调利用表冷器冷却机房回风,用专用空调风机送风冷却设备。这种方式离热源最远。

(2)列间空调方式:在每列服务器机架中,夹杂几个冷冻水列间空调,机架排风面为列间空调的进风口,机架的前面板方向为列间空调的送风口,列间空调使用多台小风机作为风路循环驱动。这种方式使冷水更靠近热源,依旧使用空气载冷,但风的方向要在很小的范围2次转向才能完成气流循环,因此不是很合理,容易形成乱流(见图3)。

图3 列间空调方式

(3)水冷背板方式:在机架背后直接悬挂水表冷器,无额外风机驱动,仅靠服务器内的风扇驱动气流,热量几乎是在产生点被直接对冲,机架总排风已基本不含高热。

(4)液体包方式:一般是液体包与机架整体设计,服务器处于液体冷却板的包裹之中,对已经在用的机架很难改造。液体包方式可以采用封闭式机柜,柜中有一套封闭的空气循环系统,这套空气循环系统与机房内环境相对独立。

液体直接冷却芯片:芯片的散热翅片改为水冷头,液体直接接入水冷头。目前很少有服务器能直接使用液冷。

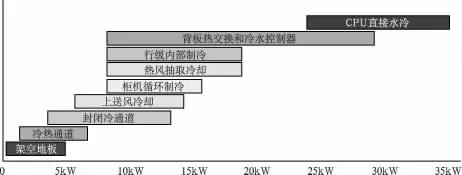

图4为各种冷却方式的适用情况,水冷背板的适用范围广,可以应用于6~30 k W/机架的密度,而且无需外加风扇。

图4 各种冷却方式适用情况

5 水冷背板+冷水分配器的运用方式

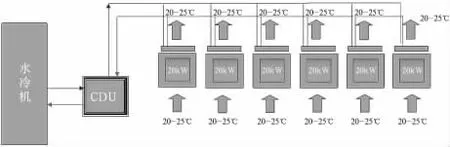

图5 冷水机+冷水分配器方式

图6 机架上改造的水冷背板

冷水机组制备冷冻水,供给冷水分配器(CDU)(见图5~图7)。冷水分配器需要起到3个主要作用:⑴将大系统的水压降低,一般用板式换热器,类似电源中的变压器。⑵调节一次侧和二次侧的流量,以控制二次侧的水温高于机房露点温度,防止结露。⑶合理分配二次侧各支路的流量,适应各机架的热负荷。

图7 冷水分配器CDU

设计优良的CDU在进水、出水、水泵等都为双路由,确保系统在使用期间可以进行在线维护、维修。在二次侧管路全部使用高压部件,但运行时保持低压力、小水量的水系统,同时具有完备的漏水检测系统,使机房免于水患。一般在二次侧仅有几十升的水量,一个标准背板的水容量只有2~3升。

6 水冷背板的应用效果

在实验环境中,服务器的排风口最高温度达43℃,即使与其他机位的气流混合,在机架背后60 c m处,仍达到31℃。利用传统专用空调方式制冷,空调机组就必须将31℃的回风冷却,再通过风路送到机架进风处(见图8)。

图8 实验环境中机架排风温度

图9 使用冷水背板后机架排风温度

而使用了冷水背板之后,机架排风温度明显下降,实验中得到了平均温度下降到19℃,甚至低于机架的进风温度。此时机架已经不是热源,对机房而言,可以认为是一台“小空调”(见图9)。

8 结 语

随着云机房的出现和发展,高热密度将成为机房的潜在危险,在单机架的容量超过6 k W后,传统的气流冷却方式很难解决散热问题,水冷背板将是解决这一难题的最佳辅助方法之一。而且,水冷背板在现网的改造是非常方便的。