复杂背景下基于贝叶斯-全概率联合估计的前景检测

2012-04-29李拥军徐克付

李拥军 曾 标 徐克付 李 阳

①(华南理工大学计算机科学与工程学院 广州 510006)

②(华南理工大学理学院 广州 510640)

③(中国科学院计算技术研究所信息内容安全技术国家工程实验室 北京 100190)

1 引言

目前,从图像序列中提取背景物体常用的方法主要是帧差与背景相结合的方法[1]。文献[2]提出了一种基于行扫描点线目标聚类合并的快速实时多目标检测算法,该方法在一定程度上避免了帧差法、投影法等传统检测算法带来的漏检;基于背景Codebook模型[3]的前景检测算法也是当前比较常用的目标检测算法,它比传统的目标检测算法具有更高的精确度和鲁棒性;另外,混合高斯模型(MOG)方法[4]在现实生活中得到大量应用;密度估计运动检测方法[5]也是当前研究的热点之一;文献[6]总结了一些经典背景建模方法的基本原理和优缺点。贝叶斯模型是一种不确定性知识的推理和描述,在图像分割中发挥着重要的作用[7,8]。贝叶斯采用“逆概率”思想,推算出该特征向量属于背景或前景的概率;全概率则是计算在某一像素点,出现某一特征的概率。由于以上文献所提出的模型对背景建模不具有一般性,只能对特定类型视频场景进行建模或者只能针对特定运动目标才具有较好的检测效果。因此,为了建立一个能够适应大部分视频场景的前景检测模型,本文提出了贝叶斯-全概率联合估计模型。通过对贝叶斯准则和全概率公式的结合,能够很好地检测处于复杂背景中的运动物体。

本文其它章节安排如下:第2节介绍贝叶斯-全概率的联合估计模型对背景和前景进行分类;第3节主要描述了基于贝叶斯-全概率的联合估计模型的算法流程;第4节对本文算法与其它两种算法的实验效果进行了比较,并对实验结果进行误差分析;第5节为结束语。

2 贝叶斯-全概率估计联合估计模型

2.1 问题说明

在视频处理中,背景一般由静止和周期性运动的对象组成。但是,随着时间的变化,背景可能经历两种不同类型的变化,一是由自然光线引起的变化;二是一些突发的环境变化。突发变化又分为全局突发变化和局部突发变化,全局突发变化可能由开关灯等引起的;局部突变化则可能是移除了某些背景物体。因此,背景的不同部分应该由不同类型的特征描述。

2.2 背景和前景特征信息的获取

对于某一种特定类型的背景对象,存在一些重要的特征,这些特征能够有效地分离背景和前景,利用贝叶斯估计法则,特征向量ξt来自背景b和前景f的后验概率满足[9,10]

如果特征向量满足:

则把这个像素归为背景,其中ψ为像素点。然而当背景中出现大量的前景物体时,背景将长时间被前景物体覆盖,导致式(2)中的两个条件并不能得到满足,为了能够在拥堵背景环境下更好地分离前景和背景,本文提出了背景误差控制的方法,即将式(2)变为

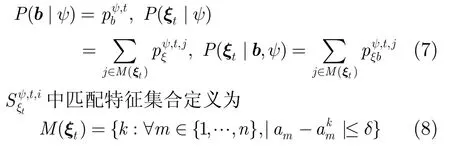

其中εi,i= 1,2,这里称之为背景误差控制变量。当前景物体运动缓慢或者视频场景中的前景物体较多时,通过选择恰当的εi,可以获得更多的前景点,减少前景点被误判的概率。把式(1)和全概率公式代入式(3)可以得到如下基于贝叶斯-全概率的联合估计模型:

对于L位n维的特征向量,P(ξt|ψ)或P(ξt|b,ψ)的联合直方图包含Ln个bins(bins为频数分布直方图中的小矩形),如果L或n的值很大,对于相关的计算或存储的代价将是巨大的,例如当L=32,n= 1 0时,Ln= 3210≈1015。可见,一个好的近似显得十分必要。背景被认为是稳定的对象,如果有一个好的特征选择,就可以用直方图中小部分的bins涵盖大部分与背景有关的特征向量。令为特征直方图中的前N个bins并按降序排列,对于给定的比例值M1,M2=1-M1,存在比较小的正整数N1,满足

自然地,N的值依赖于所选取的特征向量和位数L,对于每一种特征向量(来自前景或者背景),用(其中i= 1,2,…,N(N>N))表示特征统计221表,它记录了在像素ψ(x,y),时刻t处N2个最重要的值,表中的每一个元素由3个部分组成,即

当一个像素与稳定的背景相关时,选取颜色作为特征向量,本文采用HSV颜色空间对图像进行处理,即ξt用ωt=[ht,st,vt]T代替;当像素与运动背景相关时,颜色共生特性被选为特征向量,ξt用ωωt=[ht-1,st-1,vt-1,ht,st,vt]T代替。

3 贝叶斯-全概率联合估计前景检测算法

3.1 算法过程

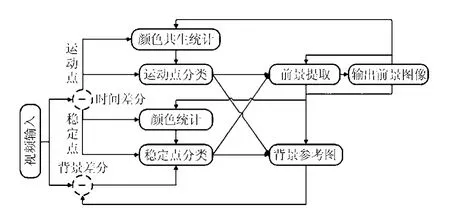

本文的算法包含3部分:像素变化检测,背景和前景像素点的分类,前景物体的提取和参考背景的更新。算法结构如图1。

图1 本文算法对前景提取的算法流程图

3.1.1 像素变化检测根据不同场景,选择适当的控制变量参数εi,i= 1,2,将视频图像转换为HSV图像空间。令I(ψ,t)={Iω(ψ,t)}为输入图像,B(ψ,t)={Bω(ψ,t)}为系统在时刻t保存的参考背景图像,其中,ω∈ {h,s,v}表示颜色组成成分。将3个组成部分的结果相结合,产生背景差分Fbd(ψ,t)和时间差分Ftd(ψ,t)。

3.1.2 背景和前景像素点的分类时间差分将变化的像素分为两种类型,如果Ftd(ψ,t)=1,这个像素被认为是运动的像素,且属于运动的物体,否则它是一个与静止物体有关的像素。它们进一步单独划分为背景或前景。对于静止的像素或运动的像素,特征向量的选择是依据 2.4节中提出的方法。将这种特征向量ξt与前N1个从对应背景的特征统计表格中获取的特征向量做比较,重新获取相似特征。令条件概率从式(7)获得。

其中δ为控制变量,这样相似的特征向量可以量化到邻域向量,统计仍然能够重新获得。经过大量视频的测试,当δ∈ [ 1.5,2.5]时,匹配效果最好。

3.1.3 前景物体的提取和参考背景的更新利用形态学运算(开运算或者闭运算)去除离散的点,输出图像O(ψ,t),提取前景物体。用特征向量ξt将像素分类前景或背景,对应特征统计用式(9)更新[11]。

其中i=1,2,…,N2,α2称之为学习速率,它用来控制特征学习的速度。当在t时刻,从最后分离反馈为ψ(x,y)为背景,则否则;当式(7)中的相匹配时,,否则。如果没有中的元素和ξ匹配时,则t表中的第N2个元素变为

当背景突然变化时,新的背景特征随即出现,则特征统计用以下式子进行更新:

3.2 更新参考背景图像

如果ψ为无关紧要变化的像素点,则Bω(ψ,t+ 1 )=( 1 -α1)Bω(ψ,t)+α1Iω(ψ,t)被用来对背景进行更新,其中ω∈ (h,s,v),α1为无限脉冲反应滤波参数;如果O(ψ,t)=0,Ftd(ψ,t)=1 或者Fbd(ψ,t)=1,Bω(ψ,t+ 1 )=Iω(ψ,t),ω∈ (h,s,v)则被用来对参考背景进行更新,这样参考图像就能够适应背景的突然变化。

4 实验结果与误差分析

4.1 实验结果

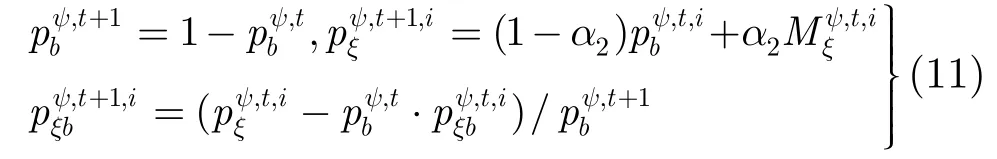

实验演示了许多复杂的室内室外视频场景,包括摆动的树枝,下雪环境,拥挤的路面和光照条件的变化等。为了验证本文算法在复杂背景环境下对前景的检测是否更具有适应性,本文选择了两种目前比较流行的算法与之对比:一是具有鲁棒性的背景相减法(RBS)[12];二是改进的混合高斯模型算法(MOG)[13]。这两种模型对光照变化都具有一定的鲁棒性。为了进行合理的对比,采取同样的形态学开运算或者闭运算对小区域消除。图2是本文算法实现与RBS和MOG法对比的效果图。其中(a)来自视频的一帧;(b)RBS算法处理的结果;(c)MOG算法处理的结果;(d)本文算法处理的结果;(e)人工素描,趋近真实的前景图。

4.2 实验误差及原因分析

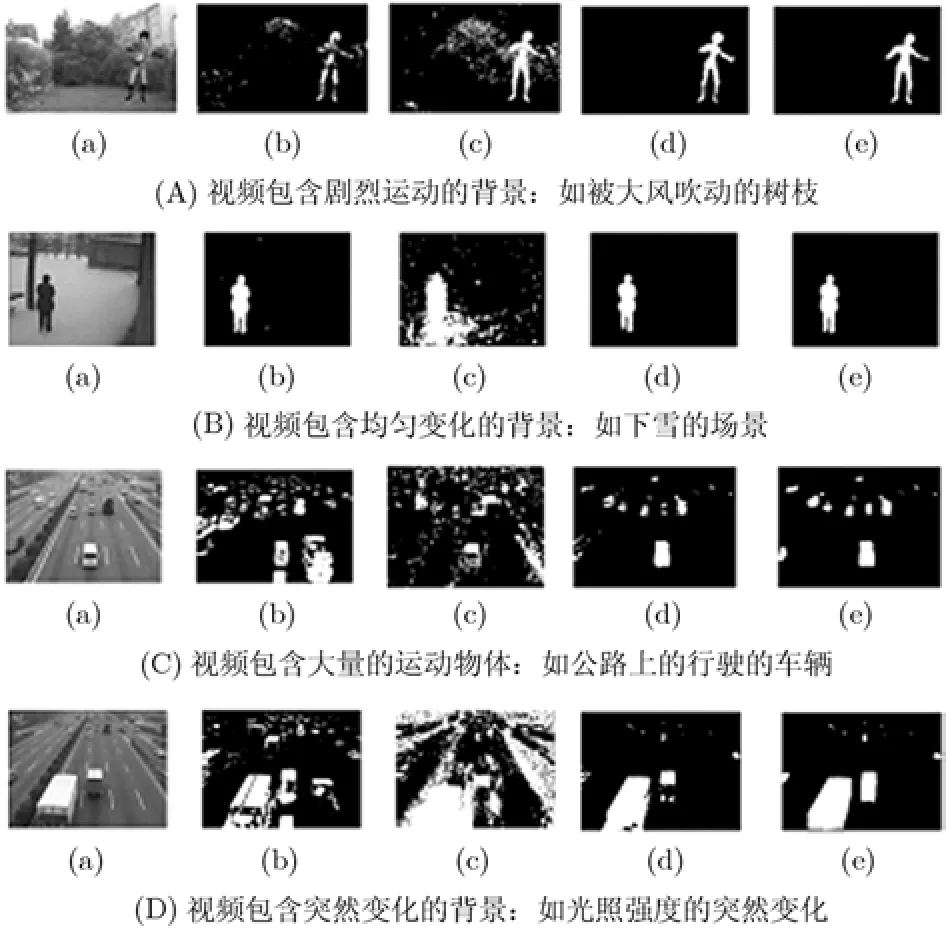

下面的一些概念是常用于对前景或背景检测效果进行评估的指标[14,15]:

4.2.1 实验误差图形描述

The Actual Number of Foreground (AF):当前帧实际前景点的数量;

The Actual Number of Background (AB):当前帧实际背景点的数量;

The True Positive Outcome (TP):已检测到并且为正常前景点的数量;

The True Negative Outcome (TN):已检测到并且为正常背景点的数量;

The False Positive Errors (FP):背景点被误检为前景点的数量;

The False Negative Errors (FN):前景点被误检为背景点的数量;

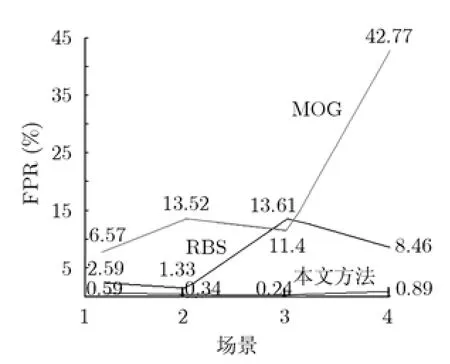

False Positive Rate (FPR):FPR=FP/(FP+TN):背景误判率;

图2 各种算法实验效果对比图

False Negative Rate (FNR): FNR = FN/(TP+ FN):前景误判率;

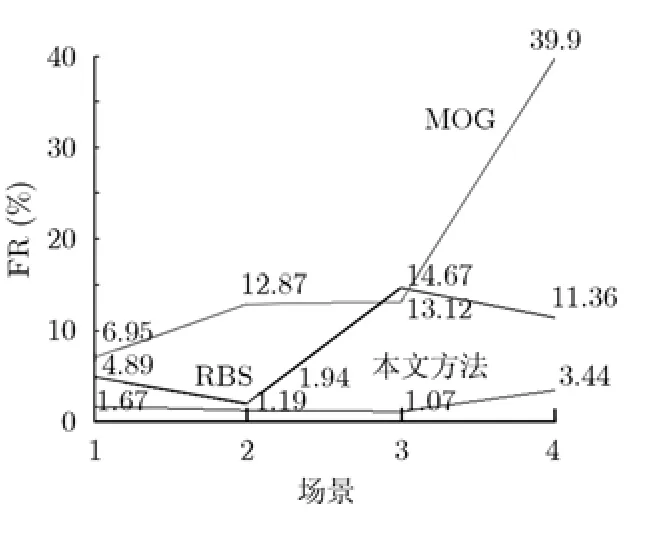

False Rate (FR): FR=(FP+FN)/(AF+AB):总体误判率。

表1为不同类型的前景像素点和背景像素点的数量统计表。表2为在不同检测方法下,不同错误率的信息统计表。

图3至图5根据表2绘制出来的,图中横坐标代表场景,纵坐标表示错误率(%)。

4.2.2 实验误差原因分析图3至图5中显示了在不同算法和不同实验背景环境下,不同类型误差对比的折线图,下面对 RBS, MOG以及本文算法这 3种算法进行误差分析:

(1)RBS算法:从图3中可以清晰地看到FPR的数值大小总体上是可以接受的,但是当视频中含有大量前景物体时(图2(C)和图2(D)),FPR偏大。从图4可以看出,FNR总体也偏大。出现这种问题是因为当前景比较密集且分布不均匀时,造成背景无法得到及时更新,最终导致了像素点的误判。然而当背景像素点变化比较均匀且前景运动物体比较少时,RBS方法对前景的检测性能是比较好的(例如,图2(B)(b))。

(2)MOG算法:通过观察图3,图4和图5中MOG模型误差曲线,不难发现FPR, FNR和FR值都相对较大。不过MOG模型一般能够检测出大部分前景像素点。但是由于存在大量像素点的误判,因而在总体上,MOG模型在处理复杂背景环境时,并不是一种理想的方法。导致MOG模型对前景物体检测失败的原因是:当背景中出现大量剧烈运动的背景像素点或者背景环境突然变化时,像素点不符合高斯分布,最终导致高斯建模失败。

(3)本文算法:相对RBS和MOG算法,从图3至图5中本文算法的FPR, FNR和FR曲线可以清晰地看出本文的算法对复杂背景条件下前景检测具有更明显的优势。但是也丢失了一些前景点,主要有两个原因:一是当场景中的前景和背景的H,S,V 3个分量之间的数值非常接近时(例如,图2B(b)中人的衣服和树木都为黑色),前景点会被误判为背景;二是在前景出现之前,视频预处理的帧数较少在一定程度上也会使模型的建立存在误差。但是,经过大量复杂背景场景的反复测试,本算法具有更高的准确性和可靠性。

表1 不同类型的前景像素点和背景像素点的数量统计表

表2 在不同检测方法下,不同错误率的信息统计表(%)

图3 FPR曲线图

图4 FNR曲线图

图5 FR曲线图

5 结束语

本文提出了一种基于贝叶斯-全概率的联合估计模型,并结合误差控制变量来从视频流中检测和分离前景物体。大量实验表明,本文的算法对前景物体的提取效果是比较理想的。本文算法的主要不足之处是,当前景像素和背景像素H, S, V分量较为接近时,部分前景像素点会被误认为是背景。另外,当某个前景物体移动很缓慢,则会导致这个前景物体的一些像素点会被误判为背景像素点,拓展颜色共生向量可以在一定程度上减少前景像素误判的问题,结合光流法确定光流场[16]也是一种可以参照的方法,但都会在一定程度上增加算法复杂度,影响前景的实时检测,这也是需要进一步研究的内容。

[1]Tsai Tsung-han, Lin Chung-yuan, Peng De-zhang,et al..Design and integration for background subtraction and foreground tracking algorithm[C]. Fifth International Conference on Information Assurance and Security, Xi’an,Aug. 18-20, 2009, 2: 181-184.

[2]叶有时, 唐林波, 赵保军. 一种基于聚类的深空红外多目标快速检测算法[J]. 电子与信息学报, 2011, 31(1): 77-84.Ye You-shi, Tang Lin-bo, Zhao Bao-jun. A fast deep-space infrared multi-target detection algorithm based on clustering[J].Journal of Electronics&Information Technology, 2011, 31(1): 77-84.

[3]熊亮, 刘伟铭. 基于背景Codebook模型的前景检测算法[J].科学技术与工程, 2010, 10(9): 2118-2121.Xiong Liang and Liu Wei-ming. Foreground detection algorithm based on background codebook model[J].Science Technology and Engineering, 2010, 10(9): 2118-2121.

[4]Zeng H C and Lai S H. Adaptive foreground object extraction for real-time video surveillance with lighting variations[C].IEEE International Conference on Acoustics, Speech, and Signal Processing, Honolulu, HI, USA, April 15-20, 2007,I-1201-I-1204.

[5]周恩策, 刘纯平, 张玲燕, 等. 基于时间窗的自适应核密度估计运动检测方法[J]. 通信学报, 2011, 32(3): 106-114.Zhou En-ce, Liu Chun-ping, Zhang Ling-yan,et al..Foreground object detection based on time information window adaptive kernel density estimation[J].Journal on Communications, 2011, 32(3): 106-114.

[6]代科学, 李国辉, 涂丹, 等. 监控视频运动目标检测减背景技术的研究现状和展望[J]. 中国图像图形学报, 2006, 11(7):920-927.Dai Ke-xue, Li Guo-hui, Tu Dan,et al.. Prospects and current studies on background subtraction techniques for moving objects detection from surveillance video [J].Journal of Image and Graphics, 2006, 11(7): 920-927.

[7]Rahimizadeh H, Marhaban M H, Kamil R M,et al.. Color image segmentation based on Bayesian theorem and kernel density estimation[J].European Journal of Scientific Research, 2009, 26(3): 430-436.

[8]Zribi M. Unsupervised Bayesian image segmentation using orthogonal series[J].Journal of Visual Communication and Image Representation, 2007, 18(6): 496-503.

[9]Bhaskar H, Mihaylova L, and Achim A. Video foreground detection based on symmetric alpha-stable mixture models[J].IEEE Transactions on Circuits and Systems for Video Technology, 2010, 20(8): 1133-1138.

[10]Kim K and Davis L S. Object detection and tracking for intelligent video surveillance[J].Multimedia Analysis,Processing and Communications, 2011, 346(2): 265-288.

[11]Yu Sheng-yang, Wang Fang-lin, Xue Yun-feng,et al..Bayesian moving object detection in dynamic scenes using an adaptive foreground model[J].Journal of Zhejiang University Science A(An International Applied Physics&Engineering Journal), 2009, 10(12): 1750-1758.

[12]Li L and Leung M K H. Integrating intensity and texture differences for robust change detection[J].IEEE Transactions on Image Processing, 2002, 11(2): 105-112.

[13]Huang Xin-juan, Zhou Jie-min, and Liu Bo-yang. Moving objects detection approach based on adaptive mixture Gaussian background mode[J].Journal of Computer Application, 2010, 30(1): 71-74.

[14]Wikipedia. Sensitivity and specificity. http://en.wikipedia.org/wiki/Sensitivity_and_specificity, 2011.

[15]Wikipedia. Confusion matrix. http://en.wikipedia.org/wiki/Confusion_matrix, 2011.

[16]Li Wei, Wu Xiao-juan, and Zhao Hua-an. New techniques of foreground detection, segmentation and density estimation for crowded objects motion analysis[J].Journal of Information Processing, 2011, 19(4): 190-200.