用于视频监控的特定声实时定位系统

2010-09-17曾春燕窦维蓓

张 勇,曾春燕,窦维蓓

(清华大学 电子工程系,北京 100084)

1 引言

声音定位技术有广阔的应用前景,比如多媒体安全监控[1-2]。在多媒体安全监控系统中,声音定位系统可以估算出声源方向,以此控制摄像头的方向,可以提高摄像镜头对异常事件的捕捉能力,对室内外环境进行有效监控。

常用的声音定位技术主要有:基于TDoA的声音定位技术[3-5],基于高分辨力的空间谱估计的声音定位技术[6-7],基于神经网络的定位技术,基于头相关传递函数的声音定位技术[8-10]。在这些定位技术中,后3种技术的复杂度相对比较高,而基于TDoA的声音定位技术相对来说比较简单,适合于低成本的实时系统,而且性能能够满足大多数应用场合的要求,所以应用得比较多。

基于TDoA的定位算法的现有研究中,大多在努力提高定位的精度。但是,在实际的应用中,除了希望提高定位精度,更希望系统只对特定的声音进行定位,忽略其他类型的声音。这可以大大提高系统的抗干扰能力,提高系统的实用性。

为此,笔者提出了一种对特定声定位的系统,它利用广义互相关(GCC)方法估算声音到达传声器(即麦克风)的时间差TDoA,以此确定声源的方向;同时利用特定声检测技术,只有检测到特定声时,才输出定位结果。特定声定位系统框图如图1所示。

图1 基于DSP的特定声定位系统

在本系统中,首先对传声器的采集信号进行预处理,然后对声源方向进行定位并且检测声音类型,最后根据当前帧的声音类别决定是否输出定位结果。

2 基于TDoA的定位

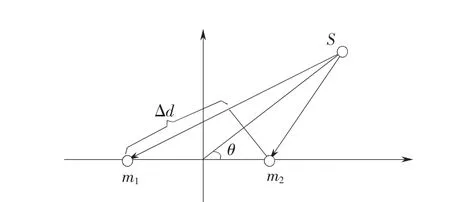

基于TDoA的声源定位如图2所示,S表示声源,m1和m2分别表示2个传声器,声源相对于传声器连接线的方向角是θ,从S传来的声音到达这2个传声器的距离差是△d,这将带来时间差△t。而且这个时间差△t和方向角θ密切相关,不同的θ对应不同的时间差,当方向角θ是0°或者180°的时候,时间差最大。当θ角是90°的时候,时间差是0。

2.1 广义互相关计算TDoA

在图2所示的模型中,可以用式(1)表示2个传声器的接收信号

图2 基于TDoA的声源定位

式中: s(t)表示声源信号;m1(t)和 m2(t)表示 2 个传声器接收的信号;n1(t)和 n2(t)表示 2 个传声器上独立的噪声,比如电噪声;t0表示信号到达两个传声器的时间延迟;α表示2个信号在幅度上的差别,假如传声器的距离不大,声源到达2个传声器的路径差别不是很大的时候,可以假定α=1。估算t0的简单有效方法就是互相关。一个信号的自相关函数在0点达到最大值,假如把一个信号延时t0后与原信号做互相关,它的峰值将会延时t0。所以在式(1)中,估算出 m1(t)和 m2(t)的互相关函数的峰值点,就知道了它们的延时t0。

然而,考虑到噪声 n1(t)和 n2(t)或者室内混响的影响,这种方法的定位性能不稳定。为了提高各种复杂环境下声音定位的性能,人们研究出了各种广义互相关算法。

广义互相关先对传声器接收信号 m1(t),m2(t)进行处理,然后再做相关,如图3所示。

图3 广义互相关算法的示意图[11]

图3中的H1,H2表示2个滤波器的传递函数。滤波后的2个信号求互相关函数,最后,进行峰值检测,找到峰值点,这就是 m1(t)和 m2(t)之间的相对延时。

不同的滤波器就对应了不同的广义互相关算法。文献中,有的互相关算法是适用于噪声环境下的定位,比如最大似然法(HT)[12],也有的算法适用于混响环境的定位,比如相位变换方法(PHAT)[11]。也有利用声源本身的特点对声源定位,比如利用人声的基音[5]或者是线性预测误差[13]。在混响环境中,人声的频谱会产生畸变,但是基音的频率和线性预测误差的时间规律不会改变,所以这些算法适合于混响环境。

在本文的系统中,要对室内和室内的特定声方向进行定位,分别采用PHAT和HT方法。PHAT方法的原理推导在文献[11]中有详细推导,这里只给出计算公式

2.2 根据时间差确定声源方向

根据TDoA和传声器排列的几何位置定位方法主要有最大似然算法和闭式表达式法。闭式表达式法算法复杂度低,其性能在实际应用中也能满足要求,所以得到了广泛的应用。闭式表达式法主要有交叉双曲线、球插值算法等。假定声音是远场信号,还可以用简单的方法得到声源的方向角。远场信号示意图如图4所示。

图4 系统实现框架图

图4中,L,R代表2个传声器,dm是2个传声器的距离,ds是到达距离差(TDoA乘以声波速度)。方向角θ为

计算出每一帧的角度后,还需要对异常结果进行处理。在笔者提出的特定声定位系统中,计算出了声源的方向角,就可以控制摄像机转向声源方向,对该方向的场景进行监控。

3 特定声的检测

特定声是指在特定的应用场合中需要特别关注的声音。比如在安全监控中,枪声的出现意味着有异常事件的发生,所以枪声就是特定声。

为了检测特定声,对现场采录的信号进行特征提取和分析,把当前声音进行分类。在本系统中,采用如图5所示的二级分类树。

在第一级分类中,以过零率作为特征,把声音分为噪声和非噪声。在第二级分类中,利用子带能量等特征把非噪声分为枪声和人声。过零率和子带能量等特征的提取过程都不复杂,适合在DSP中实现。

图5 特定声检测用的分类树

4 DSP实时系统的构建和试验结果

为了验证特定声定位系统的精度以及特定声检测模块对枪声检测的准确性,构建了一个基于ADI公司的Blackfin 16位定点处理器ADSP-BF561的特定声定位实时系统。

4.1 实时定位系统的组成

实时定位系统由3个子系统组成,如图1所示,声音采集放大、数据处理和输出结果的图形显示等子系统。

在声音采集放大子系统中,使用2个型号是SMM310的硅微传声器,它们的间距是12.75 cm。硅微传声器的对称性比较好,信噪比64.5 dB,灵敏度-42 dB。由于传声器信号的输出电压范围是微伏级,而后级的AD转换器输入的动态范围是0~1 V,所以设计了一个用运放组成的负反馈放大电路,它的放大倍数是100倍。

数据处理子系统中,采用ADI公司的ADSP-BF561 EZkit Lite,它有AD1836作为AD转换器,采样频率可以高达96 kHz。其DSP处理器是ADI公司的Blackfin系列中的双核16位定点处理器,2个独立的DSP核,可以工作到750 MHz。系统中,一个核做输出结果的图形化显示,另外一个核做声音定位和特定声检测计算。

输出结果的图形化显示是由东方迪码公司的SSK-561完成,这是ADSP-BF561 EZkit Lite的接口扩展板,板上的TFT显示器是TopSun公司的TS35ND1501, 24位真彩色,分辨力是240×320。

图6是笔者设计的定位结果输出图形界面,图中半圆表示声源定位的有效范围,本系统只对传声器前方180°范围的声源定位。圆上的小球指示了当前声源的大致方向,下面的数字表示声源的角度。左下方的图标表示当前声音类别是枪声,右下方图标表示当前声音是人声。

4.2 误差计算方法

本测试中,为了验证定位系统的估算角度与实际角度的偏差,测量了音箱相对于传声器的实际角度。但是,由于直接测量音箱到传声器阵列的绝对角度比较困难,笔者测试的是相对角度。把传声器固定后,音箱先后在2个不同的方位角播放声音,系统估算出2个角度,它们之间的角度差就是相对角度。最大误差是指定位系统估算出声源角度,经过排除孤立的异常结果后,各帧结果与均值的最大差值。

4.3 室内测试结果

在室内测试中,混响场空间参数为:长7 m,宽4 m,高2.9 m。测试场中有很多矮隔板和电脑,混响时间约为120~180 ms。声源是漫步者电脑音箱R1900T-Ⅲ,它在不同的方位角上不断播放枪声、人声和其他声音,调整音量,使信噪比在10 dB以上。音箱距离传声器阵列约4 m。表1是室内枪声的定位结果。特定声检测模块对枪声的检出率是89.7%,准确率是78.2%。

图6 声音定位系统的界面

表1 室内枪声定位的误差均值和方差

4.4 室外测试结果

室外测试中,选择校园内一个交通路口旁边一小块空旷地作为测试场地,测试场中有汽车行驶的噪声、大功率空调主机噪声、轻轨和火车行驶噪声,以及一些自然风声等。调整音箱的音量大小,使信噪比达到10 dB。测试方法和4.2节一样,数据处理帧长是1 000个采样点。定位结果见表2。

表2 室外枪声的定位结果

从表2看出,在室外的声音定位中,当声源偏离传声器正前方±30°以内,定位偏差在5°以内。如果声源偏离角度增大,这个偏差也会增大。特定声检测模块对枪声的检出率是90%,好于室内测试结果,而准确率是75%,略差于室内的测试结果。这是因为室外干扰声比较大,有时候会有很多干扰声被识别成枪声。

5 小结

笔者提出的结合基于TDoA的声音定位和特定声检测的特定声方向定位系统可以实时地进行特定声的检测和定位,它的抗干扰能力也较强。当它的输出设备是TFT显示器的时候,可以直观显示声源的方向;如果用本定位系统的输出角度控制摄像机云台,摄像机就能够及时转向并跟踪特定声声源方向,有效提高视频监控的有效性。在没有检测到特定声的时候,如果该系统关闭摄像机,就可以在很大程度上降低视频监控系统的能耗。

:

[1]YITENG H,BENESTY J,ELKO G W.Passive acoustic source localization for video camera steering[C]//Proc.2002 IEEE International Conference on Acoustics, Speech, and Signal.[S.l.]:IEEE Press,2000:909-912.

[2]CLAVEL C,EHRETTE T,RICHARD G.Events detection for an audio-based surveillance system [C]//IEEE Conference on Multimedia and Expo 2005.[S.l.]:IEEE Press,2005:1308-1309.

[3]CHAN Y, RILEY J, PLANT J.A parameter estimation approach to time-delay estimation and signal detection[J].IEEE Transactions on Acoustics, Speech, and Signal Processing, 1980, 28(1):8-16.

[4]STEPHENNE A,CHAMPAGNE B.Cepstral prefiltering for time delay estimation in reverberant environments[EB/OL].[2009-06-02].http://eprints.kfupm.edu.sa/29439.

[5]BRANDSTEIN,M S.A pitch-based approach to time-delay estimation of reverberant speech[EB/OL].[2009-06-02].http://ieeexplore.ieee.org/xpls/abs_all.jsp?arnumber=625637.

[6]ARGENTRERI S,DANES P.Broadband variations of the MUSIC highresolution method for sound source localization in robotics[EB/OL].[2009-06-02].http://ieeexplore.ieee.org/xpl/freeabs_all.jsp?arnumber=4399422.

[7]LEON D F A,MARCIANO J J S.Source localization using music in a multipath environment[EB/OL].[2009-06-02].http://d.wanfangdata.com.cn/NSTLHY_NSTL_HY14773667.aspx.

[8]KEYROUZ F,MAIER W,DIEPOLD K.A novel humanoid binaural 3D sound localization and separation algorithm[EB/OL].[2009-06-02].http://d.wanfangdata.com.cn/NSTLHY_NSTL_HY17814078.aspx.

[9]ROMAN N,DELIANG W,BROWN G J.Speech segregation based on sound localization[EB/OL].[2009-06-02].http://www.cse.ohio-state.edu/~dwang/papers/RWB.jasa03.pdf.

[10]FAKHEREDINE K,KLAUS D.An enhanced binaural 3D sound localization algorithm[EB/OL].[2009-06-02].http://ieeexplore.ieee.org/xpl/freeabs_all.jsp?arnumber=4042325.

[11]KNAPP C,CARTER G.The generalized correlation method for estimation of time delay[J].IEEE Trans.Signal Acoustics, Speech, and Signal Processing, 1976,24(4):320-327.

[12]VALENZISE G,GEROSA L,TAQLIASACCHI M,et al.Scream and gunshot detection and localization for audio-surveillance systems[EB/OL].[2009-06-02].http://www.citeulike.org/user/tiboeret/article/5095282.

[13]CHENG E, BURNETT I, RITZ C.Using spatial audio cues from speech excitation for meeting speech segmentation[EB/OL].[2009-06-02].http://ieeexplore.ieee.org/iel5/4128765/4129618/04129778.pdf?arnumber=4129778.