强化学习在协作频谱感知中的应用

2024-09-19刘春玲许军郭楷文

摘 要:针对随着节点数量的增多,多节点协作频谱感知(Cooperative Spectrum Sensing,CSS) 会产生大量本地数据,导致能耗变高和全局决策延迟的问题,提出节点评估与选择(Node Evaluation Selection,NES) 和网格搜索(Grid Search,GS) 的强化学习(Reinforcement Learning,RL) 算法。通过NES 算法在融合中心(Fusion Center,FC) 实时更新协作用户的信任值,对信任值大小进行排序,根据设定的阈值,阻止恶意用户(Malicious Users,MU) 参与CSS。通过基于GS 的RL 机制对处理后的数据进行标记,把信噪比(Signal to Noise Ratio,SNR) 和信任值作为输入参数,搜索出所有可能的参数组合。在相同环境参数时,FC 可以直接调用该环境下的节点,不需要再重新进行感知操作,如果有新用户加入时通过改变参数的范围重新搜索,新用户可以模仿其他用户RL 的经验,从而获得更加快速的信道占用情况。仿真结果表明,该方法与其他算法相比,在提高检测概率的同时,降低了能耗,减少重复计算的时间,解决了全局决策延迟的问题。

关键词:协作频谱感知;认知无线网络;融合中心;网格搜索;强化学习

中图分类号:TN925 文献标志码:A 开放科学(资源服务)标识码(OSID):

文章编号:1003-3106(2024)06-1346-09

0 引言

随着5G 进入商业阶段,云计算、网络功能虚拟化和软件定义网络概念的快速革命[1],人们已经开始6G[2]移动通信的研究,在6G 网络中不再局限于传统的地面蜂窝架构,正在向地面-水下-空中-空间混合网络发展。6G 的频谱研究将集中在扩展频谱资源、频谱共享与动态分配、智能频谱管理等方面,以满足未来移动通信的需求,并提供更快速、可靠和高效的连接体验。认知无线电(CognitiveRadio,CR)系统是针对射频环境中频谱稀缺[3]问题提出的一种解决方案,主要提高频谱的整体利用率。频谱感知是通信期间,次用户(Secondary User,SU)利用未使用的主用户(Primary User,PU)频谱[4],实现频谱共享、频谱动态分配和干扰检测等功能。由于地理位置对频谱感知的影响,单节点的感知精度低,而多节点协作频谱感知(Cooperative SpectrumSensing,CSS)可以克服由于多径衰落和阴影导致的频谱感知性能下降的问题。因此,在认知无线电网络(Cognitive Radio Network,CRN)中,CSS 是一种被广泛使用的感知技术,可以成功地提高感知精度[5]。但随着感知节点数量的增加,CRN 中全局决策实时性降低且能量消耗也随之增加。

在CSS 中,一些恶意节点可能会参与到频谱感知中,从而混淆检测系统,也可能因为传感设备错误或信道噪声,一些节点会向融合中心(FusionCenter,FC)发送不正确的结果,这些节点会干扰CSS。为了实现高效的频谱感知,检测恶意用户(Malicious Users,MU)是一个具有挑战性的问题,许多研究人员一直在研究这个问题[6]。文献[7]设计了一种以信誉值为基础的拍卖算法,用于分配感知收益。该算法不仅确保感知收益公平分配,降低了算法复杂度,还可以促进更多群智感知(Crowd Sensors)参与感知任务。利用区块链的去中心化和去信任化特性,提高了频谱感知的稳定性和可靠性。然而,该算法在考虑报价策略时没有考虑到环境的变化以及Crowd Sensors 在能量消耗方面的影响。文献[8]提出了一种双自适应阈值技术,以增强其信誉计算算法的鲁棒性。该技术计算每个用户的信誉分数,并计算一组可疑用户,利用自适应阈值对这组可疑用户执行第二信誉计算。未通过此双重检查的可疑用户将被归类为最终MU,同时在感知用户数增多时整个感知过程计算量也在变大。文献[9]提出了一种称为频谱感知策略选择的新算法,以协作或独立的方式选择更好的感知策略。为了推导节点频谱状态的最大后验估计,通过基于图割的CSS方法构建了拓扑信息成本函数和感知结果成本函数。把信誉值应用于评估CSS 和独立感知的性能,以最大限度地降低选择性能较差的感知方式的概率。文献[10]提出了一种基于强化学习(Rein-forcement Learning,RL)的协同频谱感知方案,用于SU 确定信道扫描顺序和选择合作伙伴进行协同频谱感知。通过Q-learning 方法,每个SU 学习主要通道的占用模式,以生成动态的扫描优先列表,从而降低扫描成本并减少访问延迟。然而没有考虑阻止置信度低的用户参与协作感知,使其能耗偏高。文献[11]提出的混合方案将差分进化(Differential E-volution,DE)优化方案与基于机器学习的增强树算法相结合以减轻MU 在CSS 系统中的影响,根据使用DE 的SU 确定优化阈值和系数向量用于训练增强树算法,从而获得可靠的感知结果。虽然检测概率得到了提高,但感知时间和能量消耗的成本也在变大。在文献[12]中,FC 根据从所有SU 接收到的硬二进制决策进行全局决策。遗传算法(Genetic Algorithm ,GA)采用一对多邻居距离和z-score 作为适应度函数,在有MU 的情况下通过选择和交叉来识别最佳感知结果,该方案能够在不识别MU 的情况下避免MU 在CSS 中的影响,但整个网络的能量消耗也在增高。

针对以上问题,提出了节点评估与选择(NodeEvaluation Selection,NES)算法剔除信任值低的节点(MU),选择信任值高的节点(可靠节点)参与CSS,从而在保证检测性能的情况下减少了能量的消耗。提出基于网格搜索(Grid Search,GS)的RL,在出现相同环境参数时,FC 可以直接调用当前节点,而无需再次进行感知操作,从而减少数据的处理,提高全局决策的实时性。

1 系统模型

1. 1 CSS 模型

建立了由一个PU 和若干个SU 组成的模拟CR模型,各节点通过FC 通信,FC 通过各节点信息判断PU 通道是否空闲。CRN 模型如图1 所示。

1. 2 能量检测模型

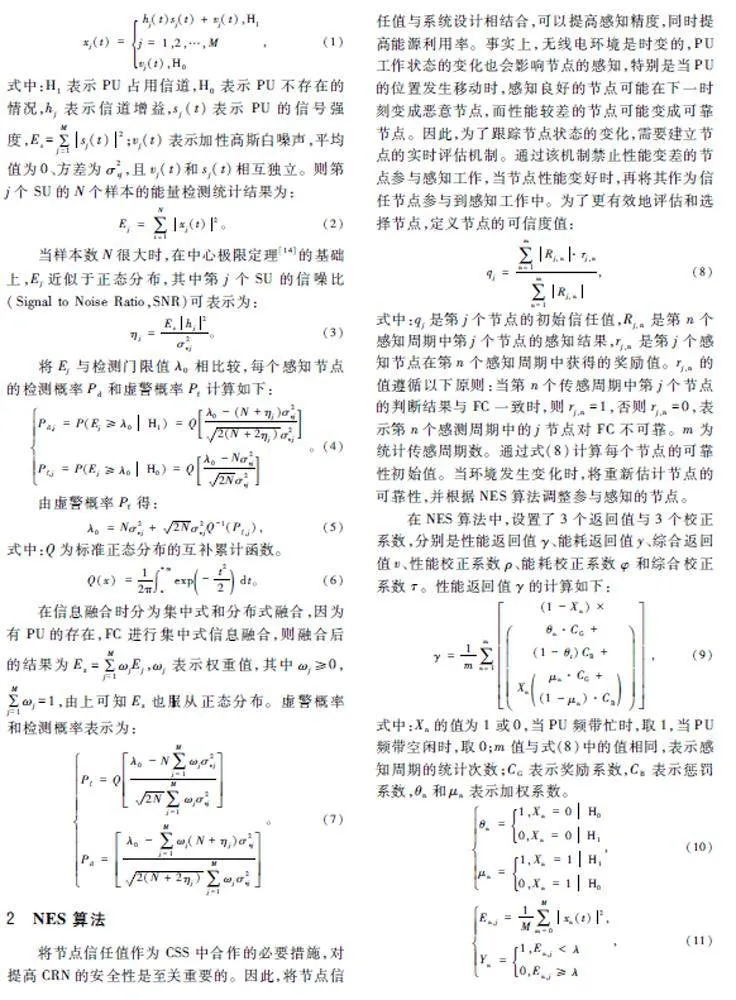

在频谱感知中,每个SU 独立执行一个能量检测[13]过程。这是因为能量检测操作简单,且不需要PU 的先验信息。第j 个SU 接收到的信号确定如下:

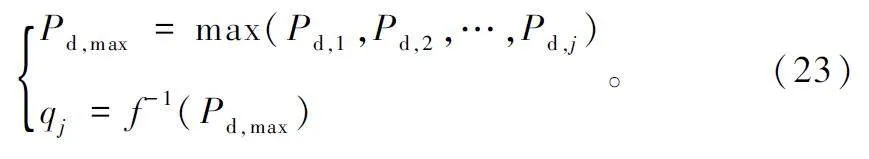

式中:qnj是前一感知周期中第j 个节点的信任值,qn+1j 是第j 个结点的当前信任值,v 是前一周期的综合返回值,τnj是前一个周期的综合校正系数,Φ 是加权因子,值取1 或0。Φ 的值取1 的次数越多时,能量利用效率越高。反之,表明需要调整感知节点以提高感知性能和能耗指数。

调整感知节点的数量,再调用信任值大于阈值的节点参与CSS,这里的阈值设置为信任值的平均值,当信任值大于等于平均值时节点是可靠的,当信任值小于平均值时节点是不可靠的,公式为:

qave = qmax + qmin/2 。(20)

NES 算法流程如算法1 所示。

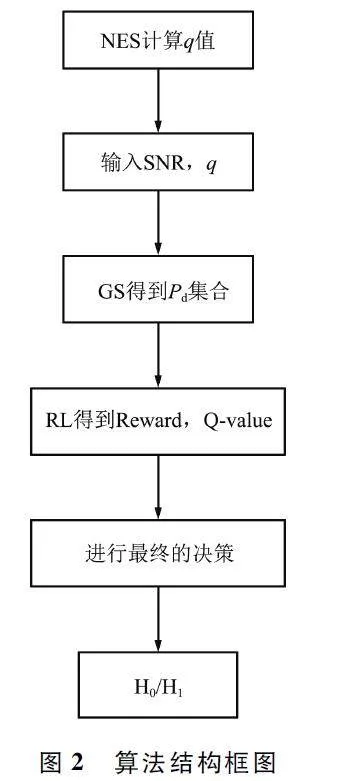

3 基于GS 的RL

3. 1 GS

GS[15]是指事先在给定的超参数空间中定义一组候选超参数,然后进行排列组合,形成一个超参数的“网格”,按照“网格”依次搜索超参数空间中的各个组合。GS 的好处是能够对所有可能的参数组合进行搜索。可以使用搜索来获得信任值可靠的节点qj,为了提高搜索效率,进行了GS。训练搜索后的参数包括SNR 和信任值,其中设置SNR ∈(-20,-10)dB,qj ∈(0. 5,1)。通过搜索把这些信息作为先验知识保存到知识库中。GS 的过程如下:

① 当ηi 出现时,FC 将进行实时搜索,从而获得qj,并得到对应的Pd。其中ηi 是第i(正整数)个出现的SNR,如果SNR 是新出现的,就设置新的参数重新搜索。最后搜索的结果将在Pd 和qj 返回时输出。此外,qj 和ηi 将成为FC 搜索的先验知识,搜索得到的数据存储库Ω 为:

Ω = f(qj,ηi), (21)

式中:f 是一个搜索函数。

② 当ηi 不是新出现时,FC 将利用学习的知识直接选择qj:

qi = f -1(ηi,Ω)。(22)

③ 在ηi 下,形成i×j 的网格,i 是所设的SNR 的步长,j 是节点数,步长都为1。

④ Pd,j 是第j 个网格的节点检测概率,一直增加到所参与的协作的节点数,或当Pd,j = 1 时停止搜索时;否则将继续搜索。

⑤ 当实时搜索完成时,会得到概率Pd 的集合和相应的qj:

3. 2 RL 的过程

RL[16]是一种机器学习方法,主要包括环境和智能体(agent)两部分。而Q-learning 在RL 方法中经常被使用,其中处于状态s 的智能体通过采取动作a 来与环境交互,目的是从行动的结果中学习环境。根据结果,智能体获得奖励值r(s,a),并更新Q值。在每个时间点t,智能体可能处于特定的状态s,并且可以根据其在之前迭代中的学习选择一个动作。Q-learning 的历史可以用状态-动作奖励序列表示:<s0,a0,r1,s1,a1,r2,s2,a2,r3,s3,a3,r4,s4,s4,… >,智能体在状态s0 时采取行动a0 ,并获得奖励值r1 。之后,进入状态s1 ,以此类推。智能体从状态-行动-奖励历史中学习。一种状态-行动-奖励的经验(<s,a,r,s′>)获得回报值Q(s,a),同时按照贝尔曼最优化准则进行Q 值的更新来选择下一步动作,表达式为:

Qt+1(s,a) = (1 - α)Qt(s,a)+α{rt(s,a)+ ξmax[Qt+1(s′,a′)]},(24)

式中:学习因子α 和折损因子ξ 取值都为(0,1),当α 接近于0 时,智能体从状态-行动-奖励过程中学到的很少,历史占主导地位。如果环境是确定的,则α 的最优值为1。

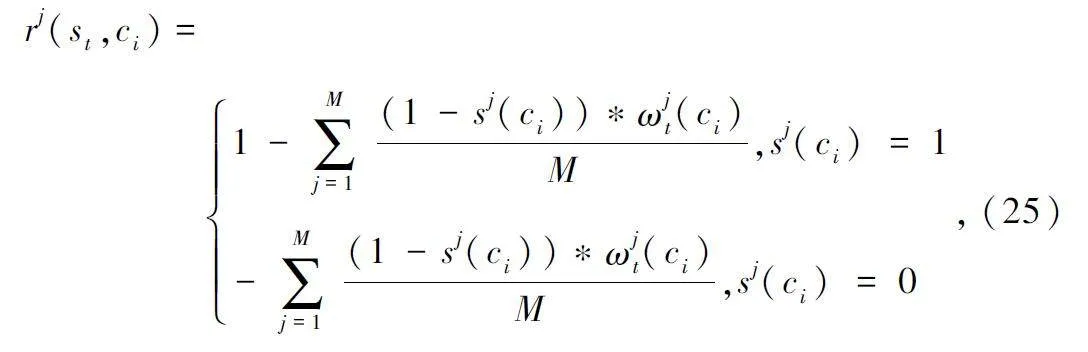

在GS 后将RL 的理论运用SU 的状态和环境的学习。将SU 比作RL 中的智能体[17]学习信道占用的模式,st 表示信道的状态,在t 时刻信道是否被PU 占用。当SUj 出现时,通过扫描信道(ci )来采取行动。使用Q 学习方法,获得奖励值rjt(st,ci )在时间t 下信道的状态:

式中:sj(ci)= 1 表示信道空闲,sj(ci)= 0 表示信道繁忙,ωjt(ci)与式(7)一致表示权重。于是节点j 在信道状态ci 时Q 值的更新为:

Qj(st+1 ,ci)← (1 - α)·Qj(st,ci)+α·{rj(si,ci)- ξ(e-τm )}, (26)

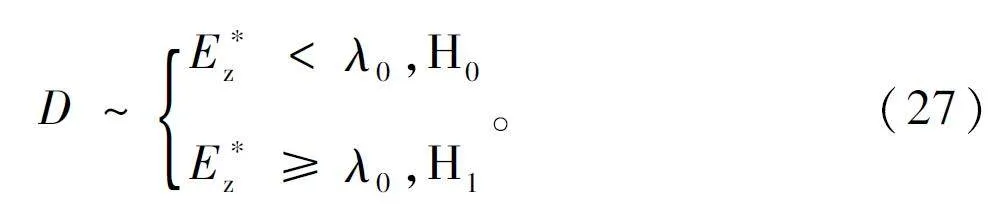

式中:τ 表示(0,1)的常数,m 表示SU 第m 次扫描信道。信息融合与前面的Ez 一致,信道的判决结果如下所示:

在融合阶段结束时,得出m 个协作用户的测量值,将测量值存放于矩阵Z 中。当CR 环境与存储矩阵Z 的数据一致时,RL 采用直接从动作空间A 中选择适当的动作来更新函数值,通过持续的迭代更新获得最优动作a* ,从而选出参与协作感知的用户。如果有新用户加入到CR 环境中,就需要重新设置网GS 的参数,在原来的矩阵扩充第m+1 维数,协作结束时,将协作结果广播到所有协作用户。在矩阵Z 中的第一列表示信任值可靠的节点Qj,第二列表示SNR 的值。每行表示通过在特定无线电环境中执行GS 的RL 算法找到参与协作的节点。

在FC 完成GS 的RL 后,获得的矩阵Z 表示如下:

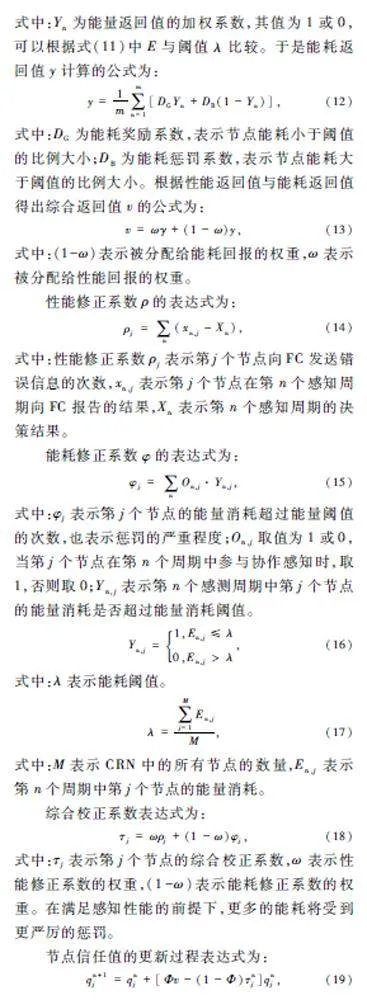

算法结构框图如图2 所示。

4 算法仿真及分析

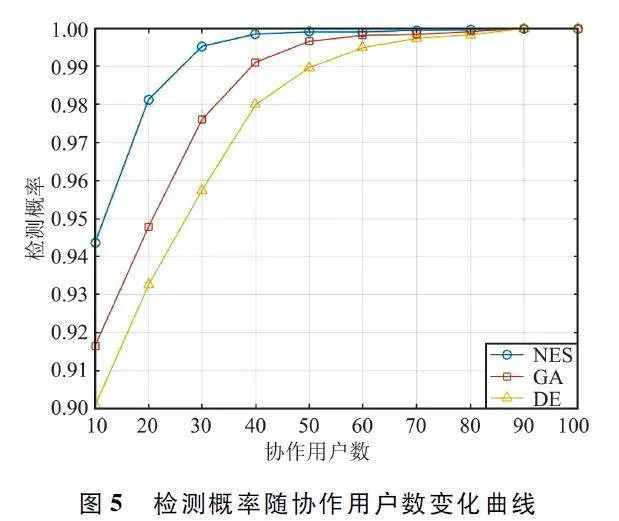

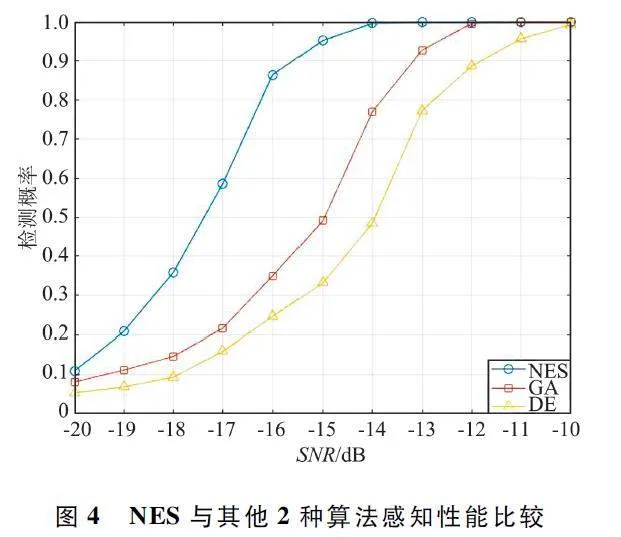

通过蒙特卡洛模拟进行实验,在CRN 中所有节点的仿真结果都超过了2 000 次迭代,建模的CRN中有8 个辅助节点[18]和30 个感知节点。在加性高斯白噪声(Additive White Gaussian Noise,AWGN)的信道下,感知场景范围为200 m,节点随机分布,PU在场景的边缘,所需的节点总数为30(每10 个节点为SNR = -12、-10、-8 dB),8 个辅助节点(SNR =-8 dB),BPSK 信号功率为100 mW,带宽为100 kHz。在此仿真环境中,MU 在2 种不同情况下进行设置:第一种情况,如果有5 个MU,其中在SNR = -12 dB 下有2 个;第二种情况,如果有9 个MU,在SNR = -10 dB 下有4 个MU。为了验证本文算法的性能,将其与DE 和GA 进行比较。在考虑NES 时,设置9 个恶意节点,在其他2 种算法中,设置5 个恶意节点,其他参数都相同。仿真场景如图3 所示。NES 与其他2 种算法感知性能比较如图4 所示。检测概率随协作用户数变化曲线如图5所示。

从图4 可以看出,在SNR 低于-12 dB 时,NES算法的检测概率高于DE 和GA 算法,这是因为NES算法考虑了CRN 中MU 的存在,并阻止了MU 参与CSS,所以使整个网络具有更强的可靠性。当SNR为- 15 dB 时,NES 算法比GA 算法检测概率高0. 46。通过图5 可以发现,随着协作用户数的增加,3 种算法的检测概率都呈现增加的趋势,在M <70时,NES 算法检测概率比GA 和DE 算法检测概率高,这是因为NES 算法剔除了MU,参与协作感知的都是可靠用户。

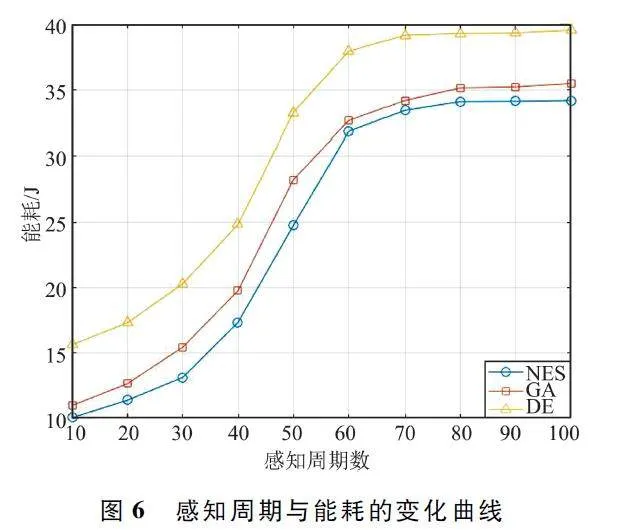

NES 算法与GA 和DE 算法在相同条件下的能耗对比,其他仿真实验参数与上实验相同,感知周期与能耗的变化曲线如图6 所示。从图6 结果可以看出,m<60 时随着感知周期数的增加三者能耗都在增加,但NES 算法效果比GA 和DE 算法优益,但当感知周期数m>60 时,三者能耗基本趋于稳定,此时NES 算法与GA 算法能耗接近,但整个周期中NES算法比GA 算法节能效果好。

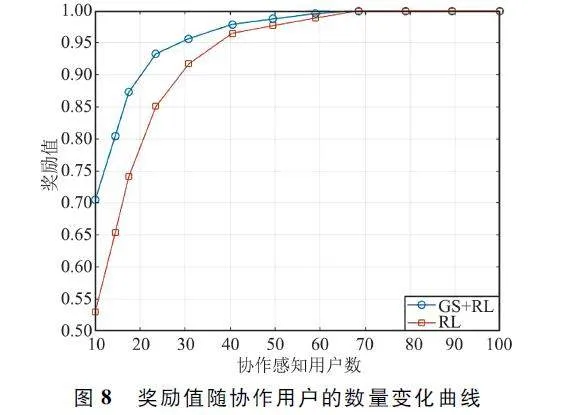

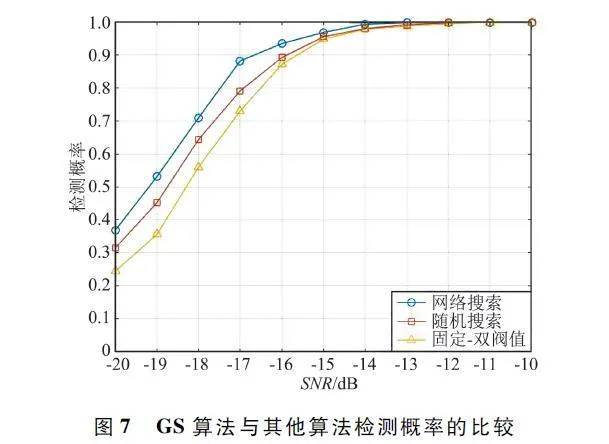

在NES 后,加入GS 算法与随机搜索算法[19]和固定-双阈值算法[20]作比较,如图7 所示。由图可以看出,相同的SNR 下,GS 算法的检测概率比随机搜索和固定-双阈值算法都要高,在-17 dB 时GS 算法比随机搜索检测概率高了0. 1,比固定—双阈值算法检测概率高了0. 16。这是因为GS 算法可以在遍历指定的参数组合时,保证在任何环境下可以找到最优的参数,而随机搜索和固定-双阈值会出现无效或者冗余取值的情况。

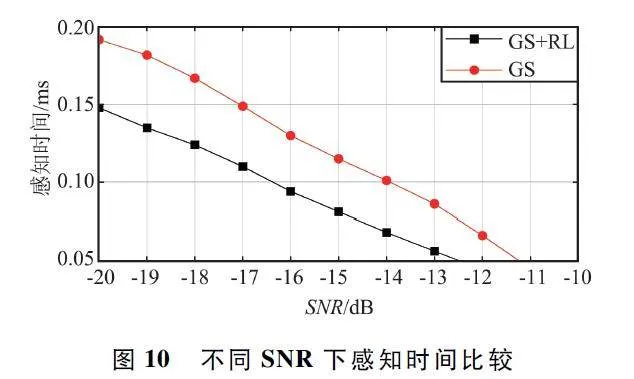

奖励值随协作用户的数量变化曲线如图8 所示。可以看出,随着协作用户的增加奖励值也在增加,在达到一定用户数时收敛于1,这也符合协作感知的规律;协作用户M<60 时,GS 算法后的RL 奖励值高于单独RL 下的值,这是因为GS 算法得到了最优的协作用户。图9 显示了PU 在频带使用率不同时,Q 值随着时间的变化,PU 占用的频带越低Q 值通常较高。此外,在感知期间随着时间的推移Q 值在减小,并在某个时间趋于稳定。不同SNR 下感知时间比较如图10 所示。可以看出,在相同SNR 情况下,基于GS 算法的RL 比没有RL 加入时感知时间更短,因此,提高了全局决策的实时性。如果没有使用RL,那么每个频谱感知过程都需要使用GS 算法来查找可靠的节点,这将导致感知时间增加。当SNR 增加时,感知时间减少,这是因为随着SNR 的提高,存储的信息更少,更容易做出判断。

5 结束语

提出了一种基于RL 的CSS 算法。利用NES 算法解决了CRN 中可能存在MU 参与CSS 导致能量消耗高和感知精度低的问题;通过GS 的RL 算法解决了在相同CR 环境下重复计算的时间,减少了计算量,缩短了感知时间,提高了频谱感知速度,为全局决策的实时性提供了保障,使频谱动态分配成为可能。后续在此基础上评估网络的平均生存周期,根据仿真结果,对网络模型和频谱感知算法进行优化改进。

参考文献

[1] JAGADEESAN N A,NACHIKETHAS B . SoftwaredefinedNetworking Paradigms in Wireless Networks:A Survey[J]. ACM Computing Surveys,2014,47(2):1-11.

[2] JIANG W,HAN B,HABIBI M A,et al. The Road Towards6G:A Comprehensive Survey[J]. IEEE Open Journal ofthe Communications Society,2021,2:334-366.

[3] SAAVEDRA E,MASCARAQUE L,CALDERON G,et al.A Universal Testbed for IoT Wireless Technologies:Abstracting Latency,Error Rate and Stability from the IoTProtocol and Hardware Platform [J]. Sensors,2022,22(11):4159.

[4] PERARASI T,NAGARAJAIN G,GAYATHRI R,et al.Evaluation of Cooperative Spectrum Sensing with FilteredBank Multi Carrier Utilized for Detecting in CognitiveRadio Network [J]. Transactions on Emerging Telecommunications Technologies,2022,33(7):e4478.

[5] 李叶. 基于单节点及多节点频谱感知的认知无线电网络资源分配研究[D]. 成都:西南交通大学,2021.

[6] HWANG J,KIM J,SUNG I,et al. Fast and AccurateDetection of Malicious Users in Cooperative SpectrumSensing Network[J]. Wireless Personal Communications,2021,118(2):1709-1731.

[7] 吕培,赵杭生,张建照. 一种基于信誉值拍卖的区块链下的感知收益分配机制[J]. 电讯技术,2021,61(1):1-7.

[8] JIBRAN M,KIM J,KOO J,et al. A Double AdaptiveApproach to Tackle Malicious Users in Cognitive RadioNetworks[J]. Wireless Communications and Mobile Computing,2019,2019:2214-2223.

[9] SUN Z G,XU Z Y,CHEN Z M,et al. ReputationbasedSpectrum Sensing Strategy Selection in Cognitive RadioAd Hoc Networks[J]. Sensors,2018,18(12):4377.

[10] NING W L,HUANG X Y,YANG K,et al. ReinforcementLearning Enabled Cooperative Spectrum Sensing in Cognitive Radio Networks[J]. Journal of Communications andNetworks,2020,22(1):12-22.

[11] GUL N,KIM S M,AHMED S,et al. Differential EvolutionBased Machine Learning Scheme for Secure CooperativeSpectru Sensing System [J ]. Electronics,2021,10(14):1687.

[12] GUL N,QURESHI I M,ELAHI A,et al. Defense AgainstMalicious Users in Cooperative Spectrum Sensing UsingGenetic Algorithm [J]. International Journal of Antennasand Propagation,2018,2018:1-11.

[13] 王聪,刘雄厚,孙超,等. 基于频率着色的被动声呐宽带能量检测方法[J]. 哈尔滨工程大学学报,2021,42(4):456-462.

[14] PAGE E L,PEIGN? M,PHAM D C. Central LimitTheorem for a Critical Multitype Branching Process inRandom Environments[J]. Tunisian Journal of Mathematics,2021,3(4):801-842.

[15] FAYED H A,ATIYA A F. Speed up Gridsearch forParameter Selection of Support Vector Machines [J ].Applied Soft Computing,2019,80:202-210.

[16] HAN K,YE C Y. Power Control Research for DevicetoDevice Wireless Network Underlying ReinforcementLearning[C]∥ Global Conference on Robotics,ArtificialIntelligence and Information Technology. Chicago:IEEE,2022:351-354.

[17] 李冠雄,李桂林. 基于强化学习的合作频谱分配算法[J]. 电波科学学报,2022,37(1):8-14.

[18] 曹龙,赵杭生,鲍丽娜,等. 基于辅助节点的安全协作频谱感知[J]. 计算机工程,2014,40(2):123-127.

[19] KOSTEN V A,SELEZENEV L E. Random Search Algorithmwith Selflearning for Neural Network Training[J]. OpticalMemory and Neural Networks,2021,30(2):180-186.

[20] HUANG T,YIN X D,CAO Q J. A New Algorithm forConsidering Green Communication and Excellent SensingPerformance in Cognitive Radio Networks [J ].International Journal of Distributed Sensor Networks,2020,16(6):645-649.

作者简介

刘春玲 女,(1971—),博士,教授,硕士生导师,CCF 会员。主要研究方向:信号检测与信号处理。

许 军 男,(1996—),硕士研究生。主要研究方向:认知无线电与压缩感知。

郭楷文 男,(1997—),硕士研究生。主要研究方向:机器人路径规划。

基金项目:辽宁省教育厅面上基金项目(LJKZ1184)