基于人体骨骼关键点的心血管患者康复训练动作评估方法

2024-08-15张睿泽郭威杨观赐罗可欣李杨何玲

摘 要:为解决心血管患者日常康复训练依赖于康复中心专业医务人员现场指导的问题,围绕获得支撑心血管患者自主康复训练的动作评估系统,提出了基于人体骨骼关键点的心血管患者康复训练动作评估方法(ASRT-PHS)。首先,根据心血管患者的康复训练动作规范拍摄构建了康复训练动作数据集;然后,引入基于深度学习的检测器和姿态估计器采集人体位置信息与人体关键点信息,并将提取结果输入到卷积神经网络中进行动作识别;接着,通过关节距离比值计算、关节角度阈值计算与标准动作判断,构建基于关节距离比值的动作切分模型和基于动作关节角度阈值的动作评估模型;最后,通过测试ASRT-PHS在不同关节角度阈值和不同动作识别方法下的动作切分与评估性能,得出了ASRT-PHS的最优工作参数。测试结果表明,ASRT-PHS在动作识别、动作切分与动作评估中的准确率分别达到92.78%、77.6%和87%。此外,真实心血管患者案例测试表明,原型系统的动作评估平均准确率为71.3%,为患者居家自主康复训练提供了可行的智能辅助系统。

关键词:人体关键点; 康复训练; 心血管患者; 动作评估

中图分类号:TP391 文献标志码:A

文章编号:1001-3695(2024)08-027-2441-07

doi:10.19734/j.issn.1001-3695.2023.11.0606

Action assessment method of rehabilitation training based onhuman skeleton key points for cardiovascular patients

Zhang Ruize1a, Guo Wei2, Yang Guanci1a,1b, Luo Kexin1c, Li Yang1a, He Ling1a

(1.a.Key Laboratory of Advanced Manufacturing Technology of Ministry of Education, b.State Key Laboratory of Public Big Data, c. School of Mechanical Engineering, Guizhou University, Guiyang 550025, China; 2.Guizhou Provincial Staff & Workers Hospital, Guiyang 550025, China)

Abstract:In order to solve the problem that the daily rehabilitation training of cardiovascular patients depends on directing by health care professions in rehabilitation centre,during assessing and correcting the movements system about cardiovascular patients’ independent rehabilitation training at home, this paper proposed an action assessment method for cardiovascular patients’ rehabilitation training based on key points of the human skeleton(ASRT-PHS). Firstly, this paper constructed a dataset for rehabilitation training actions using a camera and data augmentation in accordance with the specified rehabilitation trai-ning specification for cardiovascular patients. Secondly, this paper employed a deep learning-based detector and pose estimator to capture human body positions and extract key points of the human skeleton, respectively, and then input the results into a convolutional neural network for action recognition. Thirdly, by calculating joint angle thresholds, joint distance ratio and assessing standard motions, this paper constructed a motion segmentation model based on joint distance ratios and an action assessment model based on action joint angle thresholds. This paper investigated the optimal combination of ASRT-PHS by assessing its performance with various joint angle thresholds and action recognition approaches. The results show that ASRT-PHS achieves an average action recognition, segmentation and assessment accuracy of 92.78%, 77.6% and 87%, respectively. Furthermore, case tests about the true cardiovascular patients show that the average accuracy of the prototype system is 71.3%, which provides a feasible intelligent auxiliary system for patients’ autonomous rehabilitation training at home.

Key words:human key point; rehabilitation training; cardiovascular patient; action assessment

0 引言

据报道,全球每年约有1 790万人死于心血管疾病,中国约有3.3亿名心血管疾病患者[1]。心血管疾病导致的瘫痪和伤残使得老年人面临身体平衡和日常活动能力方面的挑战,进而影响其独立生活的能力。康复训练对于提升患者的日常生活能力至关重要。当前,患者的日常康复训练依赖于康复中心专业医务人员的现场指导,不仅需要患者承担高额的医疗费用,还导致医疗资源紧张。尤其是出院后的家庭康复训练阶段,由于训练质量要求较高、家庭锻炼的坚持率较低以及缺乏及时的评估反馈,康复训练难以达到理想效果。研究显示,2017—2019年参与门诊心脏康复治疗的患者中,仅有18.7%的患者完成了24次以上的康复治疗[2]。鉴于此,当前亟需采取有效手段,鼓励患者更主动地参与康复训练,而研究支撑心血管患者康复训练动作评估的技术与康复训练机器人引起了学者的广泛关注[3,4]。

基于虚拟现实技术的康复训练方面,Wang等人[5]通过提取脑电信号并分类,设计了基于运动想象的在线脑机接口上肢康复系统,该系统根据实验者的脑电信号实时控制机器人手臂,但该研究涉及的数据量较小,且未考虑信号采集时的噪声处理。文献[6]将VR和BCI融入手部康复系统,将传统的被动康复转变为主动康复,该系统能够提高患者的康复参与度。Liu等人[7]基于虚拟现实设计了虚拟康复训练与评估系统,通过康复训练游戏吸引患者的注意力,从而减轻患者可能因长时间康复训练产生的厌倦情绪。Bortone等人[8]提出了用于神经运动障碍儿童康复治疗的沉浸式虚拟现实康复训练系统,通过自定义与虚拟环境的交互方式,将该系统与可穿戴触觉设备结合,以满足不同患者的需求。文献[9]将VR体能训练监测与上肢康复技术相结合,通过深度传感器采集的图像序列定位人体的关键部位,实现了实时评估患者康复训练的质量并监测康复进展,但该系统仅关注关键部位,没有考虑整体动作。Zhao等人[10]设计了基于智能测控的康复训练系统,通过康复专家定制子系统、患者培训子系统、后台管理子系统构建了康复系统,但该系统主要用于康复管理,依赖于主动输入的数据。

为了探索机器人远程辅助康复治疗方法,Liu等人[11]设计了居家环境下的远程康复系统。通过触觉引导训练和基于肌电信号的监督训练,患者在治疗师的引导下能够进行机器人辅助的被动康复或自主康复训练,该系统依赖可穿戴设备和治疗师的指导。Fan等人[12]提出了用于家庭呼吸康复锻炼的非接触式运动监测和评估系统。该系统通过多波段微波传感技术实时监控患者的康复训练情况,训练后基于运动信息评估康复运动的质量,无法做到实时评估。Bai等人[13]运用多传感器融合技术(包括Kinect和姿态传感器)监测运动轨迹,进而研制了上肢康复训练评估系统。此系统采用Fugl-Meyer运动评分表评估康复动作,但其仅适用于解决上肢动作轨迹不一致的问题。Kim等人[14]通过在天花板安装轨道平台和手推车构建康复训练系统,该系统能够通过检测运动意图进而预知患者移动方向。

上述研究仅通过虚拟现实或者机器人辅助来进行康复训练评估,没有进一步探索与人工智能相结合的动作评估方法。为了评估太极运动,Li等人[15]将评估方法与RGB-D相机结合,开发了实时智能动作质量分析系统,但该系统仅适用于太极运动的动作评估。Parsa等人[16]为在线动作识别提出了一种时空金字塔图卷积网络,在姿态估计任务中,该方法取得了高准确率并具备良好的实时性。Zhang等人[17]提出了基于时空特征的动作评估模型,通过捕捉全局时空特征中的深度依赖性来解决表达和泛化能力不足的问题。

在康复训练过程中,由于人体动作与骨骼关键点之间存在十分密切的联系,通过人体骨骼关键点的变化可以反映出执行动作的姿势、肢体运动路径等方面的信息,并且随着人体姿态估计算法的发展,人体骨骼关键点检测精确度也越来越高。将其应用于康复训练,实现动作精准识别的同时也可以为康复训练提供更加科学的评估和指导。面对心血管患者日常康复训练中存在的问题,特别是对康复中心专业医务人员现场指导的依赖,围绕获得支撑心血管患者自主康复训练的动作评估系统,本文提出基于人体关键点的心血管患者康复训练动作评估方法。

1 康复训练动作评估数据集构建

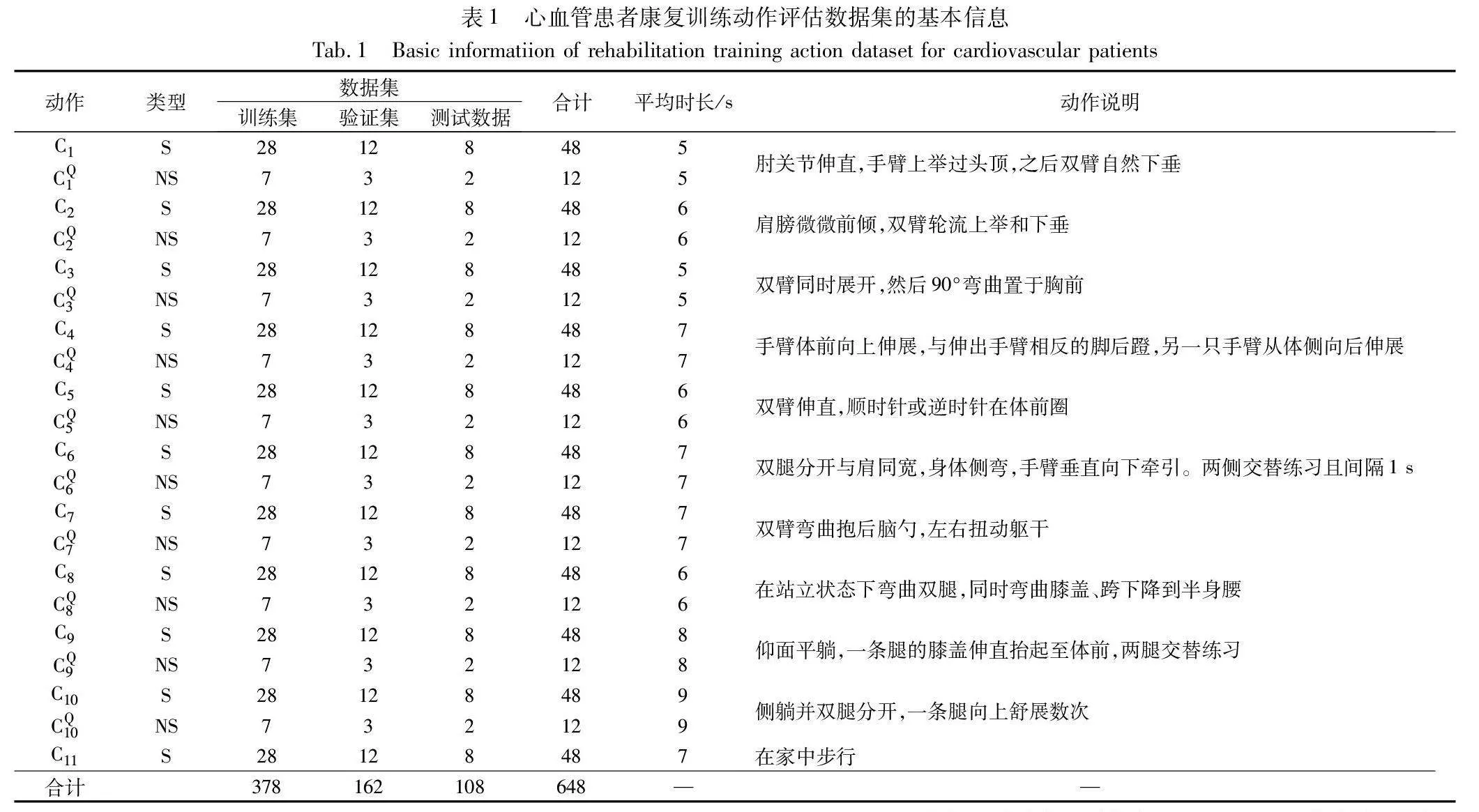

当前,已有由Kinect传感器采集制作成的康复运动数据集UI-PRMD,只支持康复训练中与锻炼相关的常见动作识别,而不适用于心血管患者的康复训练。另一方面,其数据均由人体关键点坐标构成,无法实现端到端的动作识别与评估。因此,本文根据康复训练动作规范的指导[18],构建了心血管患者康复训练数据集,以达到居家环境心血管患者康复训练动作评估的目的。康复训练动作数据集构建方案与过程如下:

1)数据采集设备 采用SAMSUNG S21+智能手机作为数据采集设备。

2)参与人员 邀请课题组内五位研究生作为志愿者参与视频数据的采集。五位志愿者体重在60~75 kg,身高在1.60~1.85 m,符合大多数人的身材比例。

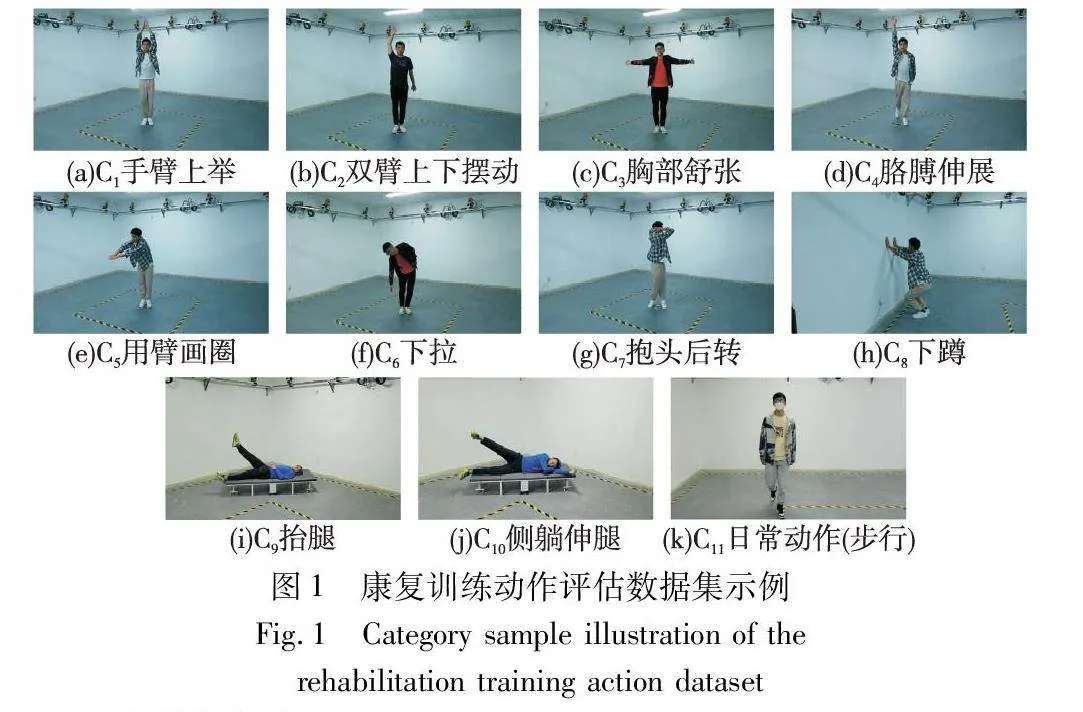

3)动作类型 动作类型分为10类康复动作及1类日常活动动作。10类康复动作分别为:手臂上举(C1)、双臂上下摆动(C2)、胸部舒张(C3)、胳膊伸展(C4)、用臂画圈(C5)、下拉(C6)、抱头后转(C7)、下蹲(C8)、抬腿(C9)、侧躺伸腿(C10)。1类日常活动动作为步行(C11)。图1是不同动作类型示例图。

4)采集方案

a)训练数据与验证数据的采集。康复动作数据集包含标准(S)动作视频和非标准(NS)动作视频。非标准动作是指不符合规范的动作或者完成度不符合要求的动作,完成度不符合要求是指超过一定阈值的动作(阈值将在3.2节中进行讨论)。针对10类康复动作与1类日常动作,其标准动作视频由5位实验人员分别在强光近距离、强光远距离、弱光近距离、弱光远距离4种不同环境下拍摄,每类动作完成2~4次,同一类动作完成次数相同,每种环境采集1个样本,每类动作共采集20个样本。为防止后期动作识别网络训练过拟合,只在强光近距离环境下采集10类康复动作的非标准动作视频,每类动作采集1个样本。采集过程中摄像头位置固定,近距离与远距离代表摄像头到被测人员的垂直距离,近距离为3.8 m,远距离为7.5 m。每个动作样本持续时间为5~9 s,视频帧率为30,采集过程中动作连续进行。

b)测试数据的采集。本文设计了两类测试数据来检验模型的动作切分与评估性能。实验方案设计如下:

实验A 实验环境与训练验证数据相同,测试人员不同。这一实验验证在训练数据集环境相同时,本文康复训练动作切分与评估方法面向不同被测对象的鲁棒性。

实验B 实验环境不同,测试人员相同。这一实验验证训练数据集环境变化后,本文模型对不同环境的适应能力。

在实验B中用中等强度光代替弱光,其余采集方案与训练数据采集方案相同。每个测试类别包括40个标准视频、10个非标准视频和4个日常动作视频,因此测试数据集共有108个视频。考虑到C9和C10类别的动作特点与Faster R-CNN的算法特点(需要先检测到视频中的人体才能进行关键点检测),将实验A与B中C9和C10类别的视频分别旋转45°或60°,以提高人体检测的成功率。

5)数据处理 根据文献[19]的数据增强方法,对上述采集到的训练与验证数据通过对称变换、旋转、添加噪声等方式进行数据增强,将数据扩充1倍,得到训练数据与验证数据共有540个视频。将这些视频按照7∶3划分训练集和验证集,同时确保每类动作样本比例均衡。由于测试数据包含108个视频,所以康复训练动作评估数据集共有648个视频,表1是数据集的基本信息。对训练集和验证集的每个视频分别进行分类标注,并用Faster R-CNN和HRNet分别对每个视频进行特征提取,得到每个样本对应的含有人体位置信息和关键点信息的pkl文件。

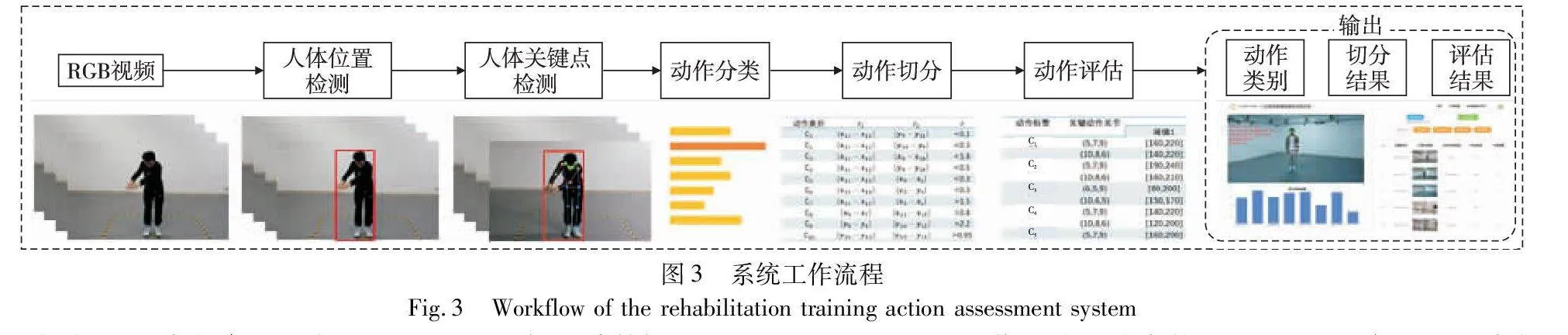

2 基于人体关键点的心血管患者康复训练动作评估算法

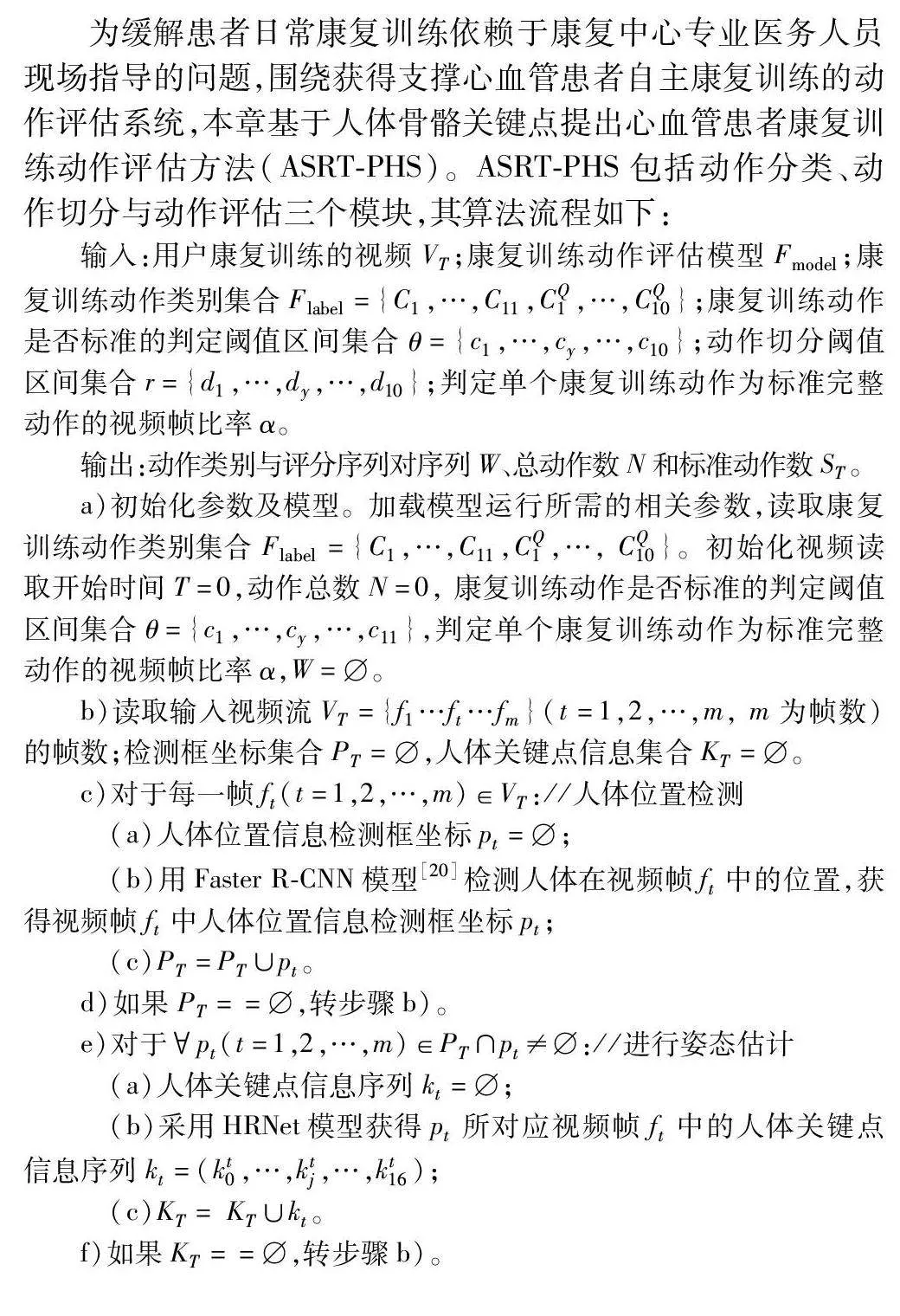

为缓解患者日常康复训练依赖于康复中心专业医务人员现场指导的问题,围绕获得支撑心血管患者自主康复训练的动作评估系统,本章基于人体骨骼关键点提出心血管患者康复训练动作评估方法(ASRT-PHS)。ASRT-PHS包括动作分类、动作切分与动作评估三个模块,其算法流程如下:

输入:用户康复训练的视频VT;康复训练动作评估模型Fmodel;康复训练动作类别集合Flabel={C1,…,C11,CQ1,…,CQ10};康复训练动作是否标准的判定阈值区间集合θ={c1,…,cy,…,c10};动作切分阈值区间集合r={d1,…,dy,…,d10};判定单个康复训练动作为标准完整动作的视频帧比率α。

输出:动作类别与评分序列对序列W、总动作数N和标准动作数ST。

a)初始化参数及模型。加载模型运行所需的相关参数,读取康复训练动作类别集合Flabel={C1,…,C11,CQ1,…, CQ10}。初始化视频读取开始时间T=0,动作总数N=0, 康复训练动作是否标准的判定阈值区间集合θ={c1,…,cy,…,c11},判定单个康复训练动作为标准完整动作的视频帧比率α,W=。

b)读取输入视频流VT ={f1…ft…fm }(t=1,2,…,m, m为帧数)的帧数;检测框坐标集合PT=,人体关键点信息集合KT=。

c)对于每一帧ft(t=1,2,…,m)∈VT://人体位置检测

(a)人体位置信息检测框坐标pt=;

(b)用Faster R-CNN模型[20]检测人体在视频帧ft中的位置,获得视频帧ft中人体位置信息检测框坐标pt;

(c)PT =PT∪pt。

d)如果PT==,转步骤b)。

e)对于pt(t=1,2,…,m)∈PT∩pt≠://进行姿态估计

(a)人体关键点信息序列kt=;

(b)采用HRNet模型获得pt所对应视频帧ft中的人体关键点信息序列kt=(kt0,…,ktj,…,kt16);

(c)KT= KT∪kt。

f)如果KT==,转步骤b)。

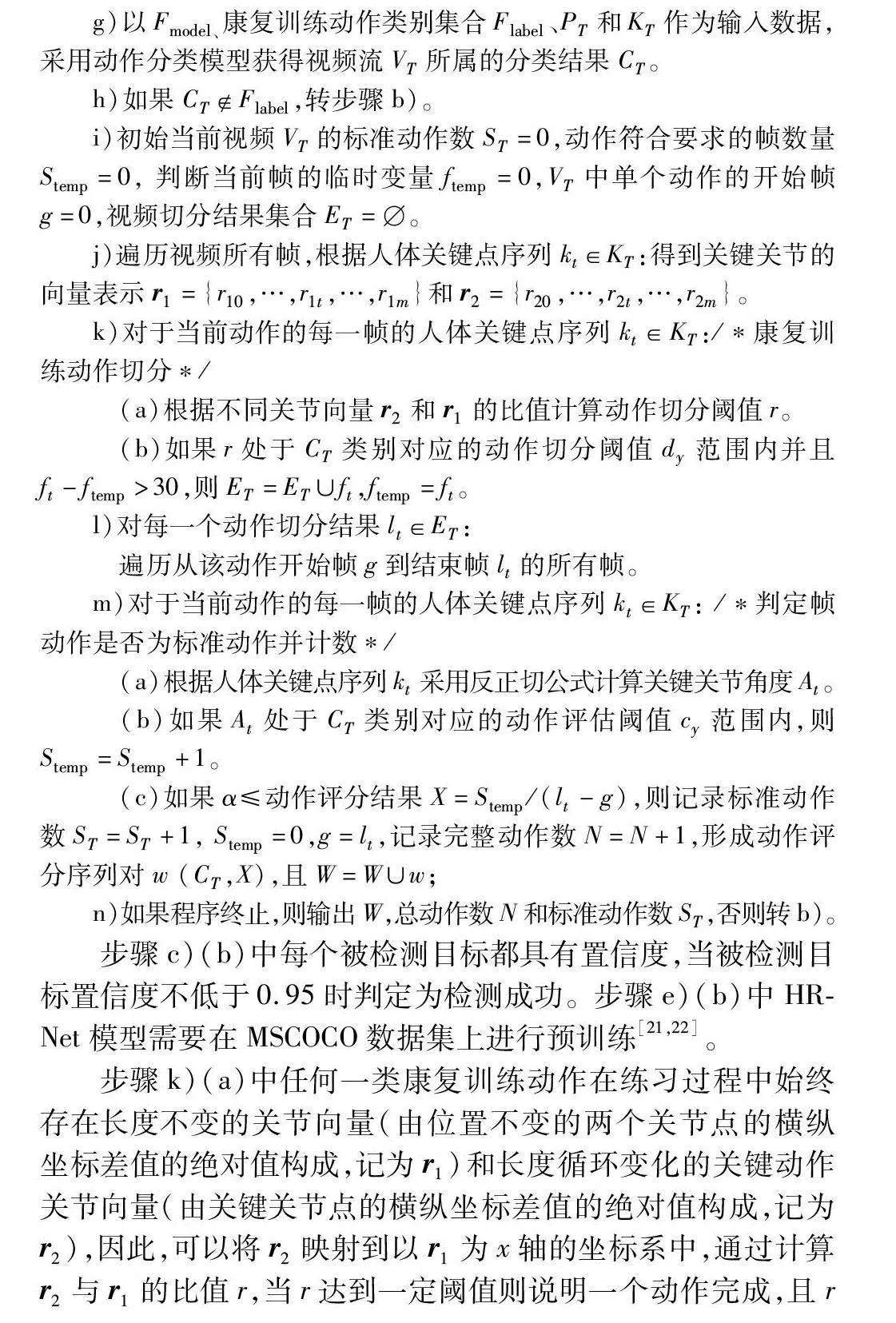

g)以Fmodel、康复训练动作类别集合Flabel、PT和KT作为输入数据,采用动作分类模型获得视频流VT所属的分类结果CT。

h)如果CTFlabel,转步骤b)。

i)初始当前视频VT的标准动作数ST=0,动作符合要求的帧数量Stemp=0, 判断当前帧的临时变量ftemp=0,VT中单个动作的开始帧g=0,视频切分结果集合ET=。

j)遍历视频所有帧,根据人体关键点序列kt∈KT:得到关键关节的向量表示r1 ={r10,…,r1t,…,r1m}和r2 ={r20,…,r2t,…,r2m}。

k)对于当前动作的每一帧的人体关键点序列kt∈KT:/*康复训练动作切分*/

(a)根据不同关节向量r2和r1的比值计算动作切分阈值r。

(b)如果r处于CT类别对应的动作切分阈值dy范围内并且ft-ftemp>30,则ET =ET∪ft,ftemp=ft。

l)对每一个动作切分结果lt∈ET:

遍历从该动作开始帧g到结束帧lt的所有帧。

m)对于当前动作的每一帧的人体关键点序列kt∈KT: /*判定帧动作是否为标准动作并计数*/

(a)根据人体关键点序列kt采用反正切公式计算关键关节角度At。

(b)如果At处于CT类别对应的动作评估阈值cy范围内,则Stemp=Stemp+1。

(c)如果α≤动作评分结果X=Stemp/(lt-g),则记录标准动作数ST=ST+1, Stemp=0,g=lt,记录完整动作数N=N+1,形成动作评分序列对w (CT,X),且W=W∪w;

n)如果程序终止,则输出W,总动作数N和标准动作数ST,否则转b)。

步骤c)(b)中每个被检测目标都具有置信度,当被检测目标置信度不低于0.95时判定为检测成功。步骤e)(b)中HRNet模型需要在MSCOCO数据集上进行预训练[21,22]。

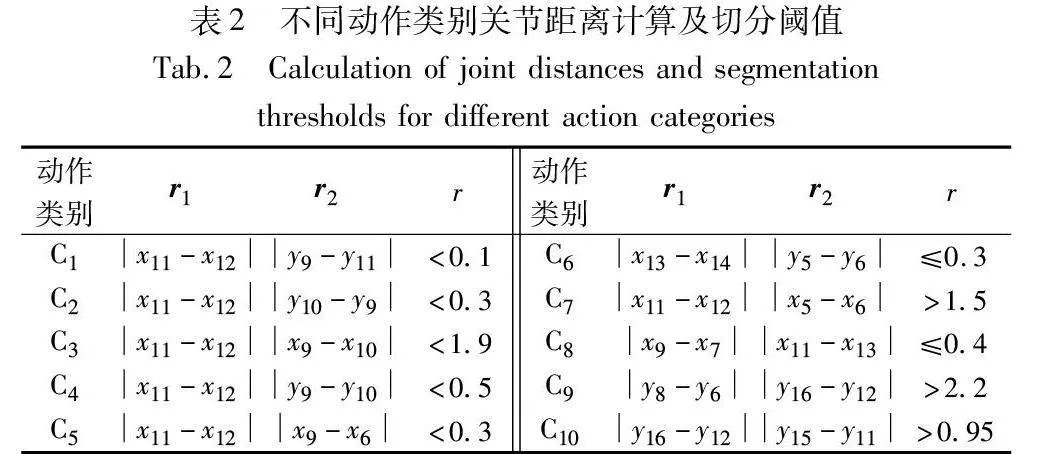

步骤k)(a)中任何一类康复训练动作在练习过程中始终存在长度不变的关节向量(由位置不变的两个关节点的横纵坐标差值的绝对值构成,记为r1)和长度循环变化的关键动作关节向量(由关键关节点的横纵坐标差值的绝对值构成,记为r2),因此,可以将r2映射到以r1为x轴的坐标系中,通过计算r2与r1的比值r,当r达到一定阈值则说明一个动作完成,且r不会随相机与受试者的距离变化。例如动作类别arm up,由关节(9,11)构成的关键关节r2与关节(11,12)构成的长度固定关节r1的比值可由式(1)得到。

r=r2r1=y9-y11x11-x12(1)

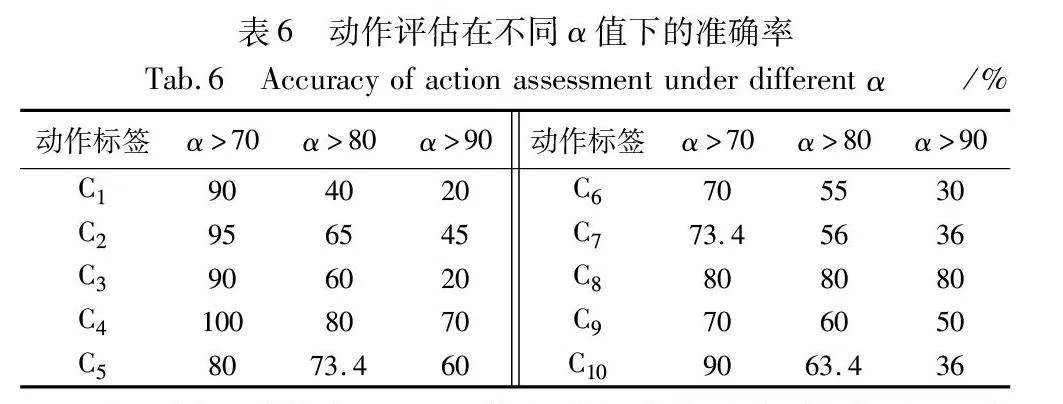

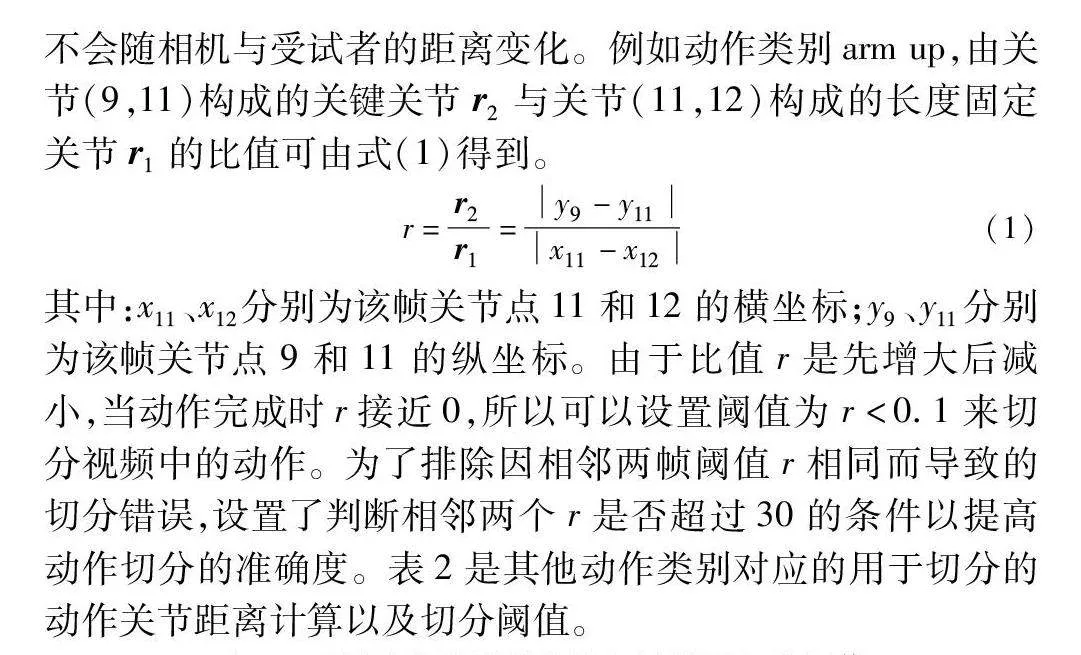

其中:x11、x12分别为该帧关节点11和12的横坐标;y9、y11分别为该帧关节点9和11的纵坐标。由于比值r是先增大后减小,当动作完成时r接近0,所以可以设置阈值为r<0.1来切分视频中的动作。为了排除因相邻两帧阈值r相同而导致的切分错误,设置了判断相邻两个r是否超过30的条件以提高动作切分的准确度。表2是其他动作类别对应的用于切分的动作关节距离计算以及切分阈值。

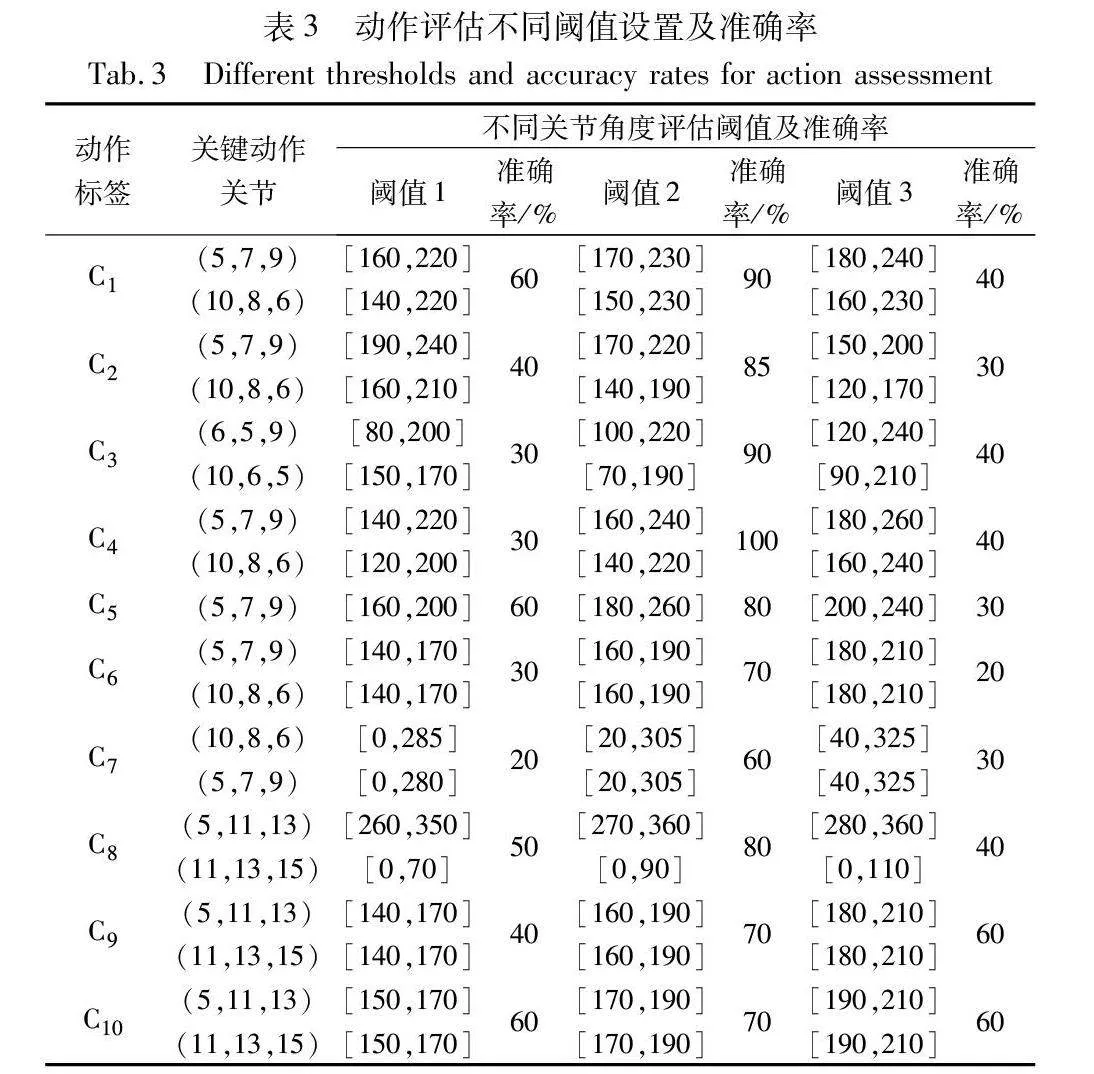

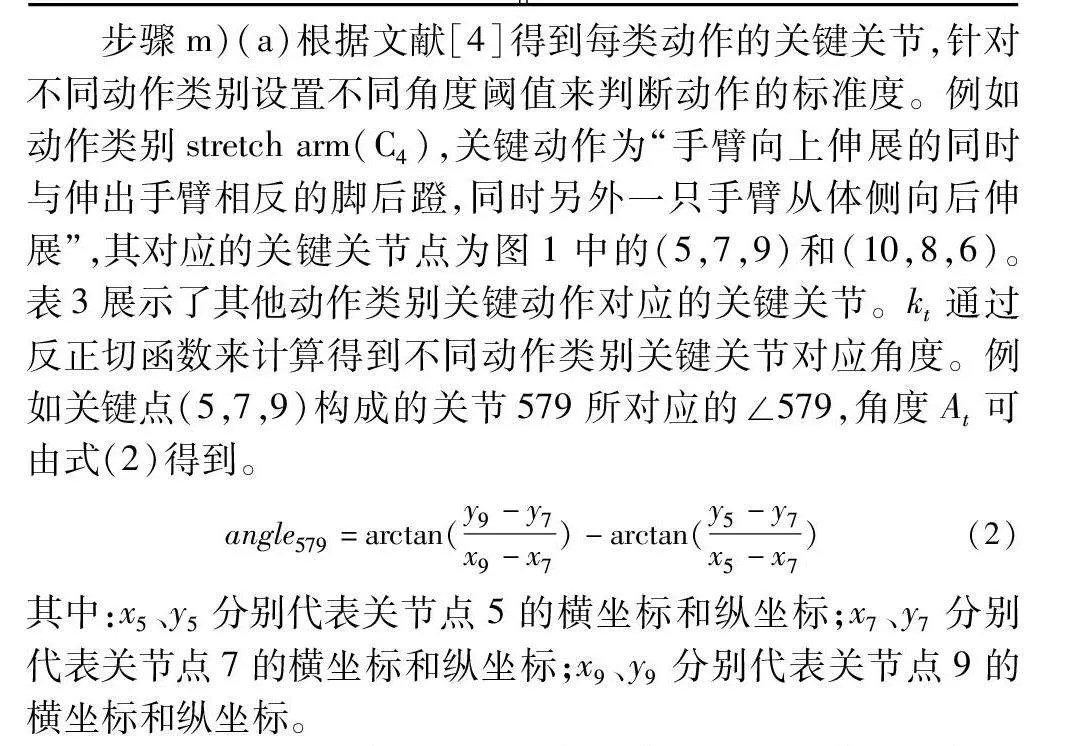

步骤m)(a)根据文献[4]得到每类动作的关键关节,针对不同动作类别设置不同角度阈值来判断动作的标准度。例如动作类别stretch arm(C4),关键动作为“手臂向上伸展的同时与伸出手臂相反的脚后蹬,同时另外一只手臂从体侧向后伸展”,其对应的关键关节点为图1中的(5,7,9)和(10,8,6)。表3展示了其他动作类别关键动作对应的关键关节。kt通过反正切函数来计算得到不同动作类别关键关节对应角度。例如关键点(5,7,9)构成的关节579所对应的∠579,角度At可由式(2)得到。

angle579=arctan(y9-y7x9-x7)-arctan(y5-y7x5-x7)(2)

其中:x5、y5分别代表关节点5的横坐标和纵坐标;x7、y7分别代表关节点7的横坐标和纵坐标;x9、y9分别代表关节点9的横坐标和纵坐标。

步骤m)(b)中,实验人员对每个康复训练动作进行标准度判断,然后通过模型获取每一帧的关节角度阈值。具体方法为:对于训练数据与验证数据采集的视频,测试人员判断视频中每个动作是否标准,同时利用模型计算每帧动作的关键关节角度,从而得到标准动作的阈值。例如动作类别stretch arm,分别作出:a)右臂向上伸展,同时伸出左脚后蹬,左臂向后伸展;b)左臂向上伸展,同时伸出右脚后蹬,右臂向后伸展。当左腋下(由关节点(7,5,11)构成的关节)角度小于90时且当右肘(由关节点(10,8,6)构成的关节)角度阈值为[160,240]时判定该动作标准,当右腋下(由关节点(8,6,12)构成的关节)角度小于90时且当左肘(由关节点(5,7,9)构成的关节)角度阈值为[140,220]时判定该动作标准,否则该动作为非标准。表3中是其他康复训练动作类别的关节角度评估阈值。

1b2ddf42eee4c724141186fed9574d683 实验结果与分析

本文实验处理器采用 Intel Core i5-10400,内存为16 GB,显卡为 GTX1050 Ti,显存为4 GB,通过1080P摄像头采集视频,操作系统为Ubuntu 20.04,基于PyTorch深度学习框架进行姿态估计模型及动作分类网络的搭建,并使用GPU加速姿态估计与动作识别模型的识别过程。

3.1 实验方案和指标

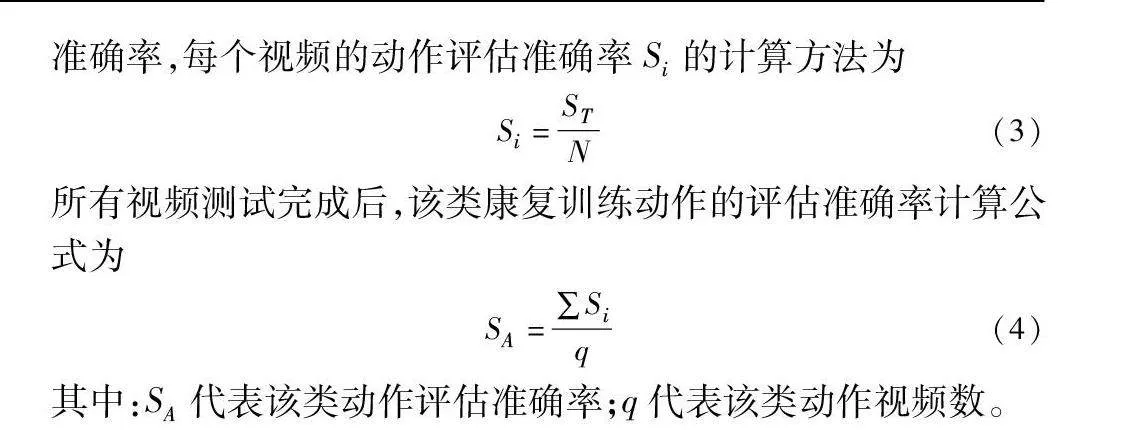

采用动作切分的准确率和动作评估的准确率、推理速度以及动作识别的top-1准确率测试方法的性能。针对动作评估的准确率,每个视频的动作评估准确率Si的计算方法为

Si=STN(3)

所有视频测试完成后,该类康复训练动作的评估准确率计算公式为

SA=∑Siq(4)

其中:SA代表该类动作评估准确率;q代表该类动作视频数。

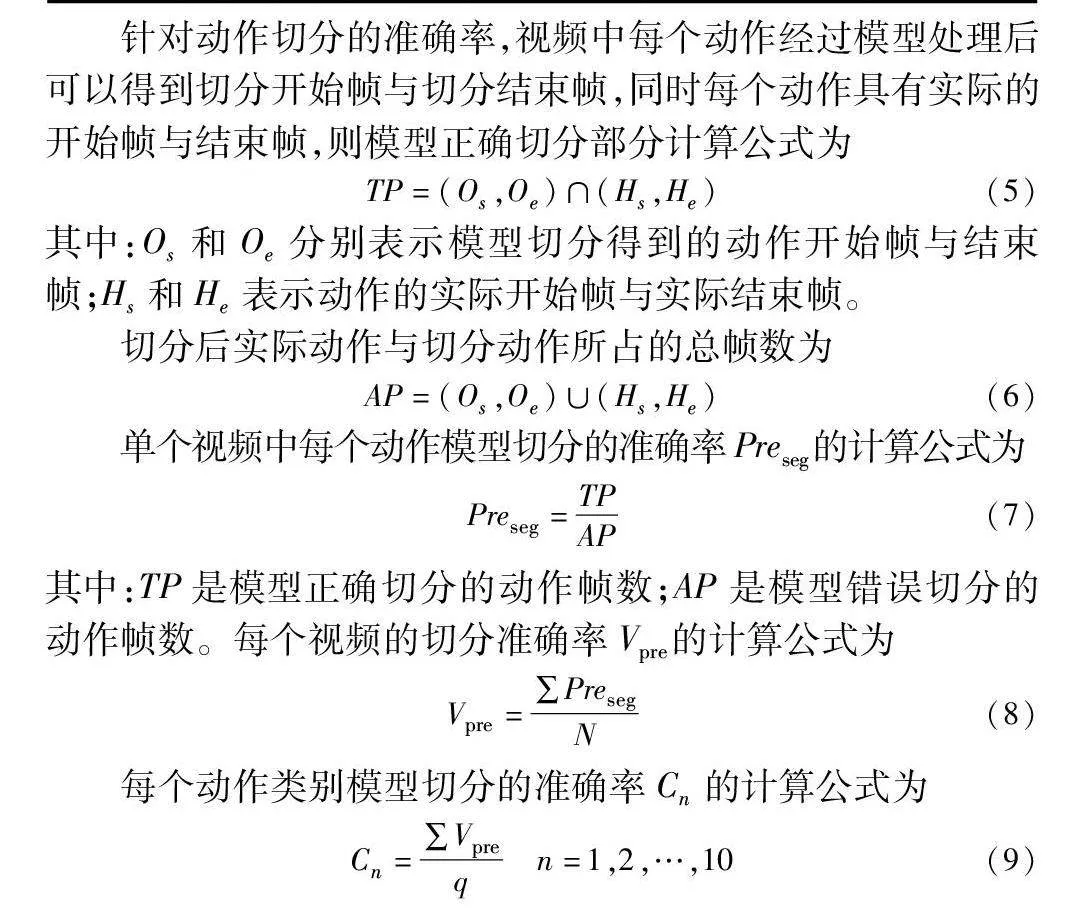

针对动作切分的准确率,视频中每个动作经过模型处理后可以得到切分开始帧与切分结束帧,同时每个动作具有实际的开始帧与结束帧,则模型正确切分部分计算公式为

TP=(Os,Oe)∩(Hs,He)(5)

其中:Os和Oe分别表示模型切分得到的动作开始帧与结束帧;Hs和He表示动作的实际开始帧与实际结束帧。

切分后实际动作与切分动作所占的总帧数为

AP=(Os,Oe)∪(Hs,He)(6)

单个视频中每个动作模型切分的准确率Preseg的计算公式为

Preseg=TPAP(7)

其中:TP是模型正确切分的动作帧数;AP是模型错误切分的动作帧数。每个视频的切分准确率Vpre的计算公式为

Vpre=∑PresegN(8)

每个动作类别模型切分的准确率Cn的计算公式为

Cn=∑Vpreq n=1,2,…,10(9)

3.2 不同关节角度阈值实验

为了更全面地优化模型性能,着重考虑两个关键方面:针对不同类别动作关键关节的判定准确率以及模型在应对不同受试者时的适用性。因此,对每个动作类别分别设置动作关键关节与评估阈值。针对每类动作分别选取不同实验人员的5个视频,通过分析视频数据并与实验人员讨论,得出用于该动作评估的大致阈值。在此基础上对阈值进行微调,得到3组不同的阈值。通过模型测试与实验人员验证得出每类动作的5个视频中不同阈值评估的准确率。具体来说,当每个视频中70%的帧经过系统判定为标准并符合实验人员验证时,该动作判定为标准,同时根据式(3)(4)计算每类动作在不同阈值下的评估准确率。观察表3可知,不同阈值设置对评估准确率存在影响,阈值2在动作评估中的准确率相对于阈值1和3要更高,相同条件下能实现评估的结果更加准确,因此选取该阈值进行后续实验验证与测试。

3.3 不同动作识别模型与α值实验

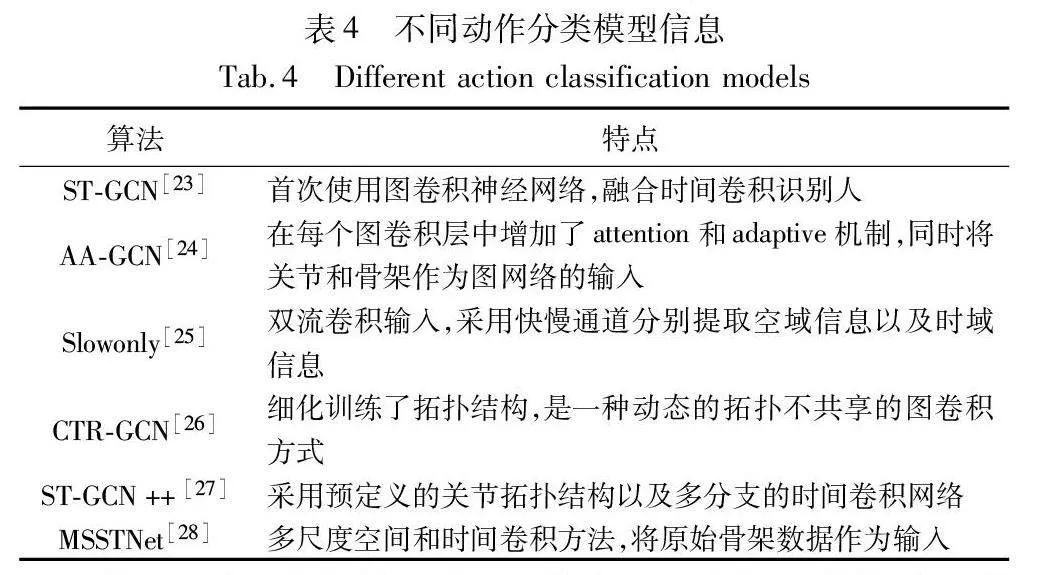

考虑到不同的动作识别模型对算法的性能有影响,因此,本节选择代表性动作识别模型进行测试,进而选择出最匹配的动作识别模型。表4是所选择的模型与特点统计。

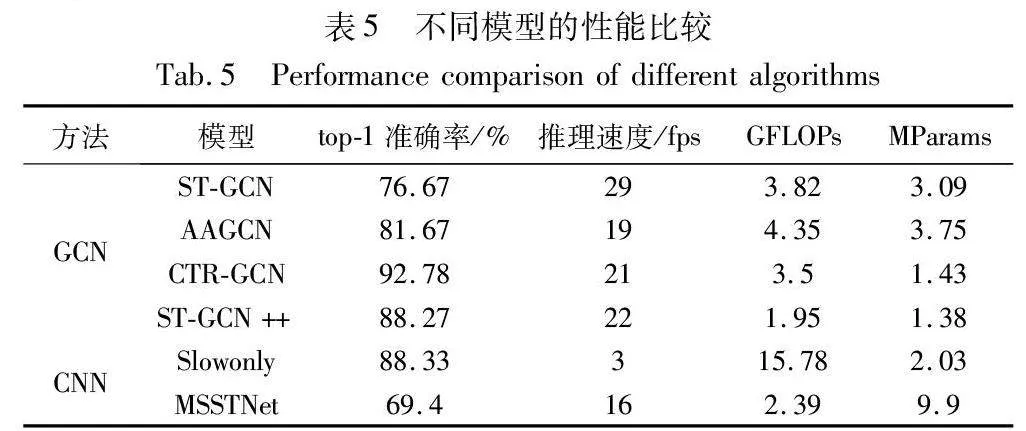

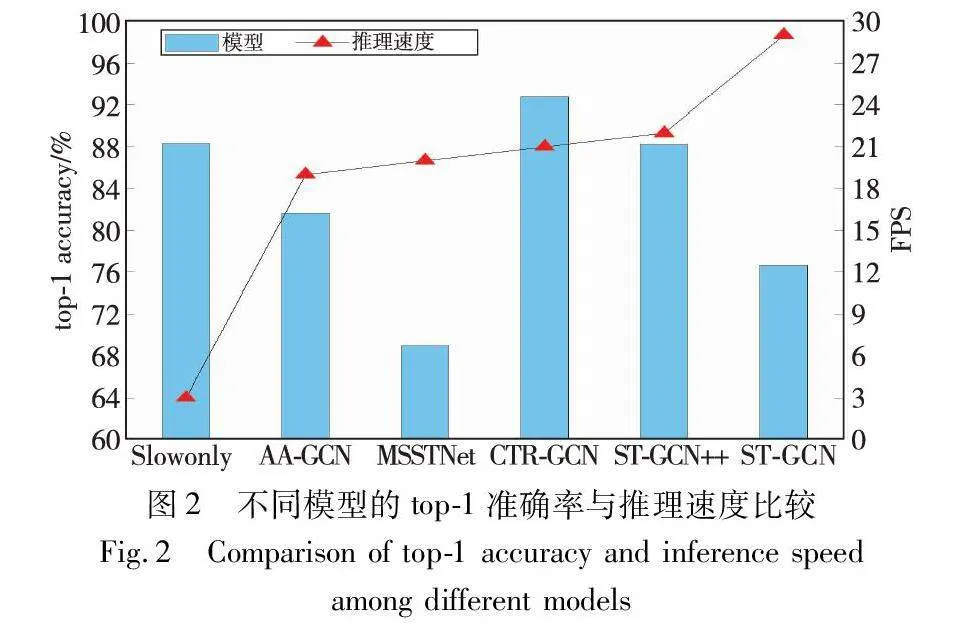

为了充分考虑各模型的特征并实现更高的准确率,表4中MSSTNet在训练时的学习率设定为0.001,而其他模型则使用学习率为0.1进行训练。训练循环30轮,batch-size为4。表5是不同模型的性能比较结果。与此同时,测试了这些方法在训练后的推理速度,结果也列在了表5中。为了探究不同方法top-1准确率和模型推理速度之间的关系,将表5中的数据按推理速度升序排列进行整理,图2是不同模型的top-1准确率与推理速度比较结果。

由表5可知,在不同模型的效率方面,基于GCN的模型相较于基于CNN的模型表现出更低的GFLOPs和更高的top-1准确率。以CTR-GCN为例,尽管其GFLOPs和MParams相较于ST-GCN++较高,但却表现出最高的top-1准确率,因此适用于对top-1准确率要求较高的场景。AAGCN在准确率和推理速度之间取得了平衡。ST-GCN具有最高的推理速度,但top-1准确率低于其他GCN模型,适用于对推理实时性有更高要求的环境。ST-GCN++具有较高的top-1准确率、与CTR-GCN相近的推理速度与更低的GFLOPs和MParams,适用于计算资源有限的环境。在CNN模型中,Slowonly具有与ST-GCN++相近的top-1准确率,但推理速度远低于STGCN++,且具有更高的GFLOPs,对计算资源的要求也更高。MSSTNet模型展现出相对较低的模型复杂度,然而其top-1准确率较低。相较于GCN模型,MSSTNet并未表现出显著优势。

观察图2可知,随着模型推理速度的增加,不同模型的top-1准确率呈现上升或下降的趋势。虽然STGCN的推理速度最快,但模型的top-1准确率较低;CTR-GCN的推理速度不如ST-GCN,但top-1准确率最高。根据这种规律可以对这些方法进行分类:一类为推理速度慢但top-1准确率高的模型,如Slowonly、CTR-GCN、ST-GCN++;另一类为推理速度较快但top-1准确率低的模型,如ST-GCN、AA-GCN、MSSTNet。综合对比考虑,选择CTR-GCN作为动作识别模型进行后续实验。

接下来,将详细探讨不同α值对动作评估准确率的影响。如3.2节所述,当每个视频中70%的帧经系统判定为标准并符合实验人员验证时,动作评估判定为正确。为了研究系统所判定的标准帧数对动作评估准确度的影响,采用3.2节中阈值实验的测试方案,分别测试当α为70%、80%、90%时动作评估的准确率。在统计结果时排除了所有因分类错误导致系统判断错误的数据。表6是动作评估准确率在不同α值下的测试结果。

由于同一动作当α>70增大时准确率下降,综合对比,当α>70时可以作为通用的动作评估判定标准。与此同时,根据用户动作差异,不同的α取值范围可以提供不同的动作评估判断标准。综上所述,当以CTR-GCN为动作识别模型,阈值2为判定阈值,α>70为动作评估判定标准时,算法具有最佳的性能。因此后续集成的系统中,选择上述参数作为ASRT-PHS默认工作参数。

3.4 算法性能分析

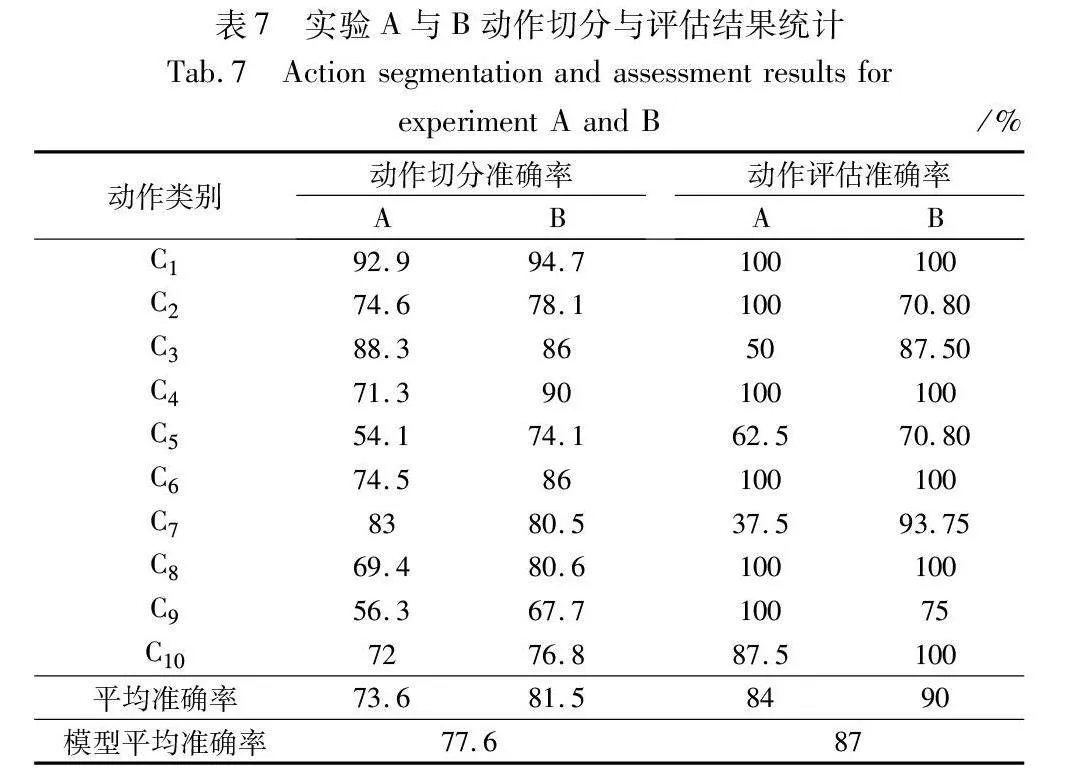

基于上述算法、评价指标与最优工作参数,以及3.1节所给出的计算公式计算每个动作类别的评估准确率和切分准确率。表7是实验A、B中不同类别的动作切分与评估统计结果。

观察表7可知,在动作切分的准确率方面,多数动作类别表现出较高的准确率,其中实验A、B的动作切分平均准确率分别达到了73.6%和81.5%。XHpS2BMn1j187vpPYEpXkH93PX0Z/A1iOOMNHldh0yU=然而,动作类别C5的准确率相对较低,这是由于关键点检测过程中出现抖动,导致部分关键点的丢失,进而影响了动作切分的准确性。对于C9和C10类别的视频,进行了旋转处理,以确保人体检测的成功率。然而,这一处理导致在部分远距离拍摄的视频中,旋转后的坐标点位置相对于原始视频发生较大的变化,因此对于相同的阈值r,其准确率会低于近距离所拍摄视频。对于C7类别,在实验A中准确率为83%,这是由于该类别包含了身体转向的步骤,当受试者朝后转向时存在关键点遮挡,导致部分帧的关键点坐标出现错误。总体而言,这些观察结果表明,在动作切分过程中需要考虑抖动问题和距离变化对准确率的影响,以便更有效地处理不同拍摄情境下的视频数据。

由表7中ASRT-PHS动作评估的平均准确率为87%可知,本文方法在动作评估方面表现出良好的性能。具体而言,实验A与B的平均准确率分别达到84%和90%,表明在不同实验条件下,多数动作类别的评估准确率较高。然而,实验B在强光下的动作评估结果准确率较高,表明环境光照强度对该类动作评估产生了影响。C2和C3类别在实验A中的准确率较低,是由于不同实验人员双臂弯曲的程度不同,对于相同评估阈值设置得到不同评估结果,进而影响了评估的准确性。针对这种差异性,实际工作中需要根据不同受试者的动作特征设置不同的评估阈值,以提高算法的适应性。对于C5和C6类别,由于完成动作时需要弯腰,不同实验人员存在运动差异,且同一实验人员每次完成动作也存在细微差异,导致评估准确率较低。同时C6类别的评估准确率也受到动作识别错误的影响(动作识别错误导致用其他类别的阈值来评估),因此在实际应用中需要针对动作特点进一步优化动作识别模型。C7类别是由于完成动作时需要转头至身后,存在部分关键点遮挡,导致无法准确识别运动信息。在实验B中,C9类别的动作评估准确率为75%,说明经过顺时针45°旋转处理后,视频的动作识别成功

率提高,但由于旋转后关键点坐标位置变化,在相同的阈值条件下,观察到远距离拍摄视频的准确率相对较低,所以近距离拍摄条件更适用于实际工作。同时,不同实验人员存在运动差异,尤其是抬腿时的幅度不同,导致C9和C10类别在实验A和B中的准确率存在差异。最后,动作类别C3和C6均含有胳膊弯曲和身体转向的动作,导致运动过程中存在部分关键点遮挡,因此在实验A和B中的准确率较低。这一现象进一步表明关键点遮挡对准确率会产生显著的负面影响,在实际工作中需要根据患者的运动特征调整阈值以确保判定准确性。

4 案例分析

根据上述研究,运用ASRT-PHS开发了康复训练动作评估系统。系统的总体框架包括前端与后端两个部分。以摄像头采集的实时视频流或录制视频数据作为输入,以终端的动作分类和评估结果作为输出。为了实现前后端的有效交互,系统以前后端分离的形式进行设计,给前端提供API接口,后端采用Flask封装深度学习模块、登录模块和MySQL数据库模块,前端界面采用Vue构建。Axios用于前端和后端交互。系统的运行流程如下:通过前端采集康复训练动作视频数据,由后端服务器运行ASRT-PHS算法对输入的视频进行相应处理,输出动作类别、动作切分结果与动作评估结果,再由前端展示输出结果等交互界面。系统具有标准视频示例、动作评估、实时检测与数据统计四个功能。图3为系统工作流程。

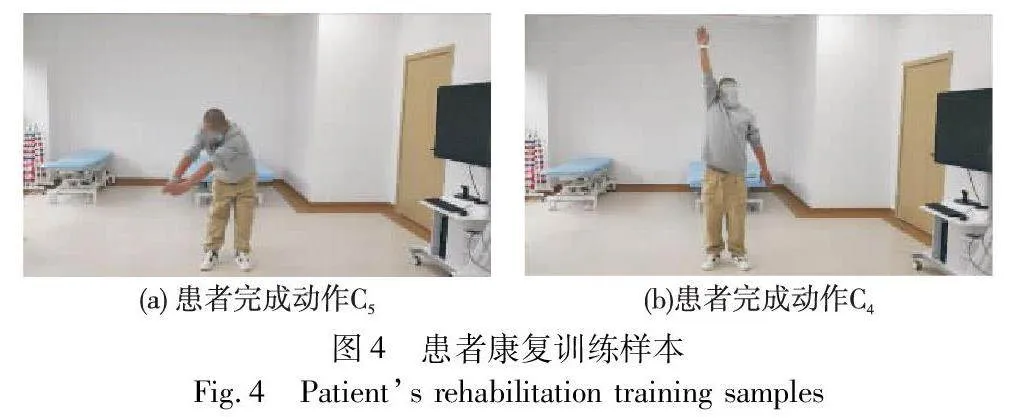

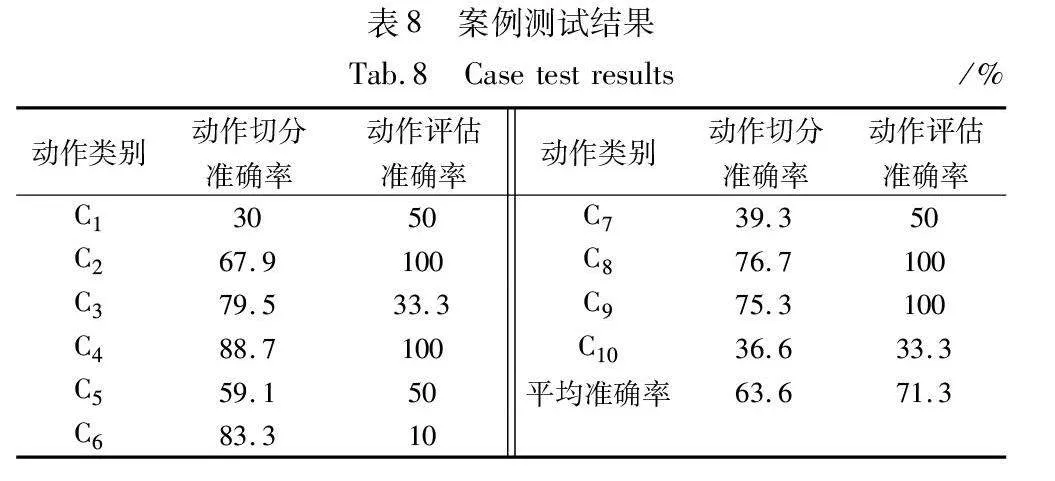

当前,全国康复专业技术人员相对匮乏,据统计数据显示,全国平均每10万人口有一名康复治疗专业技术人员[29]。为此,在贵州省职工医院招募了一位心血管患者作为案例测试,验证并探讨本文方法对心血管患者的适用性。该患者为男性,年龄50岁,具有大学文化程度,身高180 cm,体重70 kg,已经接受过心血管疾病相关治疗并处于康复阶段。首先,给患者介绍了课题组的概况及相关研究内容,并与患者签订了本文研究项目的知情同意书;其次,给患者示范了标准动作并告诉其动作要领;最后,在医生的指导与协助下采集该患者的康复训练动作数据。用摄像头采集视频,其高度与3.1节采集时相同。让患者完成10类康复训练动作,每类动作完成两次共20个视频。最后,将视频输入到系统中进行处理并分析结果,考虑到患者与健康受试者的运动差异,分别测试在不同阈值下动作切分和评估的准确率。图4是患者康复训练样本,表8是案例测试结果。

观察表8可知,动作切分和评估的平均准确率为63.6%和71.3%,C2、C4、C8和C9类别动作评估的准确率达到100%,表明本文方法对心血管患者的适用性较好。然而,C1和C3类别的动作评估准确率较低,是由于患者未经过康复动作的相关练习,与康复训练数据集中的健康受试者相比,部分动作步骤存在动作差异(例如患者左臂与右臂动作不能同步进行)。实际应用中需要根据不同患者的运动情况,进行动作切分与动作评估阈值的个性化设置。C6类别的准确率较低,一方面是由于部分视频动作识别错误导致用其他的动作类别阈值评估;另一方面是由于患者腰部无法完全弯曲导致关键关节角度无法达到阈值标准。C7类别需要患者身体转向后方,在此过程中会存在部分关键点遮挡,因此准确率较低。对于经过旋转的C9和C10类别视频,尽管得到了关键点信息,但部分视频会由于分类错误导致动作切分与评估错误,所以针对未检测成功的样本需要调整摄像头视角以确保完全检测到人体信息。而动作切分准确率较低的C1、C5、C7、C10类别,是由于患者的运动差异导致动作完成度未达到切分阈值标准,首个动作切分误差引起了后续动作的切分误差。综上所述,ASRT-PHS适用于心血管患者的康复训练,但仍需要根据不同患者的运动情况对阈值进行个性化调整。

5 结束语

合理的动作识别网络参数、动作切分与评估阈值以及实验环境可以为心血管患者居家康复训练提供科学的指导与及时的评估反馈。本文通过人体位置检测、人体关键点检测、动作识别、基于关节距离比值的动作切分方法以及基于关键关节角度阈值的动作评估方法实现了康复训练动作的识别与评估。通过测试分析不同的动作识别算法、关键动作关节角度阈值以及多种实验环境下本文方法的性能表现,对康复系统的性能进行了评估。并针对心血管患者进行了案例测试与分析,进而形成了一套基于人体骨骼关键点的心血管患者康复训练动作评估方法和系统,为心血管患者居家康复训练动作评估提供了辅助手段。鉴于人体关键点检测算法对动作切分与评估结果有影响,未来将针对该问题展开研究,以提升系统在动作识别、动作评估和动作切分方面的准确性,并通过考察不同患者的运动差异来实现阈值的动态调整,以进一步优化康复训练动作评估系统的性能。

参考文献:

[1]国家心血管病中心.《中国心血管健康与疾病报告》2020[J]. 心肺血管病杂志, 2021, 40(10): 1005-1009. (National Center for Cardiovascular Diseases. Annual report on cardiovascular health and diseases in China 2020[J]. Journal of Cardiovascular & Pulmonary Diseases, 2021, 40(10): 1005-1009.)

[2]王祎, 江露莹, 吴岳, 等. 心血管疾病患者Ⅱ期心脏康复完成率及其影响因素分析[J]. 中国循环杂志, 2021,36(10): 1003-1008. (Wang Yi, Jiang Luying, Wu Yue, et al. Completion rate and influencing factors of phase Ⅱ cardiac rehabilitation program in patients with cardiovascular disease [J]. Chinese Circulation Journal, 2021, 36(10): 1003-1008.)

[3]张延恒, 莫春晖, 张莹, 等. 移动式康复训练机器人及下肢康复运动分析[J]. 华中科技大学学报: 自然科学版, 2021,49(3): 6-11. (Zhang Yanheng, Mo Chunhui, Zhang Ying, et al. Design and motion analysis of mobile rehabilitation training robot[J]. Journal Huazhong University of Science & Technology(Natural Science Edition), 2021, 49(3): 6-11.)

[4]陈书立, 张景景, 陈海洋, 等. 镜像上肢康复机器人研究[J]. 计算机应用研究, 2019, 36(2): 321-326. (Chen Shuli, Zhang Jingjing, Chen Haiyang, et al. Research on mirror rehabilitation robot of upper limbs[J]. Application Research of Computers, 2019,36(2): 321-326.)

[5]Wang Kaiwei, Wang Zhenghui, Ren Wu, et al. Design of sports rehabilitation training system based on EEMD algorithm[J]. Computational Intelligence and Neuroscience, 2022, 2022: article ID 9987313.

[6]Chen Pengcheng, Gao Nuo. Research of VR-BCI and its application in hand soft rehabilitation system[C]//Proc of the 7th International Conference on Virtual Reality. Piscataway, NJ: IEEE Press, 2021: 254-261.

[7]Liu Siyuan, Meng Deyuan, Cheng Long, et al. A virtual reality based training and assessment system for hand rehabilitation[C]//Proc of the 9th International Conference on Intelligent Control and Information Processing. Piscataway, NJ: IEEE Press, 2018: 33-38.

[8]Bortone I, Leonardis D, Mastronicola N, et al. Wearable haptics and immersive virtual reality rehabilitation training in children with neuromotor impairments[J]. IEEE Trans on Neural Systems and Rehabilitation Engineering, 2018, 26(7): 1469-1478.

[9]Maskeliūnas R, Damaevicˇius R, Blazˇauskas T, et al. BiomacVR: a virtual reality-based system for precise human posture and motion analysis in rehabilitation exercises using depth sensors[J]. Electro-nics, 2023, 12(2): 339.

[10]Zhao Nana, Han Xiao, Chen Long. Construction and application of rehabilitation training system based on intelligent measurement and control[J]. Scientific Programming, 2022, 2022: article ID 4442590.

[11]Liu Yi, Guo Shuxiang, Yang Ziyi, et al. A home-based tele-rehabilitation system with enhanced therapist-patient remote interaction: a feasibility study[J]. IEEE Journal of Biomedical and Health Informatics, 2022, 26(8): 4176-4186.

[12]Fan Dou, Yang Xiaodong, Zhao Nan, et al. Exercise monitoring and assessment system for home-based respiratory rehabilitation[J]. IEEE Sensors Journal, 2022, 22(19): 18890-18902.

[13]Bai Jing, Song Aiguo. Development of a novel home based multi-scene upper limb rehabilitation training and evaluation system for post-stroke patients[J]. IEEE Access, 2019, 7: 9667-9677.

[14]Kim J N, Shin M Y, Chong W S, et al. Development of rail-based dynamic rehabilitation training system considering user’s movement[J]. Journal of Mechanics in Medicine and Biology, 2022, 22(3): 2240003.

[15]Li Jianwei, Hu Haiqing, Xing Qingjun, et al. Tai Chi action quality assessment and visual analysis with a consumer RGB-D camera[C]//Proc of the 24th International Workshop on Multimedia Signal Proces-sing. Piscataway, NJ: IEEE Press, 2022: 1-6.

[16]Parsa B, Narayanan A, Dariush B. Spatio-temporal pyramid graph convolutions for human action recognition and postural assessment[C]//Proc of IEEE Winter Conference on Applications of Computer Vision. Piscataway, NJ: IEEE Press, 2020: 1069-1079.

[17]Zhang Zhitao, Wang Zhengyou, Zhuang Shanna, et al. Toward action recognition and assessment using SFAGCN and combinative regression model of spatiotemporal features[J]. Applied Intelligence, 2023, 53(1): 757-768.

[18]何塞·曼努埃尔·桑斯·门希瓦尔. 人人都能看得懂的运动康复指南: 全彩图解版[M]. 董艳艳, 译. 北京: 人民邮电出版社, 2017: 83-87. (José M S M. Guide to sports rehabilitation that everyone can understand: full color graphic[M]. Dong Yanyan, Trans. Beijing: Posts & Telecom Press, 2017: 83-87.)

[19]Papakipos Z, Bitton J. AugLy: data augmentations for adversarial robustness[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2022: 156-162.

[20]Ren Shaoqing, He Kaiming, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2017, 39: 1137-1149.

[21]Sun Ke, Xiao Bin, Liu Dong, et al. Deep high-resolution representation learning for human pose estimation[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2019: 5686-5696.

[22]Luo Kexin, Yang Guanci, Li Yang, et al. Croup and pertussis cough sound classification algorithm based on channel attention and multiscale Mel-spectrogram[J]. Biomedical Signal Processing and Control, 2024, 91: 106073.

[23]Yan Sijie, Xiong Yuanjun, Lin Dahua. Spatial temporal graph convolutional networks for skeleton-based action recognition[C]//Proc of the 32nd AAAI Conference on Artificial Intelligence and 30th Innovative Applications of Artificial Intelligence Conference and 8th AAAI Symposium on Educational Advances in Artificial Intelligence. Palo Alto, CA: AAAI Press, 2018: 7444-7452.

[24]Shi Lei, Zhang Yifan, Cheng Jian, et al. Skeleton-based action re-cognition with multi-stream adaptive graph convolutional networks[J]. IEEE Trans on Image Processing, 2020, 29: 9532-9545.

[25]Duan Haodong, Zhao Yue, Chen Kai, et al. Revisiting skeleton-based action recognition[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2022: 2959-2968.

[26]Chen Yuxin, Zhang Ziqi, Yuan Chunfeng, et al. Channel-wise topo-logy refinement graph convolution for skeleton-based action recognition[C]//Proc of IEEE/CVF International Conference on Computer Vision. Piscataway, NJ: IEEE Press, 2021: 13339-13348.

[27]Duan Haodong, Wang Jiaqi, Chen Kai, et al. PYSKL: towards good practices for skeleton action recognition[C]//Proc of the 30th ACM International Conference on Multimedia. New York: ACM Press, 2022: 7351-7354.

[28]Cheng Qin, Cheng Jun, Ren Ziliang, et al. Multi-scale spatial-temporal convolutional neural network for skeleton-based action recognition[J]. Pattern Analysis and Applications, 2023, 26(3): 1303-1315.

[29]张元鸣飞, 杨延砚, 张娜, 等. 2021年度国家康复医学专业医疗服务与质量安全报告[J]. 中国康复理论与实践, 2022, 28(12): 1365-1379. (Zhang Yuanmingfei, Yang Yanyan, Zhang Na, et al. 2021 national report on rehabilitation medicine services, quality and safety in medical care system[J]. Chinese Journal of Rehabilitation Theory and Practice. 2022, 28(12): 1365-1379.)