基于Faster R-CNN的蔗田杂草检测算法研究

2024-06-17黄书琴黄福乐罗柳茗覃锋李岩舟

黄书琴 黄福乐 罗柳茗 覃锋 李岩舟

摘要:为提高自然环境下蔗田杂草检测准确率,提出一种基于改进的Faster R-CNN的蔗田杂草检测算法。在特征提取阶段使用BFP模块均衡各级语义特征来加强对杂草图像深层特征的提取;采用DLA策略动态调整网络的标签预测阈值,解决训练前期正样本稀缺问题;使用Soft-NMS对模型进行优化,通过改进原模型的NMS减少单类目标漏检并提高目标定位精度。试验结果表明,优化后算法的mAP值达81.3%,与原Faster R-CNN算法相比,精度提升6.2%,平均每幅图像测试耗时0.132 s,且在AP50、APs、APl指标上分别有6.5%、4.7%、5.1%的提高。改进后的算法具有较高的检测精度和稳定性,可以满足复杂自然环境下的蔗田杂草检测需求。

关键词:杂草检测;Faster R-CNN;均衡特征金字塔;动态分配标签策略;软非极大抑制

中图分类号:TP391

文献标识码:A

文章编号:2095-5553 (2024) 06-0208-08

收稿日期:2022年11月14日

修回日期:2023年2月1日

*基金项目:国家重点研发计划项目(2022YFD2301100);广西科技重大专项经费资助(桂科AA22117007,桂科AA22117005)

第一作者:黄书琴,女,1997年生,广西桂林人,硕士;研究方向为计算机视觉和图像处理。E-mail:2877707484@qq.com

通讯作者:李岩舟,男,1979年生,广西桂林人,博士,副教授;研究方向为农业机械、传感器应用与智能控制。E-mail:lyz197916@126.com

Research on weed detection algorithm in sugarcane field based on Faster R-CNN

Huang Shuqin1, 2, Huang Fule1, Luo Liuming1, Qin Feng1, 3, Li Yanzhou1

(1. School of Mechanical Engineering, Guangxi University, Nanning, 530004, China; 2. School of Intelligent

Manufacturing, Nanning University, Nanning, 530200, China; 3. Agricultural Genomics Institute at Shenzhen,

Chinese Academy of Agricultural Sciences, Shenzhen Branch, Guangdong Laboratory of Lingnan Modern

Agriculture, Shenzhen, 518120, China)

Abstract: In order to improve the accuracy of weed recognition in cane fields under natural environment, a weed detection algorithm based on improved Faster Region-based Convolutional Neural Network (Faster R-CNN) was proposed. Firstly, in the feature extraction stage, the balanced feature pyramid module was used to balance the semantic features at all levels to strengthen the extraction of deep features of weed images. Secondly, the dynamic label assignment was used to dynamically adjust the label prediction threshold of the network to solve the problem of scarcity of positive samples in the early stage of training. Finally, soft non-maximum suppression was used to optimize the model, which was able to reduce the missed detection of single-type targets and improve the positioning accuracy of targets by improving the non-maximum suppression of the original model.The experimental results showed that the mean average precision of the optimized algorithm reached 81.3%, which compared with the original Faster R-CNN algorithm, the precision was improved by 6.2%, and the average test time for each image was 0.132 s. There were 6.5%, 4.7%, and 5.1% improvements in the average precision of the intersection over union of 0.5 and the across scale of small and medium, respectively. The proposed algorithm has high detection precision and stability, which can meet the needs of sugarcane field weed detection in complex natural environment.

Keywords: weeds detection; Faster R-CNN; balanced feature pyramid; dynamic label assignment; soft non-maximum suppression

0 引言

甘蔗是我国最主要的糖料作物,其蔗糖产量占我国食糖总产量的90%以上,而广西作为全国最大的蔗糖生产省(区),其糖料蔗种植面积及食糖产量占全国总产量的60%以上[1, 2]。在甘蔗的生产种植中,田间杂草严重影响了糖料蔗生长和食糖产量,给食糖生产造成了一定程度的经济损失,所以及时有效地去除杂草是保证农作物高产稳产的一项重要措施。

准确高效地识别田间杂草目标不仅有助于自动化除草作业和自动水肥变量喷施,还能节约成本并减少传统除草方式造成的农药残留[3]。因此,将深度学习应用到田间杂草识别具有重要意义[4, 5]。传统的田间杂草检测主要是从作物和杂草之间的颜色、形状、纹理等特征的差异性着手,进行图像特征的手动提取,特征提取单一且效率较低,对于复杂背景环境下的杂草识别检测泛化性和实用性均不高[6-8]。随着机器视觉的发展,深度学习逐步应用于农业,其不仅在作物种节识别检测、作物生长状态监测、田间作物病虫害检测等领域取得较好的效果,还为田间杂草识别的研究提供了新思路[9-17]。孟庆宽等[18]通过构建轻量特征提取单元替代原SSD模型中相应模块,提高了自然环境下作物与杂草的识别精度;李春明等[19]通过在网络池化层后添加生成对抗网络(GAN)噪声层的方法来解决当前除草机器人杂草识别实时性差的问题;孙鹏飞[20]采用Mask R-CNN算法,对自然光照下的白菜幼苗和杂草幼苗进行识别,并取得良好效果。以上研究的开展为优化深度学习模型进一步提高田间杂草检测精度提供了参考和依据。

由于蔗田杂草与其他作物田间杂草种类稍有不同,且甘蔗叶片交错重叠对杂草识别造成一定干扰,经过实验室测试,现有方法对于蔗田杂草识别效果并不理想。目前尚未有CNN(Convolutional Neural Network)网络用于蔗田田间杂草识别的相关报导。本文针对蔗田杂草种类较多、分布状态较为复杂,自然环境背景下杂草识别率低、鲁棒性差等问题,以蔗田杂草爆发的两个时期的6种杂草为研究对象,提出一种优化的Faster R-CNN模型以提高检测蔗田杂草目标的精度。

1 材料与方法

1.1 制作数据集

桂糖42号是广西农业科学院甘蔗研究所选育的甘蔗品种,由新台糖22号×桂糖92-66杂交组合选育而成[21]。因其相比于新台糖22号获得了约10%的增产和约14%含糖量的提高,而在广西区内广泛种植,成为广西主要糖蔗品种,试验主要以种植有桂糖42号甘蔗的甘蔗地常见杂草为研究对象。

1.1.1 图像采集

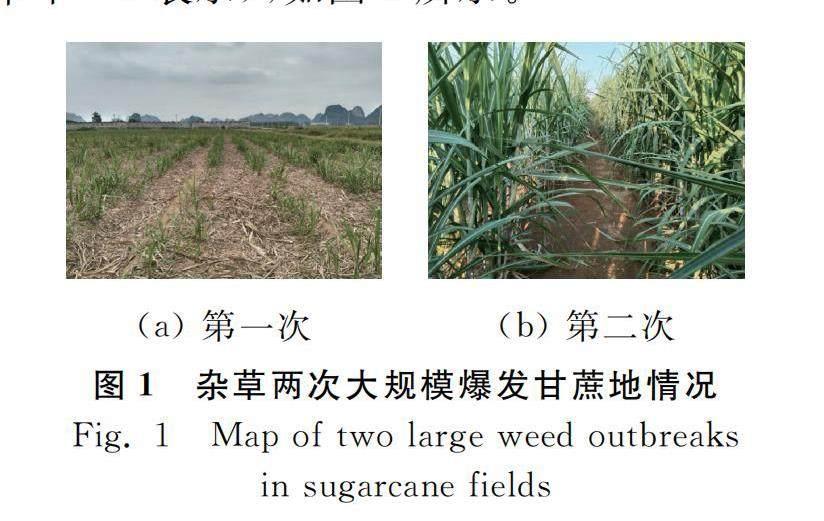

根据调查,广西甘蔗地中杂草主要爆发于甘蔗幼苗期6~7叶龄以及伸长期封行前高1.2~1.5m两个时期,本文主要以这两个时期的杂草为研究对象。由于甘蔗地常见杂草多达二十几种,考虑到时间以及硬件设备的负载问题,该研究选取其中生长数量较多且危害最为严重的6种作为主要研究对象,它们分别是野辣子、木薯、马唐、牵牛、胜红蓟、小飞蓬。试验数据采集于广西亚热带农科新城同一宿根甘蔗种植地,采集时间为2021年4月中下旬甘蔗幼苗期以及7月中旬甘蔗伸长期封行前。甘蔗幼苗期植株较小(图1(a)),有较多地面暴露在阳光下,给杂草生长提供了条件,可在甘蔗田间采集到以上6种杂草图片,如图2所示。而甘蔗伸长期植株高、叶片多(图1(b)),遮挡了大部分阳光,在很大程度上抑制了杂草的生长,但牵牛等藤蔓型杂草却并不受影响,所以在该阶段,可在甘蔗田间采集牵牛1种杂草图片(为了方便区分,下文以牵牛-2表示),如图3所示。

结合除草设备通常在甘蔗行间作业的特点,取行间距约1.5m的一半,水平方向距离甘蔗行约0.75m处作为数据采集位置。在拍摄时,根据杂草形态不同,可采用竖向(人像模式)或横向(风景模式)进行拍摄,并使杂草植株位于相机取景框之内。相机镜头过高会使设备重心升高,不利于垄间行走作业,镜头过低不利于杂草植株采集的完整性,故镜头水平位置应低于1m,略高于幼苗期甘蔗(约0.4~0.6m),故取0.7~0.8m作为相机镜头水平高度。拍摄角度与水平方向向下夹角约为0°、45°和90°,拍摄开始前锁定自动变焦开关(禁止自动调焦)。考虑到样本的多样性,通过相机共采集了不同光照条件(阴天、晴天),不同拍摄角度下的蔗田杂草图片2165张,剔除模糊图片,共保留858张清晰图片。各种杂草的图片数量如表1所示。

1.1.2 图像预处理

本次试验采集并有使用价值的甘蔗杂草图像共858张,为了训练后续模型以及减少训练所占用的内存和显存,需要将图像分辨率为4160pixel×3120pixel的图像进行压缩处理,分辨率降至768pixel×576pixel。使用Labelme工具按照COCO数据集格式进行数据标注,在标注数据时,由于牵牛类杂草为藤蔓缠绕型杂草,若以整株杂草作为一个标注对象,其包括的背景信息过多,不利于模型训练,所以除牵牛和牵牛-2使用叶片作为标注对象,其他种类杂草均以单棵植株作为标注对象。数据标注完成后,将全部标注图片按照4∶1的比例划分为训练集和测试集,并且由于识别杂草为7种6类且图像数量不同,各种杂草按图像总数所占比例划分训练集和测试集。各数据集的图片数如表2所示。

为了实现图像数据增强,以增加样本的多样性,本文对标注后的图像进行随机水平翻转、随机垂直翻转、随机亮度、随机饱和度、高斯模糊5种处理操作。经过图像数据增强,数据集由858张扩充到5148张,其中训练集由772张图像扩充为4116张图像,测试集由86张图像扩充到1032张图像。

1.2 试验方法

蔗田杂草的自动化防除的基础是杂草目标的识别检测,即包括杂草类别的确认和杂草目标位置的锁定,而二阶段的Faster R-CNN算法不仅能满足以上需求,而且具有优良的性能以及较好的通用性,故本试验基于Faster R-CNN模型进行蔗田杂草目标检测算法的优化。

1.2.1 Faster R-CNN基本原理

Faster R-CNN是由Ren等[22]通过对R-CNN和Fast R-CNN模型的分析和优化从而提出来的目标检测网络模型,该模型较之前的深度卷积模型在训练速度上有较大提升。本文选用Faster R-CNN作为蔗田杂草识别检测的基础框架,网络结构如图4所示。

由图4可以看出蔗田杂草图像在模型中训练的全过程。蔗田杂草图像首先经过骨干网络(Backbone)中的特征提取网络进行特征提取,再由特征金字塔网络(Feature Pyra-mid Network,FPN)进行特征融合得到杂草特征图。接着将生成的杂草特征图喂入RPN(Region Proposal Network)网络中,进行杂草目标候选框的选取,该网络替换原有的SS(Selective Search)方法,有效降低提取候选框所需要的时间成本。将杂草目标候选框与特征图中对应位置的杂草目标选取出来,得到带有候选框的杂草特征图,输入到ROI Pooling层,再利用最大池化将特征图调整为固定大小。最后输入到FC(Fully Connected)层,经过分类器进行杂草分类以及位置定位。

1.2.2 优化方法

本研究检测识别的目标为蔗田杂草,类别较多,且样本均采集于自然环境状态下,背景复杂多样,多存在甘蔗植株、甘蔗秸秆以及其他种类杂草,为了进一步提高模型的检测能力,本研究对原始模型进行优化改进。

1) 平衡特征金字塔(Balanced Feature Pyramid,BFP)[23]。为了进一步提高模型的特征提取能力,获得更多信息的杂草特征图,采用特征层平衡策略。不同于传统的横向融合多级特征的方法,本试验采用按同一深度融合来均衡各层级语义达到增强多级特征的方法。杂草图像经过骨干网络的下采样,得到编号为C2、C3、C4、C5的多层级特征映射图,各层特征映射图为Wn×Hn×En的特征矩阵,Wn×Hn表示第n层特征映射图的图像信息,En代表第n层特征图深度,使用插值和最大池化将各级特征映射图调整至与C4尺度相同,再通过式(1)得到平衡后的语义特征。

C=1N∑nmaxn=nminCn(1)

式中:Cn——第n层特征,n=2,3,…;

N——特征总层数;

nmax——最高层数;

nmin——最低层数。

完成尺寸调整和特征融合(integrate)后,各级特征层集成并保留各自的语义信息,再通过细化提炼(Refine)特征进一步增强集成特征,最后对每层特征使用相反过程进行重新缩放,输出为P2、P3、P4、P5,使该多层级特征映射图与C2、C3、C4、C5大小保持一致(Identity),Pn表示特征融合后的输出特征图,能按照原始目标检测流程继续进行。优化具体结构如图5所示。

2) 动态分配标签策略(Dynamic Label Assignment,DLA)[24]。本次试验使用的蔗田杂草是自采集的小数据集,为了保证训练数据的正样本数量,更好的训练分类器,解决在原有网络训练之初设置较高的交并比(IoU)阈值往往会导致正样本数量稀少的问题,采用动态标签分配策略。即在训练前期,loss值较高时,RPN无法给出高质量的目标候选框,为了保证更多的特征被模型学习,需要设置较低的IoU阈值;随着迭代次数的增加,loss值逐渐降低,模型精度不断提高,为了保证高质量的目标检测,需要提高正样本的质量来训练高质量的分类器,则IoU阈值也应设置较高。传统的标签分类策略如式(2)所示。

label=1maxIoU(b,G)≥T+0maxIoU(b,G)

式中:b——候选框,表示以候选框的中心坐标、宽和高构成的1×4向量(bx,by,bw,bh);

G——杂草目标真实边界框,表示以真实边界框的中心坐标、宽和高构成的1×4向量(Gx,Gy,Gw,Gh);

maxIoU(b,G)——b和G的IoU最大值;

T+、T-——正负阈值,此处取值为T+=T-=0.5;

1、0、-1——正样本、负样本和忽略样本。

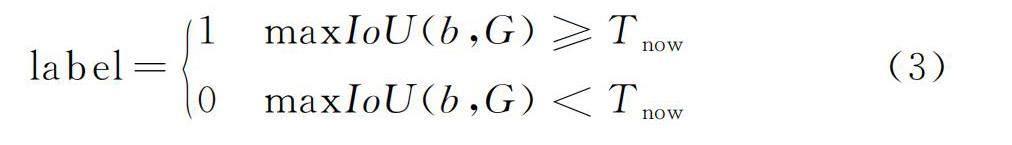

优化后的标签分配策略如式(3)所示。

label=1maxIoU(b,G)≥Tnow0maxIoU(b,G)

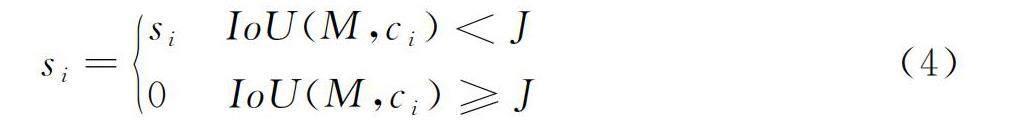

式中:Tnow——当前的IoU阈值,初始阈值设为0.4。

3) 软非极大抑制方法(Soft Non-Maximum Suppression,Soft-NMS)。自然环境条件下的蔗田杂草通常是成片生长,而在本研究中的杂草,如牵牛和牵牛-2就存在大量密集的同类杂草重叠的情况,这就导致模型的整体检测精度较高,但单类别杂草(如牵牛-2)检测精度较低。为了在提高整体检测精度的同时提高单类杂草的定位精度,本研究引入了Bodla等[25]提出的软非极大抑制方法,该方法可以在几乎不影响对稀疏目标的预选框检测的同时,提高对密集同类杂草的一框一物体定位效果。用B表示目标对象周围能检测到的所有的候选框集合,原有NMS公式如式(4)所示。

si=siIoU(M,ci)

式中:si——B中第i个候选框包含物体可能性大小,即第i个候选框的得分,取值为(0,1];

M——最有可能包含物体的框,即当前得分最高的框,是一个1×4的向量,向量中各元素分别表示框的中心坐标、宽和高;

ci——去掉M后剩下的候选框中的第i个,是一个1×4的向量,向量中各元素分别表示框的中心坐标、宽和高;

IoU(M,ci)——M和ci的IoU值;

J——自定义阈值,此处取值为0.85。

改进后的软非极大抑制算法如式(5)所示。

si=siIoU(M,ci) si[1-IoU(M,ci)]IoU(M,ci)≥J(5) 当与M越近的ci检测框的IoU值越大,所受到的衰减就会越大,si值也就越小。改进后的算法与原算法不同在于,当M和ci的IoU值不小于阈值J时,不是直接把ci的得分置0,而是保留该框,减小si的值。式(5)中,为保证衰减函数的连续性,需满足式(6)的关系,D表示框的集合。si=sie-IoU(M,ci)2σ ciD(6) 1.3 试验条件与训练设置 本试验在mmdetection深度学习工具箱的基础上实现甘蔗地杂草目标识别模型的训练和测试,硬件配置采用16GB运行内存的Intel(R) Core(TM) i7-11800H处理器和8GB运行显存的NVIDIA GeForce RTX 3050 Ti 显卡,使用Windows11操作系统,pytorch1.8.1,python3.8搭建模型运行环境。除此之外,模型训练时用ResNet50作为骨干网络,使用ReLU激活函数,SGD优化器,权重衰减为0.0001,动量因子为0.9,初始学习率为0.0025,BatchSize设为1,max_epochs设为30,迭代次数为100000次。 2 结果与分析 2.1 优化模型训练损失 在上述试验条件和训练设置下,采用优化后的模型对4116张蔗田杂草图像进行训练,耗时9h,模型的训练损失曲线如图6所示。 由图6可以看出,优化后的Faster R-CNN模型的整体损失随着迭代次数的增加而不断下降,在40000次迭代后损失值降至0.096,并且在之后的训练中损失基本稳定在0.1左右,模型基本收敛表明优化后的模型训练效果良好。 2.2 训练结果对比分析 为更加全面地评价分析优化后的Faster R-CNN对蔗田杂草目标识别的可靠性,采用目标检测常用评价指标(AP,AP50,AP75,APs,APm,APl)比较三种算法对模型性能的影响,如表3所示。 从表3可以看出,在原始模型的基础上使用BFP、DLA、Soft-NMS三种优化策略进行优化时,模型性能均得到一定提升,与原始Faster R-CNN模型相比,三种优化策略单独使用时杂草目标检测的平均精度AP(Average-Precision)分别提高了4.0%、2.8%、3.9%,这表明,三种优化策略均能在一定程度上促进原模型性能。而在同时使用三种优化策略,也就是本文所使用方法时,平均精度AP达到最高,比原始模型高出4.9个百分点,且在AP50、APs、APl指标上分别有6.5%、4.7%、5.1%的提高,可见优化后模型不仅提高了对中、大目标杂草的识别准确性,而且对小目标杂草的检测精度也有一定提升。 2.3 测试结果对比分析 优化模型训练完成后,对测试集杂草图像进行检测,采用平均召回率AR(Average Recall),AP和均值平均精度mAP(Mean Average Precious)作为评价指标。当IoU=0.75时,单类检测结果如表4所示。 AR值表示正样本的查全率,AP值表示正样本的查准率。结果显示,除了马唐和牵牛-2以外,优化后模型的单类别平均召回率和平均精度都有提升,数值均能达到80%以上,且均值平均精度mAP提高了6.2%。在7种杂草中马唐的AR值和AP值最低,结合实际情况进行分析,其主要原因可能有:一马唐生长紧贴地面,且成伞状展开,目标尺寸大,地面背景占比多;二蔗田存在大量其他种类杂草,大多数杂草均高于马唐,极易造成马唐遮挡从而未被识别;三田间背景环境复杂多样,甘蔗秸秆较多,马唐植株相对过小,易因遮挡而未被检测。除此之外,牵牛-2的AR值和AP值也较低,仅高于马唐,分析得其原因可能为:一牵牛属藤蔓型杂草,多缠绕于甘蔗植株上,形状位置各异,不利于检测识别;二甘蔗伸长期时叶片比幼苗期大,甘蔗和牵牛叶片之间交错,易造成遮挡导致牵牛的错检和漏检;三甘蔗伸长期时甘蔗株间叶片交叠,或密或疏,数据采集明暗条件无法保持一致,对牵牛的检测产生一定影响;四甘蔗伸长期蔗田环境复杂,背景为错乱的甘蔗叶片和蔗节,不利于牵牛的检测识别。如图7所示,图中黄色曲线标出了未检测出的马唐和牵牛-2。 除此之外,为了比较模型的实时性与应用性,采用模型训练时间以及测试图像平均测试时间对优化前后模型进行对比分析,结果如表5所示。 平均测试时间=测试运行时间测试的图片总数(7) 从表5可以看出,优化后模型训练时间略有增加,最主要的原因就是本文所用方法是基于Faster R-CNN模型的二阶段目标检测算法,其基本网络框架没有改变,增加了3种优化策略,模型整体框架较原模型更大,所以训练时间增加,而平均测试时间与原模型基本持平,加之优化后模型性能更优,说明本文方法具有一定的适用性。 2.4 与其他模型的性能比较 除此之外,为了更加客观地评价模型的性能,采用两种经典目标检测算法SSD、RetinaNet和优化后的模型进行对比试验。为了保证对比试验的有效性,3种方法均使用本文自制数据集在mmdetection开源框架进行模型的训练和测试,学习率统一设置为0.0025,使用SGD优化器,最大迭代次数112000次。当IoU=0.5时,3种方法的P-R(Precision-Recall)曲线如图8所示。 在P-R曲线图中,AR反映了分类器对正样本的覆盖能力,AP是对P-R曲线的积分,其值越大,表示模型检测效果越好。从图8可以看出,与其他模型相比,本文优化后的网络模型P-R曲线的积分值最大,说明本文方法优于前两者,在杂草目标检测中性能较好。 2.5 杂草目标检测结果 为了更加直观地看出模型优化前后在复杂背景环境下杂草目标检测的效果之差,从测试集中随机抽取7张图像在相同的试验条件下进行测试,如图9所示。 图9中每组对比图中左列为原始模型的检测结果,右列为优化后的模型检测结果,最后一组检测图像是通过mosaic数据增强形成。从图9中发现,优化后的模型相较于原始模型,降低了自然背景环境下杂草目标的漏检率,即杂草真检率提高,并且在一定程度上提高了总体检测精度。 3 结论 1) 本文提出一种基于Faster R-CNN改进的蔗田杂草检测算法。采用均衡特征金字塔增强各级语义特征,加强图像深层特征提取;为了缓解小数据集训练样本不足的问题,使用动态标签分配策略(DLA)取代传统标签分配方法;此外,软非极大抑制Soft-NMS代替传统的NMS,能在一定程度上减少自然环境下同类密集杂草的错检和漏检,在优化后的模型算法在自制数据集上进行训练和测试验证,通过与经典目标检测算法SSD和RetinaNet进行纵向对比试验,以及模型优化前后检测结果横向对比,验证了本文模型对于蔗田杂草识别的准确性和稳定性,同时减少了蔗田杂草错检和漏检现象。 2) 改进后的Faster R-CNN模型与原模型算法相比,均值平均精度提升6.2%,mAP值达81.3%,在AP50、APs、APl指标上分别有6.5%、4.7%、5.1%的提高,满足在复杂背景环境下的检测需求,为自然环境下的蔗田杂草目标检测提供了理论依据,同时也为后续蔗田自动除草机构的识别模块研究提供了理论保障。 3) 改进后的Faster R-CNN模型平均每幅图像测试耗时0.132s,与原模型算法平均测试时间相当,这可能是因为优化后的模型仍然属于二阶段目标检测算法,检测速度慢,模型框架较大,不方便小型处理器的搭载,未来可以在轻量化模型方面进一步研究,以达到实时检测的目标。 参 考 文 献 [1]谢金兰, 吴建明, 黄杏, 等. 我国甘蔗新品种(系)的抗旱性研究[J]. 江苏农业科学, 2015, 43(3): 108-112. [2]黄基杰. 甘蔗地快速识别的样本库建设——以广西崇左为例[J]. 南方国土资源, 2019(4): 45-47. [3]张乐, 金秀, 傅雷扬, 等. 基于Faster R-CNN深度网络的油菜田间杂草识别方法[J]. 激光与光电子学进展, 2020, 57(2): 304-312. Zhang Le, Jin Xiu, Fu Leiyang, et al. Recognition method for weeds in rapeseed field based on faster R-CNN deep network [J]. Laser & Optoelectronics Progress, 2020, 57(2): 304-312. [4]孙俊, 谭文军, 武小红, 等. 多通道深度可分离卷积模型实时识别复杂背景下甜菜与杂草[J]. 农业工程学报, 2019, 35(12): 184-190. Sun Jun, Tan Wenjun, Wu Xiaohong, et al. Real-time recognition of sugar beet and weeds in complex backgrounds using multi-channel depth-wise separable convolution model [J]. Transactions of the Chinese Society of Agricultural Engineering, 2019, 35(12): 184-190. [5]赵辉, 曹宇航, 岳有军, 等. 基于改进DenseNet的田间杂草识别[J]. 农业工程学报, 2021, 37(18): 136-142. Zhao Hui, Cao Yuhang, Yue Youjun, et al. Field weed recognition based on improved DenseNet [J]. Transactions of the Chinese Society of Agricultural Engineering, 2021, 37(18): 136-142. [6]毛文华, 王辉, 赵博, 等. 基于株心颜色的玉米田间杂草识别方法[J]. 农业工程学报, 2009, 25(S2): 161-164. Mao Wenhua, Wang Hui, Zhao Bo, et al. Weed detection method based the center color of corn seedling [J]. Transactions of the Chinese Society of Agricultural Engineering, 2009, 25(S2): 161-164. [7]谈蓉蓉, 朱伟兴. 基于图像处理技术的杂草特征提取方法研究[J]. 传感器与微系统, 2009, 28(2): 56-59, 65. Tan Rongrong, Zhu Weixing. Research of weed feature extraction method based on image processing technology [J]. Transducer and Microsystem Technologies, 2009, 28(2): 56-59, 65. [8]曹晶晶, 王一鸣, 毛文华, 等. 基于纹理和位置特征的麦田杂草识别方法[J]. 农业机械学报, 2007(4): 107-110. Cao Jingjing, Wang Yiming, Mao Wenhua, et al. Weed detection method in wheat field based on texture and position features [J]. Transactions of the Chinese Society for Agricultural Machinery, 2007(4): 107-110. [9]李向辉. 基于卷积神经网络的甘蔗切种机茎节特征识别系统[D]. 南宁: 广西民族大学, 2020. Li Xianghui. A feature recognition system for sugarcane seed cutter based on convolutional neural network [D]. Nanning: Guangxi University for Nationalities, 2020. [10]孙哲, 张春龙, 葛鲁镇, 等. 基于Faster R-CNN的田间西兰花幼苗图像检测方法[J]. 农业机械学报, 2019, 50(7): 216-221. Sun Zhe, Zhang Chunlong, Ge Luzhen, et al. Image detection method for broccoli seedlings in field based on faster R-CNN [J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(7): 216-221. [11]朱永宁, 周望, 杨洋, 等. 基于Faster R-CNN的枸杞开花期与果实成熟期识别技术[J]. 中国农业气象, 2020, 41(10): 668-677. Zhu Yongning, Zhou Wang, Yang Yang, et al. Automatic identification technology of lycium barbarum flowering period and fruit ripening period based on Faster R-CNN [J]. Chinese Journal of Agro meteorology, 2020, 41(10): 668-677. [12]李就好, 林乐坚, 田凯, 等. 改进Faster R-CNN的田间苦瓜叶部病害检测[J]. 农业工程学报, 2020, 36(12): 179-185. Li Jiuhao, Lin Lejian, Tian Kai, et al. Detection of leaf diseases of balsam pear in the field based on improved Faster R-CNN [J]. Transactions of the Chinese Society of Agricultural Engineering, 2020, 36(12): 179-185. [13]樊湘鹏, 周建平, 许燕, 等. 基于优化Faster R-CNN的棉花苗期杂草识别与定位[J]. 农业机械学报, 2021, 52(5): 26-34. Fan Xiangpeng, Zhou Jianping, Xu Yan, et al. Identification and localization of weeds based on optimized Faster R-CNN in cotton seedling stage [J]. Transactions of the Chinese Society for Agricultural Machinery, 2021, 52(5): 26-34. [14]金小俊, 孙艳霞, 于佳琳, 等. 基于深度学习与图像处理的蔬菜苗期杂草识别方法[J]. 吉林大学学报(工学版), 2023, 53(8): 2421-2429. Jin Xiaojun, Sun Yanxia, Yu Jialin, et al. Weed recognition in vegetable at seedling stage based on deep learning and image processing [J]. Journal of Jilin University (Engineering and Technology Edition), 2023, 53(8):2421-2429. [15]尚文卿, 齐红波. 基于改进Faster R-CNN与迁移学习的农田杂草识别算法[J]. 中国农机化学报, 2022, 43(10): 176-182. Shang Wenqing, Qi Hongbo. Identification algorithm of field weeds based on improved Faster R-CNN and transfer learning [J]. Journal of Chinese Agricultural Mechanization, 2022, 43(10): 176-182. [16]易佳昕, 张荣华, 刘长征, 等. 基于低空无人机影像和改进Faster R-CNN的棉田杂草识别方法[J]. 石河子大学学报(自然科学版), 2022, 40(4): 520-528. Yi Jiaxin, Zhang Ronghua, Liu Changzheng, et al. Weed detection method in cotton field based on low altitude UAV image and improved Faster R-CNN [J]. Journal of Shihezi University (Natural Science), 2022, 40(4): 520-528. [17]彭明霞, 夏俊芳, 彭辉. 融合FPN的Faster R-CNN复杂背景下棉田杂草高效识别方法[J]. 农业工程学报, 2019, 35(20): 202-209. Peng Mingxia, Xia Junfang, Peng Hui, et al. Efficient recognition of cotton and weed in field based on Faster R-CNN by integrating FPN [J]. Transactions of the Chinese Society of Agricultural Engineering, 2019, 35(20): 202-209. [18]孟庆宽, 张漫, 杨晓霞, 等. 基于轻量卷积结合特征信息融合的玉米幼苗与杂草识别[J]. 农业机械学报, 2020, 51(12): 238-245, 303. Meng Qingkuan, Zhang Man, Yang Xiaoxia, et al. Recognition of maize seedling and weed based on light weight convolution and feature fusion [J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(12): 238-245, 303. [19]李春明, 逯杉婷, 远松灵, 等. 基于Faster R-CNN的除草机器人杂草识别算法[J]. 中国农机化学报, 2019, 40(12): 171-176. Li Chunming, Lu Shanting, Yuan Songling, et al. Weed identification algorithm of weeding robot based on Faster R-CNN[J]. Journal of Chinese Agricultural Mechanization, 2019, 40(12): 171-176. [20]孙腾飞. 白菜田的杂草识别研究[D]. 昆明:昆明理工大学, 2019. Sun Tengfei. Study on weed identification in cabbage field [D]. Kunming:Kunming University of Science and Technology, 2019. [21]韦保特. 甘蔗新品种桂糖42号在百色市的种植表现及高产栽培技术[J]. 现代农业科技, 2016(12): 101, 105. [22]Ren Shaoqing. Faster R-CNN: Towards real-time object detection with region proposal networks [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149. [23]Pang J, Chen K, Shi J, et al. Libra R-CNN: Towards balanced learning for object detection [C]. Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2019: 821-830. [24]Zhang H, Chang H, Ma B, et al. Dynamic R-CNN: Towards high quality object detection via dynamic training [C]. Computer Vision-ECCV 2020: 16th European Conference, Glasgow, 2020: 260-275. [25]Bodla N, Singh B, Chellappa R, et al. Soft-NMS-improving object detection with one line of code [C]. Proceedings of the IEEE International Conference on Computer Vision, 2017: 5561-5569.