基于深度学习的鱼类特征点检测与体征识别方法

2024-06-17崔海朋秦朝旭马志宇

崔海朋 秦朝旭 马志宇

摘要:为确保鱼类养殖过程中生长状况实时监控及科学化养殖管理,需要实现高效化、自动化的鱼类体征识别。基于此,提出基于深度学习的关键特征点检测模型结合双目视觉的鱼类体征识别方法。基于预处理后的单目视觉数据集对融入金字塔分割注意力的高分辨率网络模型展开训练,获得鱼类关键特征点检测模型,在此基础上能够对双目视觉图像中各特征点进行快速检测识别与匹配,从而根据双目视觉系统内部参数计算各特征点真实坐标并计算获得对应体征参数。试验结果表明,建立的关键特征点检测模型对各特征点PCK值均大于0.85,识别得到的体征参数相对误差均小于10%,能够为鱼类体征快速准确识别提供支撑,有效助力鱼类养殖科学化、智能化发展。

关键词:鱼类;水产养殖;深度学习;关键点检测;体征识别

中图分类号:S24; S951.2

文献标识码:A

文章编号:2095-5553 (2024) 06-0201-07

收稿日期:2022年9月26日

修回日期:2023年2月20日

*基金项目:山东省重点研发计划(科技示范工程)(2021SFGC0701)

第一作者:崔海朋,男,1982年生,山东东营人,硕士,高级工程师;研究方向为深海养殖智能化系统与装备。E-mail: chp1982@126.com

Fish key feature point detection and sign identification based on deep learning

Cui Haipeng, Qin Chaoxu, Ma Zhiyu

(Qingdao JARI Industrial Control Technology Co., Ltd., Qingdao, 266520, China)

Abstract: In order to ensure real-time monitoring of growth conditions and scientific breeding management in the process of fish farming, it is necessary to realize efficient and automatic fish sign recognition. Based on this, a fish sign recognition method based on deep learning key feature point detection model combined with binocular vision is proposed. Based on the preprocessed monocular vision data set, the high-resolution network model integrated into the pyramid segmentation attention is trained to obtain the fish key feature point detection model. On this basis, the binocular vision image can be rapidly detected, recognized and matched with each feature point, and the real coordinates of each feature point and corresponding physical parameters can be calculated according to the internal parameters of the binocular vision system The test results show that the PCK value of the established key feature point detection model for each feature point is greater than 0.85, and the relative error of the identified sign parameters is less than 10%, which can provide support for the rapid identification of fish signs and effectively help the scientific and intelligent development of fish farming.

Keywords: fish; aquaculture; deep learning; key point detection; signs identification

0 引言

渔业是我国农业领域的重要组成部分,随着水产领域的飞速发展,渔业当前已在我国经济中占据了相当一部分比重。在水产养殖中,为指导鱼类选育、养殖投喂管理等工作合理高效进行,往往需要实现鱼类体长、全长、体高等体征参数变化的自动化监测,因此如何精准快速地对养殖鱼类体征进行识别是亟待解决的重要问题。

近年来,深度学习与人工智能技术飞速发展,应用广泛的计算机视觉技术也为鱼类体征有效识别问题提供新的实现思路与方法。目前计算机视觉在水产养殖领域常见的应用包括鱼类目标检测、鱼类图像分类、鱼类图像分割等多个场景[1-3]。Yu等[4]提出一种基于Mask R-CNN的鱼类形态特征分割方法,可以实现鱼类形态特征的自动、准确和批量高效的鱼类图像分割。丁顺荣等[5]采用多特征融合及粒子群优化SVM,构建一种新的鱼类识别方法,能够达到94.7%的准确率。Mathias等[6]提出基于二维经验模态分解和高斯混合模型的水下场景鱼类目标检测方法,能够达到良好的检测效率与效果。针对鱼类体征识别,要实现养殖过程中鱼类体长等体征参数自动化的识别与检测,需要对鱼类头部、身体、尾部各个关键特征点进行准确识别,以进一步测量、计算各个体征参数,与计算机视觉领域中关键点识别问题相一致。目前在人体姿态识别、人类面部识别等领域已经有许多有效的关键特征点检测算法投入应用,并取得优异的效果[7, 8]。

为识别测量鱼类在真实空间中的绝对体征参数,许多研究采用了水下双目视觉系统[9-11]。针对鱼类的体征测量,Shi等[12]通过基于LabVIEW的水下立体系统实现了鱼长自动估计,能够以较高的准确率和成功率估计鱼的长度。李艳君等[13]通过双目立体视觉技术获取三维信息,能够有效实现鱼类体长的估测。通过双目视觉图像准确获取鱼类体征参数首先需要确保实现左右图像特征点的精准匹配,而要满足在养殖过程中快速地针对大量鱼类的关键特征点进行确定并匹配的需求,可以结合深度学习方法来实现自动化的识别。

将双目视觉图像与深度学习方法结合起来,根据采集到的双目视觉图像,利用深度学习模型建立鱼类关键特征点检测模型,能够快速实现双目视觉图像中鱼类各个关键特征点识别与匹配,以获得目标鱼类的体长、体高等体征参数。但在实际应用中,训练深度学习模型往往需要大量已有的图像数据[14]。而在鱼类养殖前期往往难以实际取得满足训练条件的规模的双目图像数据,且公开的已知相机内参的鱼类双目视觉图像数据极少,无法满足现在深度学习模型训练的需求。

因此,本文提出结合单目视觉图像构建的双目视觉图像识别鱼类体征参数的流程方法:首先建立获得鱼类图像关键特征点检测深度学习模型,检测识别得到各图像中头部最前端、尾鳍末端等各个关键特征点;随后在实际应用中针对采集到的双目视觉图像,利用训练后的深度学习模型检测两张图像中各个特征点并进行匹配;最后利用双目摄影系统内部参数计算识别目标体征参数,以实现鱼类体征的快速化、自动化识别。

1 材料与方法

1.1 图像数据获取与处理

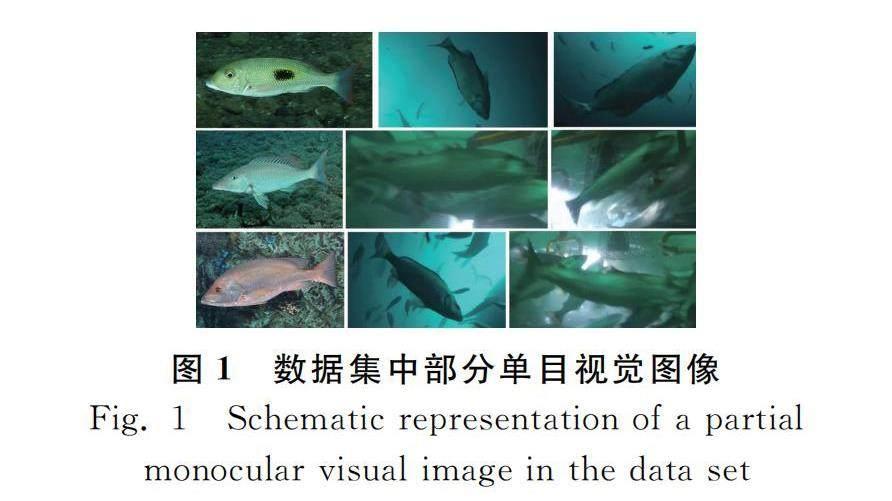

本文中所采用的图像数据包含两部分,分别包括进行关键特征点检测深度学习模型训练的单目视觉数据,以及用于对模型进行检验与校正的双目视觉数据,部分图像数据如图1所示。其中所采用的单目视觉数据来自互联网收集的不同环境下不同种类的鱼类图片,以使得建立的关键特征点检测模型具有对于不同种类养殖鱼类的适应能力。单目视觉图像由4 080张图像组成,包含了85种不同种类的鱼类,且这些图像分别来源于实际深海养殖网箱场景、小型的养殖水缸场景与离水场景等多种不同的拍摄场景。

另一部分双目视觉图像主要来源于已有的试验环境下通过双目摄像系统实际采集的鱼类图像,部分来源于互联网收集,共计包含30组图像,每组图像包含两张对应不同视觉的图像,因此数据集中共包含60张图像。由于图像数量较少,难以满足直接训练深度学习模型的需求,若通过常规的旋转、裁切等增加数据样本数量的增强方法,可能会导致训练后的网络模型产生过拟合现象,无法满足实际养殖过程中复杂情况下的鱼类体征识别。因此,在本文中,收集单目视觉图像用于建立关键特征点深度学习模型并进行训练,随后双目视觉图像则用于对模型识别的关键特征点进行匹配并变换计算鱼的体征参数。

获取图像数据后,首先需要对图像数据进行一定的预处理工作,以提高模型训练与后续识别的效果[15]。如图1所示,原始图片中,不同来源的图片一般具有不同的尺寸,因此首先需要对原始图片尺寸进行一定的处理。本文中所有图像均固定为4∶3的比例,像素尺寸对应均固定为640×480,对于部分尺寸接近固定值的图像,在保持鱼体完整的前提下可通过对图像进行适当裁剪处理。对于尺寸相差较大的图像,则首先按照原始比例对图像进行缩放,当图像高度或宽度其中一个维度的尺寸与固定尺寸相同时,对另一个维度进行黑边补齐处理,使得最终所有图像在不对比例进行拉伸的前提下保持相同的尺寸,图1中部分图像处理前后对比如图2所示。

1.2 图像数据标注

在利用图像数据进行模型训练之前,需要对每张图像进行标注工作。对于本文所要构建的关键特征点检测模型,每张图像中需要标注出各个关键特征点的坐标位置。本文选取的体征识别目标包括鱼类的体长、全长、体高、头长以及尾鳍长等5个不同的参数,各体征参数具体的含义见表1。为根据双目视觉图像确定各个体征参数,需要通过关键特征点检测网络识别出各个体征参数起止测量点的位置,即本文中需要人为在训练数据中进行标注的关键特征点。

为达成上述识别目标,在每张图像中针对6个不同的关键特征点进行了标注,分别包括头部最前端、鳃盖后缘、尾鳍基部、尾鳍末端、腹部最低点以及背部最高端,具体标注效果如图3所示。对于所有关键特征点均可见的图像,针对每一个特征点均标注其在图像中的坐标(以像素坐标形式表示),而对于部分图像,可能存在由于鱼的姿势或拍摄角度等原因导致的个别特征点被遮挡或在画面外的问题,使得该部分特征点在当前图像中无法标注。因此,针对这一部分特征点,将其坐标标注为(0, 0),以表示该图像中不包含该特征点,同时确保每个识别目标图像均具有相同数量的关键特征点。标注过程通过开源的图像标注软件实现,每张图像均按照通用的数据结构生成标注文件[16]。标注文件中包含的信息包括图像的编号、尺寸,关键点的数量,以及各个关键点的坐标,通过关键点的顺序编号区分各个关键点所对应的类型。

1.3 试验设计

本文建立的鱼类体征识别方法基本流程如图4所示,主要包含3个主要步骤:首先利用标注及预处理后的单目视觉图像数据集对特征点检测算法模型进行训练,获得鱼类关键特征点检测网络模型;随后利用关键特征点检测网络模型分别对每一张双目视觉图像中鱼类的关键特征点进行识别;最后对每一组双目视觉图像两张图像识别出的关键特征点进行立体匹配,并根据双目视觉系统内参计算得到鱼类体征参数。

1.4 试验环境

本文建立的鱼类体征识别方法试验的系统环境为AMD R7 5800H @ 3.6GHz处理器,16 GB内存,显存为6 GB的RTX 3060 Laptop显卡和Windows 11操作系统。软件及算法实现方面,鱼类关键特征点检测模型的实现及体征参数计算算法的建立均基于python编程语言,检测网络基于Pytorch深度学习框架构建。

2 特征点检测算法与体征识别方法

2.1 关键特征点检测算法

本文选用的鱼类关键特征点检测算法为高分辨率网络(High Resolution Net, HRNet)模型,目前HRNet在关键点检测领域的广泛应用已充分表明了其优异效果[17, 18]。HRNet是一类具有广泛应用场景的深度卷积神经网络,其最大的特征是能够有效融合不同分辨率尺度下图像的特征,使得每个分辨率尺度的特征都能够更加广泛地包含来自其他尺度的特征信息,同时还能并行地保留原始尺度特征信息,来确保最终输出的精确性。在HRNet的基础上,进一步融入金字塔分割注意力(Pyramid Split Attention, PSA)机制模块,以进一步提取多尺度特征图空间信息,来实现跨维度通道注意力重要特征的交互[19]。

HRNet的基本结构如图5所示,与常规的高低分辨率特征之间的串行结构不同,HRNet采用了并行的特征图连接结构。整个网络结构被划分为了4个阶段,其中第1个阶段中首先针对输入的原始图像进行卷积处理获取其特征图像,在第1阶段内特征图像分辨率维持不变,随后在第1阶段后进行特征转换,对原始特征图像进行一次下采样生成低分辨率特征图像,并将原始特征与低分辨率特征图像保持并行。在第2阶段,高低分辨率特征图像之间进行不同尺度特征的融合,低分辨率特征图像经上采样操作后与原始特征图像相连接,作为新的原始分辨率特征图像,而原始特征图像经再次下采样后与低分辨率特征图像连接作为新的低分辨率特征图像。随后在第3阶段后对低分辨率图像进行进一步的下采样操作获得更低一级的低分辨率图像,并进行三种不同分辨率下特征图像的融合,最后在第4阶段进行相似的操作,将三种不同分辨率下的特征图像信息进行融合,获得原始分辨率下的特征图像输出,再次经卷积操作后输出获得关键特征点识别结果。

关键点检测方法中,获得最终检测结果的方式包括两种,分别为回归关键点的具体坐标值以及输出关键点分布的概率热力图[17]。直接回归关键点坐标可以在网络模型末端增加全连接层输出对应的坐标值,但这种方式通常收敛比较困难。输出概率热力图的方式是指直接以特征图像作为结果输出,图像中每个像素点的值为该关键点位于当前像素位置的概率,从而寻找概率最高的位置判断关键点坐标。本文中HRNet采用的输出热力图的方式,在HRNet末端输出高分辨率的特征图像后,经过一个包含6个大小为1×1的卷积核的卷积层输出每个关键点的概率热力图,其中卷积核个数对应确定的需要检测的关键点的个数。

HRNet结构中最为关键的部分是对特征图像进行的上采样以及下采样操作,实现上下采样的具体操作如图6所示。其中上采样首先需要通过卷积核大小为1×1、步长为1的卷积层,随后经批量归一化层处理后采用最近邻方法进行n倍的上采样操作。下采样则是通过卷积核大小为3×3,步长为2的卷积层进行缩放1倍下采样,随后再经批量归一化层进行处理,当需要多倍缩放时,则需要重复通过卷积层处理进行多次下采样。

在HRNet的基础上,本文进一步引入了PSA机制模块,PSA模块是一类高效、轻量的通道注意力机制模块,能够更细粒度地处理多尺度的输入特征图的空间信息,并建立多尺度通道注意力间的长期依赖关系[19]。PSA模块基本结构如图7所示,其首先利用通道划分模块对原始特征图像进行通道划分,其中通道划分模块会将原始通道划分为多组,并针对每组通道特征进行不同尺度的卷积操作,以根据每组通道的空间特征信息进行多尺度的特征提取;随后采用SE权重模块提取不同尺度特征图的通道注意力权重,并对获得的多尺度通道注意力权重利用softmax进行重新标定;最后对重新标定后的注意力权重与多尺度特征图像进行点乘操作,获得提取多尺度特征信息后的特征图像。

为将PSA模块嵌入基础的HRNet结构中,将不同阶段之间传递特征图像信息的卷积过程替换为PSA模块的多尺度注意力提取过程,将原始特征图像转换为获取了多尺度通道注意力的特征图像,以提高原始模型对于空间及通道全局特征的提取能力。

2.2 双目视觉体征识别方法

基于双目视觉图像,通过对图像中各个关键特征点进行匹配,确定各个关键点的视差,即可根据视差与双目视觉系统基线长度计算各个关键点的真实坐标,从而计算鱼类体长等体征参数。

双目视觉实现体征识别原理如图8所示,将左右两个摄像机组成双目视觉系统,随后对摄像机进行标定及校正,使得左右摄像机位于同一水平面对齐并确定基线长度,进一步获得焦距等相机内参[20]。

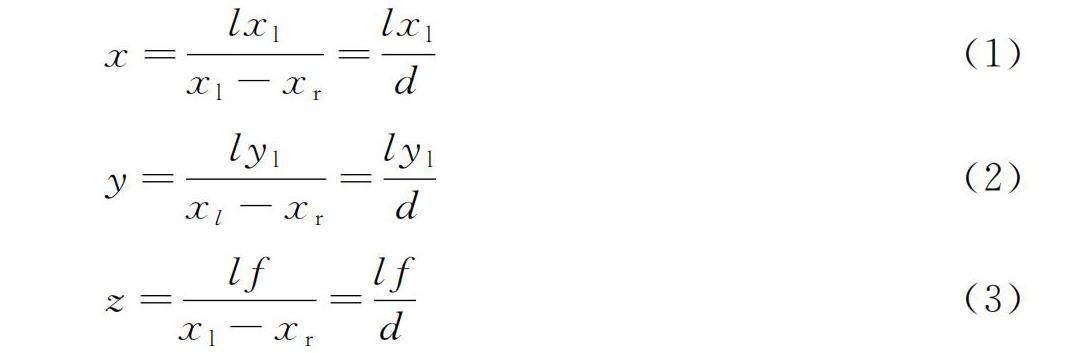

对于双目视觉系统中真实坐标为(x,y,z)的物点P,经拍摄后可分别在焦距为f的左右成像平面上获得其对应的左右像点,其在左右成像面上投影的坐标分别为(xl,yl)以及(xr,yr),由于双目视觉系统经标定后位于同一水平面,则有yl=yr。因此,根据相似三角形及透视变换处理,可以获得物点真实空间三维坐标,如式(1)~式(3)所示。

x=lxlxl-xr=lxld(1)

y=lylxl-xr=lyld(2)

z=lfxl-xr=lfd(3)

式中:d——物点在左右成像平面上成像点之间的视差,d=xl-xr。

基于上述双目视觉系统中物点三维坐标计算公式,结合鱼类关键特征点检测模型,可以快速对双目图像中鱼类各个体征测量的关键点进行识别并匹配,从而获取每个关键点的视差值,进而计算得到其对应的三维坐标,实现对鱼类体长等各个体征参数的识别计算。

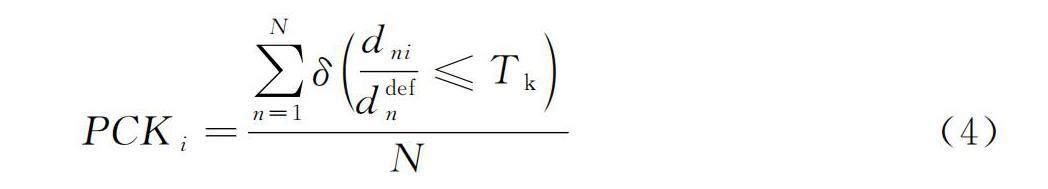

2.3 效果评价标准

针对建立的鱼类体征识别方法效果的评价,可以从鱼类关键特征点检测与体征参数识别的准确性两个方面展开评价。针对鱼类关键特征点检测算法,采用常用的指标正确识别关键点比例(Percentage of Correct Keypoints,PCK)来评价算法的效果[21]。PCK是指目标关键点被识别正确的比例,具体含义为检测出的关键点距离真实关键点之间的归一化距离小于设定阈值的比例,其计算如式(4)所示。

PCKi=∑Nn=1δdniddefn≤TkN(4)

式中:n——当前鱼类图像;

N——需要进行效果评价的鱼类图像总数;

dni——第n张图像的第i个关键点检测坐标与真实坐标之间的欧氏距离;

ddefn——第n张图像计算归一化距离时选用的标定距离;

δ——第i个关键点的归一化因子;

Tk——设定的阈值。

在本文中,ddefn表示采用头部最前端与鳃盖后缘真实坐标之间的欧式距离;Tk设定为0.1,即检测关键点与真实关键点之间的距离不大于目标鱼类头部长度的1/10视为识别有效关键点。

针对鱼类体征识别结果的准确性,采用计算得到的各个体征参数与真实体征参数之间的平均相对误差MRE以及均方根误差RMSE作为评价指标进行效果评价,计算如式(5)、式(6)所示。

MREi=1N∑Nn=1yni-yni-yni(5)

RMSEi=1N∑Nn=1(yni-yni-)2(6)

式中:yni——第n张图像中第i个体征参数的真实值;

yni-——第n张图像中第i个体征参数的估计值。

3 结果与分析

为验证分析建立的鱼类体征识别方法的效果,分别从鱼类关键特征点检测效果以及体征参数计算效果两个层面进行了评价分析。

3.1 鱼类关键特征点检测效果

针对建立的鱼类关键特征点检测模型,首先将单目视觉数据集按照8∶2的比例随机划分为训练集与测试集,并采用训练集对检测模型进行训练,训练过程中采用Adam优化器,共迭代训练160代,随后分别利用单目视觉测试集以及双目视觉全部数据集对模型进行效果评价,计算各个关键点检测的PCK值并进行对比。为进一步验证建立的检测算法的有效性,利用相同的数据集训练了未耦合PSA模块的原始HRNet模型以及支持向量机回归(Support Vector Regression, SVR)模型,对其检测效果进行对比,其中SVR的检测结果输出方式为直接回归关键特征点坐标值。首先选取部分图像对PSA-HRNet检测出的关键点坐标与实际标注关键点坐标进行对比,其在图像中的标注位置对比如图9所示。

由图9可见,建立的关键点检测算法能够有效确定大多数关键特征点的坐标位置,检测坐标与实际坐标非常接近,说明建立的检测算法能够有效识别出鱼类体征识别的各个关键特征点。

进一步从定量的角度综合评价对比检测模型的效果,分别计算获得了PSA-HRNet模型、HRNet模型以及SVR模型对于单目视觉测试集以及双目视觉数据集各个关键特征点的PCK值,结果如表2所示。由表2可知,与其余模型相比,PSA-HRNet对于所有关键特征点均具有更大的PCK值,单目与双目视觉图像平均PCK值相比较于另外两种方法分别高5.29%、22.61%与1.99%、25.96%,说明PSA-HRNet通过引入多尺度通道特征注意力的机制能够更充分地提取表征关键特征点位置的特征,从而有效提升检测结果。并且PSA-HRNet模型所有关键特征点的PCK值均大于0.85,表明建立的关键特征点检测算法的有效性,为进一步体征参数的计算提供有效支撑。同时,头部最前端与尾鳍末端相比较于其余特征点PCK值更高,其原因是相比较于其余关键特征点这两个特征点部位相对更加明确,在人工标注时产生的误差更小,使得识别得到的准确性更高。

3.2 鱼类体征识别效果

根据关键特征点检测结果,对双目视觉数据集图像识别出的各个关键特征点进行匹配,根据双目视觉系统参数计算各关键特征点左右视觉图像中的视差,以此获取各个关键特征点的真实三维坐标,并在此基础上计算各个体征参数的值。针对双目视觉数据集,分别计算了根据关键特征点检测结果计算出的体征参数与实际参数之间的MRE及RMSE,如表3所示。由对比结果可见,对于各个体征参数,其平均相对误差均小于10%,均方根误差最大仅为1.34cm,进一步证明了建立的体征识别方法的有效性。

同时,图10与图11分别展示了各个图像样本每个体征参数识别相对误差总体分布情况与分布直方图,30组双目视觉图像共包含150个体征参数样本。图10中绝大多数样本点集中分布在表征误差为10%的虚线内部,证明了识别方法的可靠性。而在整体分布特征上,由图11可知,相对误差分布整体呈现正态分布特征,大多数体征的相对误差在5%以内,只有极小部分体征参数由于受到拍摄角度、标注误差等限制,最终识别结果的相对误差超过了15%。以上鱼类体征识别的结果对比,综合表明了本文建立的鱼类体征识别方法的有效性。

4 结论

本文基于单目视觉图像构建鱼类关键特征点检测模型,在此基础上实现对双目视觉图像关键特征点的检测及匹配,以计算获得鱼类体长、全长的体征参数,形成了快速、准确的鱼类体征识别方法。

1) 采集不同环境下鱼类单目视觉图像及双目视觉图像,并对图像进行预处理及标注工作,形成鱼类关键特征点单目及双目视觉数据集,并基于单目视觉数据集构建训练获得考虑多尺度特征图像通道注意力地PSA-HRNet深度学习模型,获得的模型针对单目视觉测试集及双目视觉图像数据集均获得了优异的检测结果,各个关键特征点检测PCK值均大于0.85。

2) 基于建立的鱼类图像关键特征点检测模型,通过对双目视觉图像分别进行检测,实现了左右视觉图像中关键特征点的检测及匹配,并根据双目视觉系统参数计算获得了各关键特征点真实坐标,在此基础上实现了对鱼类各个体征参数的计算,各个体征参数识别结果相对误差均小于10%,RMSE最高仅为1.34 cm,表明本文提出的鱼类体征识别方法具有出色的精度,能够为鱼类高效、科学养殖提供有力支撑。

参 考 文 献

[1]Zhao Z, Liu Y, Sun X, et al. Composited FishNet: Fish detection and species recognition from low-quality underwater videos [J]. IEEE Transactions on Image Processing, 2021, 30: 4719-4734.

[2]陈文辉, 蔡妹姝, 严松, 等. 基于深度卷积神经网络与迁移学习的鱼类分类识别[J]. 福建师大福清分校学报, 2019(5): 30-38.

Chen Wenhui, Cai Meishu, Yan Song, et al. Fish classification based on deep convolutional neural network and transfer learning [J]. Journal of Fuqing Branch of Fujian Normal University, 2019(5): 30-38.

[3]蔡卫明, 庞海通, 张一涛, 等. 基于卷积神经网络的养殖鱼类品种识别模型[J]. 水产学报, 2022, 46(8): 1369-1376.

Cai Weiming, Pang Haitong, Zhang Yitao, et al. Recognition model of farmed fish species based on convolutional neural network [J]. Journal of Fisheries of China, 2022, 46(8): 1369-1376.

[4]Yu C, Fan X, Hu Z, et al. Segmentation and measurement scheme for fish morphological features based on Mask R-CNN [J]. Information Processing in Agriculture, 2020, 7(4): 523-534.

[5]丁顺荣, 肖珂. 基于粒子群优化SVM和多特征融合的鱼类分类方法研究[J]. 中国农机化学报, 2020, 41(11): 113-118, 170.

Ding Shunrong, Xiao Ke. Improving fish classification method in particle swarm optimization SVM and multi-feature fusion [J].Journal of Chinese Agricultural Mechanization, 2022, 41(11): 113-118, 170.

[6]Mathias A, Dhanalakshmi S, Kumar R, et al. Underwater object detection based on Bi-dimensional empirical mode decomposition and Gaussian Mixture Model approach [J]. Ecological Informatics, 2021, 66: 101469.

[7]Zhang J, Chen Z, Tao D. Towards high performance human keypoint detection [J]. International Journal of Computer Vision, 2021, 129(9): 2639-2662.

[8]曾文献, 马月, 李伟光. 轻量化二维人体骨骼关键点检测算法综述[J]. 科学技术与工程, 2022, 22(16): 6377-6392.

Zeng Wenxian, Ma Yue, Li Weiguang. A survey of lightweight two-dimensional human skeleton key point detection algorithms [J]. Science Technology and Engineering, 2022, 22(16): 6377-6392.

[9]赵建敏, 关晓鹏. 基于双目深度估计的牛体尺测量方法设计[J]. 光电子·激光, 2022, 33(4): 429-435.

Zhao Jianmin, Guan Xiaopeng. Design of the measurement method of cow body size based on binocular depth estimation [J]. Journal of Optoelectronics Laser, 2022, 33(4): 429-435.

[10]董鹏, 周烽, 赵悰悰, 等. 基于双目视觉的水下海参尺寸自动测量方法[J]. 计算机工程与应用, 2021, 57(8): 271-278.

Dong Peng, Zhou Feng, Zhao Congcong, et al. Automatic measurement of underwater sea cucumber size based on binocular vision [J]. Computer Engineering and Applications, 2021, 57(8): 271-278.

[11]郭卜瑜, 于佳, 王姣姣, 等. 双目视觉用于鱼苗尺寸测量[J]. 光学技术, 2017, 43(2): 153-157.

Guo Buyu, Yu Jia, Wang Jiaojiao, et al. Stereo vision for measuring the size of fish [J]. Optical Technique, 2017, 43(2): 153-157.

[12]Shi C, Wang Q, He X, et al. An automatic method of fish length estimation using underwater stereo system based on LabVIEW [J]. Computers and Electronics in Agriculture, 2020, 173: 105419.

[13]李艳君, 黄康为, 项基. 基于立体视觉的动态鱼体尺寸测量[J]. 农业工程学报, 2020, 36(21): 220-226.

Li Yanjun, Huang Kangwei, Xiang Ji. Measurement of dynamic fish dimension based on stereoscopic vision [J]. Transactions of the Chinese Society of Agricultural Engineering, 2020, 36(21): 220-226.

[14]Wu X, Sahoo D, Hoi S C H. Recent advances in deep learning for object detection [J]. Neurocomputing, 2020, 396: 39-64.

[15]Lei W, Luo J, Hou F, et al. Underground cylindrical objects detection and diameter identification in GPR B-scans via the CNN-LSTM framework [J]. Electronics, 2020, 9(11): 1804.

[16]Wang C, Pang C. Object detection method of power equipment based on mask R-CNN [J]. Academic Journal of Science and Technology, 2022, 1(2): 60-62.

[17]Sun K, Xiao B, Liu D, et al. Deep high-resolution representation learning for human pose estimation [C]. Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2019: 5693-5703.

[18]马皖宜, 张德平. 基于多谱注意力高分辨率网络的人体姿态估计[J]. 计算机辅助设计与图形学学报, 2022, 34(8): 1283-1292.

Ma Wanyi, Zhang Deping. Human pose estimation based on multi-spectral attention and high resolution network [J]. Journal of Computer-Aided Design & Computer Graphics, 2022, 34(8): 1283-1292.

[19]Zhang H, Zu K, Lu J, et al. EPSANet: An efficient pyramid squeeze attention block on convolutional neural network [C]. Proceedings of the Asian Conference on Computer Vision. 2022: 1161-1177.

[20]罗桂娥. 双目立体视觉深度感知与三维重建若干问题研究[D]. 长沙: 中南大学, 2012.

Luo Guie. Some issues of depth perception and three dimension reconstruction from binocular stereo vision [D]. Changsha: Central South University, 2012.

[21]周燕, 刘紫琴, 曾凡智, 等. 深度学习的二维人体姿态估计综述[J]. 计算机科学与探索, 2021, 15(4): 641-657.

Zhou Yan, Liu Ziqin, Zeng Fanzhi, et al. Survey on two-dimensional human pose estimation of deep learning [J]. Journal of Frontiers of Computer Science and Technology, 2021, 15(4): 641-657.