基于交互注意力的红外与可见光图像融合算法

2024-06-07山子岐邹华宇李凡刁悦钦

山子岐 邹华宇 李凡 刁悦钦

DOI:10.20030/j.cnki.1000?3932.202403022

摘 要 为解决现有红外与可见光图像融合目标不够显著,轮廓纹理细节不够清晰等问题,提出了一种基于交互注意力的红外和可见光图像融合网络。该方法通过双流特征提取分支提取源图像的多尺度特征,然后经过交互融合网络获得注意力图,以便从红外与可见光图像中自适应地选择特征进行融合,最后通过图像重建模块生成高质量的融合图像。在MSRS数据集和TNO数据集的实验结果表明,所提方法在主观视觉描述和客观指标评价方面均表现出了较好的性能,融合结果包含更清晰的细节信息和更明显的目标。

关键词 图像融合 深度学习 交互注意力 密集残差连接

中图分类号 TP183 文献标志码 A 文章编号 1000?3932(2024)03?0523?06

作者简介:山子岐(1998-),硕士研究生,从事计算机视觉、机器学习及人工智能等的研究。

通讯作者:李凡(1986-),副教授,从事图像处理、计算机视觉等的研究,478263823@qq.com。

引用本文:山子岐,邹华宇,李凡,等.基于交互注意力的红外与可见光图像融合算法[J].化工自动化及仪表,2024,51(3):523-527;534.

由于成像设备技术的限制,仅凭单一模态的传感器或单一摄像头下捕获的信息不能有效、全面地描述成像场景[1],因此,图像融合技术应运而生。红外传感器通过捕获物体散发的热辐射信息成像,能够有效地突出行人、车辆等显著目标,但是缺失了大部分场景的细节信息。可见光图像通常包含许多细节信息,但却容易遭受极端环境的影响而丢失显著性目标。红外和可见光图像融合旨在整合源图像中的互补信息,并生成既能突出显著目标又包含丰富纹理细节的高对比度融合图像。目前,红外和可见光图像融合技术已在军事行动、目标检测[2]、人脸识别[3]、行人重识别[4]及语义分割[5]等领域得到了广泛应用。

现有的融合方法主要分为两类:传统融合方法和基于深度学习的方法。传统融合方法利用数学变换将源图像转换到变换域,并在变换域中设计融合规则以实现图像融合。传统的图像融合技术主要包括基于多尺度分解的方法、基于子空间聚类的方法[6]、基于稀疏表示的方法[7]、基于优化的方法[8]和混合方法[9]。然而,传统方法采用的变换方式越来越复杂,这无法满足计算机实时應用的要求[10],也难以适应复杂场景。

近年来,深度学习的方法越来越多地应用到图像融合领域。目前,基于深度学习的红外与可见光图像融合大致可以分为3类,即基于自编码器(AE)的方法、基于卷积神经网络(CNN)的方法和基于生成对抗网络(GAN)的方法。

基于AE的方法继承了传统图像融合算法,主要包括特征提取、融合和重建过程。LI H和WU X J首先提出了一种简单的融合架构[11],由编码器层、手工融合层和解码器层3部分组成。之后,LI H等进一步对编码器进行强化,引入密集连接提取深度特征,实现特征提取与重建[12]。然而,上述方法依赖手工制作的方法来制定融合规则,严重限制了融合性能的提高。

基于CNN的图像融合可以在一定程度上避免手工制作的融合规则的局限性。ZHANG H等提出一种端到端的框架[13],通过强度和梯度损失来保持图像梯度和强度的比例。JIAN L等进一步提出了一种基于残差块的对称编码器和解码器结构的红外和可见光图像融合方法[14]。

基于GAN的图像融合方法采用对抗损失来约束融合网络。MA J等首先将基于GAN的方法用于红外和可见图像融合[15]。之后,MA J等进一步提出了一种双鉴别器的生成对抗网络,以保持不同源图像之间的分布平衡[16]。但是,过强的约束容易将人工纹理引入到融合图像中。

1 基于交互注意力的红外与可见光图像融合网络

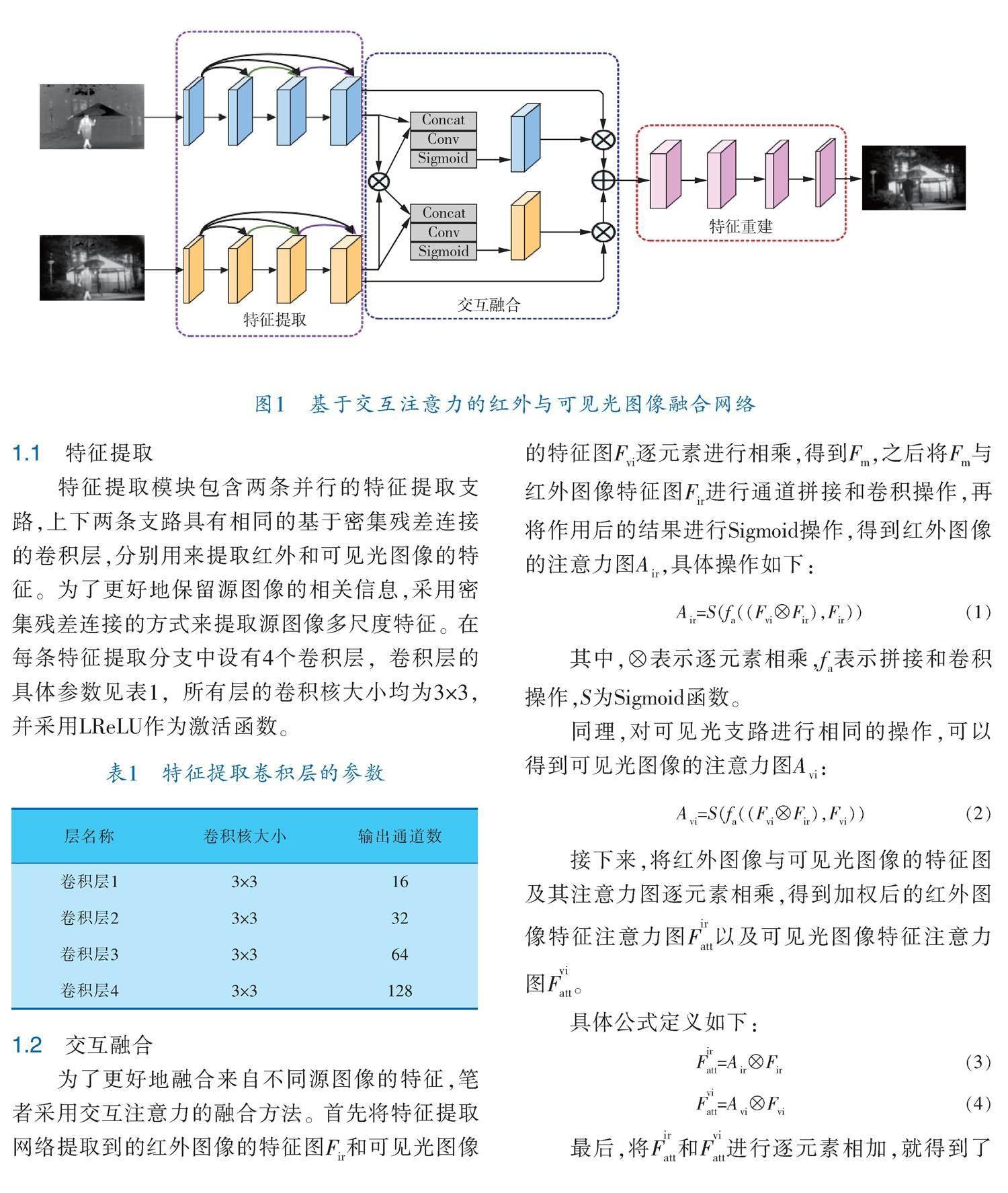

笔者提出的融合网络总体框架如图1所示,网络以端到端的CNN框架作为主干,主要由特征提取模块、交互融合模块和特征重建模块组成。

1.1 特征提取

特征提取模块包含两条并行的特征提取支路,上下两条支路具有相同的基于密集残差连接的卷积层,分别用来提取红外和可见光图像的特征。为了更好地保留源图像的相关信息,采用密集残差连接的方式来提取源图像多尺度特征。在每条特征提取分支中设有4个卷积层,卷积层的具体参数见表1,所有层的卷积核大小均为3×3,并采用LReLU作为激活函数。

1.2 交互融合

为了更好地融合来自不同源图像的特征,笔者采用交互注意力的融合方法。首先将特征提取网络提取到的红外图像的特征图F和可见光图像的特征图F逐元素进行相乘,得到F,之后将F与红外图像特征图F进行通道拼接和卷积操作,再将作用后的结果进行Sigmoid操作,得到红外图像的注意力图A,具体操作如下:

A=S(f((F?F),F)) (1)

其中,?表示逐元素相乘,f表示拼接和卷积操作,S为Sigmoid函数。

同理,对可见光支路进行相同的操作,可以得到可见光图像的注意力图A:

A=S(f((F?F),F)) (2)

接下来,将红外图像与可见光图像的特征图及其注意力图逐元素相乘,得到加权后的红外图像特征注意力图F以及可见光图像特征注意力图F。

具体公式定义如下:

F=A?F (3)

F=A?F (4)

最后,将F和F进行逐元素相加,就得到了初步融合后的特征图。

1.3 特征重建

融合后的特征图即为特征重建模块的输入,其中特征重建模块包含4个卷积层,用于充分集合公有和互补的特征信息,并生成最终的融合图像。特征重建模块的具体参数见表2,除最后一层的卷积核大小为1×1外,其余层的大小均为3×3。只有最后一层的激活函数为Tanh激活函数,其余图像重建分支中的所有卷积层均采用LReLU作为激活函数。在图像融合领域,避免信息丢失是一个关键问题。因此,该网络不引入任何下采样,从而保证融合图像的大小与源图像一致。

1.4 损失函数

损失函数是优化算法的关键部分,在训练过程中,通过最小化损失函数来调整模型参数,使得模型能够不断优化以提高结果的准确性。文中的损失函数由结构相似性损失L和纹理损失L组成。

为了使融合图像能够保持更多的结构信息,引入结构相似性损失Lssim:

L=(1-SSIM(I,I))+(1-SSIM(I,I)) (5)

其中,I表示融合图像,I表示红外图像,I表示可见光图像,SSIM()表示结构相似度。

为了使融合图像能够保留丰富的纹理细节,引入纹理损失L:

L=?I -max( ?I , ?I ) (6)

其中,max()表示选择最大元素,?表示对图像取梯度运算。

融合总损失由结构相似性损失和纹理损失两部分构成:

L=L+λL (7)

其中,λ是一个超参数,用于平衡两种损失函数间的差异。

2 实验验证

2.1 实验数据集及实验设置

笔者在MSRS数据集上训练提出的融合模型。首先在MSRS数据集上选取1 000对红外和可见光图像构成训练集,然后采用裁剪等数据扩充的方式扩充数据,以保证有足够的训练样本来进行训练。所有实验均基于NVIDIA 2080 Ti GPU下的PyTorch框架实现。笔者采用Adam优化器对模型进行优化,初始学习率设置为0.001。测试阶段,从MSRS数据集和TNO数据集中选择部分红外和可见光图像对作为测试数据。

2.2 对比实验

为了全面评估笔者所提方法的实验性能,将其与其他5种图像融合算法进行了定性与定量的比较,包括DenseFuse[11]、FusionGAN[14]、IFCNN[17]、PMGI[13]和U2Fusion[18]。

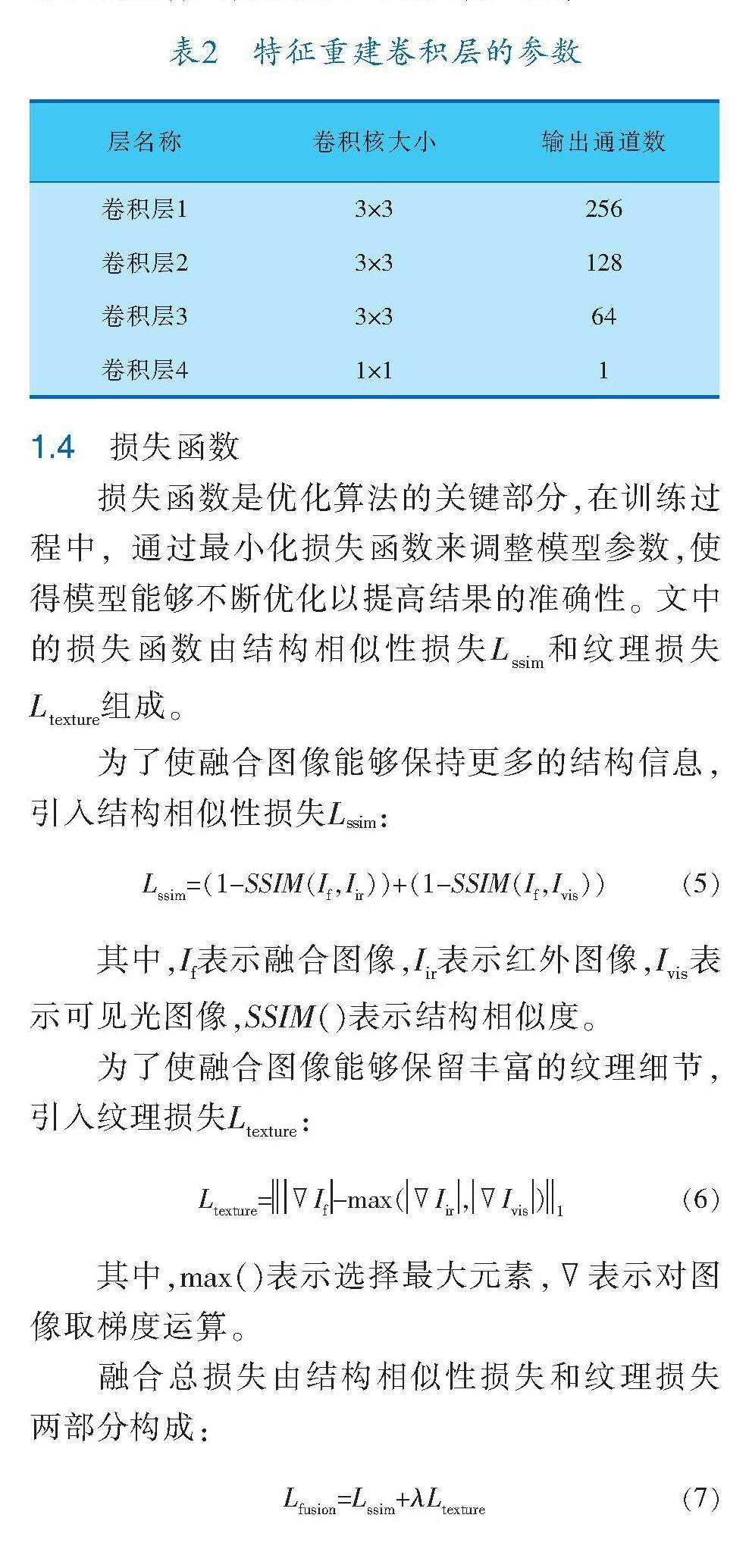

2.2.1 主觀评价

图像融合的可视化结果如图2所示,红外图像含有显著性目标信息,可见光图像主要包含细节信息。在每张融合图像中划定了一个纹理区域(红框)、显著目标区域(绿框)和细节区域(蓝框)。在融合结果中,FusionGAN和U2Fusion在一定程度上削弱了红外目标,PMGI在融合过程中引入了噪声,DenseFuse、FusionGAN、IFCNN和U2Fusion未能清楚地显示隐藏在黑暗中的树干等信息,另外FusionGAN和PMGI模糊了图像中的文字。与其他方法相比,笔者所提方法较好地整合了红外和可见光图像的互补信息。

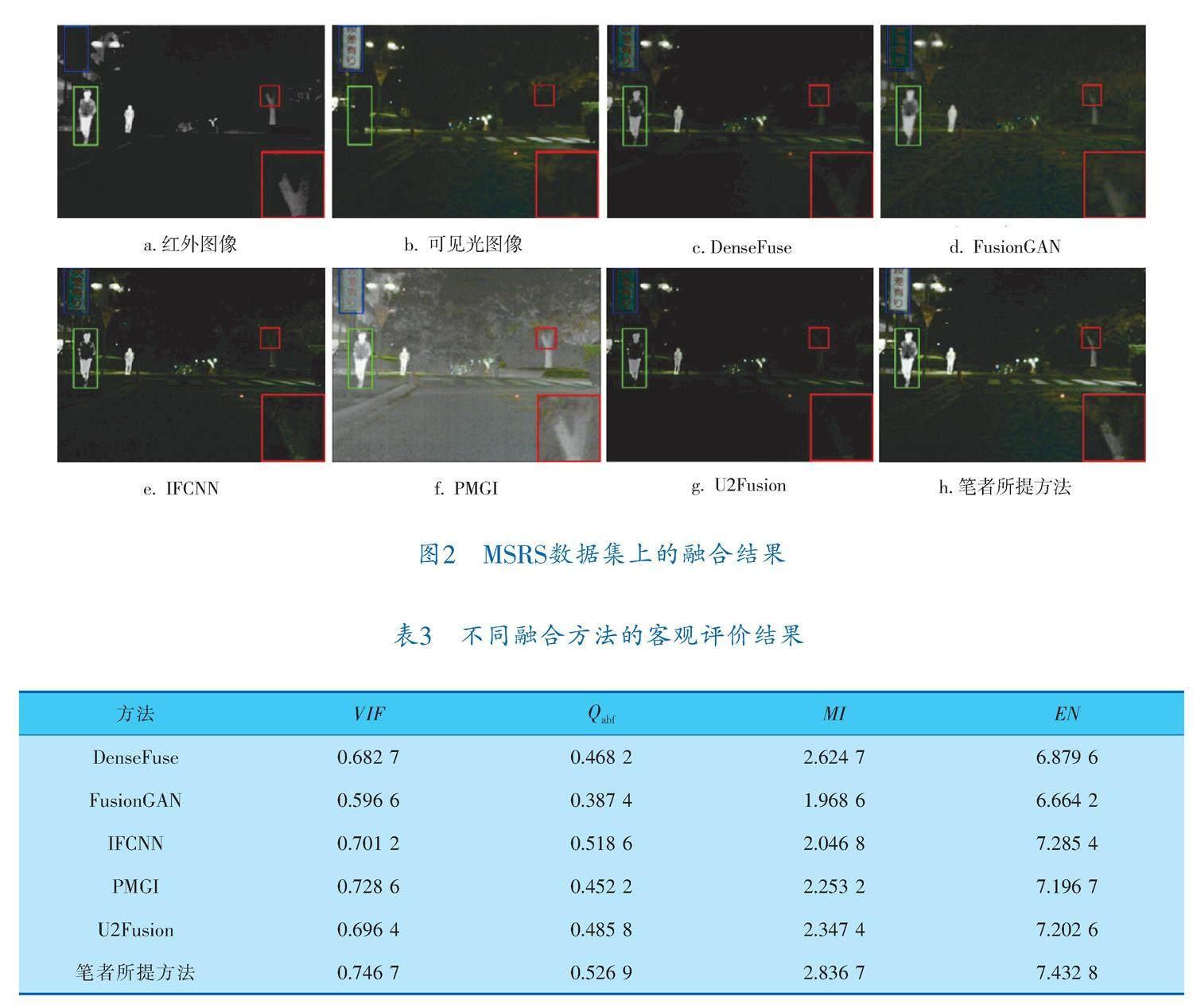

2.2.2 客观评价

笔者采用视觉保真度(VIF)、互信息(MI)、熵(EN)和基于边缘信息的指标Q作为评价指标对融合效果进行客观评价。所有评价指标的值与图像的融合质量均成正相关。

图像融合的定量结果见表3,笔者所提方法在4个指标中都表现出显著优势。其中,本文方法实现了最高的VIF,表明此方法的融合图像具有高对比度和满意的视觉效果。此外,本文方法的Q显示了最好的性能,这意味着融合结果中保留了更多的边缘细节信息。

2.3 泛化实验

为了验证笔者所提方法的泛化能力,将其在MSRS数据集上进行训练,并将训练好的模型在TNO数据集上进行测试,可视化结果如图3所示。

在TNO数据集上的融合结果显示,DenseFuse和U2Fusion削弱了显著目标。此外,FusionGAN和PMGI模糊了目标的边缘,并且在背景区域存在一定的光谱污染。与其他方法相比,笔者所提方法在显著目标突出、纹理细节保留等方面更加具有优势。

3 结束语

针对现有融合图像任务中融合图像缺乏显著性目标、纹理细节等问题,提出了基于交互注意力的渐进式红外与可见光图像融合算法。该算法可以自适应地集成红外图像与可见光图像中有意义的特征信息。经过大量实验验证,笔者提出的方法无论是在主观还是客观评价层面均取得了最佳的融合效果,在目标突出、纹理细节保留等方面均有一定的优势,并且具有一定的泛化能力。

参 考 文 献

[1] MA J,MA Y,LI C.Infrared and visible image fusion me? thods and applications:A survey[J].Information Fusion,2019,45:153-178.

[2] 宁大海,郑晟.可见光和红外图像决策级融合目标检测算法[J].红外技术,2023,45(3):282-291.

[3] 赵云丰,尹怡欣.基于决策融合的红外与可见光图像人脸识别研究[J].激光与红外,2008,38(6):622-625.

[4] LU Y,WU Y,LIU B,et al.Cross?modality person re?

identification with shared?specific feature transfer[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE,2020:13379-13389.

[5] HA Q,WATANABE K,KARASAWA T,et al.MFNet:Towards real?time semantic segmentation for autono? mous vehicles with multi?spectral scenes[C]//2017 IEEE/RSJ International Conference on Intelligent Robo? ts and Systems(IROS).Piscataway,NJ:IEEE,2017:5108-5115.

[6] CVEJIC N,BULL D,CANAGARAJAH N.Region?based multimodal image fusion using ICA bases[J].IEEE Sensors Journal, 2007,7(5):743-751.

[7] LIU Y,CHEN X,WARD R K,et al.Image fusion with convolutional sparse representation[J].IEEE Signal Processing Letters,2016,23(12):1882-1886.

[8] MA J,CHEN C,LI C,et al.Infrared and visible image fusion via gradient transfer and total variation minimization[J].Information Fusion,2016,31:100-109.

[9] MA J,ZHOU Z,WANG B,et al.Infrared and visible image fusion based on visual saliency map and weighted least square optimization[J].Infrared Physics & Technology,2017,82:8-17.

[10] LI S,KANG X,FANG L,et al.Pixel?level image fu?

sion:A survey of the state of the art[J].Information Fusion,2017,33:100-112.

[11] LI H,WU X J.DenseFuse:A fusion approach to infra? red and visible images[J].IEEE Transactions on Image Processing,2018,28(5):2614-2623.

[12] LI H,WU X J,DURRANI T.NestFuse:An infrared

and visible image fusion architecture based on nest connection and spatial/channel attention models[J].IEEE Transactions on Instrumentation and Measurement,2020,69(12):9645-9656.

[13] ZHANG H,XU H,XIAO Y,et al.Rethinking the image fusion:A fast unified image fusion network based on proportional maintenance of gradient and intensity[C]//Proceedings of the AAAI Conference on Artificial Intelligence.AAAI,2020:12797-12804.

[14] JIAN L,YANG X,LIU Z,et al.A symmetric encoder?decoder with residual block for infrared and visible image fusion[J].arXiv Preprint,2019.DOI:10.48550/arXiv.1905.11447.

[15] MA J,XU H,JIANG J,et al.DDcGAN:A dual?discri? minator conditional generative adversarial network for multi?resolution image fusion[J].IEEE Transactions on Image Processing,2020,29:4980-4995.

[16] MA J,ZHANG H,SHAO Z,et al.GANMcC:A generative adversarial network with multiclassification constraints for infrared and visible image fusion[J].IEEE Transactions on Instrumentation and Measurement,2020,70:1-14.

[17] ZHANG Y,LIU Y,SUN P,et al.IFCNN:A general image fusion framework based on convolutional neural network[J].Information Fusion,2020,54:99-118.

[18] XU H,MA J,JIANG J,et al.U2Fusion:A unified unsupervised image fusion network[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2020,44(1):502-518.

(收稿日期:2023-05-22,修回日期:2024-03-15)

Interactive Attention?based Fusion Algorithm for

Infrared and Visible Images

SHAN Zi?qi, ZOU Hua?yu, LI Fan, DIAO Yue?qin

(Faculty of Information Engineering and Automation, Kunming University of Science and Technology)

Abstract Considering insufficient remarkability and unclear contour texture of existing infrared and visible images, an interactive attention?based infrared and visible image fusion network was proposed. In which, multi?scale features of the source image through a dual?stream feature extraction branch was extracted and an attention map was obtained through the interactive fusion network to adaptively select features from the IR and visible images for fusion and finally generates a high?quality fused image through the image reconstruction module. Experiments on both the MSRS dataset and the TNO dataset show that, the algorithm proposed exhibits better performance in both subjective visual description and objective index evaluation, and the image fusion results contain clearer detail information and more obvious targets.

Key words image fusion, deep learning, interactive attention, dense residual connectivity